Tutorial ini menunjukkan cara membuat pipeline yang dapat digunakan kembali yang membaca data dari Cloud Storage, melakukan pemeriksaan kualitas data, dan menulis ke Cloud Storage.

Pipeline yang dapat digunakan kembali memiliki struktur pipeline reguler, tetapi Anda dapat mengubah konfigurasi setiap node pipeline berdasarkan konfigurasi yang disediakan oleh server HTTP. Misalnya, pipeline statis dapat membaca data dari Cloud Storage, menerapkan transformasi, dan menulis ke tabel output BigQuery. Jika ingin transformasi dan tabel output BigQuery berubah berdasarkan file Cloud Storage yang dibaca pipeline, Anda harus membuat pipeline yang dapat digunakan kembali.

Tujuan

- Gunakan plugin Penyetel Argumen Cloud Storage untuk memungkinkan pipeline membaca input yang berbeda-beda dalam setiap operasi.

- Gunakan plugin Cloud Storage Argument Setter untuk memungkinkan pipeline melakukan pemeriksaan kualitas yang berbeda dalam setiap operasi.

- Tulis data output dari setiap operasi ke Cloud Storage.

Biaya

Dalam dokumen ini, Anda akan menggunakan komponen Google Cloud yang dapat ditagih berikut:

- Cloud Data Fusion

- Cloud Storage

Untuk membuat perkiraan biaya berdasarkan proyeksi penggunaan Anda,

gunakan kalkulator harga.

Sebelum memulai

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

Enable the Cloud Data Fusion, Cloud Storage, BigQuery, and Dataproc APIs.

- Buat instance Cloud Data Fusion.

Membuka antarmuka web Cloud Data Fusion

Saat menggunakan Cloud Data Fusion, Anda menggunakan konsol Google Cloud dan antarmuka web Cloud Data Fusion terpisah. Di konsol Google Cloud, Anda dapat membuat project konsol Google Cloud, serta membuat dan menghapus instance Cloud Data Fusion. Di antarmuka web Cloud Data Fusion, Anda dapat menggunakan berbagai halaman, seperti Pipeline Studio atau Wrangler, untuk menggunakan fitur Cloud Data Fusion.

Di konsol Google Cloud, buka halaman Instance.

Di kolom Actions untuk instance, klik link View Instance. Antarmuka web Cloud Data Fusion akan terbuka di tab browser baru.

Men-deploy plugin Cloud Storage Argument Setter

Di antarmuka web Cloud Data Fusion, buka halaman Studio.

Di menu Actions, klik GCS Argument Setter.

Membaca dari Cloud Storage

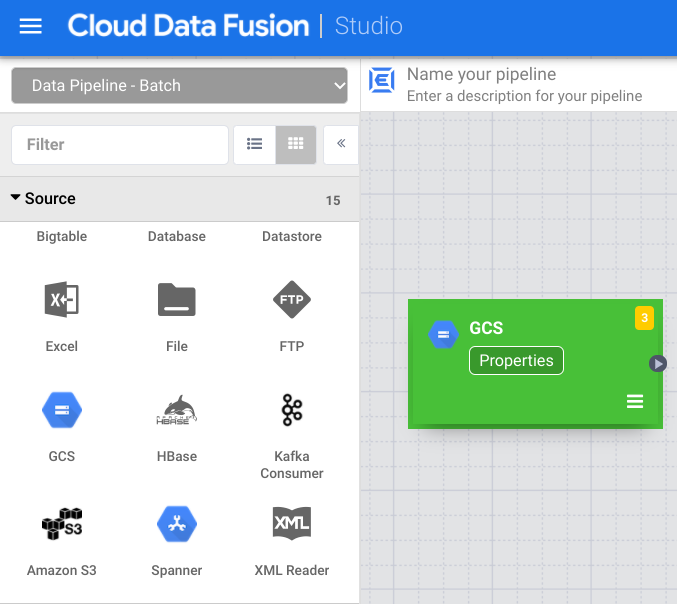

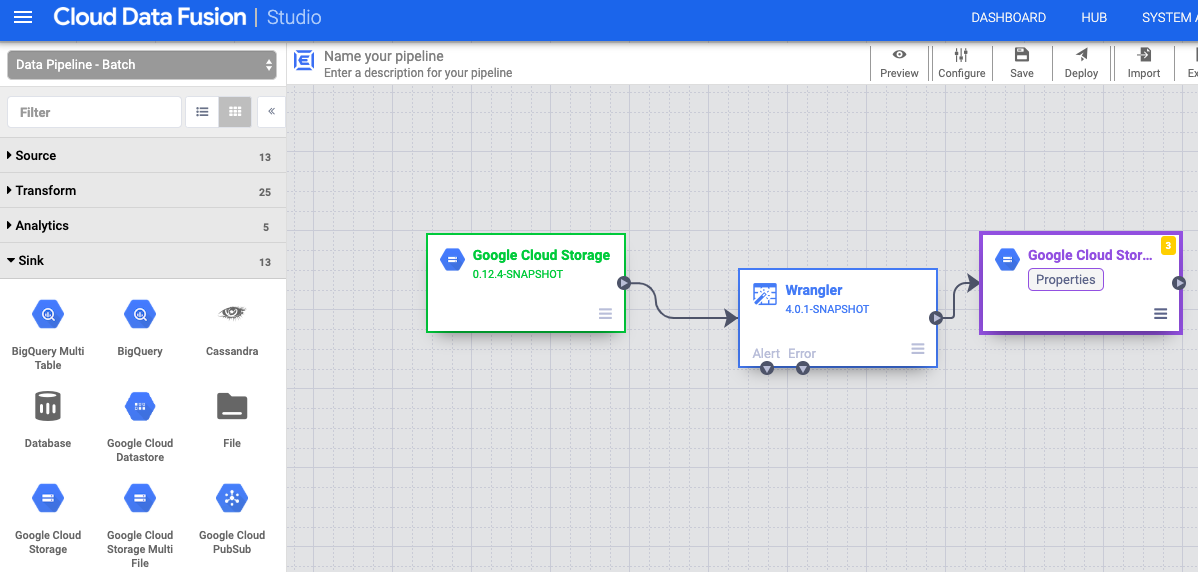

- Di antarmuka web Cloud Data Fusion, buka halaman Studio.

- Klik arrow_drop_down Source, lalu pilih Cloud Storage. Node untuk sumber Cloud Storage akan muncul di pipeline.

Di node Cloud Storage, klik Properties.

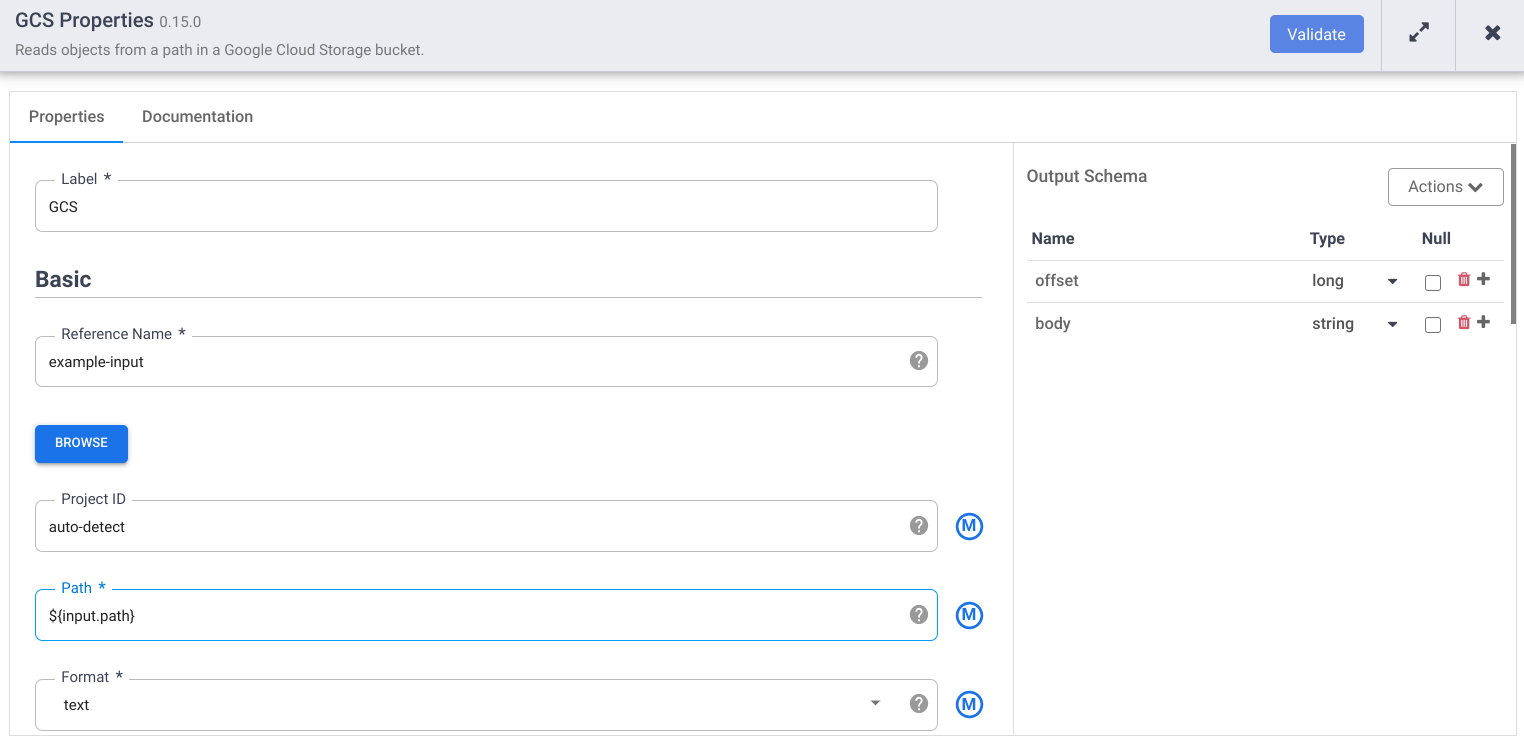

Di kolom Nama referensi, masukkan nama.

Di kolom Path, masukkan

${input.path}. Makro ini mengontrol jalur input Cloud Storage yang akan digunakan dalam berbagai pipeline yang berjalan.Di panel Skema Output sebelah kanan, hapus kolom offset dari skema output dengan mengklik ikon sampah di baris kolom offset.

Klik Validasi dan perbaiki error yang ada.

Klik untuk keluar dari dialog Properties.

Mengubah data Anda

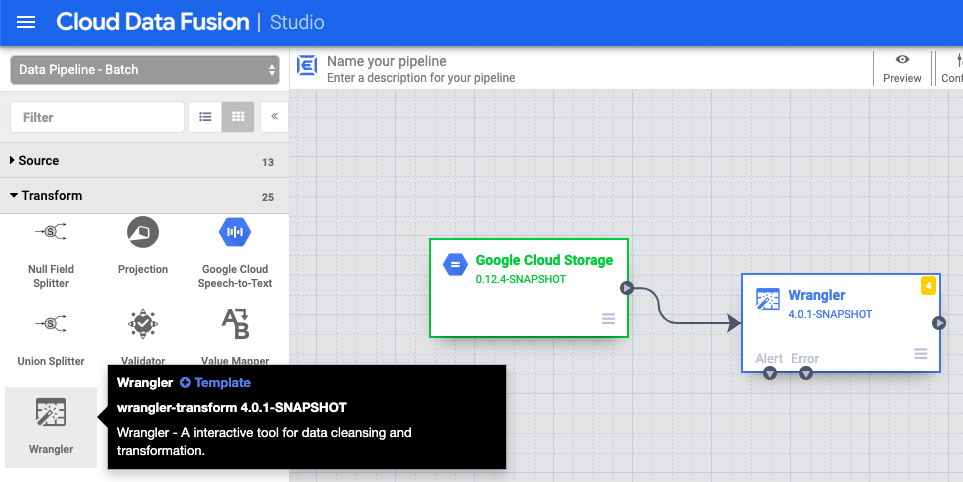

- Di antarmuka web Cloud Data Fusion, buka pipeline data Anda di halaman Studio.

- Di menu drop-down Transform arrow_drop_down, pilih Wrangler.

- Di kanvas Pipeline Studio, tarik panah dari node Cloud Storage ke node Wrangler.

- Buka node Wrangler di pipeline Anda, lalu klik Properties.

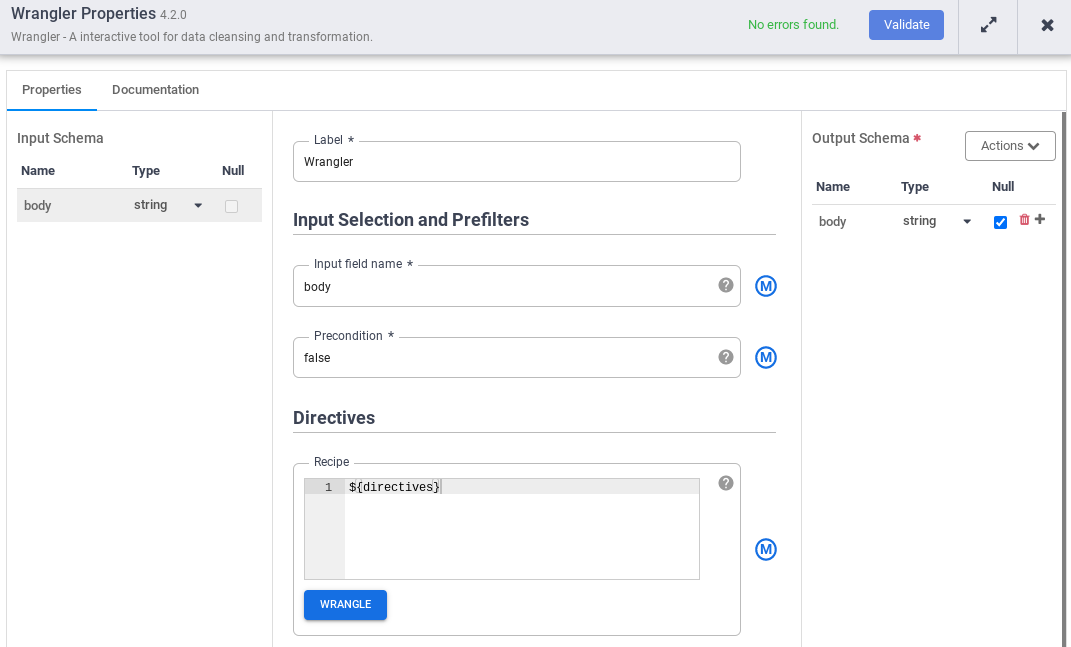

- Di Input field name, masukkan

body. - Di kolom Recipe, masukkan

${directives}. Makro ini mengontrol logika transformasi yang akan ada dalam berbagai pipeline yang berjalan.

- Klik Validasi dan perbaiki error yang ada.

- Klik untuk keluar dari dialog Properties.

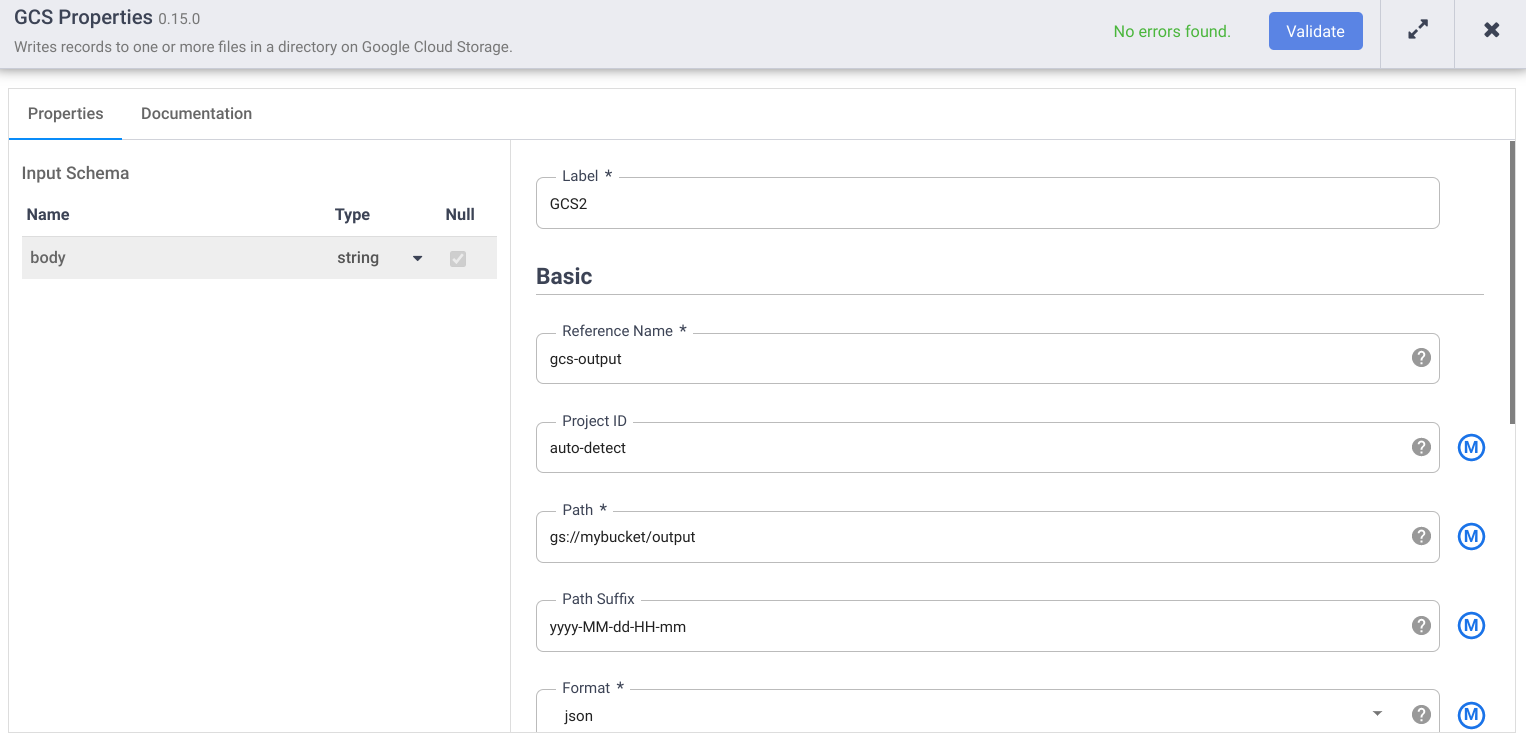

Menulis ke Cloud Storage

- Di antarmuka web Cloud Data Fusion, buka pipeline data Anda di halaman Studio.

- Di menu drop-down Sink arrow_drop_down, pilih Cloud Storage.

- Di kanvas Pipeline Studio, tarik panah dari node Wrangler ke node Cloud Storage yang baru saja Anda tambahkan.

- Buka node sink Cloud Storage di pipeline Anda, lalu klik Properties.

- Di kolom Nama referensi, masukkan nama.

- Di kolom Path, masukkan jalur bucket Cloud Storage di project Anda, tempat pipeline dapat menulis file output. Jika Anda tidak memiliki bucket Cloud Storage, buat bucket.

- Klik Validasi dan perbaiki error yang ada.

- Klik untuk keluar dari dialog Properties.

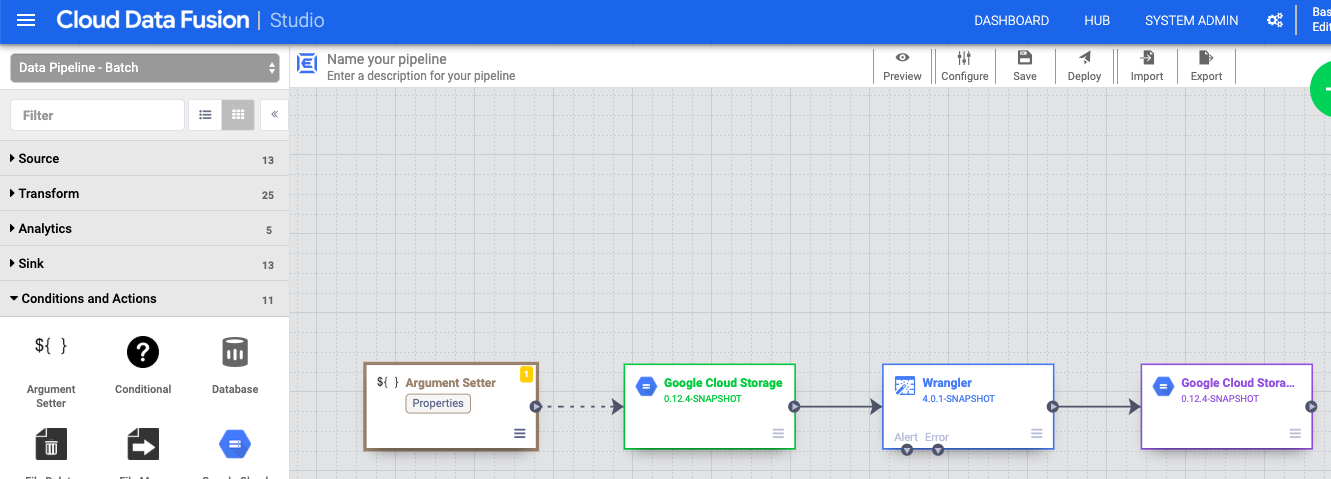

Menetapkan argumen makro

- Di antarmuka web Cloud Data Fusion, buka pipeline data Anda di halaman Studio.

- Di menu drop-down arrow_drop_down Conditions and Actions, klik GCS Argument Setter.

- Di kanvas Pipeline Studio, tarik panah dari node Cloud Storage Argument Setter ke node source Cloud Storage.

- Buka node Cloud Storage Argument Setter di pipeline Anda, lalu klik Properties.

Di kolom URL, masukkan URL berikut:

gs://reusable-pipeline-tutorial/args.jsonURL ini sesuai dengan objek yang dapat diakses publik di Cloud Storage yang berisi konten berikut:

{ "arguments" : [ { "name": "input.path", "value": "gs://reusable-pipeline-tutorial/user-emails.txt" }, { "name": "directives", "value": "send-to-error !dq:isEmail(body)" } ] }Argumen pertama dari dua argumen adalah nilai untuk

input.path. Jalurgs://reusable-pipeline-tutorial/user-emails.txtadalah objek yang dapat diakses publik di Cloud Storage yang berisi data pengujian berikut:alice@example.com bob@example.com craig@invalid@example.comArgumen kedua adalah nilai untuk

directives. Nilaisend-to-error !dq:isEmail(body)mengonfigurasi Wrangler untuk memfilter baris yang bukan alamat email yang valid. Misalnya,craig@invalid@example.comakan difilter.Klik Validasi untuk memastikan tidak ada error.

Klik untuk keluar dari dialog Properties.

Men-deploy dan menjalankan pipeline

Di panel atas halaman Pipeline Studio, klik Beri nama pipeline Anda. Beri nama pipeline Anda, lalu klik Simpan.

Klik Deploy.

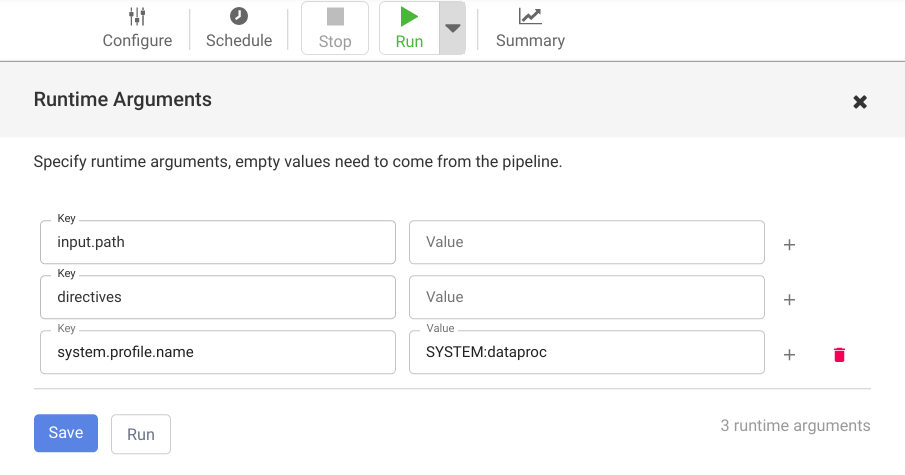

Untuk membuka Runtime Arguments dan melihat argumen makro (runtime)

input.pathdandirectives, klik dropdown arrow_drop_down di samping Run.Biarkan kolom nilai kosong untuk memberi tahu Cloud Data Fusion bahwa node Cloud Storage Argument Setter dalam pipeline akan menetapkan nilai argumen ini selama runtime.

Klik Run.

Pembersihan

Agar tidak perlu membayar biaya pada akun Google Cloud Anda untuk resource yang digunakan dalam tutorial ini, hapus project yang berisi resource tersebut, atau simpan project dan hapus setiap resource.

Setelah menyelesaikan tutorial, bersihkan resource yang dibuat di Google Cloud sehingga resource tersebut tidak akan menggunakan kuota dan Anda tidak akan ditagih di masa mendatang. Bagian berikut menjelaskan cara menghapus atau menonaktifkan resource ini.

Menghapus instance Cloud Data Fusion

Ikuti petunjuk untuk menghapus instance Cloud Data Fusion.

Menghapus project

Cara termudah untuk menghilangkan penagihan adalah dengan menghapus project yang Anda buat untuk tutorial.

Untuk menghapus project:

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

Langkah selanjutnya

- Baca panduan cara kerja

- Pelajari tutorial lain