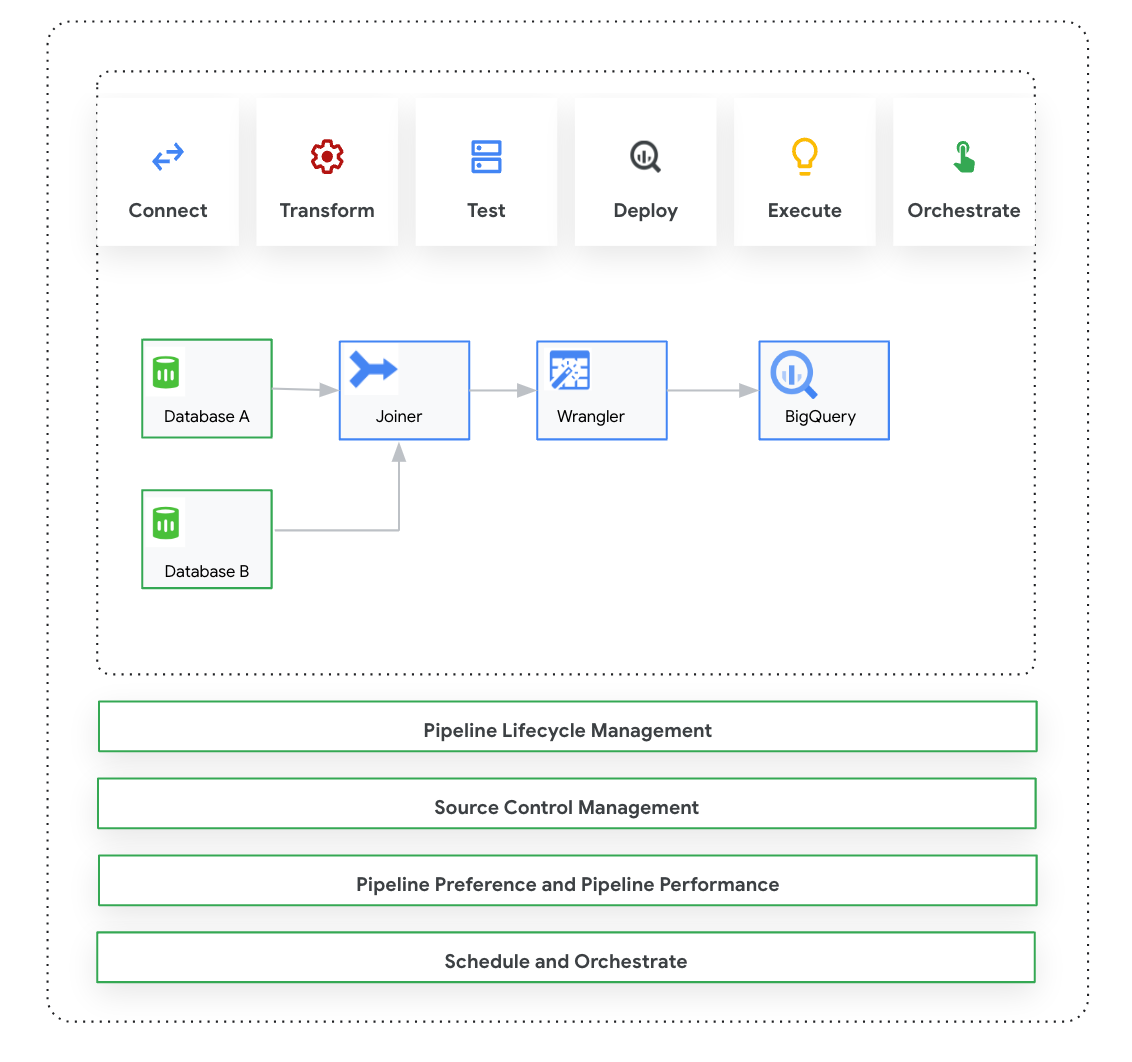

Halaman ini memperkenalkan Cloud Data Fusion: Studio, yang merupakan antarmuka visual klik dan tarik untuk membuat pipeline data dari library plugin bawaan dan antarmuka tempat Anda mengonfigurasi, menjalankan, dan mengelola pipeline. Mem-build pipeline di Studio biasanya mengikuti proses ini:

- Menghubungkan ke sumber data lokal atau cloud.

- Menyiapkan dan mengubah data Anda.

- Hubungkan ke tujuan.

- Uji pipeline Anda.

- Jalankan pipeline Anda.

- Menjadwalkan dan memicu pipeline Anda.

Setelah mendesain dan menjalankan pipeline, Anda dapat mengelola pipeline di halaman Pipeline Studio Cloud Data Fusion:

- Gunakan kembali pipeline dengan memparametrisasi pipeline tersebut dengan preferensi dan argumen runtime.

- Kelola eksekusi pipeline dengan menyesuaikan profil komputasi, mengelola resource, dan meningkatkan performa pipeline.

- Mengelola siklus proses pipeline dengan mengedit pipeline.

- Mengelola kontrol sumber pipeline menggunakan integrasi Git.

Sebelum memulai

- Aktifkan Cloud Data Fusion API.

- Buat instance Cloud Data Fusion.

- Pahami kontrol akses di Cloud Data Fusion.

- Pahami konsep dan istilah utama di Cloud Data Fusion.

Cloud Data Fusion: Ringkasan Studio

Studio mencakup komponen berikut.

Administrasi

Cloud Data Fusion memungkinkan Anda memiliki beberapa namespace di setiap instance. Dalam Studio, administrator dapat mengelola semua namespace secara terpusat, atau setiap namespace satu per satu.

Studio menyediakan kontrol administrator berikut:

- Administrasi Sistem

- Modul System Admin di Studio memungkinkan Anda membuat namespace baru dan menentukan konfigurasi compute profile pusat di tingkat sistem, yang berlaku untuk setiap namespace dalam instance tersebut. Untuk informasi selengkapnya, lihat Mengelola administrasi Studio.

- Administrasi Namespace

- Modul Namespace Admin di Studio memungkinkan Anda mengelola konfigurasi untuk namespace tertentu. Untuk setiap namespace, Anda dapat menentukan profil komputasi, preferensi runtime, driver, akun layanan, dan konfigurasi git. Untuk informasi selengkapnya, lihat Mengelola administrasi Studio.

Pipeline Design Studio

Anda mendesain dan menjalankan pipeline di Pipeline Design Studio di antarmuka web Cloud Data Fusion. Mendesain dan menjalankan pipeline data mencakup langkah-langkah berikut:

- Menghubungkan ke sumber: Cloud Data Fusion memungkinkan koneksi ke sumber data lokal dan cloud. Antarmuka Studio memiliki plugin sistem default, yang sudah diinstal sebelumnya di Studio. Anda dapat mendownload plugin tambahan dari repositori plugin, yang dikenal sebagai Hub. Untuk informasi selengkapnya, lihat Ringkasan plugin.

- Persiapan data: Cloud Data Fusion memungkinkan Anda menyiapkan data menggunakan plugin persiapan data yang canggih: Wrangler. Wrangler membantu Anda melihat, menjelajahi, dan mengubah sampel kecil data di satu tempat sebelum menjalankan logika pada seluruh set data di Studio. Hal ini memungkinkan Anda menerapkan transformasi dengan cepat untuk mendapatkan pemahaman tentang pengaruhnya terhadap seluruh set data. Anda dapat membuat beberapa transformasi dan menambahkannya ke sebuah resep. Untuk informasi selengkapnya, lihat ringkasan Wrangler.

- Transformasi: Plugin transformasi mengubah data setelah dimuat dari sumber—misalnya, Anda dapat meng-clone data, mengubah format file menjadi JSON, atau menggunakan plugin JavaScript untuk membuat transformasi kustom. Untuk mengetahui informasi selengkapnya, lihat Ringkasan plugin.

- Menghubungkan ke tujuan: Setelah menyiapkan data dan menerapkan transformasi, Anda dapat terhubung ke tujuan tempat Anda berencana memuat data. Cloud Data Fusion mendukung koneksi ke beberapa tujuan. Untuk informasi selengkapnya, lihat Ringkasan plugin.

- Pratinjau: Setelah mendesain pipeline, untuk men-debug masalah sebelum men-deploy dan menjalankan pipeline, Anda harus menjalankan Tugas pratinjau. Jika mengalami error, Anda dapat memperbaikinya saat dalam mode Draf. Studio menggunakan 100 baris pertama set data sumber Anda untuk membuat pratinjau. Studio menampilkan status dan durasi tugas Pratinjau. Anda dapat menghentikan tugas kapan saja. Anda juga dapat memantau peristiwa log saat tugas Pratinjau berjalan. Untuk mengetahui informasi selengkapnya, lihat Melihat pratinjau data.

Mengelola konfigurasi pipeline: Setelah melihat pratinjau data, Anda dapat men-deploy pipeline dan mengelola konfigurasi pipeline berikut:

- Konfigurasi komputasi: Anda dapat mengubah profil komputasi yang menjalankan pipeline—misalnya, Anda ingin menjalankan pipeline terhadap cluster Dataproc yang disesuaikan, bukan cluster Dataproc default.

- Konfigurasi pipeline: Untuk setiap pipeline, Anda dapat mengaktifkan atau menonaktifkan instrumentasi, seperti metrik pengaturan waktu. Secara default, instrumentasi diaktifkan.

- Konfigurasi mesin: Spark adalah mesin eksekusi default. Anda dapat meneruskan parameter kustom untuk Spark.

- Resource: Anda dapat menentukan memori dan jumlah CPU untuk driver dan eksekutor Spark. Driver mengatur tugas Spark. Eksekutor menangani pemrosesan data di Spark.

- Pemberitahuan pipeline: Anda dapat mengonfigurasi pipeline untuk mengirim pemberitahuan dan memulai tugas pascapemrosesan setelah operasi pipeline selesai. Anda membuat pemberitahuan pipeline saat mendesain pipeline. Setelah men-deploy pipeline, Anda dapat melihat pemberitahuan. Untuk mengubah setelan pemberitahuan, Anda dapat mengedit pipeline.

- Pushdown transformasi: Anda dapat mengaktifkan Pushdown transformasi jika ingin pipeline menjalankan transformasi tertentu di BigQuery.

Untuk mengetahui informasi selengkapnya, lihat Mengelola konfigurasi pipeline.

Menggunakan kembali pipeline menggunakan makro, preferensi, dan argumen runtime: Cloud Data Fusion memungkinkan Anda menggunakan kembali pipeline data. Dengan pipeline data yang dapat digunakan kembali, Anda dapat memiliki satu pipeline yang dapat menerapkan pola integrasi data ke berbagai kasus penggunaan dan set data. Pipeline yang dapat digunakan kembali memberi Anda pengelolaan yang lebih baik. Dengan ini, Anda dapat menetapkan sebagian besar konfigurasi pipeline pada waktu eksekusi, bukan dengan melakukan hard coding pada waktu desain. Di Pipeline Design Studio, Anda dapat menggunakan makro untuk menambahkan variabel ke konfigurasi plugin sehingga Anda dapat menentukan penggantian variabel saat runtime. Untuk informasi selengkapnya, lihat Mengelola makro, preferensi, dan argumen runtime.

Execute: Setelah meninjau konfigurasi pipeline, Anda dapat memulai eksekusi pipeline. Anda dapat melihat perubahan status selama fase pipeline berjalan—misalnya penyediaan, memulai, berjalan, dan berhasil.

Menjadwalkan dan mengatur: Pipeline data batch dapat disetel untuk dijalankan pada jadwal dan frekuensi yang ditentukan. Setelah membuat dan men-deploy pipeline, Anda dapat membuat jadwal. Di Pipeline Design Studio, Anda dapat melakukan orkestrasi pipeline dengan membuat pemicu pada pipeline data batch agar berjalan saat satu atau beberapa pipeline selesai dijalankan. Ini disebut pipeline downstream dan upstream. Anda membuat pemicu di pipeline downstream sehingga berjalan berdasarkan penyelesaian satu atau beberapa pipeline upstream.

Direkomendasikan: Anda juga dapat menggunakan Composer untuk mengorkestrasi pipeline di Cloud Data Fusion. Untuk informasi selengkapnya, lihat Menjadwalkan pipeline dan Menyusun pipeline.

Mengedit pipeline: Cloud Data Fusion memungkinkan Anda mengedit pipeline yang di-deploy. Saat Anda mengedit pipeline yang di-deploy, pipeline tersebut akan membuat versi baru dengan nama yang sama dan menandainya sebagai versi terbaru. Hal ini memungkinkan Anda mengembangkan pipeline secara iteratif, bukan menduplikasi pipeline, yang akan membuat pipeline baru dengan nama yang berbeda. Untuk mengetahui informasi selengkapnya, lihat Mengedit pipeline.

Pengelolaan Kontrol Sumber: Cloud Data Fusion memungkinkan Anda mengelola pipeline dengan lebih baik antara pengembangan dan produksi dengan Pengelolaan Kontrol Sumber pipeline menggunakan GitHub.

Logging dan pemantauan: Untuk memantau metrik dan log pipeline, sebaiknya Anda mengaktifkan layanan logging Stackdriver untuk menggunakan Cloud Logging dengan pipeline Cloud Data Fusion.

Langkah selanjutnya

- Pelajari lebih lanjut cara mengelola administrasi Studio.