Hier erfahren Sie mehr über die spezifischen KI-Funktionen von Apigee, die für die Entwicklung, nahtlose Anwendungsintegration und effektive Skalierung von KI-Lösungen entwickelt wurden.

Ein unternehmensgerechtes KI-Gateway implementieren

Die wichtigsten Funktionen des API-Gateways von Apigee umfassen native Funktionen zur Verwaltung des Traffics für KI-Anwendungen und bieten einen konsistenten API-Vertrag für den Dienstverbrauch.

Funktionen:

- Modellabstraktion

- Routing für Multi-Cloud-Modelle

- Anfrage-/Antwortanreicherung

- RAG-Integrationen

- Agent-Konnektivität zu Drittanbietersystemen (mit der Application Integration-Plattform von Google Cloud)

- LLM-Circuit-Breaker-Muster für Hochverfügbarkeit

- Semantisches Caching

Ressourcen

Programmierbare API-Proxys

Wenn Sie Richtlinien an verschiedene Stellen in einem Apigee API-Proxy-Ablauf anhängen, können Sie das API-Verhalten detailliert steuern. Diese Platzierung bestimmt genau, wann jede Richtlinie angewendet wird, wenn Anfragen und Antworten über den Proxy gesendet werden.

Die nächste Generation der Integration: KI-basiert

Nutzen Sie das Potenzial von Generative AI, um erweiterte Automatisierungsworkflows zu erstellen. Hier erfahren Sie, wie Sie über 100 Anwendungen mithilfe einfacher natürlicher Sprache verbinden können. Hier erfahren Sie, wie Sie mit generativen KI-Agents Ihre Abläufe im Google Cloud-Ökosystem optimieren können.

Hugging Face-Modelle aus Vertex AI mit Apigee bereitstellen

Erstellen Sie ein LLM-API-Gateway mit Apigee und Vertex AI. In dieser praktischen Demo wird gezeigt, wie Sie einen Proxy für Ihren LLM-Endpunkt erstellen. Sie ist ideal für Entwickler, die neu in Apigee sind oder KI-APIs einbinden möchten. Hier erfahren Sie, wie Apigee Ihre KI-Anwendungen schützt, verwaltet und optimiert.

Workflows auf Agent-Ebene, die auf dem Unternehmenskontext basieren

KI-Agenten nutzen die Funktionen von LLMs, um Aufgaben für Endnutzer zu erledigen. Diese Agenten können mithilfe einer Vielzahl von Tools erstellt werden – von No-Code- und Low-Code-Plattformen wie Agentspace bis hin zu Full-Code-Frameworks wie LangChain oder LlamaIndex. Apigee fungiert als Vermittler zwischen Ihrer KI-Anwendung und ihren Agenten.

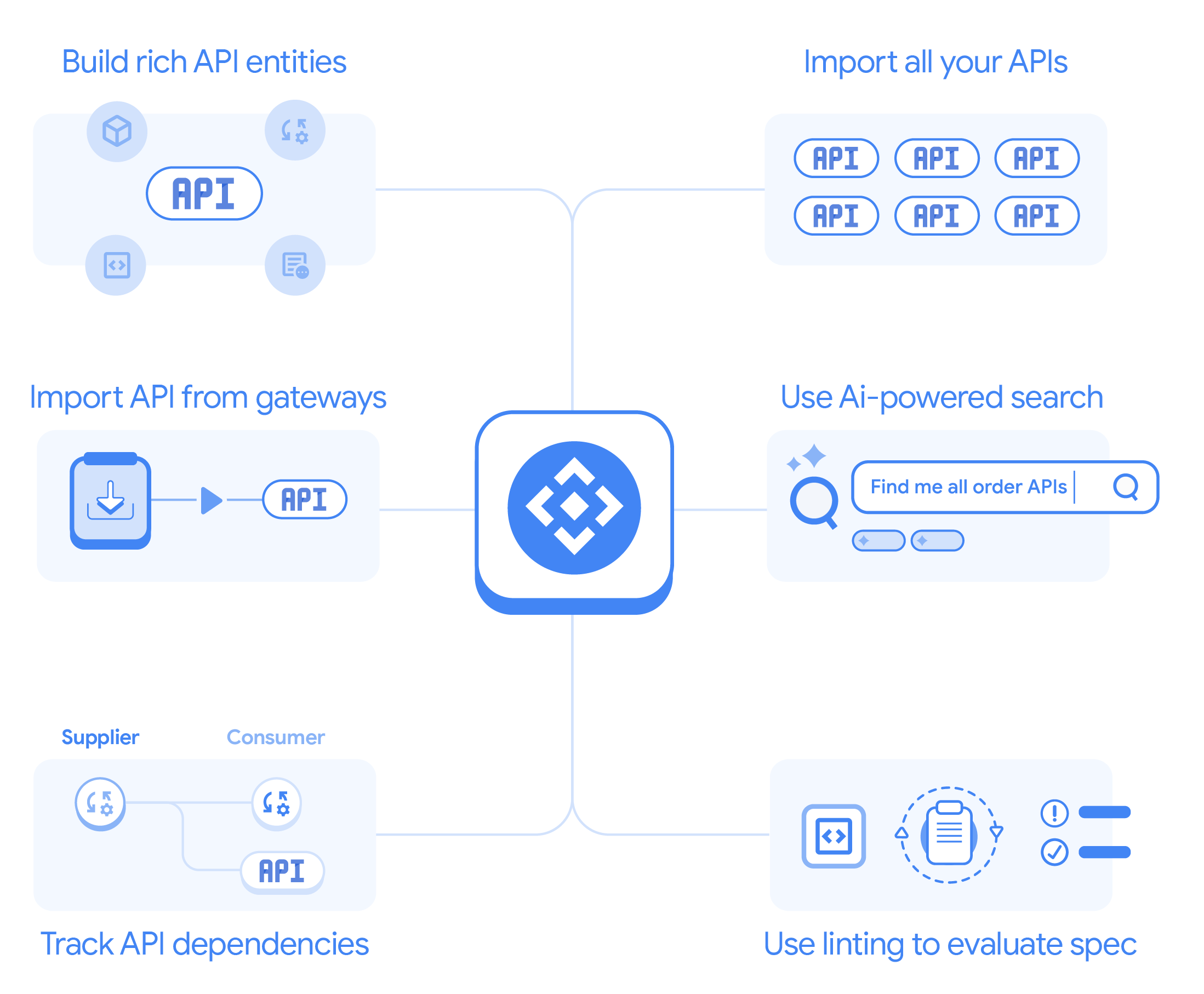

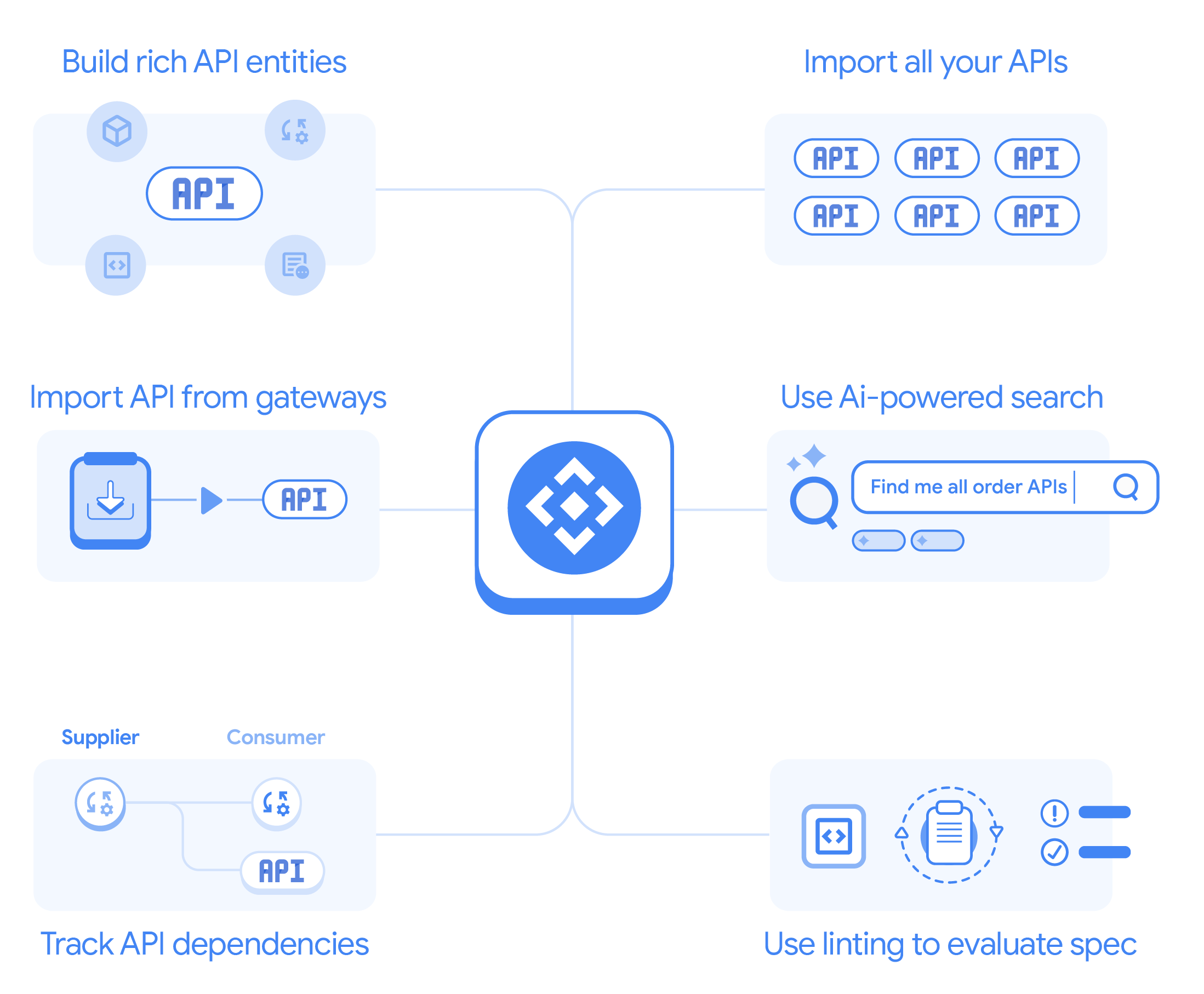

Mit dem jetzt allgemein verfügbaren Gemini Code Assist in Apigee können Sie API-Spezifikationen schnell mit natürlicher Sprache in den Cloud Code- und Gemini Chat-Benutzeroberflächen erstellen. Wenn Sie das API-Ökosystem Ihrer Organisation über den API-Hub nutzen, erhalten Sie Unternehmenskontext für konsistente, sichere APIs mit Unterstützung für geschachtelte Objekte und proaktive Erkennung doppelter APIs.

Funktionen:

- Apigee API-Hub, um APIs und Workflows von Drittanbietern und selbst erstellte APIs zu katalogisieren

- Durchsetzung des Token-Limits für Kostenkontrollen

- Orchestrierung mehrerer Agenten

- Authentifizierung und Autorisierung

- Semantic Caching für optimierte Leistung

- API-Spezifikationsgenerierung mit Unternehmenskontext (mit Gemini Code Assist)

Ressourcen

Dokumentation: Apigee API-Hub

Mit Apigee API Hub, einer zentralen Plattform in Google Cloud, können Sie alle Ihre APIs entdecken, verwalten und dokumentieren, um die Sichtbarkeit, Kontrolle, Wiederverwendung, Governance und Entwicklung zu verbessern.

Blog: Apigee API-Hub jetzt allgemein verfügbar

Mit dem jetzt allgemein verfügbaren Apigee API-Hub können Sie alle Ihre APIs zentral finden, verwalten und steuern. Diese Plattform bietet einen einheitlichen Überblick über Ihre gesamte API-Landschaft, unabhängig vom Bereitstellungsort. So können Teams Abläufe optimieren und die API-Governance im gesamten Unternehmen stärken.

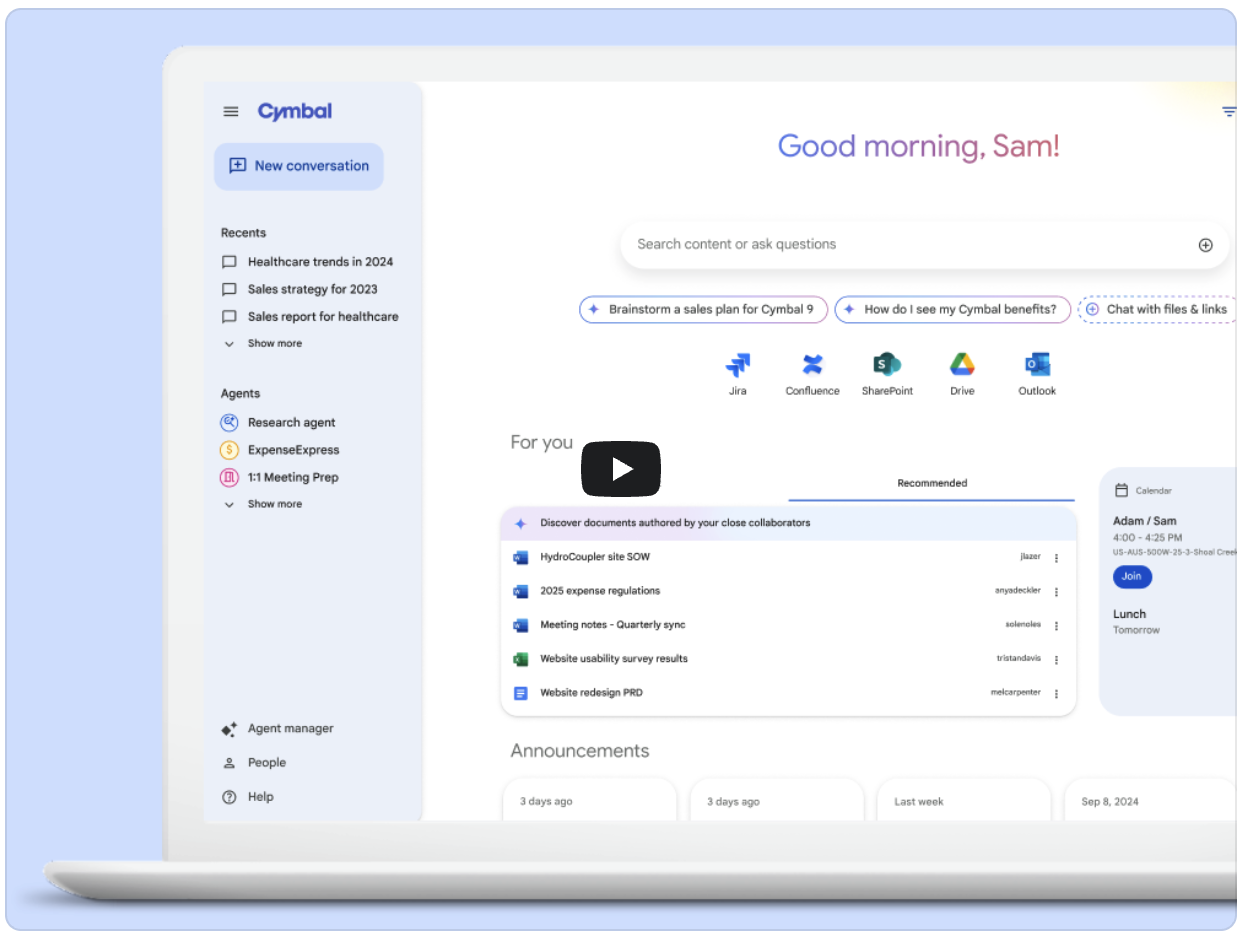

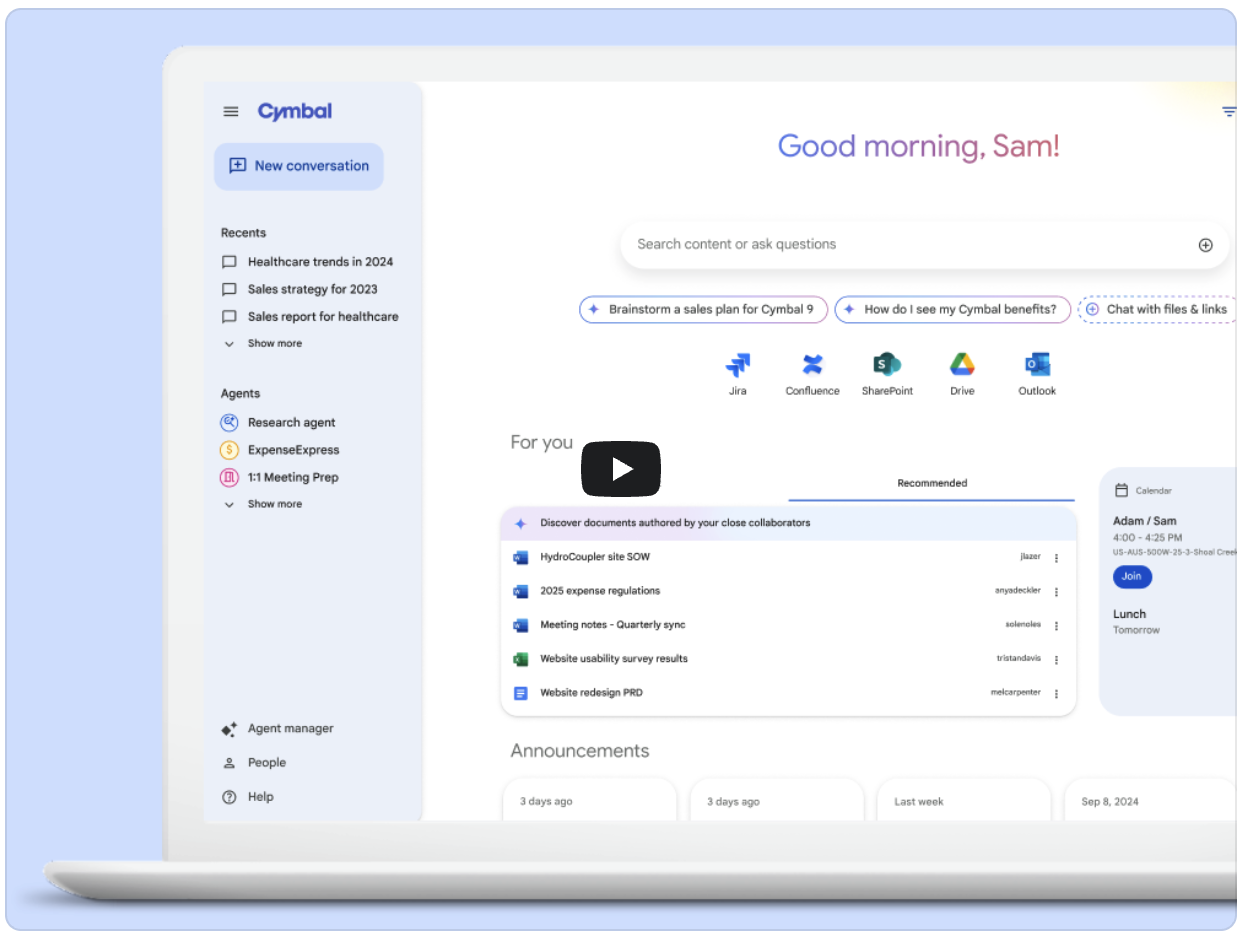

Weitere Informationen zu Agentspace

Mit Google Cloud Agentspace können Sie das Potenzial Ihrer Belegschaft voll ausschöpfen. Mitarbeiter profitieren von sicherem Zugriff auf Unternehmensdaten, KI-gestützter Aufgabenautomatisierung und intelligenten Statistiken, die die Produktivität auf ein neues Level heben.

Unternehmensweiten Zugriff und Nutzung von LLMs verwalten

Mit den nativen Richtlinien und Verteilungsfunktionen von Apigee können Gen AI-Plattformteams KI-Anwendungen und die Verwendung von LLMs effizient verwalten.

Funktionen:

- Integriertes Entwicklerportal für Self-Service-Zugriff auf Modelle

- Detaillierte, richtlinienbasierte Steuerung von Modellzugriff und Nutzungslimits

- Limits für die Tokennutzung überwachen und melden

- LLM-Prüfung und ‑Protokollierung

Ressourcen

Blog: Generative AI-Anwendungen mit Apigee operationalisieren

Mit Apigee, der API-Verwaltungsplattform von Google Cloud, können Unternehmen APIs für ihre KI-Dienste sicher skalieren und verwalten und so auch bei steigender Nutzernachfrage einen zuverlässigen Zugriff gewährleisten.

Zugriff auf APIs durch Registrierung von Anwendungen steuern

Steuern Sie den Zugriff auf Ihre APIs in Apigee, indem Sie Entwickler-Apps registrieren. Diese registrierten Apps werden dann verwendet, um API-Schlüssel zu erhalten, die eine sichere API-Nutzung ermöglichen.

Generative AI mit der API-Verwaltung von Apigee erstellen und skalieren

Generative AI verändert Branchen, aber wie können Sie diese leistungsstarken Modelle effektiv in die Produktion einbinden? In diesem Webinar wird die zentrale Rolle von APIs bei der Operationalisierung von generativer KI untersucht.

KI-Anwendungen leistungsstark und hochverfügbar halten

Apigee bietet eine umfassende Beobachtbarkeit für KI-Anwendungen, damit Sie die Kosten für Generative AI verwalten und optimieren und die KI-Nutzung in Ihrem Unternehmen effizient steuern können.

Funktionen:

- Einblicke in die Modellnutzung und den Tokenverbrauch der Anwendung

- Interne Kostenberichte und -optimierung

- Benutzerdefinierte Dashboards zur Überwachung der Nutzung basierend auf der tatsächlichen Anzahl von Tokens (durch Einbindung von Looker Studio)

- Logging für KI-Anwendungen

Ressourcen

Semantischer Cache in der Apigee-Referenzlösung

Dieses Apigee-Beispiel verwendet zwischengespeicherte Antworten und die Vektorsuche, um ähnliche frühere Anfragen basierend auf der Nähe des Prompts und einem konfigurierbaren Ähnlichkeitsfaktor zu finden.

Muster für LLM-Circuit-Breaking in Apigee

Mit Apigee-Circuit-Breaking lassen sich 429-Fehler in RAG-Anwendungen mit LLMs verhindern, indem der Traffic verwaltet und ordnungsgemäße Fehler sichergestellt werden.

LLM-APIs schützen und gleichzeitig Endnutzer und Marke schützen

Apigee fungiert als sicheres Gateway für LLM-APIs. Sie können den Zugriff mit API-Schlüsseln, OAuth 2.0 und JWT-Validierung steuern und Missbrauch sowie Überlastung durch Ratenbegrenzungen und Kontingente verhindern. Mit der erweiterten API-Sicherheit von Apigee können Sie noch mehr Schutz bieten.

Funktionen:

- Model Armor-Einbindung und Richtliniendurchsetzung für die Bereinigung von Prompts und Antworten

- Authentifizierung und Autorisierung

- Erkennung von Missbrauch und Anomalien

- Minimierung von OWASP-Top-10-API- und LLM-Sicherheitsrisiken

- Erkennung von LLM API-Sicherheitsfehlkonfigurationen

- Google SecOps und Drittanbieter-SIEM-Integration

Ressourcen

Apigee Advanced API Security

Schützen Sie Ihre APIs mit der erweiterten API-Sicherheit von Google Cloud. Dieser Dienst analysiert API-Traffic und -Konfigurationen, um Bedrohungen zu stoppen, ohne die Leistung zu beeinträchtigen. Es identifiziert verdächtige Anfragen, die blockiert werden sollen, und weist auf Fehlkonfigurationen hin.

Whitepaper: OWASP Top 10 API Security Threats mindern

Mit Apigee die OWASP Top 10 API-Angriffe abwehren Sichere Authentifizierung, Autorisierung und Bedrohungserkennung schützen Ihr Unternehmen.

Blog: Ihre APIs vor den Top 10-Sicherheitsbedrohungen der OWASP schützen

Mit Apigee, der API-Verwaltungsplattform von Google Cloud, können Sie Ihre APIs vor den größten Bedrohungen wie fehlerhafter Authentifizierung und Injection-Fehlern schützen.

KI-Gateway

Ein unternehmensgerechtes KI-Gateway implementieren

Die wichtigsten Funktionen des API-Gateways von Apigee umfassen native Funktionen zur Verwaltung des Traffics für KI-Anwendungen und bieten einen konsistenten API-Vertrag für den Dienstverbrauch.

Funktionen:

- Modellabstraktion

- Routing für Multi-Cloud-Modelle

- Anfrage-/Antwortanreicherung

- RAG-Integrationen

- Agent-Konnektivität zu Drittanbietersystemen (mit der Application Integration-Plattform von Google Cloud)

- LLM-Circuit-Breaker-Muster für Hochverfügbarkeit

- Semantisches Caching

Ressourcen

Programmierbare API-Proxys

Wenn Sie Richtlinien an verschiedene Stellen in einem Apigee API-Proxy-Ablauf anhängen, können Sie das API-Verhalten detailliert steuern. Diese Platzierung bestimmt genau, wann jede Richtlinie angewendet wird, wenn Anfragen und Antworten über den Proxy gesendet werden.

Die nächste Generation der Integration: KI-basiert

Nutzen Sie das Potenzial von Generative AI, um erweiterte Automatisierungsworkflows zu erstellen. Hier erfahren Sie, wie Sie über 100 Anwendungen mithilfe einfacher natürlicher Sprache verbinden können. Hier erfahren Sie, wie Sie mit generativen KI-Agents Ihre Abläufe im Google Cloud-Ökosystem optimieren können.

Hugging Face-Modelle aus Vertex AI mit Apigee bereitstellen

Erstellen Sie ein LLM-API-Gateway mit Apigee und Vertex AI. In dieser praktischen Demo wird gezeigt, wie Sie einen Proxy für Ihren LLM-Endpunkt erstellen. Sie ist ideal für Entwickler, die neu in Apigee sind oder KI-APIs einbinden möchten. Hier erfahren Sie, wie Apigee Ihre KI-Anwendungen schützt, verwaltet und optimiert.

KI-Agents

Workflows auf Agent-Ebene, die auf dem Unternehmenskontext basieren

KI-Agenten nutzen die Funktionen von LLMs, um Aufgaben für Endnutzer zu erledigen. Diese Agenten können mithilfe einer Vielzahl von Tools erstellt werden – von No-Code- und Low-Code-Plattformen wie Agentspace bis hin zu Full-Code-Frameworks wie LangChain oder LlamaIndex. Apigee fungiert als Vermittler zwischen Ihrer KI-Anwendung und ihren Agenten.

Mit dem jetzt allgemein verfügbaren Gemini Code Assist in Apigee können Sie API-Spezifikationen schnell mit natürlicher Sprache in den Cloud Code- und Gemini Chat-Benutzeroberflächen erstellen. Wenn Sie das API-Ökosystem Ihrer Organisation über den API-Hub nutzen, erhalten Sie Unternehmenskontext für konsistente, sichere APIs mit Unterstützung für geschachtelte Objekte und proaktive Erkennung doppelter APIs.

Funktionen:

- Apigee API-Hub, um APIs und Workflows von Drittanbietern und selbst erstellte APIs zu katalogisieren

- Durchsetzung des Token-Limits für Kostenkontrollen

- Orchestrierung mehrerer Agenten

- Authentifizierung und Autorisierung

- Semantic Caching für optimierte Leistung

- API-Spezifikationsgenerierung mit Unternehmenskontext (mit Gemini Code Assist)

Ressourcen

Dokumentation: Apigee API-Hub

Mit Apigee API Hub, einer zentralen Plattform in Google Cloud, können Sie alle Ihre APIs entdecken, verwalten und dokumentieren, um die Sichtbarkeit, Kontrolle, Wiederverwendung, Governance und Entwicklung zu verbessern.

Blog: Apigee API-Hub jetzt allgemein verfügbar

Mit dem jetzt allgemein verfügbaren Apigee API-Hub können Sie alle Ihre APIs zentral finden, verwalten und steuern. Diese Plattform bietet einen einheitlichen Überblick über Ihre gesamte API-Landschaft, unabhängig vom Bereitstellungsort. So können Teams Abläufe optimieren und die API-Governance im gesamten Unternehmen stärken.

Weitere Informationen zu Agentspace

Mit Google Cloud Agentspace können Sie das Potenzial Ihrer Belegschaft voll ausschöpfen. Mitarbeiter profitieren von sicherem Zugriff auf Unternehmensdaten, KI-gestützter Aufgabenautomatisierung und intelligenten Statistiken, die die Produktivität auf ein neues Level heben.

KI-Governance

Unternehmensweiten Zugriff und Nutzung von LLMs verwalten

Mit den nativen Richtlinien und Verteilungsfunktionen von Apigee können Gen AI-Plattformteams KI-Anwendungen und die Verwendung von LLMs effizient verwalten.

Funktionen:

- Integriertes Entwicklerportal für Self-Service-Zugriff auf Modelle

- Detaillierte, richtlinienbasierte Steuerung von Modellzugriff und Nutzungslimits

- Limits für die Tokennutzung überwachen und melden

- LLM-Prüfung und ‑Protokollierung

Ressourcen

Blog: Generative AI-Anwendungen mit Apigee operationalisieren

Mit Apigee, der API-Verwaltungsplattform von Google Cloud, können Unternehmen APIs für ihre KI-Dienste sicher skalieren und verwalten und so auch bei steigender Nutzernachfrage einen zuverlässigen Zugriff gewährleisten.

Zugriff auf APIs durch Registrierung von Anwendungen steuern

Steuern Sie den Zugriff auf Ihre APIs in Apigee, indem Sie Entwickler-Apps registrieren. Diese registrierten Apps werden dann verwendet, um API-Schlüssel zu erhalten, die eine sichere API-Nutzung ermöglichen.

Generative AI mit der API-Verwaltung von Apigee erstellen und skalieren

Generative AI verändert Branchen, aber wie können Sie diese leistungsstarken Modelle effektiv in die Produktion einbinden? In diesem Webinar wird die zentrale Rolle von APIs bei der Operationalisierung von generativer KI untersucht.

Beobachtbarkeit von KI

KI-Anwendungen leistungsstark und hochverfügbar halten

Apigee bietet eine umfassende Beobachtbarkeit für KI-Anwendungen, damit Sie die Kosten für Generative AI verwalten und optimieren und die KI-Nutzung in Ihrem Unternehmen effizient steuern können.

Funktionen:

- Einblicke in die Modellnutzung und den Tokenverbrauch der Anwendung

- Interne Kostenberichte und -optimierung

- Benutzerdefinierte Dashboards zur Überwachung der Nutzung basierend auf der tatsächlichen Anzahl von Tokens (durch Einbindung von Looker Studio)

- Logging für KI-Anwendungen

Ressourcen

Semantischer Cache in der Apigee-Referenzlösung

Dieses Apigee-Beispiel verwendet zwischengespeicherte Antworten und die Vektorsuche, um ähnliche frühere Anfragen basierend auf der Nähe des Prompts und einem konfigurierbaren Ähnlichkeitsfaktor zu finden.

Muster für LLM-Circuit-Breaking in Apigee

Mit Apigee-Circuit-Breaking lassen sich 429-Fehler in RAG-Anwendungen mit LLMs verhindern, indem der Traffic verwaltet und ordnungsgemäße Fehler sichergestellt werden.

Sicherheit und Datenschutz bei KI

LLM-APIs schützen und gleichzeitig Endnutzer und Marke schützen

Apigee fungiert als sicheres Gateway für LLM-APIs. Sie können den Zugriff mit API-Schlüsseln, OAuth 2.0 und JWT-Validierung steuern und Missbrauch sowie Überlastung durch Ratenbegrenzungen und Kontingente verhindern. Mit der erweiterten API-Sicherheit von Apigee können Sie noch mehr Schutz bieten.

Funktionen:

- Model Armor-Einbindung und Richtliniendurchsetzung für die Bereinigung von Prompts und Antworten

- Authentifizierung und Autorisierung

- Erkennung von Missbrauch und Anomalien

- Minimierung von OWASP-Top-10-API- und LLM-Sicherheitsrisiken

- Erkennung von LLM API-Sicherheitsfehlkonfigurationen

- Google SecOps und Drittanbieter-SIEM-Integration

Ressourcen

Apigee Advanced API Security

Schützen Sie Ihre APIs mit der erweiterten API-Sicherheit von Google Cloud. Dieser Dienst analysiert API-Traffic und -Konfigurationen, um Bedrohungen zu stoppen, ohne die Leistung zu beeinträchtigen. Es identifiziert verdächtige Anfragen, die blockiert werden sollen, und weist auf Fehlkonfigurationen hin.

Whitepaper: OWASP Top 10 API Security Threats mindern

Mit Apigee die OWASP Top 10 API-Angriffe abwehren Sichere Authentifizierung, Autorisierung und Bedrohungserkennung schützen Ihr Unternehmen.

Blog: Ihre APIs vor den Top 10-Sicherheitsbedrohungen der OWASP schützen

Mit Apigee, der API-Verwaltungsplattform von Google Cloud, können Sie Ihre APIs vor den größten Bedrohungen wie fehlerhafter Authentifizierung und Injection-Fehlern schützen.

Entwicklerressourcen

Hier erfahren Sie, wie Sie mit Apigee das volle Potenzial Ihrer Generative-AI-Projekte ausschöpfen können.

Apigee AI-Lösungen für Ihren Anwendungsfall

KI-Anwendungen mit Apigee schützen

Verwenden Sie Apigee als Richtlinien-Erzwingungspunkt für die Prompt- und Antwort-Sanierung von Model Armor und verringern Sie die OWASP-LLM- und API-Top-10-Sicherheitsrisiken.

Möchten Sie das volle Potenzial von KI ausschöpfen?

Möchten Sie das volle Potenzial von KI ausschöpfen?

Mit Apigee das Potenzial generativer KI für Ihre Lösungen nutzen Nutzen Sie die robusten Funktionen zur Operationalisierung von Apigee, um sichere, skalierbare und optimierte Bereitstellungen mit Zuversicht zu erstellen.

Sind Sie bereit? Sehen Sie sich unsere Apigee-Seite mit Generative-AI-Beispielen an.