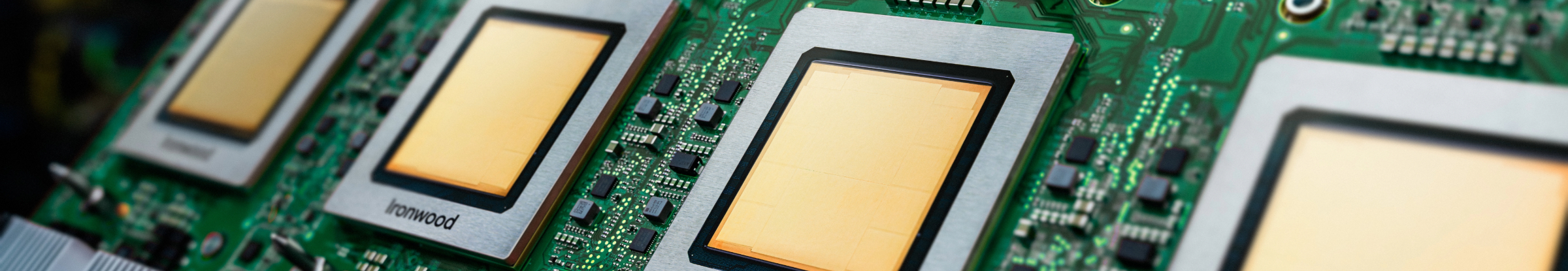

Ironwood: 推論用に設計された Google Cloud の第 7 世代 TPU

これまでで最もパワフルな TPU で、大規模なモデルやデータセットを効率的にトレーニング、ファインチューニング、サービングします。

Ironwood の詳細については、お問い合わせください。

- (+1)

- アイスランド

- アイルランド

- アセンション島

- アゼルバイジャン

- アフガニスタン

- アメリカ合衆国

- アラブ首長国連邦

- アルジェリア

- アルゼンチン

- アルバ

- アルバニア

- アルメニア

- アンギラ

- アンゴラ

- アンティグア・バーブーダ

- アンドラ

- イエメン

- イギリス

- イスラエル

- イタリア

- イラク

- インド

- インドネシア

- ウォリス・フツナ

- ウガンダ

- ウクライナ

- ウズベキスタン

- ウルグアイ

- エクアドル

- エジプト

- エストニア

- エスワティニ

- エチオピア

- エリトリア

- エルサルバドル

- オマーン

- オランダ

- オーストラリア

- オーストリア

- カザフスタン

- カタール

- カナダ

- カメルーン

- カンボジア

- カーボベルデ

- ガイアナ

- ガボン

- ガンビア

- ガーナ

- キプロス

- キュラソー

- キリバス

- キルギス

- ギニア

- ギニアビサウ

- ギリシャ

- クウェート

- クック諸島

- クリスマス島

- クロアチア

- グアテマラ

- グアドループ

- グアム

- グリーンランド

- グレナダ

- ケイマン諸島

- ケニア

- ココス(キーリング)諸島

- コスタリカ

- コモロ

- コロンビア

- コンゴ共和国(ブラザビル)

- コンゴ民主共和国(キンシャサ)

- コートジボワール

- サウジアラビア

- サウスジョージア・サウスサンドウィッチ諸島

- サモア

- サントメ・プリンシペ

- サンピエール島・ミクロン島

- サンマリノ

- サン・バルテルミー

- サン・マルタン

- ザンビア

- シエラレオネ

- シンガポール

- シント・マールテン

- ジブチ

- ジブラルタル

- ジャマイカ

- ジョージア

- ジンバブエ

- スイス

- スウェーデン

- スバールバル諸島・ヤンマイエン島

- スペイン

- スリナム

- スリランカ

- スロバキア

- スロベニア

- セネガル

- セルビア

- セントクリストファー・ネーヴィス

- セントビンセント及びグレナディーン諸島

- セントヘレナ

- セントルシア

- セーシェル

- ソマリア

- ソロモン諸島

- タイ

- タジキスタン

- タンザニア

- タークス・カイコス諸島

- チェコ

- チャド

- チュニジア

- チリ

- ツバル

- デンマーク

- トケラウ

- トリニダード・トバゴ

- トルクメニスタン

- トルコ

- トンガ

- トーゴ

- ドイツ

- ドミニカ共和国

- ドミニカ国

- ナイジェリア

- ナウル

- ナミビア

- ニウエ

- ニカラグア

- ニジェール

- ニューカレドニア

- ニュージーランド

- ネパール

- ノルウェー

- ノーフォーク島

- ハイチ

- ハンガリー

- ハード島・マクドナルド諸島

- バチカン市国

- バヌアツ

- バハマ

- バミューダ

- バルバドス

- バングラデシュ

- バーレーン

- パキスタン

- パナマ

- パプアニューギニア

- パラオ

- パラグアイ

- パレスチナ

- ピトケアン諸島

- フィジー

- フィリピン

- フィンランド

- フェロー諸島

- フォークランド諸島 (マルビーナス諸島)

- フランス

- ブラジル

- ブルガリア

- ブルキナファソ

- ブルネイ

- ブルンジ

- ブータン

- ブーベ島

- プエルトリコ

- ベトナム

- ベナン

- ベネズエラ

- ベラルーシ

- ベリーズ

- ベルギー

- ペルー

- ホンジュラス

- ボスニア・ヘルツェゴビナ

- ボツワナ

- ボリビア

- ポルトガル

- ポーランド

- マカオ

- マダガスカル

- マヨット

- マラウイ

- マリ

- マルタ

- マルティニーク

- マレーシア

- マーシャル諸島

- ミクロネシア連邦

- ミャンマー (ビルマ)

- メキシコ

- モザンビーク

- モナコ

- モルディブ

- モルドバ

- モロッコ

- モンゴル

- モンテネグロ

- モントセラト

- モーリシャス

- モーリタニア

- ヨルダン

- ラオス

- ラトビア

- リトアニア

- リヒテンシュタイン

- リビア

- リベリア

- ルクセンブルク

- ルワンダ

- ルーマニア

- レソト

- レバノン

- レユニオン

- ロシア

- 中国

- 中央アフリカ共和国

- 仏領ギアナ

- 仏領ポリネシア

- 仏領極南諸島

- 北マケドニア

- 北マリアナ諸島

- 南アフリカ

- 南スーダン

- 南極

- 台湾

- 合衆国領有小離島

- 日本

- 東ティモール

- 米領サモア

- 米領ヴァージン諸島

- 英領インド洋地域

- 英領ヴァージン諸島

- 西サハラ

- 赤道ギニア

- 韓国

- 香港

貴社のインフラストラクチャは推論の時代に対応していますか?

Ironwood は、これまでで最もパワフルで高性能、かつエネルギー効率に優れた Tensor Processing Unit(TPU)で、大規模な思考型・推論型 AI モデルを支えるために設計されています。Google の社内サービスと Google Cloud のお客様向けに TPU を開発してきた豊富な経験に基づいて、Ironwood は、大規模言語モデル(LLM)、Mixture of Experts(MoE)、高度な推論タスクなどのモデルの計算とメモリの要求に対応するように設計されています。Google Cloud の AI ハイパーコンピュータ アーキテクチャ内でトレーニングとサービングの両方のワークロードをサポートします。

大規模言語モデル(LLM)向けに最適化: Ironwood は、LLM や生成 AI アプリケーションの需要の高まりに対応できるように特別に設計されています。

相互接続技術の強化: TPU の相互接続技術の向上により、通信がより高速化され、レイテンシが低減されます。

ハイ パフォーマンス コンピューティング: 幅広い推論タスクで大幅なパフォーマンス向上を実現します。

サステナブルな AI: Ironwood は、Google Cloud のサステナビリティへの取り組みを継続し、最適化されたエネルギー効率で優れたパフォーマンスを実現します。

Ironwood は、計算密度、メモリ容量、相互接続帯域幅を増加させ、電力効率を大幅に向上させます。これらの機能は、要求の厳しい AI のトレーニングおよびサービングのワークロード、特に大規模で複雑なモデルを扱うワークロードで、高スループットと低レイテンシを実現できるように設計されています。Ironwood TPU は、Google Cloud の AI ハイパーコンピュータ アーキテクチャ内で動作します。

Cloud AI プロダクトは、Google の SLA ポリシーに準拠しています。これらの SLA ポリシーで保証されているレイテンシや可用性は、他の Google Cloud サービスと異なる場合があります。