Pub/Sub

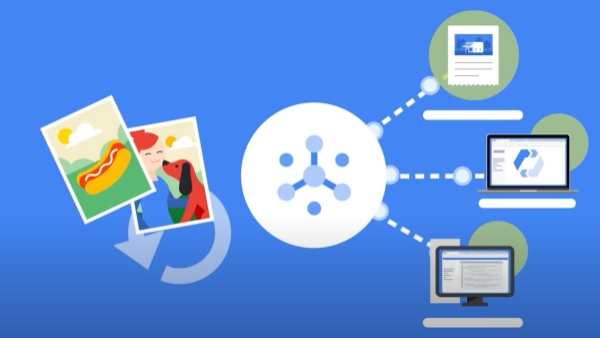

Ingérez des événements pour les insérer en flux dans BigQuery, des lacs de données ou des bases de données opérationnelles.

Les nouveaux clients bénéficient de 300 $ de crédits gratuits à dépenser sur Pub/Sub. Tous les clients disposent d'un espace de stockage gratuit de 10 Go par mois pour l'ingestion ou la distribution de messages, non déduit de vos crédits.

Déployez un exemple de solution d'entrepôt de données pour explorer, analyser et visualiser des données à l'aide de BigQuery et Looker Studio. Enfin, appliquez l'IA générative pour résumer les résultats de l'analyse.

Système de messagerie ou de file d'attente no-ops, sécurisé et évolutif

Diffusion des messages au moins une fois, dans l'ordre et dans n'importe quel ordre avec les modes pull et push

Sécurisez les données avec des contrôles d'accès précis et un chiffrement permanent.

Avantages

Haute disponibilité simplifiée

Le suivi synchrone et interzone des réplications de messages et des accusés de réception par message garantit une distribution fiable à n'importe quelle échelle.

Zéro planification et automatisation complète

Les fonctionnalités d'autoscaling et de provisionnement automatique sans partitions vous dispensent de planification et garantissent que les charges de travail sont prêtes pour la production dès le premier jour.

Base simple et ouverte pour les systèmes de données en temps réel

Cette solution est un moyen rapide et fiable d'envoyer de petits enregistrements à n'importe quel volume, un point d'entrée pour les pipelines en temps réel et par lot qui alimentent BigQuery, les lacs de données et les bases de données opérationnelles. Utilisez-la avec des pipelines ETL/ELT dans Dataflow.

Principales fonctionnalités

Principales fonctionnalités

Analyses de flux et connecteurs

L'intégration native à Dataflow permet le traitement et l'intégration de type "exactement une fois" fiables et expressifs des flux d'événements dans Java, Python et SQL.

Diffusion dans l'ordre à grande échelle

Le tri par clé facultative (bêta) simplifie la logique des applications avec état sans impact sur le scaling horizontal ; aucune partition n'est requise.

Ingestion en flux continu simplifiée grâce à des intégrations natives

Ingérez des flux de données depuis Pub/Sub directement dans BigQuery ou Cloud Storage avec nos abonnements natifs.

Clients

Découvrez comment nos clients utilisent Pub/Sub

Nouveautés

Nouveautés

Inscrivez-vous à la newsletter Google Cloud pour recevoir des informations sur les produits et événements, des offres spéciales et bien plus encore.

Documentation

Cas d'utilisation

Cas d'utilisation

Analyse de flux

L'analyse de flux de Google permet de mieux organiser les données, et de les rendre utiles et accessibles dès qu'elles sont générées. Basées sur Pub/Sub, Dataflow et BigQuery, nos solutions de streaming assurent le provisionnement des ressources dont vous avez besoin pour ingérer, traiter et analyser des volumes fluctuants de données en temps réel afin d'obtenir des insights métier instantanés. Ce provisionnement distinct réduit la complexité et rend les analyses de flux accessibles aux analystes et aux ingénieurs de données.

Intégration asynchrone de microservices

Pub/Sub fonctionne comme un middleware de messagerie pour l'intégration de services traditionnels ou comme un simple moyen de communication pour les microservices modernes. Les abonnements Push diffusent des événements aux webhooks sans serveur sur Cloud Functions, App Engine, Cloud Run ou des environnements personnalisés sur Google Kubernetes Engine ou Compute Engine. La diffusion pull à faible latence est disponible lorsque l'exposition des webhooks n'est pas possible ou pour permettre la gestion efficace des flux de débit plus importants.

Toutes les fonctionnalités

Toutes les fonctionnalités

| Distribution de type "au moins une fois" | Le suivi synchrone et interzone des réplications de messages et des accusés de réception par message garantit une distribution de type "au moins une fois" à n'importe quelle échelle. |

| Ouvrir | Les API ouvertes et les bibliothèques clientes dans sept langages permettent des déploiements hybrides et sur plusieurs clouds. |

| Traitement de type "exactement une fois" | Dataflow permet le traitement de type "exactement une fois" fiable et expressif des flux Pub/Sub. |

| Zéro provisionnement et automatisation complète | Pub/Sub ne comporte ni segments, ni partitions. Définissez simplement votre quota, publiez et consommez. |

| Conformité et sécurité | Pub/Sub est un service conforme à la loi HIPAA, offrant un contrôle ultraprécis des accès et un chiffrement de bout en bout. |

| Intégrations Google Cloud natives | Tirez parti des intégrations à plusieurs services tels que les événements de mise à jour Cloud Storage et Gmail, et Cloud Functions pour le calcul informatique basé sur des événements et sans serveur. |

| Intégrations tierces et OSS | Pub/Sub offre des intégrations tierces : Splunk et Datadog pour les journaux, Striim et Informatica pour l'intégration des données. De plus, les intégrations OSS sont disponibles via Confluent Cloud pour Apache Kafka et Knative Eventing pour les charges de travail sans serveur basées sur Kubernetes. |

| Recherche et répétition | Remontez à n'importe quel moment dans le temps ou utilisez un instantané afin de traiter à nouveau les messages. Avancez pour supprimer les données obsolètes. |

| Sujets des lettres mortes | La fonctionnalité Sujets des lettres mortes permet de mettre de côté les messages qui n'ont pas pu être traités par les applications de l'abonné afin de procéder à l'examen et au débogage hors ligne de ces derniers, et d'éviter de retarder le traitement des autres messages. |

| Filtrage | Pub/Sub peut filtrer les messages en fonction d'attributs afin de réduire les volumes de diffusion de messages aux abonnés. |

Tarification

Tarifs

Les tarifs de Pub/Sub sont calculés en fonction des volumes de données mensuels. Les 100 premiers Go de données du mois sont gratuits.

Volume de données mensuel1 | Prix par Tio2 |

|---|---|

10 premiers Go | 0,00 $ |

Au-delà de 10 Go | 40,00 $ |

1 Pour obtenir des informations détaillées sur les prix, consultez notre grille tarifaire.

2 "Tio" fait référence à "tébioctet", soit 240 octets.

Si vous ne payez pas en USD, les tarifs indiqués dans votre devise sur la page des codes SKU Cloud Platform s'appliquent.

Passez à l'étape suivante

Profitez de 300 $ de crédits gratuits et de plus de 20 produits Always Free pour commencer à créer des applications sur Google Cloud.

Vous avez besoin d'aide pour démarrer ?

Contacter le service commercialFaites appel à un partenaire de confiance

Trouvez un partenairePoursuivez vos recherches

Voir tous les produits