Questo documento descrive come creare e gestire i bucket Cloud Logging utilizzando la console Google Cloud , Google Cloud CLI e l'API Logging .

Fornisce inoltre istruzioni per la creazione e la gestione dei bucket di log a livello di progettoGoogle Cloud . Non puoi creare bucket di log a livello di cartella o organizzazione. Tuttavia, Cloud Logging crea automaticamente i bucket di log _Default e _Required a livello di cartella e organizzazione.

Puoi eseguire l'upgrade dei bucket di log per utilizzare Analisi dei log. L'analisi dei log consente di eseguire query SQL sui dati di log, aiutandoti a risolvere i problemi di applicazioni, sicurezza e networking.

Per utilizzare BigQuery per analizzare i dati di log, hai due opzioni:

Esegui l'upgrade di un bucket di log per utilizzare l'analisi dei log e poi crea un set di dati BigQuery collegato. In questo scenario, Logging archivia i dati di log, ma BigQuery può leggerli.

Esporta le voci di log in BigQuery. In questo scenario, devi creare un sink, BigQuery archivia e gestisce i dati e hai la possibilità di utilizzare tabelle partizionate.

Quando i dati di log sono disponibili per BigQuery, puoi unirli ad altri dati archiviati in BigQuery e puoi accedere a questi dati da altri strumenti come Looker Studio e Looker.

Per una panoramica concettuale dei bucket, consulta Panoramica su routing e archiviazione: bucket di log.

Questo documento non descrive come creare un bucket di log che utilizza una chiave di crittografia gestita dal cliente (CMEK). Se ti interessa l'argomento, consulta Configurare CMEK per l'archiviazione dei log.

Prima di iniziare

Per iniziare a utilizzare i bucket:

- Configura il tuo progetto Google Cloud :

-

Verify that billing is enabled for your Google Cloud project.

-

Per ottenere le autorizzazioni necessarie per creare, eseguire l'upgrade e collegare un bucket dei log, chiedi all'amministratore di concederti il ruolo IAM Logs Configuration Writer (

roles/logging.configWriter) nel progetto. Per saperne di più sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.Potresti anche riuscire a ottenere le autorizzazioni richieste tramite i ruoli personalizzati o altri ruoli predefiniti.

Per l'elenco completo di autorizzazioni e ruoli, consulta Controllo dell'accesso con IAM.

- (Facoltativo) Per utilizzare BigQuery per visualizzare i dati archiviati in un

bucket log, procedi nel seguente modo:

- Assicurati che l'API BigQuery sia abilitata. Puoi verificare che l'API sia abilitata elencando i servizi disponibili.

- Il tuo ruolo Identity and Access Management include le autorizzazioni che ti consentono di creare un set di dati collegato. Per ulteriori informazioni, consulta Autorizzazioni per i set di dati BigQuery collegati.

-

- Comprendere le regioni supportate in cui puoi archiviare i log.

-

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

gcloud

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

REST

Per utilizzare gli esempi di API REST in questa pagina in un ambiente di sviluppo locale, utilizza le credenziali che fornisci a gcloud CLI.

Installa Google Cloud CLI. Dopo l'installazione, inizializza Google Cloud CLI eseguendo il seguente comando:

gcloud initSe utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

Per saperne di più, consulta Autenticarsi per l'utilizzo di REST nella documentazione sull'autenticazione di Google Cloud .

- Se prevedi di utilizzare Google Cloud CLI o l'API Cloud Logging per creare o gestire i bucket di log, comprendi i requisiti di formattazione

LogBucket.Crea un bucket

Puoi creare un massimo di 100 bucket per Google Cloud progetto.

Per creare un bucket di log definito dall'utente per il tuo progetto Google Cloud :

Console Google Cloud

Per creare un bucket di log nel tuo progetto Google Cloud :

-

Nella console Google Cloud , vai alla pagina Archiviazione dei log:

Se utilizzi la barra di ricerca per trovare questa pagina, seleziona il risultato con il sottotitolo Logging.

Fai clic su Crea bucket di log.

Inserisci un nome e una descrizione per il bucket.

(Facoltativo) Esegui l'upgrade del bucket per utilizzare Analisi dei log.

Seleziona Esegui l'upgrade per utilizzare Analisi dei log.

Quando esegui l'upgrade di un bucket per utilizzare Analisi dei log, puoi eseguire query sui log nella pagina Analisi dei log utilizzando query SQL. Puoi anche continuare a visualizzare i log utilizzando Esplora log.

(Facoltativo) Per visualizzare i log in BigQuery, seleziona Crea un nuovo set di dati BigQuery che si colleghi a questo bucket e inserisci un nome univoco per il set di dati.

Quando selezioni questa opzione, BigQuery può leggere i dati archiviati nel bucket di log. Ora puoi eseguire query nell'interfaccia BigQuery, dove puoi unire i dati di log e accedere anche ai dati di altri strumenti come Looker Studio e Looker.

(Facoltativo) Per selezionare la regione di archiviazione per i log, fai clic sul menu Seleziona la regione del bucket di log e seleziona una regione. Se non selezioni una regione, viene utilizzata la regione

global, il che significa che i log potrebbero trovarsi fisicamente in qualsiasi regione supportata.(Facoltativo) Per impostare un periodo di conservazione personalizzato per i log nel bucket, fai clic su Avanti.

Nel campo Periodo di conservazione, inserisci il numero di giorni, tra 1 e 3650, durante i quali vuoi che Cloud Logging conservi i log. Se non personalizzi il periodo di conservazione, il valore predefinito è

30 days.Puoi anche aggiornare il bucket per applicare la conservazione personalizzata dopo averlo creato.

Fai clic su Crea bucket.

Dopo la creazione del bucket di log, Logging esegue l'upgrade del bucket e crea il collegamento al set di dati, se queste opzioni sono state selezionate.

Il completamento di questi passaggi potrebbe richiedere alcuni istanti.

gcloud

Per creare solo un bucket log, esegui il comando

gcloud logging buckets create. Se vuoi eseguire l'upgrade del bucket di log per utilizzare Analisi dei log, includi i flag--enable-analyticse--asynce assicurati di impostare la variabile LOCATION su una regione supportata:gcloud logging buckets create BUCKET_ID --location=LOCATION --enable-analytics --async OPTIONAL_FLAGS

Il flag

--asyncforza l'esecuzione asincrona del comando. Il valore restituito di un metodo asincrono è un oggettoOperation, che contiene informazioni sullo stato di avanzamento del metodo. Al termine del metodo, l'oggettoOperationcontiene lo stato. Per ulteriori informazioni, consulta Metodi API asincroni.Se non vuoi eseguire l'upgrade del bucket di log per utilizzare Analisi dei log, ometti i flag

--enable-analyticse--async.Ad esempio, se vuoi creare un bucket con BUCKET_ID

my-bucketnella regioneglobal, il comando sarà simile al seguente:gcloud logging buckets create my-bucket --location global --description "My first bucket"

Ad esempio, per creare un bucket con BUCKET_ID

my-upgraded-bucketnella localitàglobale poi eseguire l'upgrade del bucket di log per utilizzare Analisi dei log, il comando sarà simile al seguente:gcloud logging buckets create my-upgraded-bucket --location global \ --description "My first upgraded bucket" \ --enable-analytics --retention-days=45REST

Per creare un bucket, utilizza il metodo

projects.locations.buckets.createoprojects.locations.buckets.createAsync. Prepara gli argomenti per il metodo nel seguente modo:Imposta il parametro

parentin modo che corrisponda alla risorsa in cui creare il bucket:projects/PROJECT_ID/locations/LOCATIONLa variabile LOCATION si riferisce alla regione in cui vuoi che vengano archiviati i log.

Ad esempio, se vuoi creare un bucket per il progetto

my-projectnella regioneglobal, il parametroparentsarà simile a questo:projects/my-project/locations/globalImposta il parametro

bucketId, ad esempiomy-bucket.Esegui una delle seguenti operazioni:

Per creare un bucket di log ed eseguire l'upgrade del bucket di log per utilizzare Analisi dei log:

Imposta il valore booleano

LogBucket.analyticsEnabledsutrue.Chiama il metodo asincrono

projects.locations.buckets.createAsyncper creare il bucket.La risposta ai metodi asincroni è un oggetto

Operation. Questo oggetto contiene informazioni sullo stato di avanzamento del metodo. Al termine del metodo, l'oggettoOperationcontiene lo stato. Per ulteriori informazioni, consulta Metodi API asincroni.Il completamento del metodo

createAsyncrichiede diversi minuti. Questo metodo non genera un messaggio di errore o non va a buon fine quando il valore booleanoanalyticsEnabledè impostato sutrue.

In caso contrario, chiama il metodo sincrono

projects.locations.buckets.createper creare il bucket.

Dopo aver creato un bucket, crea un sink per indirizzare le voci di log al bucket e configura le visualizzazioni dei log per controllare chi può accedere ai log nel nuovo bucket e quali log sono accessibili. Puoi anche aggiornare il bucket per configurare la conservazione personalizzata e i campi con limitazioni.

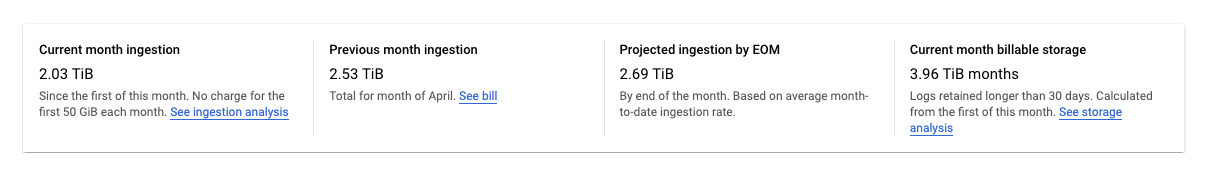

Monitorare il volume dei log archiviati nei bucket di log

La pagina Archiviazione dei log nella console Google Cloud monitora il volume di dati dei log archiviati nei bucket di log:

Nella console Google Cloud , vai alla pagina Archiviazione dei log:

Se utilizzi la barra di ricerca per trovare questa pagina, seleziona il risultato con il sottotitolo Logging.

La pagina Archiviazione log mostra un riepilogo delle statistiche per il tuo progettoGoogle Cloud :

Vengono riportate le seguenti statistiche:

Importazione del mese corrente: la quantità di dati dei log che il tuo progettoGoogle Cloud ha archiviato nei bucket di log dal primo giorno del mese di calendario corrente.

Inserimento del mese precedente: la quantità di dati di log che il tuo progettoGoogle Cloud ha archiviato nei bucket di log nell'ultimo mese di calendario.

Importazione prevista entro la fine del mese: la quantità stimata di dati di log che il tuo progettoGoogle Cloud archivierà nei bucket di log entro la fine del mese di calendario corrente, in base all'utilizzo attuale.

Archiviazione fatturabile nel mese corrente: la quantità di dati dei log conservati per più di 30 giorni che viene fatturata.

Le statistiche precedenti non includono i log nel bucket

_Required. I log in questo bucket non possono essere esclusi o disattivati.La pagina Log Router nella console Google Cloud ti offre strumenti che puoi utilizzare per ridurre al minimo gli addebiti per l'archiviazione dei log nei bucket di log o per lo spazio di archiviazione che supera la quota mensile. Puoi:

- Disattiva l'archiviazione dei log a livello di bucket.

- Escludi determinate voci di log dall'archiviazione nei bucket di log.

Per saperne di più, consulta Gestire i sink.

Gestire i bucket

Questa sezione descrive come gestire i bucket di log utilizzando la Google Cloud CLI o la console Google Cloud .

Aggiorna un bucket

Per aggiornare le proprietà del bucket, ad esempio la descrizione o il periodo di conservazione, segui questi passaggi:Console Google Cloud

Per aggiornare le proprietà del bucket:

-

Nella console Google Cloud , vai alla pagina Archiviazione dei log:

Se utilizzi la barra di ricerca per trovare questa pagina, seleziona il risultato con il sottotitolo Logging.

Per il bucket che vuoi aggiornare, fai clic su more_vert Altro.

Seleziona Modifica bucket.

Modifica il bucket in base alle esigenze.

Fai clic su Aggiorna bucket.

gcloud

Per aggiornare le proprietà del bucket, esegui il comando

gcloud logging buckets update:gcloud logging buckets update BUCKET_ID --location=LOCATION UPDATED_ATTRIBUTES

Ad esempio:

gcloud logging buckets update my-bucket --location=global --description "Updated description"

REST

Per aggiornare le proprietà del bucket, utilizza

projects.locations.buckets.patchnell'API Logging.Eseguire l'upgrade di un bucket per utilizzare Analisi dei log

Dopo aver eseguito l'upgrade di un bucket per utilizzare Analisi dei log, tutte le nuove voci di log che arrivano sono disponibili per l'analisi nell'interfaccia di Analisi dei log. Cloud Logging avvia anche un'operazione di backfill, che ti consente di analizzare le voci di log precedenti scritte prima dell'upgrade. Il processo di backfill potrebbe richiedere diverse ore. Non puoi annullare un'operazione di upgrade su un bucket.

Per eseguire l'upgrade di un bucket esistente per utilizzare Analisi dei log, si applicano le seguenti limitazioni:

- Il bucket di log è stato creato a livello di progetto Google Cloud .

- Il bucket di log è sbloccato, a meno che non si tratti del bucket

_Required. Non sono presenti aggiornamenti in attesa per il bucket.

Console Google Cloud

Per eseguire l'upgrade di un bucket esistente per utilizzare Analisi dei log:

-

Nella console Google Cloud , vai alla pagina Archiviazione dei log:

Se utilizzi la barra di ricerca per trovare questa pagina, seleziona il risultato con il sottotitolo Logging.

Individua il bucket di cui vuoi eseguire l'upgrade.

Quando la colonna Analisi dei log disponibile mostra Upgrade, puoi eseguire l'upgrade del bucket di log per utilizzare Analisi dei log. Fai clic su Esegui upgrade.

Si apre una finestra di dialogo. Fai clic su Conferma.

gcloud

Per eseguire l'upgrade del bucket di log per utilizzare Analisi dei log, esegui il comando

gcloud logging buckets update. Devi impostare il flag--enable-analyticse ti consigliamo di includere anche il flag--async:gcloud logging buckets update BUCKET_ID --location=LOCATION --enable-analytics --async

Il flag

--asyncforza l'esecuzione asincrona del comando. Il valore restituito di un metodo asincrono è un oggettoOperatione contiene informazioni sullo stato di avanzamento del metodo. Al termine del metodo, l'oggettoOperationcontiene lo stato. Per ulteriori informazioni, consulta Metodi API asincroni.REST

Per eseguire l'upgrade di un bucket di log per utilizzare Analisi dei log, utilizza il metodo

projects.locations.buckets.updateAsyncdell'API Cloud Logging.Prepara gli argomenti per il metodo nel seguente modo:

- Imposta il valore booleano

LogBucket.analyticsEnabledsutrue. - Per il parametro di query del comando, utilizza

updateMask=analyticsEnabled.

La risposta ai metodi asincroni è un oggetto

Operation. Questo oggetto contiene informazioni sullo stato di avanzamento del metodo. Al termine del metodo, l'oggettoOperationcontiene lo stato. Per saperne di più, vedi Metodi API asincroni.Il completamento dell'

updateAsyncpotrebbe richiedere diversi minuti.Crea un set di dati BigQuery collegato

Se vuoi utilizzare le funzionalità di BigQuery per analizzare i dati di log, esegui l'upgrade di un bucket di log per utilizzare l'analisi dei log, quindi crea un set di dati collegato. Con questa configurazione, Logging archivia i dati di log, ma BigQuery può leggerli.

Console Google Cloud

Per creare un link a un set di dati BigQuery per un bucket di log esistente, procedi nel seguente modo:

-

Nella console Google Cloud , vai alla pagina Archiviazione dei log:

Se utilizzi la barra di ricerca per trovare questa pagina, seleziona il risultato con il sottotitolo Logging.

Individua il bucket dei log e verifica che la colonna Log Analytics disponibile mostri Apri.

Se questa colonna mostra Esegui upgrade, significa che non è stato eseguito l'upgrade del bucket di log per utilizzare Analisi dei log. Configura Log Analytics:

- Fai clic su Esegui upgrade.

- Fai clic su Conferma nella finestra di dialogo.

Al termine dell'upgrade, vai al passaggio successivo.

Nel bucket di log, fai clic su Altromore_vert e poi su Modifica bucket.

Si apre la finestra di dialogo Modifica bucket log.

Seleziona Crea un nuovo set di dati BigQuery che si colleghi a questo bucket e inserisci il nome del nuovo set di dati.

Il nome del set di dati deve essere univoco per ogni Google Cloud progetto. Se inserisci il nome di un set di dati esistente, ricevi il seguente errore:

Dataset name must be unique in the selected region.Fai clic su Fine, quindi su Aggiorna bucket.

Dopo che Logging mostra il nome del set di dati collegato nella pagina Archiviazione log, potrebbero essere necessari diversi minuti prima che BigQuery riconosca il set di dati.

gcloud

Per creare un set di dati collegato per un bucket di log di cui è stato eseguito l'upgrade per utilizzare Analisi dei log, esegui il comando

gcloud logging links create:gcloud logging links create LINK_ID --bucket=BUCKET_ID --location=LOCATION

Il LINK_ID che fornisci viene utilizzato come nome del set di dati BigQuery e il valore di questo campo deve essere univoco per il tuo progetto Google Cloud .

Il comando

links createè asincrono. Il valore restituito di un metodo asincrono è un oggettoOperatione contiene informazioni sullo stato di avanzamento del metodo. Al termine del metodo, l'oggettoOperationcontiene lo stato. Per ulteriori informazioni, consulta Metodi API asincroni.Il completamento del comando

links createrichiede diversi minuti.Ad esempio, il seguente comando crea un set di dati collegato denominato

mylinkper il bucket dei log denominatomy-bucket:gcloud logging links create mylink --bucket=my-bucket --location=global

Il nome del set di dati deve essere univoco per ogni Google Cloud progetto. Se tenti di creare un set di dati con lo stesso nome di un set di dati esistente, ricevi il seguente errore:

BigQuery dataset with name "LINK_ID" already exists.Se tenti di creare un set di dati collegato per un bucket di log di cui non è stato eseguito l'upgrade per utilizzare Analisi dei log, viene segnalato il seguente errore:

A link can only be created for an analytics-enabled bucket.REST

Per creare un set di dati BigQuery collegato per un bucket di log esistente di cui è stato eseguito l'upgrade, utilizza l'analisi dei log e chiama il metodo asincrono

projects.locations.buckets.links.createdell'API Cloud Logging.Prepara gli argomenti per il metodo nel seguente modo:

- Crea il corpo della richiesta per il comando

create. Il corpo della richiesta è formattato come un oggettoLink. - Per il parametro di query del comando, utilizza

linkId=LINK_ID. Il LINK_ID che fornisci viene utilizzato come nome del set di dati BigQuery e il valore di questo campo deve essere univoco per il tuo progetto Google Cloud .

La risposta ai metodi asincroni è un oggetto

Operation. Questo oggetto contiene informazioni sullo stato di avanzamento del metodo. Al termine del metodo, l'oggettoOperationcontiene lo stato. Per ulteriori informazioni, consulta Metodi API asincroni.Il completamento del metodo

links.createrichiede diversi minuti.Il nome del set di dati deve essere univoco per ogni Google Cloud progetto. Se tenti di creare un set di dati con lo stesso nome di un set di dati esistente, ricevi il seguente errore:

BigQuery dataset with name "LINK_ID" already exists.Se tenti di creare un set di dati collegato per un bucket di log di cui non è stato eseguito l'upgrade per utilizzare Analisi dei log, viene segnalato il seguente errore:

A link can only be created for an analytics-enabled bucket.Bloccare un bucket

Quando blocchi un bucket per impedire gli aggiornamenti, blocchi anche la relativa policy di conservazione. Una volta bloccato un criterio di conservazione, non puoi eliminare il bucket finché ogni voce di log nel bucket non ha soddisfatto il periodo di conservazione del bucket. Se vuoi impedire l'eliminazione accidentale di un progetto che contiene un bucket di log bloccato, aggiungi un blocco al progetto. Per scoprire di più, consulta l'articolo Protezione dei progetti con blocchi.

Per impedire a chiunque di aggiornare o eliminare un bucket di log, bloccalo. Per bloccare il secchio:

Console Google Cloud

La console Google Cloud non supporta il blocco di un bucket di log.

gcloud

Per bloccare il bucket, esegui il comando

gcloud logging buckets updatecon il flag--locked:gcloud logging buckets update BUCKET_ID --location=LOCATION --locked

Ad esempio:

gcloud logging buckets update my-bucket --location=global --locked

REST

Per bloccare gli attributi del bucket, utilizza

projects.locations.buckets.patchnell'API Logging. Imposta il parametrolockedsutrue.Elenca bucket

Per elencare i bucket di log associati a un progetto Google Cloud e visualizzare dettagli come le impostazioni di conservazione, segui questi passaggi:

Console Google Cloud

Nella console Google Cloud , vai alla pagina Archiviazione dei log:

Se utilizzi la barra di ricerca per trovare questa pagina, seleziona il risultato con il sottotitolo Logging.

Una tabella denominata Bucket di log elenca i bucket associati al progettoGoogle Cloud corrente.

La tabella elenca i seguenti attributi per ogni bucket log:

- Nome: il nome del bucket di log.

- Descrizione: la descrizione del bucket.

- Periodo di conservazione: il numero di giorni per i quali i dati del bucket verranno archiviati da Cloud Logging.

- Regione: la posizione geografica in cui sono archiviati i dati del bucket.

- Stato: indica se il bucket è bloccato o sbloccato.

Se un bucket è in attesa di eliminazione da parte di Cloud Logging, la relativa voce di tabella è annotata con un simbolo di warning avviso.

gcloud

Esegui il comando

gcloud logging buckets list:gcloud logging buckets list

Vengono visualizzati i seguenti attributi per i bucket log:

LOCATION: la regione in cui sono archiviati i dati del bucket.BUCKET_ID: il nome del bucket dei log.RETENTION_DAYS: il numero di giorni in cui i dati del bucket verranno archiviati da Cloud Logging.LIFECYCLE_STATE: indica se il bucket è in attesa di eliminazione da parte di Cloud Logging.LOCKED: indica se il bucket è bloccato o sbloccato.CREATE_TIME: un timestamp che indica quando è stato creato il bucket.UPDATE_TIME: un timestamp che indica l'ultima modifica apportata al bucket.

Puoi anche visualizzare gli attributi di un solo bucket. Ad esempio, per visualizzare i dettagli del bucket di log

_Defaultnella regioneglobal, esegui il comandogcloud logging buckets describe:gcloud logging buckets describe _Default --location=global

REST

Per elencare i bucket di log associati a un progetto Google Cloud , utilizza

projects.locations.buckets.listnell'API Logging.Visualizzare i dettagli di un bucket

Per visualizzare i dettagli di un singolo bucket di log:

Console Google Cloud

Nella console Google Cloud , vai alla pagina Archiviazione dei log:

Se utilizzi la barra di ricerca per trovare questa pagina, seleziona il risultato con il sottotitolo Logging.

Nel bucket di log, fai clic su more_vert Altro e poi seleziona Visualizza dettagli bucket.

La finestra di dialogo elenca i seguenti attributi per il bucket dei log:

- Nome: il nome del bucket di log.

- Descrizione: la descrizione del bucket di log.

- Periodo di conservazione: il numero di giorni per i quali i dati del bucket verranno archiviati da Cloud Logging.

- Regione: la posizione geografica in cui sono archiviati i dati del bucket.

- Analisi dei log: indica se è stato eseguito l'upgrade del bucket per utilizzare Analisi dei log.

- Analisi BigQuery: indica se un set di dati BigQuery è collegato al tuo bucket.

- Set di dati BigQuery: fornisce un link al tuo set di dati BigQuery, che si apre nella pagina BigQuery Studio. Viene visualizzata anche la data in cui è stato attivato il collegamento di BigQuery.

gcloud

Esegui il comando

gcloud logging buckets describe.Ad esempio, il seguente comando riporta i dettagli del bucket

_Default:gcloud logging buckets describe _Default --location=global

Vengono visualizzati i seguenti attributi per il bucket log:

createTime: un timestamp che indica quando è stato creato il bucket.description: la descrizione del bucket dei log.lifecycleState: indica se il bucket è in attesa di eliminazione da parte di Cloud Logging.name: il nome del bucket dei log.retentionDays: il numero di giorni in cui i dati del bucket verranno archiviati da Cloud Logging.updateTime: un timestamp che indica l'ultima modifica apportata al bucket.

REST

Per visualizzare i dettagli di un singolo bucket di log, utilizza

projects.locations.buckets.getnell'API Logging.Eliminare un bucket

Puoi eliminare i bucket dei log che soddisfano uno dei seguenti requisiti:

- Il bucket di log è sbloccato.

- Il bucket di log è bloccato e tutte le voci di log nel bucket di log hanno soddisfatto il periodo di conservazione del bucket.

Non puoi eliminare un bucket di log bloccato contro gli aggiornamenti quando questo bucket di log archivia voci di log che non hanno soddisfatto il periodo di conservazione del bucket.

Dopo aver emesso il comando di eliminazione, il bucket dei log passa allo stato

DELETE_REQUESTEDe rimane in questo stato per 7 giorni. Durante questo periodo di tempo, Logging continua a instradare i log al bucket dei log. Puoi interrompere il routing dei log al bucket di log eliminando o modificando i sink di log che indirizzano le voci di log al bucket.Non puoi creare un nuovo bucket dei log che utilizzi lo stesso nome di un bucket dei log che si trova nello stato

DELETE_REQUESTED.Per eliminare un bucket log:

Console Google Cloud

Per eliminare un bucket log:

-

Nella console Google Cloud , vai alla pagina Archiviazione dei log:

Se utilizzi la barra di ricerca per trovare questa pagina, seleziona il risultato con il sottotitolo Logging.

Individua il bucket che vuoi eliminare e fai clic su more_vertAltro.

Se la colonna Set di dati collegato in BigQuery mostra un link, elimina il set di dati BigQuery collegato:

Fai clic su Modifica bucket.

Deseleziona Crea un nuovo set di dati BigQuery che si colleghi a questo bucket, fai clic su Fine e poi su Aggiorna bucket.

Dopo essere tornato alla pagina Archiviazione log, fai clic su more_vertAltro per il bucket da eliminare, quindi procedi con i passaggi successivi.

Seleziona Elimina bucket.

Nel riquadro di conferma, fai clic su Elimina.

Nella pagina Archiviazione log, il bucket ha un indicatore che ne segnala l'eliminazione in attesa. Il bucket, inclusi tutti i log al suo interno, viene eliminato dopo 7 giorni.

gcloud

Per eliminare un bucket log, esegui il comando

gcloud logging buckets delete:gcloud logging buckets delete BUCKET_ID --location=LOCATION

Non puoi eliminare un bucket di log quando questo ha un set di dati BigQuery collegato:

- Per elencare i link associati a un bucket log, esegui il comando

gcloud logging links list. - Per eliminare un set di dati collegato, esegui il

comando

gcloud logging links delete.

REST

Per eliminare un bucket, utilizza

projects.locations.buckets.deletenell'API Logging.È un errore eliminare un bucket di log se questo bucket ha un set di dati BigQuery collegato. Prima di eliminare il bucket dei log, devi eliminare il set di dati collegato:

- Per elencare i link associati a un bucket log, esegui il metodo

projects.locations.buckets.links.list. - Per eliminare un set di dati collegato, esegui il metodo

projects.locations.buckets.links.delete.

Ripristinare un bucket eliminato

Puoi ripristinare o annullare l'eliminazione di un bucket di log in attesa di eliminazione. Per ripristinare un bucket di log:

Console Google Cloud

Per ripristinare un bucket dei log in attesa di eliminazione:

-

Nella console Google Cloud , vai alla pagina Archiviazione dei log:

Se utilizzi la barra di ricerca per trovare questa pagina, seleziona il risultato con il sottotitolo Logging.

Per il bucket da ripristinare, fai clic su more_vert Altro e poi seleziona Ripristina bucket eliminato.

Nel riquadro di conferma, fai clic su Ripristina.

Nella pagina Archiviazione log, l'indicatore di eliminazione in attesa viene rimosso dal bucket di log.

gcloud

Per ripristinare un bucket dei log in attesa di eliminazione, esegui il comando

gcloud logging buckets undelete:gcloud logging buckets undelete BUCKET_ID --location=LOCATION

REST

Per ripristinare un bucket in attesa di eliminazione, utilizza

projects.locations.buckets.undeletenell'API Logging.Avviso sui byte di log mensili archiviati nei bucket di log

Per creare un criterio di avviso, nella pagina Archiviazione log della consoleGoogle Cloud , fai clic su add_alert Crea avviso di utilizzo. Questo pulsante apre la pagina Crea criterio di avviso in Monitoring e compila il campo del tipo di metrica con

logging.googleapis.com/billing/bytes_ingested.Per creare un criterio di avviso che si attivi quando il numero di byte di log scritti nei bucket di log supera il limite definito dall'utente per Cloud Logging, utilizza le impostazioni seguenti.

Nuova condizione

Campo

ValoreRisorsa e metrica Nel menu Risorse, seleziona Globale.

Nel menu Categorie di metriche, seleziona Metrica basata su log.

Nel menu Metriche, seleziona Byte di log mensili inseriti.Filtro Nessuno. Tra le serie temporali

Aggregazione serie temporalisum

Finestra temporale continua 60 m

Funzione finestra temporale continua maxConfigura trigger di avviso

Campo

ValoreTipo di condizione ThresholdTrigger avviso Any time series violatesPosizione soglia Above thresholdValore soglia Sei tu a determinare il valore accettabile. Finestra di ripetizione test Il valore minimo accettabile è di 30 minuti. Per saperne di più sui criteri di avviso, consulta la pagina Panoramica degli avvisi.

Scrivere in un bucket

Non scrivi direttamente i log in un bucket di log. Scrivi invece i log nella risorsaGoogle Cloud : un progetto, una cartella o un'organizzazione. Google Cloud I sink nella risorsa padre indirizzano quindi i log alle destinazioni, inclusi i bucket di log. Un sink esegue il routing dei log in una destinazione del bucket di log quando i log corrispondono al filtro del sink e il sink dispone dell'autorizzazione per eseguire il routing dei log nel bucket di log.

Leggere da un bucket

Ogni bucket di log ha un insieme di visualizzazioni di log. Per leggere i log da un bucket di log, devi avere accesso a una visualizzazione di log nel bucket di log. Le visualizzazioni dei log consentono di concedere a un utente l'accesso solo a un sottoinsieme dei log archiviati in un bucket dei log. Per informazioni su come configurare le visualizzazioni log e concedere l'accesso a visualizzazioni log specifiche, consulta Configurare le visualizzazioni log in un bucket log.

Per leggere i log da un bucket di log:

Console Google Cloud

-

Nella Google Cloud console, vai alla pagina Esplora log:

Se utilizzi la barra di ricerca per trovare questa pagina, seleziona il risultato con il sottotitolo Logging.

Per personalizzare i log visualizzati in Esplora log, fai clic su Definisci ambito e seleziona un'opzione. Ad esempio, puoi visualizzare i log archiviati in un progetto o per visualizzazione di log.

Fai clic su Applica. Il riquadro Risultati delle query viene ricaricato con i log che corrispondono all'opzione selezionata.

Per ulteriori informazioni, vedi Panoramica di Esplora log: perfezionare l'ambito.

gcloud

Per leggere i log da un bucket di log, utilizza il comando

gcloud logging reade aggiungi unLOG_FILTERper selezionare i dati:gcloud logging read LOG_FILTER --bucket=BUCKET_ID --location=LOCATION --view=LOG_VIEW_ID

REST

Per leggere i log da un bucket di log, utilizza il metodo entries.list. Imposta

resourceNamesper specificare il bucket e la visualizzazione dei log appropriati e impostafilterper selezionare i dati.Per informazioni dettagliate sulla sintassi di filtro, vedi Linguaggio delle query di Logging.

Configurare la conservazione personalizzata

Quando crei un bucket dei log, puoi personalizzare il periodo di tempo per cui Cloud Logging archivia i log del bucket. Puoi configurare il periodo di conservazione per qualsiasi bucket di log definito dall'utente e anche per il bucket di log

_Default. Non puoi modificare il periodo di conservazione del bucket di log_Required.Se riduci il periodo di conservazione di un bucket, è previsto un periodo di tolleranza di 7 giorni durante il quale i log scaduti non vengono eliminati. Non puoi eseguire query o visualizzare questi log scaduti, ma in questi 7 giorni puoi ripristinare l'accesso completo estendendo il periodo di conservazione del bucket. I log archiviati durante il periodo di tolleranza vengono conteggiati ai fini dei costi di conservazione.

L'applicazione della conservazione è un processo a coerenza finale. Se scrivi voci di log in un bucket di log quando le voci di log sono precedenti al periodo di conservazione del bucket, potresti riuscire a visualizzarle brevemente. Ad esempio, se invii voci di log di 10 giorni a un bucket di log con un periodo di conservazione di 7 giorni, queste voci di log vengono archiviate e poi eliminate definitivamente. Queste voci di log non contribuiscono ai costi di conservazione. Contribuiscono però ai costi di archiviazione. Per ridurre al minimo i costi di archiviazione, non scrivere voci di log precedenti al periodo di conservazione del bucket.

Per aggiornare il periodo di conservazione per un bucket di log personalizzato o per il bucket di log

_Default:Console Google Cloud

Per aggiornare il periodo di conservazione di un bucket di log:

-

Nella console Google Cloud , vai alla pagina Archiviazione dei log:

Se utilizzi la barra di ricerca per trovare questa pagina, seleziona il risultato con il sottotitolo Logging.

Per il bucket da aggiornare, fai clic su more_vert Altro, quindi seleziona Modifica bucket.

Nel campo Conservazione, inserisci il numero di giorni, tra 1 e 3650, durante i quali vuoi che Cloud Logging conservi i log.

Fai clic su Aggiorna bucket. La nuova durata del periodo di conservazione viene visualizzata nell'elenco Bucket di log.

gcloud

Per aggiornare il periodo di conservazione di un bucket log, esegui il comando

gcloud logging buckets update, dopo aver impostato un valore per RETENTION_DAYS:gcloud logging buckets update BUCKET_ID --location=LOCATION --retention-days=RETENTION_DAYS

Ad esempio, per conservare i log nel bucket

_Defaultnella localitàglobalper un anno, il comando sarà simile al seguente:gcloud logging buckets update _Default --location=global --retention-days=365

Se estendi il periodo di conservazione di un bucket, le regole di conservazione si applicano in futuro e non retroattivamente. I log non possono essere recuperati dopo la fine del periodo di conservazione applicabile.

Metodi API asincroni

La risposta di un metodo asincrono come

projects.locations.buckets.createAsyncè un oggettoOperation.Le applicazioni che chiamano un metodo API asincrono devono eseguire il polling dell'endpoint

operation.getfinché il valore del campoOperation.donenon ètrue:Quando

doneèfalse, l'operazione è in corso.Per aggiornare le informazioni sullo stato, invia una richiesta

GETall'endpointoperation.get.Quando

doneètrue, l'operazione è completata e viene impostato il campoerrororesponse:error: se impostato, l'operazione asincrona non è riuscita. Il valore di questo campo è un oggettoStatusche contiene un codice di errore gRPC e un messaggio di errore.response: se impostato, l'operazione asincrona è stata completata correttamente e il valore riflette il risultato.

Per eseguire il polling di un comando asincrono utilizzando Google Cloud CLI, esegui questo comando:

gcloud logging operations describe OPERATION_ID --location=LOCATION --project=PROJECT_ID

Per ulteriori informazioni, vedi

gcloud logging operations describe.Risolvere i problemi comuni

Se riscontri problemi durante l'utilizzo dei bucket dei log, consulta i seguenti passaggi per la risoluzione dei problemi e le risposte alle domande frequenti.

Perché non riesco a eliminare questo bucket?

Se stai tentando di eliminare un bucket:

Verifica di disporre delle autorizzazioni corrette per eliminare il bucket. Per l'elenco delle autorizzazioni necessarie, consulta Controllo dell'accesso con IAM.

Determina se il bucket è bloccato elencando gli attributi del bucket. Se il bucket è bloccato, controlla il periodo di conservazione. Non puoi eliminare un bucket bloccato finché tutti i log nel bucket non hanno soddisfatto il periodo di conservazione del bucket.

Verifica che il bucket di log non abbia un set di dati BigQuery collegato. Non puoi eliminare un bucket dei log con un set di dati collegato.

Il seguente errore viene visualizzato in risposta a un comando

deletesu un bucket log con un set di dati collegato:FAILED_PRECONDITION: This bucket is used for advanced analytics and has an active link. The link must be deleted first before deleting the bucket

Per elencare i link associati a un bucket log, esegui il comando

gcloud logging links listo il metodo dell'APIprojects.locations.buckets.links.list.

Quali service account eseguono il routing dei log nel mio bucket?

Per determinare se alcuni service account dispongono delle autorizzazioni IAM per instradare i log al tuo bucket, procedi nel seguente modo:

-

Nella console Google Cloud , vai alla pagina IAM:

Se utilizzi la barra di ricerca per trovare questa pagina, seleziona il risultato con il sottotitolo IAM e amministrazione.

Nella scheda Autorizzazioni, visualizza i dati per Ruoli. Viene visualizzata una tabella con tutti i ruoli e le entità IAM associati al tuo progettoGoogle Cloud .

Nella casella di testo Filtro filter_list della tabella, inserisci Writer bucket log.

Visualizzi tutte le entità con il ruolo Writer bucket log. Se un'entità è un account di servizio, il suo ID contiene la stringa

gserviceaccount.com.(Facoltativo) Se vuoi impedire a un account di servizio di instradare i log al tuo progetto Google Cloud , seleziona la casella di controllo check_box_outline_blank per il account di servizio e fai clic su Rimuovi.

Perché vedo i log per un progetto Google Cloud anche se li ho esclusi dal mio sink

_Default?Potresti visualizzare i log in un bucket di log in un progetto Google Cloud centralizzato, che aggrega i log di tutta l'organizzazione.

Se utilizzi Esplora log per accedere a questi log e visualizzare i log che hai escluso dal sink

_Default, la visualizzazione potrebbe essere impostata a livello di progettoGoogle Cloud .Per risolvere il problema, seleziona Visualizzazione log nel menu Perfeziona ambito e poi seleziona la visualizzazione log associata al bucket

_Defaultnel tuo progettoGoogle Cloud . Non dovresti più visualizzare i log esclusi.Passaggi successivi

Per informazioni sui metodi API dei bucket log, consulta la documentazione di riferimento di

LogBucket.Se gestisci un'organizzazione o una cartella, puoi specificare la posizione dei bucket di log

_Defaulte_Requireddelle risorse secondarie. Puoi anche configurare se i bucket di log utilizzano CMEK e il comportamento del sink di log_Default. Per ulteriori informazioni, consulta la pagina Configurare le impostazioni predefinite per organizzazioni e cartelle.Per informazioni su come gestire i casi d'uso comuni con i bucket di log, consulta i seguenti argomenti:

Salvo quando diversamente specificato, i contenuti di questa pagina sono concessi in base alla licenza Creative Commons Attribution 4.0, mentre gli esempi di codice sono concessi in base alla licenza Apache 2.0. Per ulteriori dettagli, consulta le norme del sito di Google Developers. Java è un marchio registrato di Oracle e/o delle sue consociate.

Ultimo aggiornamento 2025-10-22 UTC.

- Se prevedi di utilizzare Google Cloud CLI o l'API Cloud Logging per creare o gestire i bucket di log, comprendi i requisiti di formattazione