In questo documento vengono utilizzati i seguenti componenti fatturabili di Google Cloud:

- Dataproc

- Compute Engine

- Cloud Composer

Per generare una stima dei costi in base all'utilizzo previsto,

utilizza il calcolatore prezzi.

Prima di iniziare

Configura il progetto

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Dataproc, Compute Engine, and Cloud Composer APIs.

-

Install the Google Cloud CLI.

-

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

-

Per inizializzare gcloud CLI, esegui questo comando:

gcloud init -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Dataproc, Compute Engine, and Cloud Composer APIs.

-

Install the Google Cloud CLI.

-

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

-

Per inizializzare gcloud CLI, esegui questo comando:

gcloud init - Crea il modello di workflow

sparkpi.gcloud dataproc workflow-templates create sparkpi \ --region=us-central1 - Aggiungi il job Spark al modello di workflow

sparkpi. Il flag "compute"step-ididentifica il job SparkPi.gcloud dataproc workflow-templates add-job spark \ --workflow-template=sparkpi \ --step-id=compute \ --class=org.apache.spark.examples.SparkPi \ --jars=file:///usr/lib/spark/examples/jars/spark-examples.jar \ --region=us-central1 \ -- 1000 - Utilizza un cluster gestito

a un solo nodo

per eseguire il workflow. Dataproc creerà il cluster, eseguirà il workflow e lo eliminerà al termine del workflow.

gcloud dataproc workflow-templates set-managed-cluster sparkpi \ --cluster-name=sparkpi \ --single-node \ --region=us-central1 - Conferma la creazione del modello di workflow.

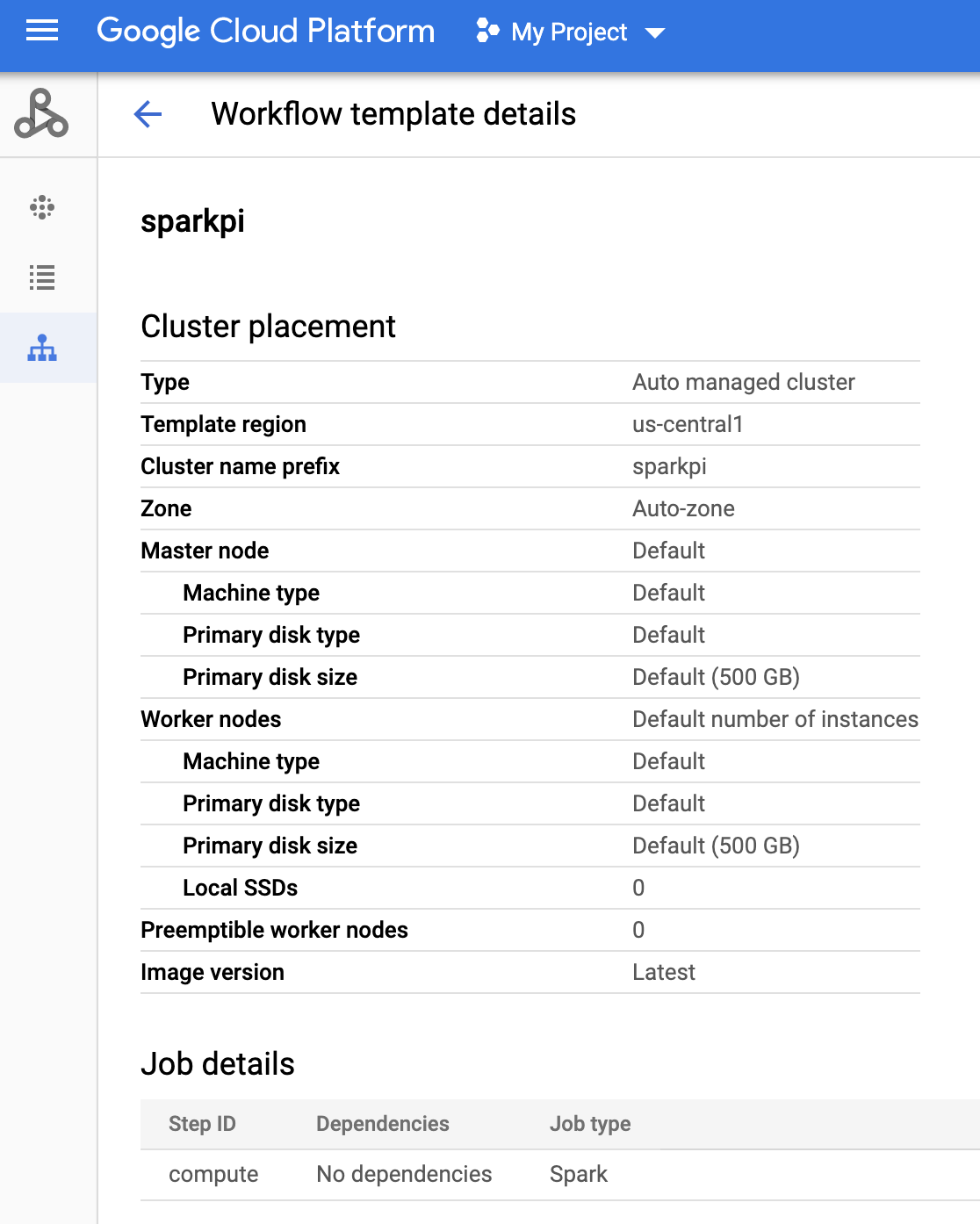

Console

Fai clic sul nome

sparkpinella pagina Workflows di Dataproc nella console Google Cloud per aprire la pagina Dettagli modello di flusso di lavoro. Fai clic sul nome del modello di workflow per confermare gli attributi del modellosparkpi.

Comando g-cloud

Esegui questo comando:

gcloud dataproc workflow-templates describe sparkpi --region=us-central1 - Crea o utilizza un ambiente Cloud Composer esistente.

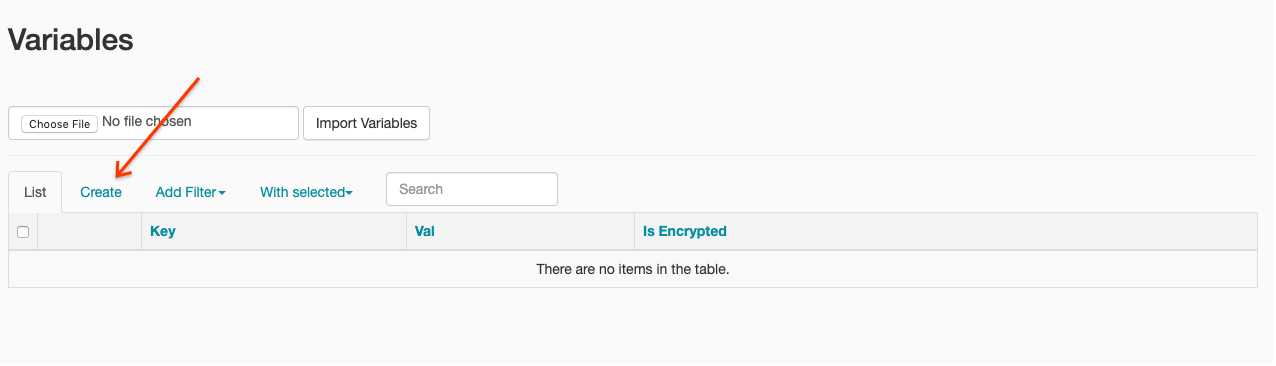

- Imposta le variabili di ambiente.

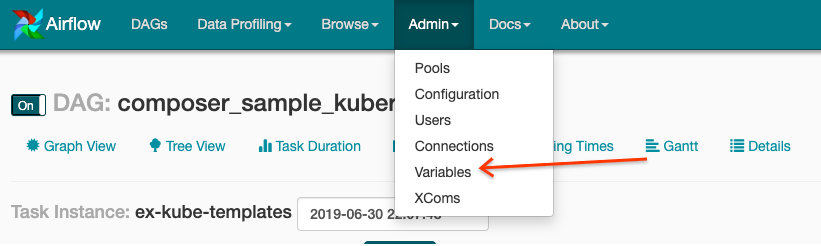

UI di Airflow

- Nella barra degli strumenti, fai clic su Amministrazione > Variabili.

- Fai clic su Crea.

- Inserisci le seguenti informazioni:

- Chiave:

project_id - Val: PROJECT_ID: il tuo ID progetto Google Cloud

- Chiave:

- Fai clic su Salva.

Comando g-cloud

Inserisci i seguenti comandi:

ENVIRONMENTè il nome dell'ambiente Cloud ComposerLOCATIONè la regione in cui si trova l'ambiente Cloud ComposerPROJECT_IDè l'ID progetto del progetto che contiene l'ambiente Cloud Composer

gcloud composer environments run ENVIRONMENT --location LOCATION variables set -- project_id PROJECT_ID - Nella barra degli strumenti, fai clic su Amministrazione > Variabili.

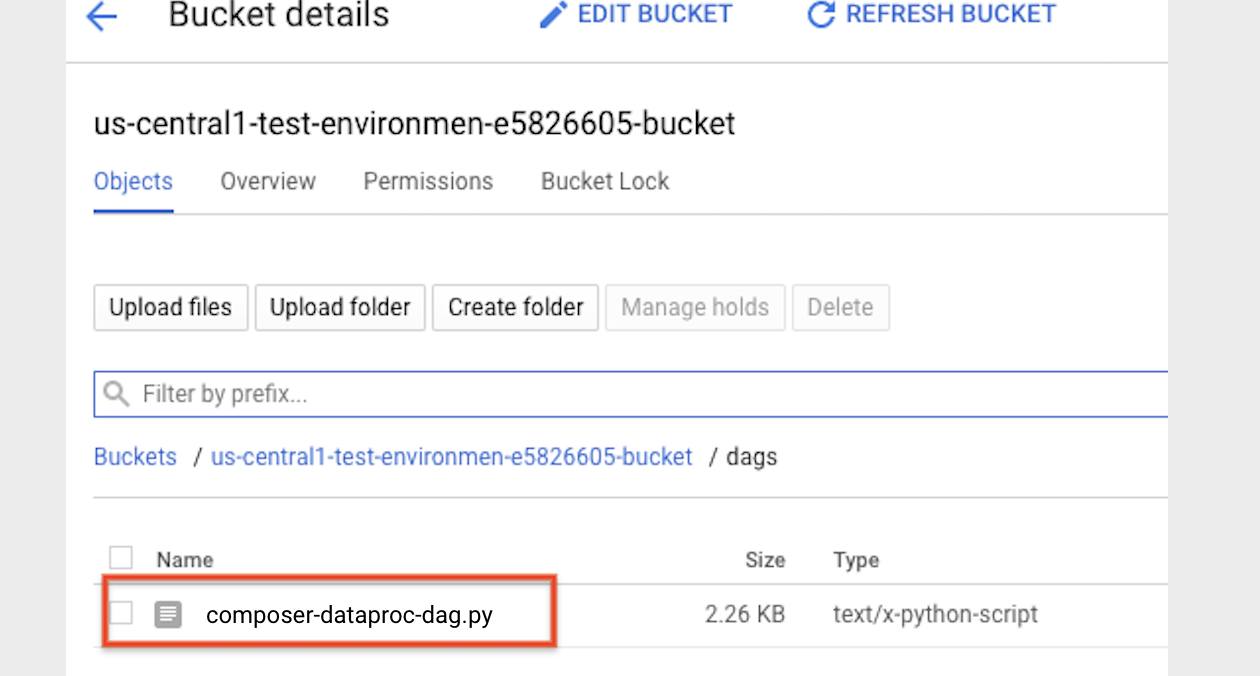

- Copia il seguente codice DAG localmente in un file denominato "composer-dataproc-dag.py",

che utilizza

DataprocInstantiateWorkflowTemplateOperator.

Airflow 2

Airflow 1

- Carica il

DAG nella cartella dell'ambiente in Cloud Storage. Una volta completato

il caricamento, fai clic sul link Cartella DAG

nella pagina dell'ambiente Cloud Composer.

- Apri l'interfaccia web di Airflow.

- Nella pagina DAG, fai clic sul nome del DAG (ad esempio,

dataproc_workflow_dag). - Nella pagina Dettagli DAG, fai clic su Visualizzazione grafico.

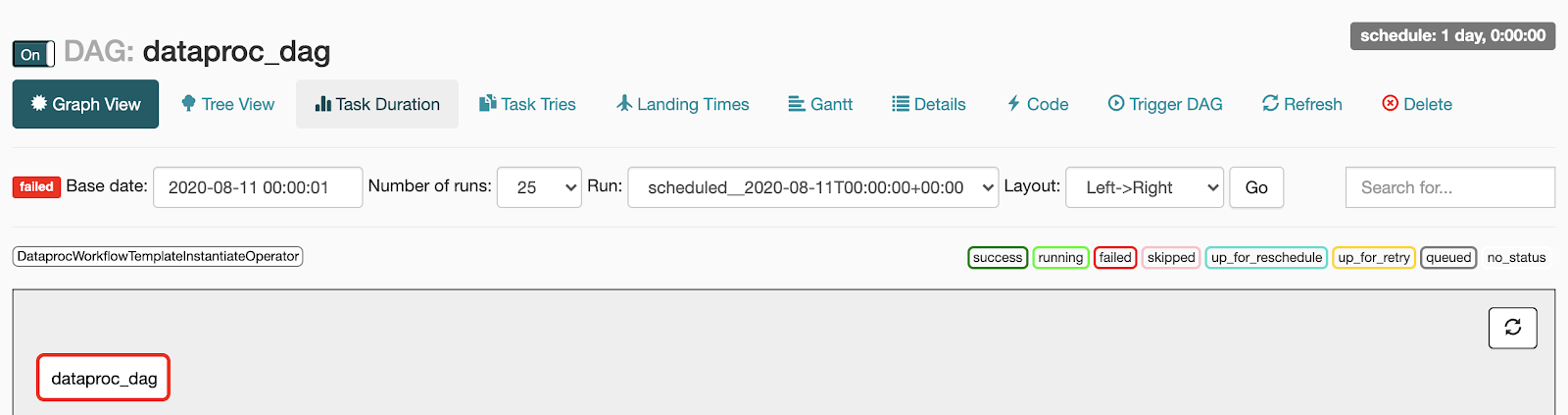

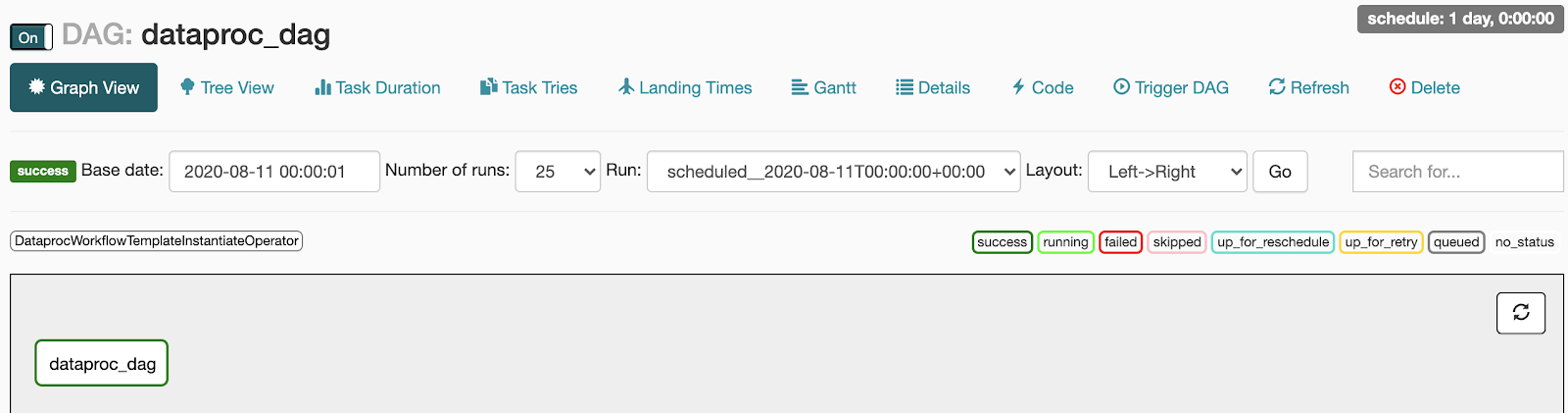

- Controlla lo stato:

- Non riuscita: l'attività è racchiusa in un riquadro rosso.

Puoi anche tenere il puntatore sopra l'attività e cercare Stato: non riuscito.

- Riuscita: l'attività è racchiusa in un riquadro verde.

Puoi anche tenere il puntatore sopra l'attività e verificare la presenza di Stato: riuscita.

- Non riuscita: l'attività è racchiusa in un riquadro rosso.

Puoi anche tenere il puntatore sopra l'attività e cercare Stato: non riuscito.

- Vedi Panoramica dei modelli di flusso di lavoro Dataproc.

- Vedi Soluzioni di pianificazione del flusso di lavoro.

Crea un modello di workflow Dataproc

Copia ed esegui i seguenti comandi in una finestra del terminale locale o in Cloud Shell per creare e definire un modello di flusso di lavoro.

Crea e carica un DAG in Cloud Storage

Visualizzare lo stato di un'attività

UI di Airflow

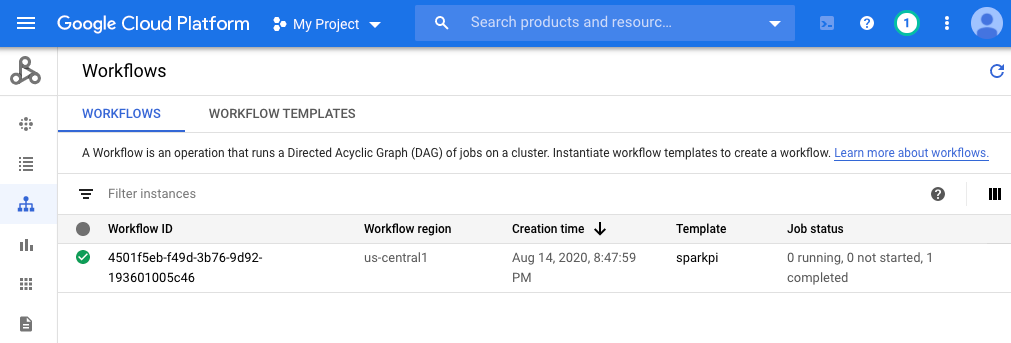

Console

Fai clic sulla scheda Workflows per visualizzare lo stato del flusso di lavoro.

Comando g-cloud

gcloud dataproc operations list \

--region=us-central1 \

--filter="labels.goog-dataproc-workflow-template-id=sparkpi"

Esegui la pulizia

Per evitare che al tuo account Google Cloud vengano addebitati costi, puoi eliminare le risorse utilizzate in questo tutorial: