Dokumen ini menunjukkan cara mengaktifkan dan menggunakan asal data untuk tugas Dataproc Hive.

Anda mengaktifkan Linage data untuk tugas Hive Dataproc menggunakan tindakan inisialisasi saat membuat cluster.

Saat Anda mengaktifkan Silsilah data Hive di cluster, tugas Hive yang Anda kirimkan ke cluster akan merekam peristiwa silsilah data dan memublikasikannya ke Dataplex Universal Catalog.

Memvisualisasikan informasi silsilah

Grafik asal data menampilkan hubungan antara resource project Anda dan proses yang membuatnya. Anda dapat mengakses grafik silsilah menggunakan Katalog Universal Dataplex, BigQuery Studio, dan Vertex AI di konsol Google Cloud .

Harga

Silsilah data Hive Dataproc ditawarkan selama Pratinjau tanpa biaya tambahan. Harga Dataproc standar berlaku.

Sebelum memulai

Di konsol Google Cloud , pada halaman pemilih project, pilih project yang berisi cluster Dataproc yang ingin Anda lacak silsilahnya.

Aktifkan Data Lineage API dan Dataplex API.

Peran yang diperlukan

Untuk mendapatkan izin yang Anda perlukan guna menggunakan silsilah data di Dataproc, minta administrator untuk memberi Anda peran IAM berikut di akun layanan VM cluster Dataproc:

-

Melihat silsilah data di Dataplex Universal Catalog atau menggunakan Data Lineage API:

Pelihat Silsilah Data (

roles/datalineage.viewer) -

Menghasilkan silsilah data secara manual menggunakan API:

Data Lineage Events Producer (

roles/datalineage.producer) -

Mengedit silsilah data menggunakan API:

Editor Silsilah Data (

roles/datalineage.editor) -

Melakukan semua operasi pada silsilah data:

Administrator Silsilah Data (

roles/datalineage.admin)

Untuk mengetahui informasi selengkapnya tentang pemberian peran, lihat Mengelola akses ke project, folder, dan organisasi.

Anda mungkin juga bisa mendapatkan izin yang diperlukan melalui peran kustom atau peran yang telah ditentukan lainnya.

Mengaktifkan silsilah data Hive

Untuk mengaktifkan asal data Hive pada cluster, tentukan hive-lineage.sh

tindakan inisialisasi saat

Anda membuat cluster Dataproc.

Tindakan inisialisasi ini disimpan dalam bucket regional di Cloud Storage.

Contoh pembuatan cluster gcloud CLI:

gcloud dataproc clusters create CLUSTER_NAME \

--project PROJECT_ID \

--region REGION \

--image-version IMAGE_VERSION \

--initialization-actions gs://goog-dataproc-initialization-actions-REGION/hive-lineage/hive-lineage.shGanti kode berikut:

- CLUSTER_NAME: Nama cluster.

- PROJECT_ID: ID project Google Cloud Anda. Project ID tercantum di bagian Project info di Google Cloud Dasbor konsol.

- REGION: Region Compute Engine tempat cluster akan berada.

- IMAGE_VERSION Versi image yang dimaksudkan untuk cluster.

--initialization-actions: Menentukan tindakan penginstalan yang berada di lokasi regional Cloud Storage, yang mengaktifkan asal data Hive.- Secara opsional, tambahkan tindakan inisialisasi konektor Hive-BigQuery. Jika ingin mengintegrasikan tabel BigQuery dengan beban kerja Hive, Anda harus menginstal konektor Hive-BigQuery di cluster. Lihat contoh silsilah data Hive dengan BigQuery, yang menjalankan tindakan inisialisasi konektor untuk menginstal konektor Hive-BigQuery di cluster.

Mengirimkan tugas Hive

Saat Anda mengirimkan tugas Hive ke cluster Dataproc yang dibuat dengan silsilah data Hive diaktifkan, Dataproc akan mengambil dan melaporkan informasi silsilah data ke Katalog Universal Dataplex.

Contoh pengiriman tugas Hive gcloud CLI:

gcloud dataproc jobs submit hive \

--cluster=CLUSTER_NAME \

--project PROJECT_ID \

--region REGION \

--properties=hive.openlineage.namespace=CUSTOM_NAMESPACE \

--execute HIVE_QUERYGanti kode berikut:

- CLUSTER_NAME: Nama cluster.

- PROJECT_ID: ID project Google Cloud Anda. Project ID tercantum di bagian Project info di Google Cloud Dasbor konsol.

- REGION: Region Compute Engine tempat cluster Anda berada.

- CUSTOM_NAMESPACE: Namespace Hive kustom opsional yang dapat Anda tentukan untuk mengidentifikasi tugas Hive.

- HIVE_QUERY: Kueri Hive yang akan dikirimkan ke cluster.

Daripada menentukan kueri, Anda dapat mengganti flag

--execute HIVE_QUERYdengan flag--file SQL_FILEuntuk menentukan lokasi file yang berisi kueri.

Melihat silsilah di Dataplex Universal Catalog

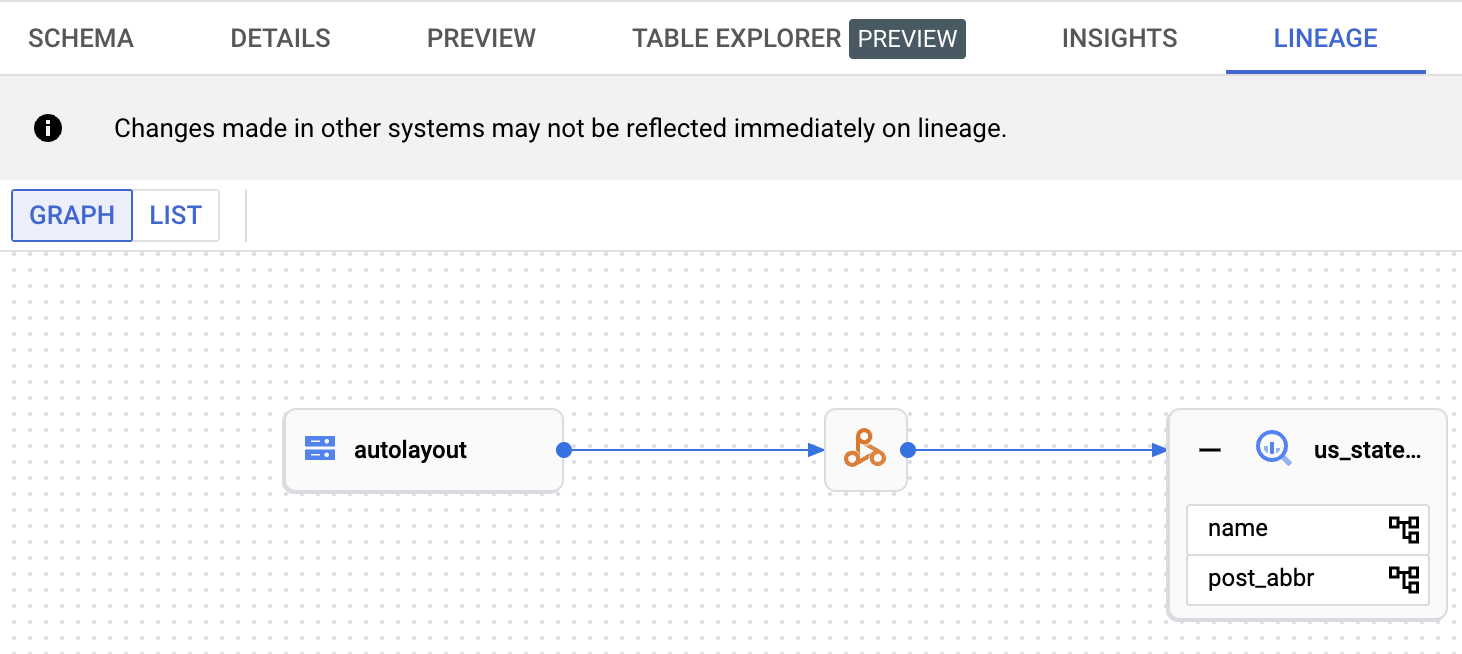

Grafik silsilah menampilkan hubungan antara resource project Anda dan proses yang membuatnya. Anda dapat melihat informasi silsilah data di konsol Google Cloud , atau mengambilnya dari Data Lineage API dalam bentuk data JSON.

Contoh data lineage Hive dengan BigQuery

Contoh di bagian ini terdiri dari langkah-langkah berikut:

- Buat cluster Dataproc yang mengaktifkan silsilah data Hive dan menginstal konektor Hive-BigQuery di cluster.

- Jalankan kueri Hive di cluster untuk menyalin data antar-tabel Hive.

- Melihat grafik silsilah data yang dihasilkan di BigQuery Studio.

Membuat cluster Dataproc

Jalankan perintah berikut di jendela terminal lokal atau di Cloud Shell untuk membuat cluster Dataproc.

gcloud dataproc clusters create CLUSTER_NAME \ --project PROJECT_ID \ --region REGION \ --image-version IMAGE_VERSION \ --initialization-actions gs://goog-dataproc-initialization-actions-REGION/connectors/connectors.sh, gs://goog-dataproc-initialization-actions-REGION/hive-lineage/hive-lineage.sh \ --metadata hive-bigquery-connector-version=HIVE_BQ_VERSION

Catatan:

- CLUSTER_NAME: Nama cluster.

- PROJECT_ID: ID project Google Cloud Anda. Project ID tercantum di bagian Project info di Google Cloud Dasbor konsol.

- REGION: Region Compute Engine tempat cluster akan berada.

- IMAGE_VERSION Versi image yang dimaksudkan untuk cluster.

--initialization-actions: Tindakan penginstalan ini, yang berada di Cloud Storage, akan menginstal konektor Hive-BigQuery dan mengaktifkan asal data Hive.- HIVE_BQ_VERSION: Menentukan

versi konektor Hive-BigQuery.

Flag

--metadatameneruskan versi ke tindakan inisialisasiconnectors.shuntuk menginstal konektor Hive-BigQuery di cluster.

Menjalankan kueri Hive

Jalankan kueri Hive untuk melakukan tindakan berikut:

- Buat tabel eksternal

us_statesdengan input data sampel darigs://cloud-samples-data/bigquery/hive-partitioning-samples/autolayout. - Buat tabel terkelola

us_states_copydi set data BigQuery yang ditentukan. - Salin seluruh data dari

us_stateskeus_states_copy.

Untuk menjalankan kueri:

- Di jendela terminal lokal atau di Cloud Shell,

gunakan editor teks, seperti

viataunano, untuk menyalin pernyataan kueri Hive berikut ke dalam filehive-example.sql, lalu simpan file di direktori saat ini. - Kirimkan file

hive-example.sqlke cluster Dataproc yang dibuat sebelumnya dengan mengganti flag--execute HIVE_QUERYdengan flag--file SQL_FILEuntuk menentukan lokasi filehive-example.sqlyang disimpan. Perhatikan bahwa variabel PROJECT dan BQ_DATASET harus diisi.

Hive BigQueryStorageHandler

CREATE EXTERNAL TABLE us_states ( name STRING, post_abbr STRING ) STORED AS PARQUET LOCATION 'gs://cloud-samples-data/bigquery/hive-partitioning-samples/autolayout'; CREATE TABLE us_states_copy ( name STRING, post_abbr STRING ) STORED BY 'com.google.cloud.hive.bigquery.connector.BigQueryStorageHandler' TBLPROPERTIES ( 'bq.table'='PROJECT.BQ_DATASET.us_states_copy' ); INSERT INTO us_states_copy SELECT * FROM us_states;

Melihat grafik silsilah data

Setelah tugas Hive selesai dengan berhasil, lihat silsilah data di BigQuery Studio di konsol Google Cloud :

Untuk mengetahui informasi tentang menampilkan grafik di BigQuery Studio, lihat Melihat silsilah di BigQuery. Untuk mengetahui informasi tentang cara memahami grafik, lihat Model informasi silsilah data.

Langkah berikutnya

- Pelajari lebih lanjut silsilah data.