Lorsque vous envoyez un job Dataproc, Dataproc recueille automatiquement les résultats du job et les met à votre disposition. Cela signifie que vous pouvez rapidement consulter les résultats des tâches sans avoir à maintenir une connexion au cluster pendant l'exécution de vos tâches ni à parcourir des fichiers journaux compliqués.

Journaux Spark

Il existe deux types de journaux Spark : les journaux du pilote Spark et les journaux de l'exécuteur Spark.

Les journaux du pilote Spark contiennent le résultat du job, tandis que les journaux de l'exécuteur Spark contiennent le résultat de l'exécutable ou du lanceur du job, tel qu'un message spark-submit "Submitted application xxx" (Application xxx soumise). Ils peuvent être utiles pour déboguer les échecs de jobs.

Le pilote de tâche Dataproc, qui est distinct du pilote Spark, est un lanceur pour de nombreux types de tâches. Lors du lancement de tâches Spark, il s'exécute en tant qu'encapsuleur sur l'exécutable spark-submit sous-jacent, qui lance le pilote Spark. Le pilote Spark exécute le job sur le cluster Dataproc en mode Spark client ou cluster :

Mode

client: le pilote Spark exécute la tâche dans le processusspark-submit, et les journaux Spark sont envoyés au pilote de tâche Dataproc.Mode

cluster: le pilote Spark exécute le job dans un conteneur YARN. Les journaux du pilote Spark ne sont pas disponibles pour le pilote de tâches Dataproc.

Présentation des propriétés des jobs Dataproc et Spark

| Propriété | Valeur | Par défaut | Description |

|---|---|---|---|

dataproc:dataproc.logging.stackdriver.job.driver.enable |

"true" ou "false" | faux | Doit être défini au moment de la création du cluster. Lorsque la valeur est true, les résultats du pilote de tâches se trouvent dans Logging et sont associés à la ressource de tâche. Lorsque la valeur est false, les résultats du pilote de tâches ne se trouvent pas dans Logging.Remarque : Les paramètres de propriété de cluster suivants sont également requis pour activer les journaux de pilotes de tâches dans Logging. Ils sont définis par défaut lors de la création d'un cluster : dataproc:dataproc.logging.stackdriver.enable=true

et dataproc:jobs.file-backed-output.enable=true.

|

dataproc:dataproc.logging.stackdriver.job.yarn.container.enable |

"true" ou "false" | faux | Doit être défini au moment de la création du cluster.

Lorsque la valeur est true, les journaux de conteneur YARN des tâches sont associés à la ressource de tâche. Lorsque la valeur est false, les journaux de conteneur YARN des tâches sont associés à la ressource de cluster. |

spark:spark.submit.deployMode |

client ou cluster | Client | Contrôle le mode Spark client ou cluster. |

Tâches Spark envoyées à l'aide de l'API Dataproc jobs

Les tableaux de cette section listent l'effet des différents paramètres de propriété sur la destination des résultats du pilote de tâches Dataproc lorsque les tâches sont envoyées via l'API jobs Dataproc, qui inclut l'envoi de tâches via la consoleGoogle Cloud , gcloud CLI et les bibliothèques clientes Cloud.

Les propriétés Dataproc et Spark listées peuvent être définies avec l'indicateur --properties lors de la création d'un cluster. Elles s'appliqueront à toutes les tâches Spark exécutées sur le cluster. Les propriétés Spark peuvent également être définies avec l'indicateur --properties (sans le préfixe "spark:") lorsqu'une tâche est envoyée à l'API Dataproc jobs. Elles ne s'appliqueront qu'à la tâche.

Résultats du pilote de tâches Dataproc

Les tableaux suivants indiquent l'effet de différents paramètres de propriété sur la destination de la sortie du pilote de job Dataproc.

dataproc: |

Sortie |

|---|---|

| false (valeur par défaut) |

|

| vrai |

|

Journaux du pilote Spark

Les tableaux suivants indiquent l'effet de différents paramètres de propriété sur la destination des journaux de pilote Spark.

spark: |

dataproc: |

dataproc: |

Sortie du pilote |

|---|---|---|---|

| Client | false (valeur par défaut) | "true" ou "false" |

|

| Client | vrai | "true" ou "false" |

|

| cluster | false (valeur par défaut) | faux |

|

| cluster | vrai | vrai |

|

Journaux de l'exécuteur Spark

Les tableaux suivants indiquent l'effet de différents paramètres de propriété sur la destination des journaux d'exécution Spark.

dataproc: |

Journal de l'exécuteur |

|---|---|

| false (valeur par défaut) | Dans Logging : yarn-userlogs sous la ressource de cluster |

| vrai | Dans Logging dataproc.job.yarn.container sous la ressource de job |

Tâches Spark envoyées sans utiliser l'API Dataproc jobs

Cette section décrit l'effet de différents paramètres de propriété sur la destination des journaux des tâches Spark lorsque les tâches sont envoyées sans utiliser l'API Dataproc jobs, par exemple lorsque vous envoyez une tâche directement sur un nœud de cluster à l'aide de spark-submit ou lorsque vous utilisez un notebook Jupyter ou Zeppelin. Ces jobs ne disposent pas d'ID ni de pilotes Dataproc.

Journaux du pilote Spark

Les tableaux suivants indiquent l'effet de différents paramètres de propriété sur la destination des journaux de pilote Spark pour les jobs qui ne sont pas envoyés via l'API Dataproc jobs.

spark: |

Sortie du pilote |

|---|---|

| Client |

|

| cluster |

|

Journaux de l'exécuteur Spark

Lorsque les tâches Spark ne sont pas envoyées via l'API jobs Dataproc, les journaux de l'exécuteur se trouvent dans Logging yarn-userlogs sous la ressource de cluster.

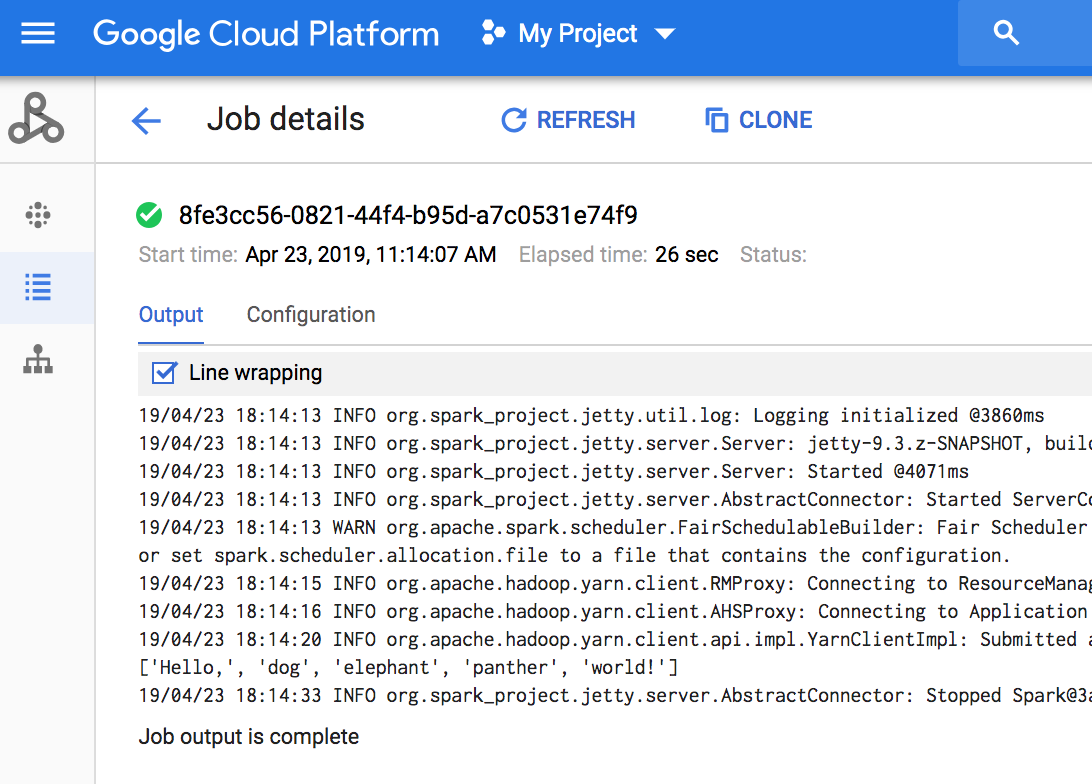

Afficher le résultat du job

Vous pouvez accéder aux résultats des jobs Dataproc dans la console Google Cloud , gcloud CLI, Cloud Storage ou Logging.

Console

Pour afficher les résultats des tâches, accédez à la section Tâches Dataproc de votre projet, puis cliquez sur l'ID de la tâche pour afficher les résultats.

Si la tâche est en cours d'exécution, les résultats sont actualisés périodiquement avec le nouveau contenu.

Commande gcloud

Lorsque vous envoyez une tâche à l'aide de la commande gcloud dataproc jobs submit, les résultats de la tâche s'affichent dans la console. Vous pouvez "retrouver" ces résultats ultérieurement, sur un autre ordinateur ou dans une nouvelle fenêtre, en transmettant l'ID de votre tâche à la commande gcloud dataproc jobs wait. L'ID de tâche est un GUID, tel que 5c1754a5-34f7-4553-b667-8a1199cb9cab. Voici un exemple.

gcloud dataproc jobs wait 5c1754a5-34f7-4553-b667-8a1199cb9cab \ --project my-project-id --region my-cluster-region

Waiting for job output... ... INFO gcs.GoogleHadoopFileSystemBase: GHFS version: 1.4.2-hadoop2 ... 16:47:45 INFO client.RMProxy: Connecting to ResourceManager at my-test-cluster-m/ ...

Cloud Storage

Dans Cloud Storage, les résultats des jobs sont stockés dans le bucket de préproduction ou le bucket spécifié lors de la création du cluster. Dans Cloud Storage, un lien vers les résultats des tâches est fourni dans le champ Job.driverOutputResourceUri renvoyé par :

- une requête d'API jobs.get.

- une commande gcloud dataproc jobs describe job-id.

$ gcloud dataproc jobs describe spark-pi ... driverOutputResourceUri: gs://dataproc-nnn/jobs/spark-pi/driveroutput ...