Ao criar um cluster do Dataproc, você pode ativar a autenticação de cluster pessoal do Dataproc para permitir que as cargas de trabalho interativas no cluster sejam executadas com segurança como sua identidade de usuário. Isso significa que as interações com outros recursos do Google Cloud , como o Cloud Storage, serão autenticadas como você em vez de como a conta de serviço de cluster.

Considerações

Quando você cria um cluster com a autenticação de cluster pessoal ativada, o cluster só poderá ser usado pela sua identidade. Outros usuários não poderão executar jobs no cluster nem acessar os endpoints do Gateway de componentes no cluster.

Os clusters com a autenticação de cluster pessoal ativa bloqueiam o acesso SSH e os recursos do Compute Engine, como scripts de inicialização em todas as VMs no cluster.

Os clusters com a autenticação de cluster pessoal ativada são automaticamente ativados e configuram o Kerberos no cluster para a comunicação segura entre clusters. No entanto, todas as identidades do Kerberos no cluster vão interagir com os recursos do Google Cloud como o mesmo usuário.

Os clusters com a autenticação de cluster pessoal ativada não são compatíveis com imagens personalizadas.

A autenticação de cluster pessoal do Dataproc não é compatível com os fluxos de trabalho do Dataproc.

A autenticação de cluster pessoal do Dataproc destina-se apenas a jobs interativos executados por um usuário individual (humano). Jobs e operações de longa duração precisam configurar e usar uma identidade de conta de serviço apropriada.

As credenciais propagadas estão no escopo com um limite de acesso a credenciais. O limite de acesso padrão é limitado à leitura e à gravação de objetos do Cloud Storage nos buckets do Cloud Storage pertencentes ao mesmo projeto que contém o cluster. É possível definir um limite de acesso não padrão ao ativar_uma_sessão_interativa.

A autenticação de cluster pessoal do Dataproc usa atributos de convidado do Compute Engine. Se o recurso de atributos de convidado estiver desativado, a autenticação de cluster pessoal vai falhar.

Objetivos

Crie um cluster do Dataproc com a autenticação de cluster pessoal do Dataproc ativada.

Inicie a propagação de credencial no cluster.

Usar um notebook do Jupyter no cluster para executar jobs do Spark que autenticam com suas credenciais.

Antes de começar

Criar um projeto

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Dataproc API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Ao usar um provedor de identidade (IdP) externo, primeiro faça login na gcloud CLI com sua identidade federada.

-

Para inicializar a gcloud CLI, execute o seguinte comando:

gcloud init -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Dataproc API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Ao usar um provedor de identidade (IdP) externo, primeiro faça login na gcloud CLI com sua identidade federada.

-

Para inicializar a gcloud CLI, execute o seguinte comando:

gcloud init - Inicie uma sessão do Cloud Shell.

- Execute

gcloud auth loginpara receber credenciais de usuário válidas. Encontre o endereço de e-mail da sua conta ativa no gcloud.

gcloud auth list --filter=status=ACTIVE --format="value(account)"

Criar um cluster.

gcloud dataproc clusters create CLUSTER_NAME \ --properties=dataproc:dataproc.personal-auth.user=your-email-address \ --enable-component-gateway \ --optional-components=JUPYTER \ --region=REGION

Ative uma sessão de propagação de credenciais para o cluster começar a usar suas credenciais pessoais ao interagir com os recursos Google Cloud.

gcloud dataproc clusters enable-personal-auth-session \ --region=REGION \ CLUSTER_NAME

Exemplo de resposta:

Injecting initial credentials into the cluster CLUSTER_NAME...done. Periodically refreshing credentials for cluster CLUSTER_NAME. This will continue running until the command is interrupted...

Exemplo de limite de acesso com escopo diminuído: o exemplo a seguir ativa uma sessão de autenticação pessoal que é mais restritiva do que o limite de acesso de credencial com escopo diminuído padrão. Ele restringe o acesso ao bucket de preparo do cluster do Dataproc. Para mais informações, consulte Downscope com limites de acesso a credenciais .

gcloud dataproc clusters enable-personal-auth-session \ --project=PROJECT_ID \ --region=REGION \ --access-boundary=<(echo -n "{ \ \"access_boundary\": { \ \"accessBoundaryRules\": [{ \ \"availableResource\": \"//storage.googleapis.com/projects/_/buckets/$(gcloud dataproc clusters describe --project=PROJECT_ID --region=REGION CLUSTER_NAME --format="value(config.configBucket)")\", \ \"availablePermissions\": [ \ \"inRole:roles/storage.objectViewer\", \ \"inRole:roles/storage.objectCreator\", \ \"inRole:roles/storage.objectAdmin\", \ \"inRole:roles/storage.legacyBucketReader\" \ ] \ }] \ } \ }") \ CLUSTER_NAME

Mantenha o comando em execução e alterne para uma nova guia ou sessão de terminal do Cloud Shell. O cliente atualizará as credenciais enquanto o comando estiver em execução.

Digite

Ctrl-Cpara encerrar a sessão.- Receber detalhes do cluster.

gcloud dataproc clusters describe CLUSTER_NAME --region=REGION

O URL da interface da Web do Jupyter está listado nos detalhes do cluster.

... JupyterLab: https://UUID-dot-us-central1.dataproc.googleusercontent.com/jupyter/lab/ ...

- Copie o URL no navegador local para iniciar a IU do Jupyter.

- Verifique se a autenticação do cluster pessoal foi bem-sucedida.

- Inicie um terminal do Jupyter.

- Executar

gcloud auth list - Verifique se seu nome de usuário é a única conta ativa.

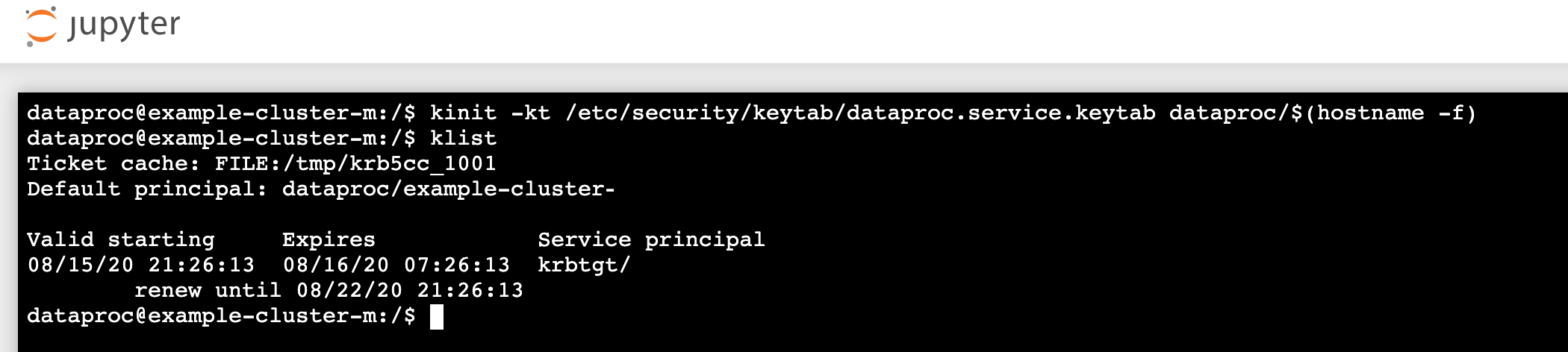

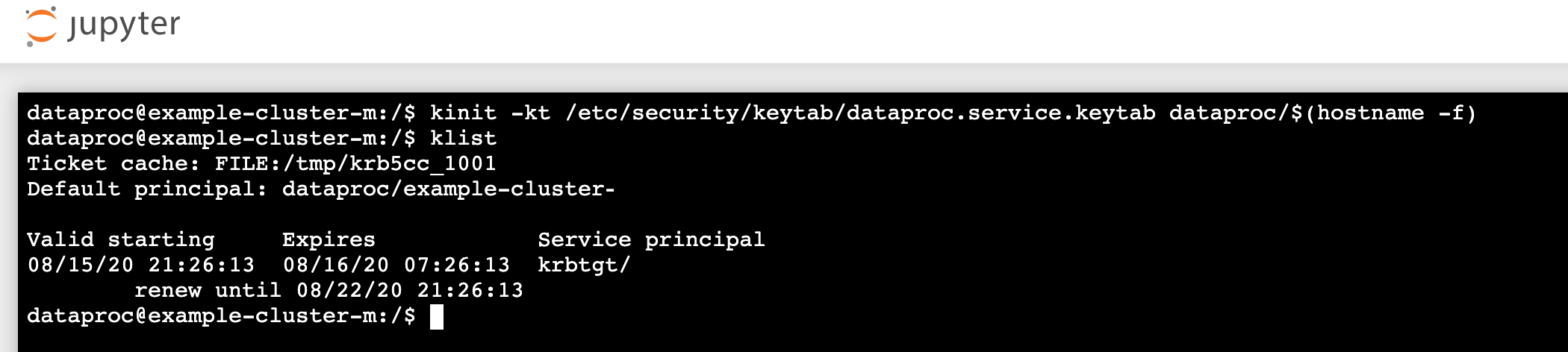

- Em um terminal Jupyter, ative o Jupyter para autenticar com o Kerberos e enviar jobs do Spark.

kinit -kt /etc/security/keytab/dataproc.service.keytab dataproc/$(hostname -f)

- Execute

klistpara verificar se o Jupyter teve um TGT válido.

- Execute

- Em um terminal do Juypter, use a CLI gcloud para criar um arquivo

rose.txtem um bucket do Cloud Storage no seu projeto.echo "A rose by any other name would smell as sweet" > /tmp/rose.txt

gcloud storage cp /tmp/rose.txt gs://bucket-name/rose.txt

- Marque o arquivo como privado para que apenas a sua conta de usuário possa ler ou

gravar nele. O Jupyter usará suas credenciais pessoais ao interagir

com o Cloud Storage.

gcloud storage objects update gs://bucket-name/rose.txt --predefined-acl=private

- Verifique o acesso privado.

gcloud storage objects describe gs://$BUCKET/rose.txt

acl:

- Marque o arquivo como privado para que apenas a sua conta de usuário possa ler ou

gravar nele. O Jupyter usará suas credenciais pessoais ao interagir

com o Cloud Storage.

- email: $USER entity: user-$USER role: OWNER

- Clique no link Jupyter Gateway de Componentes para iniciar a IU do Jupyter.

- Verifique se a autenticação do cluster pessoal foi bem-sucedida.

- Iniciar um terminal do Jupyter

- Executar

gcloud auth list - Verifique se seu nome de usuário é a única conta ativa.

- Em um terminal Jupyter, ative o Jupyter para autenticar com o Kerberos e enviar jobs do Spark.

kinit -kt /etc/security/keytab/dataproc.service.keytab dataproc/$(hostname -f)

- Execute

klistpara verificar se o Jupyter teve um TGT válido.

- Execute

- Em um terminal do Jupyter, use a CLI gcloud para criar um arquivo

rose.txtem um bucket do Cloud Storage no seu projeto.echo "A rose by any other name would smell as sweet" > /tmp/rose.txt

gcloud storage cp /tmp/rose.txt gs://bucket-name/rose.txt

- Marque o arquivo como privado para que apenas a sua conta de usuário possa ler ou

gravar nele. O Jupyter usará suas credenciais pessoais ao interagir

com o Cloud Storage.

gcloud storage objects update gs://bucket-name/rose.txt --predefined-acl=private

- Verifique o acesso privado.

gcloud storage objects describe gs://bucket-name/rose.txt

acl:

- Marque o arquivo como privado para que apenas a sua conta de usuário possa ler ou

gravar nele. O Jupyter usará suas credenciais pessoais ao interagir

com o Cloud Storage.

- email: $USER entity: user-$USER role: OWNER

- Navegue até uma pasta e crie um notebook do PySpark.

Execute um job básico de contagem de palavras no arquivo

rose.txtcriado acima.text_file = sc.textFile("gs://bucket-name/rose.txt") counts = text_file.flatMap(lambda line: line.split(" ")) \ .map(lambda word: (word, 1)) \ .reduceByKey(lambda a, b: a + b) print(counts.collect())rose.txtno Cloud Storage porque ele é executado com suas credenciais de usuário.Também é possível verificar os Registros de auditoria do bucket do Cloud Storage para confirmar se o job está acessando o Cloud Storage com sua identidade. Consulte Registros de auditoria do Cloud com o Cloud Storage para mais informações.

- Exclua o cluster do Dataproc.

gcloud dataproc clusters delete CLUSTER_NAME --region=REGION

Configure o ambiente

Configure o ambiente a partir do Cloud Shell ou de um terminal local: