Puoi utilizzare l'infrastruttura di logging integrata dell'SDK Apache Beam per registrare informazioni durante l'esecuzione della pipeline. Puoi utilizzare la consoleGoogle Cloud per monitorare le informazioni di logging durante e dopo l'esecuzione della pipeline.

Aggiungere messaggi di log alla pipeline

Java

L'SDK Apache Beam per Java consiglia di registrare i messaggi dei worker tramite la libreria Simple Logging Facade for Java (SLF4J) open source. L'Apache Beam SDK per Java implementa l'infrastruttura di logging richiesta, in modo che il codice Java debba solo importare l'API SLF4J. Poi, crea un'istanza di Logger per abilitare la registrazione dei messaggi nel codice della pipeline.

Per il codice e/o le librerie preesistenti, l'Apache Beam SDK per Java configura un'infrastruttura di logging aggiuntiva. Vengono acquisiti i messaggi di log generati dalle seguenti librerie di logging per Java:

Python

L'SDK Apache Beam per Python fornisce il pacchetto della libreria logging, che consente ai worker della pipeline di generare messaggi di log. Per utilizzare le funzioni della libreria, devi importarla:

import logging

Vai

L'SDK Apache Beam per Go fornisce il pacchetto della libreria log,

che consente ai worker della pipeline di generare messaggi di log. Per utilizzare le funzioni della libreria, devi importarla:

import "github.com/apache/beam/sdks/v2/go/pkg/beam/log"

Esempio di codice del messaggio di log del worker

Java

L'esempio seguente utilizza SLF4J per la registrazione di Dataflow. Per saperne di più sulla configurazione di SLF4J per la registrazione di Dataflow, consulta l'articolo Suggerimenti per Java.

L'esempio WordCount di Apache Beam può essere modificato per generare un messaggio di log quando la parola "amore" viene trovata in una riga del testo elaborato. Il codice aggiunto è indicato in grassetto nell'esempio seguente (il codice circostante è incluso per contesto).

package org.apache.beam.examples; // Import SLF4J packages. import org.slf4j.Logger; import org.slf4j.LoggerFactory; ... public class WordCount { ... static class ExtractWordsFn extends DoFn<String, String> { // Instantiate Logger. // Suggestion: As shown, specify the class name of the containing class // (WordCount). private static final Logger LOG = LoggerFactory.getLogger(WordCount.class); ... @ProcessElement public void processElement(ProcessContext c) { ... // Output each word encountered into the output PCollection. for (String word : words) { if (!word.isEmpty()) { c.output(word); } // Log INFO messages when the word "love" is found. if(word.toLowerCase().equals("love")) { LOG.info("Found " + word.toLowerCase()); } } } } ... // Remaining WordCount example code ...

Python

L'esempio Apache Beam wordcount.py può essere modificato per generare un messaggio di log quando viene trovata la parola "love" in una riga del testo elaborato.

# import Python logging module. import logging class ExtractWordsFn(beam.DoFn): def process(self, element): words = re.findall(r'[A-Za-z\']+', element) for word in words: yield word if word.lower() == 'love': # Log using the root logger at info or higher levels logging.info('Found : %s', word.lower()) # Remaining WordCount example code ...

Vai

L'esempio wordcount.go di Apache Beam può essere modificato per generare un messaggio di log quando la parola "amore" viene trovata in una riga del testo elaborato.

func (f *extractFn) ProcessElement(ctx context.Context, line string, emit func(string)) { for _, word := range wordRE.FindAllString(line, -1) { // increment the counter for small words if length of words is // less than small_word_length if strings.ToLower(word) == "love" { log.Infof(ctx, "Found : %s", strings.ToLower(word)) } emit(word) } } // Remaining Wordcount example

Java

Se la pipeline WordCount modificata viene eseguita localmente utilizzando DirectRunner

con l'output inviato a un file locale (--output=./local-wordcounts), l'output della console

include i messaggi di log aggiunti:

INFO: Executing pipeline using the DirectRunner. ... Feb 11, 2015 1:13:22 PM org.apache.beam.examples.WordCount$ExtractWordsFn processElement INFO: Found love Feb 11, 2015 1:13:22 PM org.apache.beam.examples.WordCount$ExtractWordsFn processElement INFO: Found love Feb 11, 2015 1:13:22 PM org.apache.beam.examples.WordCount$ExtractWordsFn processElement INFO: Found love ... INFO: Pipeline execution complete.

Per impostazione predefinita, a Cloud Logging vengono inviate solo le righe di log contrassegnate con INFO e livelli superiori. Per modificare questo comportamento, vedi

Impostazione dei livelli di log del worker della pipeline.

Python

Se la pipeline WordCount modificata viene eseguita localmente utilizzando DirectRunner

con l'output inviato a un file locale (--output=./local-wordcounts), l'output della console

include i messaggi di log aggiunti:

INFO:root:Found : love INFO:root:Found : love INFO:root:Found : love

Per impostazione predefinita, a Cloud Logging vengono inviate solo le righe di log contrassegnate con INFO e livelli superiori. Per modificare questo comportamento, vedi

Impostazione dei livelli di log del worker della pipeline.

Non sovrascrivere la configurazione di logging con le funzioni logging.config, in quanto ciò potrebbe disattivare i gestori di log preconfigurati che trasmettono i log della pipeline a Dataflow e Cloud Logging.

Vai

Se la pipeline WordCount modificata viene eseguita localmente utilizzando DirectRunner

con l'output inviato a un file locale (--output=./local-wordcounts), l'output della console

include i messaggi di log aggiunti:

2022/05/26 11:36:44 Found : love 2022/05/26 11:36:44 Found : love 2022/05/26 11:36:44 Found : love

Per impostazione predefinita, a Cloud Logging vengono inviate solo le righe di log contrassegnate con INFO e livelli superiori.

Controllare il volume dei log

Puoi anche ridurre il volume dei log generati modificando i livelli di log della pipeline. Se non vuoi continuare a importare alcuni o tutti i log Dataflow, aggiungi un'esclusione Logging per escludere i log Dataflow. Poi, esporta i log in una destinazione diversa, ad esempio BigQuery, Cloud Storage o Pub/Sub. Per ulteriori informazioni, vedi Controllare l'importazione dei log di Dataflow.

Limitazione e throttling della registrazione

I messaggi di log dei worker sono limitati a 15.000 messaggi ogni 30 secondi per worker. Se questo limite viene raggiunto, viene aggiunto un singolo messaggio di log del worker che indica che la registrazione è limitata:

Throttling logger worker. It used up its 30s quota for logs in only 12.345s

Archiviazione e conservazione dei log

I log operativi vengono archiviati nel bucket di log

_Default. Il nome del servizio API Logging è dataflow.googleapis.com. Per saperne di più

sui servizi e sui tipi di risorsa monitorata della Google Cloud Platform utilizzati in

Cloud Logging, consulta Servizi e risorse monitorate.

Per informazioni dettagliate sulla durata di conservazione delle voci di log da parte di Logging, consulta le informazioni sulla conservazione in Quote e limiti: periodi di conservazione dei log.

Per informazioni sulla visualizzazione dei log operativi, vedi Monitorare e visualizzare i log della pipeline.

Monitorare e visualizzare i log della pipeline

Quando esegui la pipeline sul servizio Dataflow, puoi utilizzare l'interfaccia di monitoraggio di Dataflow per visualizzare i log emessi dalla pipeline.

Esempio di log del worker Dataflow

La pipeline WordCount modificata può essere eseguita nel cloud con le seguenti opzioni:

Java

--project=WordCountExample --output=gs://<bucket-name>/counts --runner=DataflowRunner --tempLocation=gs://<bucket-name>/temp --stagingLocation=gs://<bucket-name>/binaries

Python

--project=WordCountExample --output=gs://<bucket-name>/counts --runner=DataflowRunner --staging_location=gs://<bucket-name>/binaries

Vai

--project=WordCountExample --output=gs://<bucket-name>/counts --runner=DataflowRunner --staging_location=gs://<bucket-name>/binaries

Visualizza i log

Poiché la pipeline cloud WordCount utilizza l'esecuzione bloccante, i messaggi della console vengono generati durante l'esecuzione della pipeline. Dopo l'avvio del job, nella console viene visualizzato un link alla pagina della consoleGoogle Cloud , seguito dall'ID job della pipeline:

INFO: To access the Dataflow monitoring console, please navigate to https://console.developers.google.com/dataflow/job/2017-04-13_13_58_10-6217777367720337669 Submitted job: 2017-04-13_13_58_10-6217777367720337669

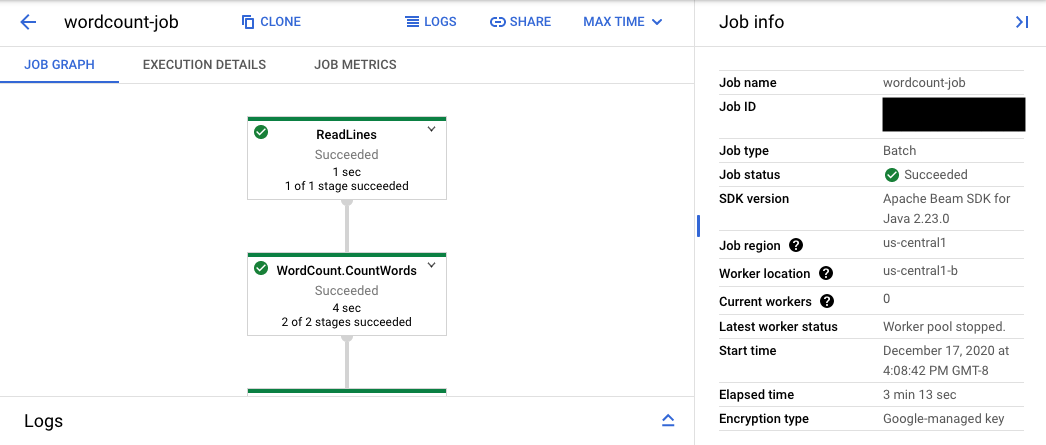

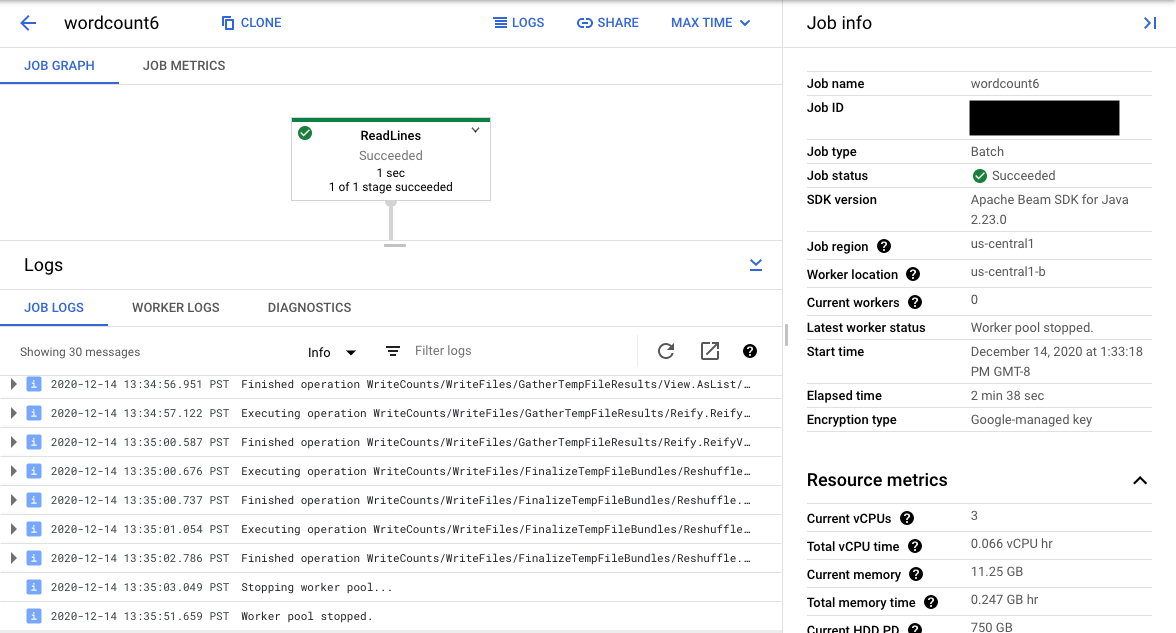

L'URL della console rimanda all'interfaccia di monitoraggio di Dataflow con una pagina di riepilogo per il job inviato. A sinistra viene visualizzato un grafico di esecuzione dinamico, mentre a destra sono riportate le informazioni di riepilogo. Fai clic su keyboard_capslock nel riquadro inferiore per espandere il riquadro dei log.

Per impostazione predefinita, il pannello dei log mostra i log dei job che riportano lo stato del job nel suo complesso. Puoi filtrare i messaggi visualizzati nel riquadro dei log facendo clic su Informazioniarrow_drop_down e filter_listFiltra log.

Se selezioni un passaggio della pipeline nel grafico, la visualizzazione cambia in Log dei passaggi generati dal codice e dal codice generato in esecuzione nel passaggio della pipeline.

Per tornare a Log dei job, cancella il passaggio facendo clic all'esterno del grafico o utilizzando il pulsante Deseleziona passaggio nel riquadro laterale destro.

Vai a Esplora log

Per aprire Esplora log e selezionare diversi tipi di log, nel riquadro dei log, fai clic su Visualizza in Esplora log (il pulsante del link esterno).

In Esplora log, per visualizzare il riquadro con i diversi tipi di log, fai clic sul pulsante di attivazione/disattivazione Campi log.

Nella pagina Esplora log, la query potrebbe filtrare i log in base al passaggio del job o al tipo di log. Per rimuovere i filtri, fai clic sul pulsante di attivazione/disattivazione Mostra query e modifica la query.

Per visualizzare tutti i log disponibili per un job:

Nel campo Query, inserisci la seguente query:

resource.type="dataflow_step" resource.labels.job_id="JOB_ID"Sostituisci JOB_ID con l'ID del tuo job.

Fai clic su Esegui query.

Se utilizzi questa query e non vedi i log per il tuo job, fai clic su Modifica ora.

Modifica l'ora di inizio e di fine, quindi fai clic su Applica.

Tipi di log

Esplora log include anche i log dell'infrastruttura per la tua pipeline. Utilizza i log di errori e avvisi per diagnosticare i problemi osservati nella pipeline. Gli errori e gli avvisi nei log dell'infrastruttura che non sono correlati a un problema della pipeline non indicano necessariamente un problema.

Ecco un riepilogo dei diversi tipi di log disponibili per la visualizzazione dalla pagina Esplora log:

- I log job-message contengono messaggi a livello di job generati da vari componenti di Dataflow. Alcuni esempi includono la configurazione della scalabilità automatica, l'avvio o l'arresto dei worker, l'avanzamento del passaggio del job e gli errori del job. Gli errori a livello di worker che hanno origine dal codice utente che genera arresti anomali e che sono presenti nei log worker vengono propagati anche ai log job-message.

- I log worker vengono generati dai worker Dataflow. I worker svolgono la maggior parte del lavoro della pipeline (ad esempio, applicano le

ParDoai dati). I log Worker contengono i messaggi registrati dal tuo codice e da Dataflow. - I log worker-startup sono presenti nella maggior parte dei job Dataflow e possono acquisire messaggi relativi al processo di avvio. Il processo di avvio include il download dei file JAR del job da Cloud Storage, quindi l'avvio dei worker. Se si verifica un problema con l'avvio dei worker, questi log sono un buon punto di partenza.

- I log harness contengono messaggi dall'harness di Runner v2.

- I log di shuffler contengono messaggi dei worker che consolidano i risultati delle operazioni della pipeline parallela.

- I log di sistema contengono messaggi dai sistemi operativi host delle VM worker. In alcuni scenari, potrebbero acquisire arresti anomali dei processi o eventi di esaurimento della memoria (OOM).

- I log di docker e kubelet contengono messaggi relativi a queste tecnologie pubbliche, utilizzate sui worker Dataflow.

- I log nvidia-mps contengono messaggi relativi alle operazioni di NVIDIA Multi-Process Service (MPS).

Impostare i livelli di log dei worker della pipeline

Java

Il livello di logging SLF4J predefinito impostato sui worker dall'SDK Apache Beam per Java è

INFO. Verranno emessi tutti i messaggi di log di INFO o superiore (INFO,

WARN, ERROR). Puoi impostare un livello di log predefinito diverso

per supportare livelli di logging SLF4J inferiori (TRACE o DEBUG) o impostare livelli di log diversi

per pacchetti diversi di classi nel tuo codice.

Sono disponibili le seguenti opzioni della pipeline per impostare i livelli di log dei worker dalla riga di comando o in modo programmatico:

--defaultSdkHarnessLogLevel=<level>: utilizza questa opzione per impostare tutti i logger al livello predefinito specificato. Ad esempio, la seguente opzione della riga di comando sostituirà il livello di log predefinito di DataflowINFOe lo imposterà suDEBUG:

--defaultSdkHarnessLogLevel=DEBUG--sdkHarnessLogLevelOverrides={"<package or class>":"<level>"}: utilizza questa opzione per impostare il livello di logging per pacchetti o classi specifici. Ad esempio, per eseguire l'override del livello di log della pipeline predefinito per il pacchettoorg.apache.beam.runners.dataflowe impostarlo suTRACE:

--sdkHarnessLogLevelOverrides='{"org.apache.beam.runners.dataflow":"TRACE"}'

Per eseguire più override, fornisci una mappa JSON:

(--sdkHarnessLogLevelOverrides={"<package/class>":"<level>","<package/class>":"<level>",...}).- Le opzioni della pipeline

defaultSdkHarnessLogLevelesdkHarnessLogLevelOverridesnon sono supportate con le pipeline che utilizzano le versioni 2.50.0 e precedenti dell'SDK Apache Beam senza Runner v2. In questo caso, utilizza le opzioni della pipeline--defaultWorkerLogLevel=<level>e--workerLogLevelOverrides={"<package or class>":"<level>"}. Per eseguire più override, fornisci una mappa JSON:

(--workerLogLevelOverrides={"<package/class>":"<level>","<package/class>":"<level>",...})

Il seguente esempio imposta programmaticamente le opzioni di logging della pipeline con valori predefiniti che possono essere sostituiti dalla riga di comando:

PipelineOptions options = ... SdkHarnessOptions loggingOptions = options.as(SdkHarnessOptions.class); // Overrides the default log level on the worker to emit logs at TRACE or higher. loggingOptions.setDefaultSdkHarnessLogLevel(LogLevel.TRACE); // Overrides the Foo class and "org.apache.beam.runners.dataflow" package to emit logs at WARN or higher. loggingOptions.getSdkHarnessLogLevelOverrides() .addOverrideForClass(Foo.class, LogLevel.WARN) .addOverrideForPackage(Package.getPackage("org.apache.beam.runners.dataflow"), LogLevel.WARN);

Python

Il livello di logging predefinito impostato sui worker dall'SDK Apache Beam per Python è

INFO. Verranno emessi tutti i messaggi di log di INFO o superiore (INFO,

WARNING, ERROR, CRITICAL).

Puoi impostare un livello di log predefinito diverso per supportare livelli di logging inferiori (DEBUG)

o impostare livelli di log diversi per moduli diversi nel codice.

Vengono fornite due opzioni di pipeline per consentirti di impostare i livelli di log dei worker dalla riga di comando o in modo programmatico:

--default_sdk_harness_log_level=<level>: utilizza questa opzione per impostare tutti i logger al livello predefinito specificato. Ad esempio, la seguente opzione della riga di comando sostituisce il livello di log predefinito di DataflowINFOe lo imposta suDEBUG:

--default_sdk_harness_log_level=DEBUG--sdk_harness_log_level_overrides={\"<module>\":\"<level>\"}: utilizza questa opzione per impostare il livello di logging per i moduli specificati. Ad esempio, per eseguire l'override del livello di log della pipeline predefinito per il moduloapache_beam.runners.dataflow, e impostarlo suDEBUG:

--sdk_harness_log_level_overrides={\"apache_beam.runners.dataflow\":\"DEBUG\"}

Per eseguire più override, fornisci una mappa JSON:

(--sdk_harness_log_level_overrides={\"<module>\":\"<level>\",\"<module>\":\"<level>\",...}).

L'esempio seguente utilizza la classe

WorkerOptions

per impostare in modo programmatico le opzioni di logging della pipeline

che possono essere sostituite dalla riga di comando:

from apache_beam.options.pipeline_options import PipelineOptions, WorkerOptions pipeline_args = [ '--project=PROJECT_NAME', '--job_name=JOB_NAME', '--staging_location=gs://STORAGE_BUCKET/staging/', '--temp_location=gs://STORAGE_BUCKET/tmp/', '--region=DATAFLOW_REGION', '--runner=DataflowRunner' ] pipeline_options = PipelineOptions(pipeline_args) worker_options = pipeline_options.view_as(WorkerOptions) worker_options.default_sdk_harness_log_level = 'WARNING' # Note: In Apache Beam SDK 2.42.0 and earlier versions, use ['{"apache_beam.runners.dataflow":"WARNING"}'] worker_options.sdk_harness_log_level_overrides = {"apache_beam.runners.dataflow":"WARNING"} # Pass in pipeline options during pipeline creation. with beam.Pipeline(options=pipeline_options) as pipeline:

Sostituisci quanto segue:

PROJECT_NAME: il nome del progettoJOB_NAME: il nome del jobSTORAGE_BUCKET: il nome di Cloud StorageDATAFLOW_REGION: la regione in cui vuoi eseguire il deployment del job DataflowIl flag

--regionsostituisce la regione predefinita impostata nel server dei metadati, nel client locale o nelle variabili di ambiente.

Vai

Questa funzionalità non è disponibile nell'SDK Apache Beam per Go.

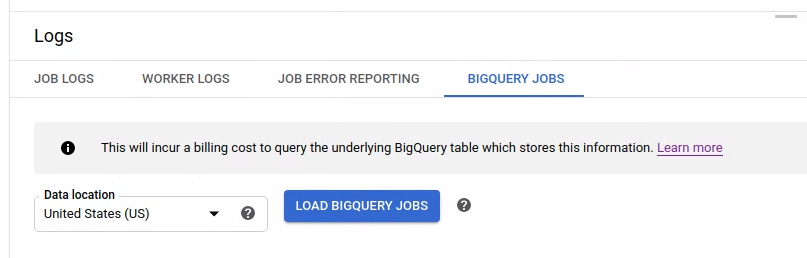

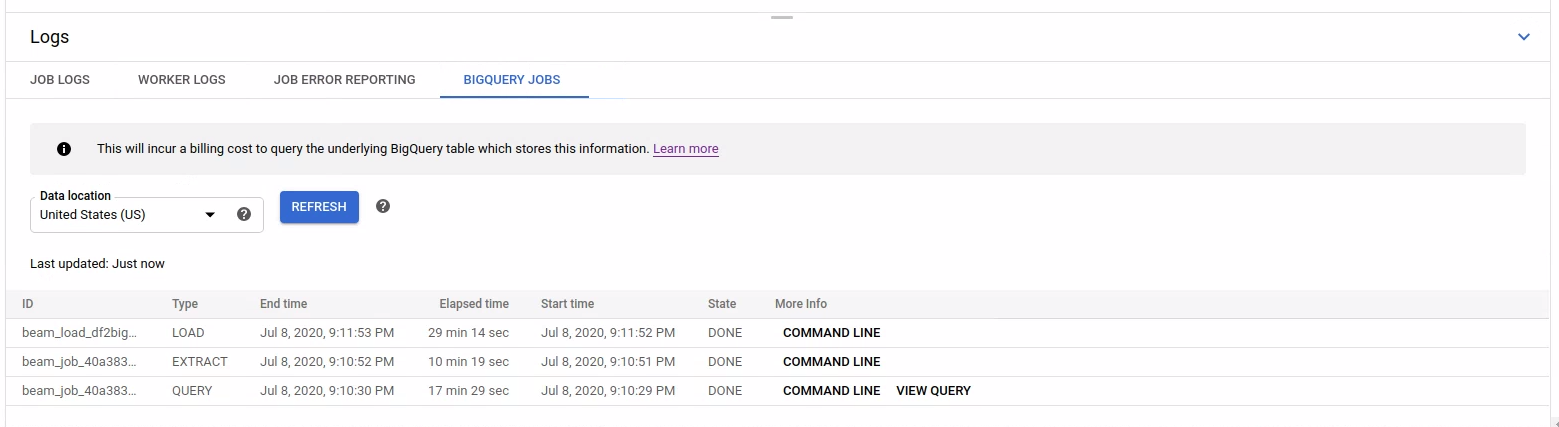

Visualizza il log dei job BigQuery avviati

Quando utilizzi BigQuery nella pipeline Dataflow, vengono avviati job BigQuery per eseguire varie azioni per tuo conto. Queste azioni potrebbero includere il caricamento dei dati, l'esportazione dei dati e altre attività simili. A scopo di risoluzione dei problemi e monitoraggio, l'interfaccia di monitoraggio Dataflow contiene ulteriori informazioni su questi job BigQuery disponibili nel riquadro Log.

Le informazioni sui job BigQuery visualizzate nel riquadro Log vengono memorizzate e caricate da una tabella di sistema BigQuery. Quando viene eseguita una query sulla tabella BigQuery sottostante, viene addebitato un costo di fatturazione.

Visualizzare i dettagli del job BigQuery

Per visualizzare le informazioni sui job BigQuery, la pipeline deve utilizzare Apache Beam 2.24.0 o versioni successive.

Per elencare i job BigQuery, apri la scheda BigQuery Jobs e seleziona la località dei job BigQuery. Poi, fai clic su Carica job BigQuery e conferma la finestra di dialogo. Al termine della query, viene visualizzato l'elenco dei job.

Vengono fornite informazioni di base su ogni job, tra cui ID, tipo, durata e altri dettagli.

Per informazioni più dettagliate su un job specifico, fai clic su Riga di comando nella colonna Altre informazioni.

Nella finestra modale per la riga di comando, copia il comando bq jobs describe ed eseguilo localmente o in Cloud Shell.

gcloud alpha bq jobs describe BIGQUERY_JOB_ID

Il comando bq jobs describe restituisce

JobStatistics,

che fornisce ulteriori dettagli utili per la diagnosi di un job BigQuery lento o bloccato.

In alternativa, quando utilizzi BigQueryIO con una query SQL, viene emesso un job di query. Per visualizzare la query SQL utilizzata dal job, fai clic su Visualizza query nella colonna Ulteriori informazioni.

Visualizzare la diagnostica

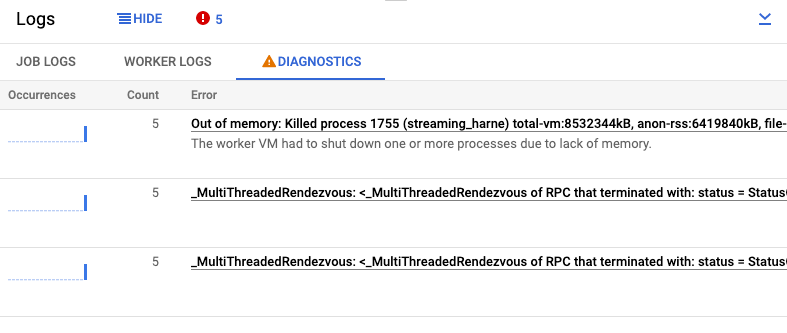

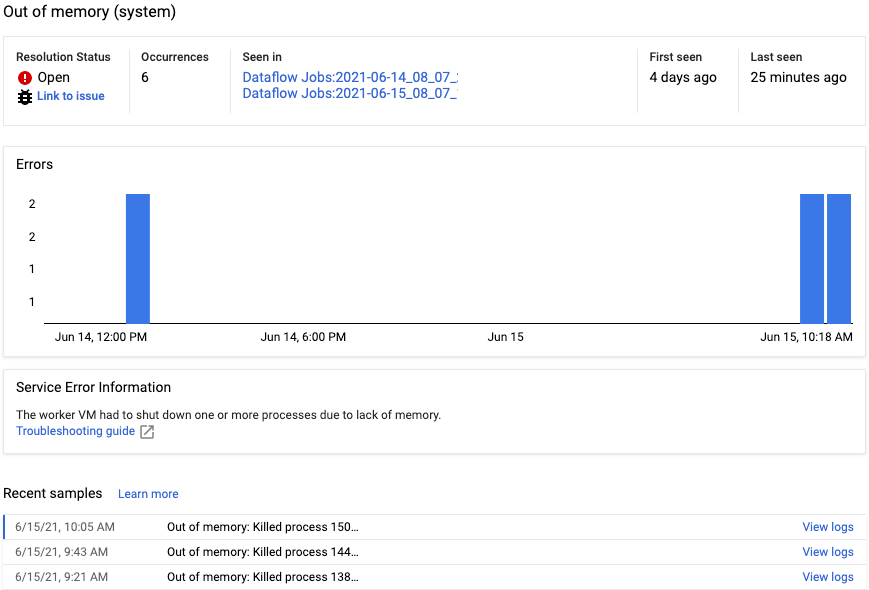

La scheda Diagnostica del riquadro Log raccoglie e mostra determinate voci di log prodotte nelle pipeline. Queste voci includono messaggi che indicano un problema probabile con la pipeline e messaggi di errore con analisi dello stack. Le voci di log raccolte vengono deduplicate e combinate in gruppi di errori.

Il report sugli errori include le seguenti informazioni:

- Un elenco di errori con i relativi messaggi

- Il numero di volte in cui si è verificato ciascun errore

- Un istogramma che indica quando si è verificato ogni errore

- L'ora in cui si è verificato l'errore più di recente

- L'ora in cui si è verificato l'errore per la prima volta

- Lo stato dell'errore

Per visualizzare il report sugli errori per un errore specifico, fai clic sulla descrizione nella colonna Errori. Viene visualizzata la pagina Error Reporting. Se l'errore è un errore del servizio, viene visualizzato un link alla Guida alla risoluzione dei problemi.

Per saperne di più sulla pagina, consulta Visualizzare e filtrare gli errori.

Disattivare la notifica di un errore

Per disattivare un messaggio di errore:

- Apri la scheda Diagnostica.

- Fai clic sull'errore che vuoi disattivare.

- Apri il menu dello stato della risoluzione. Gli stati hanno le seguenti etichette: Aperto, Confermato, Risolto o Disattivato.

- Seleziona Disattivato.

Utilizzare un altro provider di logging SLF4J

Per impostazione predefinita, l'Apache Beam SDK per Java utilizza java.util.logging come provider di logging SLF4J. Quando viene avviata una pipeline, Dataflow

aggiunge automaticamente i file JAR necessari al classpath Java per configurare questo

ambiente di logging.

Per utilizzare un altro provider di logging SLF4J, ad esempio

Reload4J o Logback,

devi impedire l'aggiunta dei file JAR predefiniti al classpath, perché

SLF4J supporta un solo provider di logging in fase di runtime. Aggiungi

il seguente esperimento alle opzioni della pipeline:

--experiments=use_custom_logging_libraries. Questa opzione è disponibile solo per

le pipeline che utilizzano Runner V2 a partire dall'SDK Apache Beam

2.63.0.

Quando attivi questo esperimento, puoi raggruppare il tuo provider di logging SLF4J preferito con i file JAR della pipeline.