Crea una canalización de campañas objetivo

Aprende a usar Cloud Data Fusion para limpiar, transformar y procesar datos de clientes, y así seleccionar candidatos para una campaña de segmentación.

Para seguir la guía paso a paso sobre esta tarea directamente en la consola Google Cloud , haz clic en Guiarme:

Situación

Deseas crear materiales de marketing personalizados para una promoción de campaña en curso y deseas distribuir el material directamente en los buzones de correo de tus clientes.

Su campaña tiene dos restricciones:

- Ubicación: Solo realizas entregas a clientes en California, Washington y Oregón.

- Costo: Para ahorrar en combustible, entregas a los hogares de clientes con acceso rápido. Entregas solo a clientes que viven en avenidas.

En este instructivo, se muestra cómo generar la lista de direcciones de clientes para la campaña. En este instructivo, harás lo que se indica a continuación:

- Limpiar los datos de los clientes: filtrar a los clientes que viven en una avenida de California, Washington u Oregón

Crear una canalización que haga lo siguiente:

- Unir los datos de clientes filtrados con un conjunto de datos públicos que contenga abreviaturas de estado

- Almacenar los datos limpiados y combinados en una tabla de BigQuery que puedas consultar (mediante la interfaz web de BigQuery) o analizar (mediante Looker Studio)

Objetivos

- Conectar Cloud Data Fusion a dos fuentes de datos

- Aplicar transformaciones básicas

- Unir las dos fuentes de datos

- Escribir los datos de salida en un receptor

Antes de comenzar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Data Fusion, BigQuery, Cloud Storage, and Dataproc APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Crea una instancia de Cloud Data Fusion.

En este instructivo, se supone que usas la cuenta de servicio predeterminada de Compute Engine. En la consola de Google Cloud , ve a la página Roles.

Haz clic en Crear rol.

En el campo Title, ingresa

Custom Role-Tutorial.Haz clic en Agregar permisos.

En la ventana Agregar permisos, selecciona los siguientes permisos y haz clic en Agregar:

bigquery.datasets.createbigquery.jobs.createstorage.buckets.create

Haz clic en Crear.

Ve a la página de Instancias de Cloud Data Fusion.

Haz clic en el nombre de la instancia.

Toma nota de la cuenta de servicio de Dataproc predeterminada. La página de detalles de la instancia contiene esta información.

A continuación, se muestra el formato del nombre de la cuenta de servicio de Dataproc:

CUSTOMER_PROJECT_NUMBER-compute@developer.gserviceaccount.comObtén más información sobre las cuentas de servicio de Dataproc.

Ve a la página IAM:

En la barra de filtros, ingresa el nombre de tu cuenta de servicio predeterminada de Dataproc.

Para la cuenta de servicio predeterminada de Compute Engine, haz clic en Editar.

Haz clic en Agregar otro rol.

En el campo Selecciona un rol, selecciona Rol personalizado - instructivo.

Haz clic en Guardar.

Asegúrate de que la cuenta de servicio ya tenga asignado el rol de ejecutor de Cloud Data Fusion.

Administrar permisos

Crea y asigna los roles y permisos personalizados necesarios.

Crea un rol personalizado y agrega permisos

Asigna un rol personalizado a la cuenta de servicio predeterminada de Compute Engine

Prepara los datos del cliente

En este instructivo, se requieren los siguientes dos conjuntos de datos de entrada, los cuales se proporcionan en tu instancia de Cloud Data Fusion:

- Datos de clientes de muestra: Un archivo CSV llamado

customers.csv. - Abreviaturas de estado: Una tabla de BigQuery llamada

state_abbreviations.

Carga los datos del cliente

Ve a la página de Instancias de Cloud Data Fusion.

En la instancia de Cloud Data Fusion que estás usando, haz clic en Ver instancia. Se abrirá la interfaz web de Cloud Data Fusion en una pestaña nueva.

Haz clic en Wrangler. Se abrirá la página Wrangler.

En el panel Connections, selecciona GCS > Sample Buckets.

Haz clic en campaign-tutorial.

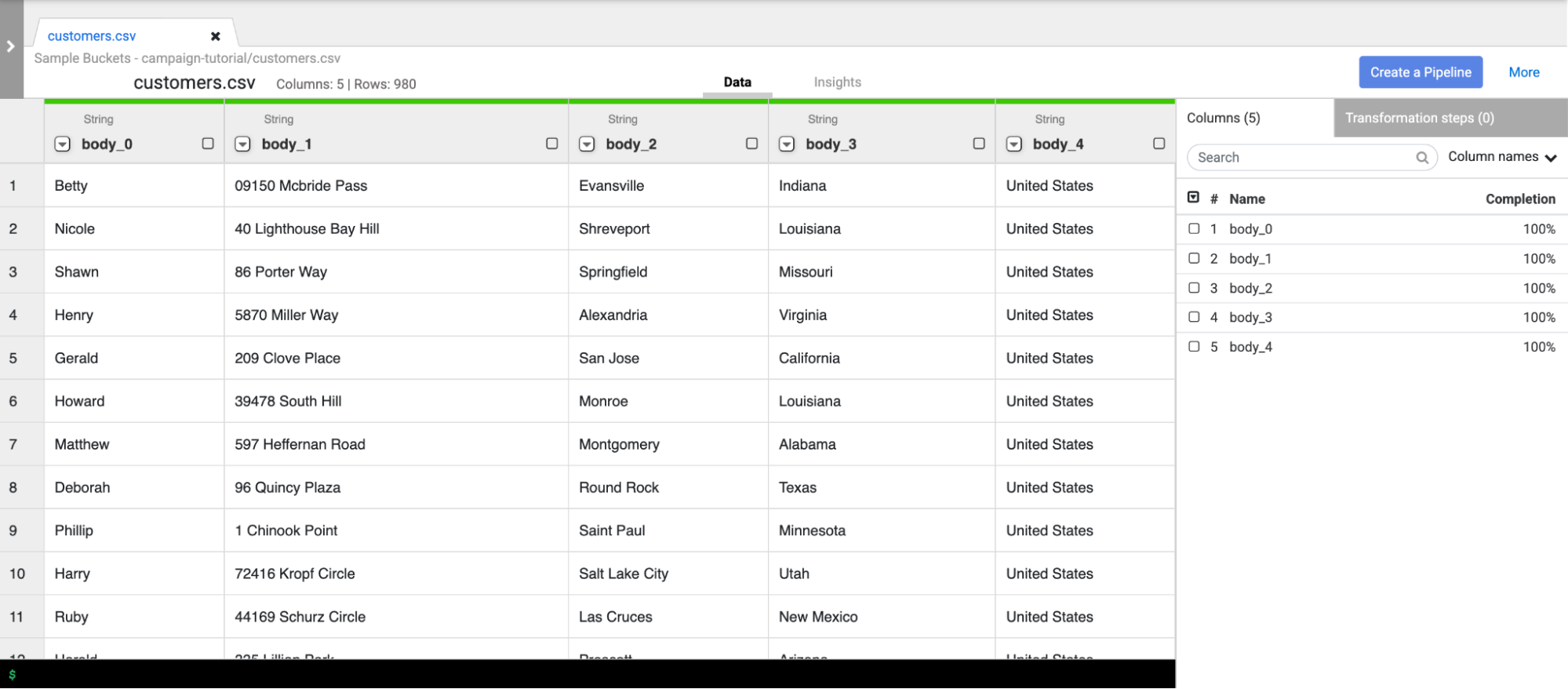

Haz clic en customers.csv.

En la ventana Parsing options, especifica lo siguiente:

- Format:

csv - Enable quoted values:

False - Use first row as header:

False - File-encoding:

UTF-8

- Format:

Haz clic en Confirmar. Los datos del cliente se cargan en una pestaña nueva en Wrangler.

Limpie los datos del cliente

Esto contiene dos subtareas:

- Configurar el esquema

- Filtrar los datos del cliente para presentar solo el público objetivo que necesitas

Configura el esquema

Establece el esquema de los datos mediante la asignación de los nombres adecuados a las columnas de la tabla. Para asignarles nombres más informativos a las columnas, como body_1 y body_2, sigue estos pasos:

- En el panel de la derecha, haz clic en la pestaña Columns.

- Haz clic en el menú desplegable Column names y selecciona Set all.

En el cuadro de diálogo Bulk set column names, ingresa los siguientes nombres de columna separados por comas:

Name,StreetAddress,City,State,CountryHaz clic en Aplicar.

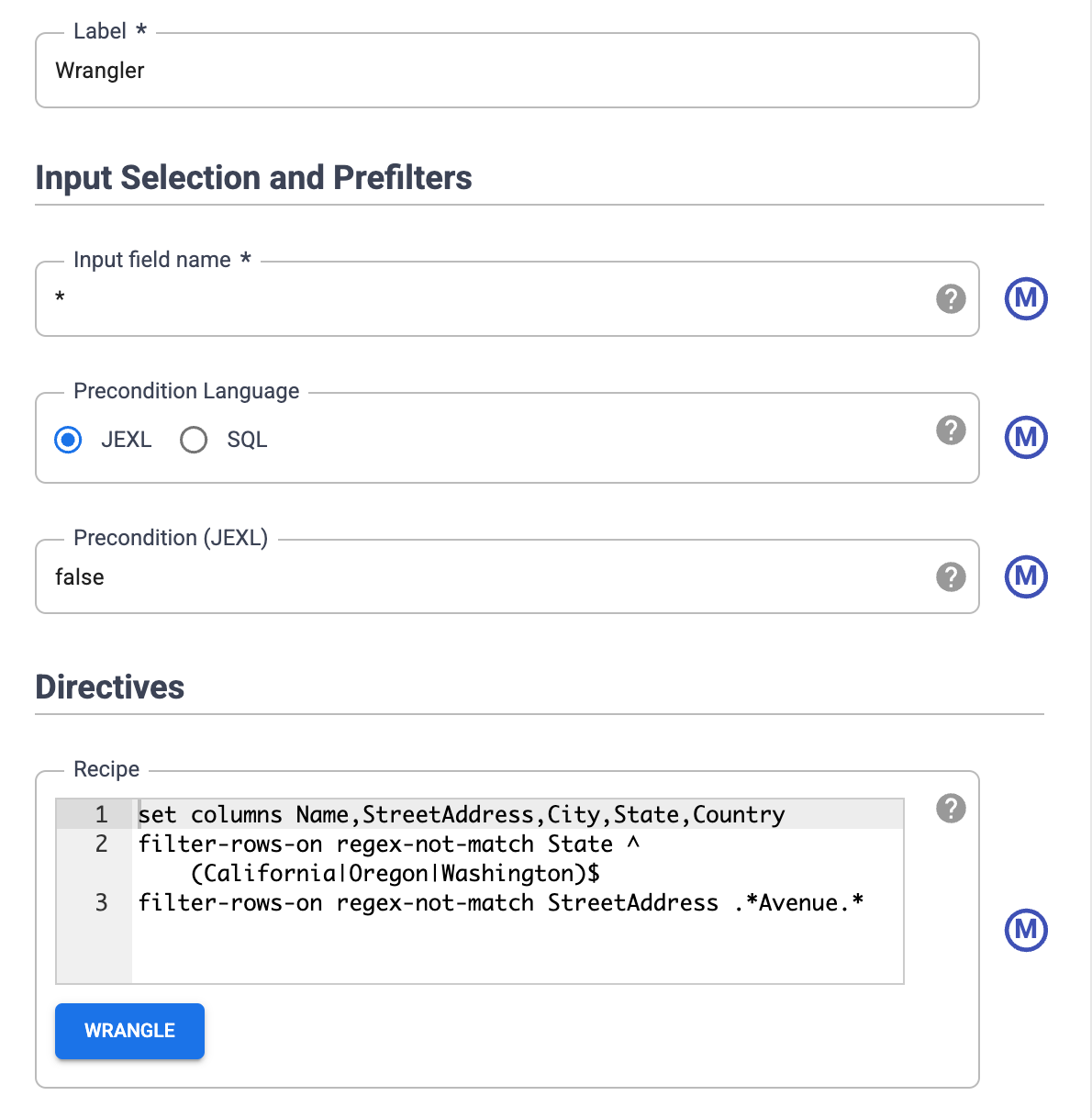

Filtre los datos.

Filtra los datos para mostrar solo los clientes que viven en California, Oregón o Washington.

Quita todas las filas que contengan valores distintos de esos estados:

- Haz clic en el menú desplegable de la columna State y selecciona Filter.

En la ventana de filtros, haz lo siguiente:

- Haz clic en Conservar filas.

- Haz clic en el menú desplegable If y selecciona value matches regex.

Ingrese la siguiente expresión regular:

^(California|Oregon|Washington)$Haz clic en Aplicar.

Los valores de la columna State son California, Oregon o Washington.

Filtra los datos para mostrar solo a los clientes que residen en avenidas. Mantén solo las direcciones que contienen la string Avenue:

- Haz clic en el menú desplegable StreetAddress y selecciona StreetAddress.

- En la ventana de filtros, haga lo siguiente:

- Haz clic en Conservar filas.

- En el menú desplegable If, selecciona value contains y, luego, ingresa

Avenue. - Selecciona Ignore case.

- Haz clic en Aplicar.

Antes de realizar trabajos de procesamiento paralelo en todo tu conjunto de datos, Wrangler muestra solo los primeros 1,000 valores de un conjunto de datos. Debido a que filtraste algunos datos, solo algunos clientes permanecen en la pantalla de Wrangler.

Crea una canalización por lotes

Limpiaste tus datos y ejecutaste transformaciones en un subconjunto de ellos. Ahora puedes crear una canalización por lotes para ejecutar transformaciones en todo tu conjunto de datos.

Cloud Data Fusion traduce la canalización que compilas en Studio en un programa de Apache Spark que ejecuta transformaciones en paralelo en un clúster efímero de Dataproc. Este proceso te permite ejecutar transformaciones complejas sobre grandes cantidades de datos de manera escalable y confiable, sin tener que controlar la infraestructura.

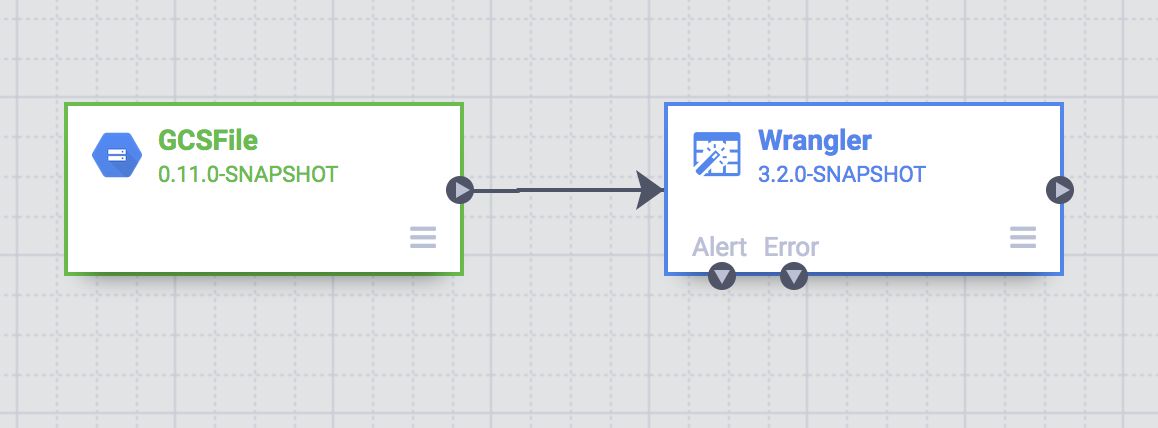

- En la página de Wrangler, haz clic en Create a pipeline.

- Selecciona Canalización por lotes. Se abrirá la página de Studio.

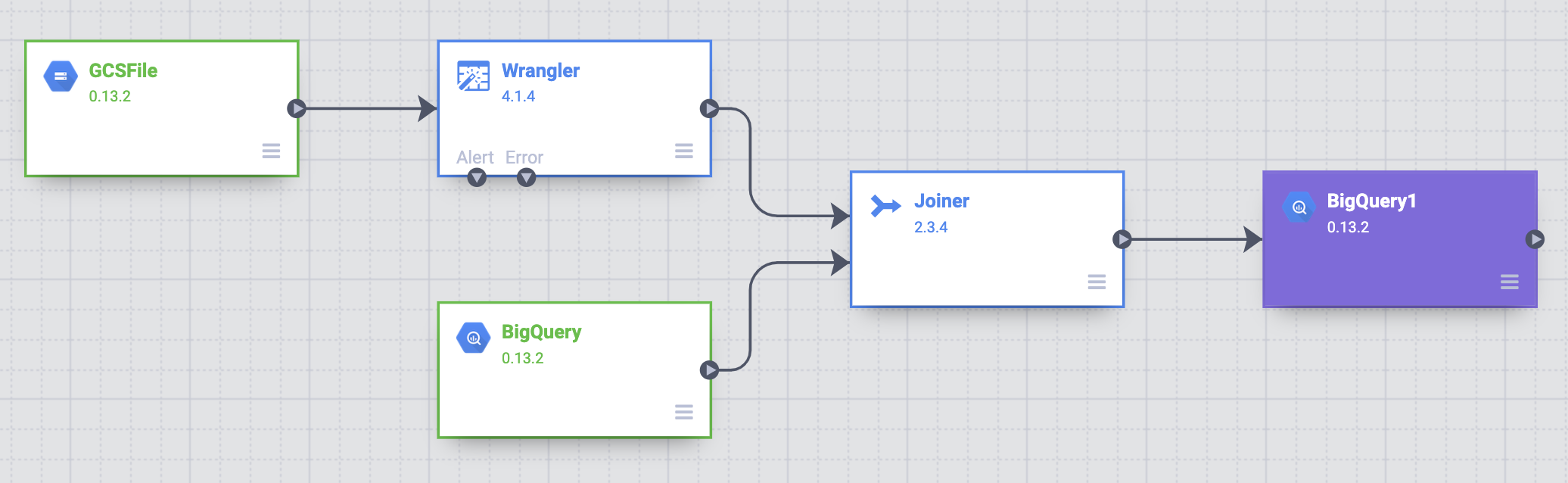

En la página de Studio, hay un nodo de origen GCSFile conectado a un nodo GCSFile.

Las transformaciones que aplicaste en la página de Wrangler aparecen en el nodo de Wrangler en la página Studio.

Para ver las transformaciones que aplicaste, mantén el puntero sobre el nodo de Wrangler y haz clic en Properties.

Las transformaciones que aplicaste aparecen en las Directivas.

Haz clic en Validate.

Haz clic en Cerrar.

Por ejemplo, te das cuenta de que la columna Country no es necesaria porque el valor es siempre USA. Para borrar la columna, sigue estos pasos:

- Haz clic en Wrangle.

- Haz clic en la flecha hacia abajo junto a País y selecciona Borrar columna.

- Haz clic en Aplicar. Se cierra la página de Wrangler y se abre la ventana Propiedades de Wrangler en la página Studio. En Directives, aparecerá

drop Country. - Haz clic en Cerrar.

Abrevie los nombres de los estados

El sistema de navegación de tu vehículo de entrega solo reconoce direcciones que contienen nombres de estados abreviados (CA, no California), y los datos del cliente contienen nombres de estados completos.

La tabla pública state_abbreviations de BigQuery contiene dos columnas: una con los nombres completos de estado y otra con los nombres de estado abreviados.

Puedes usar esta tabla para actualizar los nombres de los estados en tus datos del cliente.

Visualice los datos de los nombres de los estados en BigQuery

En una pestaña aparte, ve a la página de BigQuery Studio:

Haz clic en Crear una consulta en SQL y, luego, ingresa la siguiente consulta en el editor de consultas:

SELECT * FROM `dis-user-guide.campaign_tutorial.state_abbreviations`Haz clic en Ejecutar.

BigQuery muestra una lista de los nombres de los estados y sus abreviaturas.

Cómo acceder a la tabla de BigQuery

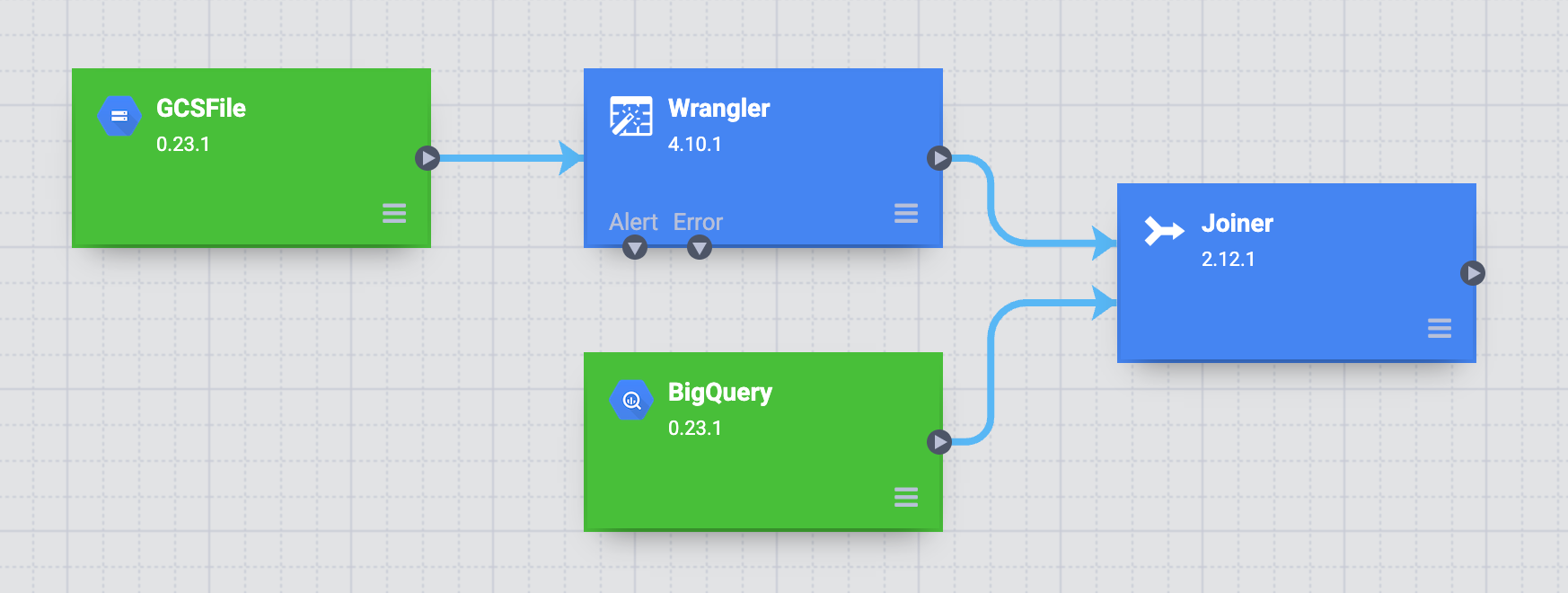

Agrega una fuente en tu canalización que acceda a la tabla state_abbreviations de BigQuery.

- Ve a la página Studio de Cloud Data Fusion y expande el menú Source.

Haga clic en BigQuery.

Aparecerá un nodo fuente de BigQuery en el lienzo junto con los otros dos nodos.

Mantén el puntero sobre el nodo de origen de BigQuery y haz clic en Properties.

- En el campo Dataset Project ID, ingresa

dis-user-guide. - En el campo Reference Name, ingresa

state_abbreviations. - En el campo Dataset, ingresa

campaign_tutorial. - En el campo Table, ingresa

state_abbreviations.

- En el campo Dataset Project ID, ingresa

Propaga el esquema de la tabla desde BigQuery si haces clic en Obtener esquema.

Haz clic en Cerrar.

Una las dos fuentes de datos

Para generar un resultado que contenga datos del cliente con nombres de estados abreviados, une las dos fuentes de datos, los datos del cliente y las abreviaturas de los estados.

- Ve a la página de Studio de Cloud Data Fusion y expande el menú Analytics.

Haz clic en Joiner.

Aparece en el lienzo un nodo de Joiner, que representa una acción similar a una instrucción Join de SQL.

Conecta el nodo Wrangler y el nodo de BigQuery al nodo Joiner. Para ello, arrastra una flecha de conexión del borde derecho del nodo fuente y suéltala en el nodo de destino.

Mantén el puntero sobre el nodo Joiner y haz clic en Properties.

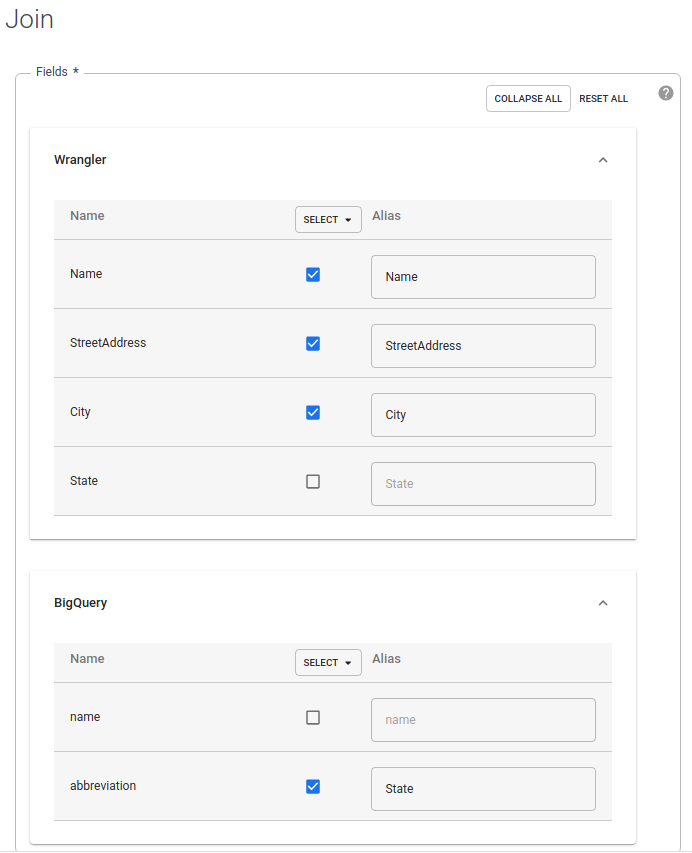

En la sección Fields, expande Wrangler y BigQuery.

- Desmarca la casilla de verificación state de Wrangler.

- Desmarca la casilla de verificación name de BigQuery, ya que solo necesitas el nombre abreviado del estado.

Mantén seleccionada la casilla de verificación abbreviation de BigQuery y cambia el alias a

State.

En el campo Join Type, deja el valor como Outer. En Required inputs, selecciona la casilla de verificación Wrangler.

En la sección Join condition, para Wrangler, selecciona State. Para BigQuery, selecciona nombre.

Genera el esquema de la unión resultante. Haz clic en Obtener esquema.

Haz clic en Validate.

Haz clic en Cerrar.

Almacene el resultado en BigQuery

Almacena el resultado de tu canalización en una tabla de BigQuery. El lugar donde almacena sus datos se denomina receptor.

- Ve a la página Studio de Cloud Data Fusion y expande Receptor.

- Haga clic en BigQuery.

Conecta el nodo de Unión al de BigQuery.

Mantén el puntero sobre el nodo BigQuery y haz clic en Propiedades.

- En el campo Dataset, ingresa

dis_user_guide. - En el campo Table, selecciona

customer_data_abbreviated_states. - Haz clic en Cerrar.

- En el campo Dataset, ingresa

Implementa y ejecuta la canalización

- En la página de Studio, haz clic en Name your pipeline y, luego, ingresa

CampaignPipeline. - Haz clic en Guardar.

- En la esquina superior derecha, haga clic en Implementar.

- Cuando se complete la implementación, haz clic en Run.

Puede tardar unos minutos ejecutar tu canalización. Mientras esperas, puedes observar el Estado de la transición de la canalización: Provisioning > Starting > Running > Deprovisioning > Succeeded.

Vea los resultados

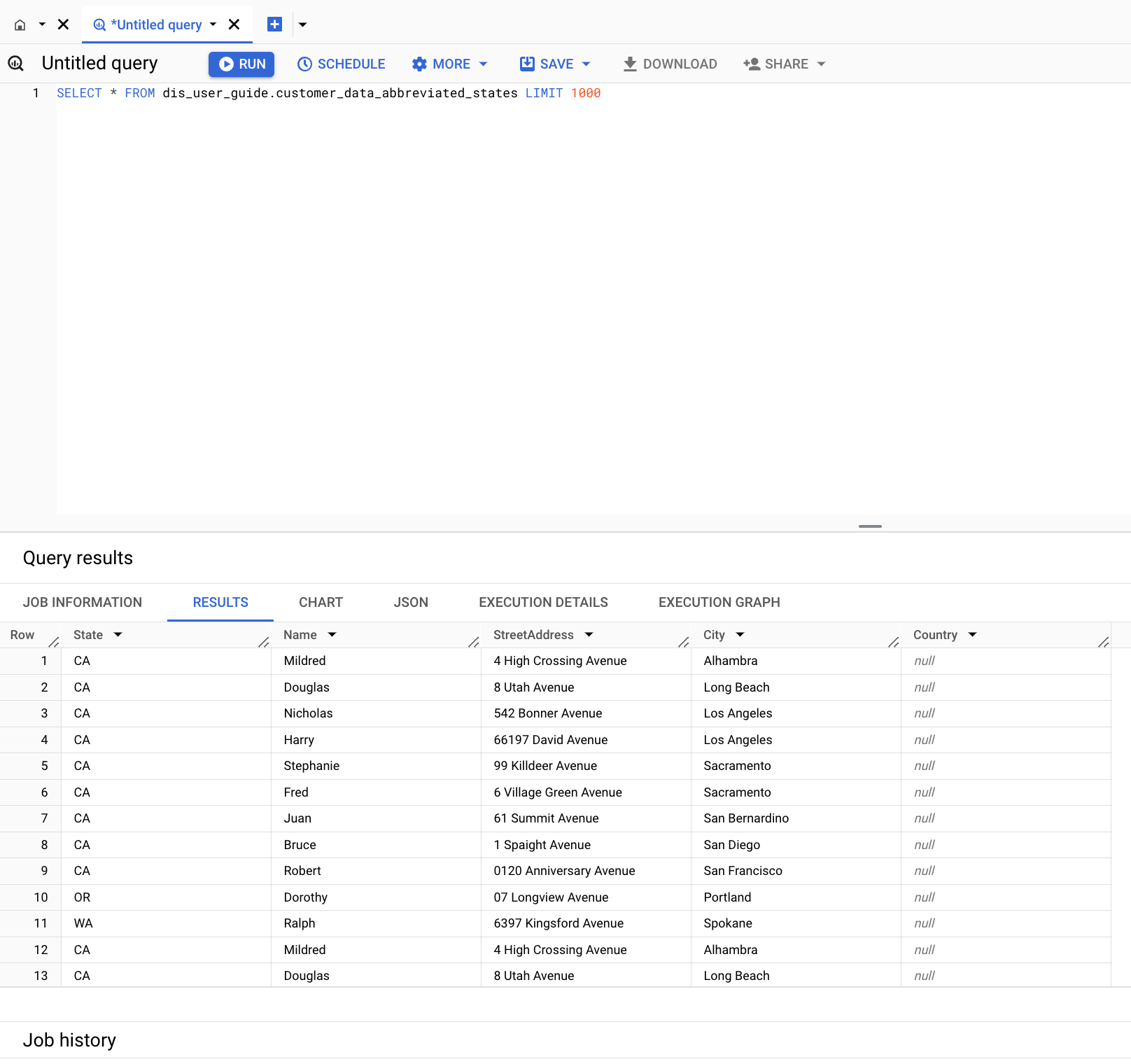

En la consola de Google Cloud , ve a la página BigQuery.

Haz clic en Crear una consulta en SQL.

Consulta la tabla

customer_data_abbreviated_states:SELECT * FROM dis_user_guide.customer_data_abbreviated_states LIMIT 1000

Creaste correctamente una canalización de datos.

Limpia

Sigue estos pasos para evitar que se apliquen cargos a tu cuenta de Google Cloud por los recursos que usaste en esta página.

Borra el conjunto de datos de BigQuery

Para borrar el conjunto de datos de BigQuery que creaste en este instructivo, haz lo siguiente:

- En la consola de Google Cloud , ve a la página BigQuery.

- Selecciona el conjunto de datos

dis_user_guide. - Haz clic en delete Borrar conjunto de datos.

Borra la instancia de Cloud Data Fusion

Sigue estas instrucciones para borrar tu instancia de Cloud Data Fusion.

Borra el proyecto

La manera más fácil de eliminar la facturación es borrar el proyecto que creaste para el instructivo.

Para borrar el proyecto, sigue estos pasos:

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

¿Qué sigue?

- Obtén más información sobre Cloud Data Fusion.