データ パイプラインの作成

このクイックスタートでは、次の方法について説明します。

- Cloud Data Fusion インスタンスを作成します。

- Cloud Data Fusion インスタンスで提供されているサンプル パイプラインをデプロイします。このパイプラインは次の処理を行います。

- NYT ベストセラー データを含む JSON ファイルを Cloud Storage から読み取る

- ファイルに対し変換を実施して、データの解析とクリーニングを行う。

- 先週追加された高評価の書籍で $25 未満のものを BigQuery に読み込む。

始める前に

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Enable the Cloud Data Fusion API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Enable the Cloud Data Fusion API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - [インスタンスを作成] をクリックします。

- [インスタンス名] を入力します。

- インスタンスの [説明] を入力します。

- インスタンスを作成する [リージョン] を入力します。

- 使用する Cloud Data Fusion の [バージョン] を選択します。

- Cloud Data Fusion のエディションを選択します。

- Cloud Data Fusion バージョン 6.2.3 以降の場合は、[承認] フィールドで、Dataproc の Cloud Data Fusion パイプラインを実行するために使用する Dataproc サービス アカウントを選択します。デフォルト値の [Compute Engine アカウント] があらかじめ選択されています。

- [作成] をクリックします。インスタンスの作成プロセスが完了するまで 30 分ほどかかります。Cloud Data Fusion がインスタンスを作成している間 [インスタンス] ページのインスタンス名の横に進捗状況が表示されます。完了すると緑色のチェックマークに変わり、インスタンスの使用を開始できることが示されます。

Google Cloud コンソールで、次のことができます。

- Google Cloud コンソール プロジェクトを作成する

- Cloud Data Fusion インスタンスを作成して削除する

- Cloud Data Fusion インスタンスの詳細を表示する

Cloud Data Fusion ウェブ インターフェースでは、Studio や Wrangler などのさまざまなページを使用して Cloud Data Fusion の機能を使用できます。

- Google Cloud コンソールで、[インスタンス] ページを開きます。

- インスタンスの [操作] 列で、[インスタンスの表示] リンクをクリックします。

- Cloud Data Fusion ウェブ インターフェースで、左側のナビゲーション パネルを使用して必要なページに移動します。

- Cloud Data Fusion ウェブ インターフェースで、[Hub] をクリックします。

- 左側のパネルで [Pipelines] をクリックします。

- [Cloud Data Fusion Quickstart] パイプラインをクリックします。

- [作成] をクリックします。

- Cloud Data Fusion Quickstart 構成パネルで、[Finish] をクリックします。

[Customize Pipeline] をクリックします。

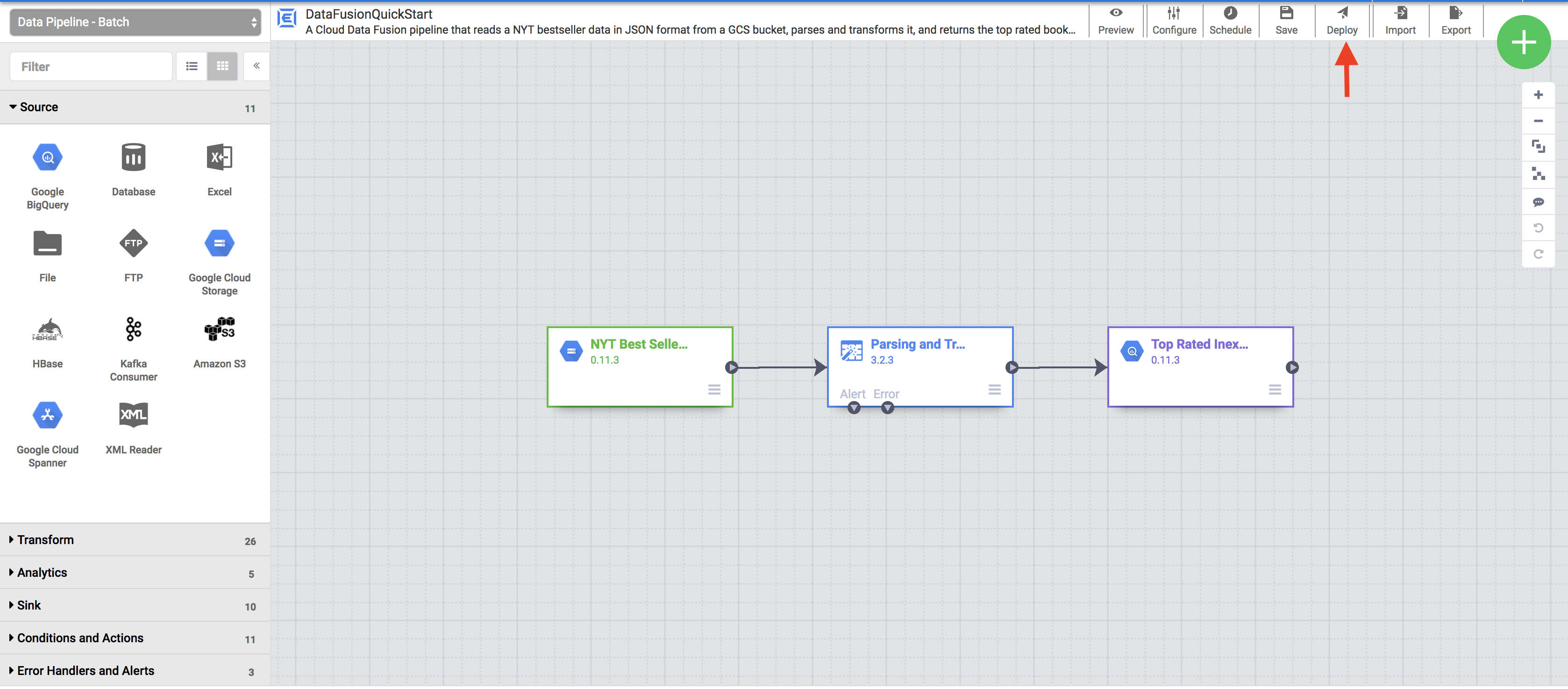

パイプラインの視覚的な表現が [Studio] ページに表示されます。これは、データ統合パイプライン開発用のグラフィカル インターフェースです。左側に使用可能なパイプライン プラグインが表示され、メインのキャンバス領域にパイプラインが表示されます。パイプラインの各ノードの上にポインタを重ねて、[プロパティ] をクリックすると、パイプラインを調べられます。各ノードのプロパティ メニューを使用して、そのノードに関連付けられているオブジェクトや操作を表示できます。

右上のメニューで [Deploy] をクリックします。この手順により、パイプラインが Cloud Data Fusion に送信されます。このクイックスタートの次のセクションでパイプラインを実行します。

- パイプラインの構造と構成を表示する。

- 手動でパイプラインを実行するか、スケジュールやトリガーを設定する。

- 実行時間、ログ、指標など、パイプラインの実行履歴の概要を表示する。

- エフェメラル Dataproc クラスタをプロビジョニングします

- Apache Spark を使用してクラスタ上でパイプラインを実行します

- クラスタを削除します。

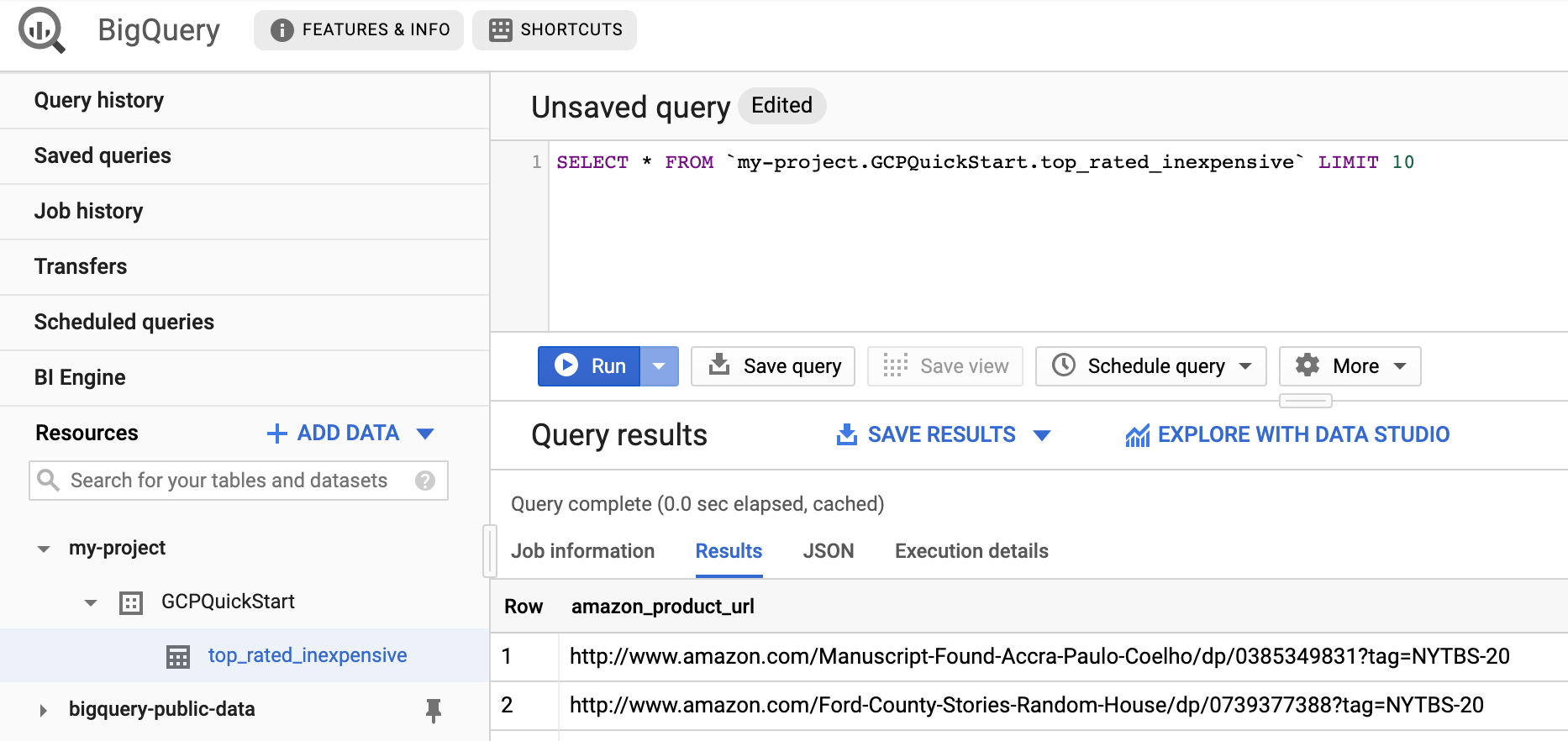

- BigQuery ウェブ インターフェースに移動します。

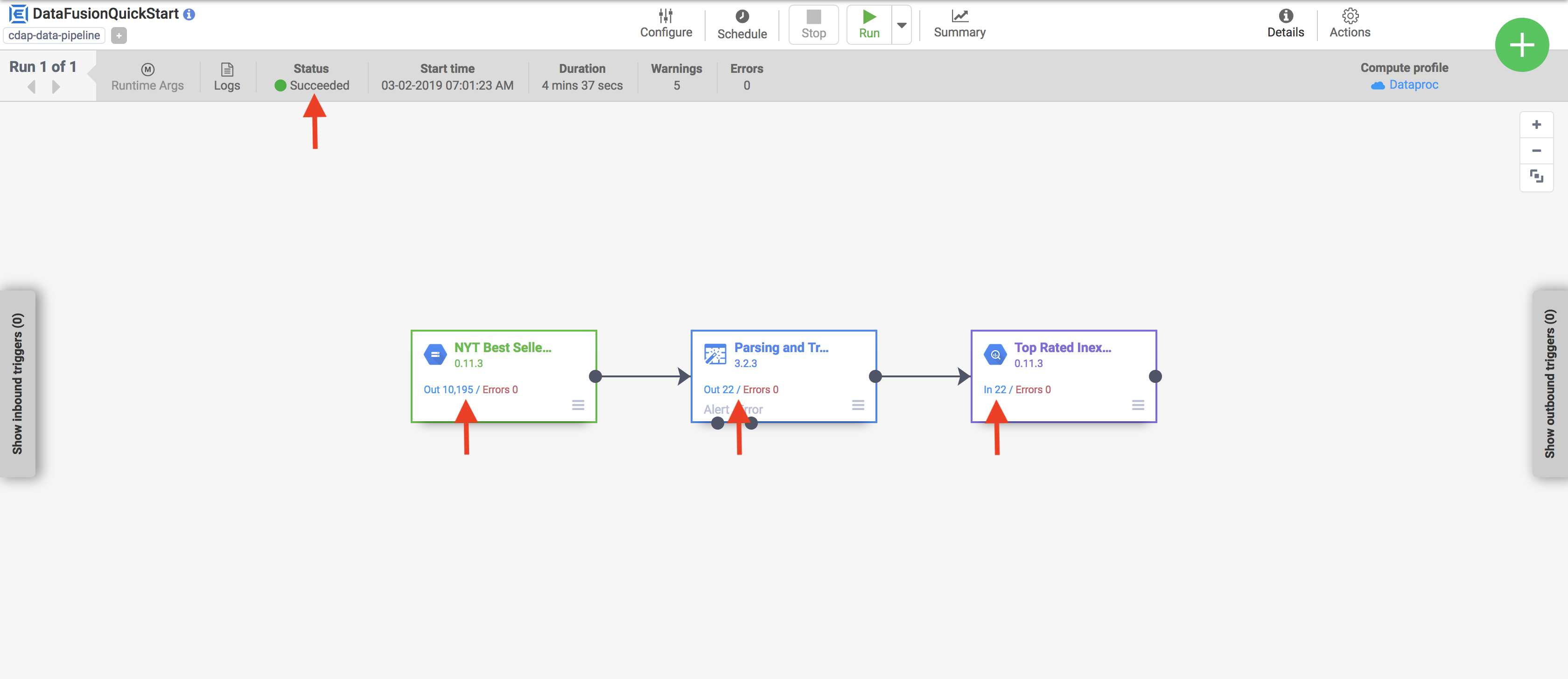

結果のサンプルを表示するには、プロジェクトの

DataFusionQuickstartデータセットに移動してtop_rated_inexpensiveテーブルをクリックし、単純なクエリを実行します。次に例を示します。SELECT * FROM PROJECT_ID.GCPQuickStart.top_rated_inexpensive LIMIT 10PROJECT_ID は、実際のプロジェクト ID に置き換えます。

- このクイックスタートでパイプラインが書き込んだ BigQuery データセットを削除します。

省略可: プロジェクトを削除します。

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

Cloud Data Fusion インスタンスを作成する

Cloud Data Fusion ウェブ インターフェースに移動する

Cloud Data Fusion を使用する際は、 Google Cloud コンソールと個別の Cloud Data Fusion ウェブ インターフェースの両方を使用します。

Cloud Data Fusion インターフェースを操作するには、次の手順に従います。

サンプル パイプラインをデプロイする

サンプル パイプラインは Cloud Data Fusion Hub を使用して入手できます。このサンプル パイプラインにより、再利用可能な Cloud Data Fusion パイプライン、プラグイン、ソリューションを共有できます。

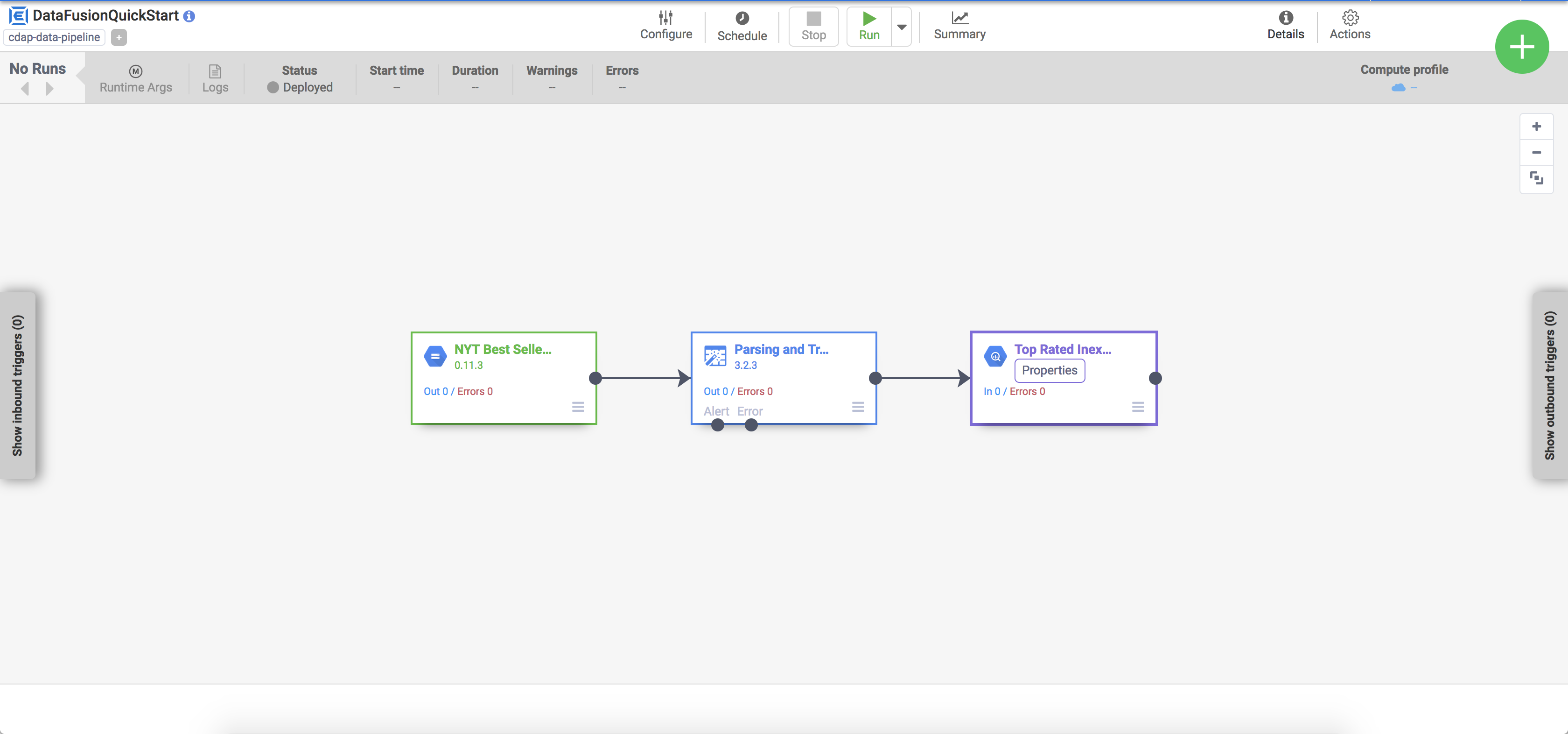

パイプラインを表示する

デプロイされたパイプラインがパイプラインの詳細ビューに表示されます。このビューでは、次の操作を行うことができます。

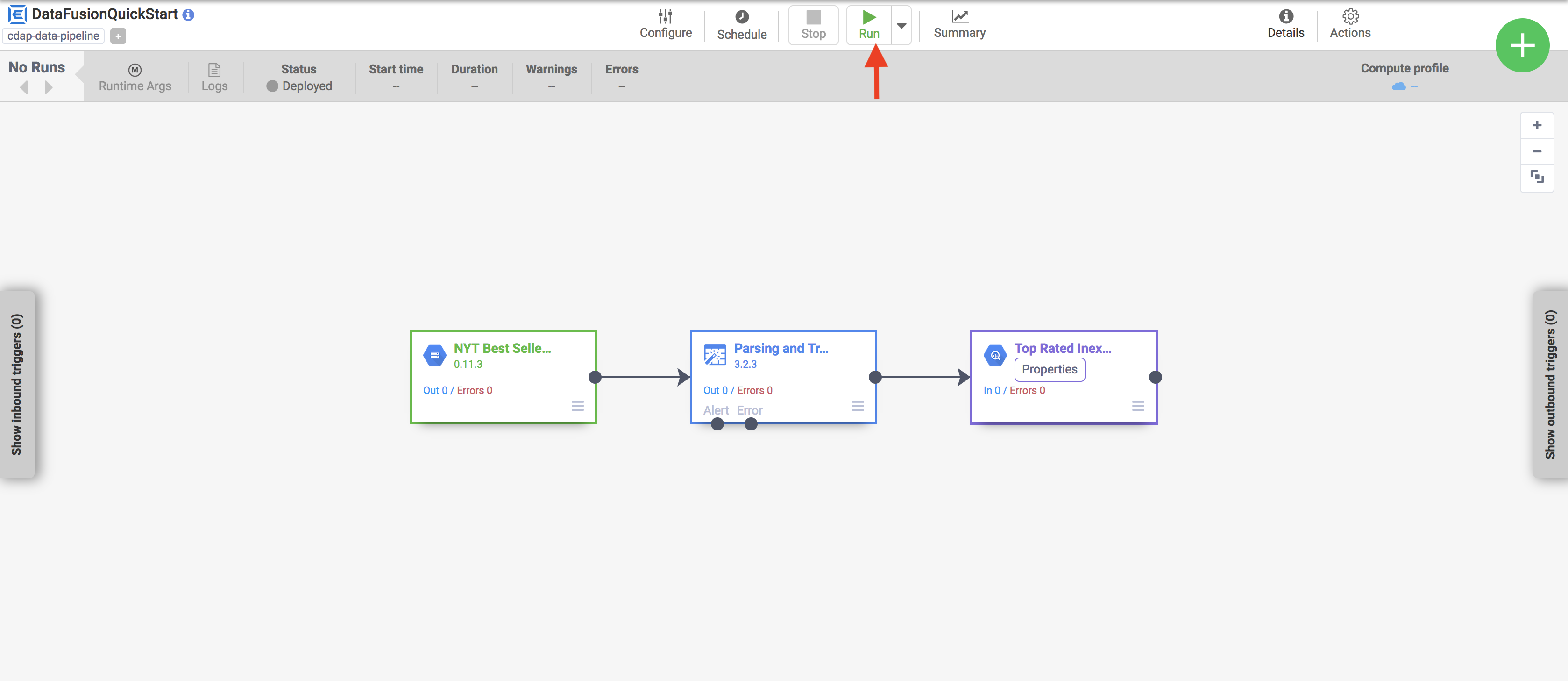

パイプラインを実行する

パイプラインの詳細ビューで [Run] をクリックしてパイプラインを実行します。

パイプラインを実行するときに、Cloud Data Fusion は次の処理を行います。

結果を見る

数分後、パイプラインが完了します。パイプラインのステータスが Succeeded に変わり、各ノードで処理されたレコード数が表示されます。

クリーンアップ

このページで使用したリソースについて、 Google Cloud アカウントに課金されないようにするには、次の手順を実施します。