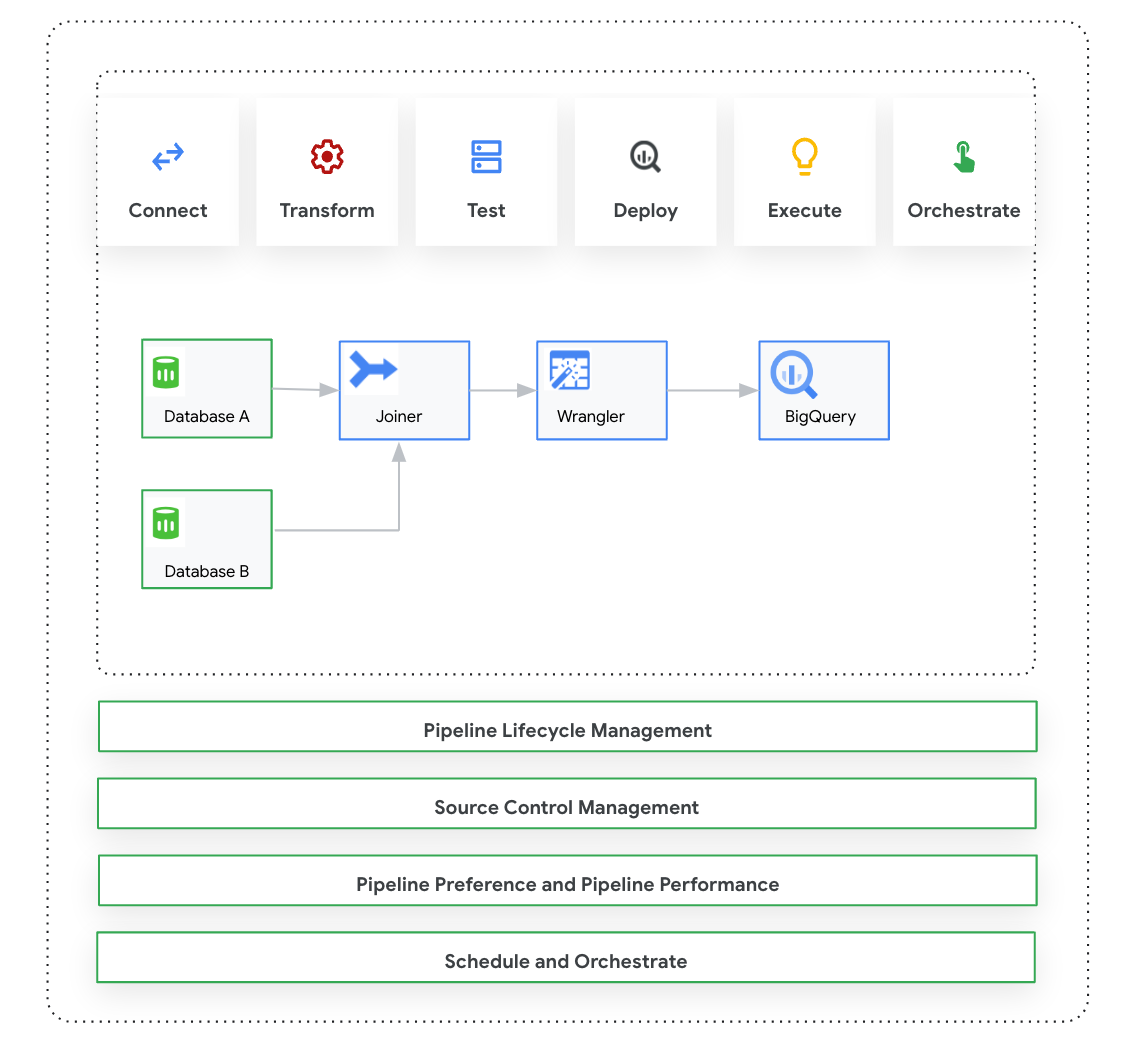

En esta página se presenta Cloud Data Fusion Studio, una interfaz visual de arrastrar y soltar para crear flujos de procesamiento de datos a partir de una biblioteca de complementos precompilados, así como una interfaz en la que puedes configurar, ejecutar y gestionar tus flujos de procesamiento. Para crear una canalización en Studio, normalmente se sigue este proceso:

- Conéctate a una fuente de datos local o en la nube.

- Prepara y transforma tus datos.

- Conéctate al destino.

- Prueba tu flujo de procesamiento.

- Ejecuta el flujo de procesamiento.

- Programa y activa tus flujos de procesamiento.

Una vez que hayas diseñado y ejecutado el flujo de procesamiento, podrás gestionarlo en la página Pipeline Studio de Cloud Data Fusion:

- Reutiliza las canalizaciones parametrizándolas con preferencias y argumentos de tiempo de ejecución.

- Gestiona la ejecución de la canalización personalizando los perfiles de computación, gestionando los recursos y ajustando el rendimiento de la canalización.

- Gestiona el ciclo de vida de los procesos editándolos.

- Gestiona el control de código fuente de la canalización mediante la integración de Git.

Antes de empezar

- Habilita la API Cloud Data Fusion.

- Crea una instancia de Cloud Data Fusion.

- Consulta información sobre el control de acceso en Cloud Data Fusion.

- Familiarizarse con los conceptos y términos clave de Cloud Data Fusion.

Cloud Data Fusion: descripción general de Studio

Studio incluye los siguientes componentes.

Administración

Cloud Data Fusion te permite tener varios espacios de nombres en cada instancia. En Studio, los administradores pueden gestionar todos los espacios de nombres de forma centralizada o cada uno de ellos por separado.

Studio ofrece los siguientes controles de administrador:

- Administrador de sistemas

- El módulo Administrador del sistema de Studio te permite crear nuevos espacios de nombres y definir las configuraciones centrales del perfil de cálculo a nivel del sistema, que se aplican a cada espacio de nombres de esa instancia. Para obtener más información, consulta el artículo Gestionar la administración de Studio.

- Administración de espacios de nombres

- El módulo Administrador de espacio de nombres de Studio te permite gestionar las configuraciones de un espacio de nombres específico. En cada espacio de nombres, puedes definir perfiles de computación, preferencias de tiempo de ejecución, controladores, cuentas de servicio y configuraciones de Git. Para obtener más información, consulta el artículo Gestionar la administración de Studio.

Pipeline Design Studio

Diseñas y ejecutas flujos de procesamiento en Pipeline Design Studio, en la interfaz web de Cloud Data Fusion. El diseño y la ejecución de flujos de datos incluyen los siguientes pasos:

- Conectarse a una fuente: Cloud Data Fusion permite conectarse a fuentes de datos locales y en la nube. La interfaz de Studio tiene complementos del sistema predeterminados que vienen preinstalados en Studio. Puedes descargar complementos adicionales de un repositorio de complementos, conocido como centro. Para obtener más información, consulta el artículo Descripción general de los complementos.

- Preparación de datos: Cloud Data Fusion te permite preparar tus datos con su potente complemento de preparación de datos Wrangler. Wrangler te ayuda a ver, explorar y transformar una pequeña muestra de tus datos en un mismo lugar antes de ejecutar la lógica en todo el conjunto de datos en Studio. De esta forma, puedes aplicar transformaciones rápidamente para saber cómo afectan a todo el conjunto de datos. Puedes crear varias transformaciones y añadirlas a una receta. Para obtener más información, consulta la descripción general de Wrangler.

- Transformar: los complementos de transformación cambian los datos después de que se hayan cargado desde una fuente. Por ejemplo, puedes clonar un registro, cambiar el formato de archivo a JSON o usar el complemento de JavaScript para crear una transformación personalizada. Para obtener más información, consulta la descripción general de los complementos.

- Conectarse a un destino: después de preparar los datos y aplicar las transformaciones, puede conectarse al destino donde quiera cargar los datos. Cloud Data Fusion admite conexiones a varios destinos. Para obtener más información, consulta la descripción general de los complementos.

- Vista previa: después de diseñar la canalización, para depurar los problemas antes de implementar y ejecutar una canalización, ejecuta un trabajo de vista previa. Si se produce algún error, puedes corregirlo en el modo Borrador. Studio usa las 100 primeras filas del conjunto de datos de origen para generar la vista previa. Studio muestra el estado y la duración del trabajo de vista previa. Puedes detener el trabajo en cualquier momento. También puedes monitorizar los eventos de registro mientras se ejecuta el trabajo de vista previa. Para obtener más información, consulta Vista previa de los datos.

Gestionar configuraciones de la canalización: después de previsualizar los datos, puedes implementar la canalización y gestionar las siguientes configuraciones:

- Configuración de computación: puedes cambiar el perfil de computación que ejecuta el flujo de procesamiento. Por ejemplo, puedes ejecutar el flujo de procesamiento en un clúster de Dataproc personalizado en lugar de en el clúster de Dataproc predeterminado.

- Configuración de la canalización: en cada canalización, puede habilitar o inhabilitar la instrumentación, como las métricas de tiempo. De forma predeterminada, la instrumentación está habilitada.

- Configuración del motor: Spark es el motor de ejecución predeterminado. Puedes transferir parámetros personalizados para Spark.

- Recursos: puedes especificar la memoria y el número de CPUs del controlador y del ejecutor de Spark. El controlador coordina el trabajo de Spark. El ejecutor gestiona el procesamiento de datos en Spark.

- Alerta de la canalización: puedes configurar la canalización para que envíe alertas e inicie tareas de posprocesamiento después de que finalice la ejecución de la canalización. Las alertas de la canalización se crean al diseñar la canalización. Una vez que hayas implementado la canalización, podrás ver las alertas. Para cambiar los ajustes de las alertas, puedes editar la canalización.

- Pushdown de transformaciones: puedes habilitar esta opción si quieres que un flujo de procesamiento ejecute determinadas transformaciones en BigQuery.

Para obtener más información, consulta Gestionar configuraciones de la canalización.

Reutilizar flujos de procesamiento con macros, preferencias y argumentos de tiempo de ejecución: Cloud Data Fusion te permite reutilizar flujos de procesamiento de datos. Con las canalizaciones de datos reutilizables, puedes tener una sola canalización que aplique un patrón de integración de datos a una gran variedad de casos prácticos y conjuntos de datos. Las pipelines reutilizables te ofrecen una mejor gestión. Te permiten definir la mayor parte de la configuración de una canalización en el tiempo de ejecución, en lugar de codificarla en el tiempo de diseño. En Pipeline Design Studio, puedes usar macros para añadir variables a las configuraciones de los complementos, de forma que puedas especificar las sustituciones de variables en tiempo de ejecución. Para obtener más información, consulta Gestionar macros, preferencias y argumentos de tiempo de ejecución.

Ejecutar: una vez que hayas revisado las configuraciones de la canalización, puedes iniciar la ejecución de la canalización. Puedes ver el cambio de estado durante las fases de la ejecución de la canalización, como aprovisionamiento, inicio, ejecución y éxito.

Programar y orquestar: los flujos de procesamiento de datos por lotes se pueden configurar para que se ejecuten con una programación y una frecuencia específicas. Después de crear e implementar una canalización, puedes crear una programación. En Pipeline Design Studio, puedes orquestar flujos de procesamiento creando un activador en un flujo de procesamiento de datos por lotes para que se ejecute cuando se completen una o varias ejecuciones de flujos de procesamiento. Se denominan "pipelines de descarga" y "pipelines de subida". Crea un activador en la canalización de nivel inferior para que se ejecute en función de la finalización de una o varias canalizaciones de nivel superior.

Recomendación: También puedes usar Composer para orquestar flujos de procesamiento en Cloud Data Fusion. Para obtener más información, consulta Programar flujos de procesamiento y Orquestar flujos de procesamiento.

Editar flujos de procesamiento: Cloud Data Fusion te permite editar un flujo de procesamiento implementado. Cuando editas un flujo de procesamiento implementado, se crea una nueva versión del flujo con el mismo nombre y se marca como la versión más reciente. De esta forma, puedes desarrollar flujos de procesamiento de forma iterativa en lugar de duplicarlos, lo que crea un nuevo flujo con un nombre diferente. Para obtener más información, consulta Editar flujos de trabajo.

Gestión del control de versiones: Cloud Data Fusion te permite gestionar mejor los flujos de procesamiento entre el desarrollo y la producción con la gestión del control de versiones de los flujos de procesamiento mediante GitHub.

Registro y monitorización: para monitorizar las métricas y los registros de las canalizaciones, te recomendamos que habilites el servicio de registro de Stackdriver para usar Cloud Logging con tu canalización de Cloud Data Fusion.

Siguientes pasos

- Consulta más información sobre cómo gestionar la administración de Studio.