Executar um DAG do Apache Airflow no Cloud Composer 1

Cloud Composer 1 | Cloud Composer 2 | Cloud Composer 3

Neste guia de início rápido, mostramos como criar um ambiente do Cloud Composer e execute um DAG do Apache Airflow no Cloud Composer 1.

Se você é novo no Airflow, consulte a Tutorial de conceitos do Airflow no Apache Airflow documentação para mais informações sobre conceitos, objetos e e como usá-los.

Se você quiser usar a Google Cloud CLI, consulte Execute um DAG do Apache Airflow no Cloud Composer (Google Cloud CLI).

Se você quiser criar um ambiente usando o Terraform, consulte Criar ambientes (Terraform).

Antes de começar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

Enable the Cloud Composer API.

-

Para conseguir as permissões necessárias a fim de concluir o guia de início rápido, peça ao administrador para conceder a você os seguintes papéis do IAM no projeto:

-

Para conferir, criar e gerenciar o ambiente do Cloud Composer:

-

Administrador de ambiente e de objetos do Storage (

roles/composer.environmentAndStorageObjectAdmin) -

Usuário da conta de serviço (

roles/iam.serviceAccountUser)

-

Administrador de ambiente e de objetos do Storage (

-

Para conferir os registros:

Visualizador de registros (

roles/logging.viewer)

Para mais informações sobre a concessão de papéis, consulte Gerenciar o acesso a projetos, pastas e organizações.

Também é possível conseguir as permissões necessárias por meio de papéis personalizados ou de outros papéis predefinidos.

-

Para conferir, criar e gerenciar o ambiente do Cloud Composer:

Criar um ambiente

No console do Google Cloud, acesse a página Criar ambiente.

No campo Nome, use

example-environment.Na lista suspensa Local, selecione uma região para o ambiente do Cloud Composer. Este guia usa a região

us-central1.Para outras opções de configuração do ambiente, use os padrões fornecidos.

Clique em Criar e aguarde até que o ambiente seja criado.

Quando terminar, uma marca de seleção verde vai aparecer ao lado do nome do ambiente.

Criar um arquivo DAG

Um DAG do Airflow é uma coleção de tarefas organizadas que você quer programar e executar. Os DAGs são definidos em arquivos Python padrão.

Neste guia, usamos um exemplo de DAG do Airflow definido no arquivo quickstart.py.

O código Python neste arquivo faz o seguinte:

- Cria um DAG,

composer_sample_dag. Esse DAG é executado todos os dias. - Executa uma tarefa,

print_dag_run_conf. A tarefa imprime a configuração da execução do DAG usando o operador bash.

Salve uma cópia do arquivo quickstart.py na sua máquina local:

faça upload do arquivo DAG para o bucket do ambiente

Todos os ambientes do Cloud Composer têm um bucket do Cloud Storage associado. Apenas programações do Airflow no Cloud Composer

DAGs que estão localizados na pasta /dags neste bucket.

Para programar seu DAG, faça upload do arquivo quickstart.py da máquina local para o

pasta /dags do ambiente:

No console do Google Cloud, acesse a página Ambientes.

Na lista de ambientes, clique no nome do ambiente,

example-environment. A página Detalhes do ambiente é aberta.Clique em Abrir pasta de DAGs. A página Detalhes do bucket é aberta.

Clique em Fazer upload de arquivos e selecione sua cópia de

quickstart.py.Para fazer upload do arquivo, clique em Abrir.

Conferir o DAG

Depois de fazer upload do arquivo DAG, o Airflow faz o seguinte:

- Analisa o arquivo DAG que você enviou. Pode levar alguns minutos para que o DAG ficar disponível para o Airflow.

- Adiciona o DAG à lista de DAGs disponíveis.

- Executa o DAG de acordo com a programação que você forneceu no arquivo DAG.

Verifique se o DAG foi processado sem erros e está disponível no Airflow na interface do DAG. A interface do DAG é a interface do Cloud Composer para visualização Informações do DAG no console do Google Cloud. O Cloud Composer também oferece Acesso à IU do Airflow, que é uma interface nativa da plataforma interface gráfica do usuário.

Aguarde cerca de cinco minutos para que o Airflow tenha tempo de processar o arquivo DAG que você enviou anteriormente e concluir a primeira execução do DAG (explicado mais tarde).

No console do Google Cloud, acesse a página Ambientes.

Na lista de ambientes, clique no nome do ambiente.

example-environment: A página Detalhes do ambiente é aberta.Acesse a guia DAGs.

Verificar se o DAG

composer_quickstartestá presente na lista de DAGs.

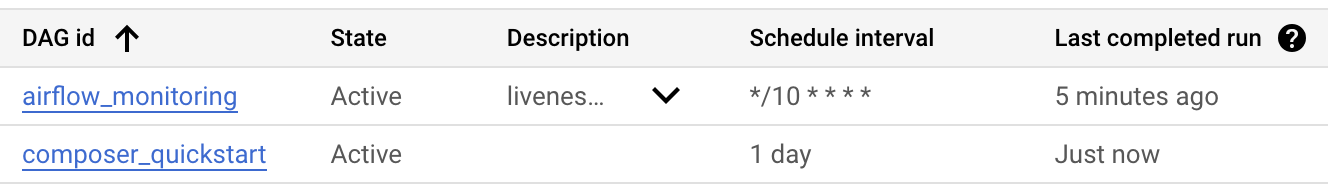

Figura 1. A lista de DAGs exibe DAG composer_quickstart (clique para ampliar)

Mais detalhes da execução do DAG

Uma única execução de um DAG é chamada de execução de DAG. Airflow imediatamente executa um DAG para o DAG de exemplo porque a data de início no arquivo DAG é definido como ontem. Assim, o Airflow alcança os DAGs especificados cronograma.

O DAG de exemplo contém uma tarefa, print_dag_run_conf, que executa a echo

no console. Esse comando gera metainformações sobre o DAG

(identificador numérico da execução do DAG).

Na guia DAGs, clique em

composer_quickstart. A guia Runs do DAG é aberta.Na lista de execuções do DAG, clique na primeira entrada.

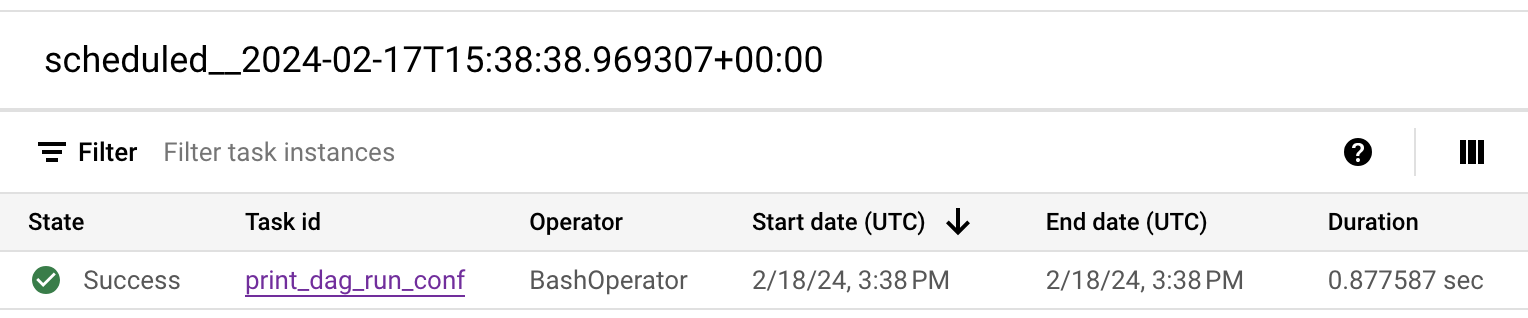

Figura 2. A lista de execuções de DAG para o DAG composer_quickstart (clique para ampliar) Os detalhes da execução do DAG são mostrados, detalhando as informações as tarefas do DAG de exemplo.

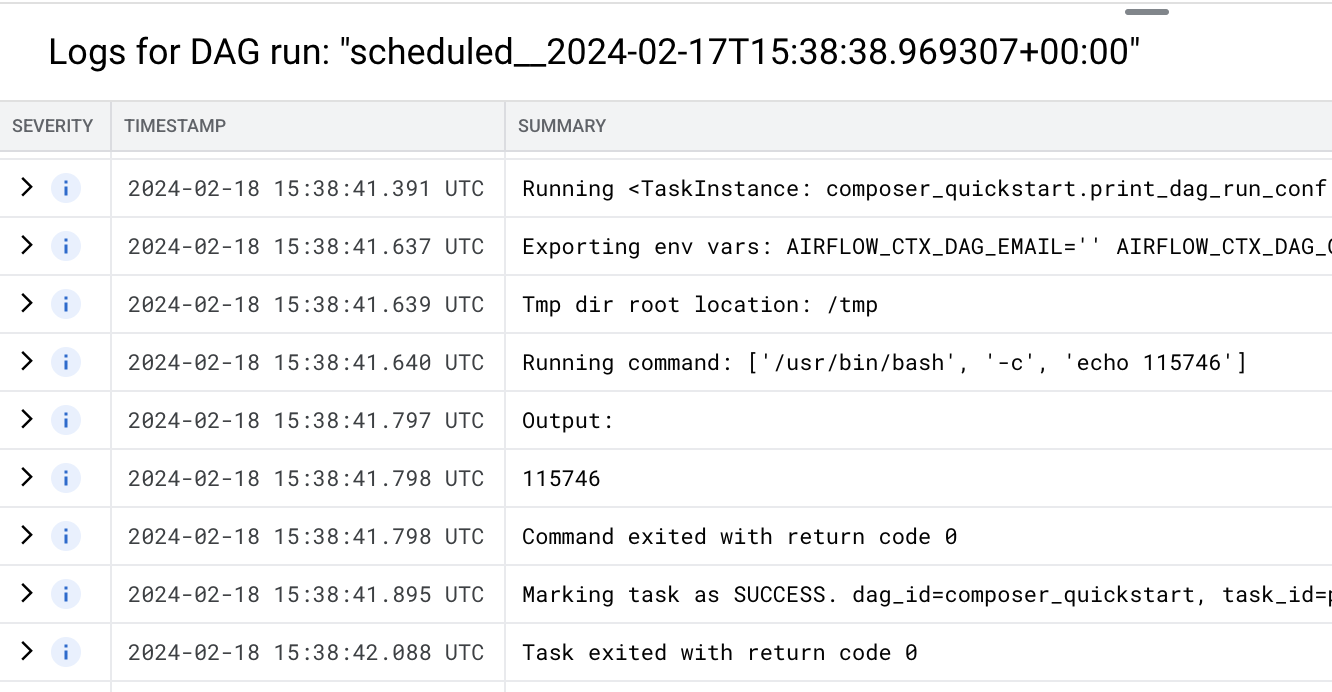

Figura 3. A lista de tarefas que foram executadas em a execução do DAG (clique para ampliar) A seção Registros da execução do DAG lista os registros de todas as tarefas na execução do DAG. É possível conferir a saída do comando

echonos registros.

Figura 4. Registros da tarefa print_dag_run_conf (clique para ampliar)

Limpar

Para evitar cobranças na conta do Google Cloud pelos recursos usados nesta página, siga estas etapas.

Exclua os recursos usados neste tutorial:

Exclua o ambiente do Cloud Composer:

No console do Google Cloud, acesse a página Ambientes.

Selecione

example-environmente clique em Excluir.Aguarde até o ambiente ser excluído.

Exclua o bucket do ambiente. A exclusão do ambiente do Cloud Composer não exclui o bucket.

No console do Google Cloud, acesse Armazenamento > Navegador.

Selecione o bucket do ambiente e clique em Excluir. Por exemplo, ele pode ter o nome

us-central1-example-environ-c1616fe8-bucket.

Exclua o disco permanente da fila do Redis do seu ambiente. A exclusão do ambiente do Cloud Composer não remove o disco permanente.

No console do Google Cloud, acesse a página Compute Engine > Discos.

Selecione o disco permanente da fila do Redis do ambiente e clique em Excluir.

Por exemplo, esse disco pode ser nomeado

gke-us-central1-exampl-pvc-b12055b6-c92c-43ff-9de9-10f2cc6fc0ee: Os discos do Cloud Composer 1 sempre têm aStandard persistent disktipo e o tamanho de 2 GB.

A seguir