Ironwood:Google Cloud 第 7 代 TPU,專為推論作業打造

運用目前最強大的 TPU,有效率地訓練、微調及提供更大的模型和資料集。

歡迎洽詢 Ironwood 的詳細資訊。

姓氏

名字

公司電子郵件地址

電話國碼 (+1)

+1

- (+1)

公司電話

職稱

公司名稱

國家/地區美國

- 不丹

- 中國

- 中非共和國

- 丹麥

- 亞塞拜然

- 亞美尼亞

- 以色列

- 伊拉克

- 俄羅斯

- 保加利亞

- 克羅埃西亞

- 冰島

- 列支敦斯登

- 利比亞

- 剛果(布拉薩)

- 剛果(金夏沙)

- 加彭

- 加拿大

- 匈牙利

- 北馬其頓

- 北馬利安納群島

- 千里達及托巴哥

- 南喬治亞與南三明治群島

- 南極洲

- 南蘇丹

- 南非

- 南韓

- 卡達

- 印尼

- 印度

- 厄利垂亞

- 厄瓜多

- 台灣

- 史瓦帝尼

- 吉布地

- 吉爾吉斯

- 吉里巴斯

- 吐瓦魯

- 哈薩克

- 哥倫比亞

- 哥斯大黎加

- 喀麥隆

- 喬治亞

- 土克斯及開科斯群島

- 土庫曼

- 土耳其

- 坦尚尼亞

- 埃及

- 塔吉克

- 塞內加爾

- 塞席爾

- 塞爾維亞

- 墨西哥

- 多哥

- 多明尼加共和國

- 多米尼克

- 奈及利亞

- 奧地利

- 委內瑞拉

- 孟加拉

- 安哥拉

- 安地卡及巴布達

- 安奎拉

- 安道爾

- 宏都拉斯

- 密克羅尼西亞

- 寮國

- 尚比亞

- 尼加拉瓜

- 尼日

- 尼泊爾

- 巴勒斯坦

- 巴哈馬

- 巴基斯坦

- 巴布亞紐幾內亞

- 巴拉圭

- 巴拿馬

- 巴林

- 巴西

- 巴貝多

- 布吉納法索

- 布威島

- 希臘

- 帛琉

- 幾內亞

- 幾內亞比索

- 庫克群島

- 庫拉索

- 德國

- 愛沙尼亞

- 愛爾蘭

- 托克勞群島

- 拉脫維亞

- 挪威

- 挪威屬斯瓦巴及尖棉

- 捷克

- 摩洛哥

- 摩爾多瓦

- 摩納哥

- 斐濟

- 斯洛伐克

- 斯洛維尼亞

- 斯里蘭卡

- 新加坡

- 新喀里多尼亞

- 日本

- 智利

- 東加

- 東帝汶

- 查德

- 柬埔寨

- 格瑞那達

- 格陵蘭

- 梵蒂岡

- 模里西斯

- 比利時

- 汶萊

- 沙烏地阿拉伯

- 法國

- 法屬南部屬地

- 法屬圭亞那

- 法屬玻里尼西亞

- 法屬聖馬丁

- 法羅群島

- 波士尼亞與赫塞哥維納

- 波多黎各

- 波札那

- 波蘭

- 泰國

- 海地

- 澳洲

- 澳門

- 烏克蘭

- 烏干達

- 烏拉圭

- 烏茲別克

- 牙買加

- 獅子山

- 玻利維亞

- 瑞典

- 瑞士

- 瓜地洛普

- 瓜地馬拉

- 瓦利斯群島和富圖那群島

- 甘比亞

- 留尼旺

- 白俄羅斯

- 百慕達

- 皮特肯群島

- 盧安達

- 盧森堡

- 直布羅陀

- 福克蘭群島(馬爾維納斯群島)

- 科克斯(基靈)群島

- 科威特

- 秘魯

- 突尼西亞

- 立陶宛

- 約旦

- 納米比亞

- 紐埃島

- 紐西蘭

- 索羅門群島

- 索馬利亞

- 維德角

- 緬甸

- 羅馬尼亞

- 美國

- 美國本土外小島嶼

- 美屬維京群島

- 美屬薩摩亞

- 義大利

- 聖克里斯多福及尼維斯

- 聖多美普林西比

- 聖巴瑟米

- 聖文森及格瑞那丁

- 聖皮埃與密克隆群島

- 聖誕島

- 聖赫勒拿島

- 聖露西亞

- 聖馬利諾

- 肯亞

- 芬蘭

- 英國

- 英屬印度洋領地

- 英屬維京群島

- 茅利塔尼亞

- 荷屬聖馬丁

- 荷屬阿魯巴

- 荷蘭

- 莫三比克

- 菲律賓

- 萬那杜

- 葉門

- 葛摩

- 葡萄牙

- 蒙古

- 蒙哲臘

- 蒙特內哥羅

- 蒲隆地

- 蓋亞那

- 薩摩亞

- 薩爾瓦多

- 蘇利南

- 衣索比亞

- 西撒哈拉

- 西班牙

- 諾福克島

- 諾魯

- 象牙海岸

- 貝南

- 貝里斯

- 賴比瑞亞

- 賴索托

- 賽普勒斯

- 赤道幾內亞

- 赫德島及麥唐納群島

- 越南

- 辛巴威

- 迦納

- 開曼群島

- 關島

- 阿富汗

- 阿拉伯聯合大公國

- 阿曼

- 阿根廷

- 阿森松島

- 阿爾及利亞

- 阿爾巴尼亞

- 香港

- 馬丁尼克

- 馬來西亞

- 馬利

- 馬拉威

- 馬爾他

- 馬爾地夫

- 馬約特島

- 馬紹爾群島

- 馬達加斯加

- 黎巴嫩

我想收到 Google 發送的 Google Cloud 相關新聞、產品最新動態、活動資訊與特價優惠。

我瞭解 Google 會依據其《隱私權政策》處理我的個人資料。

貴企業的基礎架構是否已準備好迎接推論時代?

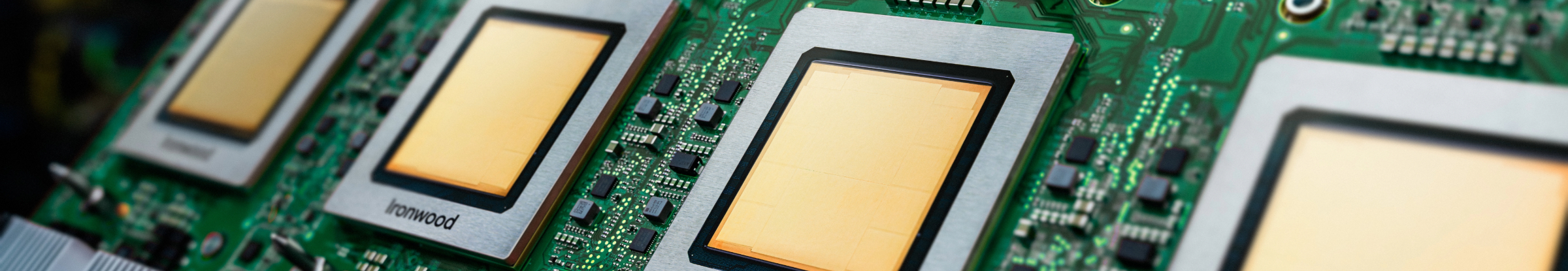

Ironwood 是 Google 迄今最強大、功能最佳且最高效節能的 Tensor Processing Unit (TPU),專為大規模驅動思考型和推論型 AI 模型而打造。我們有為 Google 內部服務和 Google Cloud 客戶開發 TPU 的豐富經驗,並根據這些經驗建構 Ironwood,以處理大型語言模型 (LLM)、混合專家模型 (MoE) 等模型,以及進階推論任務的運算和記憶體需求。Ironwood 可在 Google Cloud AI Hypercomputer 架構中支援訓練及提供模型的工作負載。

專為大型語言模型 (LLM) 最佳化:Ironwood 專為加速需求日益增加的 LLM 和生成式 AI 應用程式而設計。

強化的互連網路技術:採用改良版 TPU 互連網路技術,可加快通訊速度並縮短延遲時間。

高效能運算:在執行各種推論任務時,體驗大幅提升的效能。

永續 AI:Ironwood 延續 Google Cloud 對永續發展的承諾,以最佳化的能源效率提供卓越效能

Ironwood 整合了更高的運算密度、記憶體容量和互連網路頻寬,同時大幅提升電源效率。這些功能可提高處理量並縮短延遲時間,讓您輕鬆處理嚴苛的 AI 訓練及提供模型的工作負載,尤其是涉及大型複雜模型的工作負載。Ironwood TPU 在 Google Cloud AI Hypercomputer 架構中運作。

Cloud AI 產品符合我們的服務水準協議政策。這些產品的延遲時間或可用性保證可能與其他 Google Cloud 服務不同。