Ironwood:专为推理而打造的第 7 代 Google Cloud TPU

使用迄今最强大的 TPU 高效地训练、微调和提供更大的模型和数据集。

欢迎咨询 Ironwood 的详情。

姓氏

名字

公司电子邮箱

呼叫代码 (+1)

+1

- (+1)

工作电话

职位

公司名称

国家/地区美国

- 不丹

- 东帝汶

- 中国

- 中非共和国

- 丹麦

- 乌克兰

- 乌兹别克斯坦

- 乌干达

- 乌拉圭

- 乍得

- 也门

- 亚美尼亚

- 以色列

- 伊拉克

- 伯利兹

- 佛得角

- 俄罗斯

- 保加利亚

- 克罗地亚

- 关岛

- 冈比亚

- 冰岛

- 几内亚

- 几内亚比绍

- 列支敦士登

- 刚果(布)

- 刚果(金)

- 利比亚

- 利比里亚

- 加拿大

- 加纳

- 加蓬

- 匈牙利

- 北马其顿

- 北马里亚纳群岛

- 南乔治亚和南桑威奇群岛

- 南极洲

- 南苏丹

- 南非

- 博茨瓦纳

- 卡塔尔

- 卢旺达

- 卢森堡

- 印度

- 印度尼西亚

- 危地马拉

- 厄瓜多尔

- 厄立特里亚

- 台湾

- 吉尔吉斯斯坦

- 吉布提

- 哈萨克斯坦

- 哥伦比亚

- 哥斯达黎加

- 喀麦隆

- 图瓦卢

- 土库曼斯坦

- 土耳其

- 圣卢西亚

- 圣基茨和尼维斯

- 圣多美和普林西比

- 圣巴泰勒米

- 圣文森特和格林纳丁斯

- 圣皮埃尔和密克隆群岛

- 圣诞岛

- 圣赫勒拿

- 圣马力诺

- 圭亚那

- 坦桑尼亚

- 埃及

- 埃塞俄比亚

- 基里巴斯

- 塔吉克斯坦

- 塞内加尔

- 塞尔维亚

- 塞拉利昂

- 塞浦路斯

- 塞舌尔

- 墨西哥

- 多哥

- 多米尼克

- 多米尼加共和国

- 奥地利

- 委内瑞拉

- 孟加拉国

- 安哥拉

- 安圭拉

- 安提瓜和巴布达

- 安道尔

- 密克罗尼西亚

- 尼加拉瓜

- 尼日利亚

- 尼日尔

- 尼泊尔

- 巴勒斯坦

- 巴哈马

- 巴基斯坦

- 巴巴多斯

- 巴布亚新几内亚

- 巴拉圭

- 巴拿马

- 巴林

- 巴西

- 布基纳法索

- 布隆迪

- 布韦岛

- 希腊

- 帕劳

- 库克群岛

- 库拉索

- 开曼群岛

- 德国

- 意大利

- 所罗门群岛

- 托克劳

- 拉脱维亚

- 挪威

- 捷克

- 摩尔多瓦

- 摩洛哥

- 摩纳哥

- 文莱

- 斐济

- 斯威士兰

- 斯洛伐克

- 斯洛文尼亚

- 斯瓦尔巴和扬马延

- 斯里兰卡

- 新加坡

- 新喀里多尼亚

- 新西兰

- 日本

- 智利

- 柬埔寨

- 格林纳达

- 格陵兰

- 格鲁吉亚

- 梵蒂冈

- 比利时

- 毛里塔尼亚

- 毛里求斯

- 汤加

- 沙特阿拉伯

- 法国

- 法属南部领地

- 法属圣马丁

- 法属圭亚那

- 法属波利尼西亚

- 法罗群岛

- 波兰

- 波多黎各

- 波斯尼亚和黑塞哥维那

- 泰国

- 津巴布韦

- 洪都拉斯

- 海地

- 澳大利亚

- 澳门

- 爱尔兰

- 爱沙尼亚

- 牙买加

- 特克斯和凯科斯群岛

- 特立尼达和多巴哥

- 玻利维亚

- 瑙鲁

- 瑞典

- 瑞士

- 瓜德罗普

- 瓦利斯和富图纳

- 瓦努阿图

- 留尼汪

- 白俄罗斯

- 百慕大

- 皮特凯恩群岛

- 直布罗陀

- 福克兰群岛(马尔维纳斯群岛)

- 科威特

- 科摩罗

- 科特迪瓦

- 科科斯(基林)群岛

- 秘鲁

- 突尼斯

- 立陶宛

- 索马里

- 约旦

- 纳米比亚

- 纽埃

- 缅甸

- 罗马尼亚

- 美国

- 美国本土外小岛屿

- 美属维尔京群岛

- 美属萨摩亚

- 老挝

- 肯尼亚

- 芬兰

- 苏里南

- 英国

- 英属印度洋领地

- 英属维尔京群岛

- 荷兰

- 荷属圣马丁

- 莫桑比克

- 莱索托

- 菲律宾

- 萨尔瓦多

- 萨摩亚

- 葡萄牙

- 蒙古

- 蒙特塞拉特

- 西撒哈拉

- 西班牙

- 诺福克岛

- 贝宁

- 赞比亚

- 赤道几内亚

- 赫德岛和麦克唐纳群岛

- 越南

- 阿塞拜疆

- 阿富汗

- 阿尔及利亚

- 阿尔巴尼亚

- 阿拉伯联合酋长国

- 阿曼

- 阿根廷

- 阿森松岛

- 阿鲁巴

- 韩国

- 香港

- 马尔代夫

- 马拉维

- 马提尼克

- 马来西亚

- 马约特

- 马绍尔群岛

- 马耳他

- 马达加斯加

- 马里

- 黎巴嫩

- 黑山

我愿意接收 Google 关于 Google Cloud 的新闻、产品更新、活动信息以及特别优惠。

我理解,我的个人数据将根据 Google 隐私政策进行处理。

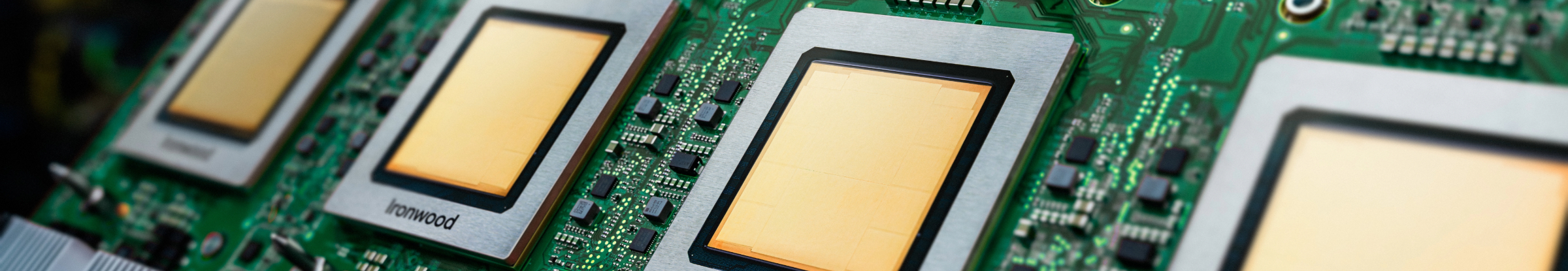

您的基础设施是否已为推理时代做好准备?

Ironwood 是 Google 迄今功能和性能最强大、能源效率最高的张量处理单元 (TPU),旨在为大规模的思考型推理 AI 模型提供支持。Ironwood 是基于 Google 为内部服务和 Google Cloud 客户开发 TPU 的丰富经验而设计的,旨在满足模型(例如大语言模型 [LLM]、专家混合 [MoE] 模型和高级推理任务)的计算和内存需求。支持在 Google Cloud AI Hypercomputer 架构内训练和提供工作负载。

针对大语言模型 (LLM) 进行优化:Ironwood 专为满足 LLM 和生成式 AI 应用日益增长的需求而设计。

增强型互连技术:受益于 TPU 互连技术的改进,实现更快的通信和更短的延迟。

高性能计算:在执行各种推理任务时,性能显著提升。

可持续的 AI:Ironwood 延续了 Google Cloud 对可持续性的承诺,在提高能源效率的同时提供卓越的性能。

Ironwood 集成了更高的计算密度、内存容量和互连带宽,并显著提高了功率效率。这些功能旨在为要求苛刻的 AI 训练和服务工作负载提供更高的吞吐量和更低的延迟,尤其是涉及大型复杂模型的工作负载。Ironwood TPU 在 Google Cloud AI Hypercomputer 架构内运行。

Cloud AI 产品遵循我们的服务等级协议 (SLA) 政策。这些产品在延迟时间或可用性方面的保证可能与其他 Google Cloud 服务有所不同。