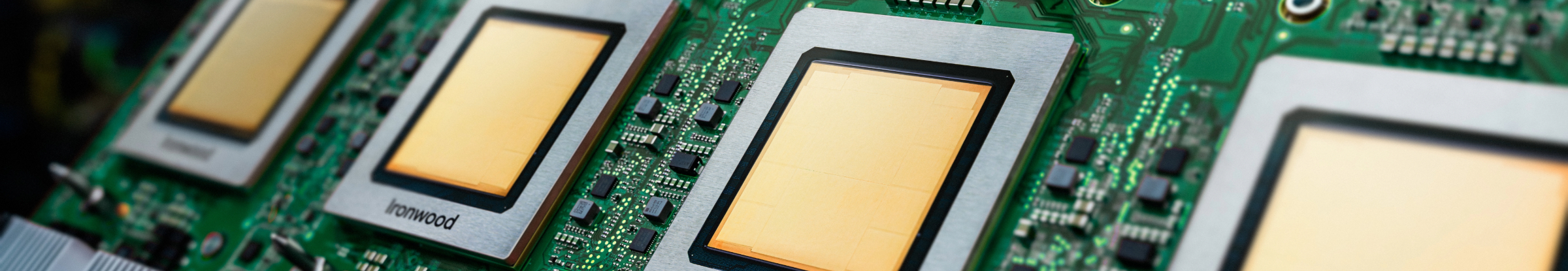

Ironwood: a 7ª geração de TPUs do Google Cloud projetada para inferência

Treine, ajuste e disponibilize modelos e conjuntos de dados maiores com eficiência usando a TPU mais avançada até agora.

Solicite mais informações sobre o Ironwood.

- (+1)

- Afeganistão

- Albânia

- Alemanha

- Andorra

- Angola

- Anguila

- Antártida

- Antígua e Barbuda

- Argentina

- Argélia

- Armênia

- Aruba

- Arábia Saudita

- Austrália

- Azerbaijão

- Bahamas

- Bangladesh

- Barbados

- Barein

- Belize

- Benin

- Bermudas

- Bielorrússia

- Bolívia

- Botsuana

- Brasil

- Brunei

- Bulgária

- Burquina Faso

- Burundi

- Butão

- Bélgica

- Bósnia e Herzegovina

- Cabo Verde

- Camarões

- Camboja

- Canadá

- Catar

- Cazaquistão

- Chade

- Chile

- China

- Chipre

- Cidade do Vaticano

- Colômbia

- Comores

- Congo - Kinshasa

- Coreia do Sul

- Costa Rica

- Costa do Marfim

- Croácia

- Curaçao

- Dinamarca

- Djibuti

- Dominica

- Egito

- El Salvador

- Emirados Árabes Unidos

- Equador

- Eritreia

- Eslováquia

- Eslovênia

- Espanha

- Essuatíni

- Estados Unidos

- Estônia

- Etiópia

- Fiji

- Filipinas

- Finlândia

- França

- Gabão

- Gana

- Geórgia

- Gibraltar

- Granada

- Groenlândia

- Grécia

- Guadalupe

- Guam

- Guatemala

- Guiana

- Guiana Francesa

- Guiné

- Guiné Equatorial

- Guiné-Bissau

- Gâmbia

- Haiti

- Honduras

- Hong Kong

- Hungria

- Ilha Bouvet

- Ilha Christmas

- Ilha Norfolk

- Ilha de Ascensão

- Ilhas Cayman

- Ilhas Cocos (Keeling)

- Ilhas Cook

- Ilhas Faroé

- Ilhas Geórgia do Sul e Sandwich do Sul

- Ilhas Heard e McDonald

- Ilhas Malvinas (Ilhas Falkland)

- Ilhas Marianas do Norte

- Ilhas Marshall

- Ilhas Menores Distantes dos EUA

- Ilhas Pitcairn

- Ilhas Salomão

- Ilhas Turcas e Caicos

- Ilhas Virgens Americanas

- Ilhas Virgens Britânicas

- Indonésia

- Iraque

- Irlanda

- Islândia

- Israel

- Itália

- Iêmen

- Jamaica

- Japão

- Jordânia

- Kuwait

- Laos

- Lesoto

- Letônia

- Libéria

- Liechtenstein

- Lituânia

- Luxemburgo

- Líbano

- Líbia

- Macau

- Macedônia do Norte

- Madagascar

- Malaui

- Maldivas

- Mali

- Malta

- Malásia

- Marrocos

- Martinica

- Mauritânia

- Maurício

- Mayotte

- Mianmar (Birmânia)

- Micronésia

- Moldávia

- Mongólia

- Montenegro

- Montserrat

- Moçambique

- México

- Mônaco

- Namíbia

- Nauru

- Nepal

- Nicarágua

- Nigéria

- Niue

- Noruega

- Nova Caledônia

- Nova Zelândia

- Níger

- Omã

- Palau

- Palestina

- Panamá

- Papua-Nova Guiné

- Paquistão

- Paraguai

- Países Baixos

- Peru

- Polinésia Francesa

- Polônia

- Porto Rico

- Portugal

- Quirguistão

- Quiribati

- Quênia

- Reino Unido

- República Centro-Africana

- República Dominicana

- República do Congo

- Reunião

- Romênia

- Ruanda

- Rússia

- Saara Ocidental

- Samoa

- Samoa Americana

- San Marino

- Santa Helena

- Santa Lúcia

- Seicheles

- Senegal

- Serra Leoa

- Singapura

- Sint Maarten

- Somália

- Sri Lanka

- Sudão do Sul

- Suriname

- Suécia

- Suíça

- Svalbard e Jan Mayen

- São Bartolomeu

- São Cristóvão e Névis

- São Martinho

- São Pedro e Miquelão

- São Tomé e Príncipe

- São Vicente e Granadinas

- Sérvia

- Tadjiquistão

- Tailândia

- Taiwan

- Tanzânia

- Tchéquia

- Território Britânico do Oceano Índico

- Territórios Franceses do Sul

- Timor-Leste

- Togo

- Tokelau

- Tonga

- Trinidad e Tobago

- Tunísia

- Turcomenistão

- Turquia

- Tuvalu

- Ucrânia

- Uganda

- Uruguai

- Uzbequistão

- Vanuatu

- Venezuela

- Vietnã

- Wallis e Futuna

- Zimbábue

- Zâmbia

- África do Sul

- Áustria

- Índia

Sua infraestrutura está pronta para a era da inferência?

O Ironwood é a Unidade de Processamento de Tensor (TPU) mais potente, capaz e eficiente em termos de energia do Google até o momento, projetada para impulsionar modelos de IA de raciocínio e inferência em grande escala. Com base na vasta experiência no desenvolvimento de TPUs para os serviços internos do Google e clientes do Google Cloud, o Ironwood foi criado para lidar com as demandas computacionais e de memória de modelos como modelos de linguagem grandes (LLMs), misturas de especialistas (MoEs) e tarefas de raciocínio avançadas. Ele oferece suporte a cargas de trabalho de treinamento e disponibilização na arquitetura de hipercomputador de IA do Google Cloud.

Otimizado para modelos de linguagem grandes (LLMs): o Ironwood foi criado especificamente para acelerar as demandas crescentes de LLMs e aplicativos de IA generativa.

Tecnologia de interconexão aprimorada: aproveite as melhorias na tecnologia de interconexão de TPU, que permite uma comunicação mais rápida e reduz a latência.

Computação de alto desempenho: tenha ganhos significativos de desempenho para uma ampla variedade de tarefas de inferência.

IA sustentável: a Ironwood continua o compromisso do Google Cloud com a sustentabilidade, oferecendo desempenho excepcional com eficiência energética otimizada.

O Ironwood integra maior densidade de computação, capacidade de memória e largura de banda de interconexão com ganhos significativos na eficiência energética. Esses recursos foram criados para permitir maior capacidade de processamento e latência mais baixa para cargas de trabalho exigentes de treinamento e disponibilização de IA, principalmente aquelas que envolvem modelos grandes e complexos. As TPUs Ironwood operam na arquitetura de hipercomputador de IA do Google Cloud.

Os produtos de IA do Google Cloud estão em conformidade com nossas políticas de SLA. Elas oferecem garantias de latência ou disponibilidade diferentes de outros serviços do Google Cloud.