Ironwood: 추론을 위해 설계된 Google Cloud의 7세대 TPU

가장 강력한 TPU로 더 큰 모델과 데이터 세트를 효율적으로 학습시키고 미세 조정하고 제공하세요.

Ironwood에 관한 자세한 정보를 요청하세요.

- (+1)

- 가나

- 가봉

- 가이아나

- 감비아

- 과들루프

- 과테말라

- 괌

- 그레나다

- 그리스

- 그린란드

- 기니

- 기니비사우

- 나미비아

- 나우루

- 나이지리아

- 남극 대륙

- 남수단

- 남아프리카

- 네덜란드

- 네팔

- 노르웨이

- 노퍽섬

- 뉴질랜드

- 뉴칼레도니아

- 니우에

- 니제르

- 니카라과

- 대만

- 대한민국

- 덴마크

- 도미니카

- 도미니카 공화국

- 독일

- 동티모르

- 라오스

- 라이베리아

- 라트비아

- 러시아

- 레바논

- 레소토

- 레위니옹

- 루마니아

- 룩셈부르크

- 르완다

- 리비아

- 리투아니아

- 리히텐슈타인

- 마다가스카르

- 마르티니크

- 마셜 제도

- 마요트

- 마카오

- 말라위

- 말레이시아

- 말리

- 멕시코

- 모나코

- 모로코

- 모리셔스

- 모리타니

- 모잠비크

- 몬테네그로

- 몬트세라트

- 몰도바

- 몰디브

- 몰타

- 몽골

- 미국

- 미국령 버진아일랜드

- 미국령 해외 제도

- 미얀마

- 미크로네시아

- 바누아투

- 바레인

- 바베이도스

- 바티칸 시국

- 바하마

- 방글라데시

- 버뮤다

- 베냉

- 베네수엘라

- 베트남

- 벨기에

- 벨라루스

- 벨리즈

- 보스니아 헤르체고비나

- 보츠와나

- 볼리비아

- 부룬디

- 부르키나파소

- 부베섬

- 부탄

- 북마리아나제도

- 북마케도니아

- 불가리아

- 브라질

- 브루나이

- 사모아

- 사우디아라비아

- 사우스조지아 사우스샌드위치 제도

- 산마리노

- 상투메 프린시페

- 생마르탱

- 생바르텔레미

- 생피에르 미클롱

- 서사하라

- 세네갈

- 세르비아

- 세이셸

- 세인트루시아

- 세인트빈센트그레나딘

- 세인트키츠 네비스

- 세인트헬레나

- 소말리아

- 솔로몬 제도

- 수리남

- 스리랑카

- 스발바르제도-얀마웬섬

- 스웨덴

- 스위스

- 스페인

- 슬로바키아

- 슬로베니아

- 시에라리온

- 신트마르턴

- 싱가포르

- 아랍에미리트

- 아루바

- 아르메니아

- 아르헨티나

- 아메리칸 사모아

- 아이슬란드

- 아이티

- 아일랜드

- 아제르바이잔

- 아프가니스탄

- 안도라

- 알바니아

- 알제리

- 앙골라

- 앤티가 바부다

- 앵귈라

- 어센션섬

- 에리트리아

- 에스와티니

- 에스토니아

- 에콰도르

- 에티오피아

- 엘살바도르

- 영국

- 영국령 버진아일랜드

- 영국령 인도양 지역

- 예멘

- 오만

- 오스트레일리아

- 오스트리아

- 온두라스

- 왈리스-푸투나 제도

- 요르단

- 우간다

- 우루과이

- 우즈베키스탄

- 우크라이나

- 이라크

- 이스라엘

- 이집트

- 이탈리아

- 인도

- 인도네시아

- 일본

- 자메이카

- 잠비아

- 적도 기니

- 조지아

- 중국

- 중앙 아프리카 공화국

- 지부티

- 지브롤터

- 짐바브웨

- 차드

- 체코

- 칠레

- 카메룬

- 카보베르데

- 카자흐스탄

- 카타르

- 캄보디아

- 캐나다

- 케냐

- 케이맨 제도

- 코모로

- 코스타리카

- 코코스 제도

- 코트디부아르

- 콜롬비아

- 콩고-브라자빌

- 콩고-킨샤사

- 쿠웨이트

- 쿡 제도

- 퀴라소

- 크로아티아

- 크리스마스섬

- 키르기스스탄

- 키리바시

- 키프로스

- 타지키스탄

- 탄자니아

- 태국

- 터크스 케이커스 제도

- 토고

- 토켈라우

- 통가

- 투르크메니스탄

- 투발루

- 튀니지

- 튀르키예

- 트리니다드 토바고

- 파나마

- 파라과이

- 파키스탄

- 파푸아뉴기니

- 팔라우

- 팔레스타인

- 페로 제도

- 페루

- 포르투갈

- 포클랜드 제도(말비나스 군도)

- 폴란드

- 푸에르토리코

- 프랑스

- 프랑스령 기아나

- 프랑스령 남방 지역

- 프랑스령 폴리네시아

- 피지

- 핀란드

- 필리핀

- 핏케언 제도

- 허드 맥도널드 제도

- 헝가리

- 홍콩

귀사의 인프라는 추론 시대를 위한 준비가 되었나요?

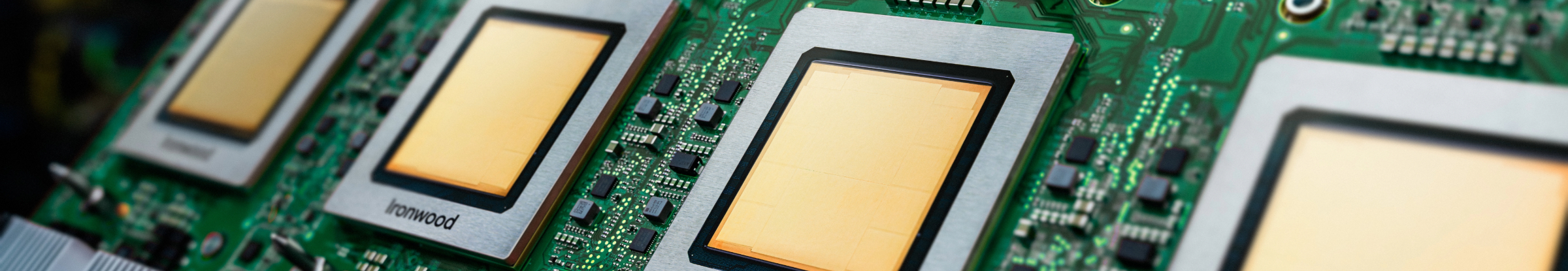

Ironwood는 Google의 가장 강력하고 성능이 우수하며 에너지 효율적인 Tensor Processing Unit(TPU)으로, 사고 및 추론 AI 모델을 대규모로 지원하도록 설계되었습니다. Google의 내부 서비스와 Google Cloud 고객을 위한 광범위한 TPU 개발 경험을 기반으로 Ironwood는 대규모 언어 모델(LLM), 전문가 망(MoE), 고급 추론 작업과 같은 모델의 연산 및 메모리 요구사항을 처리하도록 설계되었습니다. Google Cloud AI 하이퍼컴퓨터 아키텍처 내에서 학습 및 서빙 워크로드 모두를 지원합니다.

대규모 언어 모델(LLM)에 최적화: Ironwood는 LLM 및 생성형 AI 애플리케이션에 대한 증가하는 수요를 가속화하도록 특별히 설계되었습니다.

향상된 상호 연결 기술: TPU 상호 연결 기술의 개선으로 통신 속도를 높이고 지연 시간을 줄일 수 있습니다.

고성능 컴퓨팅: 다양한 추론 작업에서 상당한 성능 향상을 경험하세요.

지속 가능한 AI: Ironwood는 Google Cloud의 지속 가능성에 대한 노력을 이어가며 최적화된 에너지 효율로 뛰어난 성능을 제공합니다.

Ironwood는 향상된 컴퓨팅 밀도, 메모리 용량, 상호 연결 대역폭을 통합하여 전력 효율을 크게 향상합니다. 이러한 기능은 특히 크고 복잡한 모델이 포함된 까다로운 AI 학습 및 서빙 워크로드의 처리량을 높이고 지연 시간을 단축하도록 설계되었습니다. Ironwood TPU는 Google Cloud AI 하이퍼컴퓨터 아키텍처 내에서 작동합니다.

Cloud AI 제품은 SLA 정책을 준수하며 지연 시간이나 가용성 보장 측면에서 다른 Google Cloud 서비스와는 차이가 있을 수 있습니다.