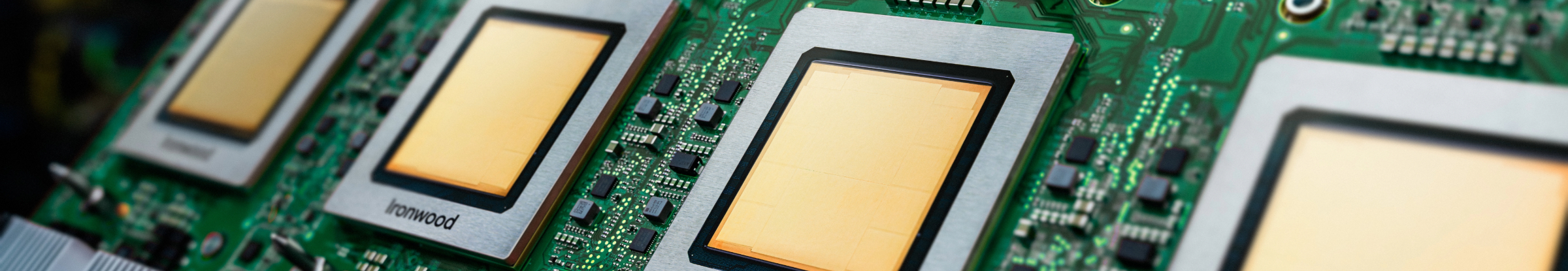

Ironwood: TPU di Google Cloud di settima generazione progettata per l'inferenza

Addestra, ottimizza e distribuisci modelli e set di dati più grandi in modo efficiente con la TPU più potente di sempre.

Richiedi maggiori informazioni su Ironwood.

- (+1)

- Afghanistan

- Albania

- Algeria

- Andorra

- Angola

- Anguilla

- Antartide

- Antigua e Barbuda

- Arabia Saudita

- Argentina

- Armenia

- Aruba

- Australia

- Austria

- Azerbaigian

- Bahamas

- Bahrein

- Bangladesh

- Barbados

- Belgio

- Belize

- Benin

- Bermuda

- Bhutan

- Bielorussia

- Bolivia

- Bosnia ed Erzegovina

- Botswana

- Brasile

- Brunei

- Bulgaria

- Burkina Faso

- Burundi

- Cambogia

- Camerun

- Canada

- Capo Verde

- Cechia

- Ciad

- Cile

- Cina

- Cipro

- Città del Vaticano

- Colombia

- Comore

- Congo - Kinshasa

- Congo-Brazzaville

- Corea del Sud

- Costa Rica

- Costa d’Avorio

- Croazia

- Curaçao

- Danimarca

- Dominica

- Ecuador

- Egitto

- El Salvador

- Emirati Arabi Uniti

- Eritrea

- Estonia

- Eswatini

- Etiopia

- Figi

- Filippine

- Finlandia

- Francia

- Gabon

- Gambia

- Georgia

- Georgia del Sud e Sandwich Australi

- Germania

- Ghana

- Giamaica

- Giappone

- Gibilterra

- Gibuti

- Giordania

- Grecia

- Grenada

- Groenlandia

- Guadalupa

- Guam

- Guatemala

- Guinea

- Guinea Equatoriale

- Guinea-Bissau

- Guyana

- Guyana Francese

- Haiti

- Honduras

- Hong Kong

- India

- Indonesia

- Iraq

- Irlanda

- Islanda

- Isola Ascensione

- Isola Bouvet

- Isola Christmas

- Isola Norfolk

- Isole Cayman

- Isole Cocos (Keeling)

- Isole Cook

- Isole Falkland (Isole Malvine)

- Isole Fær Øer

- Isole Heard e McDonald

- Isole Marianne Settentrionali

- Isole Marshall

- Isole Minori Esterne degli Stati Uniti

- Isole Pitcairn

- Isole Salomone

- Isole Turks e Caicos

- Isole Vergini Americane

- Isole Vergini Britanniche

- Israele

- Italia

- Kazakistan

- Kenya

- Kirghizistan

- Kiribati

- Kuwait

- Laos

- Lesotho

- Lettonia

- Libano

- Liberia

- Libia

- Liechtenstein

- Lituania

- Lussemburgo

- Macao

- Macedonia del Nord

- Madagascar

- Malawi

- Malaysia

- Maldive

- Mali

- Malta

- Marocco

- Martinica

- Mauritania

- Mauritius

- Mayotte

- Messico

- Micronesia

- Moldavia

- Monaco

- Mongolia

- Montenegro

- Montserrat

- Mozambico

- Myanmar (Birmania)

- Namibia

- Nauru

- Nepal

- Nicaragua

- Niger

- Nigeria

- Niue

- Norvegia

- Nuova Caledonia

- Nuova Zelanda

- Oman

- Paesi Bassi

- Pakistan

- Palau

- Palestina

- Panama

- Papua Nuova Guinea

- Paraguay

- Perù

- Polinesia Francese

- Polonia

- Portogallo

- Portorico

- Qatar

- Regno Unito

- Repubblica Centrafricana

- Repubblica Dominicana

- Riunione

- Romania

- Ruanda

- Russia

- Sahara Occidentale

- Saint Kitts e Nevis

- Saint Lucia

- Saint Martin

- Saint Vincent e Grenadine

- Saint-Barthélemy

- Saint-Pierre e Miquelon

- Samoa

- Samoa Americane

- San Marino

- Sant’Elena

- Senegal

- Serbia

- Seychelles

- Sierra Leone

- Singapore

- Sint Maarten

- Slovacchia

- Slovenia

- Somalia

- Spagna

- Sri Lanka

- Stati Uniti

- Sud Sudan

- Sudafrica

- Suriname

- Svalbard e Jan Mayen

- Svezia

- Svizzera

- São Tomé e Príncipe

- Tagikistan

- Taiwan

- Tanzania

- Terre Australi Francesi

- Territorio Britannico dell’Oceano Indiano

- Thailandia

- Timor Est

- Togo

- Tokelau

- Tonga

- Trinidad e Tobago

- Tunisia

- Turchia

- Turkmenistan

- Tuvalu

- Ucraina

- Uganda

- Ungheria

- Uruguay

- Uzbekistan

- Vanuatu

- Venezuela

- Vietnam

- Wallis e Futuna

- Yemen

- Zambia

- Zimbabwe

La tua infrastruttura è pronta per l'era dell'inferenza?

Ironwood è la Tensor Processing Unit (TPU) più potente, funzionale ed efficiente dal punto di vista energetico di Google, progettata per supportare modelli pensanti di AI inferenziale su larga scala. Sfruttando l'ampia esperienza nello sviluppo di TPU per i servizi interni di Google e per i clienti di Google Cloud, Ironwood è progettato per gestire le richieste di calcolo e memoria di modelli come i modelli linguistici di grandi dimensioni (LLM), i modelli Mixture-of-Experts (MoE) e le attività di ragionamento avanzato. Supporta sia i carichi di lavoro di addestramento che quelli di erogazione all'interno dell'architettura dell'AI Hypercomputer di Google Cloud.

Ottimizzato per i modelli linguistici di grandi dimensioni (LLM): Ironwood è progettato specificamente per accelerare le crescenti esigenze di LLM e applicazioni di AI generativa.

Tecnologia di interconnessione migliorata: sfrutta i miglioramenti della tecnologia di interconnessione TPU, che consente una comunicazione più rapida e offre una latenza ridotta.

Computing ad alte prestazioni: ottieni notevoli miglioramenti delle prestazioni per un'ampia gamma di attività di inferenza.

AI sostenibile: Ironwood prosegue l'impegno di Google Cloud per la sostenibilità, offrendo prestazioni eccezionali con un'efficienza energetica ottimizzata.

Ironwood integra una maggiore densità di calcolo, capacità di memoria e larghezza di banda di interconnessione con significativi guadagni in termini di efficienza energetica. Queste funzionalità sono progettate per consentire una maggiore velocità effettiva e una minore latenza per carichi di lavoro impegnativi di addestramento e gestione dell'AI, in particolare quelli che coinvolgono modelli complessi e di grandi dimensioni. Le TPU Ironwood operano all'interno dell'architettura dell'AI Hypercomputer Google Cloud.

I prodotti AI Cloud sono conformi alle nostre norme relative allo SLA. Possono offrire garanzie di latenza o disponibilità diverse rispetto ad altri servizi Google Cloud.