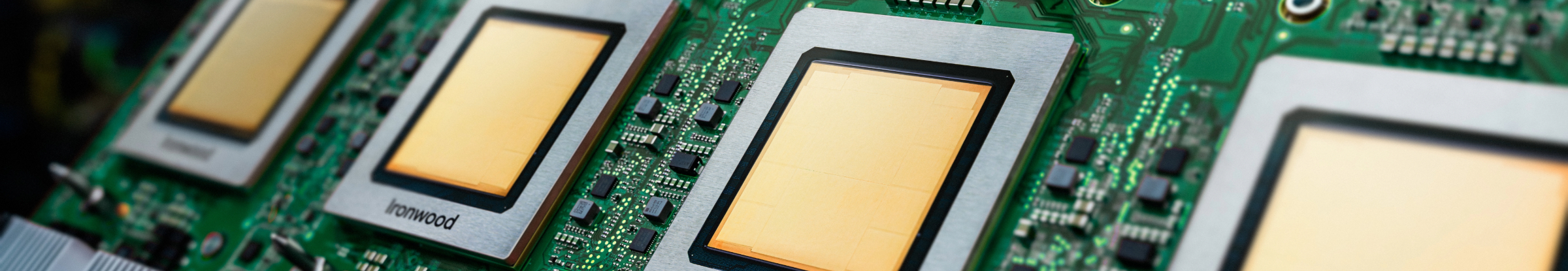

Ironwood: TPU Generasi ke-7 Google Cloud yang Dirancang untuk Inferensi

Latih, sesuaikan, dan sajikan model dan set data yang lebih besar secara efisien dengan TPU yang paling canggih.

Minta informasi selengkapnya tentang Ironwood.

- (+1)

- Afganistan

- Afrika Selatan

- Albania

- Aljazair

- Amerika Serikat

- Andorra

- Angola

- Anguilla

- Antarktika

- Antigua dan Barbuda

- Arab Saudi

- Argentina

- Armenia

- Aruba

- Australia

- Austria

- Azerbaijan

- Bahama

- Bahrain

- Bangladesh

- Barbados

- Belanda

- Belarus

- Belgia

- Belize

- Benin

- Bermuda

- Bhutan

- Bolivia

- Bosnia dan Herzegovina

- Botswana

- Brasil

- Brunei

- Bulgaria

- Burkina Faso

- Burundi

- Ceko

- Chad

- Cile

- Curaçao

- Côte d’Ivoire

- Denmark

- Dominika

- Ekuador

- El Salvador

- Eritrea

- Estonia

- Etiopia

- Fiji

- Filipina

- Finlandia

- Gabon

- Gambia

- Georgia

- Georgia Selatan & Kep. Sandwich Selatan

- Ghana

- Gibraltar

- Greenland

- Grenada

- Guadeloupe

- Guam

- Guatemala

- Guinea

- Guinea Ekuatorial

- Guinea-Bissau

- Guyana

- Guyana Prancis

- Haiti

- Honduras

- Hong Kong

- Hungaria

- India

- Indonesia

- Inggris Raya

- Irak

- Irlandia

- Islandia

- Israel

- Italia

- Jamaika

- Jepang

- Jerman

- Jibuti

- Kaledonia Baru

- Kamboja

- Kamerun

- Kanada

- Kazakhstan

- Kenya

- Kepulauan Cayman

- Kepulauan Cocos (Keeling)

- Kepulauan Cook

- Kepulauan Falkland (Malvinas)

- Kepulauan Faroe

- Kepulauan Mariana Utara

- Kepulauan Marshall

- Kepulauan Norfolk

- Kepulauan Pitcairn

- Kepulauan Solomon

- Kepulauan Svalbard dan Jan Mayen

- Kepulauan Terluar AS

- Kepulauan Turks dan Caicos

- Kepulauan Virgin Amerika Serikat

- Kepulauan Virgin Britania Raya

- Kepulauan Wallis dan Futuna

- Kirgizstan

- Kiribati

- Kolombia

- Komoro

- Kongo - Brazzaville

- Kongo - Kinshasa

- Korea Selatan

- Kosta Rika

- Kroasia

- Kuwait

- Laos

- Latvia

- Lebanon

- Lesotho

- Liberia

- Libya

- Liechtenstein

- Lituania

- Luksemburg

- Madagaskar

- Makau

- Makedonia Utara

- Maladewa

- Malawi

- Malaysia

- Mali

- Malta

- Maroko

- Martinik

- Mauritania

- Mauritius

- Mayotte

- Meksiko

- Mesir

- Mikronesia

- Moldova

- Monako

- Mongolia

- Montenegro

- Montserrat

- Mozambik

- Myanmar (Burma)

- Namibia

- Nauru

- Nepal

- Niger

- Nigeria

- Nikaragua

- Niue

- Norwegia

- Oman

- Pakistan

- Palau

- Palestina

- Panama

- Papua Nugini

- Paraguay

- Peru

- Polandia

- Polinesia Prancis

- Portugal

- Prancis

- Puerto Riko

- Pulau Ascension

- Pulau Bouvet

- Pulau Heard dan Kepulauan McDonald

- Pulau Natal

- Qatar

- Republik Afrika Tengah

- Republik Dominika

- Rumania

- Rusia

- Rwanda

- Réunion

- Sahara Barat

- Saint Barthélemy

- Saint Helena

- Saint Kitts dan Nevis

- Saint Lucia

- Saint Martin

- Saint Pierre dan Miquelon

- Saint Vincent dan Grenadine

- Samoa

- Samoa Amerika

- San Marino

- Sao Tome dan Principe

- Selandia Baru

- Senegal

- Serbia

- Seychelles

- Sierra Leone

- Singapura

- Sint Maarten

- Siprus

- Slovakia

- Slovenia

- Somalia

- Spanyol

- Sri Lanka

- Sudan Selatan

- Suriname

- Swedia

- Swiss

- Taiwan

- Tajikistan

- Tanjung Verde

- Tanzania

- Thailand

- Timor Leste

- Tiongkok

- Togo

- Tokelau

- Tonga

- Trinidad dan Tobago

- Tunisia

- Turki

- Turkmenistan

- Tuvalu

- Uganda

- Ukraina

- Uni Emirat Arab

- Uruguay

- Uzbekistan

- Vanuatu

- Vatikan

- Venezuela

- Vietnam

- Wilayah Inggris di Samudra Hindia

- Wilayah Selatan Prancis

- Yaman

- Yordania

- Yunani

- Zambia

- Zimbabwe

- eSwatini

Apakah infrastruktur Anda siap untuk era inferensi?

Ironwood adalah Tensor Processing Unit (TPU) Google yang paling canggih, andal, dan hemat energi, yang dirancang untuk mendukung model AI inferensi dalam skala besar. Berbekal pengalaman luas dalam mengembangkan TPU untuk layanan internal Google dan pelanggan Google Cloud, Ironwood dirancang untuk menangani kebutuhan komputasi dan memori model seperti Model Bahasa Besar (LLM), Campuran Pakar (MoE), dan tugas penalaran canggih. Ironwood mendukung workload pelatihan dan penyajian dalam arsitektur AI Hypercomputer Google Cloud.

Dioptimalkan untuk Model Bahasa Besar (LLM): Ironwood dirancang khusus untuk mempercepat peningkatan permintaan LLM dan aplikasi AI generatif.

Enhanced Interconnect Technology: Manfaatkan peningkatan pada teknologi interconnect TPU, yang memungkinkan komunikasi lebih cepat dan latensi lebih rendah.

Komputasi Berperforma Tinggi: Dapatkan peningkatan performa yang signifikan untuk berbagai tugas inferensi.

Sustainable AI: Ironwood melanjutkan komitmen Google Cloud terhadap keberlanjutan, yang memberikan performa luar biasa dengan efisiensi energi yang dioptimalkan

Ironwood mengintegrasikan peningkatan kepadatan komputasi, kapasitas memori, dan bandwidth interkoneksi dengan peningkatan signifikan dalam efisiensi daya. Fitur-fitur ini dirancang untuk memungkinkan throughput yang lebih tinggi dan latensi yang lebih rendah untuk workload pelatihan dan penyajian AI yang menuntut, khususnya yang melibatkan model besar dan kompleks. TPU Ironwood beroperasi dalam arsitektur AI Hypercomputer Google Cloud.

Produk-produk AI Cloud mematuhi kebijakan SLA kami. Produk tersebut mungkin menawarkan jaminan latensi atau ketersediaan yang berbeda dari layanan Google Cloud lainnya.