Ironwood : TPU de 7e génération de Google Cloud conçu pour l'inférence

Entraînez, affinez et livrez des modèles et des ensembles de données plus volumineux de manière efficace avec le TPU le plus puissant à ce jour.

Demander plus d'informations sur Ironwood

- (+1)

- Afghanistan

- Afrique du Sud

- Albanie

- Algérie

- Allemagne

- Andorre

- Angola

- Anguilla

- Antarctique

- Antigua-et-Barbuda

- Arabie saoudite

- Argentine

- Arménie

- Aruba

- Australie

- Autriche

- Azerbaïdjan

- Bahamas

- Bahreïn

- Bangladesh

- Barbade

- Belgique

- Belize

- Bermudes

- Bhoutan

- Biélorussie

- Bolivie

- Bosnie-Herzégovine

- Botswana

- Brunei

- Brésil

- Bulgarie

- Burkina Faso

- Burundi

- Bénin

- Cambodge

- Cameroun

- Canada

- Cap-Vert

- Chili

- Chine

- Chypre

- Colombie

- Comores

- Congo-Brazzaville

- Congo-Kinshasa

- Corée du Sud

- Costa Rica

- Croatie

- Curaçao

- Côte d’Ivoire

- Danemark

- Djibouti

- Dominique

- Espagne

- Estonie

- Eswatini

- Fidji

- Finlande

- France

- Gabon

- Gambie

- Ghana

- Gibraltar

- Grenade

- Groenland

- Grèce

- Guadeloupe

- Guam

- Guatemala

- Guinée

- Guinée équatoriale

- Guinée-Bissau

- Guyana

- Guyane française

- Géorgie

- Géorgie du Sud-et-les Îles Sandwich du Sud

- Haïti

- Honduras

- Hong Kong

- Hongrie

- Inde

- Indonésie

- Irak

- Irlande

- Islande

- Israël

- Italie

- Jamaïque

- Japon

- Jordanie

- Kazakhstan

- Kenya

- Kirghizstan

- Kiribati

- Koweït

- La Réunion

- Laos

- Lesotho

- Lettonie

- Liban

- Liberia

- Libye

- Liechtenstein

- Lituanie

- Luxembourg

- Macao

- Macédoine du Nord

- Madagascar

- Malaisie

- Malawi

- Maldives

- Mali

- Malte

- Maroc

- Martinique

- Maurice

- Mauritanie

- Mayotte

- Mexique

- Micronésie

- Moldavie

- Monaco

- Mongolie

- Montserrat

- Monténégro

- Mozambique

- Myanmar (Birmanie)

- Namibie

- Nauru

- Nicaragua

- Niger

- Nigeria

- Niue

- Norvège

- Nouvelle-Calédonie

- Nouvelle-Zélande

- Népal

- Oman

- Ouganda

- Ouzbékistan

- Pakistan

- Palaos

- Palestine

- Panama

- Papouasie-Nouvelle-Guinée

- Paraguay

- Pays-Bas

- Philippines

- Pologne

- Polynésie française

- Porto Rico

- Portugal

- Pérou

- Qatar

- Roumanie

- Royaume-Uni

- Russie

- Rwanda

- République centrafricaine

- République dominicaine

- Sahara occidental

- Saint-Barthélemy

- Saint-Christophe-et-Niévès

- Saint-Marin

- Saint-Martin

- Saint-Martin (partie néerlandaise)

- Saint-Pierre-et-Miquelon

- Saint-Vincent-et-les Grenadines

- Sainte-Hélène

- Sainte-Lucie

- Salvador

- Samoa

- Samoa américaines

- Sao Tomé-et-Principe

- Serbie

- Seychelles

- Sierra Leone

- Singapour

- Slovaquie

- Slovénie

- Somalie

- Soudan du Sud

- Sri Lanka

- Suisse

- Suriname

- Suède

- Svalbard et Jan Mayen

- Sénégal

- Tadjikistan

- Tanzanie

- Taïwan

- Tchad

- Tchéquie

- Terres australes françaises

- Territoire britannique de l’océan Indien

- Thaïlande

- Timor oriental

- Togo

- Tokelau

- Tonga

- Trinité-et-Tobago

- Tunisie

- Turkménistan

- Turquie

- Tuvalu

- Ukraine

- Uruguay

- Vanuatu

- Venezuela

- Viêt Nam

- Wallis-et-Futuna

- Yémen

- Zambie

- Zimbabwe

- Égypte

- Émirats arabes unis

- Équateur

- Érythrée

- État de la Cité du Vatican

- États-Unis

- Éthiopie

- Île Bouvet

- Île Christmas

- Île Norfolk

- Île de l’Ascension

- Îles Caïmans

- Îles Cocos

- Îles Cook

- Îles Féroé

- Îles Heard-et-MacDonald

- Îles Malouines (Îles Falkland)

- Îles Mariannes du Nord

- Îles Marshall

- Îles Pitcairn

- Îles Salomon

- Îles Turques-et-Caïques

- Îles Vierges britanniques

- Îles Vierges des États-Unis

- Îles mineures éloignées des États-Unis

Votre infrastructure est-elle prête pour l'ère de l'inférence ?

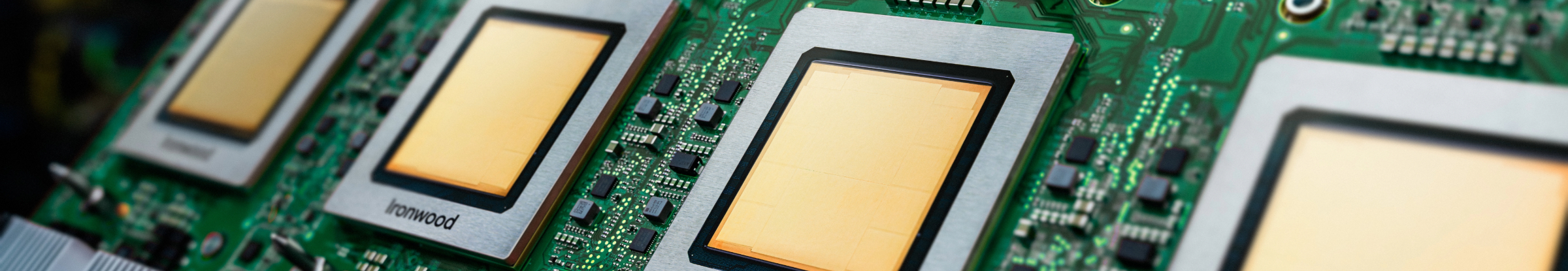

Ironwood est le TPU (Tensor Processing Unit) le plus puissant, le plus performant et le plus économe en énergie de Google à ce jour. Il est conçu pour alimenter des modèles d'IA de raisonnement et d'inférence à grande échelle. S'appuyant sur une vaste expérience du développement de TPU pour les services internes de Google et les clients Google Cloud, Ironwood est conçu pour gérer les exigences de calcul et de mémoire de modèles tels que les grands modèles de langage (LLM), l'approche Mixture-of-Experts (MoE) et les tâches de raisonnement avancées. Il prend en charge les charges de travail d'entraînement et de diffusion dans l'architecture AI Hypercomputer de Google Cloud.

Optimisé pour les grands modèles de langage (LLM) : Ironwood est spécialement conçu pour répondre à la demande croissante des LLM et des applications d'IA générative.

Technologie d'interconnexion améliorée : profitez des améliorations apportées à la technologie d'interconnexion TPU, qui permet d'accélérer les communications et de réduire la latence.

Calcul hautes performances : bénéficiez d'une amélioration significative des performances pour un large éventail de tâches d'inférence.

IA durable : Ironwood poursuit l'engagement de Google Cloud en faveur du développement durable, en offrant des performances exceptionnelles avec une efficacité énergétique optimisée.

Ironwood intègre une densité de calcul, une capacité de mémoire et une bande passante d'interconnexion accrues, avec des gains significatifs en termes d'efficacité énergétique. Ces fonctionnalités sont conçues pour offrir un débit plus élevé et une latence plus faible pour les charges de travail d'entraînement et de diffusion de l'IA exigeantes, en particulier celles qui impliquent des modèles volumineux et complexes. Les TPU Ironwood fonctionnent dans l'architecture AI Hypercomputer de Google Cloud.

Les produits d'IA Google Cloud font l'objet d'un contrat de niveau de service spécifique. Ils peuvent présenter des latences ou des garanties de disponibilité différentes de celles d'autres services Google Cloud.