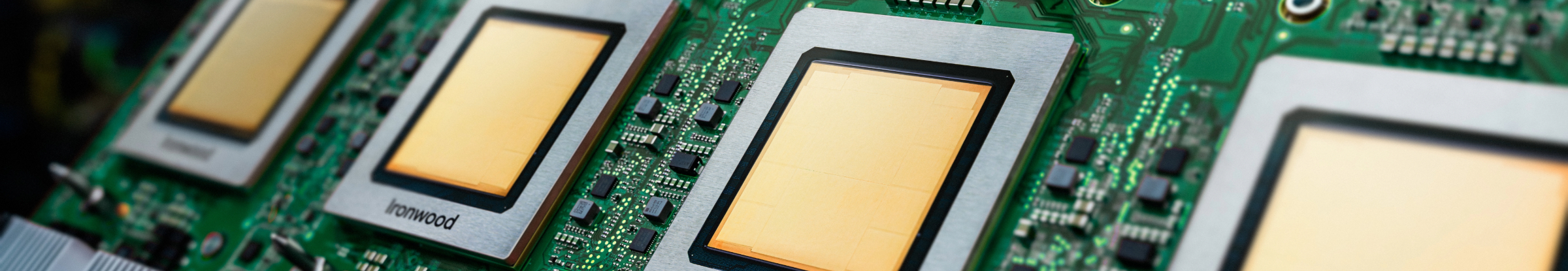

Ironwood: TPU de 7ª generación de Google Cloud diseñada para la inferencia

Entrena, ajusta y entrega modelos y conjuntos de datos más grandes de forma eficiente con la TPU más potente hasta el momento.

Solicita más información sobre Ironwood.

- (+1)

- Afganistán

- Albania

- Alemania

- Andorra

- Angola

- Anguila

- Antigua y Barbuda

- Antártida

- Arabia Saudita

- Argelia

- Argentina

- Armenia

- Aruba

- Australia

- Austria

- Azerbaiyán

- Bahamas

- Bangladés

- Barbados

- Baréin

- Belice

- Benín

- Bermudas

- Bielorrusia

- Bolivia

- Bosnia-Herzegovina

- Botsuana

- Brasil

- Brunéi

- Bulgaria

- Burkina Faso

- Burundi

- Bután

- Bélgica

- Cabo Verde

- Camboya

- Camerún

- Canadá

- Catar

- Chad

- Chequia

- Chile

- China

- Chipre

- Ciudad del Vaticano

- Colombia

- Comoras

- Corea del Sur

- Costa Rica

- Costa de Marfil

- Croacia

- Curazao

- Dinamarca

- Dominica

- Ecuador

- Egipto

- El Salvador

- Emiratos Árabes Unidos

- Eritrea

- Eslovaquia

- Eslovenia

- España

- Estados Unidos

- Estonia

- Esuatini

- Etiopía

- Filipinas

- Finlandia

- Fiyi

- Francia

- Gabón

- Gambia

- Georgia

- Ghana

- Gibraltar

- Granada

- Grecia

- Groenlandia

- Guadalupe

- Guam

- Guatemala

- Guayana Francesa

- Guinea

- Guinea Ecuatorial

- Guinea-Bisáu

- Guyana

- Haití

- Honduras

- Hong Kong

- Hungría

- India

- Indonesia

- Irak

- Irlanda

- Isla Ascensión

- Isla Bouvet

- Isla Norfolk

- Isla de Navidad

- Islandia

- Islas Caimán

- Islas Cocos

- Islas Cook

- Islas Feroe

- Islas Georgia del Sur y Sándwich del Sur

- Islas Heard y McDonald

- Islas Malvinas (Islas Falkland)

- Islas Marianas del Norte

- Islas Marshall

- Islas Pitcairn

- Islas Salomón

- Islas Turcas y Caicos

- Islas Ultramarinas de EE.UU.

- Islas Vírgenes Británicas

- Islas Vírgenes de EE. UU.

- Israel

- Italia

- Jamaica

- Japón

- Jordania

- Kazajistán

- Kenia

- Kirguistán

- Kiribati

- Kuwait

- Laos

- Lesoto

- Letonia

- Liberia

- Libia

- Liechtenstein

- Lituania

- Luxemburgo

- Líbano

- Macao

- Macedonia del Norte

- Madagascar

- Malasia

- Malaui

- Maldivas

- Mali

- Malta

- Marruecos

- Martinica

- Mauricio

- Mauritania

- Mayotte

- Micronesia

- Moldavia

- Mongolia

- Montenegro

- Montserrat

- Mozambique

- Myanmar (Birmania)

- México

- Mónaco

- Namibia

- Nauru

- Nepal

- Nicaragua

- Nigeria

- Niue

- Noruega

- Nueva Caledonia

- Nueva Zelanda

- Níger

- Omán

- Pakistán

- Palaos

- Palestina

- Panamá

- Papúa Nueva Guinea

- Paraguay

- Países Bajos

- Perú

- Polinesia Francesa

- Polonia

- Portugal

- Puerto Rico

- Reino Unido

- República Centroafricana

- República Democrática del Congo

- República Dominicana

- República del Congo

- Reunión

- Ruanda

- Rumania

- Rusia

- Samoa

- Samoa Americana

- San Bartolomé

- San Cristóbal y Nieves

- San Marino

- San Martín

- San Pedro y Miquelón

- San Vicente y las Granadinas

- Santa Elena

- Santa Lucía

- Santo Tomé y Príncipe

- Senegal

- Serbia

- Seychelles

- Sierra Leona

- Singapur

- Sint Maarten

- Somalia

- Sri Lanka

- Sudáfrica

- Sudán del Sur

- Suecia

- Suiza

- Surinam

- Svalbard y Jan Mayen

- Sáhara Occidental

- Tailandia

- Taiwán

- Tanzania

- Tayikistán

- Territorio Británico del Océano Índico

- Territorios Australes Franceses

- Timor Oriental

- Togo

- Tokelau

- Tonga

- Trinidad y Tobago

- Turkmenistán

- Turquía

- Tuvalu

- Túnez

- Ucrania

- Uganda

- Uruguay

- Uzbekistán

- Vanuatu

- Venezuela

- Vietnam

- Wallis y Futuna

- Yemen

- Yibuti

- Zambia

- Zimbabue

¿Tu infraestructura está lista para la era de la inferencia?

Ironwood es la unidad de procesamiento tensorial (TPU) más potente, capaz y eficiente de Google hasta la fecha, diseñada para potenciar los modelos de IA inferencial y de pensamiento a gran escala. Aprovechando la amplia experiencia en el desarrollo de TPU para los servicios internos de Google y los clientes de Google Cloud, Ironwood se diseñó para manejar las demandas de procesamiento y memoria de modelos como los modelos de lenguaje grandes (LLM), la mezcla de expertos (MoE) y las tareas de razonamiento avanzado. Admite cargas de trabajo de entrenamiento y las entregas dentro de la arquitectura de AI Hypercomputer de Google Cloud.

Optimizada para modelos de lenguaje grandes (LLM): Ironwood está diseñada específicamente para satisfacer más rápido las crecientes demandas de los LLM y acelerar las aplicaciones de IA generativa.

Tecnología de interconexión mejorada: Aprovecha las mejoras en la tecnología de interconexión de TPU, que permiten una comunicación más rápida y una latencia reducida.

Computación de alto rendimiento: Experimenta mejoras significativas en el rendimiento para un amplio rango de tareas de inferencia.

IA sustentable: Ironwood continúa el compromiso de Google Cloud con la sustentabilidad y ofrece un rendimiento excepcional con una eficiencia energética optimizada.

Ironwood integra una mayor densidad de procesamiento, más capacidad de memoria y más ancho de banda de interconexión con ganancias significativas en la eficiencia energética. Estas funciones están diseñadas para permitir una mayor capacidad de procesamiento y una menor latencia para las cargas de trabajo exigentes de entrega y entrenamiento de IA, en particular aquellas que involucran modelos grandes y complejos. Las TPU de Ironwood funcionan dentro de la arquitectura de AI Hypercomputer de Google Cloud.

Los productos de IA de Cloud cumplen con las políticas de nuestros ANS. Es posible que ofrezcan garantías de latencia o disponibilidad distintas de otros servicios de Google Cloud.