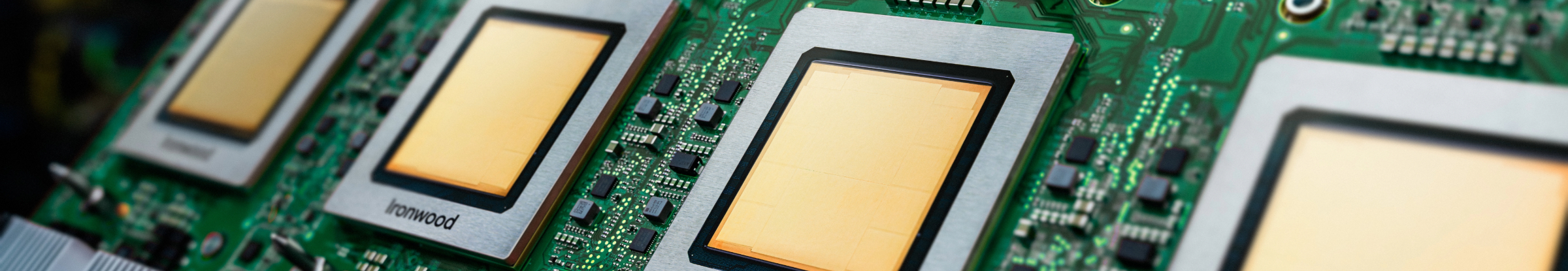

Ironwood: TPU der 7. Generation von Google Cloud, entwickelt für Inferenz

Mit der bisher leistungsstärksten TPU können Sie größere Modelle und Datasets effizient trainieren, abstimmen und bereitstellen.

Fordern Sie weitere Informationen zu Ironwood an.

- (+1)

- Afghanistan

- Albanien

- Algerien

- Amerikanisch-Samoa

- Amerikanische Jungferninseln

- Amerikanische Überseeinseln

- Andorra

- Angola

- Anguilla

- Antarktis

- Antigua und Barbuda

- Argentinien

- Armenien

- Aruba

- Ascension

- Aserbaidschan

- Australien

- Bahamas

- Bahrain

- Bangladesch

- Barbados

- Belarus

- Belgien

- Belize

- Benin

- Bermuda

- Bhutan

- Bolivien

- Bosnien und Herzegowina

- Botsuana

- Bouvetinsel

- Brasilien

- Britische Jungferninseln

- Britisches Territorium im Indischen Ozean

- Brunei Darussalam

- Bulgarien

- Burkina Faso

- Burundi

- Cabo Verde

- Chile

- China

- Cookinseln

- Costa Rica

- Curaçao

- Côte d’Ivoire

- Deutschland

- Dominica

- Dominikanische Republik

- Dschibuti

- Dänemark

- Ecuador

- El Salvador

- Eritrea

- Estland

- Eswatini

- Falklandinseln (Malwinen)

- Fidschi

- Finnland

- Frankreich

- Französisch-Guayana

- Französisch-Polynesien

- Französische Süd- und Antarktisgebiete

- Färöer

- Gabun

- Gambia

- Georgien

- Ghana

- Gibraltar

- Grenada

- Griechenland

- Grönland

- Guadeloupe

- Guam

- Guatemala

- Guinea

- Guinea-Bissau

- Guyana

- Haiti

- Heard und McDonaldinseln

- Honduras

- Hongkong

- Indien

- Indonesien

- Irak

- Irland

- Island

- Israel

- Italien

- Jamaika

- Japan

- Jemen

- Jordanien

- Kaimaninseln

- Kambodscha

- Kamerun

- Kanada

- Kasachstan

- Katar

- Kenia

- Kirgisistan

- Kiribati

- Kokosinseln

- Kolumbien

- Komoren

- Kongo-Brazzaville

- Kongo-Kinshasa

- Kroatien

- Kuwait

- Laos

- Lesotho

- Lettland

- Libanon

- Liberia

- Libyen

- Liechtenstein

- Litauen

- Luxemburg

- Macau

- Madagaskar

- Malawi

- Malaysia

- Malediven

- Mali

- Malta

- Marokko

- Marshallinseln

- Martinique

- Mauretanien

- Mauritius

- Mayotte

- Mexiko

- Mikronesien

- Monaco

- Mongolei

- Montenegro

- Montserrat

- Mosambik

- Myanmar

- Namibia

- Nauru

- Nepal

- Neukaledonien

- Neuseeland

- Nicaragua

- Niederlande

- Niger

- Nigeria

- Niue

- Nordmazedonien

- Norfolkinsel

- Norwegen

- Nördliche Marianen

- Oman

- Pakistan

- Palau

- Palästina

- Panama

- Papua-Neuguinea

- Paraguay

- Peru

- Philippinen

- Pitcairninseln

- Polen

- Portugal

- Puerto Rico

- Republik Moldau

- Ruanda

- Rumänien

- Russland

- Réunion

- Salomonen

- Sambia

- Samoa

- San Marino

- Saudi-Arabien

- Schweden

- Schweiz

- Senegal

- Serbien

- Seychellen

- Sierra Leone

- Simbabwe

- Singapur

- Sint Maarten

- Slowakei

- Slowenien

- Somalia

- Spanien

- Spitzbergen und Jan Mayen

- Sri Lanka

- St. Barthélemy

- St. Helena

- St. Kitts und Nevis

- St. Lucia

- St. Martin

- St. Pierre und Miquelon

- St. Vincent und die Grenadinen

- Suriname

- São Tomé und Príncipe

- Südafrika

- Südgeorgien und die Südlichen Sandwichinseln

- Südkorea

- Südsudan

- Tadschikistan

- Taiwan

- Tansania

- Thailand

- Timor-Leste

- Togo

- Tokelau

- Tonga

- Trinidad und Tobago

- Tschad

- Tschechien

- Tunesien

- Turkmenistan

- Turks- und Caicosinseln

- Tuvalu

- Türkei

- Uganda

- Ukraine

- Ungarn

- Uruguay

- Usbekistan

- Vanuatu

- Vatikanstadt

- Venezuela

- Vereinigte Arabische Emirate

- Vereinigte Staaten

- Vereinigtes Königreich

- Vietnam

- Wallis und Futuna

- Weihnachtsinsel

- Westsahara

- Zentralafrikanische Republik

- Zypern

- Ägypten

- Äquatorialguinea

- Äthiopien

- Österreich

Ist Ihre Infrastruktur bereit für das Zeitalter der Inferenz?

Ironwood ist die bisher leistungsstärkste, vielseitigste und energieeffizienteste Tensor Processing Unit (TPU) von Google, die für den Einsatz in inferentiellen KI-Modellen mit schlussfolgerndem Denken entwickelt wurde. Ironwood basiert auf der umfangreichen Erfahrung von Google bei der Entwicklung von TPUs für interne Dienste und Google Cloud-Kunden. Die TPU ist so konzipiert, dass sie die Rechen- und Speicheranforderungen von Modellen wie Large Language Models (LLMs), Mixture-of-Experts (MoEs) und komplexen Schlussfolgerungsaufgaben bewältigen kann. Sie unterstützt sowohl Trainings- als auch Bereitstellungs-Arbeitslasten innerhalb der Google Cloud AI Hypercomputer-Architektur.

Optimiert für Large Language Models (LLMs): Ironwood wurde speziell entwickelt, um die wachsende Nachfrage nach LLMs und Anwendungen für generative KI zu beschleunigen.

Verbesserte Interconnect-Technologie: Profitieren Sie von Verbesserungen an der TPU-Interconnect-Technologie, die eine schnellere Kommunikation und eine geringere Latenz ermöglichen.

Hochleistungs-Computing: Sie profitieren von einer deutlich höheren Leistung bei einer Vielzahl von Inferenzaufgaben.

Nachhaltige KI: Ironwood setzt das Engagement von Google Cloud für Nachhaltigkeit fort und bietet außergewöhnliche Leistung bei optimierter Energieeffizienz.

Ironwood bietet eine höhere Rechenleistung, Speicherkapazität und Bandbreite der Verbindung bei deutlich verbesserter Energieeffizienz. Diese Funktionen ermöglichen einen höheren Durchsatz und eine geringere Latenz für anspruchsvolle KI-Trainings- und Bereitstellungs-Workloads, insbesondere solche, die große, komplexe Modelle umfassen. Ironwood-TPUs sind in die Google Cloud AI Hypercomputer-Architektur eingebunden.

Cloud KI-Produkte entsprechen unseren SLA-Richtlinien. Sie bieten eventuell von anderen Google Cloud-Diensten abweichende Latenz- oder Verfügbarkeitsgarantien.