Ce tutoriel explique comment créer un pipeline réutilisable qui lit les données depuis Cloud Storage, effectue des contrôles de qualité des données et écrit dans Cloud Storage.

Les pipelines réutilisables possèdent une structure de pipeline standard, mais vous pouvez modifier la configuration de chaque nœud de pipeline en fonction des configurations fournies par un serveur HTTP. Par exemple, un pipeline statique peut lire des données à partir de Cloud Storage, appliquer des transformations et écrire des données dans une table de sortie BigQuery. Si vous souhaitez que la transformation et la table de sortie BigQuery changent en fonction du fichier Cloud Storage lu par le pipeline, vous devez créer un pipeline réutilisable.

Objectifs

- Utiliser le plug-in Cloud Storage Argument Setter pour permettre au pipeline de lire des entrées différentes à chaque exécution.

- Utiliser le plug-in Argument Setter Cloud Storage pour permettre au pipeline d'effectuer différents contrôles de qualité à chaque exécution.

- Écrire les données de sortie de chaque exécution dans Cloud Storage.

Coûts

Dans ce document, vous utilisez les composants facturables de Google Cloudsuivants :

- Cloud Data Fusion

- Cloud Storage

Vous pouvez obtenir une estimation des coûts en fonction de votre utilisation prévue à l'aide du simulateur de coût.

Avant de commencer

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Data Fusion, Cloud Storage, BigQuery, and Dataproc APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Créez une instance Cloud Data Fusion.

Dans la console Google Cloud , ouvrez la page Instances.

Dans la colonne Actions de l'instance, cliquez sur le lien Afficher l'instance. L'interface Web de Cloud Data Fusion s'ouvre dans un nouvel onglet du navigateur.

Accéder à l'interface Web de Cloud Data Fusion

Lorsque vous utilisez Cloud Data Fusion, vous utilisez à la fois la console Google Cloud et l'interface Web distincte Cloud Data Fusion. Dans la console Google Cloud , vous pouvez créer un projet de console Google Cloud , et créer et supprimer des instances Cloud Data Fusion. Dans l'interface Web de Cloud Data Fusion, vous pouvez utiliser les différentes pages, telles que Pipeline Studio ou Wrangler, pour utiliser les fonctionnalités de Cloud Data Fusion.

Déployer le plug-in Cloud Storage Argument Setter

Dans l'interface Web de Cloud Data Fusion, accédez à la page Studio.

Dans le menu Actions, cliquez sur GCS Argument Setter (Définisseur d'arguments GCS).

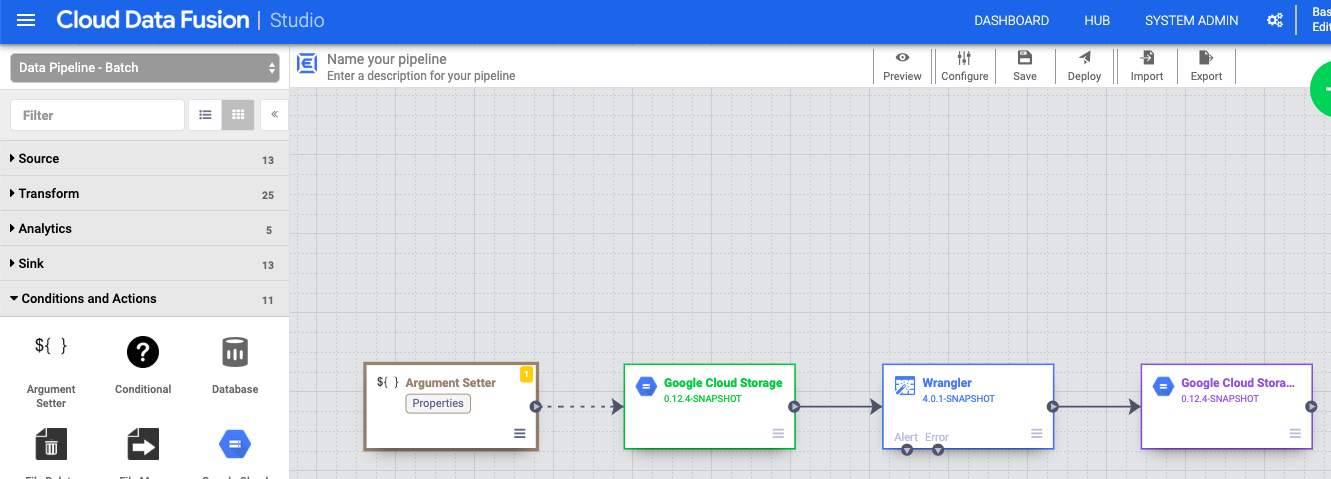

Lire à partir de Cloud Storage

- Dans l'interface Web de Cloud Data Fusion, accédez à la page Studio.

- Cliquez sur arrow_drop_down Source, puis sélectionnez Cloud Storage. Le nœud d'une source Cloud Storage s'affiche dans le pipeline.

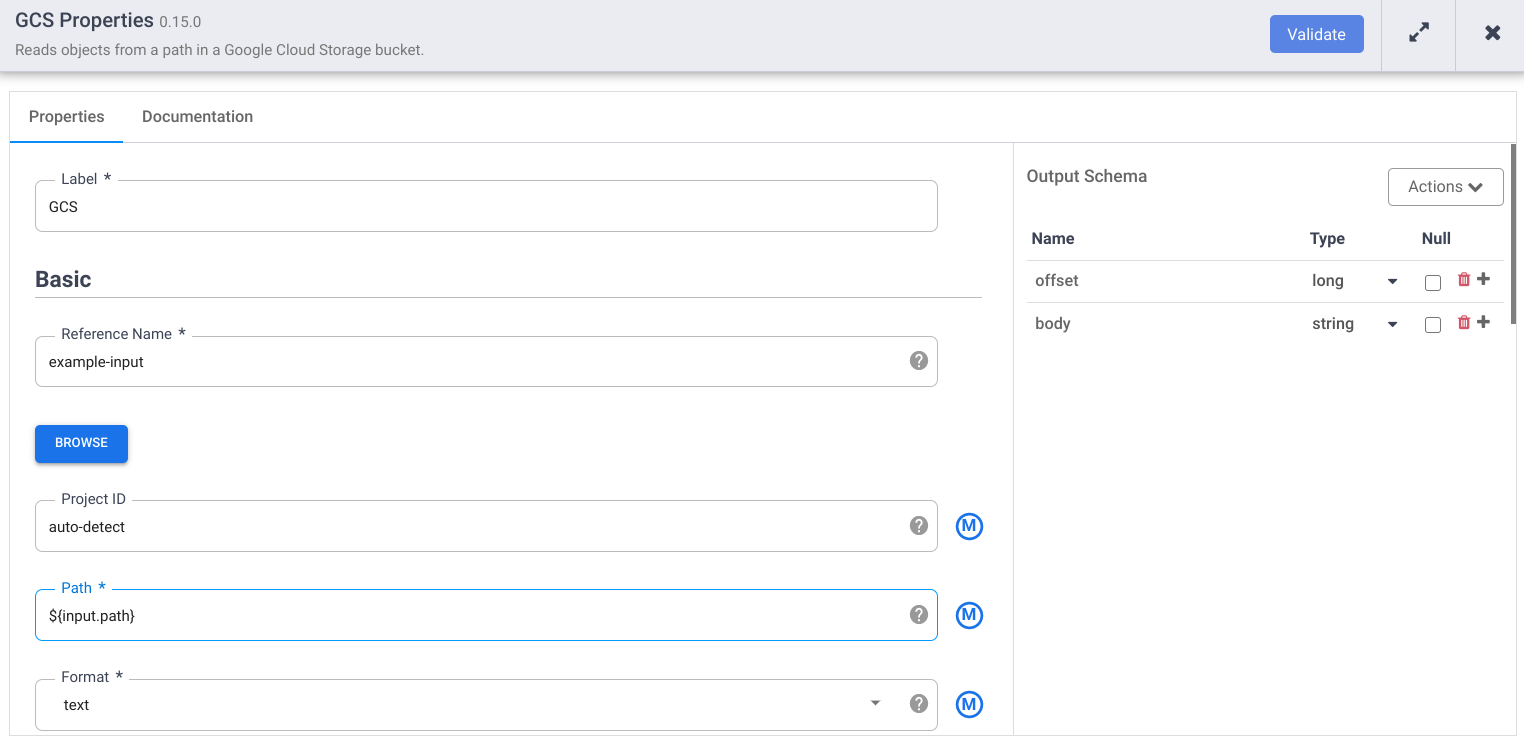

Sur le nœud Cloud Storage, cliquez sur Propriétés.

Dans le champ Nom de référence, saisissez un nom.

Dans le champ Chemin d'accès, saisissez

${input.path}. Cette macro contrôle quel sera le chemin d'entrée de Cloud Storage dans les différentes exécutions de pipeline.Dans le panneau "Schéma de sortie" situé à droite, supprimez le champ Décalage du schéma de sortie en cliquant sur l'icône de la corbeille dans la ligne correspondante.

Cliquez sur Valider et corrigez les éventuelles erreurs.

Cliquez sur pour quitter la boîte de dialogue Propriétés.

Transformez vos données

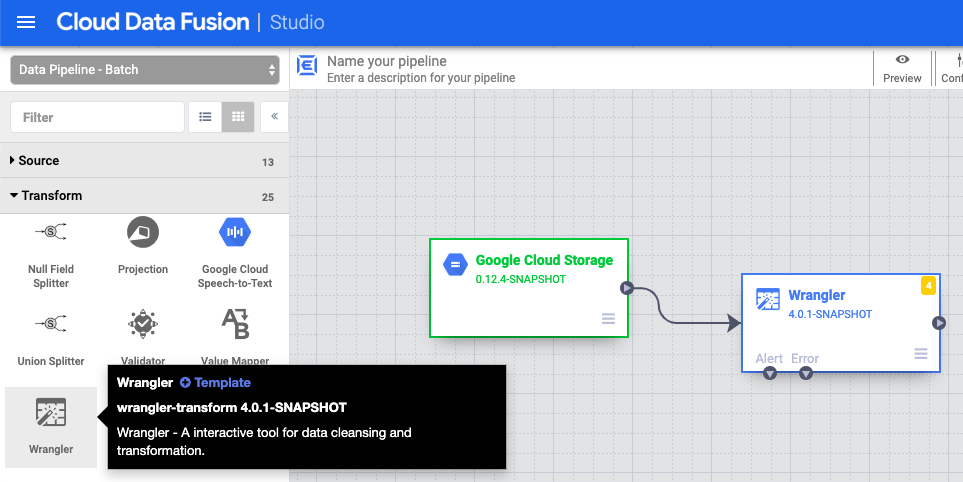

- Dans l'interface Web de Cloud Data Fusion, accédez à votre pipeline de données sur la page Studio.

- Dans le menu déroulant Transformer arrow_drop_down, sélectionnez Wrangler.

- Dans le canevas de Pipeline Studio, faites glisser une flèche du nœud Cloud Storage vers le nœud Wrangler.

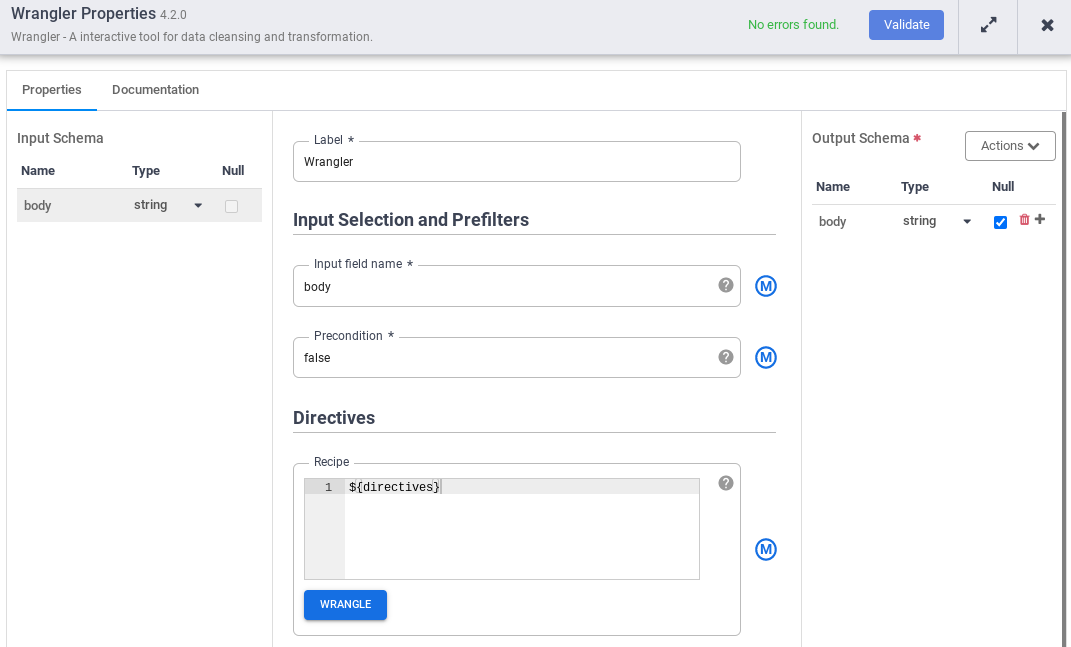

- Accédez au nœud Wrangler de votre pipeline, puis cliquez sur Propriétés.

- Dans le Nom du champ de saisie, saisissez

body. - Dans le champ Recette, saisissez

${directives}. Cette macro contrôle la logique de transformation dans les différentes exécutions de pipeline.

- Cliquez sur Valider et corrigez les éventuelles erreurs.

- Cliquez sur pour quitter la boîte de dialogue Propriétés.

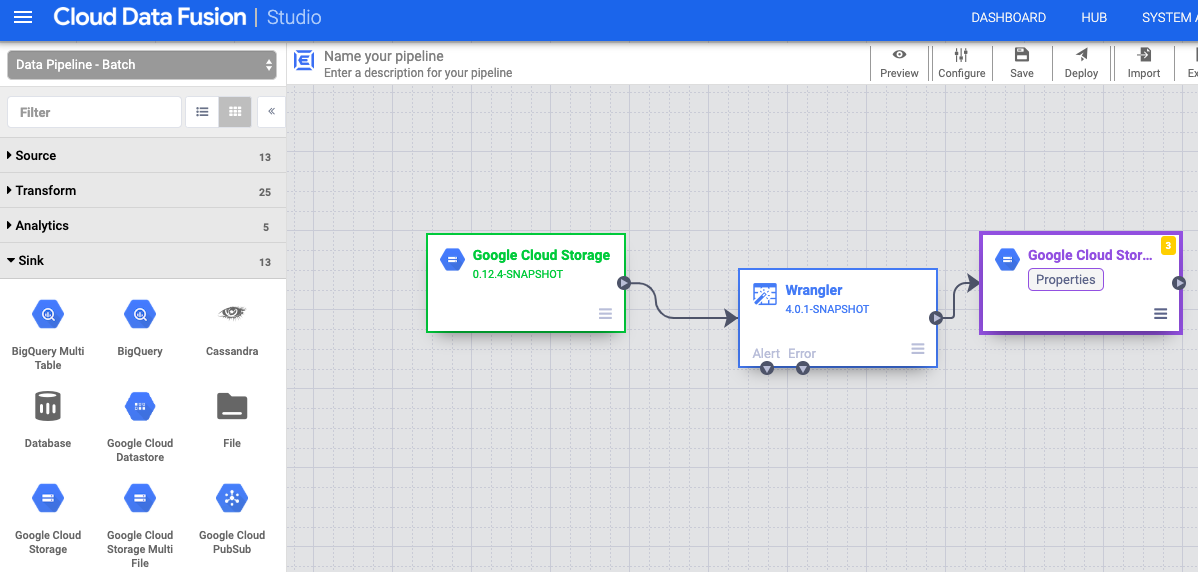

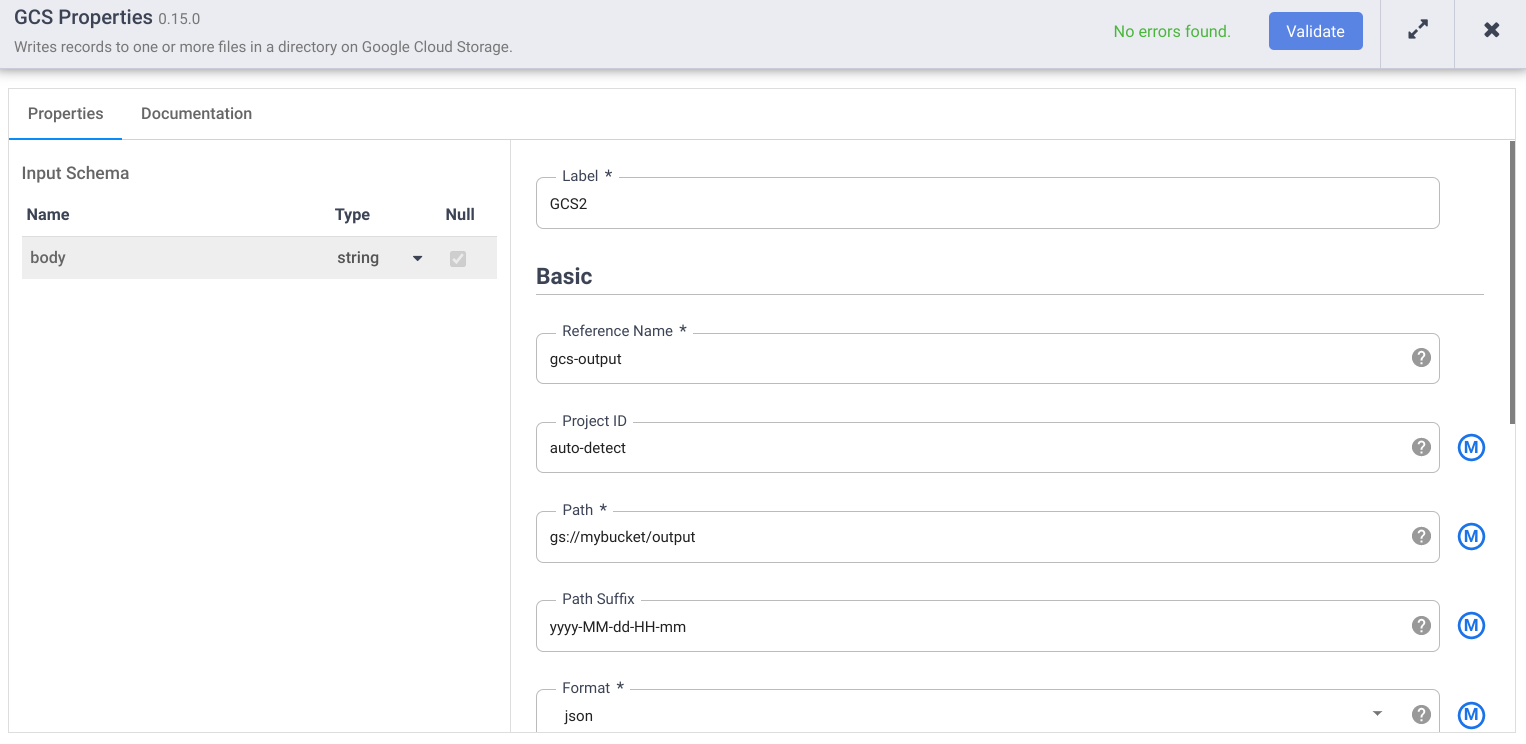

Écrire dans Cloud Storage

- Dans l'interface Web de Cloud Data Fusion, accédez à votre pipeline de données sur la page Studio.

- Dans le menu déroulant Récepteur arrow_drop_down, sélectionnez Cloud Storage.

- Dans le canevas de Pipeline Studio, faites glisser une flèche depuis le nœud Wrangler vers le nœud Cloud Storage que vous venez d'ajouter.

- Accédez au nœud de récepteur Cloud Storage dans votre pipeline, puis cliquez sur Propriétés.

- Dans le champ Nom de référence, saisissez un nom.

- Dans le champ Chemin d'accès, saisissez le chemin d'un bucket Cloud Storage dans votre projet, où votre pipeline peut écrire les fichiers de sortie. Si vous n'avez pas de bucket Cloud Storage, créez-en un.

- Cliquez sur Valider et corrigez les éventuelles erreurs.

- Cliquez sur pour quitter la boîte de dialogue Propriétés.

Définir les arguments de macro

- Dans l'interface Web de Cloud Data Fusion, accédez à votre pipeline de données sur la page Studio.

- Dans le menu déroulant arrow_drop_down Conditions et actions, cliquez sur Argument Setter GCS.

- Dans le canevas de Pipeline Studio, faites glisser une flèche depuis le nœud "Argument Setter" de Cloud Storage vers le nœud source de Cloud Storage.

- Accédez au nœud "Argument Setter" de Cloud Storage dans votre pipeline, puis cliquez sur Propriétés.

Dans le champ URL, saisissez l'URL suivante :

gs://reusable-pipeline-tutorial/args.jsonL'URL correspond à un objet accessible au public dans Cloud Storage qui contient le contenu suivant :

{ "arguments" : [ { "name": "input.path", "value": "gs://reusable-pipeline-tutorial/user-emails.txt" }, { "name": "directives", "value": "send-to-error !dq:isEmail(body)" } ] }Le premier des deux arguments est la valeur de

input.path. Le chemin d'accèsgs://reusable-pipeline-tutorial/user-emails.txtest un objet accessible au public dans Cloud Storage qui contient les données de test suivantes :alice@example.com bob@example.com craig@invalid@example.comLe deuxième argument est la valeur de

directives. La valeursend-to-error !dq:isEmail(body)configure Wrangler pour filtrer les lignes qui ne sont pas une adresse e-mail valide. Par exemple,craig@invalid@example.comest exclu.Cliquez sur Valider pour vérifier qu'il n'y a pas d'erreurs.

Cliquez sur pour quitter la boîte de dialogue Propriétés.

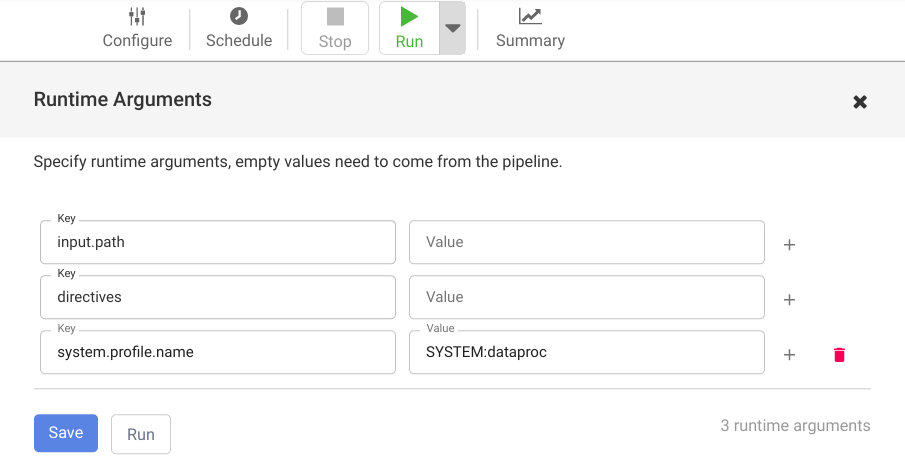

Déployer et exécuter votre pipeline

Dans la barre supérieure de la page Pipeline Studio, cliquez sur Nommer votre pipeline. Nommez votre pipeline et cliquez sur Enregistrer.

Cliquez sur Déployer.

Pour ouvrir les Arguments d'exécution et afficher les arguments de macro (exécution)

input.pathetdirectives, cliquez sur le menu déroulant arrow_drop_down à côté de Exécuter.Laissez les champs de valeur vides pour indiquer à Cloud Data Fusion que le nœud Cloud Storage Argument Setter dans le pipeline définira les valeurs de ces arguments lors de l'exécution.

Cliquez sur Exécuter.

Effectuer un nettoyage

Pour éviter que les ressources utilisées lors de ce tutoriel soient facturées sur votre compte Google Cloud, supprimez le projet contenant les ressources, ou conservez le projet et supprimez les ressources individuelles.

Une fois le tutoriel terminé, nettoyez les ressources que vous avez créées surGoogle Cloud afin qu'elles ne soient plus comptabilisées dans votre quota et qu'elles ne vous soient plus facturées. Dans les sections suivantes, nous allons voir comment supprimer ou désactiver ces ressources.

Supprimer l'instance Cloud Data Fusion

Suivez les instructions pour supprimer votre instance Cloud Data Fusion.

Supprimer le projet

Le moyen le plus simple d'empêcher la facturation est de supprimer le projet que vous avez créé pour ce tutoriel.

Pour supprimer le projet :

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

Étapes suivantes

- Consultez les guides d'utilisation

- Suivez un autre tutoriel