Linieritas data Cloud Data Fusion

Anda dapat menggunakan silsilah data Cloud Data Fusion untuk melakukan hal berikut:

Mendeteksi akar penyebab peristiwa data buruk.

Lakukan analisis dampak sebelum melakukan perubahan data.

Sebaiknya gunakan integrasi silsilah aset di Dataplex Universal Catalog. Untuk mengetahui informasi selengkapnya, lihat Melihat silsilah di Dataplex Universal Catalog.

Anda juga dapat melihat silsilah di tingkat set data dan kolom di Cloud Data Fusion Studio menggunakan opsi Metadata, yang menampilkan silsilah untuk rentang waktu yang dipilih.

Silsilah tingkat set data menunjukkan hubungan antara set data dan pipeline.

Silsilah tingkat kolom menunjukkan operasi yang dilakukan pada sekumpulan kolom dalam set data sumber untuk menghasilkan sekumpulan kolom yang berbeda dalam set data target.

Mulai dari Cloud Data Fusion 6.9.2.4 dan seterusnya, jika Anda tidak melacak silsilah di Cloud Data Fusion, sebaiknya nonaktifkan emisi silsilah tingkat kolom di instance Anda menggunakan metode patch:

curl -X PATCH -H 'Content-Type: application/json' -H "Authorization: Bearer

$(gcloud auth print-access-token)"

'https://datafusion.googleapis.com/v1beta1/projects/PROJECT_ID/locations/REGION/instances/INSTANCE_ID?updateMask=options'

-d '{ "options": { "metadata.messaging.field.lineage.emission.enabled": "false" } }'

Ganti kode berikut:

PROJECT_ID: Google Cloud project IDREGION: lokasi Google Cloud projectINSTANCE_ID: ID instance Cloud Data Fusion

Skenario Tutorial

Dalam tutorial ini, Anda akan bekerja dengan dua pipeline:

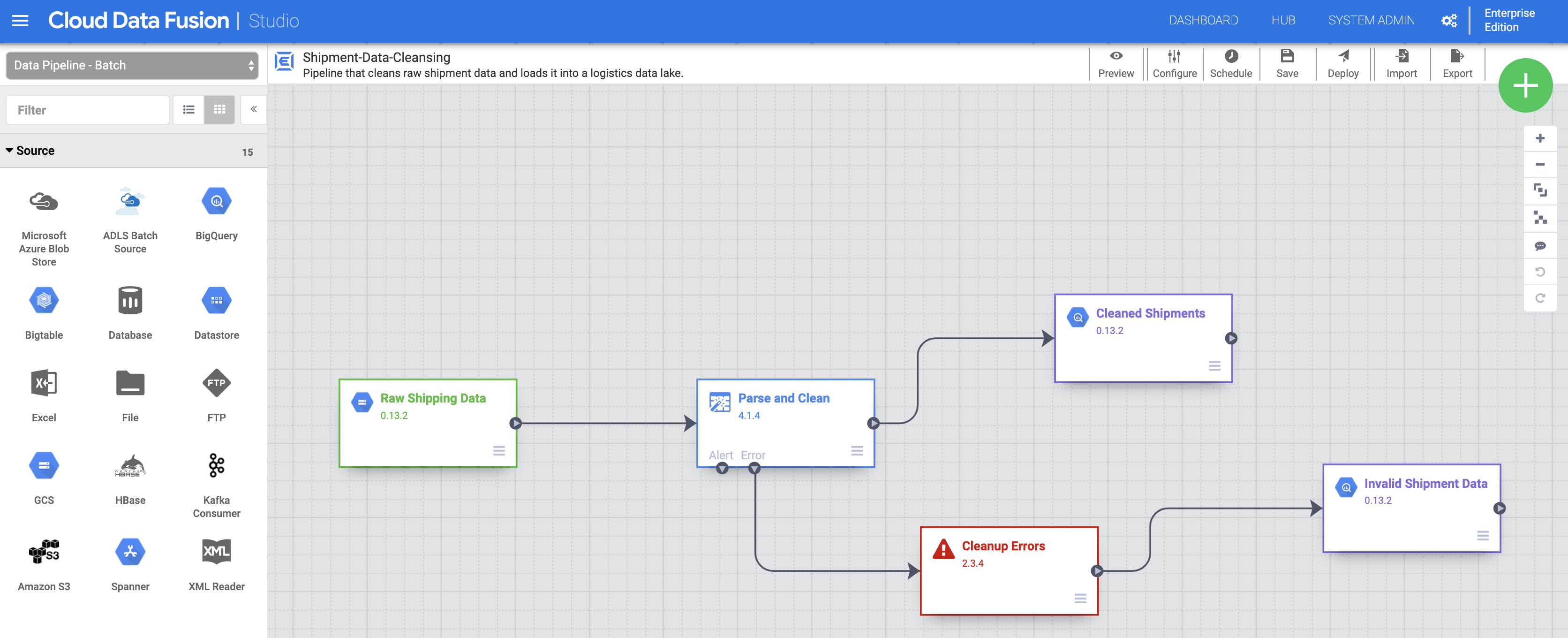

Pipeline

Shipment Data Cleansingmembaca data pengiriman mentah dari set data sampel kecil dan menerapkan transformasi untuk membersihkan data.Pipeline

Delayed Shipments USAkemudian membaca data pengiriman yang telah dibersihkan, menganalisisnya, dan menemukan pengiriman di Amerika Serikat yang tertunda lebih dari nilai minimum.

Pipeline tutorial ini menunjukkan skenario umum saat data mentah dibersihkan, lalu dikirim untuk diproses lebih lanjut. Jalur data ini dari data mentah hingga data pengiriman yang telah dibersihkan hingga output analisis dapat dijelajahi menggunakan fitur silsilah Cloud Data Fusion.

Membuka UI Cloud Data Fusion

Saat menggunakan Cloud Data Fusion, Anda menggunakan konsol Google Cloud dan UI Cloud Data Fusion yang terpisah. Di konsol Google Cloud , Anda dapat membuat project konsol Google Cloud , serta membuat dan menghapus instance Cloud Data Fusion. Di UI Cloud Data Fusion, Anda dapat menggunakan berbagai halaman, seperti Silsilah, untuk mengakses fitur Cloud Data Fusion.

Di konsol Google Cloud , buka halaman Instances.

Di kolom Actions untuk instance, klik link Lihat Instance. UI Cloud Data Fusion akan terbuka di tab browser baru.

Di panel Integrate, klik Studio untuk membuka halaman Studio Cloud Data Fusion.

Men-deploy dan menjalankan pipeline

Impor Data Pengiriman mentah. Di halaman Studio, klik Import atau klik + > Pipeline > Import, lalu pilih dan impor pipeline Pembersihan Data Pengiriman yang Anda download di Sebelum memulai.

Deploy pipeline. Klik Deploy di kanan atas halaman Studio. Setelah deployment, halaman Pipeline akan terbuka.

Jalankan pipeline. Klik Run di bagian tengah atas halaman Pipeline.

Impor, deploy, dan jalankan data dan pipeline Pengiriman Tertunda. Setelah status Pembersihan Data Pengiriman menunjukkan Berhasil, terapkan langkah-langkah sebelumnya ke data Pengiriman Tertunda Amerika Serikat yang Anda download di Sebelum Anda Memulai. Kembali ke halaman Studio untuk mengimpor data, lalu deploy dan jalankan pipeline kedua ini dari halaman Pipeline. Setelah pipeline kedua berhasil diselesaikan, lanjutkan dengan langkah-langkah yang tersisa.

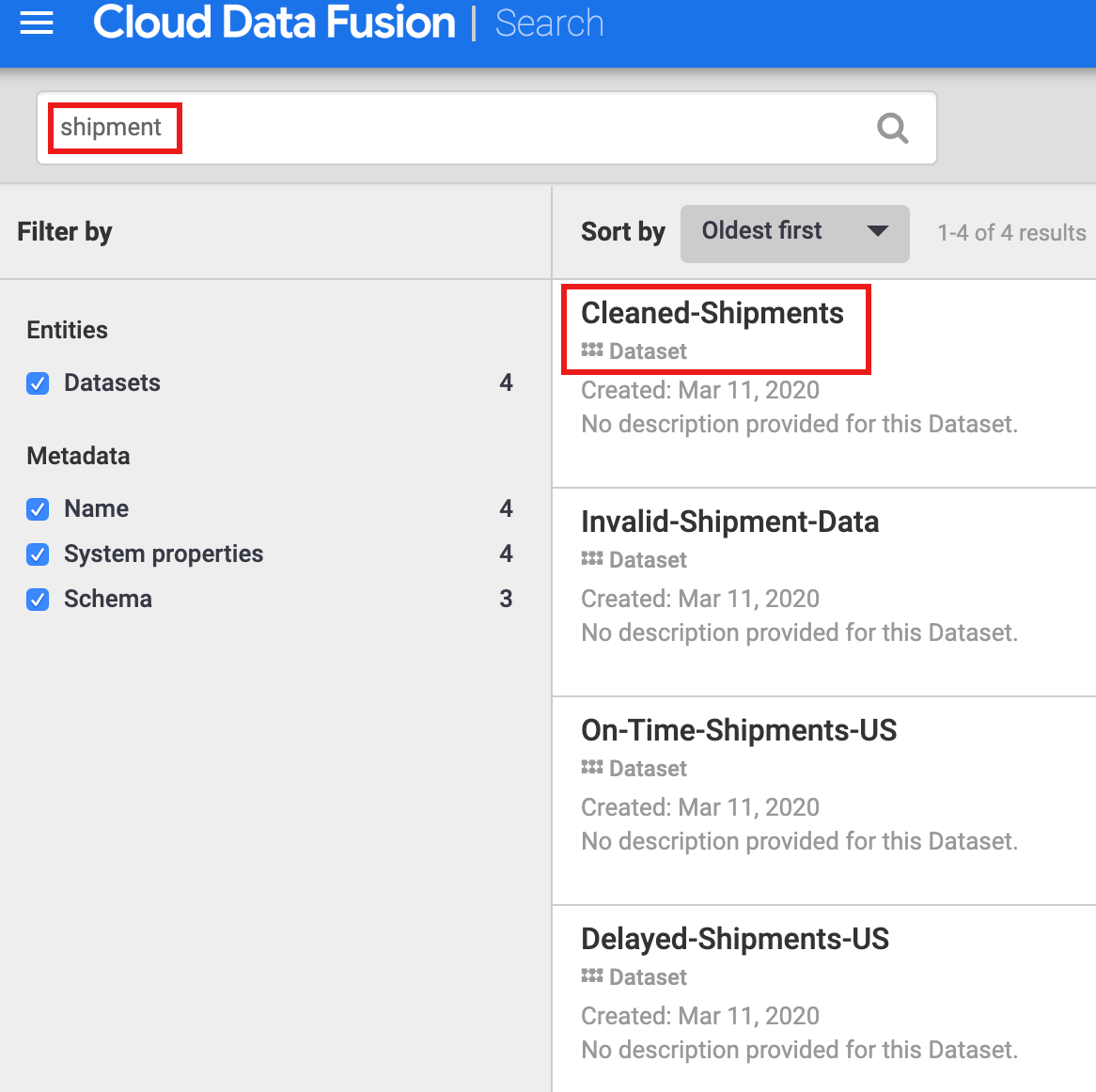

Menemukan set data

Anda harus menemukan set data sebelum menjelajahi asal-usulnya. Pilih Metadata dari panel navigasi kiri UI Cloud Data Fusion untuk membuka halaman Penelusuran metadata. Karena set data Pembersihan Data Pengiriman menentukan Cleaned-Shipments sebagai set data referensi, masukkan shipment di kotak Penelusuran. Hasil penelusuran mencakup set data ini.

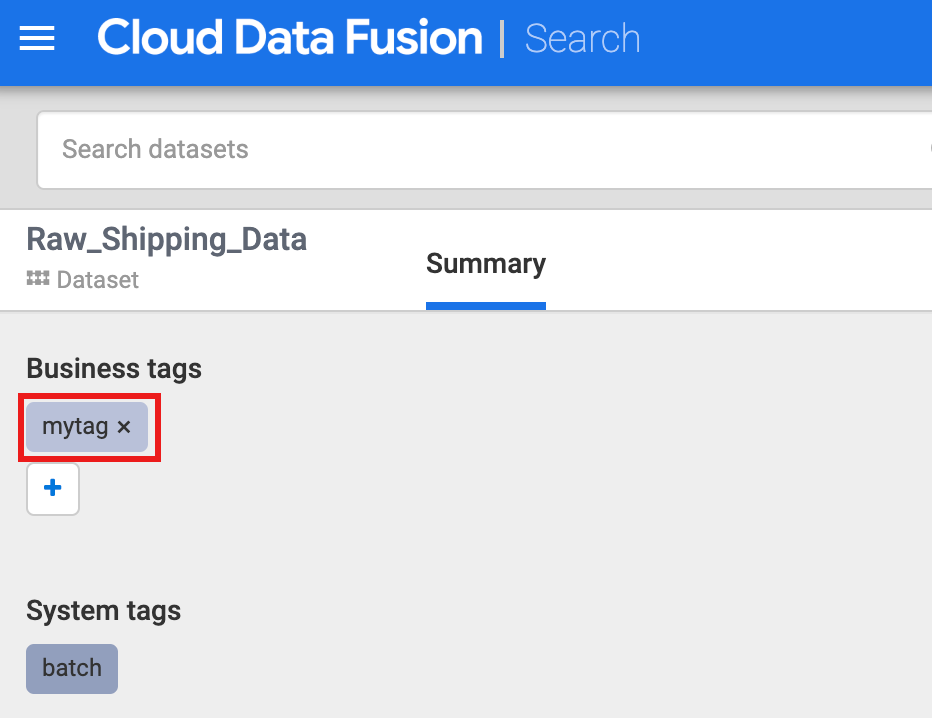

Menggunakan tag untuk menemukan set data

Penelusuran Metadata menemukan set data yang telah digunakan, diproses, atau dihasilkan oleh pipeline Cloud Data Fusion. Pipeline dijalankan pada framework terstruktur yang menghasilkan dan mengumpulkan metadata teknis dan operasional. Metadata teknis mencakup nama, jenis, skema, kolom, waktu pembuatan, dan informasi pemrosesan set data. Informasi teknis ini digunakan oleh fitur silsilah dan penelusuran metadata Cloud Data Fusion.

Cloud Data Fusion juga mendukung anotasi set data dengan metadata bisnis, seperti tag dan properti nilai kunci, yang dapat digunakan sebagai kriteria penelusuran. Misalnya, untuk menambahkan dan menelusuri anotasi tag bisnis pada set data Data Pengiriman Mentah:

Klik tombol Properties pada node Raw Shipping Data di halaman Pipeline Pembersihan Data Pengiriman untuk membuka halaman Cloud Storage Properties.

Klik Lihat Metadata untuk membuka halaman Penelusuran.

Di bagian Tag Bisnis, klik +, lalu masukkan nama tag (karakter alfanumerik dan garis bawah diizinkan) dan tekan Enter.

Menjelajahi silsilah

Silsilah tingkat set data

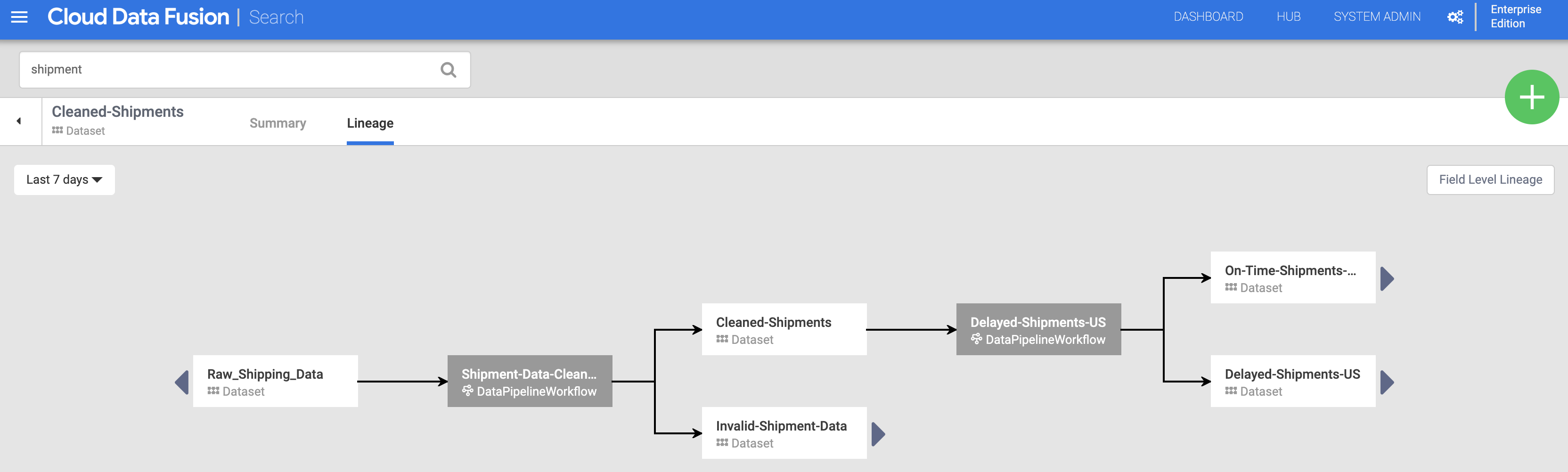

Klik nama set data Cleaned-Shipments yang tercantum di halaman Penelusuran (dari Temukan set data), lalu klik tab Silsilah. Grafik silsilah menunjukkan bahwa set data ini dihasilkan oleh pipeline Shipments-Data-Cleansing, yang telah menggunakan set data Raw_Shipping_Data.

Panah kiri dan kanan memungkinkan Anda menavigasi kembali dan maju melalui silsilah set data sebelumnya atau berikutnya. Dalam contoh ini, grafik menampilkan silsilah lengkap untuk set data Cleaned-Shipments.

Urutan tingkat kolom

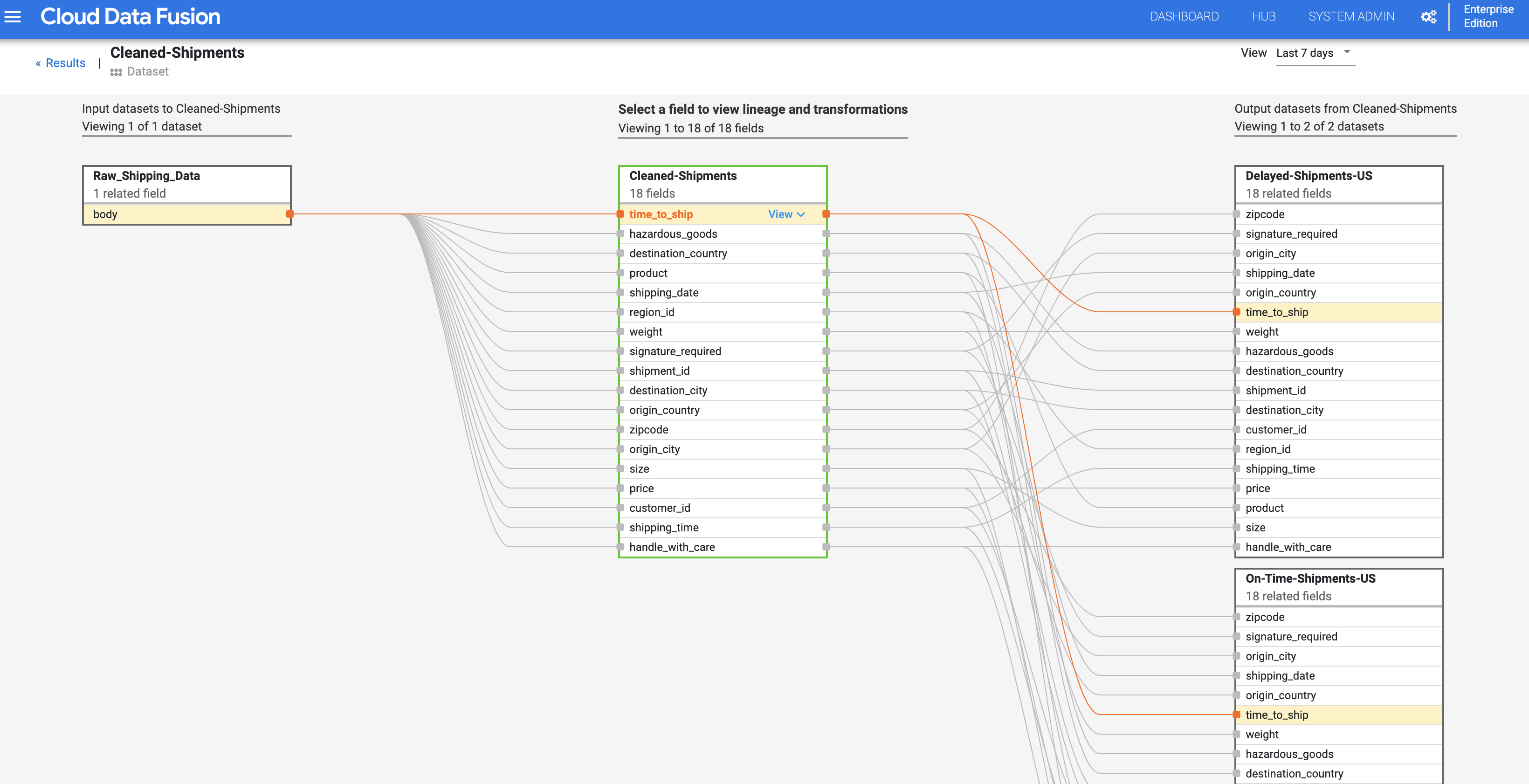

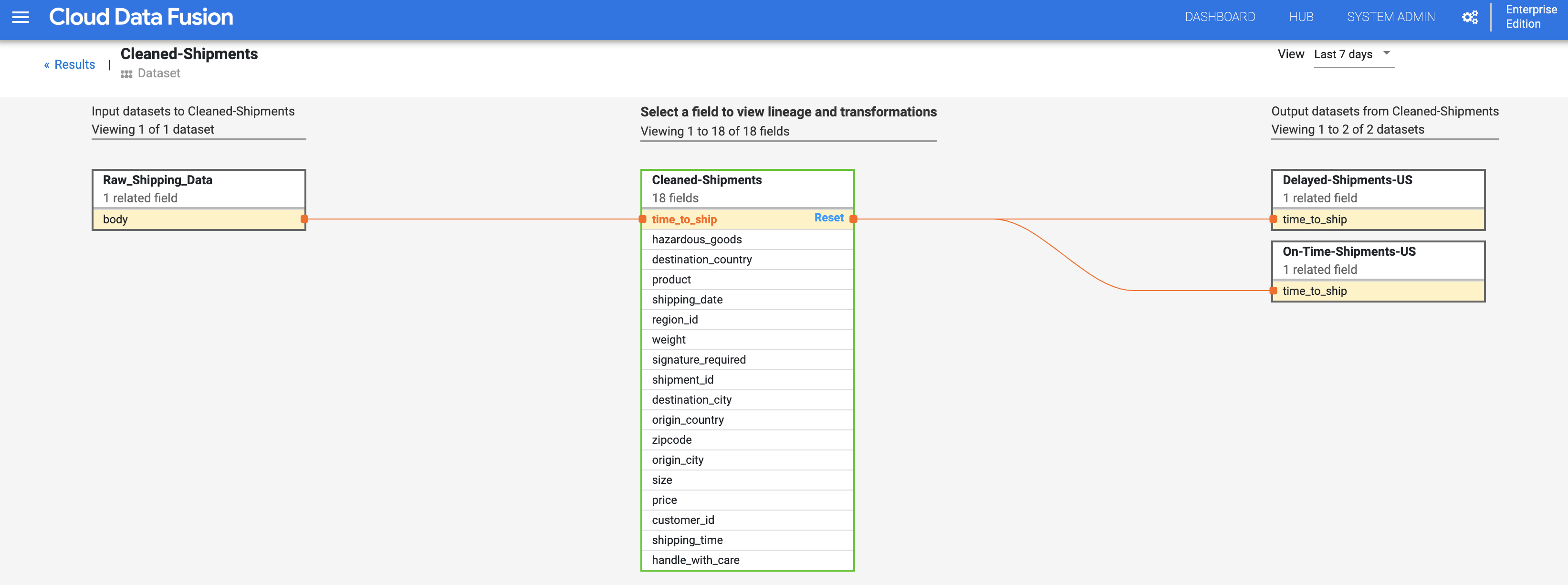

Silsilah tingkat kolom Cloud Data Fusion menunjukkan hubungan antara kolom set data dan transformasi yang dilakukan pada sekumpulan kolom untuk menghasilkan sekumpulan kolom yang berbeda. Seperti urutan tingkat set data, urutan tingkat kolom terikat waktu, dan hasilnya berubah seiring waktu.

Melanjutkan dari langkah Urutan tingkat set data, klik tombol Urutan Tingkat Kolom di kanan atas grafik urutan tingkat set data Pengiriman yang Sudah Dibersihkan untuk menampilkan grafik urutan tingkat kolomnya.

Grafik silsilah tingkat kolom menampilkan koneksi antar-kolom. Anda dapat memilih kolom untuk melihat asal-usulnya. Pilih Lihat > Sematkan kolom untuk melihat silsilah kolom tersebut saja.

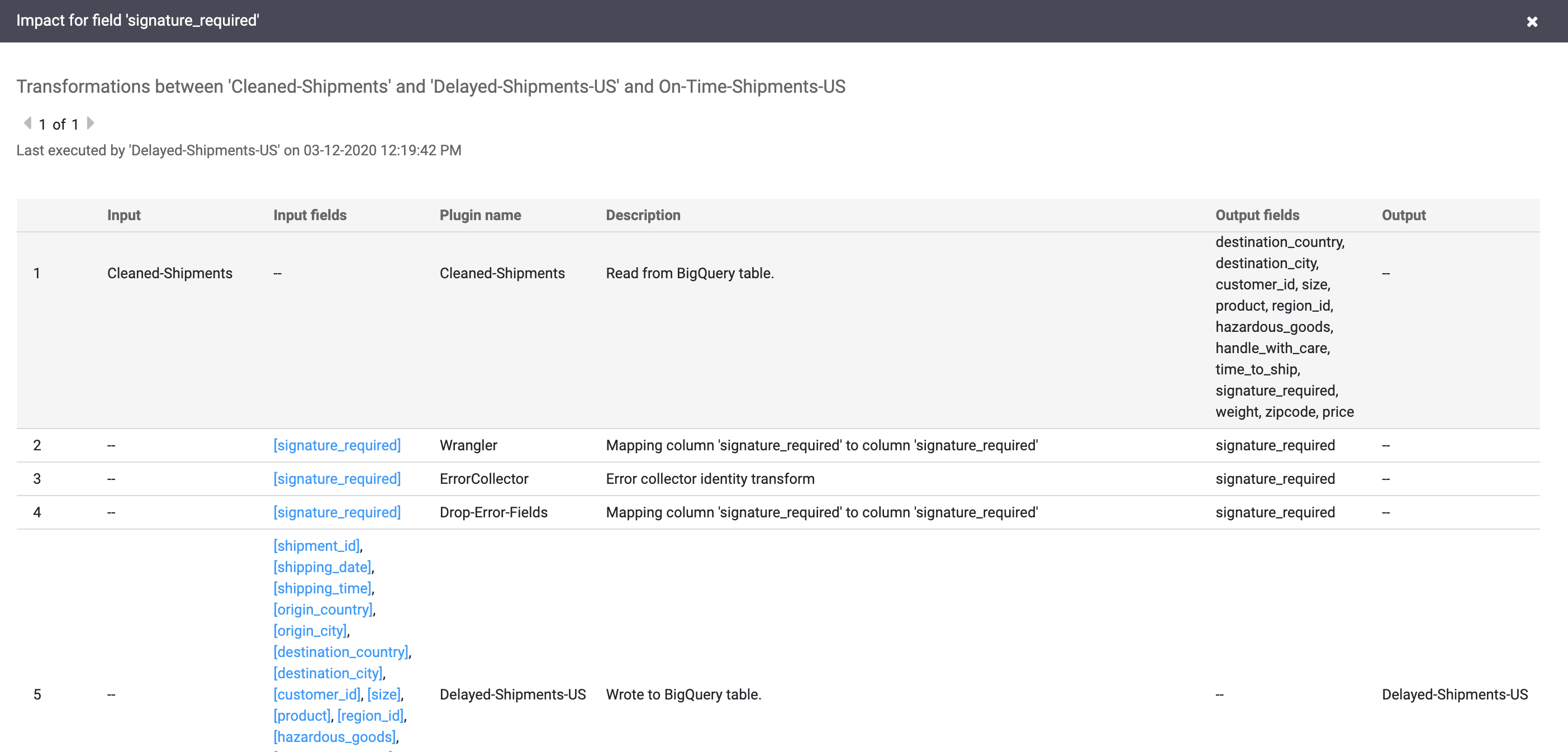

Pilih Lihat > Lihat dampak untuk melakukan analisis dampak.

Link penyebab dan dampak menampilkan transformasi yang dilakukan di kedua sisi kolom dalam format buku besar yang dapat dibaca manusia. Informasi ini dapat menjadi sangat penting untuk pelaporan dan tata kelola.