Lignaggio dei dati di Cloud Data Fusion

Puoi utilizzare la genealogia dei dati di Cloud Data Fusion per:

Rileva la causa principale degli eventi di dati errati.

Esegui un'analisi dell'impatto prima di apportare modifiche ai dati.

Ti consigliamo di utilizzare l'integrazione della derivazione degli asset in Dataplex Universal Catalog. Per saperne di più, consulta Visualizza la derivazione nel Catalogo universale Dataplex.

Puoi anche visualizzare la derivazione a livello di set di dati e campo in Cloud Data Fusion Studio utilizzando l'opzione Metadati, che mostra la derivazione per un intervallo di tempo selezionato.

La derivazione a livello di set di dati mostra la relazione tra set di dati e pipeline.

La derivazione a livello di campo mostra le operazioni eseguite su un insieme di campi nel set di dati di origine per produrre un insieme diverso di campi nel set di dati di destinazione.

A partire da Cloud Data Fusion 6.9.2.4, se non monitori la derivazione in

Cloud Data Fusion, ti consigliamo di disattivare l'emissione della derivazione a livello di campo

nella tua istanza utilizzando il metodo

patch:

curl -X PATCH -H 'Content-Type: application/json' -H "Authorization: Bearer

$(gcloud auth print-access-token)"

'https://datafusion.googleapis.com/v1beta1/projects/PROJECT_ID/locations/REGION/instances/INSTANCE_ID?updateMask=options'

-d '{ "options": { "metadata.messaging.field.lineage.emission.enabled": "false" } }'

Sostituisci quanto segue:

PROJECT_ID: l' Google Cloud ID progettoREGION: la posizione del progetto Google CloudINSTANCE_ID: l'ID istanza Cloud Data Fusion

Scenario del tutorial

In questo tutorial, lavorerai con due pipeline:

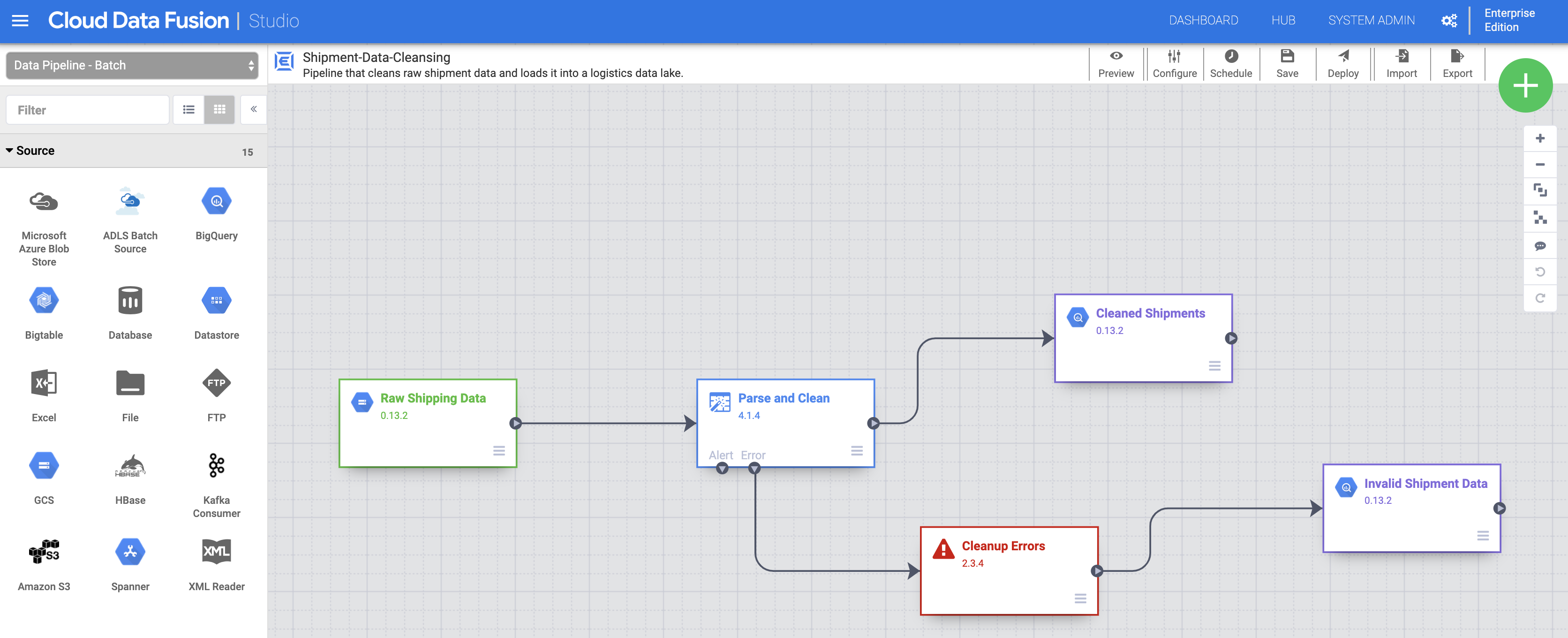

La pipeline

Shipment Data Cleansinglegge i dati di spedizione non elaborati da un piccolo set di dati di esempio e applica le trasformazioni per pulire i dati.La pipeline

Delayed Shipments USAlegge quindi i dati di spedizione puliti, li analizza e trova le spedizioni negli Stati Uniti che hanno subito un ritardo superiore a una soglia.

Queste pipeline tutorial mostrano uno scenario tipico in cui i dati non elaborati vengono puliti e poi inviati per l'elaborazione downstream. Questo percorso dei dati, dai dati non elaborati ai dati di spedizione puliti fino all'output analitico, può essere esplorato utilizzando la funzionalità di derivazione di Cloud Data Fusion.

Obiettivi

- Genera la derivazione eseguendo pipeline di esempio

- Esplora la derivazione a livello di set di dati e di campo

- Scopri come trasferire le informazioni di handshake dalla pipeline upstream alla pipeline downstream

Costi

In questo documento vengono utilizzati i seguenti componenti fatturabili di Google Cloud:

- Cloud Data Fusion

- Cloud Storage

- BigQuery

Per generare una stima dei costi in base all'utilizzo previsto,

utilizza il calcolatore prezzi.

Prima di iniziare

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Data Fusion, Cloud Storage, Dataproc, and BigQuery APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Crea un'istanza Cloud Data Fusion.

- Fai clic sui seguenti link per scaricare questi piccoli set di dati di esempio sul tuo computer locale:

Apri la UI di Cloud Data Fusion

Quando utilizzi Cloud Data Fusion, usi sia la console Google Cloud che la UI di Cloud Data Fusion separata. Nella console Google Cloud , puoi creare un progetto Google Cloud e creare ed eliminare istanze Cloud Data Fusion. Nella UI di Cloud Data Fusion, puoi utilizzare le varie pagine, ad esempio Derivazione, per accedere alle funzionalità di Cloud Data Fusion.

Nella console Google Cloud , apri la pagina Istanze.

Nella colonna Azioni per l'istanza, fai clic sul link Visualizza istanza. L'interfaccia utente di Cloud Data Fusion si apre in una nuova scheda del browser.

Nel riquadro Integra, fai clic su Studio per aprire la pagina Studio di Cloud Data Fusion.

Eseguire il deployment delle pipeline ed eseguirle

Importa i dati di spedizione non elaborati. Nella pagina Studio, fai clic su Importa o fai clic su + > Pipeline > Importa, quindi seleziona e importa la pipeline di pulizia dei dati di spedizione che hai scaricato in Prima di iniziare.

Esegui il deployment della pipeline. Fai clic su Esegui il deployment in alto a destra nella pagina Studio. Dopo il deployment, si apre la pagina Pipeline.

Esegui la pipeline. Fai clic su Esegui nella parte superiore centrale della pagina Pipeline.

Importa, esegui il deployment ed esegui i dati e la pipeline Spedizioni ritardate. Dopo che lo stato della pulizia dei dati di spedizione mostra Riuscito, applica i passaggi precedenti ai dati Spedizioni ritardate USA che hai scaricato in Prima di iniziare. Torna alla pagina Studio per importare i dati, quindi esegui il deployment e l'esecuzione di questa seconda pipeline dalla pagina Pipeline. Una volta completata correttamente la seconda pipeline, procedi con i passaggi rimanenti.

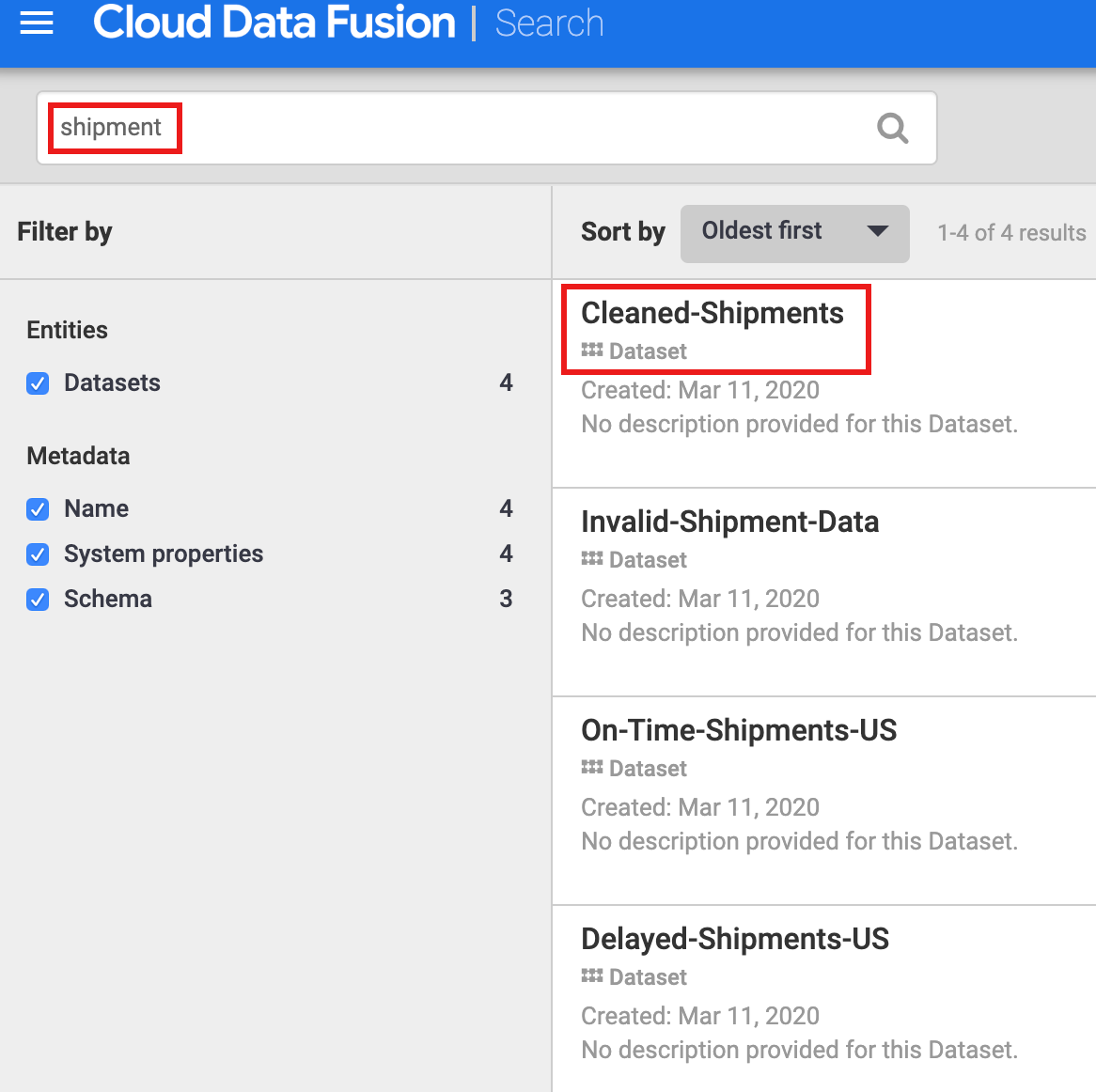

Scopri i set di dati

Devi scoprire un set di dati prima di esplorarne la derivazione. Seleziona Metadati nel pannello di navigazione a sinistra della UI di Cloud Data Fusion per aprire la pagina Ricerca dei metadati. Poiché il set di dati Pulizia dei dati di spedizione ha specificato Cleaned-Shipments come set di dati di riferimento, inserisci shipment nella casella di ricerca. I risultati della ricerca includono questo set di dati.

Utilizzare i tag per scoprire i set di dati

Una ricerca di metadati rileva i set di dati utilizzati, elaborati o generati dalle pipeline di Cloud Data Fusion. Le pipeline vengono eseguite su un framework strutturato che genera e raccoglie metadati tecnici e operativi. I metadati tecnici includono nome, tipo, schema, campi, ora di creazione e informazioni di elaborazione del set di dati. Queste informazioni tecniche vengono utilizzate dalle funzionalità di ricerca e derivazione dei metadati di Cloud Data Fusion.

Cloud Data Fusion supporta anche l'annotazione dei set di dati con metadati aziendali, come tag e proprietà chiave-valore, che possono essere utilizzati come criteri di ricerca. Ad esempio, per aggiungere e cercare un'annotazione di tag aziendale nel set di dati Raw Shipping Data:

Fai clic sul pulsante Proprietà del nodo Dati di spedizione non elaborati nella pagina Pipeline di pulizia dei dati di spedizione per aprire la pagina Proprietà di Cloud Storage.

Fai clic su Visualizza metadati per aprire la pagina Cerca.

In Tag dell'attività, fai clic su + e poi inserisci un nome del tag (sono consentiti caratteri alfanumerici e trattini bassi) e premi Invio.

Esplora derivazione

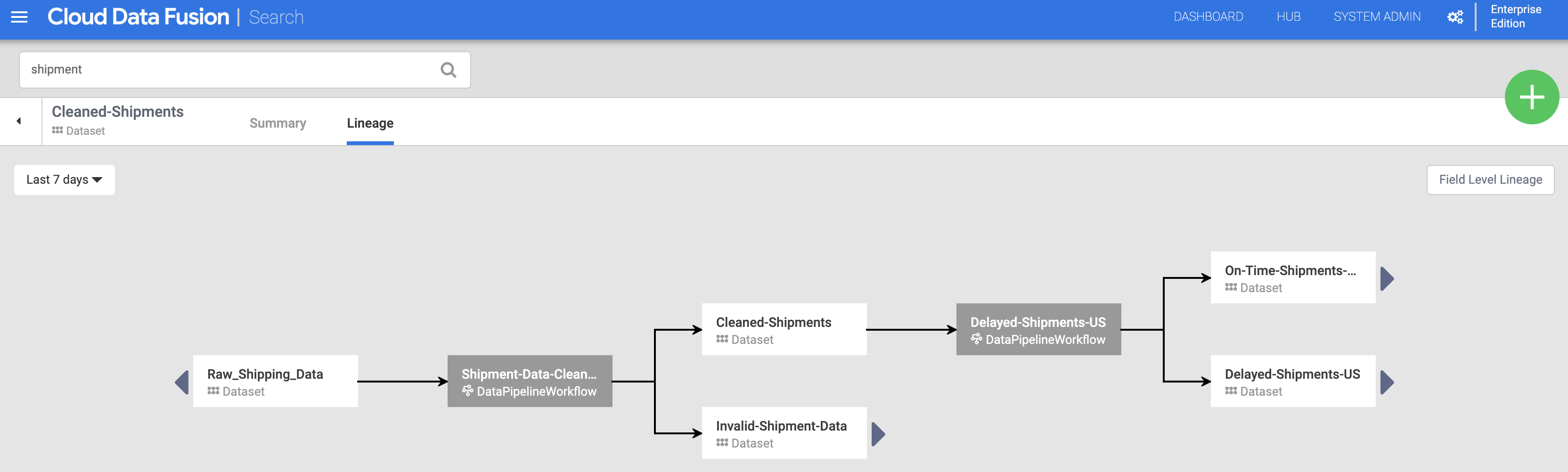

Derivazione a livello di set di dati

Fai clic sul nome del set di dati Spedizioni pulite elencato nella pagina di ricerca (da Scopri set di dati), quindi fai clic sulla scheda Lineage. Il grafico della derivazione mostra che questo set di dati è stato generato dalla pipeline Shipments-Data-Cleansing, che aveva utilizzato il set di dati Raw_Shipping_Data.

Le frecce sinistra e destra ti consentono di spostarti avanti e indietro nella genealogia di qualsiasi set di dati precedente o successivo. In questo esempio, il grafico mostra la derivazione completa del set di dati Spedizioni pulite.

Derivazione a livello di campo

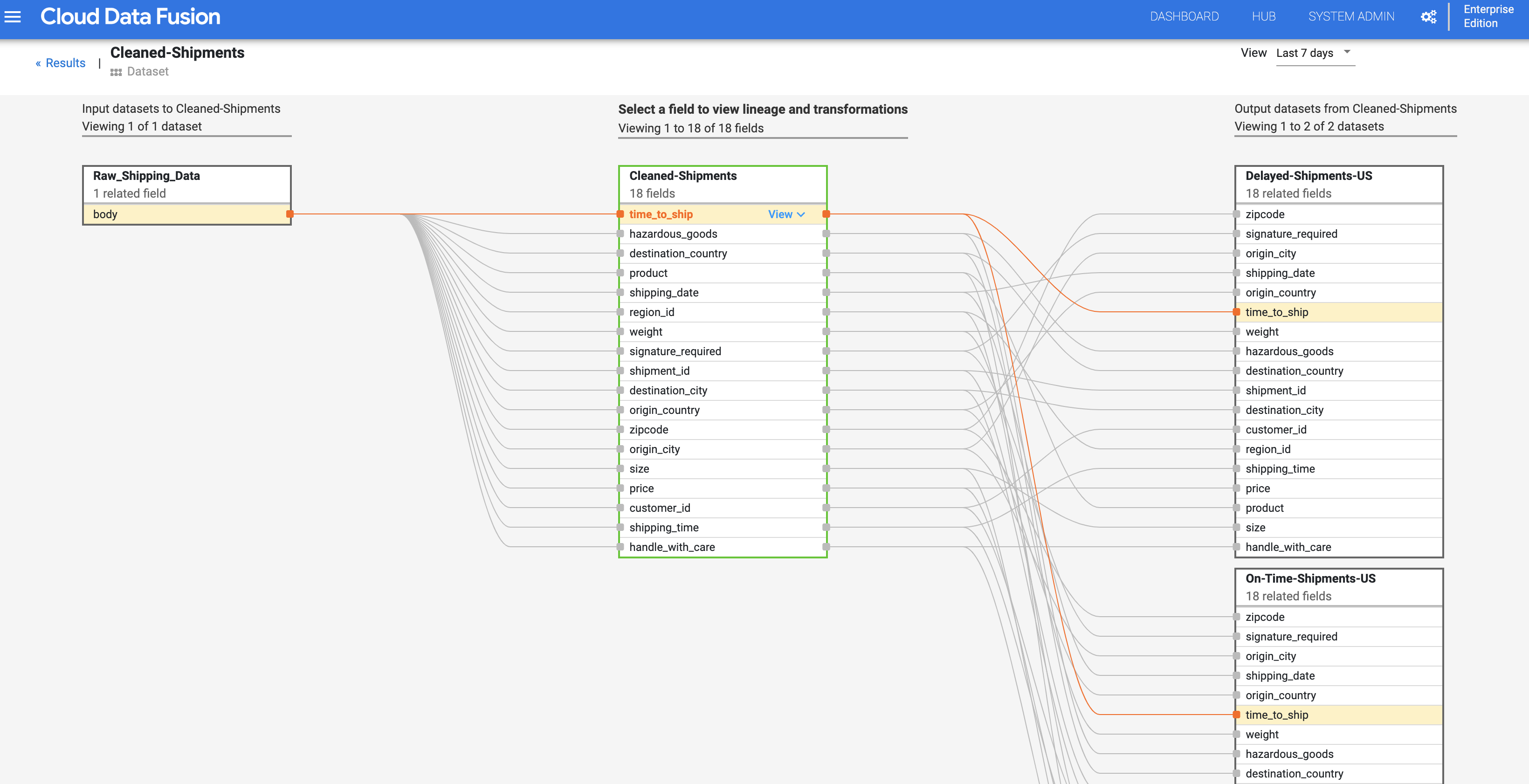

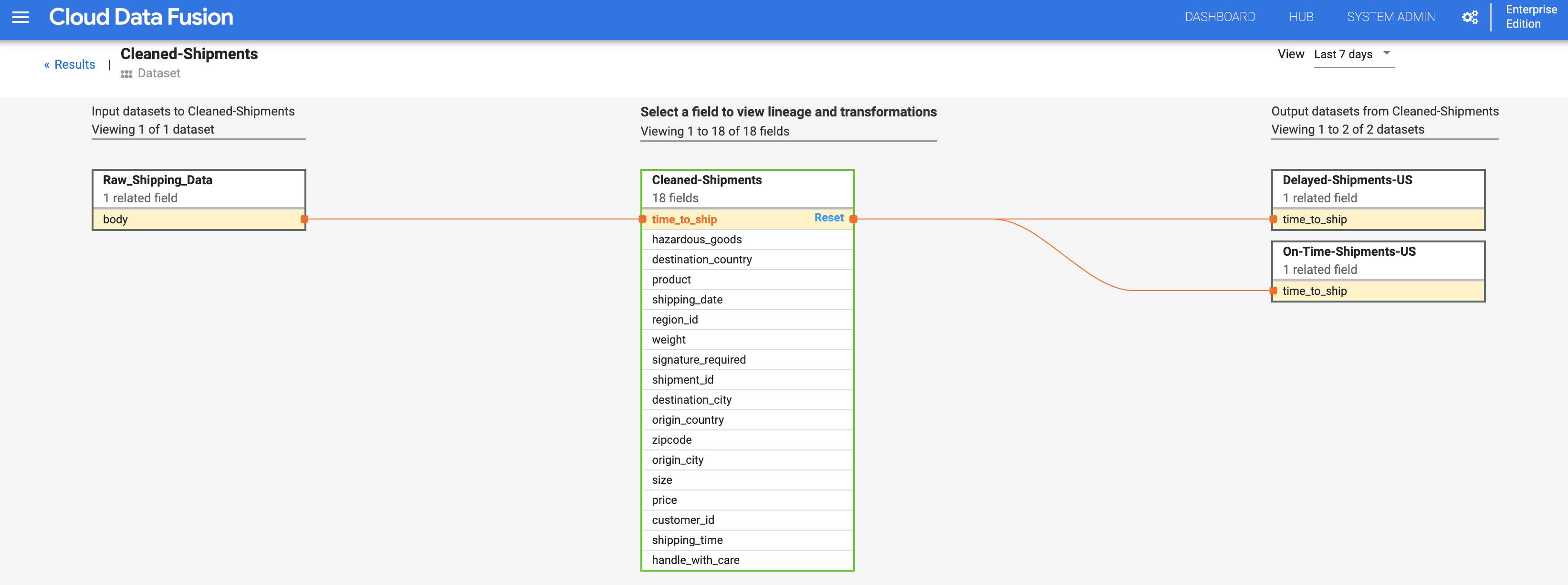

La derivazione a livello di campo di Cloud Data Fusion mostra la relazione tra i campi di un set di dati e le trasformazioni eseguite su un insieme di campi per produrre un insieme diverso di campi. Come la derivazione a livello di set di dati, la derivazione a livello di campo è vincolata al tempo e i suoi risultati cambiano nel tempo.

Continuando dal passaggio Derivazione a livello di set di dati, fai clic sul pulsante Derivazione a livello di campo in alto a destra del grafico della derivazione a livello di set di dati Spedizioni pulite per visualizzare il grafico della derivazione a livello di campo.

Il grafico della derivazione a livello di campo mostra le connessioni tra i campi. Puoi selezionare un campo per visualizzarne la derivazione. Seleziona Visualizza > Blocca campo per visualizzare solo la derivazione di quel campo.

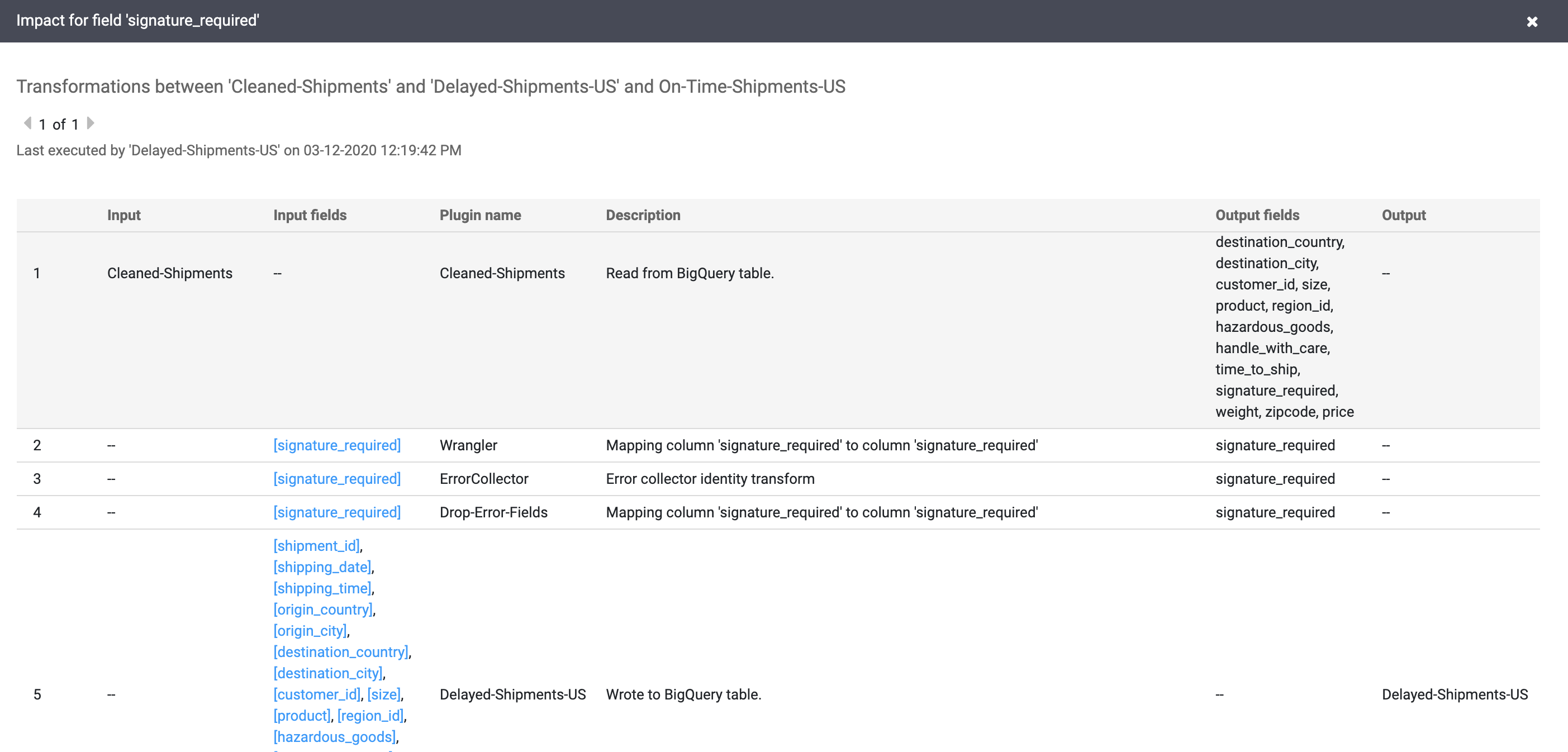

Seleziona Visualizza > Vedi impatto per eseguire un'analisi dell'impatto.

I link a causa e impatto mostrano le trasformazioni eseguite su entrambi i lati di un campo in un formato di registro leggibile. Queste informazioni possono essere essenziali per la reportistica e la governance.

Esegui la pulizia

Per evitare che al tuo account Google Cloud vengano addebitati costi relativi alle risorse utilizzate in questo tutorial, elimina il progetto che contiene le risorse oppure mantieni il progetto ed elimina le singole risorse.

Al termine del tutorial, esegui la pulizia delle risorse create suGoogle Cloud in modo che non occupino quota e non ti vengano addebitate in futuro. Le seguenti sezioni descrivono come eliminare o disattivare queste risorse.

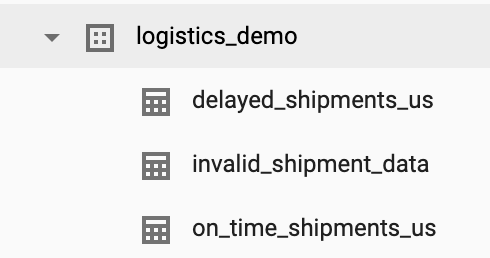

Elimina il set di dati del tutorial

Questo tutorial crea un set di dati logistics_demo con diverse tabelle nel tuo progetto.

Puoi eliminare il set di dati dall'UI web di BigQuery nella console Google Cloud .

Elimina l'istanza Cloud Data Fusion

Segui le istruzioni per eliminare l'istanza Cloud Data Fusion.

Elimina il progetto

Il modo più semplice per eliminare la fatturazione è eliminare il progetto creato per il tutorial.

Per eliminare il progetto:

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

Passaggi successivi

- Leggi le guide illustrative

- Completa un altro tutorial