Halaman ini menjelaskan cara mengaktifkan replikasi data secara real time dari aplikasi SAP ke Google Cloud menggunakan SAP Landscape Transformation (SLT). Konten ini berlaku untuk plugin SAP SLT Replication dan SAP SLT No RFC Replication, yang tersedia di Cloud Data Fusion Hub. Diagram ini menunjukkan konfigurasi untuk Sistem Sumber SAP, SLT, Cloud Storage, dan Cloud Data Fusion untuk melakukan hal berikut:

- Kirim metadata SAP dan data tabel ke Google Cloud menggunakan SAP SLT.

- Buat tugas replikasi Cloud Data Fusion yang membaca data dari bucket Cloud Storage.

Replikasi SAP SLT memungkinkan Anda mereplikasi data secara terus-menerus dan secara real time dari sumber SAP ke BigQuery. Anda dapat mengonfigurasi dan menjalankan transfer data dari sistem SAP tanpa coding apa pun.

Proses replikasi SLT Cloud Data Fusion adalah sebagai berikut:

- Data berasal dari Sistem Sumber SAP.

- SLT melacak dan membaca data, lalu mengirimkannya ke Cloud Storage.

- Cloud Data Fusion mengambil data dari bucket penyimpanan dan menulisnya ke BigQuery.

Anda dapat mentransfer data dari sistem SAP yang didukung, termasuk sistem SAP yang dihosting di Google Cloud.

Untuk informasi selengkapnya, lihat Ringkasan SAP di Google Cloud dan detail dukungan.

Sebelum memulai

Untuk menggunakan plugin ini, Anda memerlukan pengetahuan domain di bidang berikut:

- Membuat pipeline di Cloud Data Fusion

- Pengelolaan akses dengan IAM

- Mengonfigurasi SAP Cloud dan sistem enterprise resource planning (ERP) on-premise

Admin dan pengguna yang melakukan konfigurasi

Tugas di halaman ini dilakukan oleh orang dengan peran berikut di Google Cloud atau di sistem SAP mereka:

| Jenis pengguna | Deskripsi |

|---|---|

| Google Cloud Admin | Pengguna yang diberi peran ini adalah administrator akun Google Cloud. |

| Pengguna Cloud Data Fusion | Pengguna yang diberi peran ini diberi otorisasi untuk mendesain dan menjalankan pipeline data. Mereka diberi, minimal, peran Data Fusion Viewer

(

roles/datafusion.viewer). Jika menggunakan kontrol akses berbasis peran, Anda mungkin memerlukan peran tambahan.

|

| Admin SAP | Pengguna yang diberi peran ini adalah administrator sistem SAP. Mereka memiliki akses untuk mendownload software dari situs layanan SAP. Ini bukan peran IAM. |

| Pengguna SAP | Pengguna yang diberi peran ini diberi otorisasi untuk terhubung ke sistem SAP. Ini bukan peran IAM. |

Operasi replikasi yang didukung

Plugin Replikasi SAP SLT mendukung operasi berikut:

Pemodelan Data: Semua operasi pemodelan data (data insert, delete, dan

update) didukung oleh plugin ini.

Definisi Data: Seperti yang dijelaskan dalam SAP Note 2055599 (login dukungan SAP diperlukan untuk melihat), ada batasan terkait perubahan struktur tabel sistem sumber yang direplikasi oleh SLT secara otomatis. Beberapa operasi definisi data tidak didukung di plugin (Anda harus menyebarkannya secara manual).

- Didukung:

- Menambahkan kolom non-kunci (setelah melakukan perubahan di SE11, aktifkan tabel menggunakan SE14)

- Tidak didukung:

- Menambahkan/menghapus kolom kunci

- Menghapus kolom non-kunci

- Mengubah jenis data

Persyaratan SAP

Item berikut diperlukan di sistem SAP Anda:

- Anda telah menginstal Server SLT versi 2011 SP17 atau yang lebih baru di sistem SAP sumber (disematkan) atau sebagai sistem hub SLT khusus.

- Sistem SAP sumber Anda adalah SAP ECC atau SAP S/4HANA, yang mendukung DMIS 2011 SP17 atau yang lebih tinggi, seperti DMIS 2018, DMIS 2020.

- Add-on antarmuka pengguna SAP Anda harus kompatibel dengan versi SAP NetWeaver Anda.

Paket dukungan Anda mendukung class

/UI2/CL_JSONPL 12atau yang lebih baru. Jika tidak, terapkan SAP Note terbaru untuk class/UI2/CL_JSONcorrectionssesuai dengan versi add-on antarmuka pengguna Anda, seperti SAP Note 2798102 untukPL12.Keamanan berikut diterapkan:

Persyaratan Cloud Data Fusion

- Anda memerlukan instance Cloud Data Fusion, versi 6.4.0 atau yang lebih baru, edisi apa pun.

- Akun layanan yang ditetapkan ke instance Cloud Data Fusion akan diberikan peran yang diperlukan (lihat Memberikan izin pengguna akun layanan).

- Untuk instance Cloud Data Fusion pribadi, peering VPC diperlukan.

PersyaratanGoogle Cloud

- Aktifkan Cloud Storage API di project Google Cloud Anda.

- Pengguna Cloud Data Fusion harus diberi izin untuk membuat folder di bucket Cloud Storage (lihat Peran IAM untuk Cloud Storage).

- Opsional: Tetapkan kebijakan retensi, jika diperlukan oleh organisasi Anda.

Membuat bucket penyimpanan

Sebelum membuat tugas replikasi SLT, buat bucket Cloud Storage. Tugas ini mentransfer data ke bucket dan memuat ulang bucket staging setiap lima menit. Saat Anda menjalankan tugas, Cloud Data Fusion akan membaca data di bucket penyimpanan dan menulisnya ke BigQuery.

Jika SLT diinstal di Google Cloud

Server SLT harus memiliki izin untuk membuat dan mengubah objek Cloud Storage di bucket yang Anda buat.

Setidaknya, berikan peran berikut ke akun layanan:

- Service Account Token Creator (

roles/iam.serviceAccountTokenCreator) - Pelanggan Service Usage (

roles/serviceusage.serviceUsageConsumer) - Storage Object Admin (

roles/storage.objectAdmin)

Jika SLT tidak diinstal di Google Cloud

Instal Cloud VPN atau Cloud Interconnect antara VM SAP dan Google Cloud untuk mengizinkan koneksi ke endpoint metadata internal (lihat Mengonfigurasi Akses Google Pribadi untuk host lokal.

Jika metadata internal tidak dapat dipetakan:

Instal Google Cloud CLI berdasarkan sistem operasi infrastruktur tempat SLT berjalan.

Buat akun layanan di project Google Cloud tempat Cloud Storage diaktifkan.

Di sistem operasi SLT, izinkan akses ke Google Cloud dengan akun layanan.

Buat kunci API untuk akun layanan dan beri otorisasi pada cakupan terkait Cloud Storage.

Impor kunci API ke gcloud CLI yang diinstal sebelumnya menggunakan CLI.

Untuk mengaktifkan perintah gcloud CLI yang mencetak token akses, konfigurasikan Perintah Sistem Operasi SAP di alat SM69 transaksi di sistem SLT.

Mencetak token akses

Administrator SAP mengonfigurasi perintah sistem operasi, SM69, yang

mengambil token akses dari Google Cloud.

Buat skrip untuk mencetak token akses dan konfigurasikan perintah sistem operasi SAP untuk memanggil skrip sebagai pengguna <sid>adm dari host Server Replikasi SAP LT.

Linux

Untuk membuat perintah OS:

Di host Server Replikasi SAP LT, di direktori yang dapat diakses oleh

<sid>adm, buat skrip bash yang berisi baris berikut:PATH_TO_GCLOUD_CLI/bin/gcloud auth print-access-token SERVICE_ACCOUNT_NAMEDengan menggunakan antarmuka pengguna SAP, buat perintah OS eksternal:

- Masukkan transaksi

SM69. - Klik Create.

- Di bagian Command pada panel External Command, masukkan

nama perintah, seperti

ZGOOGLE_CDF_TOKEN. Di bagian Definition:

- Di kolom Operating System Command, masukkan

shsebagai ekstensi file skrip. Di kolom Parameters for Operating System Command, masukkan:

/PATH_TO_SCRIPT/FILE_NAME.sh

- Di kolom Operating System Command, masukkan

Klik Simpan.

Untuk menguji skrip, klik Execute.

Klik Execute lagi.

Token Google Cloud dikembalikan dan ditampilkan di bagian bawah panel antarmuka pengguna SAP.

- Masukkan transaksi

Windows

Dengan menggunakan antarmuka pengguna SAP, buat perintah sistem operasi eksternal:

- Masukkan transaksi

SM69. - Klik Create.

- Di bagian Command pada panel External Command, masukkan nama perintah, seperti

ZGOOGLE_CDF_TOKEN. Di bagian Definition:

- Di kolom Operating System Command, masukkan

cmd /c. Di kolom Parameters for Operating System Command, masukkan:

gcloud auth print-access-token SERVICE_ACCOUNT_NAME

- Di kolom Operating System Command, masukkan

Klik Simpan.

Untuk menguji skrip, klik Execute.

Klik Execute lagi.

Token Google Cloud ditampilkan dan ditampilkan di bagian bawah panel antarmuka pengguna SAP.

Persyaratan SLT

Konektor SLT harus memiliki penyiapan berikut:

- Konektor mendukung SAP ECC NW 7.02, DMIS 2011 SP17, dan yang lebih baru.

- Konfigurasikan koneksi RFC atau database antara SLT dan sistem Cloud Storage.

- Siapkan sertifikat SSL:

- Download sertifikat CA berikut dari

repositori Layanan Kepercayaan Google:

- GTS Root R1

- GTS CA 1C3

- Di antarmuka pengguna SAP, gunakan transaksi

STRUSTuntuk mengimpor root dan sertifikat subordinat ke dalam folderSSL Client (Standard) PSE.

- Download sertifikat CA berikut dari

repositori Layanan Kepercayaan Google:

- Internet Communication Manager (ICM) harus disiapkan untuk HTTPS. Pastikan

port HTTP dan HTTPS dikelola dan diaktifkan di sistem SAP SLT.

Hal ini dapat diperiksa melalui kode transaksi

SMICM > Services. - Aktifkan akses ke Google Cloud API di VM tempat sistem SAP SLT dihosting. Hal ini memungkinkan komunikasi pribadi antara layananGoogle Cloud tanpa melakukan perutean melalui internet publik.

- Pastikan jaringan dapat mendukung volume dan kecepatan transfer data yang diperlukan antara infrastruktur SAP dan Cloud Storage. Untuk penginstalan yang berhasil, Cloud VPN dan/atau Cloud Interconnect direkomendasikan. Throughput streaming API bergantung pada kuota klien yang telah diberikan ke project Cloud Storage Anda.

Mengonfigurasi Server Replikasi SLT

Pengguna SAP melakukan langkah-langkah berikut.

Pada langkah-langkah berikut, Anda akan menghubungkan server SLT ke sistem sumber dan bucket di Cloud Storage, dengan menentukan sistem sumber, tabel data yang akan direplikasi, dan bucket penyimpanan target.

Mengonfigurasi Google ABAP SDK

Untuk mengonfigurasi SLT guna replikasi data (satu kali per instance Cloud Data Fusion), ikuti langkah-langkah berikut:

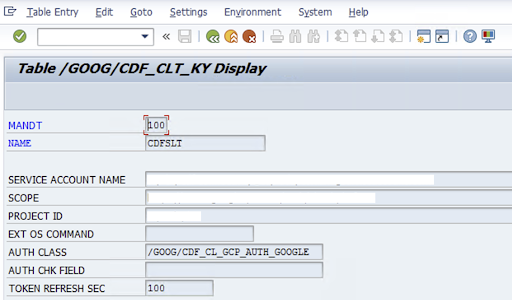

Untuk mengonfigurasi konektor SLT, SAP-User memasukkan informasi berikut di layar konfigurasi (

/GOOG/CDF_SETTINGSTransaksi SAP) tentang Google Cloud kunci akun layanan untuk mentransfer data ke Cloud Storage. Konfigurasikan properti berikut di tabel /GOOG/CDF_CLT_KY menggunakan Transaksi SE16 dan catat kunci ini:- NAME: Nama untuk kunci akun layanan Anda (misalnya,

CDFSLT) - SERVICE ACCOUNT NAME: Nama akun layanan IAM

- SCOPE: Cakupan akun layanan

- PROJECT ID: ID Google Cloud project Anda

- Opsional: Perintah OS EXT: Hanya gunakan kolom ini jika SLT tidak diinstal di Google Cloud

AUTH CLASS: Jika perintah OS disiapkan di tabel

/GOOG/CDF_CLT_KY, gunakan nilai tetap:/GOOG/CDF_CL_GCP_AUTH.TOKEN REFRESH SEC: Durasi untuk pembaruan token otorisasi

- NAME: Nama untuk kunci akun layanan Anda (misalnya,

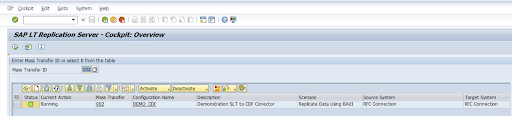

Buat konfigurasi replikasi

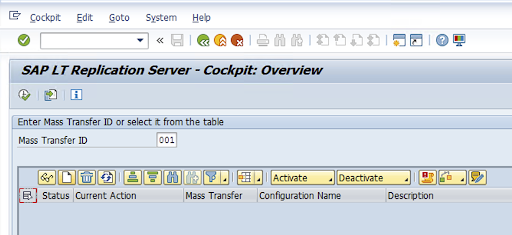

Buat konfigurasi Replikasi dalam kode transaksi: LTRC.

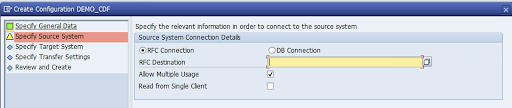

- Sebelum melanjutkan konfigurasi LTRC, pastikan koneksi RFC antara SLT dan sistem SAP Sumber telah dibuat.

- Untuk satu konfigurasi SLT, mungkin ada beberapa tabel SAP yang ditetapkan untuk replikasi.

Buka kode transaksi

LTRC, lalu klik Konfigurasi Baru.

Masukkan Configuration Name dan Description, lalu klik Next.

Tentukan Koneksi RFC sistem Sumber SAP, lalu klik Next.

Di Target System Connection Details, pilih Other.

Luaskan kolom Scenario for RFC Communication, pilih SLT SDK, lalu klik Next.

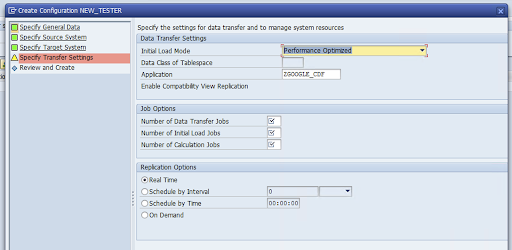

Buka jendela Specify Transfer Settings dan masukkan nama aplikasi:

ZGOOGLE_CDF.

Masukkan Number of Data Transfer Jobs, Number of Initial Load Jobs, dan Number of Calculation Jobs. Untuk mengetahui informasi selengkapnya tentang performa, lihat panduan pengoptimalan performa Server Replikasi SAP LT.

Klik Real Time > Next.

Tinjau konfigurasi, lalu klik Simpan. Perhatikan ID Mass Transfer untuk langkah-langkah berikut.

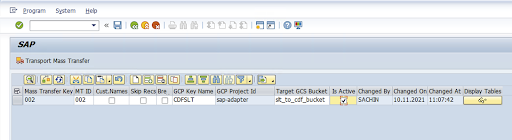

Untuk mempertahankan ID Transfer Massal dan detail tabel SAP, jalankan transaksi SAP:

/GOOG/CDF_SETTINGS.Klik Execute atau tekan

F8.Buat entri baru dengan mengklik ikon tambahkan baris.

Masukkan Mass Transfer ID, Mass Transfer Key, GCP Key Name, dan Target GCS Bucket. Centang kotak Is Active dan simpan perubahan.

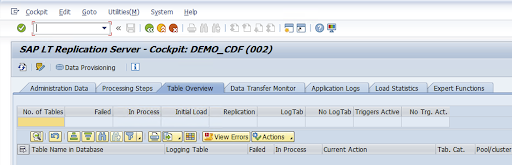

Pilih konfigurasi di kolom Nama Konfigurasi, lalu klik Penyediaan Data.

Opsional: Sesuaikan nama tabel dan kolom.

Klik Nama Kustom dan simpan.

Klik Tampilkan.

Buat entri baru dengan mengklik tombol Tambahkan baris atau Buat.

Masukkan nama tabel SAP dan nama tabel eksternal yang akan digunakan di BigQuery, lalu simpan perubahannya.

Klik tombol Lihat di kolom Kolom tampilan untuk mempertahankan pemetaan untuk kolom tabel.

Halaman akan terbuka dengan pemetaan yang disarankan. Opsional: Edit Nama Kolom sementara dan Deskripsi Kolom, lalu simpan pemetaan.

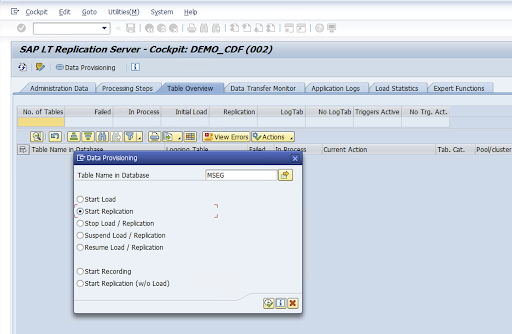

Buka transaksi LTRC.

Pilih nilai di kolom Nama Konfigurasi, lalu klik Penyediaan Data.

Masukkan nama tabel di kolom Table Name in Database dan pilih skenario replikasi.

Klik Jalankan. Tindakan ini akan memicu penerapan SLT SDK dan mulai mentransfer data ke bucket target di Cloud Storage.

Menginstal file transpor SAP

Untuk mendesain dan menjalankan tugas replikasi di Cloud Data Fusion, komponen SAP dikirim sebagai file transpor SAP yang diarsipkan dalam file zip. Download tersedia saat Anda men-deploy plugin di Cloud Data Fusion Hub.

Untuk menginstal transpor SAP, ikuti langkah-langkah berikut:

Langkah 1: Upload file permintaan transportasi

- Login ke sistem operasi Instance SAP.

- Gunakan kode transaksi SAP

AL11untuk mendapatkan jalur folderDIR_TRANS. Biasanya, jalurnya adalah/usr/sap/trans/. - Salin cofile ke folder

DIR_TRANS/cofiles. - Salin file data ke folder

DIR_TRANS/data. - Tetapkan Pengguna dan Grup data dan cofile ke

<sid>admdansapsys.

Langkah 2: Impor file permintaan transpor

Administrator SAP dapat mengimpor file permintaan transpor menggunakan sistem pengelolaan transpor SAP atau sistem operasi:

Sistem pengelolaan transportasi SAP

- Login ke sistem SAP sebagai administrator SAP.

- Masukkan STMS transaksi.

- Klik Ringkasan > Impor.

- Di kolom Antrean, klik dua kali SID saat ini.

- Klik Tambahan > Permintaan Lainnya > Tambahkan.

- Pilih ID permintaan transpor, lalu klik Lanjutkan.

- Pilih permintaan transpor di antrean impor, lalu klik Minta > Impor.

- Masukkan nomor Klien.

Di tab Options, pilih Overwrite Originals dan Ignore Invalid Component Version (jika tersedia).

Opsional: Untuk mengimpor ulang transpor nanti, klik Biarkan Permintaan Transpor dalam Antrean untuk Diimpor Nanti dan Impor Permintaan Transpor Lagi. Hal ini berguna untuk upgrade sistem SAP dan pemulihan cadangan.

Klik Lanjutkan.

Pastikan modul fungsi dan peran otorisasi berhasil diimpor menggunakan transaksi, seperti

SE80danPFCG.

Sistem operasi

- Login ke sistem SAP sebagai administrator SAP.

Tambahkan permintaan ke buffer impor:

tp addtobuffer TRANSPORT_REQUEST_ID SIDContoh:

tp addtobuffer IB1K903958 DD1Impor permintaan transpor:

tp import TRANSPORT_REQUEST_ID SID client=NNN U1238Ganti

NNNdengan nomor klien. Contoh:tp import IB1K903958 DD1 client=800 U1238Pastikan modul fungsi dan peran otorisasi berhasil diimpor menggunakan transaksi yang sesuai, seperti

SE80danPFCG.

Otorisasi SAP yang diperlukan

Untuk menjalankan pipeline data di Cloud Data Fusion, Anda memerlukan pengguna SAP. Pengguna SAP

harus berjenis Komunikasi atau Dialog. Untuk mencegah penggunaan resource dialog SAP, sebaiknya gunakan jenis Komunikasi. Pengguna dapat dibuat oleh Admin SAP menggunakan kode transaksi SAP SU01.

Otorisasi SAP diperlukan untuk mengelola dan mengonfigurasi konektor untuk SAP, kombinasi objek otorisasi konektor baru dan standar SAP. Anda memelihara objek otorisasi berdasarkan kebijakan keamanan organisasi. Daftar berikut menjelaskan beberapa otorisasi penting yang diperlukan untuk konektor:

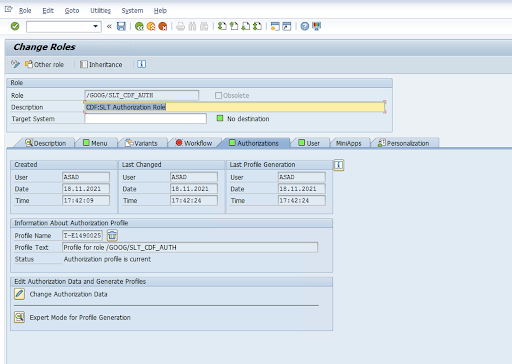

Objek Otorisasi: Objek Otorisasi

ZGOOGCDFMTdikirim sebagai bagian dari Peran Permintaan Transportasi.Pembuatan Peran: Buat Peran menggunakan kode transaksi

PFCG.

Untuk Objek Otorisasi SAP standar, organisasi Anda mengelola izin dengan mekanisme keamanannya sendiri.

Untuk Objek Otorisasi Kustom, berikan nilai di kolom otorisasi untuk objek otorisasi

ZGOOGCDFMT.Untuk kontrol akses terperinci,

ZGOOGCDFMTmenyediakan otorisasi berbasis grup otorisasi. Pengguna dengan akses lengkap, sebagian, atau tidak ada akses ke grup otorisasi akan diberi akses berdasarkan grup otorisasi yang ditetapkan dalam perannya./GOOG/SLT_CDF_AUTH: Peran dengan akses ke semua Grup Otorisasi. Untuk membatasi akses khusus untuk Grup Otorisasi tertentu, pertahankan Authorization Group FICDF dalam konfigurasi.

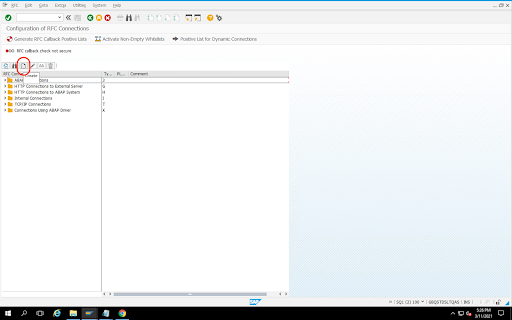

Membuat Tujuan RFC untuk sumber

Sebelum memulai konfigurasi, pastikan koneksi RFC dibuat antara sumber dan tujuan.

Buka kode transaksi

SM59.Klik Create > Connection Type 3 (ABAP Connection).

Di jendela Technical Settings, masukkan detail tentang Tujuan RFC.

Klik tab Logon and Security untuk mengelola kredensial RFC (pengguna dan sandi RFC).

Klik Simpan.

Klik Uji Koneksi. Setelah pengujian berhasil, Anda dapat melanjutkan.

Pastikan Pengujian Otorisasi RFC berhasil.

Klik Utilities > Test > Authorization Test.

Mengonfigurasi plugin

Untuk mengonfigurasi plugin, deploy dari Hub, buat tugas replikasi, dan konfigurasikan sumber dan target dengan langkah-langkah berikut.

Men-deploy plugin di Cloud Data Fusion

Pengguna Cloud Data Fusion melakukan langkah-langkah berikut.

Sebelum Anda dapat menjalankan tugas replikasi Cloud Data Fusion, deploy plugin Replikasi SAP SLT:

Buka instance Anda:

Di konsol Google Cloud , buka halaman Instance Cloud Data Fusion.

Aktifkan Replikasi di instance baru atau yang sudah ada:

- Untuk instance baru, klik Create instance, masukkan nama instance, klik Add accelerators, centang kotak Replication, lalu klik Save.

- Untuk instance yang ada, lihat Mengaktifkan Replikasi pada instance yang ada.

Klik Lihat instance untuk membuka instance di antarmuka web Cloud Data Fusion.

Klik Hub.

Buka tab SAP, klik SAP SLT, lalu klik Plugin Replikasi SAP SLT atau Plugin Replikasi SAP SLT Tanpa RFC.

Klik Deploy.

Membuat tugas replikasi

Plugin Replikasi SAP SLT membaca konten tabel SAP menggunakan bucket staging Cloud Storage API.

Untuk membuat tugas replikasi untuk transfer data, ikuti langkah-langkah berikut:

Di instance Cloud Data Fusion yang terbuka, klik Beranda > Replikasi > Buat tugas replikasi. Jika tidak ada opsi Replikasi, aktifkan replikasi untuk instance.

Masukkan Nama dan Deskripsi unik untuk tugas replikasi.

Klik Berikutnya.

Mengonfigurasi sumber

Konfigurasikan sumber dengan memasukkan nilai di kolom berikut:

- Project ID: ID project Google Cloud Anda (kolom ini diisi secara otomatis)

Jalur GCS Replikasi Data: Jalur Cloud Storage yang berisi data untuk replikasi. Jalur ini harus sama dengan jalur yang dikonfigurasi dalam tugas SAP SLT. Secara internal, jalur yang disediakan digabungkan dengan

Mass Transfer IDdanSource Table Name:Format:

gs://<base-path>/<mass-transfer-id>/<source-table-name>Contoh:

gs://slt_bucket/012/MARAGUID: GUID SLT—ID unik yang ditetapkan ke ID Transfer Massal SAP SLT.

Mass Transfer ID: Mass Transfer ID SLT adalah ID unik yang ditetapkan ke konfigurasi di SAP SLT.

Jalur GCS Library JCo SAP: Jalur penyimpanan yang berisi file library JCo SAP yang diupload pengguna. Library JCo SAP dapat didownload dari Portal Dukungan SAP. (Dihapus di versi plugin 0.10.0.)

Host Server SLT: Nama host atau alamat IP Server SLT. (Dihapus di versi plugin 0.10.0.)

Nomor Sistem SAP: Nomor sistem penginstalan yang diberikan oleh administrator sistem (misalnya,

00). (Dihapus di plugin versi 0.10.0.)Klien SAP: Klien SAP yang akan digunakan (misalnya,

100). (Dihapus di plugin versi 0.10.0.)Bahasa SAP: Bahasa login SAP (misalnya,

EN). (Dihapus di plugin versi 0.10.0.)Nama Pengguna Login SAP: Nama pengguna SAP. (Dihapus di plugin versi 0.10.0.)

- Direkomendasikan: Jika Nama Pengguna Login SAP berubah secara berkala, gunakan makro.

SAP Logon Password (M): Sandi Pengguna SAP untuk autentikasi pengguna.

- Direkomendasikan: Gunakan makro aman untuk nilai sensitif, seperti sandi. (Dihapus di plugin versi 0.10.0.)

Menangguhkan replikasi SLT saat tugas CDF berhenti: Mencoba menghentikan tugas replikasi SLT (untuk tabel yang terlibat) saat tugas replikasi Cloud Data Fusion berhenti. Mungkin gagal jika tugas di Cloud Data Fusion berhenti secara tiba-tiba.

Replikasi Data yang Ada: Menunjukkan apakah akan mereplikasi data yang ada dari tabel sumber. Secara default, tugas mereplikasi data yang ada dari tabel sumber. Jika ditetapkan ke

false, data apa pun yang ada di tabel sumber akan diabaikan dan hanya perubahan yang terjadi setelah tugas dimulai yang direplikasi.Kunci Akun Layanan: Kunci yang akan digunakan saat berinteraksi dengan Cloud Storage. Akun layanan harus memiliki izin untuk menulis ke Cloud Storage. Saat berjalan di VM Google Cloud , nilai ini harus ditetapkan ke

auto-detectuntuk menggunakan akun layanan yang terpasang ke VM.

Klik Berikutnya.

Mengonfigurasi target

Untuk menulis data ke BigQuery, plugin memerlukan akses tulis ke BigQuery dan bucket staging. Peristiwa perubahan pertama kali ditulis dalam batch dari SLT ke Cloud Storage. Data tersebut kemudian dimuat ke tabel staging di BigQuery. Perubahan dari tabel staging digabungkan ke dalam tabel target akhir menggunakan kueri penggabungan BigQuery.

Tabel target akhir menyertakan semua kolom asli dari tabel sumber

ditambah satu kolom _sequence_num tambahan. Nomor urutan memastikan bahwa

data tidak diduplikasi atau terlewat dalam skenario kegagalan replikator.

Konfigurasikan sumber dengan memasukkan nilai di kolom berikut:

- Project ID: Project set data BigQuery. Saat berjalan di cluster Dataproc, kolom ini dapat dibiarkan kosong, yang akan menggunakan project cluster.

- Kredensial: Lihat Kredensial.

- Kunci Akun Layanan: Konten kunci akun layanan yang akan digunakan saat berinteraksi dengan Cloud Storage dan BigQuery. Saat berjalan di cluster Dataproc, kolom ini harus dibiarkan kosong, yang menggunakan akun layanan cluster.

- Nama Set Data: Nama set data yang akan dibuat di BigQuery. Ini bersifat opsional dan, secara default, nama set data sama dengan nama database sumber. Nama yang valid hanya boleh berisi huruf, angka, dan garis bawah, serta panjang maksimumnya dapat mencapai 1.024 karakter. Setiap karakter yang tidak valid akan diganti dengan garis bawah dalam nama set data akhir dan karakter apa pun yang melebihi batas panjang akan terpotong.

- Nama Kunci Enkripsi: kunci enkripsi yang dikelola pelanggan (CMEK) yang digunakan untuk mengamankan resource yang dibuat oleh target ini. Nama kunci enkripsi harus dalam format

projects/<project-id>/locations/<key-location>/keyRings/<key-ring-name>/cryptoKeys/<key-name>. - Lokasi: Lokasi tempat set data BigQuery dan bucket staging Cloud Storage dibuat. Misalnya,

us-east1untuk bucket regional,usuntuk bucket multi-regional (lihat Lokasi). Nilai ini diabaikan jika bucket yang ada ditentukan, karena bucket staging dan set data BigQuery dibuat di lokasi yang sama dengan bucket tersebut. Bucket Staging: Bucket tempat peristiwa perubahan ditulis sebelum dimuat ke tabel staging. Perubahan ditulis ke direktori yang berisi nama dan namespace replikator. Anda dapat menggunakan bucket yang sama di beberapa replikator dalam instance yang sama dengan aman. Jika dibagikan oleh replikator di beberapa instance, pastikan namespace dan namanya unik. Jika tidak, perilakunya tidak ditentukan. Bucket harus berada di lokasi yang sama dengan set data BigQuery. Jika tidak diberikan, bucket baru akan dibuat untuk setiap tugas yang diberi nama

df-rbq-<namespace-name>-<job-name>-<deployment-timestamp>.Interval Pemuatan (detik): Jumlah detik yang harus ditunggu sebelum memuat batch data ke BigQuery.

Awalan Tabel Staging: Perubahan pertama kali ditulis ke tabel staging sebelum digabungkan ke tabel akhir. Nama tabel staging dibuat dengan menambahkan awalan ini ke nama tabel target.

Require Manual Drop Intervention: Apakah akan mewajibkan tindakan administrative manual untuk menghapus tabel dan set data saat peristiwa drop table atau drop database terjadi. Jika disetel ke true, replikator tidak akan menghapus tabel atau set data. Sebagai gantinya, operasi ini akan gagal dan mencoba lagi hingga tabel atau set data tidak ada. Jika set data atau tabel tidak ada, tidak diperlukan intervensi manual. Peristiwa akan dilewati seperti biasa.

Enable Soft Deletes: Jika disetel ke true, saat peristiwa penghapusan diterima oleh target, kolom

_is_deleteduntuk data akan ditetapkan ketrue. Jika tidak, data akan dihapus dari tabel BigQuery. Konfigurasi ini tidak berfungsi untuk sumber yang menghasilkan peristiwa secara tidak berurutan dan kumpulan data selalu dihapus secara soft dari tabel BigQuery.

Klik Berikutnya.

Kredensial

Jika plugin dijalankan di cluster Dataproc, kunci akun layanan harus ditetapkan ke deteksi otomatis. Kredensial otomatis dibaca dari lingkungan cluster.

Jika plugin tidak dijalankan di cluster Dataproc, jalur ke kunci akun layanan harus disediakan. Kunci akun layanan dapat ditemukan di halaman IAM di Google Cloud console. Pastikan kunci akun memiliki izin untuk mengakses BigQuery. File kunci akun layanan harus tersedia di setiap node dalam cluster Anda dan harus dapat dibaca oleh semua pengguna yang menjalankan tugas.

Batasan

- Tabel harus memiliki kunci utama agar dapat direplikasi.

- Operasi penggantian nama tabel tidak didukung.

- Perubahan tabel didukung sebagian.

- Kolom non-nullable yang ada dapat diubah menjadi kolom nullable.

- Kolom nullable baru dapat ditambahkan ke tabel yang ada.

- Jenis perubahan lain pada skema tabel akan gagal.

- Perubahan pada kunci utama tidak akan gagal, tetapi data yang ada tidak ditulis ulang untuk mematuhi keunikan pada kunci utama baru.

Memilih tabel dan transformasi

Pada langkah Select tables and transformations, daftar tabel yang dipilih untuk replika di sistem SLT akan muncul.

- Pilih tabel yang akan direplikasi.

- Opsional: Pilih operasi skema tambahan, seperti Inserts, Updates, atau Deletes.

- Untuk melihat skema, klik Kolom yang akan direplikasi untuk tabel.

Opsional: Untuk mengganti nama kolom dalam skema, ikuti langkah-langkah berikut:

- Saat melihat skema, klik Transform > Rename.

- Di kolom Rename, masukkan nama baru, lalu klik Apply.

- Untuk menyimpan nama baru, klik Refresh dan Save.

Klik Berikutnya.

Opsional: Mengonfigurasi properti lanjutan

Jika mengetahui jumlah data yang direplikasi dalam satu jam, Anda dapat memilih opsi yang sesuai.

Tinjau penilaian

Langkah Tinjau penilaian memindai masalah skema, fitur yang tidak ada, atau masalah konektivitas yang terjadi selama replikasi.

Di halaman Tinjau penilaian, klik Lihat pemetaan.

Jika ada masalah, masalah tersebut harus diselesaikan sebelum Anda dapat melanjutkan.

Opsional: Jika Anda mengganti nama kolom saat memilih tabel dan transformasi, pastikan nama baru sudah benar pada langkah ini.

Klik Berikutnya.

Melihat ringkasan dan men-deploy tugas replikasi

Di halaman Tinjau detail tugas replikasi, tinjau setelan dan klik Deploy replication job.

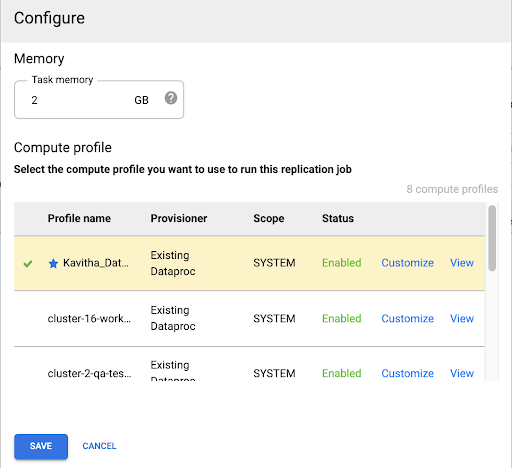

Memilih profil Compute Engine

Setelah men-deploy tugas replikasi, klik Configure dari halaman mana pun di antarmuka web Cloud Data Fusion.

Pilih profil Compute Engine yang ingin Anda gunakan untuk menjalankan tugas replikasi ini.

Klik Simpan.

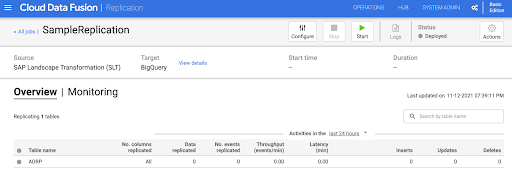

Memulai tugas replikasi

- Untuk menjalankan tugas replikasi, klik Mulai.

Opsional: Mengoptimalkan performa

Secara default, plugin dikonfigurasi untuk performa yang optimal. Untuk pengoptimalan tambahan, lihat Argumen runtime.

Performa komunikasi SLT dan Cloud Data Fusion bergantung pada faktor berikut:

- SLT di sistem sumber versus sistem SLT pusat khusus (opsi yang lebih disukai)

- Pemrosesan tugas latar belakang di sistem SLT

- Proses tugas dialog di sistem SAP sumber

- Jumlah proses tugas latar belakang yang dialokasikan ke setiap ID Transfer Massal di tab Administrasi LTRC

- Setelan LTRS

- Hardware (CPU dan memori) sistem SLT

- Database yang digunakan (misalnya: HANA, Sybase, atau DB2)

- Bandwidth internet (konektivitas antara sistem SAP dan Google Cloud melalui internet)

- Pemakaian (beban) yang sudah ada di sistem

- Jumlah kolom dalam tabel. Dengan lebih banyak kolom, replika menjadi lambat dan latensi dapat meningkat.

Jenis baca berikut di setelan LTRS direkomendasikan untuk pemuatan awal:

| Sistem SLT | Sistem Sumber | Jenis tabel | Jenis baca yang direkomendasikan [beban awal] |

|---|---|---|---|

| SLT 3.0 mandiri [DMIS 2018_1_752 SP 2] |

S/4 HANA 1909 | Transparan (kecil/sedang) Transparan (besar) Tabel cluster |

1 penghitungan rentang 1 penghitungan rentang 4 antrean pengirim |

| SLT tersemat [S4CORE 104 HANA 1909] |

T/A | Transparan (kecil/sedang) Transparan (besar) Tabel cluster |

1 penghitungan rentang 1 penghitungan rentang 4 antrean pengirim |

| SLT 2.0 mandiri [DMIS 2011_1_731 SP 17] |

ECC NW 7.02 | Transparan (kecil/sedang) Transparan (besar) Tabel cluster |

5 sender queue 5 sender queue 4 sender Queue |

| SLT tersemat [DMIS 2011_1_700 SP 17] |

T/A | Transparan (kecil/sedang) Transparan (besar) Tabel cluster |

5 antrean pengirim 5 antrean pengirim 4 antrean pengirim |

- Untuk replikasi, gunakan Tidak Ada Rentang untuk meningkatkan performa:

- Rentang hanya boleh digunakan jika backlog dibuat dalam tabel logging dengan latensi tinggi.

- Menggunakan satu penghitungan rentang: Jenis baca untuk pemuatan awal tidak direkomendasikan dalam hal sistem SLT 2.0 dan Non-HANA.

- Menggunakan satu penghitungan rentang: Jenis baca untuk pemuatan awal dapat menyebabkan data duplikat di BigQuery.

- Performa selalu lebih baik jika sistem SLT mandiri digunakan.

- Sistem SLT mandiri selalu direkomendasikan jika penggunaan resource sistem sumber sudah tinggi.

Argumen runtime

snapshot.thread.count: Meneruskan jumlah thread untuk mulai melakukan pemuatan dataSNAPSHOT/INITIALsecara paralel. Secara default, tugas ini menggunakan jumlah vCPU yang tersedia di cluster Dataproc tempat tugas replikasi berjalan.Direkomendasikan: hanya tetapkan parameter ini jika Anda memerlukan kontrol yang tepat atas jumlah thread paralel (misalnya, untuk mengurangi penggunaan di cluster).

poll.file.count: Meneruskan jumlah file yang akan di-polling dari jalur Cloud Storage yang disediakan di kolom Data Replication GCS Path di antarmuka web. Secara default, nilainya adalah500per polling, tetapi berdasarkan konfigurasi cluster, nilai ini dapat ditingkatkan atau diturunkan.Direkomendasikan: Hanya tetapkan parameter ini jika Anda memiliki persyaratan ketat untuk penundaan replikasi. Nilai yang lebih rendah dapat mengurangi penundaan. Anda dapat menggunakannya untuk meningkatkan throughput (jika tidak responsif, gunakan nilai yang lebih tinggi dari default).

bad.files.base.path: Meneruskan jalur Cloud Storage dasar tempat semua file data error atau rusak disalin yang ditemukan selama replikasi. Hal ini berguna jika ada persyaratan ketat untuk audit data dan lokasi tertentu harus digunakan untuk mencatat transfer yang gagal.Secara default, semua file yang rusak disalin dari jalur Cloud Storage yang diberikan di kolom Jalur Cloud Storage Replikasi Data di antarmuka web.

Pola jalur akhir file data yang salah:

gs://BASE_FILE_PATH/MASS_TRANSFER_ID/SOURCE_TABLE_NAME/bad_files/REPLICATION_JOB_NAME/REPLICATION_JOB_ID/BAD_FILE_NAME

Contoh:

gs://slt_to_cdf_bucket/001/MARA/bad_files/MaraRepl/05f97349-7398-11ec-9443-8 ac0640fc83c/20220205_1901205168830_DATA_INIT.xml

Kriteria untuk file yang buruk adalah file XML yang rusak atau tidak valid, nilai PK yang hilang, atau masalah ketidakcocokan jenis data Kolom.

Detail dukungan

Produk dan versi SAP yang didukung

- Rilis SAP_BASIS 702, SP-Level 0016 dan yang lebih baru.

- Rilis SAP_ABA 702, SP-Level 0016 dan yang lebih baru.

- Rilis DMIS 2011_1_700, SP-Level 0017 dan yang lebih baru.

Versi SLT yang didukung

SLT versi 2 dan 3 didukung.

Model deployment SAP yang didukung

SLT sebagai sistem mandiri atau disematkan di sistem sumber.

Catatan SAP yang perlu diterapkan sebelum Anda mulai menggunakan SLT

Jika Paket Dukungan Anda tidak menyertakan koreksi class /UI2/CL_JSON untuk PL

12 atau yang lebih baru, terapkan Catatan SAP terbaru untuk koreksi class /UI2/CL_JSON,

misalnya, Catatan SAP 2798102 untuk PL12.

Direkomendasikan: Terapkan Catatan SAP yang direkomendasikan oleh laporan

CNV_NOTE_ANALYZER_SLT berdasarkan kondisi sistem Pusat atau Sumber. Untuk

mengetahui informasi selengkapnya, lihat

Catatan SAP 3016862

(login SAP diperlukan).

Jika SAP sudah disiapkan, tidak ada catatan tambahan yang harus diterapkan. Untuk error atau masalah tertentu, lihat Catatan SAP pusat untuk rilis SLT Anda.

Batas untuk volume data atau lebar data

Tidak ada batasan yang ditentukan untuk volume data yang diekstrak dan lebar data.

Throughput yang diharapkan untuk plugin Replikasi SAP SLT

Untuk lingkungan yang dikonfigurasi sesuai dengan panduan di Mengoptimalkan performa, plugin dapat mengekstrak sekitar 13 GB per jam untuk Pemuatan Awal dan 3 GB per jam untuk Replikasi (CDC). Performa sebenarnya dapat bervariasi dengan beban sistem Cloud Data Fusion dan SAP atau traffic jaringan.

Dukungan untuk ekstraksi delta SAP (data yang diubah)

Ekstraksi delta SAP didukung.

Wajib: Peering tenant untuk instance Cloud Data Fusion

Penautan tenant diperlukan saat instance Cloud Data Fusion dibuat dengan alamat IP internal. Untuk mengetahui informasi selengkapnya tentang peering tenant, lihat Membuat instance pribadi.

Memecahkan masalah

Tugas replikasi terus dimulai ulang

Jika tugas replikasi terus dimulai ulang secara otomatis, tingkatkan memori cluster tugas replikasi dan jalankan ulang tugas replikasi.

Data duplikat di sink BigQuery

Jika Anda menentukan jumlah tugas paralel di setelan lanjutan plugin Replikasi SAP SLT, saat tabel Anda berukuran besar, error akan terjadi yang menyebabkan kolom duplikat di sink BigQuery.

Untuk mencegah masalah ini, hapus tugas paralel untuk memuat data.

Skenario error

Tabel berikut mencantumkan beberapa pesan error umum (teks dalam tanda kutip akan diganti dengan nilai yang sebenarnya saat runtime):

| ID Pesan | Pesan | Tindakan yang disarankan |

|---|---|---|

CDF_SAP_SLT_01402 |

Service account type is not defined for

SERVICE_ACCT_NAME_FROM_UI. |

Pastikan jalur Cloud Storage yang diberikan sudah benar. |

CDF_SAP_SLT_01403 |

Service account key provided is not valid due to error:

ROOT_CAUSE. Please provide a valid service account key for

service account type : SERVICE_ACCT_NAME_FROM_UI. |

Periksa penyebab utama yang ditampilkan dalam pesan dan ambil tindakan yang sesuai. |

CDF_SAP_SLT_01404 |

Mass Transfer ID could not be found. Please ensure that it exists

in given GCS Bucket. |

Pastikan ID Transfer Massal yang diberikan dalam format yang benar. |

CDF_SAP_SLT_01502 |

The specified data replication GCS path 'slt_to_cdf_bucket_1' or

Mass Transfer ID '05C' could not be found. Please ensure that it exists in

GCS. |

Pastikan jalur Cloud Storage yang diberikan sudah benar. |

CDF_SAP_SLT_01400 |

Metadata file not found. The META_INIT.json file is not present or

file is present with invalid format. |

Periksa penyebab utama yang ditampilkan dalam pesan dan ambil tindakan yang sesuai. |

CDF_SAP_SLT_03408 |

Failed to start the event reader. |

Periksa penyebab utama yang ditampilkan dalam pesan dan ambil tindakan yang sesuai. |

CDF_SAP_SLT_03409 |

Error while processing TABLE_NAME file for source table

gs://CLOUD_STORAGE_BUCKET_NAME/MT_ID/TABLE_NAME

/FILE_NAME. Root cause: ROOT_CAUSE. |

Periksa penyebab utama yang ditampilkan dalam pesan dan ambil tindakan yang sesuai. |

CDF_SAP_SLT_03410 |

Failed to replicate data for source table TABLE_NAME

from file: gs://CLOUD_STORAGE_BUCKET_NAME/MT_ID/

TABLE_NAME/FILE_NAME. Root cause:

ROOT_CAUSE. |

Periksa penyebab utama yang ditampilkan dalam pesan dan ambil tindakan yang sesuai. |

CDF_SAP_SLT_03411 |

Failed data replication for source table TABLE_NAME.

Root cause: ROOT_CAUSE. |

Periksa penyebab utama yang ditampilkan dalam pesan dan ambil tindakan yang sesuai. |

CDF_SAP_SLT_03412 |

Failed to create target table for source table

TABLE_NAME. Root cause: ROOT_CAUSE. |

Periksa penyebab utama yang ditampilkan dalam pesan dan ambil tindakan yang sesuai. |

Pemetaan jenis data

Tabel berikut menunjukkan pemetaan antara jenis data yang digunakan dalam aplikasi SAP dan Cloud Data Fusion.

| Jenis data SAP | Jenis ABAP | Deskripsi (SAP) | Jenis data Cloud Data Fusion |

|---|---|---|---|

| Angka | |||

| INT1 | b | Bilangan bulat 1 byte | int |

| INT2 | s | Bilangan bulat 2 byte | int |

| INT4 | i | Bilangan bulat 4 byte | int |

| INT8 | 8 | Bilangan bulat 8 byte | long |

| DES | p | Angka yang dipaketkan dalam format BCD (DEC) | decimal |

| DF16_DEC DF16_RAW |

a | Floating point desimal 8 byte IEEE 754r | decimal |

| DF34_DEC DF34_RAW |

e | Floating point desimal 16 byte IEEE 754r | decimal |

| FLTP | f | Bilangan floating point biner | double |

| Karakter | |||

| CHAR LCHR |

c | String karakter | string |

| SSTRING GEOM_EWKB |

string | String karakter | string |

| STRING GEOM_EWKB |

string | CLOB string karakter | bytes |

| NUMC ACCP |

n | Teks numerik | string |

| Byte | |||

| RAW LRAW |

x | Data biner | bytes |

| RAWSTRING | xstring | BLOB string byte | bytes |

| Date/Time | |||

| DATS | d | Tanggal | date |

| Tim | t | Waktu | time |

| TIMESTAMP | utcl | ( Utclong ) TimeStamp |

timestamp |

Langkah berikutnya

- Pelajari Cloud Data Fusion lebih lanjut.

- Pelajari lebih lanjut SAP di Google Cloud.