Questa guida descrive come eseguire il deployment, configurare ed eseguire pipeline di dati che utilizzano il plug-in SAP OData.

Puoi utilizzare SAP come origine per l'estrazione di dati basata su batch in Cloud Data Fusion utilizzando il protocollo Open Data (OData). Il plug-in SAP OData consente di configurare ed eseguire trasferimenti di dati da SAP OData Catalog Services senza alcuna programmazione.

Per ulteriori informazioni sui servizi di cataloghi e sulle DataSource SAP OData supportati, consulta i dettagli dell'assistenza. Per ulteriori informazioni su SAP su Google Cloud, consulta la panoramica di SAP su Google Cloud.

Obiettivi

- Configura il sistema SAP ERP (attiva le origini dati in SAP).

- Esegui il deployment del plug-in nell'ambiente Cloud Data Fusion.

- Scarica il trasporto SAP da Cloud Data Fusion e installalo in SAP.

- Utilizza Cloud Data Fusion e SAP OData per creare pipeline di dati per l'integrazione dei dati SAP.

Prima di iniziare

Per utilizzare questo plug-in, devi avere conoscenze di dominio nelle seguenti aree:

- Creazione di pipeline in Cloud Data Fusion

- Gestione dell'accesso con IAM

- Configurazione di sistemi ERP (Enterprise Resource Planning) on-premise e SAP Cloud

Ruoli utente

Le attività in questa pagina vengono eseguite da persone con i seguenti ruoli in Google Cloud o nel sistema SAP:

| Tipo di utente | Descrizione |

|---|---|

| Amministratore Google Cloud | Gli utenti a cui è assegnato questo ruolo sono amministratori degli account Google Cloud. |

| Utente Cloud Data Fusion | Gli utenti a cui è assegnato questo ruolo sono autorizzati a progettare ed eseguire

pipeline di dati. Devono disporre almeno del ruolo Visualizzatore Data Fusion

(

roles/datafusion.viewer). Se utilizzi

il controllo degli accessi basato sui ruoli, potresti avere bisogno di

altri

ruoli.

|

| Amministratore SAP | Gli utenti a cui è assegnato questo ruolo sono amministratori del sistema SAP. Hanno accesso per scaricare il software dal sito del servizio SAP. Non è un ruolo IAM. |

| Utente SAP | Gli utenti a cui è assegnato questo ruolo sono autorizzati a connettersi a un sistema SAP. Non è un ruolo IAM. |

Prerequisiti per l'estrazione di OData

Il servizio OData Catalog deve essere attivato nel sistema SAP.

I dati devono essere inseriti nel servizio OData.

Prerequisiti per il sistema SAP

In SAP NetWeaver 7.02 e nelle release successive fino a SAP NetWeaver 7.31, le funzionalità OData e SAP Gateway vengono fornite con i seguenti componenti software SAP:

IW_FNDGW_COREIW_BEP

Nella release 7.40 e successive di SAP NetWeaver, tutte le funzionalità sono disponibili nel componente

SAP_GWFND, che deve essere reso disponibile in SAP NetWeaver.

(Facoltativo) Installa i file di trasporto SAP

I componenti SAP necessari per il bilanciamento del carico delle chiamate a SAP vengono forniti come file di trasporto SAP archiviati come file ZIP (una richiesta di trasporto composta da un file co e un file di dati). Puoi utilizzare questo passaggio per limitare più chiamate parallele a SAP, in base ai processi di lavoro disponibili in SAP.

Il download del file ZIP è disponibile quando esegui il deployment del plug-in in Cloud Data Fusion Hub.

Quando importi i file di trasporto in SAP, vengono creati i seguenti progetti SAP OData:

Progetti OData

/GOOG/GET_STATISTIC/GOOG/TH_WPINFO

Nodo di servizio ICF:

GOOG

Per installare il trasporto SAP:

Passaggio 1: carica i file delle richieste di trasporto

- Accedi al sistema operativo dell'istanza SAP.

- Utilizza il codice transazione SAP

AL11per ottenere il percorso della cartellaDIR_TRANS. In genere, il percorso è/usr/sap/trans/. - Copia i file co nella cartella

DIR_TRANS/cofiles. - Copia i file di dati nella

cartella

DIR_TRANS/data. - Imposta l'utente e il gruppo di dati e del cofile su

<sid>admesapsys.

Passaggio 2: importa i file delle richieste di trasporto

L'amministratore SAP può importare i file di richiesta di trasporto utilizzando una delle seguenti opzioni:

Opzione 1: importa i file di richiesta di trasporto utilizzando il sistema di gestione dei trasporti SAP

- Accedi al sistema SAP come amministratore SAP.

- Inserisci l'STMS della transazione.

- Fai clic su Panoramica > Importazioni.

- Nella colonna Coda, fai doppio clic sull'ID cliente corrente.

- Fai clic su Extra > Altre richieste > Aggiungi.

- Seleziona l'ID richiesta di trasporto e fai clic su Continua.

- Seleziona la richiesta di trasporto nella coda di importazione, poi fai clic su Richiesta > Importa.

- Inserisci il numero cliente.

Nella scheda Opzioni, seleziona Sovrascrive gli originali e Ignora la versione del componente non valida (se disponibile).

(Facoltativo) Per pianificare una reimportazione dei trasporti in un secondo momento, seleziona Lascia le richieste di trasporto in coda per l'importazione successiva e Importa nuovamente le richieste di trasporto. Questa operazione è utile per gli upgrade dei sistemi SAP e per i ripristini dei backup.

Fai clic su Continua.

Per verificare l'importazione, utilizza qualsiasi transazione, ad esempio

SE80eSU01.

Opzione 2: importa i file di richiesta di trasporto a livello di sistema operativo

- Accedi al sistema SAP come amministratore di sistema SAP.

Aggiungi le richieste appropriate al buffer di importazione eseguendo il seguente comando:

tp addtobuffer TRANSPORT_REQUEST_ID SIDAd esempio:

tp addtobuffer IB1K903958 DD1Importa le richieste di trasporto eseguendo il seguente comando:

tp import TRANSPORT_REQUEST_ID SID client=NNN U1238Sostituisci

NNNcon il numero del cliente. Ad esempio:tp import IB1K903958 DD1 client=800 U1238Verifica che il modulo della funzione e i ruoli di autorizzazione siano stati importati correttamente utilizzando le transazioni appropriate, ad esempio

SE80eSU01.

Visualizzare un elenco di colonne filtrabili per un servizio di catalogo SAP

Solo alcune colonne DataSource possono essere utilizzate per le condizioni di filtro (si tratta di una limitazione di SAP per progettazione).

Per ottenere un elenco di colonne filtrabili per un servizio di catalogo SAP, segui questi passaggi:

- Accedi al sistema SAP.

- Vai al codice T

SEGW. Inserisci il nome del progetto OData, che è una sottostringa del nome del servizio. Ad esempio:

- Nome servizio:

MM_PUR_POITEMS_MONI_SRV - Nome progetto:

MM_PUR_POITEMS_MONI

- Nome servizio:

Fai clic su Invio.

Vai all'entità che vuoi filtrare e seleziona Proprietà.

Puoi utilizzare i campi mostrati in Proprietà come filtri. Le operazioni supportate sono È uguale a e Tra (intervallo).

Per un elenco degli operatori supportati nel linguaggio delle espressioni, consulta la documentazione open source di OData: Convenzioni URI (versione 2.0 di OData).

URI di esempio con filtri:

/sap/opu/odata/sap/MM_PUR_POITEMS_MONI_SRV/C_PurchaseOrderItemMoni(P_DisplayCurrency='USD')/Results/?$filter=(PurchaseOrder eq '4500000000')

Configura il sistema SAP ERP

Il plug-in SAP OData utilizza un servizio OData attivato su ogni server SAP da cui vengono estratti i dati. Questo servizio OData può essere uno standard fornito da SAP o un servizio OData personalizzato sviluppato nel tuo sistema SAP.

Passaggio 1: installa SAP Gateway 2.0

L'amministratore SAP (Basis) deve verificare che i componenti di SAP Gateway 2.0 siano disponibili nel sistema di origine SAP, a seconda della release di NetWeaver. Per ulteriori informazioni sull'installazione di SAP Gateway 2.0, accedi a SAP ONE Support Launchpad e consulta la Nota 1569624 (è necessario accedere) .

Passaggio 2: attiva il servizio OData

Attiva il servizio OData richiesto sul sistema di origine. Per ulteriori informazioni, consulta Server front-end: attivare i servizi OData.

Passaggio 3: crea un ruolo di autorizzazione

Per connetterti alla DataSource, crea un ruolo di autorizzazione con le autorizzazioni richieste in SAP e poi concedilo all'utente SAP.

Per creare il ruolo di autorizzazione in SAP:

- In SAP GUI, inserisci il codice transazione PFCG per aprire la finestra Gestione dei ruoli.

Nel campo Ruolo, inserisci un nome per il ruolo.

Ad esempio:

ZODATA_AUTHFai clic su Singolo ruolo.

Si apre la finestra Crea ruoli.

Nel campo Descrizione, inserisci una descrizione e fai clic su Salva.

Ad esempio:

Authorizations for SAP OData plugin.Fai clic sulla scheda Autorizzazioni. Il titolo della finestra diventa Cambia ruoli.

In Modifica dati di autorizzazione e genera profili, fai clic su Cambia dati di autorizzazione.

Si apre la finestra Scegli modello.

Fai clic su Non selezionare modelli.

Viene visualizzata la finestra Cambia ruolo: autorizzazioni.

Fai clic su Manualmente.

Fornisci le autorizzazioni mostrate nella seguente tabella delle autorizzazioni SAP.

Fai clic su Salva.

Per attivare il ruolo di autorizzazione, fai clic sull'icona Genera.

Autorizzazioni SAP

| Classe di oggetti | Testo della classe dell'oggetto | Oggetto Authorization | Testo dell'oggetto dell'autorizzazione | Autorizzazione | Testo | Valore |

|---|---|---|---|---|---|---|

| AAAB | Oggetti di autorizzazione tra applicazioni | S_SERVICE | Controllo all'avvio dei servizi esterni | SRV_NAME | Nome del programma, della transazione o del modulo di funzione | * |

| AAAB | Oggetti di autorizzazione tra applicazioni | S_SERVICE | Controllo all'avvio dei servizi esterni | SRV_TYPE | Tipo di flag di controllo e valori predefiniti di autorizzazione | HT |

| FI | Contabilità finanziaria | F_UNI_HIER | Accesso alla gerarchia universale | ACTVT | Attività | 03 |

| FI | Contabilità finanziaria | F_UNI_HIER | Accesso alla gerarchia universale | HRYTYPE | Tipo di gerarchia | * |

| FI | Contabilità finanziaria | F_UNI_HIER | Accesso alla gerarchia universale | HRYID | ID gerarchia | * |

Per progettare ed eseguire una pipeline di dati in Cloud Data Fusion (come utente Cloud Data Fusion), devi disporre delle credenziali utente SAP (nome utente e password) per configurare il plug-in in modo che si connetta alla DataSource.

L'utente SAP deve essere di tipo Communications o Dialog. Per evitare di utilizzare

risorse di dialogo SAP, è consigliato il tipo Communications. Gli utenti possono essere

creati utilizzando il codice transazione SU01 di SAP.

(Facoltativo) Passaggio 4: proteggi la connessione

Puoi proteggere la comunicazione sulla rete tra la tua istanza Cloud Data Fusion privata e SAP.

Per proteggere la connessione:

- L'amministratore SAP deve generare un certificato X509. Per generare il certificato, consulta Creare un PSE del server SSL.

- L' Google Cloud amministratore deve copiare il file X509 in un bucket Cloud Storage leggibile nello stesso progetto dell'istanza Cloud Data Fusion e fornire il percorso del bucket all' Google Cloud utente Cloud Data Fusion, che lo inserisce durante la configurazione del plug-in.

- L' Google Cloud amministratore deve concedere l'accesso in lettura per il file X509 all' Google Cloud utente Cloud Data Fusion che progetta ed esegue le pipeline.

(Facoltativo) Passaggio 5: crea servizi OData personalizzati

Puoi personalizzare la modalità di estrazione dei dati creando servizi OData personalizzati in SAP:

- Per creare servizi OData personalizzati, consulta Creazione di servizi OData per principianti.

- Per creare servizi OData personalizzati utilizzando le visualizzazioni dei servizi di dati di base (CDS), consulta Come creare un servizio OData ed esporre le visualizzazioni CDS come servizio OData.

- Qualsiasi servizio OData personalizzato deve supportare le query

$top,$skipe$count. Queste query consentono al plug-in di partizionare i dati per l'estrazione sequenziale e parallela. Se utilizzate, devono essere supportate anche le query$filter,$expando$select.

Configurare Cloud Data Fusion

Assicurati che la comunicazione sia abilitata tra l'istanza Cloud Data Fusion e il server SAP. Per le istanze private, configura il peering di rete. Una volta stabilito il peering di rete con il progetto in cui sono ospitati i sistemi SAP, non è richiesta alcuna configurazione aggiuntiva per connettersi all'istanza Cloud Data Fusion. Sia il sistema SAP sia l'istanza Cloud Data Fusion devono trovarsi nello stesso progetto.

Passaggio 1: configura l'ambiente Cloud Data Fusion

Per configurare l'ambiente Cloud Data Fusion per il plug-in:

Vai ai dettagli dell'istanza:

Nella Google Cloud console, vai alla pagina Cloud Data Fusion.

Fai clic su Istanze, quindi sul nome dell'istanza per andare alla pagina Dettagli istanza.

Verifica che sia stato eseguito l'upgrade dell'istanza alla versione 6.4.0 o successiva. Se l'istanza è in una versione precedente, devi eseguirne l'upgrade.

Fai clic su Visualizza istanza. Quando si apre l'interfaccia utente di Cloud Data Fusion, fai clic su Hub.

Seleziona la scheda SAP > SAP OData.

Se la scheda SAP non è visibile, consulta la sezione Risolvere i problemi di integrazione di SAP.

Fai clic su Esegui il deployment del plug-in SAP OData.

Il plug-in ora viene visualizzato nel menu Origine nella pagina di Studio.

Passaggio 2: configura il plug-in

Il plug-in SAP OData legge i contenuti di un'origine dati SAP.

Per filtrare i record, puoi configurare le seguenti proprietà nella pagina Proprietà OData di SAP.

| Nome proprietà | Descrizione |

|---|---|

| Basic | |

| Nome di riferimento | Nome utilizzato per identificare in modo univoco questa origine per la derivazione o per annotare i metadati. |

| URL base SAP OData | URL di base OData di SAP Gateway (utilizza il percorso dell'URL completo, simile a

https://ADDRESS:PORT/sap/opu/odata/sap/).

|

| Versione OData | Versione SAP OData supportata. |

| Nome servizio | Nome del servizio OData SAP da cui vuoi estrarre un'entità. |

| Nome entità | Nome dell'entità che viene estratta, ad esempio Results. Puoi utilizzare un prefisso, ad esempio C_PurchaseOrderItemMoni/Results. Questo campo supporta i parametri Categoria ed Entità. Esempi:

|

| Credenziali* | |

| Tipo SAP | Di base (tramite nome utente e password). |

| Nome utente di accesso SAP | Nome utente SAP Consigliato: se il nome utente di accesso SAP cambia periodicamente, utilizza una macro. |

| Password di accesso SAP | Password utente SAP Consigliata: utilizza macro sicure per i valori sensibili, come le password. |

| Certificato client X.509 SAP (vedi Utilizzo di certificati client X.509 su SAP NetWeaver Application Server per ABAP. |

|

| ID progetto Google Cloud | Un identificatore univoco globale per il tuo progetto. Questo campo è obbligatorio se il campo Percorso in Cloud Storage del certificato X.509 non contiene un valore della macro. |

| Percorso GCS | Il percorso del bucket Cloud Storage contenente il certificato X.509 caricato dall'utente, che corrisponde al server delle applicazioni SAP per le chiamate sicure in base ai tuoi requisiti (vedi il passaggio Proteggere la connessione). |

| Passphrase | Passphrase corrispondente al certificato X.509 fornito. |

| Pulsante Get Schema (Ottieni schema) | Genera uno schema basato sui metadati di SAP, con mappatura automatica dei tipi di dati SAP ai tipi di dati Cloud Data Fusion corrispondenti (stessa funzionalità del pulsante Convalida). |

| Avanzate | |

| Opzioni di filtro | Indica il valore che deve avere un campo per essere letto. Utilizza questa condizione di filtro per limitare il volume dei dati in uscita. Ad esempio, "Prezzo > 200" seleziona i record con un valore del campo "Prezzo" maggiore di "200". (Vedi Ottenere un elenco di colonne filtrabili per un servizio di catalogo SAP.) |

| Seleziona campi | Campi da conservare nei dati estratti (ad es. Categoria, Prezzo, Nome, Fornitore/Indirizzo). |

| Campi espandibili | Elenco di campi complessi da espandere nei dati di output estratti (ad esempio Prodotti/Fornitori). |

| Numero di righe da saltare | Numero totale di righe da saltare (ad es. 10). |

| Numero di righe da recuperare | Numero totale di righe da estrarre. |

| Numero di suddivisioni da generare | Il numero di suddivisioni utilizzate per partizionare i dati di input. Più partizioni

aumentano il livello di parallelismo, ma richiedono più risorse e

overhead. Se lasciato vuoto, il plug-in sceglie un valore ottimale (opzione consigliata). |

| Dimensione batch | Numero di righe da recuperare in ogni chiamata di rete a SAP. Una dimensione ridotta provoca frequenti chiamate di rete che ripetono il sovraccarico associato. Le dimensioni elevate

potrebbero rallentare il recupero dei dati e causare un utilizzo eccessivo delle risorse in SAP.

Se il valore è impostato su 0, il valore predefinito è

2500 e il limite di righe da recuperare in ogni batch è

5000. |

| Timeout di lettura | Il tempo, in secondi, di attesa per il servizio SAP OData. Il valore predefinito è 300. Per nessun limite di tempo, imposta 0. |

Tipi OData supportati

La tabella seguente mostra la mappatura tra i tipi di dati OData v2 utilizzati nelle applicazioni SAP e i tipi di dati di Cloud Data Fusion.

| Tipo OData | Descrizione (SAP) | Tipo di dati di Cloud Data Fusion |

|---|---|---|

| Numerico | ||

| SByte | Valore intero a 8 bit con segno | int |

| Byte | Valore intero senza segno a 8 bit | int |

| Int16 | Valore intero a 16 bit con segno | int |

| Int32 | Valore intero a 32 bit con segno | int |

| Int64 | Valore intero a 64 bit con segno aggiunto al carattere: "L" Esempi: 64L, -352L |

long |

| Singolo | Numero con virgola mobile con precisione di 7 cifre che può rappresentare valori

con un intervallo approssimativo compreso tra ± 1,18e-38 e ± 3,40e+38, con il carattere aggiuntivo "f" Esempio: 2.0f |

float |

| Doppio | Numero con rappresentazione in virgola mobile con precisione di 15 cifre che può rappresentare valori

con intervalli approssimativi da ± 2,23e-308 a ± 1,79e+308, a cui è stato aggiunto

il carattere: 'd' Esempi: 1E+10d, 2.029d, 2.0d |

double |

| Decimale | Valori numerici con precisione e scala fisse che descrivono un valore numerico

compreso tra -10^255 + 1 e 10^255 -1 positivo, a cui è aggiunto il carattere: 'M' o 'm' Esempio: 2.345M |

decimal |

| Carattere | ||

| Guid | Un valore identificatore univoco di 16 byte (128 bit), che inizia con il carattere

"guid" Esempio: guid'12345678-aaaa-bbbb-cccc-ddddeeeeffff' |

string |

| Stringa | Dati di caratteri di lunghezza fissa o variabile codificati in UTF-8 | string |

| Byte | ||

| Binario | Dati binari di lunghezza fissa o variabile che iniziano con "X" o

'binary' (entrambi sono sensibili alle maiuscole) Esempio: X'23AB', binary'23ABFF' |

bytes |

| Logica | ||

| Booleano | Concetto matematico di logica a valori binari | boolean |

| Data/ora | ||

| Data/ora | Data e ora con valori compresi tra le ore 00:00:00 del 1° gennaio 1753 e le ore 23:59:59 del 31 dicembre 9999 | timestamp |

| Ora | Ora del giorno con valori compresi tra 0:00:00.x e 23:59:59.y, dove "x" e "y" dipendono dalla precisione | time |

| DateTimeOffset | Data e ora come offset, in minuti dal GMT, con valori che vanno dalle 00:00:00 del 1° gennaio 1753 alle 23:59:59 del 31 dicembre 9999 | timestamp |

| Complesso | ||

| Proprietà di navigazione e non di navigazione (moltiplicità = *) | Collezioni di un tipo, con una molteplicità di uno a molti. | array,string,int. |

| Proprietà (moltiplicità = 0,1) | Riferimenti ad altri tipi complessi con una molteplicità di relazioni uno a uno | record |

Convalida

Fai clic su Convalida in alto a destra o su Genera schema.

Il plug-in convalida le proprietà e genera uno schema in base ai metadati di SAP. Mappa automaticamente i tipi di dati SAP ai tipi di dati Cloud Data Fusion corrispondenti.

Esegui una pipeline di dati

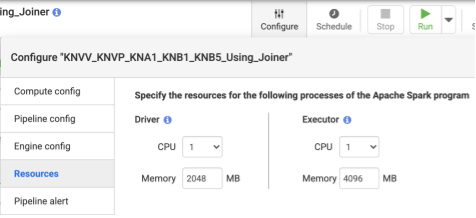

- Dopo aver eseguito il deployment della pipeline, fai clic su Configura nel riquadro in alto al centro.

- Seleziona Risorse.

- Se necessario, modifica CPU dell'executor e Memoria in base alle dimensioni complessive dei dati e al numero di trasformazioni utilizzate nella pipeline.

- Fai clic su Salva.

- Per avviare la pipeline di dati, fai clic su Esegui.

Prestazioni

Il plug-in utilizza le funzionalità di parallellizzazione di Cloud Data Fusion. Le seguenti linee guida possono aiutarti a configurare l'ambiente di runtime in modo da fornire risorse sufficienti al motore di runtime per raggiungere il grado di parallelismo e prestazioni previsto.

Ottimizza la configurazione del plug-in

Consigliato: a meno che tu non abbia dimestichezza con le impostazioni di memoria del tuo sistema SAP, lascia vuoti i campi Numero di suddivisioni da generare e Dimensione batch (non specificato).

Per migliorare le prestazioni durante l'esecuzione della pipeline, utilizza le seguenti configurazioni:

Numero di suddivisioni da generare: si consiglia di scegliere valori tra

8e16. Tuttavia, possono aumentare fino a32o addirittura64con configurazioni appropriate lato SAP (allocando risorse di memoria appropriate per i processi di lavoro in SAP). Questa configurazione migliora il parallelismo lato Cloud Data Fusion. Il motore di runtime crea il numero specificato di partizioni (e connessioni SAP) durante l'estrazione dei record.Se il servizio di configurazione (incluso nel plug-in quando importi il file di trasporto SAP) è disponibile: il plug-in utilizza per impostazione predefinita la configurazione del sistema SAP. Le suddivisioni corrispondono al 50% dei processi di lavoro della finestra di dialogo disponibili in SAP. Nota: il servizio di configurazione può essere importato solo dai sistemi S4HANA.

Se il servizio di configurazione non è disponibile, il valore predefinito è

7suddivisioni.In entrambi i casi, se specifichi un valore diverso, questo prevale sul valore predefinito della suddivisione,tranne per il fatto che è limitato dai processi di dialogo disponibili in SAP, meno due suddivisioni.

Se il numero di record da estrarre è inferiore a

2500, il numero di suddivisioni è1.

Dimensioni del batch: il numero di record da recuperare in ogni chiamata di rete a SAP. Una dimensione del batch più piccola causa chiamate di rete frequenti, ripetendo l'overhead associato. Per impostazione predefinita, il conteggio minimo è

1000e il conteggio massimo è50000.

Per ulteriori informazioni, consulta Limiti delle entità OData.

Impostazioni delle risorse Cloud Data Fusion

Consigliato: utilizza 1 CPU e 4 GB di memoria per Executor (questo valore si applica a ogni processo Executor). Impostali nella finestra di dialogo Configura > Risorse.

Impostazioni del cluster Dataproc

Consigliato:alloca almeno un totale di CPU (tra i worker) superiore al numero di suddivisioni previsto (vedi Configurazione del plug-in).

Ogni worker deve avere almeno 6,5 GB di memoria allocata per CPU nelle impostazioni di Dataproc (ovvero almeno 4 GB disponibili per l'executor Cloud Data Fusion). Le altre impostazioni possono essere mantenute ai valori predefiniti.

Consigliato: utilizza un cluster Dataproc persistente per ridurre il tempo di esecuzione della pipeline di dati (in questo modo viene eliminato il passaggio di provisioning che potrebbe richiedere alcuni minuti o più). Imposta questa opzione nella sezione di configurazione di Compute Engine.

Configurazioni di esempio e throughput

Le sezioni seguenti descrivono le configurazioni di sviluppo e produzione di esempio e il throughput.

Configurazioni di sviluppo e test di esempio

- Cluster Dataproc con 8 worker, ciascuno con 4 CPU e 26 GB di memoria. Genera fino a 28 suddivisioni.

- Cluster Dataproc con 2 worker, ciascuno con 8 CPU e 52 GB di memoria. Genera fino a 12 suddivisioni.

Configurazioni di produzione e throughput di esempio

- Cluster Dataproc con 8 worker, ciascuno con 8 CPU e 32 GB di memoria. Genera fino a 32 suddivisioni (metà delle CPU disponibili).

- Cluster Dataproc con 16 worker, ciascuno con 8 CPU e 32 GB di memoria. Genera fino a 64 suddivisioni (metà delle CPU disponibili).

Esempio di throughput per un sistema di origine di produzione SAP S4HANA 1909

La seguente tabella mostra la portata di esempio. La velocità effettiva mostrata non prevede opzioni di filtro, se non diversamente specificato. Quando utilizzi le opzioni di filtro, il throughput viene ridotto.

| Dimensione del batch | Suddivisioni | Servizio OData | Righe totali | Righe estratte | Velocità effettiva (righe al secondo) |

|---|---|---|---|---|---|

| 1000 | 4 | ZACDOCA_CDS | 5,37 M | 5,37 M | 1069 |

| 2500 | 10 | ZACDOCA_CDS | 5,37 M | 5,37 M | 3384 |

| 5000 | 8 | ZACDOCA_CDS | 5,37 M | 5,37 M | 4630 |

| 5000 | 9 | ZACDOCA_CDS | 5,37 M | 5,37 M | 4817 |

Throughput di esempio per un sistema di origine di produzione cloud SAP S4HANA

| Dimensione del batch | Suddivisioni | Servizio OData | Righe totali | Righe estratte | Velocità effettiva (GB/ora) |

|---|---|---|---|---|---|

| 2500 | 40 | TEST_04_UOM_ODATA_CDS/ | 201 Mln | 10 M | 25,48 |

| 5000 | 50 | TEST_04_UOM_ODATA_CDS/ | 201 Mln | 10 M | 26,78 |

Dettagli dell'assistenza

Il plug-in supporta i seguenti casi d'uso.

Prodotti e versioni SAP supportati

Le origini supportate includono SAP S4/HANA 1909 e versioni successive, S4/HANA su SAP Cloud e qualsiasi applicazione SAP in grado di esporre servizi OData.

Il file di trasporto contenente il servizio OData personalizzato per il bilanciamento del carico delle chiamate a SAP deve essere importato in S4/HANA 1909 e versioni successive. Il servizio consente di calcolare il numero di suddivisioni (partizioni di dati) che il plug-in può leggere in parallelo (vedi Numero di suddivisioni).

È supportata la versione 2 di OData.

Il plug-in è stato testato con i server SAP S/4HANA di cui è stato eseguito il deployment su Google Cloud.

I servizi di catalogo OData di SAP sono supportati per l'estrazione

Il plug-in supporta i seguenti tipi di DataSource:

- Dati sulle transazioni

- Visualizzazioni CDS esposte tramite OData

Dati master

- Attributi

- Messaggi

- Gerarchie

Note SAP

Non sono necessarie note SAP prima dell'estrazione, ma il sistema SAP deve avere SAP Gateway disponibile. Per ulteriori informazioni, consulta la nota 1560585 (questo sito esterno richiede un accesso SAP).

Limiti relativi al volume di dati o alla larghezza dei record

Non è definito alcun limite al volume di dati estratti. Abbiamo eseguito test con fino a 6 milioni di righe estratte in una chiamata, con una larghezza del record di 1 KB. Per SAP S4/HANA sul cloud, abbiamo eseguito test con fino a 10 milioni di righe estratte in una chiamata, con una larghezza del record di 1 KB.

Velocità effettiva del plug-in prevista

Per un ambiente configurato in base alle linee guida riportate nella sezione Rendimento, il plug-in può estrarre circa 38 GB ogni ora. Le prestazioni effettive potrebbero variare in base ai carichi del sistema Cloud Data Fusion e SAP o al traffico di rete.

Estrazione delta (dati modificati)

L'estrazione delta non è supportata.

Scenari di errore

In fase di esecuzione, il plug-in scrive le voci di log nel log della pipeline di dati Cloud Data Fusion. Queste voci sono precedute dal prefisso CDF_SAP per l'identificazione.

In fase di progettazione, quando convalidi le impostazioni del plug-in, i messaggi vengono visualizzati nella scheda Proprietà e sono evidenziati in rosso.

Il seguente elenco descrive alcuni degli errori:

| ID messaggio | Messaggio | Azione consigliata |

|---|---|---|

| Nessuno | Required property 'CONNECTION_PROPERTY' for connection

type 'CONNECTION_PROPERTY_SETTING'. |

Inserisci un valore effettivo o una variabile macro. |

| Nessuno | Invalid value for property 'PROPERTY_NAME'. |

Inserisci un numero intero non negativo (0 o superiore, senza decimali) o una variabile di macro. |

| CDF_SAP_ODATA_01505 | Failed to prepare the Cloud Data Fusion output schema. Please

check the provided runtime macros value. |

Assicurati che i valori della macro forniti siano corretti. |

| N/D | SAP X509 certificated 'STORAGE_PATH' is missing. Please

make sure the required X509 certificate is uploaded to your specified

Cloud Storage bucket 'BUCKET_NAME'. |

Assicurati che il percorso Cloud Storage fornito sia corretto. |

| CDF_SAP_ODATA_01532 | Codice di errore generico relativo a problemi di connettività OData di SAPFailed to call given SAP OData service. Root Cause:

MESSAGE. |

Controlla la causa principale visualizzata nel messaggio e intervieni in modo appropriato. |

| CDF_SAP_ODATA_01534 | Codice di errore generico relativo a un errore del servizio OData di SAP.Service validation failed. Root Cause: MESSAGE. |

Controlla la causa principale visualizzata nel messaggio e intervieni in modo appropriato. |

| CDF_SAP_ODATA_01503 | Failed to fetch total available record count from

SAP_ODATA_SERVICE_ENTITY_NAME. Root Cause: MESSAGE.

|

Controlla la causa principale visualizzata nel messaggio e intervieni in modo appropriato. |

| CDF_SAP_ODATA_01506 | No records found to extract in

SAP_ODATA_SERVICE_ENTITY_NAME.

Please ensure that the provided entity contains records. |

Controlla la causa principale visualizzata nel messaggio e intervieni in modo appropriato. |

| CDF_SAP_ODATA_01537 | Failed to process records for

SAP_ODATA_SERVICE_ENTITY_NAME.

Root Cause: MESSAGE. |

Controlla la causa principale visualizzata nel messaggio e intervieni in modo appropriato. |

| CDF_SAP_ODATA_01536 | Failed to pull records from

SAP_ODATA_SERVICE_ENTITY_NAME. Root Cause:

MESSAGE. |

Controlla la causa principale visualizzata nel messaggio e intervieni in modo appropriato. |

| CDF_SAP_ODATA_01504 | Failed to generate the encoded metadata string for the given OData

service SAP_ODATA_SERVICE_NAME. Root Cause:

MESSAGE. |

Controlla la causa principale visualizzata nel messaggio e intervieni in modo appropriato. |

| CDF_SAP_ODATA_01533 | Failed to decode the metadata from the given encoded metadata

string for service SAP_ODATA_SERVICE_NAME. Root Cause:

MESSAGE. |

Controlla la causa principale visualizzata nel messaggio e intervieni in modo appropriato. |

Passaggi successivi

- Scopri di più su Cloud Data Fusion.

- Scopri di più su SAP su Google Cloud.