Datenpipeline erstellen

In dieser Kurzanleitung wird Folgendes beschrieben:

- Erstellen Sie eine Cloud Data Fusion-Instanz.

- Beispielpipeline bereitstellen, die in Ihrer Cloud Data Fusion-Instanz bereitgestellt wird Die Pipeline führt Folgendes aus:

- Eine JSON-Datei mit NYT-Bestseller-Daten aus Cloud Storage lesen

- Transformationen an der Datei ausführen, um die Daten zu analysieren und zu bereinigen

- Die bestbewerteten Bücher, die in der letzten Woche hinzugefügt wurden und weniger als 25 $ kosten, in BigQuery laden

Hinweise

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Enable the Cloud Data Fusion API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Enable the Cloud Data Fusion API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Klicken Sie auf Instanz erstellen.

- Geben Sie einen Instanznamen ein.

- Geben Sie eine Beschreibung für Ihre Instanz ein.

- Geben Sie die Region ein, in der die Instanz erstellt werden soll.

- Wählen Sie die Cloud Data Fusion-Version aus, die Sie verwenden möchten.

- Wählen Sie die Version von Cloud Data Fusion aus.

- Wählen Sie für Cloud Data Fusion Version 6.2.3 und höher im Feld Autorisierung das Dataproc-Dienstkonto aus, das zum Ausführen Ihrer Cloud Data Fusion-Pipeline in Dataproc verwendet werden soll. Der Standardwert, das Compute Engine-Konto, ist bereits ausgewählt.

- Klicken Sie auf Erstellen. Es kann bis zu 30 Minuten dauern, bis die Instanz erstellt ist. Während Cloud Data Fusion die Instanz erstellt, wird neben dem Instanznamen auf der Seite Instanzen ein Radsymbol angezeigt, das den Fortschritt angibt. Nachdem der Vorgang abgeschlossen ist, wird es zu einem grünen Häkchen. Dies zeigt an, dass Sie die Instanz verwenden können.

In der Google Cloud Console haben Sie folgende Möglichkeiten:

- Google Cloud Konsolenprojekt erstellen

- Cloud Data Fusion-Instanzen erstellen und löschen

- Details zur Cloud Data Fusion-Instanz ansehen

In der Cloud Data Fusion-Web-UI können Sie verschiedene Seiten wie Studio oder Wrangler verwenden, um die Funktionen von Cloud Data Fusion zu nutzen.

- Öffnen Sie in der Google Cloud Console die Seite Instanzen.

- Klicken Sie in der Spalte Aktionen der Instanz auf den Link Instanz aufrufen.

- Rufen Sie in der Web-UI von Cloud Data Fusion über den linken Navigationsbereich die gewünschte Seite auf.

- Klicken Sie in der Cloud Data Fusion-Weboberfläche auf Hub.

- Klicken Sie im linken Bereich auf Pipelines.

- Klicken Sie auf die Pipeline Cloud Data Fusion-Quickstart.

- Klicken Sie auf Erstellen.

- Klicken Sie im Konfigurationsbereich für den Cloud Data Fusion-Quickstart auf Fertigstellen.

Klicken Sie auf Pipeline anpassen.

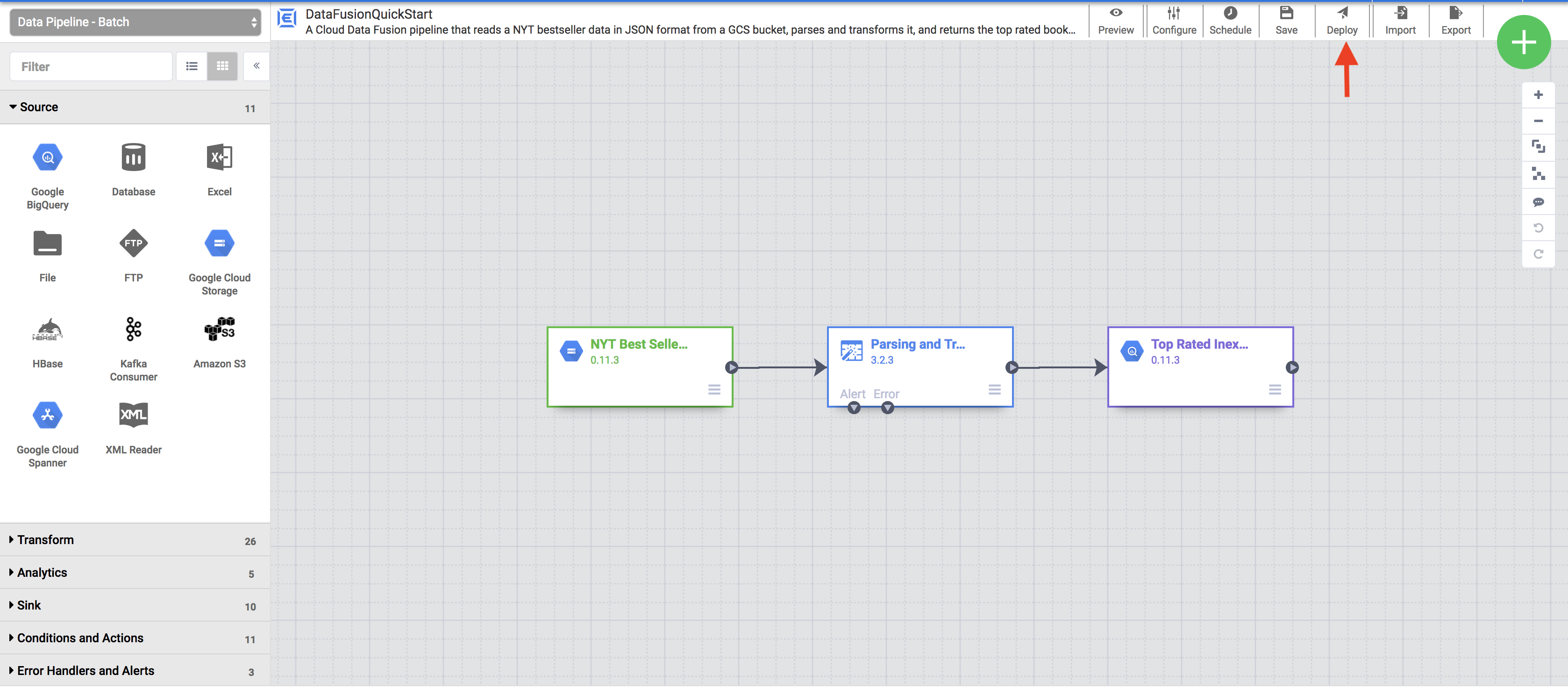

Eine visuelle Darstellung Ihrer Pipeline wird auf der Seite Studio angezeigt. Dies ist eine grafische Benutzeroberfläche zur Entwicklung von Pipelines zur Datenintegration. Auf der linken Seite sind die Pipeline-Plug-ins aufgelistet und Ihre Pipeline wird im Hauptbereich angezeigt. Sie können Ihre Pipeline untersuchen, indem Sie den Mauszeiger auf die einzelnen Knoten der Pipeline bewegen und auf Eigenschaften klicken. Über das Menü „Eigenschaften“ für jeden Knoten können Sie die mit dem Knoten verknüpften Objekte und Vorgänge aufrufen.

Klicken Sie im Menü oben rechts auf Deploy (Bereitstellen). Mit diesem Schritt wird die Pipeline an Cloud Data Fusion gesendet. Im nächsten Abschnitt dieser Kurzanleitung führen Sie die Pipeline aus.

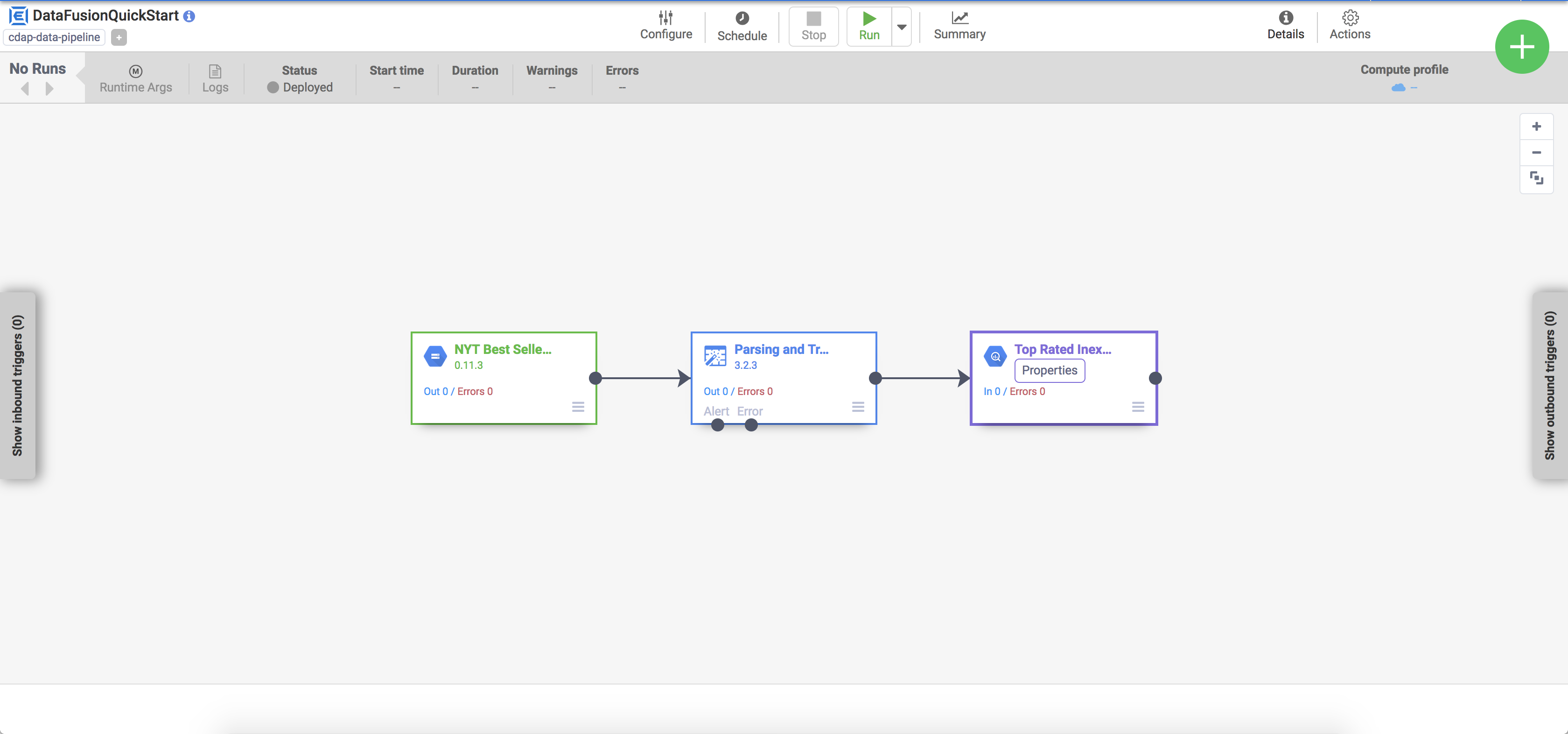

- Struktur und Konfiguration der Pipeline ansehen

- Pipeline manuell ausführen oder einen Zeitplan bzw. Trigger einrichten

- Zusammenfassung des Ausführungsverlaufs der Pipeline anzeigen, einschließlich Ausführungszeiten, Logs und Messwerte

- Stellt einen sitzungsspezifischen Dataproc-Cluster bereit

- Führt die Pipeline mit Apache Spark im Cluster aus

- Löscht den Cluster

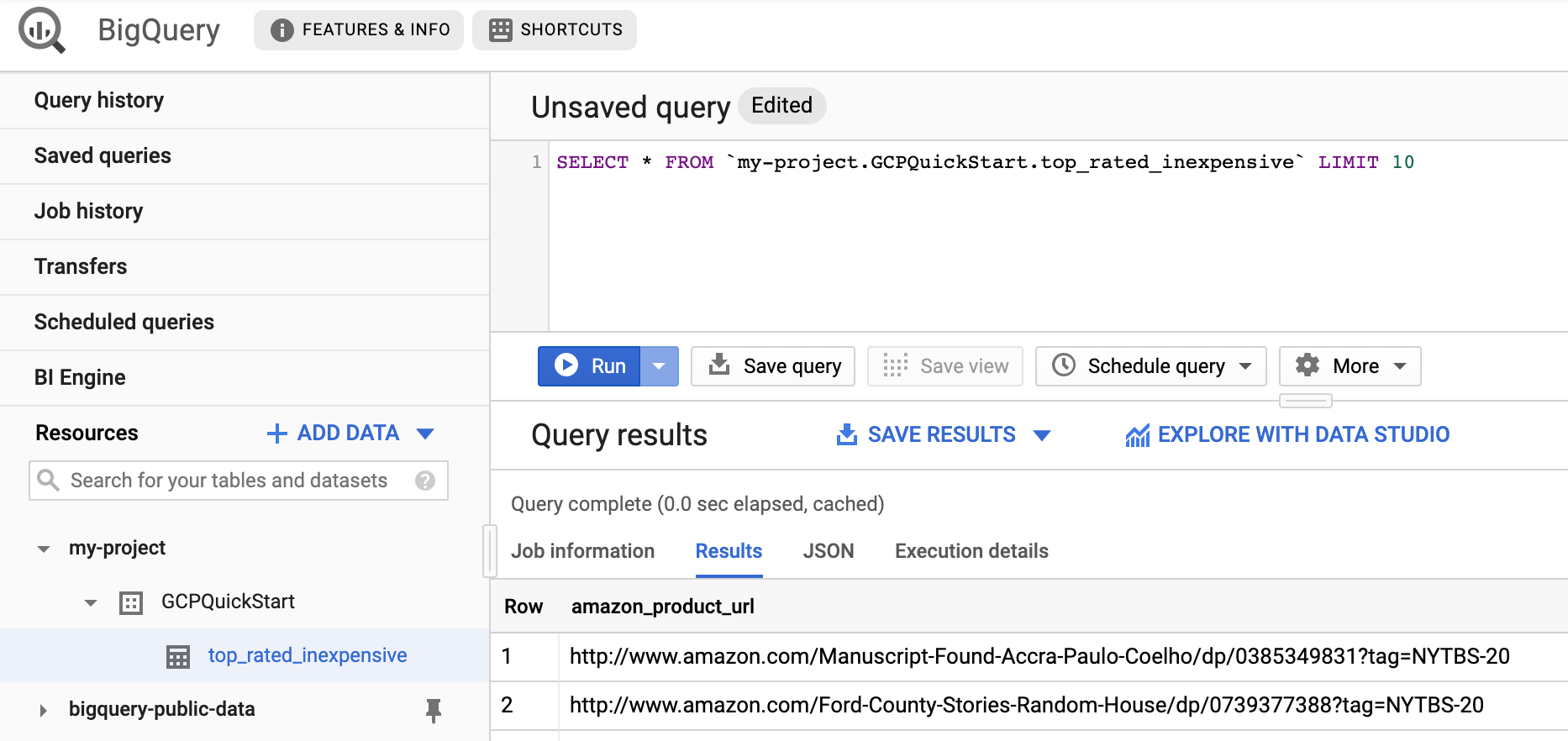

- Rufen Sie die BigQuery-Webbenutzeroberfläche auf.

Wenn Sie sich ein Beispiel der Ergebnisse ansehen möchten, rufen Sie das Dataset

DataFusionQuickstartin Ihrem Projekt auf, klicken Sie auf die Tabelletop_rated_inexpensiveund führen Sie eine einfache Abfrage aus. Beispiel:SELECT * FROM PROJECT_ID.GCPQuickStart.top_rated_inexpensive LIMIT 10Ersetzen Sie PROJECT_ID durch Ihre Projekt-ID.

- Löschen Sie das BigQuery-Dataset, in das die Pipeline in diesem Schnellstart geschrieben hat.

Optional: Löschen Sie das Projekt.

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

- Anleitung zu Cloud Data Fusion

- Informationen über Konzepte zu Cloud Data Fusion

Erstellen Sie eine Cloud Data Fusion-Instanz.

In der Cloud Data Fusion-Weboberfläche navigieren

Bei Verwendung von Cloud Data Fusion verwenden Sie sowohl die Google Cloud Console als auch die separate Cloud Data Fusion-Weboberfläche.

So rufen Sie die Benutzeroberfläche von Cloud Data Fusion auf:

Beispielpipeline bereitstellen

Beispielpipelines sind über den Cloud Data Fusion Hub verfügbar, mit dem Sie wiederverwendbare Pipelines, Plug-ins und Lösungen für Cloud Data Fusion teilen können.

Pipeline anzeigen

Die bereitgestellte Pipeline wird in der Ansicht der Pipelinedetails angezeigt. Hier können Sie Folgendes tun:

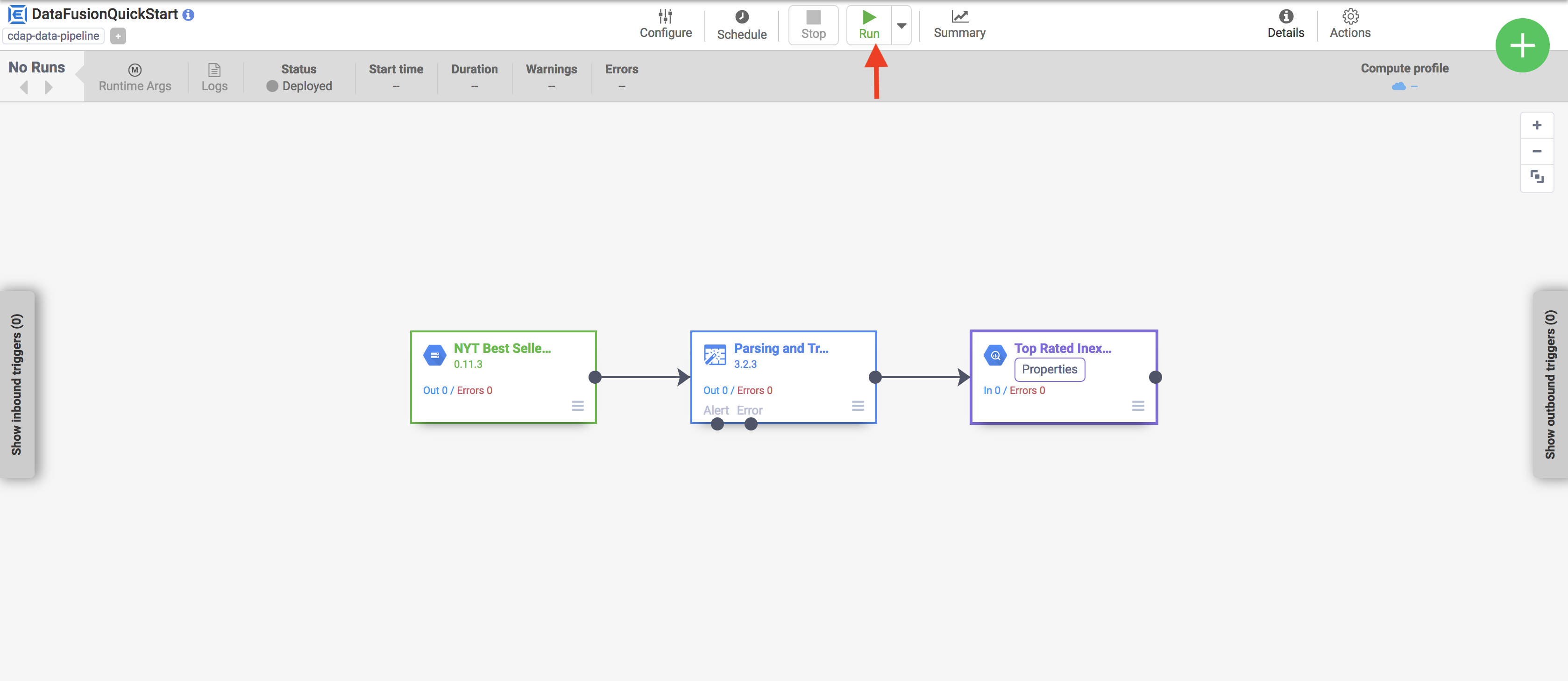

Pipeline ausführen

Klicken Sie in der Ansicht „Pipelinedetails“ auf Ausführen, um die Pipeline auszuführen.

Beim Ausführen einer Pipeline führt Cloud Data Fusion die folgenden Schritte aus:

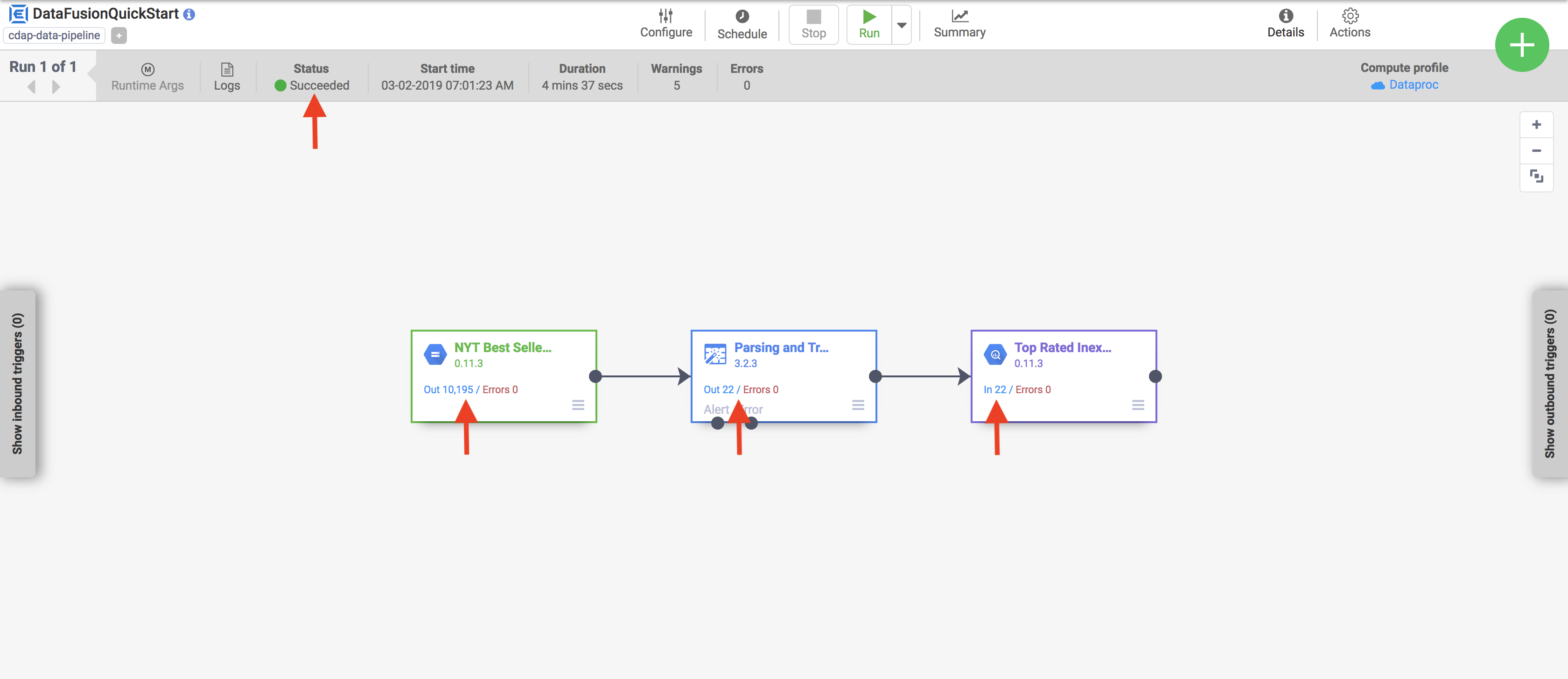

Ergebnisse aufrufen

Nach einigen Minuten ist die Pipeline abgeschlossen. Der Pipelinestatus ändert sich in Erfolgreich und die Anzahl der von jedem Knoten verarbeiteten Datensätze wird angezeigt.

Bereinigen

Mit den folgenden Schritten vermeiden Sie, dass Ihrem Google Cloud -Konto die auf dieser Seite verwendeten Ressourcen in Rechnung gestellt werden: