Cloud Data Fusion에서 데이터 파이프라인을 만들 때는 노드라고 하는 일련의 단계를 사용하여 데이터가 소스에서 싱크로 이동할 때 데이터를 이동하고 관리합니다. 각 노드는 Cloud Data Fusion의 기능을 확장하는 맞춤설정 가능한 모듈인 플러그인으로 구성됩니다.

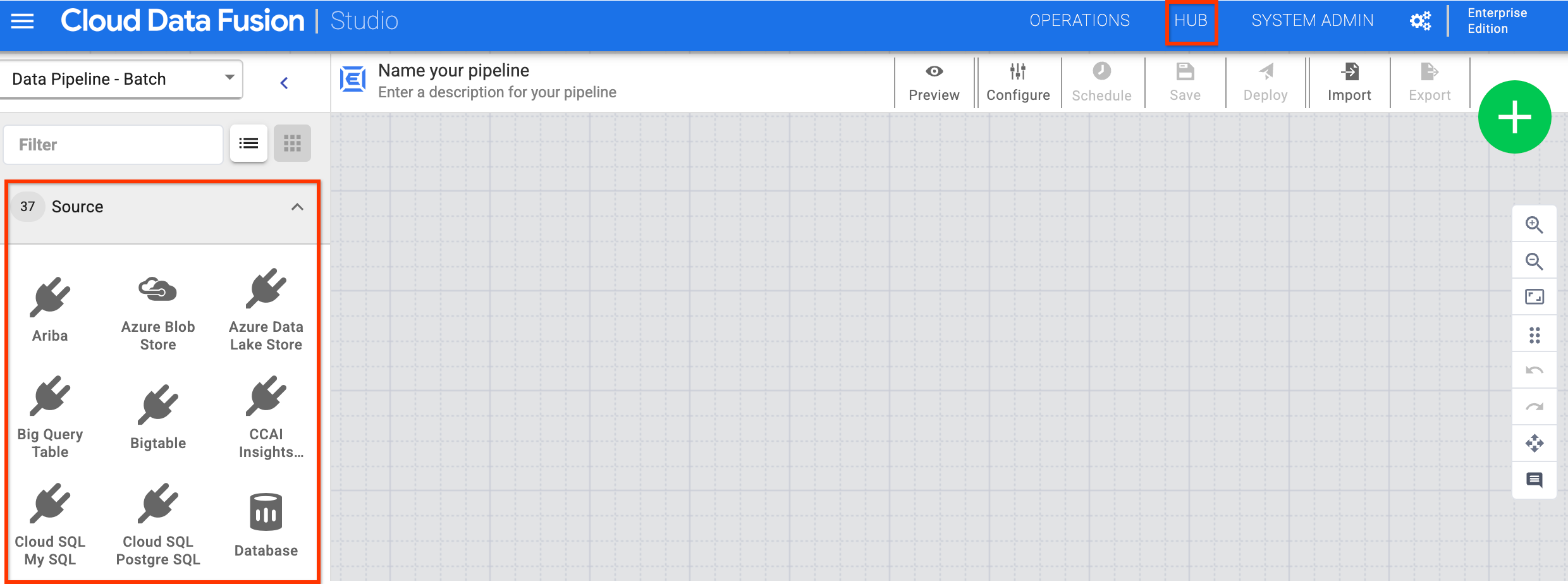

Cloud Data Fusion 웹 인터페이스의 스튜디오 페이지로 이동하여 플러그인을 찾을 수 있습니다. 플러그인을 더 보려면 허브를 클릭합니다.

플러그인 유형

플러그인은 다음과 같은 카테고리로 분류됩니다.

- 소스

- 변환

- 애널리틱스

- 싱크

- 조건 및 작업

- 오류 핸들러 및 알림

소스

소스 플러그인은 파이프라인이 데이터를 읽는 데이터베이스, 파일 또는 실시간 스트림에 연결됩니다. 웹 인터페이스를 사용하여 데이터 파이프라인의 소스를 설정하므로 하위 수준 연결을 코딩할 필요가 없습니다.

변환

변환 플러그인은 소스에서 처리된 후 데이터를 변경합니다. 예를 들어 레코드를 클론하거나, 파일 형식을 JSON으로 변경하거나, JavaScript 플러그인을 사용하여 커스텀 변환을 만들 수 있습니다.

애널리틱스

분석 플러그인은 여러 소스의 데이터를 조인하고 분석 및 머신러닝 작업을 실행하는 등의 집계를 실행합니다.

싱크

싱크 플러그인은 Cloud Storage, BigQuery, Spanner, 관계형 데이터베이스, 파일 시스템, 메인프레임과 같은 리소스에 데이터를 씁니다. Cloud Data Fusion 웹 인터페이스 또는 REST API를 사용하여 싱크에 기록되는 데이터를 쿼리할 수 있습니다.

조건 및 작업

조건 및 작업 플러그인을 사용하여 워크플로 중에 실행되며 워크플로의 데이터를 직접 조작하지 않는 작업을 예약합니다. 예를 들면 다음과 같습니다.

- 데이터베이스 플러그인을 사용하여 파이프라인 끝에 실행되도록 데이터베이스 명령어를 예약합니다.

- File Move 플러그인을 사용하여 Cloud Storage 내에서 파일을 이동하는 작업을 트리거합니다.

오류 핸들러 및 알림

단계에서 null 값, 논리 오류 또는 기타 오류 소스가 발견될 경우 오류 핸들러 플러그인을 사용하여 오류를 포착할 수 있습니다. 이러한 플러그인을 사용하여 변환 또는 분석 플러그인 후 출력에서 오류를 찾습니다. 분석을 위해 오류를 데이터베이스에 기록할 수 있습니다.

다음 단계

- 플러그인 살펴보기

- 플러그인을 사용하여 데이터 파이프라인 만들기