Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

이 페이지에서는 환경을 새 Cloud Composer 또는 Airflow 버전으로 업그레이드하는 방법을 설명합니다.

업그레이드 작업 설명

Cloud Composer 버전, Airflow 버전 또는 둘 다를 동시에 업그레이드할 수 있습니다.

다음 환경에서 사용하는 Airflow 또는 Cloud Composer 버전을 변경하면 다음과 같이 업그레이드됩니다.

Cloud Composer는 Cloud Composer 이미지의 새 버전을 사용하여 환경 구성요소를 다시 배포합니다.

Cloud Composer는 업그레이드 전에 환경에 커스텀 PyPI 패키지 또는 Airflow 구성 옵션 재정의와 같은 Airflow 구성이 있었던 경우 Airflow 구성 변경사항을 적용합니다.

Cloud Composer는 새 Cloud SQL 데이터베이스를 가리키도록 Airflow

airflow_db연결을 업데이트합니다.

업그레이드해도 환경 버킷의 URL 또는 Airflow 웹 서버와 같은 사용자 환경의 리소스에 연결하는 방법은 변경되지 않습니다.

업그레이드 작업의 제한사항

업그레이드 작업에는 다음과 같은 제한사항이 있습니다.

- 이전 버전의 Cloud Composer 또는 Airflow로 다운그레이드할 수는 없습니다.

Google Cloud 콘솔에서는 지원되는 최신 Cloud Composer 버전으로만 업그레이드할 수 있습니다.

Google Cloud CLI, API 또는 Terraform에서 지원되는 최신 버전, 이전 세 가지 버전의 Cloud Composer, 이전 부 버전의 마지막 패치 버전, 업그레이드 타임라인이 연장된 버전으로 환경을 업그레이드할 수 있습니다. 다른 버전의 Cloud Composer가 여전히 지원되고 새 환경을 만드는 데 사용할 수 있더라도 다른 버전의 Cloud Composer로 업그레이드할 수는 없습니다.

업그레이드하려는 버전이 사용자 환경의 현재 Python 버전을 지원해야 합니다.

Compute Engine API 할당량 한도로 인해 업그레이드가 방지될 수 있습니다. Google Cloud 콘솔에서 IAM 및 관리 > 할당량 및 시스템 한도 페이지로 이동하고 CPU의 Compute Engine API 할당량이 초과되지 않았는지 확인합니다. 할당량 기준점에 가까워지면 업그레이드 작업을 진행하기 전에 할당량 확장을 요청하세요.

다른 주 버전의 Cloud Composer 또는 Airflow로 업그레이드할 수 없습니다. 환경 간에 DAG 및 구성을 수동으로 전송할 수 있습니다. 자세한 내용은 다음을 참고하세요.

Airflow 데이터베이스에 16GB가 넘는 데이터가 포함된 경우 환경을 업그레이드할 수 없습니다. Airflow 데이터베이스 크기가 16GB를 초과하면 업그레이드 중 경고가 표시됩니다. 이 경우 데이터베이스 유지보수를 수행하여 데이터베이스 크기를 줄입니다.

XCom 메커니즘을 사용하여 파일을 전송하는 경우 Airflow 가이드라인에 따라 사용해야 합니다. XCom을 사용하여 큰 파일이나 다수의 파일을 전송하면 Airflow 데이터베이스 성능이 영향을 받고 스냅샷을 로드하거나 환경을 업그레이드할 때 오류가 발생할 수 있습니다. 대용량 데이터를 전송하려면 Cloud Storage와 같은 대안을 사용하는 것이 좋습니다.

시작하기 전에

필요한 경우 환경을 다시 만들 수 있도록 환경의 새 스냅샷을 만드는 것이 좋습니다.

계정에 환경 업그레이드 작업을 트리거할 수 있는 역할이 있어야 합니다. 또한 해당 환경의 서비스 계정에 업그레이드 작업을 수행하는 데 충분한 권한이 있는 역할이 있어야 합니다. 자세한 내용은 액세스 제어를 참조하세요.

환경이 최신 상태인지 확인

Cloud Composer는 환경 이미지의 전체 지원 종료 날짜가 다가올 때 경고를 표시합니다. 이러한 경고에 따라 환경을 항상 지원되는 상태로 유지할 수 있습니다.

Cloud Composer는 해당 환경의 기초가 되는 Cloud Composer 이미지 버전을 추적합니다. 지원 종료 날짜가 다가오면 환경 목록 및 환경 세부정보 페이지에 경고가 표시될 수 있습니다.

사용자 환경이 최신 상태인지 확인하려면 다음 안내를 따르세요.

콘솔

Google Cloud 콘솔에서 환경 페이지로 이동합니다.

환경 목록에서 환경 이름을 클릭합니다. 환경 세부정보 페이지가 열립니다.

환경 구성 탭으로 이동합니다.

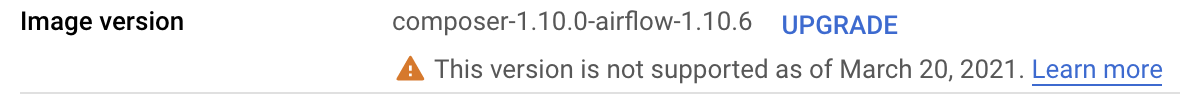

이미지 버전 필드에 다음 메시지 중 하나가 표시됩니다.

사용 가능한 최신 버전. 환경 이미지가 완전히 지원됩니다.

새 버전 사용 가능. 해당 환경 이미지가 완전히 지원되며, 이후 버전으로 업그레이드할 수 있습니다.

이 버전의 지원이 ...에 만료됨 환경 이미지의 지원 기간이 곧 만료됩니다.

이 버전은 ...부터 지원되지 않음 환경의 전체 지원 기간이 지났습니다.

gcloud

이 기능은 Google Cloud CLI에서 제공되지 않습니다. 대신 사용 가능한 업그레이드 보기를 통해 사용 가능한 새 버전을 확인할 수 있습니다.

API

이 기능은 API에서 제공되지 않습니다. 대신 사용 가능한 업그레이드 보기를 통해 사용 가능한 새 버전을 확인할 수 있습니다.

사용 가능한 업그레이드 보기

업그레이드할 수 있는 Cloud Composer 버전을 보려면 다음 안내를 따르세요.

콘솔

Google Cloud 콘솔에서 환경 페이지로 이동합니다.

환경 목록에서 환경 이름을 클릭합니다. 환경 세부정보 페이지가 열립니다.

환경 구성 탭으로 이동하고 이미지 버전 업그레이드를 클릭합니다.

사용 가능한 버전 목록을 보려면 Cloud Composer 이미지 버전 드롭다운 메뉴를 클릭합니다.

gcloud

gcloud composer environments list-upgrades \

ENVIRONMENT_NAME \

--location LOCATION

다음과 같이 바꿉니다.

ENVIRONMENT_NAME: 환경 이름LOCATION: 환경이 위치한 리전

예시:

gcloud composer environments list-upgrades example-environment \

--location us-central1

API

위치에 사용 가능한 버전을 볼 수 있습니다. 이렇게 하려면 imageVersions.list API 요청을 생성합니다.

예를 들면 다음과 같습니다.

// GET https://composer.googleapis.com/v1/projects/example-project/

// locations/us-central1/imageVersions

업그레이드 전 PyPI 패키지 충돌 확인

환경에 설치된 PyPI 패키지가 새 Cloud Composer 이미지의 사전 설치된 패키지와 충돌하는지 확인할 수 있습니다.

검사가 성공하면 현재 버전과 지정된 버전 사이에 PyPI 패키지 종속 항목 충돌이 없는 것입니다. 하지만 다른 이유로 인해 업그레이드 작업이 실패할 수도 있습니다.

콘솔

사용자 환경의 업그레이드 확인을 실행하려면 다음을 수행하세요.

Google Cloud 콘솔에서 환경 페이지로 이동합니다.

환경 목록에서 환경 이름을 클릭합니다. 환경 세부정보 페이지가 열립니다.

환경 구성 탭으로 이동하고 이미지 버전 항목을 찾아서 업그레이드를 클릭합니다.

환경 버전 업그레이드 대화상자의 새 버전 드롭다운 목록에서 업그레이드하려는 Cloud Composer 버전을 선택합니다.

PyPI 패키지 호환성 섹션에서 충돌 확인을 클릭합니다.

검사가 완료될 때까지 기다립니다. PyPI 패키지 종속 항목 충돌이 있으면 표시된 오류 메시지에 충돌하는 패키지 및 패키지 버전에 대한 세부정보가 포함됩니다.

gcloud

환경에 대한 업그레이드 확인을 실행하려면 업그레이드하려는 Cloud Composer 이미지 버전으로 environments check-upgrade 명령어를 실행합니다.

gcloud composer environments check-upgrade \

ENVIRONMENT_NAME \

--location LOCATION \

--image-version VERSION

다음과 같이 바꿉니다.

ENVIRONMENT_NAME: 환경 이름LOCATION: 환경이 위치한 리전VERSION을composer-a.b.c-airflow-x.y.z형식의 업그레이드할 새 Cloud Composer 이미지 버전으로 바꿉니다. 모든 버전 별칭을 사용할 수도 있습니다.

예시:

gcloud composer environments check-upgrade example-environment \

--location us-central1 \

--image-version composer-1.20.12-airflow-1.10.15

출력 예시:

Waiting for [projects/example-project/locations/us-central1/environments/

example-environment] to be checked for PyPI package conflicts when upgrading

to composer-1.20.12-airflow-1.10.15. Operation [projects/example-project/locations/

us-central1/operations/04d0e8b2-...]...done.

...

Response:

'@type': type.googleapis.com/

google.cloud.orchestration.airflow.service.v1.CheckUpgradeResponse

buildLogUri: https://console.cloud.google.com/cloud-build/builds/79738aa7-...

containsPypiModulesConflict: CONFLICT

pypiConflictBuildLogExtract: |-

The Cloud Build image build failed: Build failed; check build logs for

details. Full log can be found at https://console.cloud.google.com/

cloud-build/builds/79738aa7-...

Error details: tensorboard 2.2.2 has requirement

setuptools>=41.0.0, but you have setuptools 40.3.0.

또는 업그레이드 검사를 비동기적으로 실행할 수 있습니다. --async 인수를 사용하여 비동기 호출을 수행하고 gcloud composer operations describe 명령어로 결과를 확인합니다.

API

environments.checkUpgrade API 요청을 생성합니다.

imageVersion 필드에 이미지 버전을 지정합니다.

{

"imageVersion": "VERSION"

}

VERSION을 composer-a.b.c-airflow-x.y.z 형식의 업그레이드할 새 버전으로 바꿉니다.

환경 업그레이드

환경을 Cloud Composer 또는 Airflow의 이후 버전으로 업그레이드하려면 다음 안내를 따르세요.

콘솔

Google Cloud 콘솔에서 환경 페이지로 이동합니다.

환경 목록에서 환경 이름을 클릭합니다. 환경 세부정보 페이지가 열립니다.

환경 구성 탭으로 이동합니다.

이미지 버전 항목을 찾아 업그레이드를 클릭합니다.

이미지 버전 드롭다운 메뉴에서 업그레이드하려는 Cloud Composer 버전을 선택합니다.

업그레이드를 클릭합니다.

gcloud

gcloud composer environments update \

ENVIRONMENT_NAME \

--location LOCATION \

--image-version VERSION

다음과 같이 바꿉니다.

ENVIRONMENT_NAME: 환경 이름LOCATION: 환경이 위치한 리전VERSION을composer-a.b.c-airflow-x.y.z형식의 업그레이드할 새 Cloud Composer 이미지 버전으로 바꿉니다. 모든 버전 별칭을 사용할 수도 있습니다.

예를 들면 다음과 같습니다.

gcloud composer environments update

example-environment \

--location us-central1 \

--image-version composer-1.20.12-airflow-1.10.15

API

environments.patchAPI 요청을 생성합니다.이 요청의 작성 방법:

updateMask매개변수에서config.softwareConfig.imageVersion마스크를 지정합니다.요청 본문의

imageVersion필드에서 업그레이드하려는 새 버전을 지정합니다.

예를 들면 다음과 같습니다.

// PATCH https://composer.googleapis.com/v1/projects/example-project/

// locations/us-central1/environments/example-environment?updateMask=

// config.softwareConfig.imageVersion

{

"config": {

"softwareConfig": {

"imageVersion": "composer-1.20.12-airflow-1.10.15"

}

}

}

Terraform

config.software_config 블록의 image_version 필드는 환경의 Cloud Composer 이미지를 제어합니다. 이 필드에 새 Cloud Composer 이미지를 지정합니다.

resource "google_composer_environment" "example" {

provider = google-beta

name = "ENVIRONMENT_NAME"

region = "LOCATION"

config {

software_config {

image_version = "VERSION"

}

}

}

다음과 같이 바꿉니다.

ENVIRONMENT_NAME: 환경 이름LOCATION: 환경이 위치한 리전 업그레이드할 새 Cloud Composer 이미지 버전(composer-a.b.c-airflow-x.y.z형식)입니다. 모든 버전 별칭을 사용할 수도 있습니다.

예시:

resource "google_composer_environment" "example" {

provider = google-beta

name = "example-environment"

region = "us-central1"

config {

software_config {

image_version = "composer-1.20.12-airflow-1.10.15"

}

}

}