En este documento se explica cómo monitorizar el comportamiento, el estado y el rendimiento de los modelos totalmente gestionados en Vertex AI. Describe cómo usar el panel de control de observabilidad de modelos precompilados para obtener información valiosa sobre el uso de los modelos, identificar problemas de latencia y solucionar errores.

Aprenderás a hacer lo siguiente:

- Acceder al panel de control de observabilidad del modelo e interpretarlo.

- Consulta las métricas de monitorización disponibles.

- Monitoriza el tráfico de los endpoints de modelos con el explorador de métricas.

Acceder al panel de control de observabilidad del modelo e interpretarlo

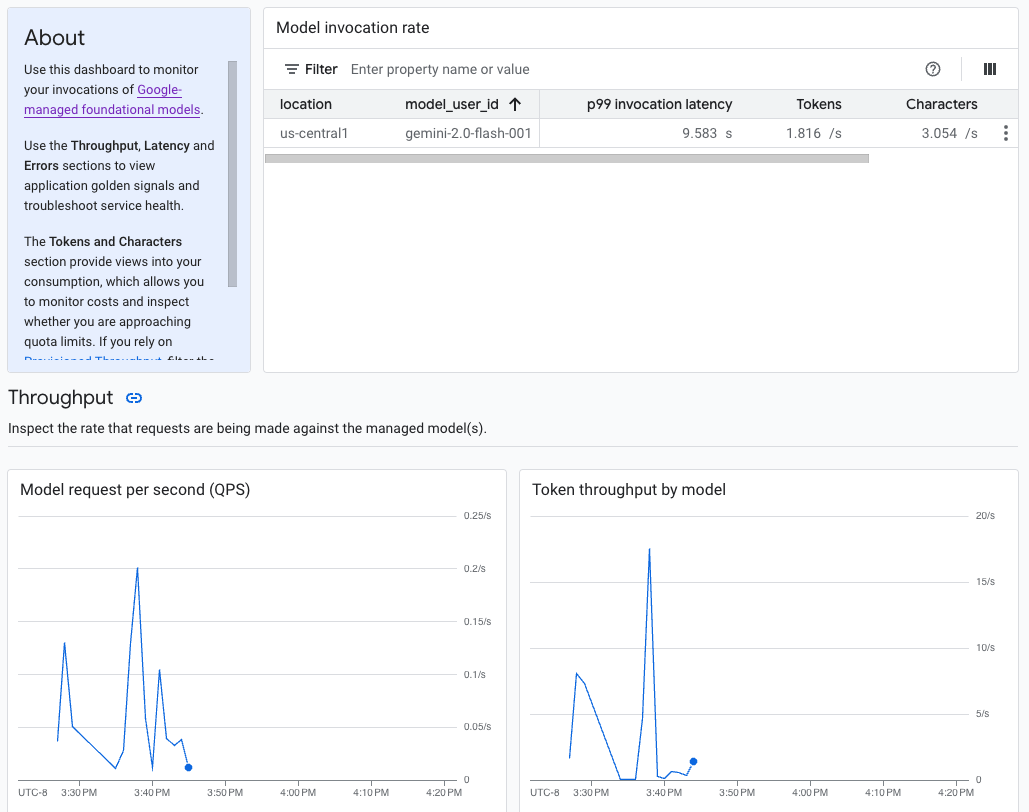

La IA generativa en Vertex AI proporciona un panel de control de observabilidad de modelos precompilado para ver el comportamiento, el estado y el rendimiento de los modelos totalmente gestionados. Google proporciona modelos totalmente gestionados, también conocidos como modelo como servicio (MaaS), que incluyen los modelos de Gemini de Google y los modelos de partners con endpoints gestionados. Las métricas de los modelos autohospedados no se incluyen en el panel de control.

La IA generativa en Vertex AI recoge y registra automáticamente la actividad de los modelos de MaaS para ayudarte a solucionar rápidamente los problemas de latencia y monitorizar la capacidad.

Caso práctico

Como desarrollador de aplicaciones, puede ver cómo interactúan sus usuarios con los modelos que ha expuesto. Por ejemplo, puede ver cómo evolucionan con el tiempo el uso del modelo (solicitudes de modelo por segundo) y la intensidad computacional de las peticiones de los usuarios (latencias de invocación del modelo). Por lo tanto, como estas métricas están relacionadas con el uso del modelo, también puedes estimar los costes de ejecutar cada modelo.

Si se produce un problema, puedes solucionarlo rápidamente desde el panel de control. Puedes comprobar si los modelos responden de forma fiable y oportuna consultando las tasas de errores de la API, las latencias del primer token y el rendimiento de los tokens.

Métricas de monitorización disponibles

El panel de control de observabilidad del modelo muestra un subconjunto de métricas que recoge Cloud Monitoring, como las solicitudes de modelo por segundo (QPS), el rendimiento de los tokens y las latencias del primer token. Consulta el panel de control para ver todas las métricas disponibles.

Limitaciones

Vertex AI solo registra las métricas del panel de control de las llamadas a la API al endpoint de un modelo. Google Cloud El uso de la consola, como las métricas de Vertex AI Studio, no se añade al panel de control.

Consultar el panel de control

- En la sección Vertex AI de la Google Cloud consola, ve a la página Panel de control.

Ve a Vertex AI. 1. En el panel de control, en Observabilidad del modelo, haga clic en Mostrar todas las métricas para ver el panel de observabilidad del modelo en la consola de Google Cloud Observability.

Para ver las métricas de un modelo específico o de una ubicación concreta, defina uno o varios filtros en la parte superior de la página del panel de control.

Para ver las descripciones de cada métrica, consulte la sección "

aiplatform" de la página Google Cloud Métricas.

Monitorizar el tráfico de endpoints de modelos

Sigue estas instrucciones para monitorizar el tráfico de tu endpoint en el explorador de métricas.

En la Google Cloud consola, ve a la página Explorador de métricas.

Selecciona el proyecto cuyas métricas quieras ver.

En el menú desplegable Métrica, haga clic en Seleccionar una métrica.

En la barra de búsqueda Filtrar por nombre de recurso o métrica, introduce

Vertex AI Endpoint.Seleccione la categoría de métrica Endpoint de Vertex AI > Predicción. En Métricas activas, seleccione una de las siguientes métricas:

prediction/online/error_countprediction/online/prediction_countprediction/online/prediction_latenciesprediction/online/response_count

Haz clic en Aplicar. Para añadir más de una métrica, haga clic en Añadir consulta.

Puede filtrar o agregar sus métricas mediante los siguientes menús desplegables:

Para seleccionar y ver un subconjunto de sus datos en función de los criterios especificados, utilice el menú desplegable Filtrar. Por ejemplo, para filtrar por el modelo

gemini-2.0-flash-001, usaendpoint_id = gemini-2p0-flash-001(ten en cuenta que el.de la versión del modelo se sustituye por unp).Para combinar varios puntos de datos en un solo valor y ver un resumen de las métricas, usa el menú desplegable Agregación. Por ejemplo, puedes agregar la Suma de

response_code.

También puedes configurar alertas para tu endpoint. Para obtener más información, consulta Gestionar políticas de alertas.

Para ver las métricas que añades a tu proyecto mediante un panel de control, consulta el artículo Descripción general de los paneles de control.

Siguientes pasos

- Para saber cómo crear alertas para tu panel de control, consulta el artículo Introducción a las alertas.

- Para obtener información sobre la conservación de datos de métricas, consulta las cuotas y los límites de Monitoring.

- Para obtener información sobre los datos en reposo, consulta el artículo Proteger los datos en reposo.

- Para ver una lista de todas las métricas que recoge Cloud Monitoring, consulta la sección "

aiplatform" de la página Google Cloud métricas.