En esta página, se describe la configuración de GPU para tus servicios de Cloud Run. Las GPUs funcionan bien para cargas de trabajo de inferencia de IA, como los modelos de lenguaje grandes (LLM) u otros casos de uso que no son de IA con gran demanda de procesamiento, como la transcodificación de videos y la renderización en 3D. Google proporciona GPU NVIDIA L4 con 24 GB de memoria de GPU (VRAM), que es independiente de la memoria de la instancia.

La GPU en Cloud Run está completamente administrada, sin necesidad de controladores ni bibliotecas adicionales. La función de GPU ofrece disponibilidad a pedido sin necesidad de reservas, similar a la forma en que funcionan la CPU y la memoria a pedido en Cloud Run. Las instancias de un servicio de Cloud Run que se configuró para usar GPU pueden reducir la escala verticalmente a cero para ahorrar costos cuando no están en uso.

Las instancias de Cloud Run con una GPU L4 conectada con controladores preinstalados comienzan en aproximadamente 5 segundos, momento en los que los procesos que se ejecutan en tu contenedor pueden comenzar a usar la GPU.

Puedes configurar una GPU por instancia de Cloud Run. Si usas contenedores secundarios, ten en cuenta que la GPU solo se puede conectar a un contenedor.

Regiones admitidas

asia-southeast1(Singapur)asia-south1(Bombay) . Esta región solo está disponible por invitación. Comunícate con tu equipo de Cuentas de Google si te interesa esta región.europe-west1(Bélgica)Bajo nivel de CO2

europe-west4(Países Bajos)Bajo nivel de CO2

us-central1(Iowa)Bajo nivel de CO2

us-east4(Virginia del Norte)

Tipos de GPU compatibles

Puedes usar una GPU L4 por instancia de Cloud Run. Una GPU L4 tiene los siguientes controladores preinstalados:

- La versión actual del controlador NVIDIA: 535.216.03 (CUDA 12.2)

Impacto en los precios

Consulta los precios de Cloud Run para obtener detalles sobre los precios de las GPU. Ten en cuenta los siguientes requisitos y consideraciones:

- No se aplican tarifas por solicitud. Debes usar la facturación basada en instancias para usar la función de GPU. Las instancias mínimas se cobran a la tarifa completa, incluso cuando están inactivas.

- Existe una diferencia en el costo entre la redundancia zonal de GPU y la redundancia no zonal. Consulta los precios de Cloud Run para obtener detalles sobre los precios de las GPU.

- Cuando implementas servicios o funciones desde código fuente con configuración de GPU usando

gcloud beta, Cloud Run usa el tipo de máquinae2-highcpu-8, en lugar del tipo de máquinae2-standard-2predeterminado (versión preliminar). El tipo de máquina más grande proporciona mayor compatibilidad con la CPU y mayor ancho de banda de red, lo que genera tiempos de compilación más rápidos. - Debes usar un mínimo de 4 CPU y 16 GiB de memoria.

- La GPU se factura por la duración completa del ciclo de vida de la instancia.

Opciones de redundancia zonal de GPU

De forma predeterminada, Cloud Run implementa tu servicio en varias zonas dentro de una región. Esta arquitectura proporciona resiliencia inherente: si una zona experimenta una interrupción, Cloud Run enruta automáticamente el tráfico fuera de la zona afectada hacia las zonas en buen estado dentro de la misma región.

Cuando trabajes con recursos de GPU, ten en cuenta que estos tienen restricciones de capacidad específicas. Durante una interrupción zonal, el mecanismo de conmutación por error estándar para las cargas de trabajo de GPU se basa en que haya suficiente capacidad de GPU sin usar disponible en las zonas en buen estado restantes. Debido a la naturaleza limitada de las GPUs, es posible que esta capacidad no siempre esté disponible.

Para aumentar la disponibilidad de tus servicios acelerados por GPU durante las interrupciones zonales, puedes configurar la redundancia zonal específicamente para las GPU:

Redundancia zonal activada (predeterminado): Cloud Run reserva capacidad de GPU para tu servicio en varias zonas. Esto aumenta significativamente la probabilidad de que tu servicio pueda controlar con éxito el tráfico redireccionado desde una zona afectada, lo que ofrece una mayor confiabilidad durante las fallas zonales con un costo adicional por segundo de GPU.

Redundancia zonal desactivada: Cloud Run intenta realizar una conmutación por error para las cargas de trabajo de GPU según el criterio del mejor esfuerzo. El tráfico se enruta a otras zonas solo si hay suficiente capacidad de GPU disponible en ese momento. Esta opción no garantiza la capacidad reservada para situaciones de conmutación por error, pero genera un costo más bajo por segundo de GPU.

ANS

El SLA de Cloud Run con GPU depende de si el servicio usa la opción de redundancia zonal o no zonal. Consulta la página del ANS para obtener más detalles.

Solicita un aumento de la cuota

Los proyectos que usan GPUs de Cloud Run nvidia-l4 en una región por primera vez reciben automáticamente una cuota de 3 GPUs (redundancia zonal desactivada) cuando se crea la primera implementación.

Si necesitas GPUs adicionales de Cloud Run, debes solicitar un aumento de cuota para tu servicio de Cloud Run. Usa los vínculos que se proporcionan en los siguientes botones para solicitar la cuota que necesitas.

| Se requiere cuota | Vínculo de cuota |

|---|---|

| GPU con redundancia zonal desactivada (precio más bajo) | Solicita una cuota de GPU sin redundancia zonal |

| GPU con redundancia zonal activada (precio más alto) | Solicita una cuota de GPU con redundancia zonal |

Si deseas obtener más información para solicitar aumentos de cuota, consulta Cómo aumentar la cuota.

Antes de comenzar

En la siguiente lista, se describen los requisitos y las limitaciones que se aplican cuando se usan GPUs en Cloud Run:

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Run API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Solicita la cuota requerida.

- Consulta Prácticas recomendadas: Inferencia de IA en Cloud Run con GPUs para obtener recomendaciones sobre cómo compilar tu imagen de contenedor y cargar modelos grandes.

- Asegúrate de que tu servicio de Cloud Run tenga la siguiente configuración:

- Configura los parámetros de facturación en la facturación basada en instancias. Ten en cuenta que los servicios configurados para la facturación basada en instancias aún pueden reducir su escala a cero.

- Configura un mínimo de 4 CPU para tu servicio, con 8 CPU recomendadas.

- Configura un mínimo de 16 GiB de memoria, con 32 GiB recomendados.

- Determina y establece una simultaneidad máxima óptima para el uso de GPU.

- La cantidad máxima de instancias debe establecerse en un número inferior a la cuota por proyecto y por región permitida para la GPU. Consulta Acerca de las GPUs y las instancias máximas.

-

Desarrollador de Cloud Run (

roles/run.developer): El servicio de Cloud Run -

Usuario de la cuenta de servicio (

roles/iam.serviceAccountUser): Es la identidad del servicio. En la consola de Google Cloud , ve a Cloud Run:

Selecciona Servicios en el menú y haz clic en Implementar contenedor para configurar un servicio nuevo. Si quieres configurar un servicio existente, haz clic en el servicio y, luego, en implementar y editar la nueva revisión.

Si configuras un servicio nuevo, completa la página de configuración del servicio inicial como desees y haz clic en Contenedores, volúmenes, Herramientas de redes y seguridad para expandir la página de configuración del servicio.

Haz clic en la pestaña Contenedor.

- Configura la CPU, la memoria, la simultaneidad, el entorno de ejecución y el sondeo de inicio según las recomendaciones que se indican en Antes de comenzar.

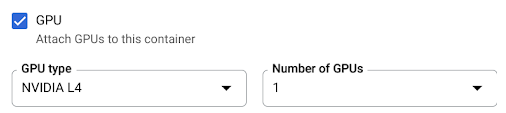

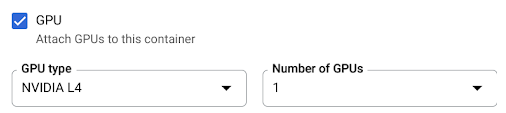

- Marca la casilla de verificación de GPU y, luego, selecciona el tipo de GPU en el menú Tipo de GPU y la cantidad de GPU en el menú Cantidad de GPU.

- De forma predeterminada, la redundancia zonal está activada para los servicios nuevos. Para cambiar el parámetro de configuración actual, selecciona la casilla de verificación de GPU para mostrar las opciones de redundancia de GPU.

- Selecciona Sin redundancia zonal para desactivar la redundancia zonal.

- Selecciona Redundancia zonal para activar la redundancia zonal.

Haz clic en Crear o Implementar.

Para implementar un contenedor, haz lo siguiente:

gcloud run deploy SERVICE \ --image IMAGE_URL \ --gpu 1

Reemplaza lo siguiente:

- SERVICE: El nombre de tu servicio de Cloud Run.

- IMAGE_URL: Es una referencia a la imagen del contenedor, por ejemplo,

us-docker.pkg.dev/cloudrun/container/hello:latest. Si usas Artifact Registry, el repositorio REPO_NAME debe estar creado. La URL sigue el formato deLOCATION-docker.pkg.dev/PROJECT_ID/REPO_NAME/PATH:TAG.

Para implementar el código fuente y permitir que Cloud Run use de forma predeterminada el tipo de máquina

e2-highcpu-8de Cloud Build, usa el comandogcloud beta run deploy:gcloud beta run deploy SERVICE \ --source . \ --gpu 1

- SERVICE: El nombre de tu servicio de Cloud Run.

- IMAGE_URL: Es una referencia a la imagen del contenedor, por ejemplo,

us-docker.pkg.dev/cloudrun/container/hello:latest. Si usas Artifact Registry, el repositorio REPO_NAME debe estar creado. La URL sigue el formato deLOCATION-docker.pkg.dev/PROJECT_ID/REPO_NAME/PATH:TAG. - CPU: Es la cantidad de CPU. Debes especificar al menos

4CPU. - MEMORY: Es la cantidad de memoria. Debes especificar al menos

16Gi(16 GiB). - GPU_NUMBER: El valor

1(uno). Si no se especifica, pero hay un GPU_TYPE presente, el valor predeterminado es1. - GPU_TYPE es el tipo de GPU. Si no se especifica, pero hay un GPU_NUMBER, el valor predeterminado es

nvidia-l4(nvidiaL4 con "L" minúscula, no el valor numérico catorce). - MAX_INSTANCE: Es la cantidad máxima de instancias. Esta cantidad no puede exceder la cuota de GPU asignada a tu proyecto.

- GPU_ZONAL_REDUNDANCY:

no-gpu-zonal-redundancypara desactivar la redundancia zonal ogpu-zonal-redundancypara activarla Si creas un servicio nuevo, omite este paso. Si actualizas un servicio existente, descarga su configuración de YAML:

gcloud run services describe SERVICE --format export > service.yaml

Actualiza los atributos

nvidia.com/gpu:ynodeSelector::

run.googleapis.com/accelerator:apiVersion: serving.knative.dev/v1 kind: Service metadata: name: SERVICE spec: template: metadata: annotations: autoscaling.knative.dev/maxScale: 'MAX_INSTANCE' run.googleapis.com/cpu-throttling: 'false' run.googleapis.com/gpu-zonal-redundancy-disabled: 'GPU_ZONAL_REDUNDANCY' spec: containers: - image: IMAGE_URL ports: - containerPort: CONTAINER_PORT name: http1 resources: limits: cpu: 'CPU' memory: 'MEMORY' nvidia.com/gpu: '1' # Optional: use a longer startup probe to allow long starting containers startupProbe: failureThreshold: 1800 periodSeconds: 1 tcpSocket: port: CONTAINER_PORT timeoutSeconds: 1 nodeSelector: run.googleapis.com/accelerator: GPU_TYPE

Reemplaza lo siguiente:

- SERVICE: El nombre de tu servicio de Cloud Run.

- IMAGE_URL: Es una referencia a la imagen del contenedor, por ejemplo,

us-docker.pkg.dev/cloudrun/container/hello:latest. Si usas Artifact Registry, el repositorio REPO_NAME debe estar creado. La URL sigue el formato deLOCATION-docker.pkg.dev/PROJECT_ID/REPO_NAME/PATH:TAG. - CONTAINER_PORT: Es el puerto del contenedor establecido para tu servicio.

- CPU: Es la cantidad de CPU. Debes especificar al menos

4CPU. - MEMORY: Es la cantidad de memoria. Debes especificar al menos

16Gi(16 GiB). - GPU_TYPE: El valor

nvidia-l4(nvidia-L4 con "L" minúscula, no el valor numérico catorce). - MAX_INSTANCE: Es la cantidad máxima de instancias. Esta cantidad no puede exceder la cuota de GPU asignada a tu proyecto.

- GPU_ZONAL_REDUNDANCY:

falsepara activar la redundancia zonal de la GPU otruepara desactivarla

Crea o actualiza el servicio con el siguiente comando:

gcloud run services replace service.yaml

- SERVICE: El nombre de tu servicio de Cloud Run.

- GPU_ZONAL_REDUNDANCY:

falsepara activar la redundancia zonal de la GPU otruepara desactivarla - IMAGE_URL: Es una referencia a la imagen del contenedor, por ejemplo,

us-docker.pkg.dev/cloudrun/container/hello:latest. Si usas Artifact Registry, el repositorio REPO_NAME debe estar creado. La URL sigue el formato deLOCATION-docker.pkg.dev/PROJECT_ID/REPO_NAME/PATH:TAG. - CPU: Es la cantidad de CPU. Debes especificar al menos

4CPU. - MEMORY: Es la cantidad de memoria. Debes especificar al menos

16Gi(16 GiB). - GPU_TYPE: El valor

nvidia-l4(nvidia-L4 con "L" minúscula, no el valor numérico catorce). En la consola de Google Cloud , ve a Cloud Run:

Haz clic en el servicio que te interesa para abrir la página Detalles del servicio.

Haz clic en la pestaña Revisiones.

En el panel de detalles a la derecha, la configuración de GPU aparece en la pestaña Contenedor.

Usa el siguiente comando:

gcloud run services describe SERVICE

Busca la configuración de GPU en la configuración mostrada.

En la consola de Google Cloud , ve a Cloud Run:

Selecciona Servicios en el menú y haz clic en Implementar contenedor para configurar un servicio nuevo. Si quieres configurar un servicio existente, haz clic en el servicio y, luego, en implementar y editar la nueva revisión.

Si configuras un servicio nuevo, completa la página de configuración del servicio inicial como desees y haz clic en Contenedores, volúmenes, Herramientas de redes y seguridad para expandir la página de configuración del servicio.

Haz clic en la pestaña Contenedor.

- Desmarca la casilla de verificación GPU.

Haz clic en Crear o Implementar.

Si creas un servicio nuevo, omite este paso. Si actualizas un servicio existente, descarga su configuración de YAML:

gcloud run services describe SERVICE --format export > service.yaml

Borra las líneas

nvidia.com/gpu:ynodeSelector: run.googleapis.com/accelerator: nvidia-l4.Crea o actualiza el servicio con el siguiente comando:

gcloud run services replace service.yaml

- La configuración Cantidad máxima de instancias limita la cantidad de instancias por servicio. No se puede establecer un valor superior a la cuota por proyecto y por región para GPU.

- Es la cuota de GPUs permitida por proyecto y por región. Esto limita la cantidad de instancias entre servicios de la misma región.

Roles requeridos

Para obtener los permisos que necesitas para configurar y, luego, implementar los servicios de Cloud Run, pídele a tu administrador que te otorgue los siguientes roles de IAM en los servicios:

Si implementas un servicio o una función desde el código fuente, también debes tener roles adicionales otorgados en tu proyecto y en la cuenta de servicio de Cloud Build.

Para obtener una lista de los roles y los permisos de IAM asociados con Cloud Run, consulta los roles de IAM de Cloud Run y los permisos de IAM de Cloud Run. Si tu servicio de Cloud Run interactúa con las APIs deGoogle Cloud , como las bibliotecas cliente de Cloud, consulta la guía de configuración de identidades del servicio. Para obtener más información sobre cómo otorgar roles, consulta permisos de implementación y administra el acceso.

Configura un servicio de Cloud Run con GPU

Cualquier cambio en la configuración conlleva la creación de una revisión nueva. Las revisiones posteriores también adoptarán esta configuración de manera automática, a menos que realices actualizaciones explícitas para cambiarla.

Puedes usar la Google Cloud consola, Google Cloud CLI o YAML para configurar la GPU.

Console

gcloud

Para crear un servicio con la GPU habilitada, usa el comando gcloud run deploy:

Para actualizar la configuración de la GPU de un servicio, usa el comando gcloud run services update:

gcloud run services update SERVICE \ --image IMAGE_URL \ --cpu CPU \ --memory MEMORY \ --no-cpu-throttling \ --gpu GPU_NUMBER \ --gpu-type GPU_TYPE \ --max-instances MAX_INSTANCE --GPU_ZONAL_REDUNDANCY

Reemplaza lo siguiente:

YAML

Terraform

Si deseas obtener más información para aplicar o quitar una configuración de Terraform, consulta los comandos básicos de Terraform.

Agrega lo siguiente a un recursogoogle_cloud_run_v2_service en tu configuración de Terraform:resource "google_cloud_run_v2_service" "default" {

provider = google-beta

name = "SERVICE"

location = "europe-west1"

template {

gpu_zonal_redundancy_disabled = "GPU_ZONAL_REDUNDANCY"

containers {

image = "IMAGE_URL"

resources {

limits = {

"cpu" = "CPU"

"memory" = "MEMORY"

"nvidia.com/gpu" = "1"

}

}

}

node_selector {

accelerator = "GPU_TYPE"

}

}

}

Reemplaza lo siguiente:

Visualiza la configuración de GPU

Para ver la configuración actual de GPU de tu servicio de Cloud Run, sigue estos pasos:

Console

gcloud

Cómo quitar GPU

Puedes quitar la GPU con la Google Cloud consola, Google Cloud CLI o YAML.

Console

gcloud

Para quitar la GPU, establece la cantidad de GPUs en 0 con el comando gcloud run services update:

gcloud run services update SERVICE --gpu 0

SERVICE por el nombre de tu servicio de Cloud Run.

YAML

Bibliotecas

De forma predeterminada, se activan todas las bibliotecas de controladores de NIVIDIA L4 en /usr/local/nvidia/lib64. Cloud Run agrega automáticamente esta ruta de acceso a la variable de entorno LD_LIBRARY_PATH (es decir, ${LD_LIBRARY_PATH}:/usr/local/nvidia/lib64) del contenedor con la GPU. Esto permite que el vinculador dinámico encuentre las bibliotecas de controladores de NVIDIA. El vinculador busca y resuelve rutas de acceso en el orden en que las enumeras en la variable de entorno LD_LIBRARY_PATH. Los valores que especifiques en esta variable tendrán prioridad sobre la ruta de acceso predeterminada de las bibliotecas del controlador de Cloud Run /usr/local/nvidia/lib64.

Si quieres usar una versión de CUDA superior a 12.2, la forma más fácil es depender de una imagen base de NVIDIA más reciente con paquetes de retrocompatibilidad ya instalados. Otra opción es instalar manualmente los paquetes de compatibilidad con versiones futuras de NVIDIA y agregarlos a LD_LIBRARY_PATH. Consulta la matriz de compatibilidad de NVIDIA para determinar qué versiones de CUDA son compatibles con la versión del controlador NVIDIA proporcionada (535.216.03).

Acerca de las GPUs y la cantidad máxima de instancias

La cantidad de instancias con GPUs está limitada de dos maneras: