Exécuter un pipeline à l'aide du générateur de jobs

Ce guide de démarrage rapide explique comment exécuter un job Dataflow à l'aide du générateur de jobs Dataflow. Le générateur de jobs est une interface utilisateur visuelle permettant de créer et d'exécuter des pipelines Dataflow dans la console Google Cloud, sans avoir à écrire de code.

Dans ce guide de démarrage rapide, vous allez charger un exemple de pipeline dans le générateur de jobs, exécuter un job et vérifier que le job a créé une sortie.

Avant de commencer

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

Enable the Dataflow, Compute Engine, Cloud Logging, Cloud Storage, Google Cloud Storage JSON, and Resource Manager APIs.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

Enable the Dataflow, Compute Engine, Cloud Logging, Cloud Storage, Google Cloud Storage JSON, and Resource Manager APIs.

- Créez un bucket Cloud Storage :

- In the Google Cloud console, go to the Cloud Storage Buckets page.

- Click Create bucket.

- On the Create a bucket page, enter your bucket information. To go to the next

step, click Continue.

- For Name your bucket, enter a unique bucket name. Don't include sensitive information in the bucket name, because the bucket namespace is global and publicly visible.

-

For Choose where to store your data, do the following:

- Select a Location type option.

- Select a Location option.

- For Choose a default storage class for your data, select the following: Standard.

- For Choose how to control access to objects, select an Access control option.

- For Advanced settings (optional), specify an encryption method, a retention policy, or bucket labels.

- Click Create.

Pour suivre la procédure de ce guide de démarrage rapide, votre compte utilisateur doit disposer du rôle Administrateur Dataflow et du rôle Utilisateur du compte de service. Le compte de service Compute Engine par défaut doit disposer du rôle Nœud de calcul Dataflow. Pour ajouter les rôles requis dans la console Google Cloud, procédez comme suit :

- Accédez à la page IAM.

Accéder à IAM - Sélectionnez votre projet.

- Sur la ligne contenant votre compte utilisateur, cliquez sur Modifier le compte principal.

- Cliquez sur Ajouter un autre rôle, puis dans la liste déroulante, sélectionnez Administrateur Dataflow.

- Cliquez sur Ajouter un autre rôle, puis sélectionnez Utilisateur du compte de service dans la liste déroulante.

- Cliquez sur Enregistrer.

- Sur la ligne contenant le compte de service Compute Engine par défaut, cliquez sur Modifier le compte principal.

- Cliquez sur Ajouter un autre rôle, puis sélectionnez Nœud de calcul Dataflow dans la liste déroulante.

- Cliquez sur Ajouter un autre rôle, puis dans la liste déroulante, sélectionnez Administrateur des objets Storage.

Cliquez sur Enregistrer.

Pour en savoir plus sur l'attribution de rôles, consultez la page Attribuer un rôle IAM à l'aide de la console.

- Accédez à la page IAM.

- Par défaut, chaque nouveau projet démarre avec un réseau par défaut.

Si le réseau par défaut de votre projet est désactivé ou a été supprimé, vous devez disposer d'un réseau dans votre projet pour lequel votre compte utilisateur dispose du Rôle d'utilisateur de réseau de Compute (

roles/compute.networkUser).

Charger l'exemple de pipeline

À cette étape, vous allez charger un exemple de pipeline qui compte les mots dans Le Roi Lear de Shakespeare.

Accédez à la page Jobs dans la console Google Cloud.

Cliquez sur Créer un job à partir d'un modèle.

Cliquez sur Générateur de tâches.

Cliquez sur Charger.

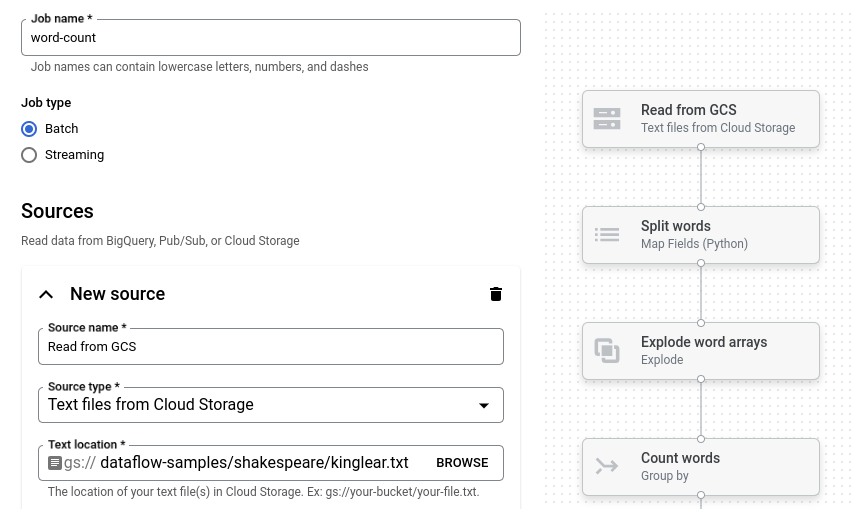

Cliquez sur Nombre de mots. Le générateur de jobs est renseigné avec une représentation graphique du pipeline.

Pour chaque étape du pipeline, le générateur de jobs affiche une fiche qui spécifie les paramètres de configuration de cette étape. Par exemple, la première étape lit les fichiers texte à partir de Cloud Storage. L'emplacement des données sources est prérempli dans la zone Emplacement du texte.

Définir l'emplacement de sortie

Au cours de cette étape, vous allez spécifier un bucket Cloud Storage dans lequel le pipeline écrit la sortie.

Recherchez la fiche intitulée Nouveau récepteur. Vous devrez peut-être faire défiler la page.

Dans la zone Emplacement du texte, cliquez sur Parcourir.

Sélectionnez le nom du bucket Cloud Storage que vous avez créé dans la section Avant de commencer.

Cliquez sur Afficher les ressources enfants.

Dans la zone "Nom de fichier", saisissez

words.Cliquez sur Sélectionner.

Exécuter le job

Cliquez sur Run Job (Exécuter la tâche). Le générateur de jobs crée un job Dataflow, puis accède au graphique de job. Au démarrage du job, le graphique de job affiche une représentation graphique du pipeline, semblable à celle affichée dans le générateur de jobs. À chaque étape du pipeline, l'état est mis à jour dans le graphique de job.

Le panneau Informations sur le job affiche l'état général du job. Si le job se termine correctement, le champ État du job est défini sur Succeeded.

Examiner le résultat du job

Une fois le job terminé, procédez comme suit pour afficher la sortie du pipeline :

Dans la console Google Cloud, accédez à la page Buckets Cloud Storage.

Dans la liste des buckets, cliquez sur le nom du bucket que vous avez créé à la section Avant de commencer.

Cliquez sur le fichier nommé

words-00000-of-00001.Sur la page Détails de l'objet, cliquez sur l'URL authentifiée pour afficher la sortie du pipeline.

Le résultat doit ressembler à ce qui suit :

brother: 20

deeper: 1

wrinkles: 1

'alack: 1

territory: 1

dismiss'd: 1

[....]

Effectuer un nettoyage

Pour éviter que les ressources utilisées dans cette page soient facturées sur votre compte Google Cloud, procédez comme suit :

Supprimer le projet

Le moyen le plus simple d'éviter la facturation consiste à supprimer le projet Google Cloud que vous avez créé dans le cadre de ce guide de démarrage rapide.

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

Supprimer les ressources individuelles

Si vous souhaitez conserver le projet Google Cloud que vous avez utilisé dans ce guide de démarrage rapide, supprimez le bucket Cloud Storage :

- In the Google Cloud console, go to the Cloud Storage Buckets page.

- Click the checkbox for the bucket that you want to delete.

- To delete the bucket, click Delete, and then follow the instructions.