Cargas de trabalho altamente paralelas de HPC do Dataflow

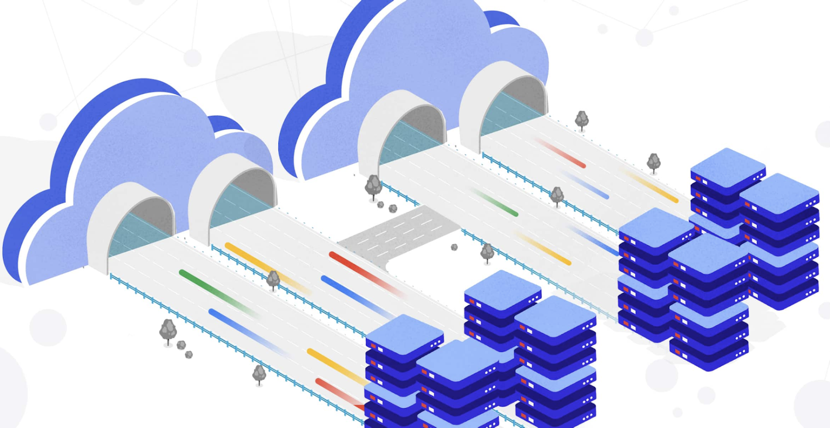

Quando trabalha com computação em grelha de grande volume, use o Dataflow para executar cargas de trabalho de HPC altamente paralelas num sistema totalmente gerido. Com o Dataflow, pode executar as suas cargas de trabalho altamente paralelas num único pipeline, o que melhora a eficiência e facilita a gestão do seu fluxo de trabalho. Os dados permanecem num sistema para pré-processamento, pós-processamento e processamento de tarefas. O Dataflow gere automaticamente as necessidades de desempenho, escalabilidade, disponibilidade e segurança.

Tutorial de contentor personalizado

Siga este tutorial para ver um exemplo completo de um pipeline altamente paralelo de HPC que usa contentores personalizados com bibliotecas C++.

Práticas recomendadas para HPC altamente paralelos

Saiba mais sobre as práticas recomendadas a ter em conta ao criar o seu pipeline altamente paralelo de HPC.

Recursos

Use GPUs

A utilização de GPUs em tarefas do Dataflow pode acelerar o processamento de imagens e as tarefas de processamento de aprendizagem automática.

Caso prático

O HSBC usou um fluxo de trabalho altamente paralelo de HPC do Dataflow para aumentar a capacidade e a velocidade de cálculo, ao mesmo tempo que reduzia os custos.

Veja os exemplos no GitHub

O exemplo de pipeline altamente paralelo do HPC do Dataflow e o código fonte correspondente estão disponíveis no GitHub.