In dieser Anleitung wird beschrieben, wie Sie mit privaten Cloud Build-Pools auf die Steuerungsebene eines privaten GKE-Clusters (Google Kubernetes Engine) zugreifen. Mit diesem Zugriff können Sie Cloud Build verwenden, um Anwendungen in einem privaten GKE-Cluster bereitzustellen und Ressourcen zu verwalten. Diese Anleitung richtet sich an Plattformadministratoren, Clusteradministratoren und Entwickler. Dabei wird davon ausgegangen, dass Sie mit GKE, Cloud Build, OpenID Connect und dem gcloud-Befehlszeilentool vertraut sind.

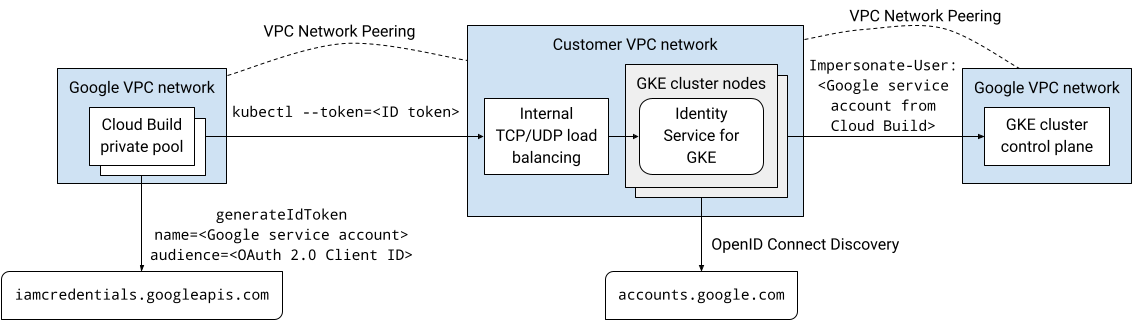

Private Cloud Build-Pools und GKE-Cluster-Steuerungsebenen werden beide in Google-VPC-Netzwerken ausgeführt. Diese VPC-Netzwerke sind über Peering mit Ihrem eigenen VPC-Netzwerk auf Google Cloudverbunden. VPC-Netzwerk-Peering unterstützt jedoch kein transitives Peering. Dies kann bei der Verwendung privater Cloud Build-Pools eine Einschränkung sein. In dieser Anleitung wird eine Lösung vorgestellt, bei der Worker in einem privaten Cloud Build-Pool mithilfe von Identity Service for GKE auf die Steuerungsebene eines privaten GKE-Cluster zugreifen können.

Architektur

Identity Service for GKE ist ein Authentifizierungsproxy für GKE-Cluster-Steuerungsebenen. Er leitet Anfragen an den API-Server weiter und validiert ID-Tokens, die von OpenID Connect (OIDC)-Identitätsanbietern ausgestellt werden. Nachdem der Proxy ein ID-Token erfolgreich validiert hat, fügt er der ursprünglichen Anfrage HTTP-Header für die Nutzeridentitätsübernahme hinzu und leitet sie an den API-Server weiter. Der Proxy wird als Kubernetes-Dienstkonto ausgeführt, das die Berechtigung hat, die Identität von Nutzern und Gruppen zu übernehmen.

Der Identity Service for GKE-Proxy wird als Pod auf Clusternodes ausgeführt. Ein Kubernetes-Dienst vom Typ LoadBalancer macht den Proxy außerhalb des Clusters verfügbar. Wenn Identity Service for GKE in einem privaten Cluster aktiviert ist, fügt das Installationsprogramm dem Kubernetes-Dienst eine Annotation hinzu, um einen internen Passthrough-Network-Load-Balancer bereitzustellen. Auf den Proxy kann über den Load-Balancer über eine VPC-Netzwerk-Peering-Verbindung zugegriffen werden, z. B. über einen privaten Cloud Build-Pool, da der Proxy auf Clusterknoten in Ihrem VPC-Netzwerk ausgeführt wird.

Sie können Google als OpenID Connect-Identitätsanbieter im Identity Service für GKE konfigurieren, da das OAuth 2.0-Authentifizierungssystem von Google der OpenID Connect-Spezifikation entspricht. Wenn Sie ID-Tokens für ein Google-Dienstkonto abrufen möchten, können Sie die Methode generateIdToken der Service Account Credentials API verwenden. Die ID-Tokens werden von Google ausgestellt und signiert.

Zusammenfassend lässt sich sagen, dass diese Lösung den Zugriff auf die private GKE-Clusterkontrollebene über den Identity Service for GKE-Proxy ermöglicht. Builds, die in einem privaten Cloud Build-Pool ausgeführt werden, stellen über eine VPC-Netzwerk-Peering-Verbindung eine Verbindung zum Proxy her. Der Build, der im privaten Pool von Cloud Build ausgeführt wird, wird als Google-Dienstkonto ausgeführt. Dieses Google-Dienstkonto kann ein ID-Token abrufen, um sich über die Service Account Credentials API beim Proxy zu authentifizieren.

Das folgende Diagramm zeigt die im vorhergehenden Text beschriebene Architektur:

Die gesamte Kommunikation in dieser Lösung erfolgt über den internen IP-Adressbereich. Die Worker im privaten Pool benötigen keine öffentliche Internetverbindung.

IAM-Berechtigungen (Identity and Access Management), die Nutzerkonten und Google-Dienstkonten gewährt werden, gelten nicht, wenn sie sich mit dem Identity Service für GKE authentifizieren. Stattdessen verwenden Sie die rollenbasierte Zugriffssteuerung (Role-based Access Control, RBAC) von Kubernetes, um Clusterberechtigungen für diese Konten zu verwalten.

Hinweise

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

Install the Google Cloud CLI.

-

Wenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

-

Führen Sie folgenden Befehl aus, um die gcloud CLI zu initialisieren:

gcloud init -

Create or select a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Create a Google Cloud project:

gcloud projects create PROJECT_ID

Replace

PROJECT_IDwith a name for the Google Cloud project you are creating. -

Select the Google Cloud project that you created:

gcloud config set project PROJECT_ID

Replace

PROJECT_IDwith your Google Cloud project name.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Build, GKE, Identity-Aware Proxy (IAP), and Service Networking APIs APIs:

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.gcloud services enable cloudbuild.googleapis.com

container.googleapis.com iap.googleapis.com servicenetworking.googleapis.com -

Install the Google Cloud CLI.

-

Wenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

-

Führen Sie folgenden Befehl aus, um die gcloud CLI zu initialisieren:

gcloud init -

Create or select a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Create a Google Cloud project:

gcloud projects create PROJECT_ID

Replace

PROJECT_IDwith a name for the Google Cloud project you are creating. -

Select the Google Cloud project that you created:

gcloud config set project PROJECT_ID

Replace

PROJECT_IDwith your Google Cloud project name.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Build, GKE, Identity-Aware Proxy (IAP), and Service Networking APIs APIs:

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles.gcloud services enable cloudbuild.googleapis.com

container.googleapis.com iap.googleapis.com servicenetworking.googleapis.com Erstellen Sie in Cloud Shell einen GKE-Cluster ohne Clientzugriff auf den öffentlichen Endpunkt der Steuerungsebene und mit installiertem Identity Service für GKE:

gcloud container clusters create CLUSTER \ --enable-identity-service \ --enable-ip-alias \ --enable-master-authorized-networks \ --enable-private-endpoint \ --enable-private-nodes \ --master-ipv4-cidr CONTROL_PLANE_CIDR \ --network NETWORK\ --release-channel regular \ --scopes cloud-platform \ --subnetwork SUBNET \ --tags NODE_TAGS \ --workload-pool PROJECT_ID.svc.id.goog \ --zone ZONEErsetzen Sie Folgendes:

- CLUSTER ist der Name des Clusters. Verwenden Sie für diese Anleitung

private-cluster. - CONTROL_PLANE_CIDR: der IP-Adressbereich der Steuerungsebene. Sie muss das Präfix

/28haben. Für diese Anleitung können Sie172.16.0.32/28verwenden. - NETWORK: Das VPC-Netzwerk, mit dem die Steuerungsebene verbunden ist. Verwenden Sie für diese Anleitung

default. - SUBNET: das Subnetz, mit dem die GKE-Cluster-Steuerungsebene verbunden ist. Das Subnetz muss zum VPC-Netzwerk gehören, das durch NETWORK angegeben wird. Verwenden Sie für diese Anleitung

default. - NODE_TAGS: Eine durch Kommas getrennte Liste von Netzwerktags, die auf die Knoten angewendet werden sollen. Verwenden Sie für diese Anleitung

private-cluster-node. - PROJECT_ID: Ihre Google Cloud -Projekt-ID

- ZONE: die Zone für den GKE-Cluster. Verwenden Sie für diese Anleitung

us-central1-f.

Beachten Sie für den Befehl Folgendes:

Mit dem Flag

--enable-identity-servicewird Identity Service for GKE im Cluster aktiviert. In Ihrer eigenen Umgebung können Sie Identity Service for GKE in einem vorhandenen Cluster aktivieren.Das Flag

--enable-private-endpointkonfiguriert die Steuerungsebene so, dass nur über interne IP-Adressen auf sie zugegriffen werden kann.Das Flag

--enable-private-nodeskonfiguriert die Clusterknoten so, dass sie nur interne IP-Adressen haben.Die Flags

--enable-master-authorized-networksund--enable-private-nodesermöglichen den Zugriff auf den API-Server nur über die privaten Netzwerke, die durch das Flag--networkangegeben werden.Mit dem optionalen Flag

--workload-poolwird die Identitätsföderation von Arbeitslasten für GKE aktiviert. Sie ist für dieses Tutorial nicht erforderlich.

- CLUSTER ist der Name des Clusters. Verwenden Sie für diese Anleitung

Fügen Sie eine Firewallregel hinzu, mit der die Steuerungsebene des GKE-Cluster eine Verbindung zum Validierungs-Webhook für ClientConfig-Ressourcen herstellen kann:

gcloud compute firewall-rules create allow-control-plane-clientconfig-webhook \ --allow tcp:15000 \ --network NETWORK\ --source-ranges CONTROL_PLANE_CIDR\ --target-tags NODE_TAGSClientConfig ist ein benutzerdefinierter Kubernetes-Ressourcentyp (CRD), der vom Identity Service für GKE verwendet wird, um die Interaktion mit Identitätsanbietern zu konfigurieren.

Öffnen Sie in der Google Cloud Console die Seite Anmeldedaten.

Klicken Sie auf Anmeldedaten erstellen.

Wählen Sie OAuth-Client-ID aus.

Wenn der Zustimmungsbildschirm für das Google Cloud-Projekt noch nicht konfiguriert wurde, klicken Sie auf Zustimmungsbildschirm konfigurieren. Folgen Sie der Dokumentation zum Konfigurieren des Zustimmungsbildschirms. Legen Sie für diese Anleitung die folgenden Werte fest:

- Nutzertyp kann entweder Intern oder Extern sein. Für diese Anleitung können Sie „Intern“ auswählen.

- Die Werte für App-Name, Nutzersupport-E-Mail und Kontaktdaten des Entwicklers sind erforderlich und können beliebige Werte haben.

- Für dieses Tutorial müssen Sie keine Bereiche hinzufügen.

Wenn Sie den Zustimmungsbildschirm konfiguriert haben, klicken Sie auf „Zurück zum Dashboard“ und beginnen Sie noch einmal mit Schritt 1 des aktuellen Verfahrens.

Wählen Sie in der Liste Anwendungstyp die Option Webanwendung aus.

Geben Sie im Feld Name einen Namen für die Client-ID ein. Verwenden Sie für diese Anleitung

Identity Service for GKE.Klicken Sie auf Erstellen.

Ein Dialogfeld wird angezeigt. Kopieren Sie den Wert von Ihre Client-ID. Sie benötigen ihn später in diesem Verfahren.

Klicken Sie auf OK, um das Dialogfeld zu schließen.

Erstellen Sie in Cloud Shell ein Verzeichnis unter Ihrem Basisverzeichnis mit dem Namen

cloud-build-private-pools-gke-tutorialund wechseln Sie dann zu diesem Verzeichnis:mkdir -p ~/cloud-build-private-pools-gke-tutorial cd ~/cloud-build-private-pools-gke-tutorial

Erstellen Sie im neuen Verzeichnis eine YAML-Datei mit dem Namen

client-config-patch.yaml, die Werte enthält, die Sie später zum Patchen der ClientConfig-Ressource des Identity Service für GKE benötigen:cat << EOF > client-config-patch.yaml spec: authentication: - name: google-oidc oidc: clientID: CLIENT_ID cloudConsoleRedirectURI: https://console.cloud.google.com/kubernetes/oidc extraParams: prompt=consent,access_type=offline issuerURI: https://accounts.google.com kubectlRedirectURI: http://localhost:10000/callback scopes: email userClaim: email userPrefix: '-' EOFErsetzen Sie CLIENT_ID durch die OAuth-Client-ID aus dem vorherigen Schritt.

Beachten Sie beim Patch Folgendes:

ID-Tokens, die vom OAuth 2.0-Authentifizierungssystem von Google ausgestellt werden, enthalten eine eindeutige numerische Kennung in der Anforderung „sub“ (subject). Wenn Sie diese nicht transparente Kennung in Rollenbindungen verwenden, ist es schwierig, das Subjekt einer Rollenbindung zu identifizieren. Mit diesem Patch wird Identity Service für GKE so konfiguriert, dass die E-Mail-Anforderung aus den ID-Tokens verwendet wird, um Nutzer zu identifizieren, anstatt die Standardanforderung „sub“ zu verwenden.

Der E-Mail-Bereich wird hinzugefügt, damit die ausgegebenen ID-Tokens die E-Mail-Anforderung enthalten.

Die Felder „

cloudConsoleRedirectURI“, „extraParams“, „kubectlRedirectURI“ und „scopes“ werden verwendet, wenn Entwickler sich mit Identity Service for GKE beim Cluster authentifizieren. Sie werden nicht verwendet, wenn sich Google-Dienstkonten beim Cluster authentifizieren. Das Feld „kubectlRedirectURI“ ist ein Pflichtfeld.Das Feld

userPrefixist ein Präfix für Nutzer, die sich mit dem konfigurierten Identitätsanbieter authentifizieren. Der Wert'-'bedeutet, dass kein Präfix verwendet wird.Das Feld

spec.authenticationist ein Array. Sie können mehrere OpenID Connect-Identitätsanbieter mit Identity Service for GKE verwenden. Sie können beispielsweise Google als Identitätsanbieter verwenden, um Google-Dienstkonten zu authentifizieren, und einen anderen Identitätsanbieter, um Entwickler zu authentifizieren.

Weitere Informationen zu den Feldern in dieser Konfiguration finden Sie unter Externe Identitätsanbieter zur Authentifizierung bei GKE verwenden.

Erstellen Sie in Cloud Shell ein Google-Dienstkonto:

gcloud iam service-accounts create ISG_GSA \ --display-name "Configure Identity Service for GKE"Ersetzen Sie ISG_GSA durch den Namen, den Sie für das Google-Dienstkonto verwenden möchten. Verwenden Sie für diese Anleitung

identity-service-for-gke.Sie weisen dieses Google-Dienstkonto einer Compute Engine-VM-Instanz zu, um Identity Service für GKE und die rollenbasierte Zugriffssteuerung von Kubernetes im Cluster zu konfigurieren.

Weisen Sie dem Google-Dienstkonto die Rolle Kubernetes Engine-Administrator für das Projekt zu:

gcloud projects add-iam-policy-binding PROJECT_ID \ --member serviceAccount:ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/container.adminDiese Rolle bietet die Berechtigungen, die für die folgenden Aufgaben in dieser Anleitung erforderlich sind:

- Konfigurieren Sie die Einstellungen für Identity Service for GKE für Cluster im Projekt.

- Erstellen Sie Rollenbindungen und Clusterrollenbindungen im Cluster.

Erstellen Sie in Cloud Shell eine Firewallregel, die SSH-Zugriff über die IAP-TCP-Weiterleitung auf alle VM-Instanzen mit dem Netzwerk-Tag

ssh-iapzulässt:gcloud compute firewall-rules create allow-ssh-ingress-from-iap \ --allow tcp:22 \ --description "Allow SSH tunneling using Identity-Aware Proxy" \ --network NETWORK \ --source-ranges 35.235.240.0/20 \ --target-tags ssh-iapDer Quellbereich enthält die IP-Adressen, die IAP für die TCP-Weiterleitung verwendet.

Erstellen Sie eine Compute Engine-VM-Instanz im selben VPC-Netzwerk wie der GKE-Cluster:

gcloud compute instances create VM \ --metadata enable-oslogin=TRUE \ --network NETWORK \ --no-address \ --scopes cloud-platform,userinfo-email \ --service-account ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --subnet SUBNET \ --tags ssh-iap \ --zone ZONEErsetzen Sie VM durch den Namen, den Sie für die VM-Instanz verwenden möchten. Verwenden Sie für diese Anleitung

identity-service-for-gke-configuration.Beachten Sie für den oben genannten Befehl Folgendes:

Das Flag

--service-accounthängt das Google-Dienstkonto an die VM-Instanz an.Der Bereich

cloud-platformist erforderlich, um auf die Service Account Credentials API zuzugreifen.Der Bereich

userinfo-emailist hilfreich, wenn Sie eine VM-Instanz zum Verwalten der rollenbasierten Zugriffssteuerung von Kubernetes erstellen. Für diese Anleitung ist sie optional.Das Flag

--no-addressbedeutet, dass die VM-Instanz ohne externe IP-Adresse erstellt wird.Mit dem optionalen Instanzmetadatenwert

enable-osloginwird OS Login auf der VM-Instanz aktiviert. Mit OS Login kann der SSH-Zugriff auf VM-Instanzen über IAM verwaltet werden.

Kopieren Sie die ClientConfig-Patchdatei auf die VM-Instanz:

gcloud compute scp client-config-patch.yaml VM:~ --tunnel-through-iap --zone ZONEDas Flag

--tunnel-through-iapweistgcloudan, die Verbindung über IAP zu tunneln.Stellen Sie eine SSH-Verbindung zur VM-Instanz her.

gcloud compute ssh VM --tunnel-through-iap --zone ZONEFühren Sie die übrigen Befehle in diesem Abschnitt aus der SSH-Sitzung aus.

Installieren Sie das

kubectl-Befehlszeilentool und die Binärdatei gke-gcloud-auth-plugin auf der VM-Instanz:sudo apt-get install -y kubectl google-cloud-sdk-gke-gcloud-auth-pluginRufen Sie die Anmeldedaten für den GKE-Cluster ab:

export USE_GKE_GCLOUD_AUTH_PLUGIN=True gcloud container clusters get-credentials CLUSTER --zone ZONEPatchen Sie die Standard-ClientConfig-Ressource:

kubectl patch clientconfig default \ --namespace kube-public \ --patch-file client-config-patch.yaml \ --type mergeExtrahieren Sie das Feld

certificateAuthorityDataaus der gepatchten Standard-ClientConfig-Ressource und speichern Sie es in einer Datei mit dem NamencertificateAuthorityData.pem:kubectl get clientconfig default \ --namespace kube-public \ --output jsonpath='{.spec.certificateAuthorityData}' \ | base64 --decode > certificateAuthorityData.pemExtrahieren Sie das Serverfeld aus der gepatchten Standard-ClientConfig-Ressource und speichern Sie es in einer Datei mit dem Namen

server.txt:kubectl get clientconfig default \ --namespace kube-public \ --output jsonpath='{.spec.server}' > server.txtVerlassen Sie die SSH-Sitzung:

exitWeisen Sie in Cloud Shell dem Google-Dienstkonto die Rolle Ersteller des OpenID Connect-Identitätstokens für das Dienstkonto für das Dienstkonto selbst zu:

gcloud iam service-accounts add-iam-policy-binding \ ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --member serviceAccount:ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/iam.serviceAccountOpenIdTokenCreatorDiese Rolle bietet die Berechtigung

iam.serviceAccounts.getOpenIdToken, die erforderlich ist, um ID-Tokens für das Dienstkonto über die Service Account Credentials API anzufordern.Stellen Sie eine SSH-Verbindung zur VM-Instanz her.

gcloud compute ssh VM --tunnel-through-iap --zone ZONEFühren Sie die übrigen Befehle in diesem Abschnitt aus der SSH-Sitzung aus.

Fordern Sie vom Metadatenserver ein OAuth 2.0-Zugriffstoken für das Google-Dienstkonto an, das mit der VM-Instanz verknüpft ist. Verwenden Sie dazu die OAuth-Client-ID als angeforderten

aud-Anspruch (Zielgruppe):ACCESS_TOKEN=$(curl --silent --header "Metadata-Flavor: Google" \ http://metadata.google.internal/computeMetadata/v1/instance/service-accounts/default/token \ | python3 -c 'import json, sys; print(json.load(sys.stdin).get("access_token"))')Der Antworttext des Metadatenservers ist ein JSON-Dokument. Der Befehl verwendet ein Inline-Python-Skript, um das Feld

access_tokenaus dem Antworttext zu extrahieren.Fordern Sie ein ID-Token von der Service Account Credentials API für das Google-Dienstkonto an, das an die VM-Instanz angehängt ist:

ID_TOKEN=$(curl --silent --request POST \ --data '{"audience": "CLIENT_ID", "includeEmail": true}' \ --header "Authorization: Bearer $ACCESS_TOKEN" \ --header "Content-Type: application/json; charset=utf-8" \ "https://iamcredentials.googleapis.com/v1/projects/-/serviceAccounts/ISG_GSA@PROJECT_ID.iam.gserviceaccount.com:generateIdToken" \ | python3 -c 'import json, sys; print(json.load(sys.stdin).get("token"))')Beachten Sie für den oben genannten Befehl Folgendes:

- Das Feld

audienceim JSON-Anfragetext gibt den angefordertenaud-Anspruch (Zielgruppe) des ID-Tokens an. - Das Zugriffstoken aus dem vorherigen Schritt wird zur Authentifizierung bei der API verwendet.

- Das Feld

Ansprüche im ID-Token ansehen:

echo $ID_TOKEN \ | cut -d. -f2 \ | base64 --decode --ignore-garbage 2> /dev/null \ | python3 -m json.toolPrüfen Sie, ob der

email-Anspruch die E-Mail-Adresse des Google-Dienstkontos enthält.Verwenden Sie das ID-Token, um sich mit Identity Service for GKE bei der Steuerungsebene zu authentifizieren:

kubectl get namespaces \ --certificate-authority certificateAuthorityData.pem \ --server $(cat server.txt) \ --token $ID_TOKENDie Ausgabe sollte so aussehen:

Error from server (Forbidden): namespaces is forbidden: User "ISG_GSA@PROJECT_ID.iam.gserviceaccount.com" cannot list resource "namespaces" in API group "" at the cluster scopeDieser Fehler wird erwartet. Obwohl dem Google-Dienstkonto IAM-Berechtigungen für GKE-Cluster im Projekt gewährt wurden, gelten IAM-Berechtigungen nicht, wenn Sie sich mit dem Identity Service für GKE authentifizieren. Stattdessen konfigurieren Sie den Zugriff mithilfe der rollenbasierten Zugriffssteuerung (RBAC) von Kubernetes.

Erstellen Sie eine Clusterrollenbindung, die dem Google-Dienstkonto die Clusterrolle

viewzuweist, wenn sich das Dienstkonto mit dem OpenID Connect-Anbieter von Google beim Cluster authentifiziert:kubectl create clusterrolebinding ISG_GSA-cluster-view \ --clusterrole view \ --user ISG_GSA@PROJECT_ID.iam.gserviceaccount.comWenn Sie in der ClientConfig in Ihrer eigenen Umgebung einen anderen

userPrefix-Wert als-festlegen, fügen Sie das Präfix dem Wert des Flags--userin diesem Befehl hinzu.Mit Identity Service for GKE auf den GKE-Cluster zugreifen:

kubectl get namespaces \ --certificate-authority certificateAuthorityData.pem \ --server $(cat server.txt) \ --token $ID_TOKENDie Ausgabe sollte so aussehen:

NAME STATUS AGE anthos-identity-service Active 1h default Active 1h kube-node-lease Active 1h kube-public Active 1h kube-system Active 1hVerlassen Sie die SSH-Sitzung:

exitKopieren Sie in Cloud Shell die Dateien mit den Daten der Zertifizierungsstelle und der Server-URL von der VM-Instanz in das aktuelle Verzeichnis:

gcloud compute scp VM:~/certificateAuthorityData.pem VM:~/server.txt . \ --tunnel-through-iap --zone ZONEErstellen Sie einen Kontext und eine Clusterkonfiguration, die Sie später verwenden, um von Cloud Build aus eine Verbindung zum GKE-Cluster herzustellen:

kubectl config set-context private-cluster \ --cluster private-cluster \ --kubeconfig kubeconfigMit dem Flag

--kubeconfigwerden die Kontext- und Clusterkonfiguration in einer neuen Datei namens „kubeconfig“ im aktuellen Verzeichnis erstellt.Bei diesem Befehl wird der Name des GKE-Cluster als Name der Clusterkonfiguration für den Kontext verwendet. In Ihrer eigenen Umgebung können Sie im Kontext einen anderen Namen für die Clusterkonfiguration verwenden.

Legen Sie das Feld

certificateAuthorityDatain der Clusterkonfiguration fest:kubectl config set-cluster private-cluster \ --certificate-authority certificateAuthorityData.pem \ --embed-certs \ --kubeconfig kubeconfigLegen Sie das Feld

serverin der Clusterkonfiguration fest:kubectl config set-cluster private-cluster \ --kubeconfig kubeconfig \ --server $(cat server.txt)Erstellen Sie in Cloud Shell ein Google-Dienstkonto, um Builds im privaten Pool von Cloud Build auszuführen:

gcloud iam service-accounts create CB_GSA \ --description "Runs builds on Cloud Build private pools" \ --display-name "Cloud Build private pool"Ersetzen Sie CB_GSA durch den Namen, den Sie für das Google-Dienstkonto verwenden möchten. Verwenden Sie für diese Anleitung

cloud-build-private-pool.Weisen Sie dem Google-Dienstkonto die Cloud Build-Dienstkontorolle für das Projekt zu:

gcloud projects add-iam-policy-binding PROJECT_ID \ --member serviceAccount:CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/cloudbuild.builds.builderDiese Rolle bietet die Standardberechtigungen des von Google verwalteten Cloud Build-Dienstkontos.

Weisen Sie dem Dienstkonto selbst die Rolle Ersteller des OpenID Connect-Identitätstokens für das Dienstkonto für das Google-Dienstkonto zu:

gcloud iam service-accounts add-iam-policy-binding \ CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --member serviceAccount:CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/iam.serviceAccountOpenIdTokenCreatorDiese Rolle bietet die Berechtigung

iam.serviceAccounts.getOpenIdToken, die erforderlich ist, um ID-Tokens für das Dienstkonto über die Service Account Credentials API anzufordern.Stellen Sie eine SSH-Verbindung zur VM-Instanz her.

gcloud compute ssh VM --tunnel-through-iap --zone ZONEFühren Sie die übrigen Befehle in diesem Abschnitt aus der SSH-Sitzung aus.

Erstellen Sie in der SSH-Sitzung eine Kubernetes-Clusterrollenbindung, die dem Google-Dienstkonto die Clusterrolle

cluster-admingewährt, wenn sich das Dienstkonto mit dem OpenID Connect-Anbieter von Google beim Cluster authentifiziert:kubectl create clusterrolebinding CB_GSA-cluster-admin \ --clusterrole cluster-admin \ --user CB_GSA@PROJECT_ID.iam.gserviceaccount.comDie Clusterrolle

cluster-admingewährt umfassende clusterweite Berechtigungen. In Ihrer eigenen Umgebung können Sie eine Clusterrolle verwenden, die nur die Berechtigungen enthält, die für die von Cloud Build ausgeführten Aufgaben erforderlich sind. Sie können auch Rollenbindungen verwenden, um Berechtigungen nur für bestimmte Namespaces zu gewähren.Wenn Sie in Ihrer eigenen Umgebung ein

userPrefixin der ClientConfig festlegen, müssen Sie dieses Präfix dem Wert des Flags--userin diesem Befehl hinzufügen.Verlassen Sie die SSH-Sitzung:

exitWeisen Sie in Cloud Shell einen IP-Adressbereich in Ihrem VPC-Netzwerk für die Verbindung mit dem privaten Pool zu:

gcloud compute addresses create RESERVED_RANGE_NAME \ --addresses RESERVED_RANGE_START_IP\ --description "Cloud Build private pool reserved range" \ --global \ --network NETWORK \ --prefix-length RESERVED_RANGE_PREFIX_LENGTH \ --purpose VPC_PEERINGErsetzen Sie Folgendes:

- RESERVED_RANGE_NAME: der Name des zugewiesenen IP-Adressbereichs, der den privaten Cloud Build-Pool hostet. Verwenden Sie für diese Anleitung

cloud-build-private-pool. - RESERVED_RANGE_START_IP: die erste IP-Adresse des zugewiesenen IP-Adressbereichs. Verwenden Sie für diese Anleitung

192.168.12.0. - RESERVED_RANGE_PREFIX_LENGTH: die Präfixlänge (Subnetzmaske) des zugewiesenen IP-Adressbereichs. Die Präfixlänge muss

/23oder eine niedrigere Zahl sein, z. B./22oder/21. Je niedriger die Zahl, desto größer der Adressbereich. Verwenden Sie für diese Anleitung23und geben Sie den führenden Schrägstrich (/) nicht ein.

- RESERVED_RANGE_NAME: der Name des zugewiesenen IP-Adressbereichs, der den privaten Cloud Build-Pool hostet. Verwenden Sie für diese Anleitung

Erstellen Sie eine Firewallregel, die eingehenden Traffic aus dem reservierten IP-Adressbereich zu anderen Ressourcen in Ihrem VPC-Netzwerk zulässt:

gcloud compute firewall-rules create allow-private-pools-ingress \ --allow all \ --network NETWORK \ --source-ranges RESERVED_RANGE_START_IP/RESERVED_RANGE_PREFIX_LENGTHErstellen Sie eine private Dienstverbindung, um Ihr VPC-Netzwerk mit dem Service Networking-Dienst zu verbinden:

gcloud services vpc-peerings connect \ --network NETWORK \ --ranges RESERVED_RANGE_NAME \ --service servicenetworking.googleapis.comPrivate Cloud Build-Pools führen Worker mithilfe von Service Networking aus. Über die private Dienstverbindung kann Ihr VPC-Netzwerk über eine VPC-Netzwerk-Peering-Verbindung mit dem privaten Pool über den zugewiesenen Bereich interner IP-Adressen kommunizieren.

Das Erstellen der privaten Dienstverbindung kann einige Minuten dauern.

Wenn Sie in Ihrer eigenen Umgebung eine freigegebene VPC verwenden, finden Sie unter Umgebung einrichten Informationen zu zusätzlichen Schritten zum Erstellen der privaten Dienstverbindung.

Erstellen Sie einen privaten Cloud Build-Pool in einem Google-VPC-Netzwerk, das über Peering mit Ihrem VPC-Netzwerk verbunden ist:

gcloud builds worker-pools create PRIVATE_POOL_NAME \ --no-public-egress \ --peered-network projects/PROJECT_ID/global/networks/NETWORK \ --region REGIONErsetzen Sie Folgendes:

- PRIVATE_POOL_NAME: der Name des privaten Pools. Verwenden Sie für diese Anleitung

private-pool. - REGION: die Region, die für den privaten Pool verwendet werden soll. Verwenden Sie für diese Anleitung

us-central1.

Das Flag

--no-public-egressbedeutet, dass Worker im privaten Pool keine öffentlichen IP-Adressen haben. In Ihrer eigenen Umgebung können Sie dieses Flag entfernen, wenn Sie möchten, dass Worker im privaten Pool über öffentliche IP-Adressen eine Internetverbindung haben.Informationen zu zusätzlichen Konfigurationsoptionen wie Maschinentyp und Laufwerkgröße für die Worker im privaten Pool finden Sie unter Private Pools erstellen und verwalten.

- PRIVATE_POOL_NAME: der Name des privaten Pools. Verwenden Sie für diese Anleitung

Erstellen Sie in Cloud Shell einen Cloud Storage-Bucket zum Speichern von Build-Logs aus Cloud Build:

gcloud storage buckets create gs://PROJECT_ID-build-logs --location=REGIONErstellen Sie eine Build-Konfigurationsdatei für Cloud Build:

cat << "EOF" > cloudbuild.yaml steps: - id: list-services name: gcr.io/google.com/cloudsdktool/google-cloud-cli entrypoint: bash args: - -eEuo - pipefail - -c - |- kubectl config use-context $_KUBECTL_CONTEXT ACCESS_TOKEN=$$(curl --silent \ --header "Metadata-Flavor: Google" \ http://metadata.google.internal/computeMetadata/v1/instance/service-accounts/default/token \ | python3 -c 'import json, sys; print(json.load(sys.stdin).get("access_token"))') ID_TOKEN=$$(curl --silent --request POST \ --data '{"audience": "CLIENT_ID", "includeEmail": true}' \ --header "Authorization: Bearer $$ACCESS_TOKEN" \ --header "Content-Type: application/json; charset=utf-8" \ "https://iamcredentials.googleapis.com/v1/projects/-/serviceAccounts/$_SERVICE_ACCOUNT:generateIdToken" \ | python3 -c 'import json, sys; print(json.load(sys.stdin).get("token"))') kubectl get services --namespace $_NAMESPACE --token $$ID_TOKEN logsBucket: gs://PROJECT_ID-build-logs options: env: - KUBECONFIG=/workspace/$_KUBECONFIG substitutions: _KUBECONFIG: kubeconfig _KUBECTL_CONTEXT: private-cluster _NAMESPACE: default serviceAccount: projects/$PROJECT_ID/serviceAccounts/$_SERVICE_ACCOUNT EOFDer Schritt in der Build-Konfigurationsdatei hat folgende Funktion:

Wechselt zum

kubectl-Kontext, der durch die_KUBECTL_CONTEXT-Ersetzung angegeben wird. Der Standardwert für die Ersetzung istprivate-cluster.Ruft ein Zugriffstoken vom Metadatenserver ab. Das Zugriffstoken wird für das Google-Dienstkonto ausgestellt, mit dem der Build ausgeführt wird.

Generiert ein ID-Token mithilfe der Service Account Credentials API. Die Anfrage zum Generieren des ID-Tokens wird mit dem Zugriffstoken authentifiziert. Der angeforderte

aud-Anspruch (Zielgruppe) des ID-Tokens ist die OAuth 2.0-Client-ID, die durch die_CLIENT_ID-Ersetzung angegeben wird.Listet die Kubernetes-Dienste im Namespace auf, der durch die Ersetzung

_NAMESPACEangegeben wird. Der Standardwert für die Ersetzung istdefault. Die Anfrage wird mit dem ID-Token authentifiziert, das im vorherigen Befehl generiert wurde.

Beachten Sie bei der Build-Konfigurationsdatei Folgendes:

Das Zeichen

$ist das Präfix für Ersetzungen.$$wird für die Bash-Parametererweiterung und die Befehlssubstitution verwendet.Mit den Substitutionen

_KUBECONFIGund_KUBECTL_CONTEXTkönnen beim Ausführen eines Builds verschiedene kubeconfig-Dateien und verschiedene Kontexte angegeben werden. Mit diesen Ersetzungen können Sie mehrere Clusterkonfigurationen entweder mit einer einzelnen kubeconfig-Datei mit mehreren Kontexten oder mit mehreren kubeconfig-Dateien verwalten.Die Substitution

_SERVICE_ACCOUNThat keinen Standardwert. Sie müssen einen Wert für diese Ersetzung angeben, wenn Sie einen Build ausführen.Mit dem Block

optionswird die UmgebungsvariableKUBECONFIGfür alle Schritte im Build festgelegt.Im Build-Schritt wird das Builder-Image

gcr.io/google.com/cloudsdktool/google-cloud-cliverwendet. Dies ist ein großes Container-Image. Es dauert einige Zeit, bis es aus der Registry in den Worker des privaten Pools übertragen wird. Um die Zeit zu verkürzen, die zum Pullen des Builder-Images benötigt wird, können Sie ein benutzerdefiniertes Builder-Image erstellen, das nur die erforderlichen Tools für den Build-Schritt enthält, z. B.curl,kubectlund Python.

Weitere Informationen zu Inline-Shell-Skripts in Build-Konfigurationsdateien finden Sie unter Bash-Skripts ausführen.

Führen Sie einen Build mit der Build-Konfigurationsdatei und den Dateien im aktuellen Verzeichnis aus:

gcloud builds submit \ --config cloudbuild.yaml \ --region REGION \ --substitutions _SERVICE_ACCOUNT=CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --worker-pool projects/PROJECT_ID/locations/REGION/workerPools/PRIVATE_POOL_NAMEMit dem Befehl werden alle Dateien im aktuellen Verzeichnis in Cloud Storage hochgeladen, damit sie von Cloud Build verwendet werden können. Im Build-Schritt wird die kubeconfig-Datei verwendet, um eine Verbindung zum GKE-Cluster herzustellen.

Gegen Ende der Ausgabe sehen Sie Zeilen, die in etwa so aussehen:

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kubernetes ClusterIP 10.0.0.1 <none> 443/TCP 2hDiese Ausgabe zeigt, dass der Worker des privaten Pools über den Authentifizierungsproxy von Identity Service for GKE eine Verbindung zur Cluster-Steuerungsebene hergestellt hat.

Löschen Sie den privaten Cloud Build-Pool in Cloud Shell:

gcloud builds worker-pools delete PRIVATE_POOL_NAME --region REGION --quietLöschen Sie die private Dienstverbindung zu Service Networking:

gcloud services vpc-peerings delete --network NETWORK \ --service servicenetworking.googleapis.com --quiet --asyncLöschen Sie den IP-Adressbereich, der privaten Cloud Build-Pools zugewiesen ist:

gcloud compute addresses delete RESERVED_RANGE_NAME --global --quietLöschen Sie den Cloud Storage-Bucket und alle zugehörigen Inhalte:

gcloud storage rm gs://PROJECT_ID-build-logs --recursiveLöschen Sie den GKE-Cluster:

gcloud container clusters delete CLUSTER --zone ZONE --quiet --asyncLöschen Sie die Compute Engine-VM-Instanz:

gcloud compute instances delete VM --zone ZONE --quietLöschen Sie die Firewallregeln:

gcloud compute firewall-rules delete allow-private-pools-ingress --quiet gcloud compute firewall-rules delete allow-ssh-ingress-from-iap --quiet gcloud compute firewall-rules delete allow-control-plane-clientconfig-webhook --quietEntfernen Sie die IAM-Rollenbindungen:

gcloud projects remove-iam-policy-binding PROJECT_ID \ --member serviceAccount:CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/cloudbuild.builds.builder gcloud projects remove-iam-policy-binding PROJECT_ID \ --member serviceAccount:ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/container.admin gcloud iam service-accounts remove-iam-policy-binding \ CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --member serviceAccount:CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/iam.serviceAccountOpenIdTokenCreator gcloud iam service-accounts remove-iam-policy-binding \ ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --member serviceAccount:ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --role roles/iam.serviceAccountOpenIdTokenCreatorLöschen Sie die Google-Dienstkonten:

gcloud iam service-accounts delete CB_GSA@PROJECT_ID.iam.gserviceaccount.com \ --quiet gcloud iam service-accounts delete ISG_GSA@PROJECT_ID.iam.gserviceaccount.com \ --quietRufen Sie in der Google Cloud Console die Seite Anmeldedaten auf:

Wählen Sie Ihr Projekt aus der Liste der Projektauswahl aus.

Suchen Sie in der Tabelle OAuth 2.0-Client-IDs die Zeile für Identity Service for GKE und klicken Sie dann auf das Symbol OAuth-Client löschen.

Klicken Sie im Dialogfeld auf Löschen.

- Auf Anthos-Cluster über Cloud Build mit dem Connect-Gateway zugreifen

- Informationen zum Zugriff auf private GKE-Cluster mit privaten Cloud Build-Pools über Cloud VPN

- Private GKE-Cluster mit Netzwerk-Proxys für den Zugriff auf die Steuerungsebene erstellen

- Informationen zum Zugriff auf externe Ressourcen in einem privaten Netzwerk über eine statische externe IP-Adresse

- GKE Identity Service Mit GKE Identity Service können Sie die Authentifizierung externer Identitätsanbieter in einer Flotte von Anthos-Cluster verwalten.

Privaten GKE-Cluster erstellen

Identity Service für GKE als OAuth 2.0-Clientanwendung registrieren

In diesem Abschnitt registrieren Sie Identity Service für GKE als Clientanwendung mit dem OAuth 2.0-Authentifizierungssystem von Google.

Google-Dienstkonto zum Konfigurieren von Identity Service for GKE erstellen

Identity Service for GKE konfigurieren

Zum Konfigurieren von Identity Service for GKE benötigen Sie Zugriff auf die Cluster-Steuerungsebene. In dieser Anleitung erstellen Sie eine Compute Engine-VM-Instanz für den Zugriff auf die Steuerungsebene.

Sie benötigen SSH-Zugriff auf die VM-Instanz. Um den authentifizierten und autorisierten SSH-Zugriff von außerhalb des VPC-Netzwerk auf die VM-Instanz zu ermöglichen, verwenden Sie die TCP-Weiterleitung mit Identity-Aware Proxy (IAP). Dieses Feature ermöglicht den SSH-Zugriff, ohne dass die VM-Instanz eine öffentliche IP-Adresse haben muss.

(Optional) Clusterkonfiguration prüfen

Bevor Sie fortfahren, können Sie prüfen, ob Identity Service for GKE im Cluster richtig eingerichtet wurde. Sie überprüfen die Einrichtung, indem Sie das mit der VM-Instanz verknüpfte Google-Dienstkonto verwenden, um sich mit Identity Service für GKE beim Cluster zu authentifizieren.

Kontext für das kubectl-Tool erstellen

Mit dem Befehl kubectl kann eine kubeconfig-Datei verwendet werden, um den Zugriff auf Cluster zu konfigurieren. Eine kubeconfig-Datei enthält einen oder mehrere Kontexte. Jeder Kontext hat einen Namen und enthält optional Informationen zur Clusterverbindung, Anmeldedaten, die zur Authentifizierung beim Cluster verwendet werden, und einen Standard-Namespace.

In diesem Abschnitt erstellen Sie eine kubeconfig-Datei mit einem Kontext. Der Kontext enthält Verbindungsdetails des Identity Service for GKE-Proxys für Ihren Cluster. Sie fügen der kubeconfig-Datei keine Nutzeranmeldedaten hinzu.

Google-Dienstkonto für Cloud Build erstellen

Privaten Cloud Build-Pool erstellen

Lösung prüfen

In diesem Abschnitt prüfen Sie die Lösung, indem Sie einen Build im privaten Cloud Build-Pool ausführen. Der Build greift auf den privaten GKE-Cluster zu.

Fehlerbehebung

Wenn Sie keine Verbindung zur VM-Instanz über SSH herstellen können, fügen Sie das Flag --troubleshoot hinzu, um die Ursache der Verbindungsprobleme zu ermitteln:

gcloud compute ssh VM --tunnel-through-iap --zone ZONE --troubleshoot

Wenn Sie beim Patchen der Standard-ClientConfig im GKE-Cluster die Meldung Error from server (NotFound): clientconfigs.authentication.gke.io "default" not found erhalten, prüfen Sie, ob Sie die Firewallregel wie im Abschnitt Privaten GKE-Cluster erstellen beschrieben erstellt haben. Bestätigen Sie, dass die Firewallregel existiert:

gcloud compute firewall-rules describe allow-control-plane-clientconfig-webhook

Wenn Sie sich nicht beim Identity Service for GKE-Proxy authentifizieren können, suchen Sie in den Logs der Pods in der gke-oidc-service-Bereitstellung nach Fehlern:

gcloud compute ssh VM --tunnel-through-iap --zone ZONE --command \

'kubectl logs deployment/gke-oidc-service \

--namespace anthos-identity-service --all-containers'

Wenn Sie Probleme mit dieser Anleitung haben, empfehlen wir Ihnen, die folgenden Dokumente zu lesen:

Bereinigen

Damit Ihrem Google Cloud-Konto die in dieser Anleitung verwendeten Ressourcen nicht in Rechnung gestellt werden, löschen Sie entweder das Projekt, das die Ressourcen enthält, oder Sie behalten das Projekt und löschen die einzelnen Ressourcen.

Projekt löschen

Delete a Google Cloud project:

gcloud projects delete PROJECT_ID

Ressourcen löschen

Wenn Sie das in dieser Anleitung verwendete Projekt beibehalten möchten, löschen Sie die einzelnen Ressourcen: