Neste tutorial, descrevemos como configurar e realizar uma pesquisa vetorial no AlloyDB para PostgreSQL usando o Google Cloud console. Os exemplos são incluídos para mostrar os recursos de pesquisa vetorial e são destinados apenas a fins de demonstração.

Para saber como usar a pesquisa vetorial filtrada para refinar suas pesquisas de similaridade, consulte Pesquisa vetorial filtrada no AlloyDB para PostgreSQL.

Para saber como fazer uma pesquisa vetorial com embeddings da Vertex AI, consulte Introdução às embedding de vetor com a IA do AlloyDB.

Objetivos

- Crie um cluster do AlloyDB e uma instância principal.

- Conecte-se ao banco de dados e instale as extensões necessárias.

- Crie uma tabela

producteproduct inventory. - Insira dados nas tabelas

producteproduct inventorye faça uma pesquisa de vetor básica. - Crie um índice do ScaNN na tabela de produtos.

- Faça uma pesquisa vetorial simples.

- Fazer uma pesquisa vetorial complexa com um filtro e uma junção.

Custos

Neste documento, você vai usar os seguintes componentes faturáveis do Google Cloud:

Para gerar uma estimativa de custo baseada na projeção de uso deste tutorial, use a calculadora de preços.

Ao concluir as tarefas descritas neste documento, é possível evitar o faturamento contínuo excluindo os recursos criados. Para mais informações, consulte Limpeza.

Antes de começar

Ativar o faturamento e as APIs necessárias

No Google Cloud console, acesse a página Clusters.

Verifique se o faturamento está ativado para seu projeto do Google Cloud .

Ative as APIs do Cloud necessárias para criar e se conectar ao AlloyDB para PostgreSQL.

- Na etapa Confirmar projeto, clique em Próxima para confirmar o nome do projeto em que você vai fazer mudanças.

Na etapa Ativar APIs, clique em Ativar para ativar o seguinte:

- API AlloyDB

- API Compute Engine

- API Service Networking

- API Vertex AI

Criar um cluster e uma instância principal do AlloyDB

No Google Cloud console, acesse a página Clusters.

Clique em Criar cluster.

Em ID do cluster, insira

my-cluster.Digite uma senha. Anote essa senha porque você a usará neste tutorial.

Selecione uma região, por exemplo,

us-central1 (Iowa).Selecione a rede padrão.

Se você tiver uma conexão de acesso privado, siga para a próxima etapa. Caso contrário, clique em Configurar conexão e siga estas etapas:

- Em Alocar um intervalo de IP, clique em Usar um intervalo de IP alocado automaticamente.

- Clique em Continuar e em Criar conexão.

Em Disponibilidade por zona, selecione Zona única.

Selecione o tipo de máquina

2 vCPU,16 GB.Em Conectividade, selecione Ativar IP público.

Clique em Criar cluster. O AlloyDB pode levar alguns minutos para criar o cluster e mostrá-lo na página Visão geral do cluster principal.

Em Instâncias no cluster, expanda o painel Conectividade. Anote o URI de conexão, porque ele será usado neste tutorial.

O URI de conexão está no formato

projects/<var>PROJECT_ID</var>/locations/<var>REGION_ID</var>/clusters/my-cluster/instances/my-cluster-primary.

Conceder permissão de usuário da Vertex AI ao agente de serviço do AlloyDB

Para permitir que o AlloyDB use modelos de incorporação de texto da Vertex AI, adicione permissões de usuário da Vertex AI ao agente de serviço do AlloyDB no projeto em que o cluster e a instância estão localizados.

Para mais informações sobre como adicionar as permissões, consulte Conceder permissão de usuário da Vertex AI ao agente de serviço do AlloyDB.

Conectar-se ao banco de dados usando um navegador da Web

No Google Cloud console, acesse a página Clusters.

Na coluna Nome do recurso, clique no nome do cluster,

my-cluster.No painel de navegação, clique em AlloyDB Studio.

Na página Fazer login no AlloyDB Studio, siga estas etapas:

- Selecione o banco de dados

postgres. - Selecione o usuário

postgres. - Insira a senha que você criou em Criar um cluster e a instância principal.

- Clique em Autenticar. O painel Explorer mostra uma lista dos objetos no banco de dados

postgres.

- Selecione o banco de dados

Abra uma nova guia clicando em + Nova guia do editor de SQL ou + Nova guia.

Instalar as extensões necessárias

Execute a consulta a seguir para instalar as extensões vector e alloydb_scann:

CREATE EXTENSION IF NOT EXISTS vector;

CREATE EXTENSION IF NOT EXISTS alloydb_scann;

Inserir dados de produtos e inventário e realizar uma pesquisa de vetor básica

Execute a seguinte instrução para criar uma tabela

productque faz o seguinte:- Armazena informações básicas do produto.

- Inclui uma coluna de vetor

embeddingque calcula e armazena um vetor de incorporação para uma descrição de cada produto.

CREATE TABLE product ( id INT PRIMARY KEY, name VARCHAR(255) NOT NULL, description TEXT, category VARCHAR(255), color VARCHAR(255), embedding vector(768) GENERATED ALWAYS AS (embedding('text-embedding-005', description)) STORED );Se necessário, use o Explorador de registros para visualizar registros e resolver erros.

Execute a consulta a seguir para criar uma tabela

product_inventoryque armazena informações sobre o inventário disponível e os preços correspondentes. As tabelasproduct_inventoryeproductsão usadas neste tutorial para executar consultas complexas de pesquisa de vetor.CREATE TABLE product_inventory ( id INT PRIMARY KEY, product_id INT REFERENCES product(id), inventory INT, price DECIMAL(10,2) );Execute a consulta a seguir para inserir dados de produtos na tabela

product:INSERT INTO product (id, name, description,category, color) VALUES (1, 'Stuffed Elephant', 'Soft plush elephant with floppy ears.', 'Plush Toys', 'Gray'), (2, 'Remote Control Airplane', 'Easy-to-fly remote control airplane.', 'Vehicles', 'Red'), (3, 'Wooden Train Set', 'Classic wooden train set with tracks and trains.', 'Vehicles', 'Multicolor'), (4, 'Kids Tool Set', 'Toy tool set with realistic tools.', 'Pretend Play', 'Multicolor'), (5, 'Play Food Set', 'Set of realistic play food items.', 'Pretend Play', 'Multicolor'), (6, 'Magnetic Tiles', 'Set of colorful magnetic tiles for building.', 'Construction Toys', 'Multicolor'), (7, 'Kids Microscope', 'Microscope for kids with different magnification levels.', 'Educational Toys', 'White'), (8, 'Telescope for Kids', 'Telescope designed for kids to explore the night sky.', 'Educational Toys', 'Blue'), (9, 'Coding Robot', 'Robot that teaches kids basic coding concepts.', 'Educational Toys', 'White'), (10, 'Kids Camera', 'Durable camera for kids to take pictures and videos.', 'Electronics', 'Pink'), (11, 'Walkie Talkies', 'Set of walkie talkies for kids to communicate.', 'Electronics', 'Blue'), (12, 'Karaoke Machine', 'Karaoke machine with built-in microphone and speaker.', 'Electronics', 'Black'), (13, 'Kids Drum Set', 'Drum set designed for kids with adjustable height.', 'Musical Instruments', 'Blue'), (14, 'Kids Guitar', 'Acoustic guitar for kids with nylon strings.', 'Musical Instruments', 'Brown'), (15, 'Kids Keyboard', 'Electronic keyboard with different instrument sounds.', 'Musical Instruments', 'Black'), (16, 'Art Easel', 'Double-sided art easel with chalkboard and whiteboard.', 'Arts & Crafts', 'White'), (17, 'Finger Paints', 'Set of non-toxic finger paints for kids.', 'Arts & Crafts', 'Multicolor'), (18, 'Modeling Clay', 'Set of colorful modeling clay.', 'Arts & Crafts', 'Multicolor'), (19, 'Watercolor Paint Set', 'Watercolor paint set with brushes and palette.', 'Arts & Crafts', 'Multicolor'), (20, 'Beading Kit', 'Kit for making bracelets and necklaces with beads.', 'Arts & Crafts', 'Multicolor'), (21, '3D Puzzle', '3D puzzle of a famous landmark.', 'Puzzles', 'Multicolor'), (22, 'Race Car Track Set', 'Race car track set with cars and accessories.', 'Vehicles', 'Multicolor'), (23, 'RC Monster Truck', 'Remote control monster truck with oversized tires.', 'Vehicles', 'Green'), (24, 'Train Track Expansion Set', 'Expansion set for wooden train tracks.', 'Vehicles', 'Multicolor');Opcional: execute a consulta a seguir para verificar se os dados foram inseridos na tabela

product:SELECT * FROM product;Execute a consulta a seguir para inserir dados de inventário na tabela

product_inventory:INSERT INTO product_inventory (id, product_id, inventory, price) VALUES (1, 1, 9, 13.09), (2, 2, 40, 79.82), (3, 3, 34, 52.49), (4, 4, 9, 12.03), (5, 5, 36, 71.29), (6, 6, 10, 51.49), (7, 7, 7, 37.35), (8, 8, 6, 10.87), (9, 9, 7, 42.47), (10, 10, 3, 24.35), (11, 11, 4, 10.20), (12, 12, 47, 74.57), (13, 13, 5, 28.54), (14, 14, 11, 25.58), (15, 15, 21, 69.84), (16, 16, 6, 47.73), (17, 17, 26, 81.00), (18, 18, 11, 91.60), (19, 19, 8, 78.53), (20, 20, 43, 84.33), (21, 21, 46, 90.01), (22, 22, 6, 49.82), (23, 23, 37, 50.20), (24, 24, 27, 99.27);Execute a seguinte consulta de pesquisa vetorial que tenta encontrar produtos semelhantes à palavra

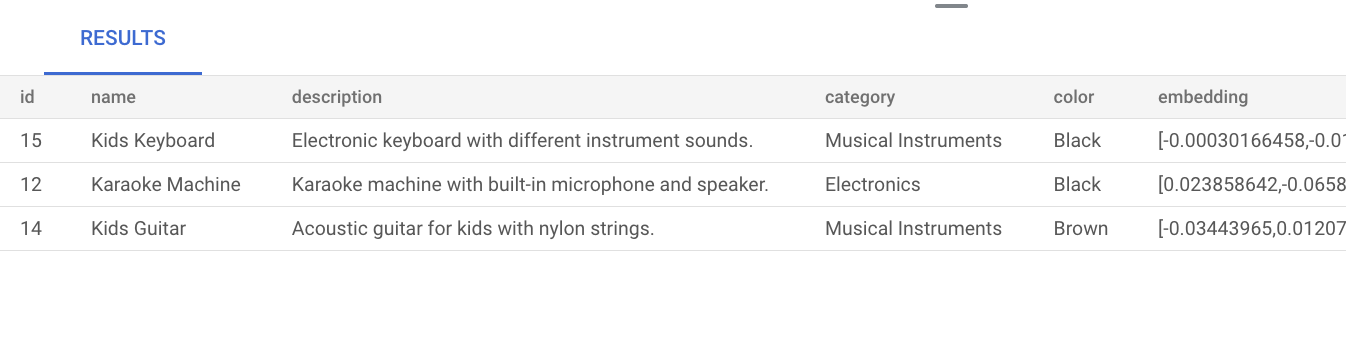

music. Isso significa que, mesmo que a palavramusicnão seja mencionada explicitamente na descrição do produto, o resultado mostra produtos relevantes para a consulta:SELECT * FROM product ORDER BY embedding <=> embedding('text-embedding-005', 'music')::vector LIMIT 3;O resultado da consulta é o seguinte:

Realizar uma pesquisa de vetor básica sem criar um índice usa a pesquisa de vizinho exato mais perto (KNN), que oferece um recall eficiente. Em grande escala, o uso do KNN pode afetar a performance. Para melhorar o desempenho da consulta, recomendamos usar o índice ScaNN para pesquisa aproximada de vizinho mais próximo (ANN), que oferece alta capacidade de recall com baixa latência.

Sem criar um índice, o AlloyDB usa por padrão a pesquisa exata de vizinho mais próximo (KNN).

Para saber mais sobre como usar o ScaNN em grande escala, consulte Introdução às embedding de vetor com a IA do AlloyDB.

Criar um índice do ScaNN na tabela de produtos

Execute a consulta a seguir para criar um índice ScaNN product_index na tabela product:

CREATE INDEX product_index ON product

USING scann (embedding cosine)

WITH (num_leaves=5);

O parâmetro num_leaves indica o número de nós folha com que o índice baseado em árvore cria o índice. Para mais informações sobre como ajustar esse parâmetro, consulte Ajustar o desempenho da consulta vetorial.

Fazer uma pesquisa de vetor

Execute a seguinte consulta de pesquisa vetorial que tenta encontrar produtos semelhantes à consulta em linguagem natural music. Mesmo que a palavra music não esteja incluída na descrição do produto, o resultado mostra produtos relevantes para a consulta:

SET LOCAL scann.num_leaves_to_search = 2;

SELECT * FROM product

ORDER BY embedding <=> embedding('text-embedding-005', 'music')::vector

LIMIT 3;

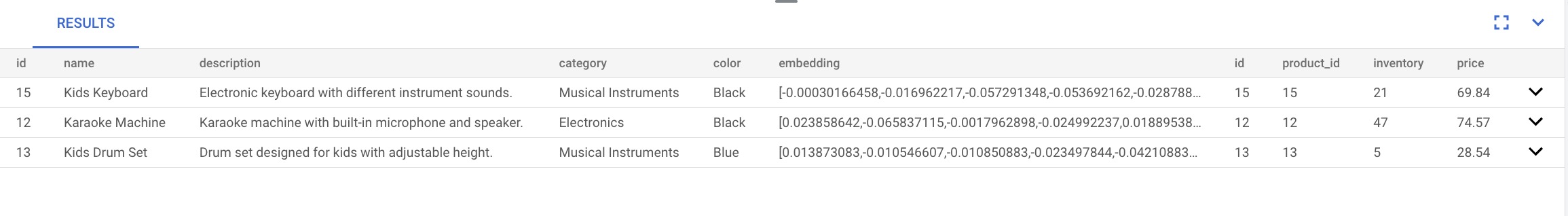

Os resultados da consulta são os seguintes:

O parâmetro de consulta scann.num_leaves_to_search controla o número de nós de folha pesquisados durante uma pesquisa de similaridade. Os valores de parâmetro num_leaves e scann.num_leaves_to_search ajudam a alcançar um equilíbrio entre desempenho e recall.

Fazer uma pesquisa vetorial que usa um filtro e uma junção

É possível executar consultas de pesquisa de vetor filtradas de forma eficiente mesmo usando o índice ScaNN. Execute a seguinte consulta complexa de pesquisa vetorial, que retorna resultados relevantes que atendem às condições da consulta, mesmo com filtros:

SET LOCAL scann.num_leaves_to_search = 2;

SELECT * FROM product p

JOIN product_inventory pi ON p.id = pi.product_id

WHERE pi.price < 80.00

ORDER BY embedding <=> embedding('text-embedding-005', 'music')::vector

LIMIT 3;

Acelerar sua pesquisa de vetor filtrada

Você pode usar o mecanismo colunar para melhorar o desempenho das pesquisas de similaridade de vetores, especificamente as pesquisas de K-Nearest Neighbor (KNN), quando combinadas com a filtragem de predicados altamente seletiva, por exemplo, usando LIKE em bancos de dados. Nesta seção, você vai usar a extensão vector e a extensão google_columnar_engine do AlloyDB.

As melhorias de desempenho vêm da eficiência integrada do mecanismo colunar na verificação de grandes conjuntos de dados e na aplicação de filtros, como predicados LIKE, além da capacidade de pré-filtrar linhas usando suporte a vetores.

Essa funcionalidade reduz o número de subconjuntos de dados necessários para cálculos subsequentes de distância vetorial KNN e ajuda a otimizar consultas analíticas complexas que envolvem filtragem padrão e pesquisa vetorial.

Para comparar o tempo de execução de uma pesquisa de vetor KNN filtrada por um predicado LIKE antes e depois de ativar o mecanismo colunar, siga estas etapas:

Ative a extensão

vectorpara oferecer suporte a tipos de dados e operações de vetores. Execute as instruções a seguir para criar uma tabela de exemplo (itens) com um ID, uma descrição de texto e uma coluna de embedding de vetor de 512 dimensões.CREATE EXTENSION IF NOT EXISTS vector; CREATE TABLE items ( id SERIAL PRIMARY KEY, description TEXT, embedding VECTOR(512) );Preencha os dados executando as seguintes instruções para inserir um milhão de linhas na tabela de exemplo

items.-- Simplified example of inserting matching (~0.1%) and non-matching data INSERT INTO items (description, embedding) SELECT CASE WHEN g % 1000 = 0 THEN 'product_' || md5(random()::text) || '_common' -- ~0.1% match ELSE 'generic_item_' || g || '_' || md5(random()::text) -- ~99.9% don't match END, random_vector(512) -- Assumes random_vector function exists FROM generate_series(1, 999999) g;Meça a performance de referência da pesquisa de semelhança vetorial sem o mecanismo de colunas.

SELECT id, description, embedding <-> '[...]' AS distance FROM items WHERE description LIKE '%product_%_common%' ORDER BY embedding <-> '[...]' LIMIT 100;Execute o comando a seguir na CLI do Google Cloud para ativar o mecanismo colunar e o suporte a vetores. Para usar a gcloud CLI, você pode instalar e inicializar a gcloud CLI.

gcloud beta alloydb instances update INSTANCE_ID \ --cluster=CLUSTER_ID \ --region=REGION_ID \ --project=PROJECT_ID \ --database-flags=google_columnar_engine.enabled=on,google_columnar_engine.enable_vector_support=onAdicione a tabela

itemsao mecanismo colunar:SELECT google_columnar_engine_add('items');Meça a performance da pesquisa de similaridade vetorial usando o mecanismo colunar. Execute novamente a consulta que você usou antes para medir o desempenho de referência.

SELECT id, description, embedding <-> '[...]' AS distance FROM items WHERE description LIKE '%product_%_common%' ORDER BY embedding <-> '[...]' LIMIT 100;Para verificar se a consulta foi executada com o mecanismo colunar, execute o comando a seguir:

explain (analyze) SELECT id, description, embedding <-> '[...]' AS distance FROM items WHERE description LIKE '%product_%_common%' ORDER BY embedding <-> '[...]' LIMIT 100;

Limpar

No Google Cloud console, acesse a página Clusters.

Clique no nome do cluster,

my-cluster, na coluna Nome do recurso.Clique em delete Excluir cluster.

Em Excluir cluster my-cluster, insira

my-clusterpara confirmar que você quer excluir o cluster.Clique em Excluir.

Se você criou uma conexão particular ao criar um cluster, acesse a página Redes do Google Cloud console e clique em Excluir rede VPC.

A seguir

- Conheça casos de uso reais da pesquisa vetorial.

- Comece a usar embeddings vetoriais com a IA do AlloyDB.

- Aprenda a criar aplicativos de IA generativa usando a IA do AlloyDB.

- Crie um índice do ScaNN.

- Ajuste seus índices do ScaNN.

- Aprenda a criar um assistente de compras inteligente com o AlloyDB, o pgvector e o gerenciamento de endpoints de modelo.

- Resolva erros usando o Explorador de registros.