Questa pagina descrive la rimozione di oggetti da un'immagine. Imagen su Vertex AI ti consente di specificare un'area di maschera, chiamata inpainting, per rimuovere oggetti da un'immagine. Puoi portare la tua maschera oppure lasciare che Imagen su Vertex AI ne generi una per te.

Esempio di rimozione dei contenuti

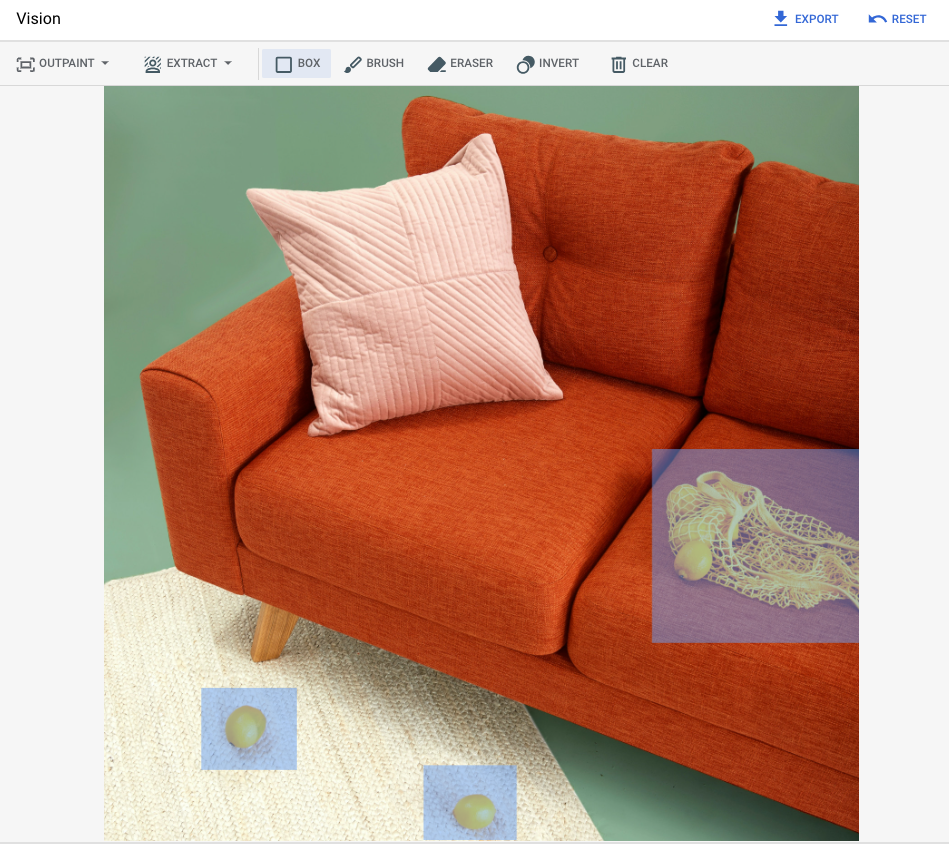

L'esempio seguente utilizza la pittura di riempimento per rimuovere contenuti da un'immagine esistente utilizzando una maschera immagine:

Input

Immagine di base* da modificare |

Area mascherata specificata utilizzando gli strumenti nella console Google Cloud |

Prompt di testo |

|---|---|---|

|

|

Prompt: rimuovi gli oggetti selezionati dall'immagine |

* Crediti immagine: Inside Weather su Unsplash.

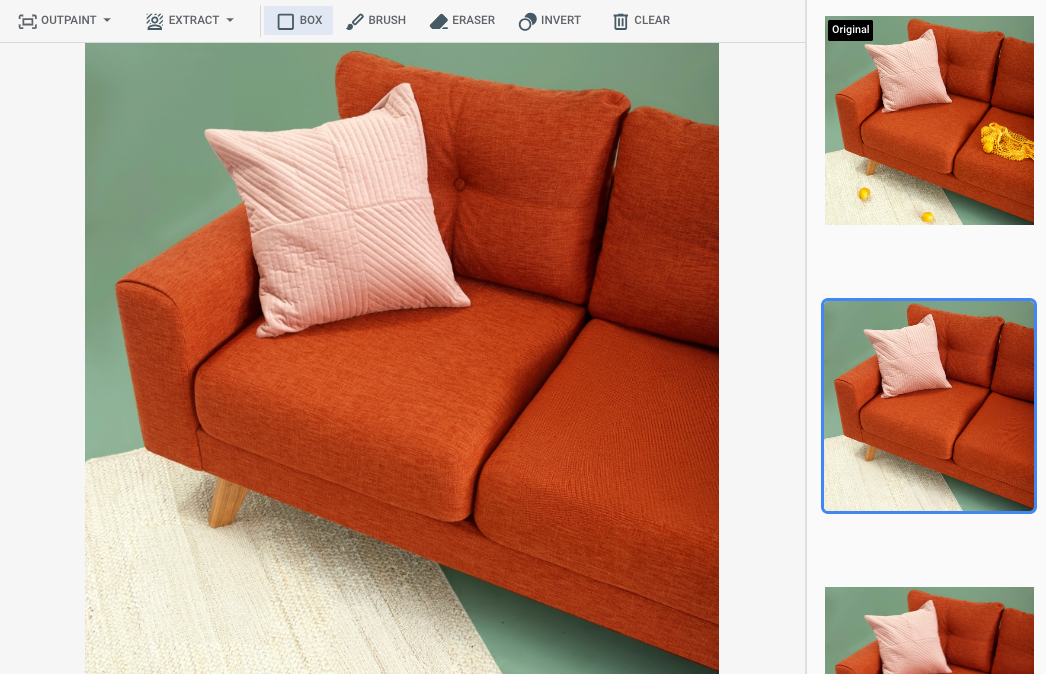

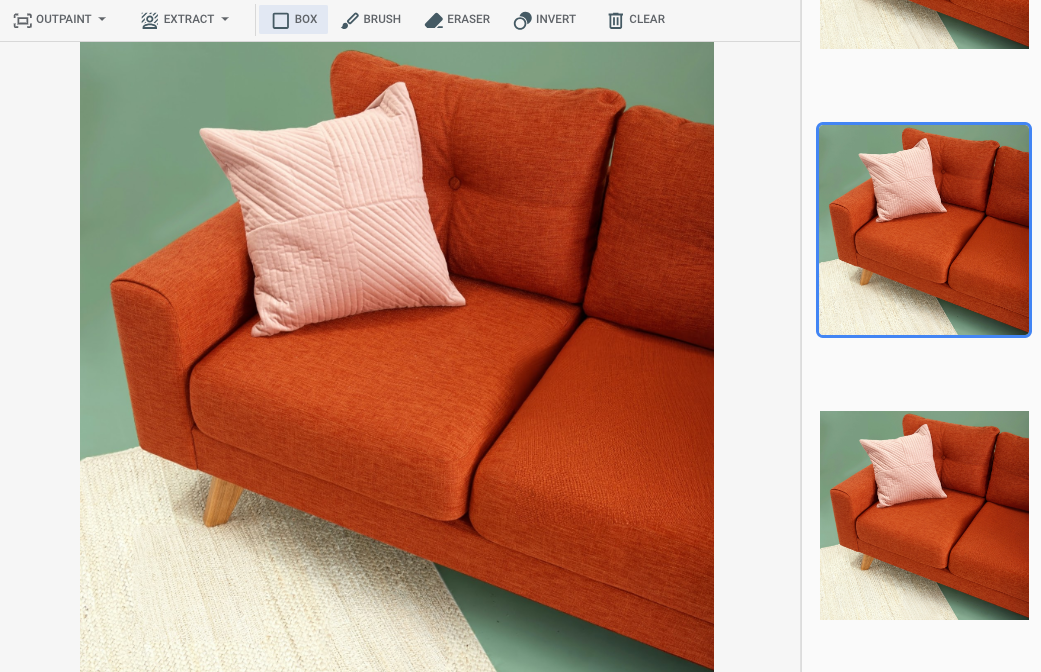

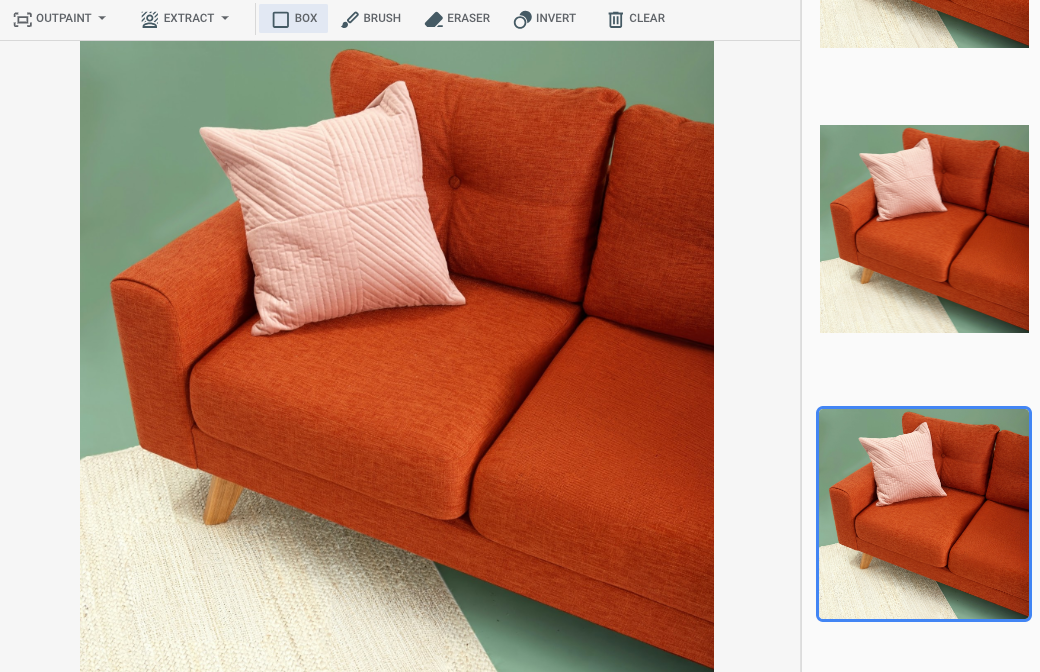

Output dopo aver specificato un'area di mascheramento nella console Google Cloud

|

|

|

Visualizza la scheda del modello Imagen per la modifica e la personalizzazione

Prima di iniziare

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vertex AI API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vertex AI API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Configura l'autenticazione per il tuo ambiente.

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

Java

Per utilizzare gli esempi di Java questa pagina in un ambiente di sviluppo locale, installa e inizializza gcloud CLI, quindi configura le credenziali predefinite dell'applicazione con le tue credenziali utente.

Installa Google Cloud CLI.

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Per saperne di più, consulta Configurare ADC per un ambiente di sviluppo locale nella documentazione sull'autenticazione Google Cloud .

Node.js

Per utilizzare gli esempi di Node.js questa pagina in un ambiente di sviluppo locale, installa e inizializza gcloud CLI, quindi configura le credenziali predefinite dell'applicazione con le tue credenziali utente.

Installa Google Cloud CLI.

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Per saperne di più, consulta Configurare ADC per un ambiente di sviluppo locale nella documentazione sull'autenticazione Google Cloud .

Python

Per utilizzare gli esempi di Python questa pagina in un ambiente di sviluppo locale, installa e inizializza gcloud CLI, quindi configura le credenziali predefinite dell'applicazione con le tue credenziali utente.

Installa Google Cloud CLI.

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Per saperne di più, consulta Configurare ADC per un ambiente di sviluppo locale nella documentazione sull'autenticazione Google Cloud .

REST

Per utilizzare gli esempi di API REST in questa pagina in un ambiente di sviluppo locale, utilizza le credenziali che fornisci a gcloud CLI.

Installa Google Cloud CLI.

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

Per saperne di più, consulta Autenticarsi per l'utilizzo di REST nella documentazione sull'autenticazione di Google Cloud .

Rimuovere con un'area della maschera definita

Utilizza i seguenti esempi per specificare l'inpainting per rimuovere i contenuti. In questi esempi, specifichi un'immagine di base, un prompt di testo e un'area della maschera per modificare l'immagine di base.

Imagen 3

Utilizza i seguenti esempi per inviare una richiesta di inpainting utilizzando il modello Imagen 3.

Console

-

Nella console Google Cloud , vai alla pagina Vertex AI > Media Studio .

- Fai clic su Carica. Nella finestra di dialogo dei file visualizzata, seleziona un file da caricare.

- Fai clic su Inpaint.

- Nel riquadro Parametri, fai clic su Inpaint (Rimuovi).

-

Esegui una di queste operazioni:

- Caricare la propria maschera:

- Crea una maschera sul computer.

- Fai clic su Carica maschera. Nella finestra di dialogo visualizzata, seleziona una maschera da caricare.

- Definisci la tua maschera:nella barra degli strumenti di modifica, utilizza gli strumenti maschera (casella, pennello o masked_transitionsinversione ) per specificare l'area o le aree a cui aggiungere contenuti.

- Caricare la propria maschera:

-

(Facoltativo) Nel riquadro Parametri, regola le seguenti opzioni:

- Modello: il modello Imagen da utilizzare

- Numero di risultati: il numero di risultati da generare

- Prompt negativo: elementi da evitare di generare

- Nel campo del prompt, inserisci un prompt per modificare l'immagine.

- Fai clic su Genera.

Python

Installa

pip install --upgrade google-genai

Per saperne di più, consulta la documentazione di riferimento dell'SDK.

Imposta le variabili di ambiente per utilizzare l'SDK Gen AI con Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=us-central1 export GOOGLE_GENAI_USE_VERTEXAI=True

REST

Per saperne di più, consulta il riferimento dell'API Modifica immagini.

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

- PROJECT_ID: il tuo Google Cloud ID progetto.

- LOCATION: la regione del progetto. Ad esempio,

us-central1,europe-west2oasia-northeast3. Per un elenco delle regioni disponibili, consulta Località dell'AI generativa su Vertex AI. prompt: per risultati ottimali, ometti un prompt enegativePromptquando utilizzi l'inpainting per la rimozione.- B64_BASE_IMAGE: L'immagine di base da modificare o di cui aumentare la risoluzione. L'immagine deve essere specificata come stringa di byte con codifica base64. Dimensioni massime: 10 MB.

- B64_MASK_IMAGE: L'immagine in bianco e nero che vuoi utilizzare come livello maschera per modificare l'immagine originale. L'immagine deve essere specificata come stringa di byte con codifica base64. Dimensioni massime: 10 MB.

- MASK_DILATION - float. La percentuale della larghezza dell'immagine in base alla quale dilatare questa maschera. Per compensare le maschere di input imperfette, è consigliabile un valore di

0.01. - EDIT_STEPS - numero intero. Il numero di passaggi di campionamento per il modello di base. Per la

rimozione dell'inpainting, inizia con

12passaggi. Aumenta i passaggi fino al limite superiore di75se la qualità non soddisfa i tuoi requisiti. L'aumento dei passaggi aumenta anche la latenza delle richieste. - EDIT_IMAGE_COUNT: il numero di immagini modificate. Valori interi accettati: 1-4. Il valore predefinito è 4.

Metodo HTTP e URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict

Corpo JSON della richiesta:

{ "instances": [ { "prompt": "", "referenceImages": [ { "referenceType": "REFERENCE_TYPE_RAW", "referenceId": 1, "referenceImage": { "bytesBase64Encoded": "B64_BASE_IMAGE" } }, { "referenceType": "REFERENCE_TYPE_MASK", "referenceId": 2, "referenceImage": { "bytesBase64Encoded": "B64_MASK_IMAGE" }, "maskImageConfig": { "maskMode": "MASK_MODE_USER_PROVIDED", "dilation": MASK_DILATION } } ] } ], "parameters": { "editConfig": { "baseSteps": EDIT_STEPS }, "editMode": "EDIT_MODE_INPAINT_REMOVAL", "sampleCount": EDIT_IMAGE_COUNT } }Per inviare la richiesta, scegli una di queste opzioni:

La seguente risposta di esempio è per una richiesta concurl

Salva il corpo della richiesta in un file denominato

request.json, ed esegui questo comando:curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict"PowerShell

Salva il corpo della richiesta in un file denominato

request.json, ed esegui questo comando:$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict" | Select-Object -Expand Content"sampleCount": 2. La risposta restituisce due oggetti di previsione, con i byte dell'immagine generata codificati in base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Imagen 2

Utilizza i seguenti esempi per inviare una richiesta di inpainting utilizzando il modello Imagen 2.

Console

-

Nella console Google Cloud , vai alla pagina Vertex AI > Media Studio .

-

Nel riquadro delle attività in basso, fai clic su Modifica immagine.

-

Fai clic su Carica per selezionare l'immagine del prodotto memorizzata localmente da modificare.

-

Nella barra degli strumenti di modifica, utilizza gli strumenti di mascheratura (rettangolo, pennello o masked_transitionsinversione) per specificare l'area o le aree da cui rimuovere i contenuti.

-

Facoltativo. Nel riquadro Parametri, regola Numero di risultati, Prompt negativo (facoltativo per la rimozione), Guida ai prompt di testo o altri parametri.

-

Lascia vuoto il campo del prompt.

-

Fai clic su Genera.

REST

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

- PROJECT_ID: il tuo Google Cloud ID progetto.

- LOCATION: la regione del progetto. Ad esempio,

us-central1,europe-west2oasia-northeast3. Per un elenco delle regioni disponibili, consulta Località dell'AI generativa su Vertex AI. - B64_BASE_IMAGE: L'immagine di base da modificare o di cui aumentare la risoluzione. L'immagine deve essere specificata come stringa di byte con codifica base64. Dimensioni massime: 10 MB.

- B64_MASK_IMAGE: L'immagine in bianco e nero che vuoi utilizzare come livello maschera per modificare l'immagine originale. L'immagine deve essere specificata come stringa di byte con codifica base64. Dimensioni massime: 10 MB.

- EDIT_IMAGE_COUNT: il numero di immagini modificate. Valore predefinito: 4.

Metodo HTTP e URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict

Corpo JSON della richiesta:

{ "instances": [ { "prompt": "", "image": { "bytesBase64Encoded": "B64_BASE_IMAGE" }, "mask": { "image": { "bytesBase64Encoded": "B64_MASK_IMAGE" } } } ], "parameters": { "sampleCount": EDIT_IMAGE_COUNT, "editConfig": { "editMode": "inpainting-remove" } } }Per inviare la richiesta, scegli una di queste opzioni:

La seguente risposta di esempio è per una richiesta concurl

Salva il corpo della richiesta in un file denominato

request.json, ed esegui questo comando:curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict"PowerShell

Salva il corpo della richiesta in un file denominato

request.json, ed esegui questo comando:$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict" | Select-Object -Expand Content"sampleCount": 2. La risposta restituisce due oggetti di previsione, con i byte dell'immagine generata codificati in base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Python

Per scoprire come installare o aggiornare l'SDK Vertex AI Python, consulta Installare l'SDK Vertex AI Python. Per saperne di più, consulta la documentazione di riferimento dell'API Python.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di Vertex AI per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vertex AI Java.

Per eseguire l'autenticazione in Vertex AI, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

In questo esempio, specifichi il modello come parte di un

EndpointName.EndpointNameviene passato al metodopredict, che viene chiamato su unPredictionServiceClient. Il servizio restituisce una versione modificata dell'immagine, che viene poi salvata localmente.Per ulteriori informazioni sulle versioni e sulle funzionalità dei modelli, vedi Modelli Imagen.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di Vertex AI per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vertex AI Node.js.

Per eseguire l'autenticazione in Vertex AI, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

In questo esempio, chiami il metodopredictsu unPredictionServiceClient. Il servizio genera immagini che vengono poi salvate localmente. Per ulteriori informazioni sulle versioni e sulle funzionalità dei modelli, vedi Modelli Imagen.Rimuovere con il rilevamento automatico della maschera

Utilizza i seguenti esempi per specificare l'inpainting per rimuovere i contenuti. In questi esempi specifichi un'immagine di base e un prompt di testo. Imagen rileva e crea automaticamente un'area della maschera per modificare l'immagine di base.

Imagen 3

Utilizza i seguenti esempi per inviare una richiesta di inpainting utilizzando il modello Imagen 3.

Console

-

Nella console Google Cloud , vai alla pagina Vertex AI > Media Studio .

- Fai clic su Carica. Nella finestra di dialogo dei file visualizzata, seleziona un file da caricare.

- Fai clic su Inpaint.

- Nel riquadro Parametri, seleziona Inpaint (Remove).

- Nella barra degli strumenti di modifica, fai clic su background_replaceEstrai.

-

Seleziona una delle opzioni di estrazione della maschera:

- Elementi di sfondo: rileva gli elementi di sfondo e crea una maschera intorno a loro.

- Elementi in primo piano: rileva gli oggetti in primo piano e crea una maschera intorno a loro.

- background_replacePeople: rileva le persone e crea una maschera intorno a loro.

-

(Facoltativo) Nel riquadro Parametri, regola le seguenti opzioni:

- Modello: il modello Imagen da utilizzare

- Numero di risultati: il numero di risultati da generare

- Prompt negativo: elementi da evitare di generare

- Nel campo del prompt, inserisci un nuovo prompt per modificare l'immagine.

- Fai clic su InviaGenera.

Python

Installa

pip install --upgrade google-genai

Per saperne di più, consulta la documentazione di riferimento dell'SDK.

Imposta le variabili di ambiente per utilizzare l'SDK Gen AI con Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=us-central1 export GOOGLE_GENAI_USE_VERTEXAI=True

REST

Per saperne di più, consulta il riferimento dell'API Modifica immagini.

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

- PROJECT_ID: il tuo Google Cloud ID progetto.

- LOCATION: la regione del progetto. Ad esempio,

us-central1,europe-west2oasia-northeast3. Per un elenco delle regioni disponibili, consulta Località dell'AI generativa su Vertex AI. prompt: per risultati ottimali, ometti un prompt enegativePromptquando utilizzi l'inpainting per la rimozione.- B64_BASE_IMAGE: L'immagine di base da modificare o di cui aumentare la risoluzione. L'immagine deve essere specificata come stringa di byte con codifica base64. Dimensioni massime: 10 MB.

- MASK_MODE: una stringa che imposta il tipo di creazione automatica della maschera utilizzata dal modello.

Valori disponibili:

MASK_MODE_BACKGROUND: genera automaticamente una maschera utilizzando la segmentazione dello sfondo. Utilizza questa impostazione per modificare i contenuti in background.MASK_MODE_FOREGROUND: genera automaticamente una maschera utilizzando la segmentazione in primo piano. Utilizza questa impostazione per modificare i contenuti in primo piano, ad esempio rimuovendo questi oggetti in primo piano (rimozione tramite inpainting).MASK_MODE_SEMANTIC: genera automaticamente una maschera utilizzando la segmentazione semantica in base alle classi di segmentazione specificate nell'arraymaskImageConfig.maskClasses. Ad esempio:"maskImageConfig": { "maskMode": "MASK_MODE_SEMANTIC", "maskClasses": [175, 176], // bicycle, car "dilation": 0.01 }

- MASK_DILATION - float. La percentuale della larghezza dell'immagine in base alla quale dilatare questa maschera. Per compensare le maschere di input imperfette, è consigliabile un valore di

0.01. - EDIT_STEPS - numero intero. Il numero di passaggi di campionamento per il modello di base. Per la

rimozione dell'inpainting, inizia con

12passaggi. Aumenta i passaggi fino al limite superiore di75se la qualità non soddisfa i tuoi requisiti. L'aumento dei passaggi aumenta anche la latenza delle richieste. - EDIT_IMAGE_COUNT: il numero di immagini modificate. Valori interi accettati: 1-4. Il valore predefinito è 4.

Metodo HTTP e URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict

Corpo JSON della richiesta:

{ "instances": [ { "prompt": "", "referenceImages": [ { "referenceType": "REFERENCE_TYPE_RAW", "referenceId": 1, "referenceImage": { "bytesBase64Encoded": "B64_BASE_IMAGE" } }, { "referenceType": "REFERENCE_TYPE_MASK", "referenceId": 2, "maskImageConfig": { "maskMode": "MASK_MODE", "dilation": MASK_DILATION } } ] } ], "parameters": { "editConfig": { "baseSteps": EDIT_STEPS }, "editMode": "EDIT_MODE_INPAINT_REMOVAL", "sampleCount": EDIT_IMAGE_COUNT } }Per inviare la richiesta, scegli una di queste opzioni:

La seguente risposta di esempio è per una richiesta concurl

Salva il corpo della richiesta in un file denominato

request.json, ed esegui questo comando:curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict"PowerShell

Salva il corpo della richiesta in un file denominato

request.json, ed esegui questo comando:$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict" | Select-Object -Expand Content"sampleCount": 2. La risposta restituisce due oggetti di previsione, con i byte dell'immagine generata codificati in base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Imagen 2

Utilizza i seguenti esempi per inviare una richiesta di inpainting utilizzando il modello Imagen 2.

Console

-

Nella console Google Cloud , vai alla pagina Vertex AI > Media Studio .

-

Nel riquadro delle attività in basso, fai clic su Modifica immagine.

-

Fai clic su Carica per selezionare l'immagine del prodotto memorizzata localmente da modificare.

-

Nella barra degli strumenti di modifica, fai clic su background_replace Estrai.

-

Seleziona una delle opzioni di estrazione della maschera:

- Elementi di sfondo: rileva gli elementi di sfondo e crea una maschera intorno a loro.

- Elementi in primo piano - Rileva gli oggetti in primo piano e crea una maschera intorno a loro.

- background_replace People: rileva le persone e crea una maschera intorno a loro.

-

Facoltativo. Nel riquadro Parametri, regola Numero di risultati, Prompt negativo, Guida al prompt di testo o altri parametri.

-

Lascia vuoto il campo del prompt.

-

Fai clic su Genera.

REST

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

- PROJECT_ID: il tuo Google Cloud ID progetto.

- LOCATION: la regione del progetto. Ad esempio,

us-central1,europe-west2oasia-northeast3. Per un elenco delle regioni disponibili, consulta Località dell'AI generativa su Vertex AI. - B64_BASE_IMAGE: L'immagine di base da modificare o di cui aumentare la risoluzione. L'immagine deve essere specificata come stringa di byte con codifica base64. Dimensioni massime: 10 MB.

- EDIT_IMAGE_COUNT: il numero di immagini modificate. Valore predefinito: 4.

- MASK_TYPE: chiede al modello di generare una maschera invece di doverne fornire

una. Di conseguenza, quando fornisci questo parametro, devi omettere un oggetto

mask. Valori disponibili:background: genera automaticamente una maschera per tutte le regioni, ad eccezione dell'oggetto, della persona o del soggetto principale dell'immagine.foreground: genera automaticamente una maschera per l'oggetto, la persona o il soggetto principale dell'immagine.semantic: utilizza la segmentazione automatica per creare un'area di maschera per una o più classi di segmentazione. Imposta le classi di segmentazione utilizzando il parametroclassese i valoriclass_idcorrispondenti. Puoi specificare fino a 5 classi. Quando utilizzi il tipo di maschera semantica, l'oggettomaskModedovrebbe avere il seguente aspetto:"maskMode": { "maskType": "semantic", "classes": [class_id1, class_id2] }

Metodo HTTP e URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict

Corpo JSON della richiesta:

{ "instances": [ { "prompt": "", "image": { "bytesBase64Encoded": "B64_BASE_IMAGE" } } ], "parameters": { "sampleCount": EDIT_IMAGE_COUNT, "editConfig": { "editMode": "inpainting-remove", "maskMode": { "maskType": "MASK_TYPE" } } } }Per inviare la richiesta, scegli una di queste opzioni:

La seguente risposta di esempio è per una richiesta concurl

Salva il corpo della richiesta in un file denominato

request.json, ed esegui questo comando:curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict"PowerShell

Salva il corpo della richiesta in un file denominato

request.json, ed esegui questo comando:$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict" | Select-Object -Expand Content"sampleCount": 2. La risposta restituisce due oggetti di previsione, con i byte dell'immagine generata codificati in base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Python

Per scoprire come installare o aggiornare l'SDK Vertex AI Python, consulta Installare l'SDK Vertex AI Python. Per saperne di più, consulta la documentazione di riferimento dell'API Python.

Limitazioni

Le sezioni seguenti spiegano le limitazioni della funzionalità di rimozione degli oggetti di Imagen.

Pixel modificati

Non è garantito che i pixel generati dal modello che non si trovano nella maschera siano identici all'input e vengono generati alla risoluzione del modello (ad esempio 1024 x 1024). Nell'immagine generata potrebbero essere presenti modifiche minime.

Se vuoi una conservazione perfetta dell'immagine, ti consigliamo di unire l'immagine generata con l'immagine di input utilizzando la maschera. In genere, se la risoluzione dell'immagine di input è 2K o superiore, è necessario combinare l'immagine generata e l'immagine di input.

Limitazione della rimozione

Potrebbero essere rimossi anche alcuni piccoli oggetti adiacenti alle maschere. Come best practice, ti consigliamo di rendere la maschera il più precisa possibile.

La rimozione di aree di grandi dimensioni nelle regioni del cielo delle immagini esterne potrebbe comportare artefatti indesiderati. Come best practice, ti consigliamo di fornire un prompt.

Passaggi successivi

Leggi gli articoli su Imagen e altri prodotti di AI generativa su Vertex AI:

- Guida per gli sviluppatori per iniziare a utilizzare Imagen 3 su Vertex AI

- Nuovi modelli e strumenti di media generativi, creati con e per i creator

- Novità di Gemini: Gem personalizzati e generazione di immagini migliorata con Imagen 3

- Google DeepMind: Imagen 3, il nostro modello di conversione da testo a immagine di altissima qualità

Salvo quando diversamente specificato, i contenuti di questa pagina sono concessi in base alla licenza Creative Commons Attribution 4.0, mentre gli esempi di codice sono concessi in base alla licenza Apache 2.0. Per ulteriori dettagli, consulta le norme del sito di Google Developers. Java è un marchio registrato di Oracle e/o delle sue consociate.

Ultimo aggiornamento 2025-10-19 UTC.

-