En esta página, se describe cómo quitar objetos de una imagen. Imagen en Vertex AI te permite especificar un área de máscara, llamada reparación, para quitar objetos de una imagen. Puedes usar tu propia máscara o dejar que Imagen en Vertex AI genere una máscara por ti.

Ejemplo de eliminación de contenido

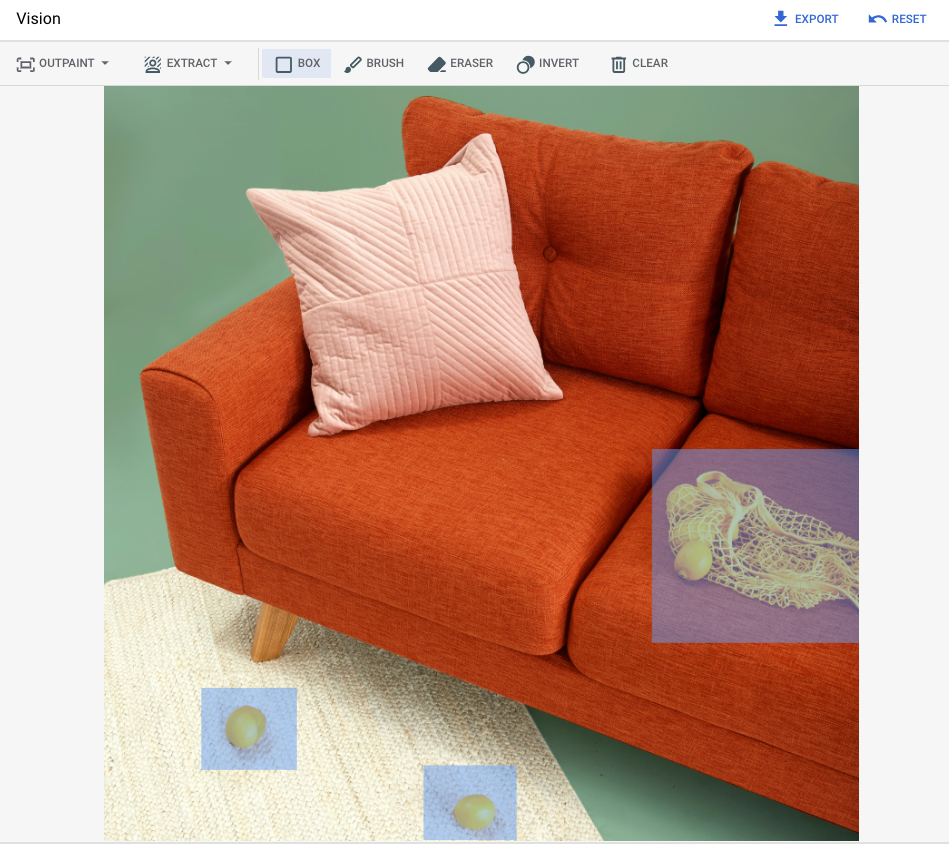

En el siguiente ejemplo, se usa el relleno para quitar contenido de una imagen existente con una máscara de imagen:

Entradas

Imagen base* para editar |

Área de la máscara especificada con las herramientas de la consola de Google Cloud |

Instrucción de texto |

|---|---|---|

|

|

Instrucción: Quita los objetos seleccionados de la imagen. |

* Crédito de la imagen: Inside Weather en Unsplash.

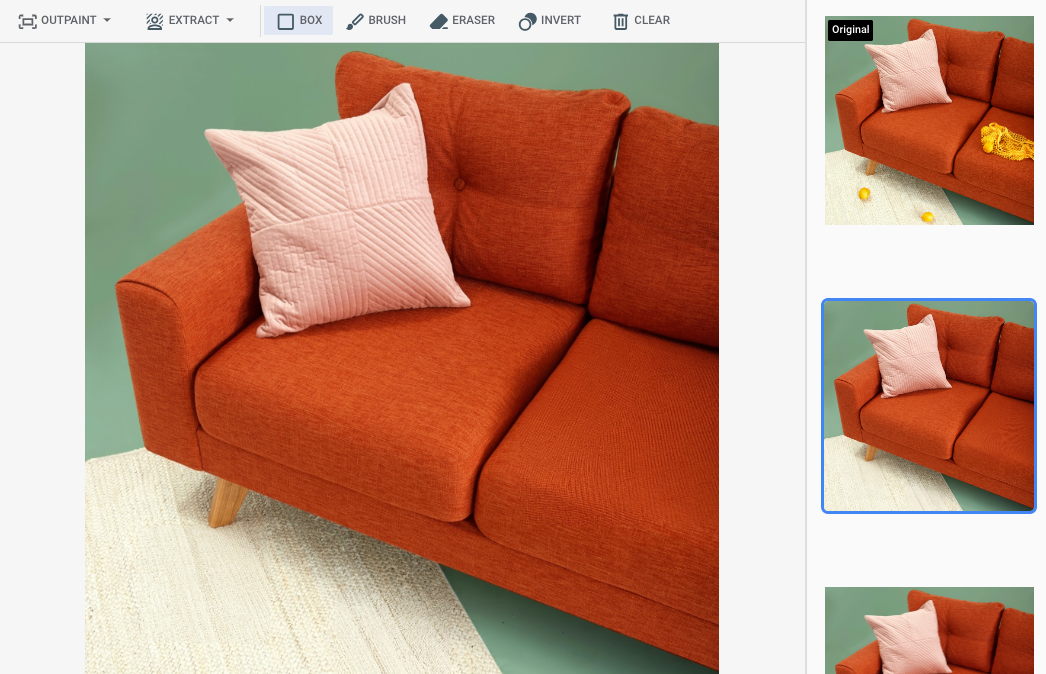

Resultado después de especificar un área de la máscara en la consola de Google Cloud

|

|

|

Consulta la tarjeta del modelo de Imagen for Editing and Customization

Antes de comenzar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vertex AI API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vertex AI API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Configura la autenticación para tu entorno.

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

Java

Para usar las muestras de Java de esta página en un entorno de desarrollo local, instala e inicializa gcloud CLI y, luego, configura las credenciales predeterminadas de la aplicación con tus credenciales de usuario.

Instala Google Cloud CLI.

Si usas un proveedor de identidad externo (IdP), primero debes acceder a gcloud CLI con tu identidad federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para obtener más información, consulta Configura ADC para un entorno de desarrollo local en la documentación de autenticación de Google Cloud .

Node.js

Para usar las muestras de Node.js de esta página en un entorno de desarrollo local, instala e inicializa gcloud CLI y, luego, configura las credenciales predeterminadas de la aplicación con tus credenciales de usuario.

Instala Google Cloud CLI.

Si usas un proveedor de identidad externo (IdP), primero debes acceder a gcloud CLI con tu identidad federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para obtener más información, consulta Configura ADC para un entorno de desarrollo local en la documentación de autenticación de Google Cloud .

Python

Para usar las muestras de Python de esta página en un entorno de desarrollo local, instala e inicializa gcloud CLI y, luego, configura las credenciales predeterminadas de la aplicación con tus credenciales de usuario.

Instala Google Cloud CLI.

Si usas un proveedor de identidad externo (IdP), primero debes acceder a gcloud CLI con tu identidad federada.

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Para obtener más información, consulta Configura ADC para un entorno de desarrollo local en la documentación de autenticación de Google Cloud .

REST

Para usar las muestras de la API de REST en esta página en un entorno de desarrollo local, debes usar las credenciales que proporciones a gcloud CLI.

Instala Google Cloud CLI.

Si usas un proveedor de identidad externo (IdP), primero debes acceder a gcloud CLI con tu identidad federada.

Para obtener más información, consulta Autentícate para usar REST en la documentación de autenticación de Google Cloud .

Cómo quitar con un área de máscara definida

Usa los siguientes ejemplos a la hora de especificar el relleno para quitar contenido. En estas muestras, especifica una imagen base, una instrucción de texto y un área de máscara para modificar la imagen base.

Imagen 3

Usa los siguientes ejemplos para enviar una solicitud de restauración con el modelo de Imagen 3.

Console

-

En la Google Cloud consola, ve a la página Vertex AI > Media Studio .

- Haz clic en Subir. En el cuadro de diálogo de archivo que se muestra, selecciona un archivo para subir.

- Haz clic en Inpaint.

- En el panel Parámetros, haz clic en Inpaint (Remove).

-

Realiza una de las siguientes acciones:

- Sube tu propia máscara:

- Crea una máscara en tu computadora.

- Haz clic en Subir máscara. En el diálogo que se muestra, selecciona una máscara para subir.

- Define tu propia máscara: En la barra de herramientas de edición, usa las herramientas de máscara (cuadro, pincel o herramienta invertida demasked_transitions) para especificar el área o áreas las que se agregará contenido.

- Sube tu propia máscara:

-

Opcional: En el panel Parámetros, ajusta las siguientes

opciones:

- Modelo: Es el modelo de Imagen que se usará.

- Cantidad de resultados: Es la cantidad de resultados que se generarán.

- Instrucción negativa: Elementos que se deben evitar generar

- En el campo de mensaje, ingresa un mensaje para modificar la imagen.

- Haz clic en Generar .

Python

Instalar

pip install --upgrade google-genai

Para obtener más información, consulta la documentación de referencia del SDK.

Establece variables de entorno para usar el SDK de IA generativa con Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=us-central1 export GOOGLE_GENAI_USE_VERTEXAI=True

REST

Para obtener más información, consulta la referencia de la API de Edit images.

Antes de usar cualquiera de los datos de solicitud a continuación, realiza los siguientes reemplazos:

- PROJECT_ID: El Google Cloud ID del proyecto.

- LOCATION: La región del proyecto. Por ejemplo,

us-central1,europe-west2oasia-northeast3. Para obtener una lista de las regiones disponibles, consulta IA generativa en ubicaciones de Vertex AI. prompt: Para obtener mejores resultados, omite una instrucción ynegativePromptcuando uses la expansión para quitar elementos.- B64_BASE_IMAGE: La imagen base que se editará o mejorará. La imagen debe especificarse como una cadena de bytes codificada en base64. Límite de tamaño: 10 MB.

- B64_MASK_IMAGE: La imagen en blanco y negro que deseas usar como capa de máscara para editar la imagen original. La imagen debe especificarse como una cadena de bytes codificada en base64. Límite de tamaño: 10 MB.

- MASK_DILATION: Número de punto flotante. Es el porcentaje del ancho de la imagen por el que se dilatará esta máscara. Se recomienda un valor de

0.01para compensar las máscaras de entrada imperfectas. - EDIT_STEPS: Es un número entero. Es la cantidad de pasos de muestreo para el modelo base. Para la eliminación de la expansión, comienza con

12pasos. Aumenta los pasos hasta el límite superior de75si la calidad no cumple con tus requisitos. Aumentar los pasos también incrementa la latencia de la solicitud. - EDIT_IMAGE_COUNT: Es la cantidad de imágenes editadas. Valores de números enteros aceptados: de 1 a 4. Valor predeterminado: 4.

Método HTTP y URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict

Cuerpo JSON de la solicitud:

{ "instances": [ { "prompt": "", "referenceImages": [ { "referenceType": "REFERENCE_TYPE_RAW", "referenceId": 1, "referenceImage": { "bytesBase64Encoded": "B64_BASE_IMAGE" } }, { "referenceType": "REFERENCE_TYPE_MASK", "referenceId": 2, "referenceImage": { "bytesBase64Encoded": "B64_MASK_IMAGE" }, "maskImageConfig": { "maskMode": "MASK_MODE_USER_PROVIDED", "dilation": MASK_DILATION } } ] } ], "parameters": { "editConfig": { "baseSteps": EDIT_STEPS }, "editMode": "EDIT_MODE_INPAINT_REMOVAL", "sampleCount": EDIT_IMAGE_COUNT } }Para enviar tu solicitud, elige una de estas opciones:

La siguiente respuesta de muestra es para una solicitud concurl

Guarda el cuerpo de la solicitud en un archivo llamado

request.jsony ejecuta el siguiente comando:curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict"PowerShell

Guarda el cuerpo de la solicitud en un archivo llamado

request.jsony ejecuta el siguiente comando:$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict" | Select-Object -Expand Content"sampleCount": 2. La respuesta muestra dos objetos de predicción, con los bytes de imagen generados codificados en base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Imagen 2

Usa los siguientes ejemplos para enviar una solicitud de restauración con el modelo de Imagen 2.

Console

-

En la Google Cloud consola, ve a la página Vertex AI > Media Studio .

-

En el panel de tareas inferior, haz clic en Editar imagen.

-

Haz clic en Subir para seleccionar la imagen de tu producto almacenado de forma local a fin de editarla.

-

En la barra de herramientas de edición, usa las herramientas de máscara (cuadro, pincel o herramienta invertida demasked_transitions) para especificar el área o áreas de las que se quitará contenido.

-

Opcional. En el panel Parámetros, ajusta la cantidad de resultados, la Instrucción negativa (opcional para la eliminación), Orientación de instrucción de texto o cualquier otro parámetro.

-

Deja el campo de la instrucción vacío.

-

Haz clic en Generar .

REST

Antes de usar cualquiera de los datos de solicitud a continuación, realiza los siguientes reemplazos:

- PROJECT_ID: El Google Cloud ID del proyecto.

- LOCATION: La región del proyecto. Por ejemplo,

us-central1,europe-west2oasia-northeast3. Para obtener una lista de las regiones disponibles, consulta IA generativa en ubicaciones de Vertex AI. - B64_BASE_IMAGE: La imagen base que se editará o mejorará. La imagen debe especificarse como una cadena de bytes codificada en base64. Límite de tamaño: 10 MB.

- B64_MASK_IMAGE: La imagen en blanco y negro que deseas usar como capa de máscara para editar la imagen original. La imagen debe especificarse como una cadena de bytes codificada en base64. Límite de tamaño: 10 MB.

- EDIT_IMAGE_COUNT: la cantidad de imágenes editadas. El valor predeterminado es 4.

Método HTTP y URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict

Cuerpo JSON de la solicitud:

{ "instances": [ { "prompt": "", "image": { "bytesBase64Encoded": "B64_BASE_IMAGE" }, "mask": { "image": { "bytesBase64Encoded": "B64_MASK_IMAGE" } } } ], "parameters": { "sampleCount": EDIT_IMAGE_COUNT, "editConfig": { "editMode": "inpainting-remove" } } }Para enviar tu solicitud, elige una de estas opciones:

La siguiente respuesta de muestra es para una solicitud concurl

Guarda el cuerpo de la solicitud en un archivo llamado

request.jsony ejecuta el siguiente comando:curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict"PowerShell

Guarda el cuerpo de la solicitud en un archivo llamado

request.jsony ejecuta el siguiente comando:$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict" | Select-Object -Expand Content"sampleCount": 2. La respuesta muestra dos objetos de predicción, con los bytes de imagen generados codificados en base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Python

Si deseas obtener información para instalar o actualizar el SDK de Vertex AI para Python, consulta Instala el SDK de Vertex AI para Python. Para obtener más información, consulta la documentación de referencia de la API de Python.

Java

Antes de probar este ejemplo, sigue las instrucciones de configuración para Java incluidas en la guía de inicio rápido de Vertex AI sobre cómo usar bibliotecas cliente. Para obtener más información, consulta la documentación de referencia de la API de Vertex AI Java.

Para autenticarte en Vertex AI, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

En este ejemplo, especificas el modelo como parte de un

EndpointName.EndpointNamese pasa al métodopredict, al que se llama en unPredictionServiceClient. El servicio devuelve una versión editada de la imagen, que luego se guarda de forma local.Para obtener más información sobre las versiones y las características de los modelos, consulta Modelos de Imagen.

Node.js

Antes de probar este ejemplo, sigue las instrucciones de configuración para Node.js incluidas en la guía de inicio rápido de Vertex AI sobre cómo usar bibliotecas cliente. Para obtener más información, consulta la documentación de referencia de la API de Vertex AI Node.js.

Para autenticarte en Vertex AI, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

En este ejemplo, llamas al métodopredicten unPredictionServiceClient. El servicio genera imágenes que, luego, se guardan de forma local. Para obtener más información sobre las versiones y los atributos del modelo, consulta Modelos de Imagen.Cómo quitar contenido con la detección automática de máscaras

Usa los siguientes ejemplos a la hora de especificar el relleno para quitar contenido. En estas muestras, especifica una imagen base y una instrucción de texto. Imagen detecta y crea de automáticamente un área de máscara para modificar la imagen base.

Imagen 3

Usa los siguientes ejemplos para enviar una solicitud de restauración con el modelo de Imagen 3.

Console

-

En la Google Cloud consola, ve a la página Vertex AI > Media Studio .

- Haz clic en Subir. En el cuadro de diálogo de archivo que se muestra, selecciona un archivo para subir.

- Haz clic en Inpaint.

- En el panel Parámetros, selecciona Inpaint (Remove).

- En la barra de herramientas de edición, haz clic en background_replaceExtraer.

-

Elige una de las siguientes opciones de extracción de máscaras:

- Elementos en segundo plano: Detecta los elementos en segundo plano y crea una máscara a su alrededor.

- Elementos en primer plano: Detecta los objetos en primer plano y crea una máscara alrededor de ellos.

- background_replacePersonas: Detecta personas y crea una máscara a su alrededor.

-

Opcional: En el panel Parámetros, ajusta las siguientes

opciones:

- Modelo: Es el modelo de Imagen que se usará.

- Cantidad de resultados: Es la cantidad de resultados que se generarán.

- Instrucción negativa: Elementos que se deben evitar generar

- En el campo de mensaje, ingresa un mensaje nuevo para modificar la imagen.

- Haz clic en EnviarGenerar.

Python

Instalar

pip install --upgrade google-genai

Para obtener más información, consulta la documentación de referencia del SDK.

Establece variables de entorno para usar el SDK de IA generativa con Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=us-central1 export GOOGLE_GENAI_USE_VERTEXAI=True

REST

Para obtener más información, consulta la referencia de la API de Edit images.

Antes de usar cualquiera de los datos de solicitud a continuación, realiza los siguientes reemplazos:

- PROJECT_ID: El Google Cloud ID del proyecto.

- LOCATION: La región del proyecto. Por ejemplo,

us-central1,europe-west2oasia-northeast3. Para obtener una lista de las regiones disponibles, consulta IA generativa en ubicaciones de Vertex AI. prompt: Para obtener mejores resultados, omite una instrucción ynegativePromptcuando uses la expansión para quitar elementos.- B64_BASE_IMAGE: La imagen base que se editará o mejorará. La imagen debe especificarse como una cadena de bytes codificada en base64. Límite de tamaño: 10 MB.

- MASK_MODE: Es una cadena que establece el tipo de creación automática de máscaras que usa el modelo.

Valores disponibles:

MASK_MODE_BACKGROUND: Genera automáticamente una máscara con la segmentación de fondo. Usa este parámetro de configuración para modificar el contenido de fondo.MASK_MODE_FOREGROUND: Genera automáticamente una máscara con la segmentación del primer plano. Usa este parámetro de configuración para modificar el contenido en primer plano, como quitar estos objetos en primer plano (eliminación con restauración).MASK_MODE_SEMANTIC: Genera automáticamente una máscara con la segmentación semántica en función de las clases de segmentación que especifiques en el arraymaskImageConfig.maskClasses. Por ejemplo:"maskImageConfig": { "maskMode": "MASK_MODE_SEMANTIC", "maskClasses": [175, 176], // bicycle, car "dilation": 0.01 }

- MASK_DILATION: Número de punto flotante. Es el porcentaje del ancho de la imagen por el que se dilatará esta máscara. Se recomienda un valor de

0.01para compensar las máscaras de entrada imperfectas. - EDIT_STEPS: Es un número entero. Es la cantidad de pasos de muestreo para el modelo base. Para la eliminación de la expansión, comienza con

12pasos. Aumenta los pasos hasta el límite superior de75si la calidad no cumple con tus requisitos. Aumentar los pasos también incrementa la latencia de la solicitud. - EDIT_IMAGE_COUNT: Es la cantidad de imágenes editadas. Valores de números enteros aceptados: de 1 a 4. Valor predeterminado: 4.

Método HTTP y URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict

Cuerpo JSON de la solicitud:

{ "instances": [ { "prompt": "", "referenceImages": [ { "referenceType": "REFERENCE_TYPE_RAW", "referenceId": 1, "referenceImage": { "bytesBase64Encoded": "B64_BASE_IMAGE" } }, { "referenceType": "REFERENCE_TYPE_MASK", "referenceId": 2, "maskImageConfig": { "maskMode": "MASK_MODE", "dilation": MASK_DILATION } } ] } ], "parameters": { "editConfig": { "baseSteps": EDIT_STEPS }, "editMode": "EDIT_MODE_INPAINT_REMOVAL", "sampleCount": EDIT_IMAGE_COUNT } }Para enviar tu solicitud, elige una de estas opciones:

La siguiente respuesta de muestra es para una solicitud concurl

Guarda el cuerpo de la solicitud en un archivo llamado

request.jsony ejecuta el siguiente comando:curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict"PowerShell

Guarda el cuerpo de la solicitud en un archivo llamado

request.jsony ejecuta el siguiente comando:$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagen-3.0-capability-001:predict" | Select-Object -Expand Content"sampleCount": 2. La respuesta muestra dos objetos de predicción, con los bytes de imagen generados codificados en base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Imagen 2

Usa los siguientes ejemplos para enviar una solicitud de restauración con el modelo de Imagen 2.

Console

-

En la Google Cloud consola, ve a la página Vertex AI > Media Studio .

-

En el panel de tareas inferior, haz clic en Editar imagen.

-

Haz clic en Subir para elegir la imagen de tu producto almacenado de forma local y, luego, editarla.

-

En la barra de herramientas de edición, haz clic en background_replace Extraer.

-

Elige una de las siguientes opciones de extracción de máscaras:

- Elementos en segundo plano: Detecta los elementos en segundo plano y crea una máscara a su alrededor.

- Elementos en primer plano: Detecta los objetos en primer plano y crea una máscara alrededor de ellos.

- background_replace: Detecta personas y crea una máscara a su alrededor.

-

Opcional. En el panel Parámetros, ajusta la Cantidad de resultados, la Instrucción negativa, la Guía de la instrucción de texto y demás parámetros.

-

Deja el campo de la instrucción vacío.

-

Haz clic en Generar .

REST

Antes de usar cualquiera de los datos de solicitud a continuación, realiza los siguientes reemplazos:

- PROJECT_ID: El Google Cloud ID del proyecto.

- LOCATION: La región del proyecto. Por ejemplo,

us-central1,europe-west2oasia-northeast3. Para obtener una lista de las regiones disponibles, consulta IA generativa en ubicaciones de Vertex AI. - B64_BASE_IMAGE: La imagen base que se editará o mejorará. La imagen debe especificarse como una cadena de bytes codificada en base64. Límite de tamaño: 10 MB.

- EDIT_IMAGE_COUNT: la cantidad de imágenes editadas. El valor predeterminado es 4.

- MASK_TYPE: Le solicita al modelo que genere una máscara en lugar de que tengas que proporcionar

una. Por lo tanto, cuando proporcionas este parámetro, debes omitir un objeto

mask. Valores disponibles:background: Genera automáticamente una máscara en todas las regiones, excepto el objeto principal, la persona o el sujeto en la imagen.foreground: Genera automáticamente una máscara para el objeto, la persona o el sujeto principales en la imagen.semantic: Usa la segmentación automática a la hora de crear un área de máscara para una o más de las clases de segmentación. Configura las clases de segmentación con el parámetroclassesy los valoresclass_idcorrespondientes. Puedes especificar hasta 5 clases. Cuando usas el tipo de máscara semántica, el objetomaskModedebe verse de la siguiente manera:"maskMode": { "maskType": "semantic", "classes": [class_id1, class_id2] }

Método HTTP y URL:

POST https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict

Cuerpo JSON de la solicitud:

{ "instances": [ { "prompt": "", "image": { "bytesBase64Encoded": "B64_BASE_IMAGE" } } ], "parameters": { "sampleCount": EDIT_IMAGE_COUNT, "editConfig": { "editMode": "inpainting-remove", "maskMode": { "maskType": "MASK_TYPE" } } } }Para enviar tu solicitud, elige una de estas opciones:

La siguiente respuesta de muestra es para una solicitud concurl

Guarda el cuerpo de la solicitud en un archivo llamado

request.jsony ejecuta el siguiente comando:curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict"PowerShell

Guarda el cuerpo de la solicitud en un archivo llamado

request.jsony ejecuta el siguiente comando:$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/imagegeneration@006:predict" | Select-Object -Expand Content"sampleCount": 2. La respuesta muestra dos objetos de predicción, con los bytes de imagen generados codificados en base64.{ "predictions": [ { "bytesBase64Encoded": "BASE64_IMG_BYTES", "mimeType": "image/png" }, { "mimeType": "image/png", "bytesBase64Encoded": "BASE64_IMG_BYTES" } ] }Python

Si deseas obtener información para instalar o actualizar el SDK de Vertex AI para Python, consulta Instala el SDK de Vertex AI para Python. Para obtener más información, consulta la documentación de referencia de la API de Python.

Limitaciones

En las siguientes secciones, se explican las limitaciones de la función de eliminación de objetos de Imagen.

Píxeles modificados

No se garantiza que los píxeles generados por el modelo que no están en la máscara sean idénticos a la entrada, y se generan en la resolución del modelo (por ejemplo, 1024 x 1024). Es posible que haya cambios muy pequeños en la imagen generada.

Si deseas conservar la imagen a la perfección, te recomendamos que combines la imagen generada con la imagen de entrada usando la máscara. Por lo general, si la resolución de la imagen de entrada es de 2K o superior, se requiere combinar la imagen generada y la imagen de entrada.

Limitación de eliminación

También se pueden quitar algunos objetos pequeños adyacentes a las máscaras. Como práctica recomendada, te sugerimos que la máscara sea lo más precisa posible.

Quitar áreas grandes en las regiones del cielo de las imágenes exteriores puede generar artefactos no deseados. Como práctica recomendada, te sugerimos que proporciones una instrucción.

¿Qué sigue?

Lee artículos sobre Imagen y otros productos de IA generativa en Vertex AI:

- Guía para desarrolladores para comenzar a usar Imagen 3 en Vertex AI

- Nuevos modelos y herramientas de medios generativos creados con y para los creadores

- Novedades de Gemini: Gemas personalizadas y generación de imágenes mejorada con Imagen 3

- Google DeepMind: Imagen 3: nuestro modelo de texto a imagen de mayor calidad

Salvo que se indique lo contrario, el contenido de esta página está sujeto a la licencia Atribución 4.0 de Creative Commons, y los ejemplos de código están sujetos a la licencia Apache 2.0. Para obtener más información, consulta las políticas del sitio de Google Developers. Java es una marca registrada de Oracle o sus afiliados.

Última actualización: 2025-10-19 (UTC)

-