Questo tutorial mostra come uno sviluppatore di servizi può risolvere i problemi di un servizio Cloud Run interrotto utilizzando gli strumenti Google Cloud Observability per l'individuazione e un flusso di lavoro di sviluppo locale per l'analisi.

Questo "case study" passo passo che accompagna la guida alla risoluzione dei problemi utilizza un progetto di esempio che genera errori di runtime durante il deployment, che risolvi per trovare e correggere il problema.

Configurazione dei valori predefiniti di gcloud

Per configurare gcloud con i valori predefiniti per il tuo servizio Cloud Run:

Imposta il progetto predefinito:

gcloud config set project PROJECT_ID

Sostituisci PROJECT_ID con il nome del progetto che hai creato per questo tutorial.

Configura gcloud per la regione scelta:

gcloud config set run/region REGION

Sostituisci REGION con la regione Cloud Run supportata che preferisci.

Località Cloud Run

Cloud Run è regionale, il che significa che l'infrastruttura che esegue i tuoi servizi Cloud Run si trova in una regione specifica ed è gestita da Google per essere disponibile in modo ridondante in tutte le zone all'interno di quella regione.

Il rispetto dei requisiti di latenza, disponibilità o durabilità sono fattori

primari per la selezione della regione in cui vengono eseguiti i servizi Cloud Run.

In genere puoi selezionare la regione più vicina ai tuoi utenti, ma devi considerare

la posizione degli altri Google Cloud

prodotti utilizzati dal tuo servizio Cloud Run.

L'utilizzo combinato dei prodotti Google Cloud in più località può influire

sulla latenza e sui costi del servizio.

Cloud Run è disponibile nelle seguenti regioni:

Soggetto ai prezzi di Livello 1

asia-east1(Taiwan)asia-northeast1(Tokyo)asia-northeast2(Osaka)asia-south1(Mumbai, India)europe-north1(Finlandia)Bassi livelli di CO2

europe-north2(Stoccolma)Bassi livelli di CO2

europe-southwest1(Madrid)Bassi livelli di CO2

europe-west1(Belgio)Bassi livelli di CO2

europe-west4(Paesi Bassi)Bassi livelli di CO2

europe-west8(Milano)europe-west9(Parigi)Bassi livelli di CO2

me-west1(Tel Aviv)northamerica-south1(Messico)us-central1(Iowa)Bassi livelli di CO2

us-east1(Carolina del Sud)us-east4(Virginia del Nord)us-east5(Columbus)us-south1(Dallas)Bassi livelli di CO2

us-west1(Oregon)Bassi livelli di CO2

Soggetto ai prezzi di Livello 2

africa-south1(Johannesburg)asia-east2(Hong Kong)asia-northeast3(Seul, Corea del Sud)asia-southeast1(Singapore)asia-southeast2(Giacarta)asia-south2(Delhi, India)australia-southeast1(Sydney)australia-southeast2(Melbourne)europe-central2(Varsavia, Polonia)europe-west10(Berlino)europe-west12(Torino)europe-west2(Londra, Regno Unito)Bassi livelli di CO2

europe-west3(Francoforte, Germania)europe-west6(Zurigo, Svizzera)A basse emissioni di CO2

me-central1(Doha)me-central2(Dammam)northamerica-northeast1(Montreal)Bassi livelli di CO2

northamerica-northeast2(Toronto)Bassi livelli di CO2

southamerica-east1(San Paolo, Brasile)Bassi livelli di CO2

southamerica-west1(Santiago, Cile)Bassi livelli di CO2

us-west2(Los Angeles)us-west3(Salt Lake City)us-west4(Las Vegas)

Se hai già creato un servizio Cloud Run, puoi visualizzare la regione nella dashboard Cloud Run nella consoleGoogle Cloud .

Assemblaggio del codice

Crea passo passo un nuovo servizio Cloud Run greeter. Ti ricordiamo che questo servizio crea intenzionalmente un errore di runtime per l'esercizio di risoluzione dei problemi.

Crea un nuovo progetto:

Node.js

Crea un progetto Node.js definendo il pacchetto di servizi, le dipendenze iniziali e alcune operazioni comuni.Crea una nuova directory

hello-service:mkdir hello-service cd hello-serviceCrea un nuovo progetto Node.js generando un file

package.json:npm init --yes npm install express@4Apri il nuovo file

package.jsonnell'editor e configura uno scriptstartper eseguirenode index.js. Al termine, il file avrà un aspetto simile al seguente:

Se continui a sviluppare questo servizio oltre il tutorial immediato, valuta la possibilità di compilare la descrizione, l'autore e la licenza. Per ulteriori dettagli, leggi la documentazione di package.json.

Python

Crea una nuova directory

hello-service:mkdir hello-service cd hello-serviceCrea un file requirements.txt e copia le dipendenze al suo interno:

Vai

Crea una nuova directory

hello-service:mkdir hello-service cd hello-serviceCrea un progetto Go inizializzando un nuovo modulo Go:

go mod init example.com/hello-service

Puoi aggiornare il nome specifico come preferisci: devi aggiornarlo se il codice viene pubblicato in un repository di codice accessibile dal web.

Java

Crea un nuovo progetto Maven:

mvn archetype:generate \ -DgroupId=com.example.cloudrun \ -DartifactId=hello-service \ -DarchetypeArtifactId=maven-archetype-quickstart \ -DinteractiveMode=falseCopia le dipendenze nell'elenco delle dipendenze

pom.xml(tra gli elementi<dependencies>):Copia l'impostazione di build in

pom.xml(sotto gli elementi<dependencies>):

Crea un servizio HTTP per gestire le richieste in entrata:

Node.js

Python

Go

Java

Crea un

Dockerfileper definire l'immagine container utilizzata per il deployment del servizio:Node.js

Python

Go

Java

Questo esempio utilizza Jib per creare immagini Docker utilizzando strumenti Java comuni. Jib ottimizza le build dei container senza la necessità di un Dockerfile o di Docker installato. Scopri di più sulla creazione di container Java con Jib.

Invio del codice in corso…

Il codice di spedizione è costituito da tre passaggi: creazione di un'immagine container con Cloud Build, caricamento dell'immagine container in Container Registry e deployment dell'immagine container in Cloud Run.

Per spedire il codice:

Crea il container e pubblicalo in Container Registry:

Node.js

gcloud builds submit --tag gcr.io/PROJECT_ID/hello-service

dove PROJECT_ID è l'ID progetto Google Cloud. Puoi controllare l'ID progetto corrente con

gcloud config get-value project.In caso di esito positivo, dovresti visualizzare un messaggio di operazione riuscita contenente l'ID, l'ora di creazione e il nome dell'immagine. L'immagine è archiviata in Container Registry e, se lo desideri, può essere riutilizzata.

Python

gcloud builds submit --tag gcr.io/PROJECT_ID/hello-service

dove PROJECT_ID è l'ID progetto Google Cloud. Puoi controllare l'ID progetto corrente con

gcloud config get-value project.In caso di esito positivo, dovresti visualizzare un messaggio di operazione riuscita contenente l'ID, l'ora di creazione e il nome dell'immagine. L'immagine è archiviata in Container Registry e, se lo desideri, può essere riutilizzata.

Vai

gcloud builds submit --tag gcr.io/PROJECT_ID/hello-service

dove PROJECT_ID è l'ID progetto Google Cloud. Puoi controllare l'ID progetto corrente con

gcloud config get-value project.In caso di esito positivo, dovresti visualizzare un messaggio di operazione riuscita contenente l'ID, l'ora di creazione e il nome dell'immagine. L'immagine è archiviata in Container Registry e, se lo desideri, può essere riutilizzata.

Java

- Utilizza l'assistente per le credenziali gcloud

per autorizzare Docker a eseguire il push su Container Registry.

gcloud auth configure-docker

- Utilizza il plug-in Jib Maven per creare il container ed eseguirne il push su Container Registry.

mvn compile jib:build -Dimage=gcr.io/PROJECT_ID/hello-service

dove PROJECT_ID è l'ID progetto Google Cloud. Puoi controllare l'ID progetto corrente con

gcloud config get-value project.In caso di esito positivo, dovresti visualizzare un messaggio BUILD SUCCESS. L'immagine è archiviata in Container Registry e, se lo desideri, può essere riutilizzata.

- Utilizza l'assistente per le credenziali gcloud

per autorizzare Docker a eseguire il push su Container Registry.

Esegui questo comando per eseguire il deployment dell'app:

gcloud run deploy hello-service --image gcr.io/PROJECT_ID/hello-service

Sostituisci PROJECT_ID con l'ID del tuo progetto Google Cloud.

hello-serviceè sia il nome dell'immagine container sia il nome del servizio Cloud Run. Tieni presente che l'immagine container viene implementata nel servizio e nella regione che hai configurato in precedenza in Configurazione di gcloud.Rispondi

y, "Sì", alla richiesta Consenti non autenticato. Per ulteriori dettagli sull'autenticazione basata su IAM, consulta la pagina Gestione dell'accesso.Attendi il completamento del deployment, che può richiedere circa 30 secondi. Se l'operazione riesce, la riga di comando visualizza l'URL del servizio.

Prova

Prova il servizio per verificare che il deployment sia stato eseguito correttamente. Le richieste devono non riuscire con un errore HTTP 500 o 503 (membri della classe 5xx Server errors). Il tutorial illustra la procedura di risoluzione dei problemi relativi a questa risposta di errore.

Al servizio viene assegnato automaticamente un URL navigabile.

Vai a questo URL con il browser web:

Apri un browser web.

Individua l'output dell'URL del servizio del comando di deployment precedente.

Se il comando di deployment non ha fornito un URL, si è verificato un problema. Esamina il messaggio di errore e agisci di conseguenza: se non sono presenti indicazioni pratiche, consulta la guida alla risoluzione dei problemi e, se necessario, riprova a eseguire il comando di deployment.

Vai a questo URL copiandolo nella barra degli indirizzi del browser e premendo INVIO.

Visualizza l'errore HTTP 500 o HTTP 503.

Se ricevi un errore HTTP 403, è possibile che tu abbia rifiutato

allow unauthenticated invocationsal prompt di deployment. Concedi l'accesso pubblico al servizio per risolvere il problema:gcloud run services add-iam-policy-binding hello-service \ --member="allUsers" \ --role="roles/run.invoker"

Per saperne di più, leggi Consentire l'accesso pubblico (non autenticato).

Analisi del problema

Visualizza l'errore HTTP 5xx riscontrato in precedenza nella sezione Prova come errore di runtime di produzione. Questo tutorial illustra una procedura formale per gestirlo. Sebbene le procedure di risoluzione degli errori di produzione varino notevolmente, questo tutorial presenta una sequenza particolare di passaggi per mostrare l'applicazione di strumenti e tecniche utili.

Per analizzare il problema, dovrai seguire queste fasi:

- Raccogli ulteriori dettagli sull'errore segnalato per supportare ulteriori indagini e definire una strategia di mitigazione.

- Ridurre l'impatto sugli utenti decidendo di procedere con una correzione o di eseguire il rollback a una versione integra nota.

- Riproduci l'errore per verificare che siano stati raccolti i dettagli corretti e che l'errore non sia un problema temporaneo

- Esegui un'analisi delle cause principali del bug per trovare il codice, la configurazione o il processo che ha creato questo errore

All'inizio dell'indagine hai un URL, un timestamp e il messaggio "Internal Server Error".

Raccolta di ulteriori dettagli

Raccogliere ulteriori informazioni sul problema per capire cosa è successo e determinare i passaggi successivi.

Utilizza gli strumenti Google Cloud Observability disponibili per raccogliere maggiori dettagli:

Utilizza la console Error Reporting, che fornisce una dashboard con dettagli e monitoraggio della ricorrenza degli errori con uno stack trace riconosciuto.

Vai alla console Error Reporting

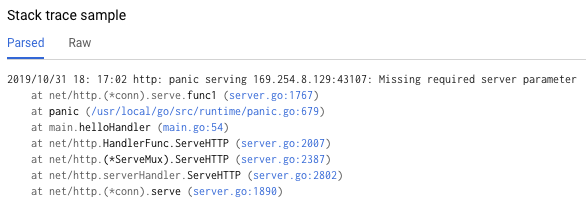

Elenco degli errori registrati. Gli errori vengono raggruppati per messaggio in base a revisioni, servizi e piattaforme. Fai clic sull'errore per visualizzare i dettagli analisi dello stack, annotando le chiamate di funzione effettuate immediatamente prima dell'errore.

Il "Campione di analisi dello stack" nella pagina dei dettagli dell'errore mostra una singola istanza dell'errore. Puoi esaminare ogni singola istanza. Utilizza Cloud Logging per esaminare la sequenza di operazioni che hanno portato al problema, inclusi i messaggi di errore che non sono inclusi nella console Error Reporting a causa della mancanza di una trace dello stack di errori riconosciuta:

Vai alla console Cloud Logging

Seleziona Revisione Cloud Run > hello-service dalla prima casella a discesa. In questo modo, le voci di log verranno filtrate in base a quelle generate dal tuo servizio.

Scopri di più sulla visualizzazione dei log in Cloud Run.

Eseguire il rollback a una versione integra

Se si tratta di un servizio consolidato, noto per funzionare, in Cloud Run sarà presente una revisione precedente del servizio. Questo tutorial utilizza un nuovo servizio senza versioni precedenti, quindi non puoi eseguire un rollback.

Tuttavia, se hai un servizio con versioni precedenti a cui puoi eseguire il rollback, segui la procedura descritta in Visualizzazione dei dettagli della revisione per estrarre il nome del container e i dettagli di configurazione necessari per creare un nuovo deployment funzionante del servizio.

Riproduzione dell'errore

Utilizzando i dettagli ottenuti in precedenza, verifica che il problema si verifichi in modo coerente nelle condizioni di test.

Invia di nuovo la stessa richiesta HTTP provandola e verifica se vengono segnalati lo stesso errore e gli stessi dettagli. Potrebbe essere necessario del tempo prima che vengano visualizzati i dettagli dell'errore.

Poiché il servizio di esempio in questo tutorial è di sola lettura e non attiva effetti collaterali complicati, la riproduzione degli errori in produzione è sicura. Tuttavia, per molti servizi reali, non sarà così: potrebbe essere necessario riprodurre gli errori in un ambiente di test o limitare questo passaggio all'analisi locale.

La riproduzione dell'errore stabilisce il contesto per il lavoro successivo. Ad esempio, se gli sviluppatori non riescono a riprodurre l'errore, ulteriori indagini potrebbero richiedere strumenti aggiuntivi per il servizio.

Esecuzione di un'analisi delle cause principali

L'analisi della causa principale è un passaggio importante per la risoluzione efficace dei problemi, in quanto ti consente di risolvere il problema anziché un sintomo.

In precedenza in questo tutorial, hai riprodotto il problema su Cloud Run, il che conferma che il problema è attivo quando il servizio è ospitato su Cloud Run. Ora riproduci il problema localmente per determinare se è isolato nel codice o se si verifica solo nell'hosting di produzione.

Se non hai utilizzato Docker CLI localmente con Container Registry, autenticalo con gcloud:

gcloud auth configure-docker

Per approcci alternativi, vedi Metodi di autenticazione di Container Registry.

Se il nome dell'immagine container utilizzata più di recente non è disponibile, la descrizione del servizio contiene le informazioni sull'immagine container di cui è stato eseguito il deployment più di recente:

gcloud run services describe hello-service

Trova il nome dell'immagine container all'interno dell'oggetto

spec. Un comando più mirato può recuperarlo direttamente:gcloud run services describe hello-service \ --format="value(spec.template.spec.containers.image)"

Questo comando mostra un nome dell'immagine container, ad esempio

gcr.io/PROJECT_ID/hello-service.Esegui il pull dell'immagine container da Container Registry al tuo ambiente. Questo passaggio potrebbe richiedere diversi minuti, poiché scarica l'immagine container:

docker pull gcr.io/PROJECT_ID/hello-service

Gli aggiornamenti successivi all'immagine container che riutilizzano questo nome possono essere recuperati con lo stesso comando. Se salti questo passaggio, il comando

docker runriportato di seguito esegue il pull di un'immagine container se non è presente sulla macchina locale.Esegui localmente per verificare che il problema non sia specifico di Cloud Run:

PORT=8080 && docker run --rm -e PORT=$PORT -p 9000:$PORT \ gcr.io/PROJECT_ID/hello-service

Analizzando gli elementi del comando precedente,

- La variabile di ambiente

PORTviene utilizzata dal servizio per determinare la porta da ascoltare all'interno del container. - Il comando

runavvia il container, utilizzando per impostazione predefinita il comando entrypoint definito nel Dockerfile o in un'immagine container padre. - Il flag

--rmelimina l'istanza del container all'uscita. - Il flag

-eassegna un valore a una variabile di ambiente.-e PORT=$PORTsta propagando la variabilePORTdal sistema locale al contenitore con lo stesso nome della variabile. - Il flag

-ppubblica il contenitore come servizio disponibile su localhost sulla porta 9000. Le richieste a localhost:9000 verranno instradate al container sulla porta 8080. Ciò significa che l'output del servizio relativo al numero di porta in uso non corrisponderà alla modalità di accesso al servizio. - L'argomento finale

gcr.io/PROJECT_ID/hello-serviceè un'immagine containertag, un'etichetta leggibile per l'identificatore hash sha256 di un'immagine container. Se non è disponibile localmente, Docker tenta di recuperare l'immagine da un registro remoto.

Nel browser, apri http://localhost:9000. Controlla l'output del terminale per messaggi di errore che corrispondono a quelli su {ops_name}}.

Se il problema non è riproducibile localmente, potrebbe essere specifico dell'ambiente Cloud Run. Consulta la guida alla risoluzione dei problemi di Cloud Run per aree specifiche da esaminare.

In questo caso, l'errore viene riprodotto localmente.

- La variabile di ambiente

Ora che l'errore è stato confermato due volte come persistente e causato dal codice del servizio anziché dalla piattaforma di hosting, è il momento di esaminare il codice più da vicino.

Ai fini di questo tutorial, è sicuro presupporre che il codice all'interno del container e il codice nel sistema locale siano identici.

Riesamina lo analisi dello stack del report sugli errori e confrontalo con il codice per trovare le righe specifiche che hanno causato l'errore.

Node.js

Trova l'origine del messaggio di errore nel fileindex.js intorno al numero di riga

indicato nellaanalisi dello stackk mostrata nei log:

Python

Trova l'origine del messaggio di errore nel filemain.py intorno al numero di riga

indicato nellaanalisi dello stackk mostrata nei log:

Vai

Trova l'origine del messaggio di errore nel file main.go intorno al numero di riga

indicato nellaanalisi dello stackk mostrata nei log:

Java

Trova l'origine del messaggio di errore nel file App.java intorno al numero di riga indicato nella analisi dello stack mostrata nei log:

Esaminando questo codice, vengono eseguite le seguenti azioni quando la variabile di ambiente NAME non è impostata:

- Viene registrato un errore in Google Cloud Observability

- Viene inviata una risposta di errore HTTP

Il problema è causato da una variabile mancante, ma la causa principale è più specifica: la modifica del codice che aggiunge la dipendenza rigida da una variabile di ambiente non include modifiche correlate agli script di deployment e alla documentazione dei requisiti di runtime.

Risoluzione della causa principale

Ora che abbiamo raccolto il codice e identificato la potenziale causa principale, possiamo adottare le misure necessarie per risolvere il problema.

Controlla se il servizio funziona localmente con l'ambiente

NAMEdisponibile:Esegui il container localmente con la variabile di ambiente aggiunta:

PORT=8080 && docker run --rm -e PORT=$PORT -p 9000:$PORT \ -e NAME="Local World!" \ gcr.io/PROJECT_ID/hello-service

Nel browser, vai alla pagina http://localhost:9000

Visualizzare "Hello Local World!" sulla pagina

Modifica l'ambiente del servizio Cloud Run in esecuzione in modo da includere questa variabile:

Esegui il comando di aggiornamento dei servizi per aggiungere una variabile di ambiente:

gcloud run services update hello-service \ --set-env-vars NAME=OverrideAttendi qualche secondo mentre Cloud Run crea una nuova revisione basata sulla revisione precedente con la nuova variabile di ambiente aggiunta.

Conferma che il servizio è stato riparato:

- Vai all'URL del servizio Cloud Run nel browser.

- Visualizza "Hello Override!" nella pagina.

- Verifica che in Cloud Logging o in Error Reporting non vengano visualizzati messaggi o errori imprevisti.

Miglioramento della velocità di risoluzione dei problemi futuri

In questo problema di produzione di esempio, l'errore era correlato alla configurazione operativa. Sono state apportate modifiche al codice che ridurranno al minimo l'impatto di questo problema in futuro.

- Migliora il log degli errori in modo che includa dettagli più specifici.

- Anziché restituire un errore, il servizio deve eseguire il failover su un valore predefinito sicuro. Se l'utilizzo di un valore predefinito rappresenta una modifica alla funzionalità normale, utilizza un messaggio di avviso a scopo di monitoraggio.

Vediamo come rimuovere la variabile di ambiente NAME come dipendenza rigida.

Rimuovi il codice di gestione di

NAMEesistente:Node.js

Python

Go

Java

Aggiungi un nuovo codice che imposta un valore di riserva:

Node.js

Python

Go

Java

Esegui il test in locale ricompilando ed eseguendo il container nei casi di configurazione interessati:

Node.js

docker build --tag gcr.io/PROJECT_ID/hello-service .

Python

docker build --tag gcr.io/PROJECT_ID/hello-service .

Vai

docker build --tag gcr.io/PROJECT_ID/hello-service .

Java

mvn compile jib:build

Verifica che la variabile di ambiente

NAMEfunzioni ancora:PORT=8080 && docker run --rm -e PORT=$PORT -p 9000:$PORT \ -e NAME="Robust World" \ gcr.io/PROJECT_ID/hello-service

Verifica che il servizio funzioni senza la variabile

NAME:PORT=8080 && docker run --rm -e PORT=$PORT -p 9000:$PORT \ gcr.io/PROJECT_ID/hello-service

Se il servizio non restituisce un risultato, verifica che la rimozione del codice nel primo passaggio non abbia rimosso righe aggiuntive, ad esempio quelle utilizzate per scrivere la risposta.

Esegui il deployment tornando alla sezione Esegui il deployment del codice.

Ogni deployment in un servizio crea una nuova revisione e inizia automaticamente a gestire il traffico quando è pronto.

Per cancellare le variabili di ambiente impostate in precedenza:

gcloud run services update hello-service --clear-env-vars

Aggiungi la nuova funzionalità per il valore predefinito alla copertura dei test automatizzati per il servizio.

Trovare altri problemi nei log

Potresti visualizzare altri problemi nel visualizzatore log per questo servizio. Ad esempio, una chiamata di sistema non supportata verrà visualizzata nei log come "Limitazione sandbox del container".

Ad esempio, i servizi Node.js a volte generano questo messaggio di log:

Container Sandbox Limitation: Unsupported syscall statx(0xffffff9c,0x3e1ba8e86d88,0x0,0xfff,0x3e1ba8e86970,0x3e1ba8e86a90). Please, refer to https://gvisor.dev/c/linux/amd64/statx for more information.

In questo caso, la mancanza di supporto non influisce sul servizio di esempio hello-service.

Risoluzione dei problemi di Terraform

Per domande o risoluzione dei problemi relativi a Terraform, consulta Risoluzione dei problemi di convalida delle norme Terraform o contatta l'assistenza Terraform.