In diesem Dokument wird beschrieben, wie Sie Cloud Logging-Buckets mit der Google Cloud -Konsole, der Google Cloud CLI und der Logging API erstellen und verwalten.

Außerdem enthält sie eine Anleitung zum Erstellen und Verwalten von Log-Buckets aufGoogle Cloud -Projektebene. Sie können keine Log-Buckets auf Ordner- oder Organisationsebene erstellen. Cloud Logging erstellt jedoch automatisch die Log-Buckets _Default und _Required auf Ordner- und Organisationsebene für Sie.

Sie können Log-Buckets upgraden, um Log Analytics zu verwenden. Mit Log Analytics können Sie SQL-Abfragen für Ihre Logdaten ausführen und so Probleme mit Anwendungen, Sicherheit und Netzwerken beheben.

Wenn Sie BigQuery zum Analysieren Ihrer Logdaten verwenden möchten, haben Sie zwei Möglichkeiten:

Führen Sie ein Upgrade eines Log-Buckets durch, um Loganalysen zu verwenden, und erstellen Sie dann ein verknüpftes BigQuery-Dataset. In diesem Szenario werden Ihre Logdaten in Logging gespeichert, können aber von BigQuery gelesen werden.

Logeinträge nach BigQuery exportieren In diesem Szenario müssen Sie eine Senke erstellen. BigQuery speichert und verwaltet die Daten und Sie haben die Möglichkeit, partitionierte Tabellen zu verwenden.

Wenn Ihre Logdaten in BigQuery verfügbar sind, können Sie sie mit anderen in BigQuery gespeicherten Daten verknüpfen und über andere Tools wie Looker Studio und Looker darauf zugreifen.

Eine konzeptionelle Übersicht über Buckets finden Sie unter Routing und Speicherübersicht: Log-Buckets.

In diesem Dokument wird nicht beschrieben, wie Sie einen Log-Bucket erstellen, der einen vom Kunden verwalteten Verschlüsselungsschlüssel (Customer-Managed Encryption Key, CMEK) verwendet. Wenn Sie sich für dieses Thema interessieren, lesen Sie den Abschnitt CMEK für die Logspeicherung konfigurieren.

Hinweise

Gehen Sie für einen Einstieg in Buckets folgendermaßen vor:

- Konfigurieren Sie Ihr Google Cloud -Projekt:

-

Verify that billing is enabled for your Google Cloud project.

-

Bitten Sie Ihren Administrator, Ihnen die IAM-Rolle Logs Configuration Writer (

roles/logging.configWriter) für Ihr Projekt zuzuweisen, um die Berechtigungen zu erhalten, die Sie zum Erstellen, Aktualisieren und Verknüpfen eines Log-Buckets benötigen. Weitere Informationen zum Zuweisen von Rollen finden Sie unter Zugriff auf Projekte, Ordner und Organisationen verwalten.Sie können die erforderlichen Berechtigungen auch über benutzerdefinierte Rollen oder andere vordefinierte Rollen erhalten.

Eine vollständige Liste der Berechtigungen und Rollen finden Sie unter Zugriffssteuerung mit IAM.

- Optional: Wenn Sie BigQuery verwenden möchten, um die in einem Log-Bucket gespeicherten Daten anzusehen, gehen Sie so vor:

- Die BigQuery API muss aktiviert sein. Sie können prüfen, ob die API aktiviert ist, indem Sie verfügbare Dienste auflisten.

- Ihre Identity and Access Management-Rolle enthält die Berechtigungen, mit denen Sie ein verknüpftes Dataset erstellen können. Weitere Informationen finden Sie unter Berechtigungen für verknüpfte BigQuery-Datasets.

-

- Machen Sie sich mit den unterstützten Regionen vertraut, in denen Sie Ihre Logs speichern können.

-

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

gcloud

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

REST

Wenn Sie die REST API-Beispiele auf dieser Seite in einer lokalen Entwicklungsumgebung verwenden möchten, verwenden Sie die Anmeldedaten, die Sie der gcloud CLI bereitstellen.

Installieren Sie die Google Cloud CLI. Initialisieren Sie die Google Cloud CLI nach der Installation mit dem folgenden Befehl:

gcloud initWenn Sie einen externen Identitätsanbieter (IdP) verwenden, müssen Sie sich zuerst mit Ihrer föderierten Identität in der gcloud CLI anmelden.

Weitere Informationen finden Sie in der Dokumentation zur Google Cloud -Authentifizierung unter Für die Verwendung von REST authentifizieren.

- Wenn Sie die Google Cloud CLI oder die Cloud Logging API zum Erstellen oder Verwalten Ihrer Log-Buckets verwenden möchten, müssen Sie die Formatierungsanforderungen für

LogBucketkennen.Bucket erstellen

Sie können maximal 100 Buckets proGoogle Cloud -Projekt erstellen.

So erstellen Sie einen benutzerdefinierten Log-Bucket für Ihr Google Cloud -Projekt:

Google Cloud Console

So erstellen Sie einen Log-Bucket in Ihrem Google Cloud -Projekt:

-

Rufen Sie in der Google Cloud Console die Seite Logspeicher auf:

Wenn Sie diese Seite über die Suchleiste suchen, wählen Sie das Ergebnis aus, dessen Zwischenüberschrift Logging ist.

Klicken Sie auf Log-Bucket erstellen.

Geben Sie unter Name einen Namen und unter Beschreibung eine Beschreibung für den Bucket ein.

Optional: Führen Sie ein Upgrade Ihres Buckets durch, um Log Analytics zu verwenden.

Wählen Sie Upgrade durchführen, um Log Analytics zu verwenden aus.

Wenn Sie ein Upgrade eines Buckets für die Verwendung von Loganalysen durchführen, können Sie Ihre Logs auf der Seite Loganalysen mit SQL-Abfragen abfragen. Sie können Ihre Logs auch weiterhin mit dem Log-Explorer aufrufen.

Optional: Wenn Sie Ihre Logs in BigQuery ansehen möchten, wählen Sie Neues BigQuery-Dataset erstellen, das mit diesem Bucket verknüpft ist aus und geben Sie einen eindeutigen Dataset-Namen ein.

Wenn Sie diese Option auswählen, kann BigQuery die in Ihrem Log-Bucket gespeicherten Daten lesen. Sie können jetzt in der BigQuery-Benutzeroberfläche Abfragen ausführen, um Ihre Logdaten zu verknüpfen und auf Daten aus anderen Tools wie Looker Studio und Looker zuzugreifen.

Optional: Wenn Sie die Region für die Speicherung Ihrer Logs auswählen möchten, klicken Sie auf das Menü Log-Bucket-Region auswählen und wählen Sie eine Region aus. Wenn Sie keine Region auswählen, wird die Region

globalverwendet. Das bedeutet, dass sich die Logs in einer beliebigen unterstützten Region befinden können.Optional: Wenn Sie eine benutzerdefinierte Aufbewahrungsdauer für die Logs im Bucket festlegen möchten, klicken Sie auf Weiter.

Geben Sie im Feld Aufbewahrungszeitraum die Anzahl der Tage zwischen 1 und 3.650 Tagen ein, in denen Cloud Logging die Logs speichern soll. Wenn Sie die Aufbewahrungsdauer nicht anpassen, wird der Standardwert

30 daysverwendet.Sie können Ihren Bucket auch nach der Erstellung mit einer benutzerdefinierten Aufbewahrungszeit aktualisieren.

Klicken Sie auf Bucket erstellen.

Nachdem der Log-Bucket erstellt wurde, wird er durch Logging aktualisiert und der Dataset-Link wird erstellt, sofern diese Optionen ausgewählt wurden.

Es kann einen Moment dauern, bis diese Schritte abgeschlossen sind.

gcloud

Wenn Sie nur einen Log-Bucket erstellen möchten, führen Sie den Befehl

gcloud logging buckets createaus. Wenn Sie den Log-Bucket für die Verwendung von Loganalysen upgraden möchten, fügen Sie die Flags--enable-analyticsund--asyncein und legen Sie die Variable LOCATION auf eine unterstützte Region fest:gcloud logging buckets create BUCKET_ID --location=LOCATION --enable-analytics --async OPTIONAL_FLAGS

Das Flag

--asyncerzwingt, dass der Befehl asynchron ausgeführt wird. Der Rückgabewert einer asynchronen Methode ist einOperation-Objekt, das Informationen zum Fortschritt der Methode enthält. Wenn die Methode abgeschlossen ist, enthält dasOperation-Objekt den Status. Weitere Informationen finden Sie unter Asynchrone API-Methoden.Wenn Sie den Log-Bucket nicht für die Verwendung von Loganalysen aktualisieren möchten, lassen Sie die Flags

--enable-analyticsund--asyncweg.Wenn Sie zum Beispiel einen Bucket mit der BUCKET_ID

my-bucketin der Regionglobalerstellen möchten, würde Ihr Befehl so aussehen:gcloud logging buckets create my-bucket --location global --description "My first bucket"

Wenn Sie beispielsweise einen Bucket mit der BUCKET_ID

my-upgraded-bucketam Standortglobalerstellen und dann den Log-Bucket für die Verwendung von Log Analytics aktualisieren möchten, würde Ihr Befehl so aussehen:gcloud logging buckets create my-upgraded-bucket --location global \ --description "My first upgraded bucket" \ --enable-analytics --retention-days=45REST

Verwenden Sie zum Erstellen eines Buckets die Methode

projects.locations.buckets.createoderprojects.locations.buckets.createAsync. Bereiten Sie die Argumente für die Methode so vor:Legen Sie den Parameter

parentauf die Ressource fest, in der der Bucket erstellt werden soll:projects/PROJECT_ID/locations/LOCATIONDie Variable LOCATION bezieht sich auf die Region, in der Ihre Logs gespeichert werden sollen.

Wenn Sie beispielsweise einen Bucket für das Projekt

my-projectin der Regionglobalerstellen möchten, sieht der Parameterparentso aus:projects/my-project/locations/globalLegen Sie den Parameter

bucketIdfest, z. B.my-bucket.Führen Sie einen der folgenden Schritte aus:

So erstellen Sie einen Log-Bucket und führen dann ein Upgrade des Log-Buckets zur Verwendung von Loganalysen durch:

Setzen Sie den booleschen Wert

LogBucket.analyticsEnabledauftrue.Rufen Sie die asynchrone Methode

projects.locations.buckets.createAsyncauf, um den Bucket zu erstellen.Die Antwort auf die asynchronen Methoden ist ein

Operation-Objekt. Dieses Objekt enthält Informationen zum Fortschritt der Methode. Wenn die Methode abgeschlossen ist, enthält dasOperation-Objekt den Status. Weitere Informationen finden Sie unter Asynchrone API-Methoden.Die Methode

createAsynckann mehrere Minuten dauern. Bei dieser Methode wird keine Fehlermeldung generiert und sie schlägt auch nicht fehl, wenn der boolesche WertanalyticsEnabledauftruegesetzt ist.

Rufen Sie andernfalls die synchrone Methode

projects.locations.buckets.createauf, um den Bucket zu erstellen.

Nachdem Sie einen Bucket erstellt haben, erstellen Sie eine Senke, um Logeinträge an den Bucket weiterzuleiten, und konfigurieren Sie Logansichten, um zu bestimmen, wer auf die Logs in dem neuen Bucket zugreifen kann und auf welche Logs sie Zugriff haben. Sie können den Bucket auch aktualisieren, um eine benutzerdefinierte Aufbewahrungsdauer und eingeschränkte Felder zu konfigurieren.

Volumen der in Log-Buckets gespeicherten Logs im Blick behalten

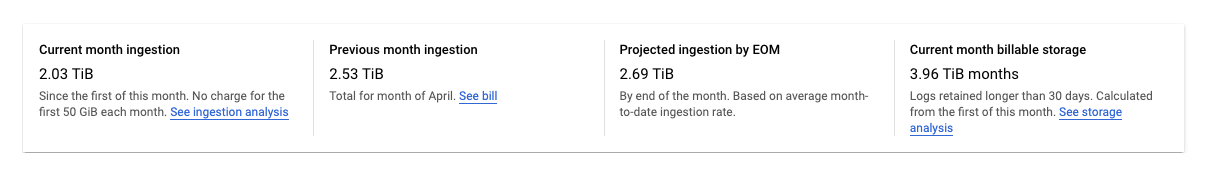

Auf der Seite Logspeicher in der Google Cloud Console wird das Volumen der in Log-Buckets gespeicherten Logdaten erfasst:

Rufen Sie in der Google Cloud Console die Seite Logspeicher auf:

Wenn Sie diese Seite über die Suchleiste suchen, wählen Sie das Ergebnis aus, dessen Zwischenüberschrift Logging ist.

Auf der Seite Logspeicher wird eine Zusammenfassung der Statistiken für IhrGoogle Cloud -Projekt angezeigt:

Die folgenden Statistiken werden gemeldet:

Aufnahme im aktuellen Monat: Die Menge der Logdaten, die seit dem ersten Tag des aktuellen Kalendermonats in Log-Buckets für IhrGoogle Cloud -Projekt gespeichert wurden.

Aufnahme im vorherigen Monat: Der Umfang der Logdaten, die IhrGoogle Cloud -Projekt im letzten Kalendermonat in Log-Buckets gespeichert hat.

Prognostizierte Aufnahme bis zum Monatsende: Die geschätzte Menge an Logdaten, die IhrGoogle Cloud -Projekt bis zum Ende des aktuellen Kalendermonats auf der Grundlage der aktuellen Nutzung in Log-Buckets speichern wird.

Abrechenbarer Speicher im aktuellen Monat: Die Menge der Logdaten, die länger als 30 Tage aufbewahrt wurden und abgerechnet werden.

Die vorherigen Statistiken enthalten keine Logs im Bucket

_Required. Die Logs in diesem Bucket können nicht ausgeschlossen oder deaktiviert werden.Auf der Seite Log-Router in der Google Cloud Console finden Sie Tools, mit denen Sie die Gebühren für das Speichern von Logs in Log-Buckets oder für Speicherplatz, der Ihr monatliches Kontingent überschreitet, minimieren können. In diesem Fall können Sie folgende Aktionen ausführen:

- Deaktivieren Sie das Speichern von Logs auf Bucket-Ebene.

- Bestimmte Logeinträge davon ausschließen, in Log-Buckets gespeichert zu werden.

Weitere Informationen finden Sie unter Senken verwalten.

Buckets verwalten

In diesem Abschnitt wird beschrieben, wie Sie Ihre Log-Buckets mit der Google Cloud CLI oder der Google Cloud -Konsole verwalten.

Bucket aktualisieren

So aktualisieren Sie die Eigenschaften Ihres Buckets, z. B. die Beschreibung oder die Aufbewahrungsdauer:Google Cloud Console

So aktualisieren Sie die Eigenschaften Ihres Buckets:

-

Rufen Sie in der Google Cloud Console die Seite Logspeicher auf:

Wenn Sie diese Seite über die Suchleiste suchen, wählen Sie das Ergebnis aus, dessen Zwischenüberschrift Logging ist.

Klicken Sie für den Bucket, den Sie aktualisieren möchten, auf more_vert Mehr.

Klicken Sie auf Bucket bearbeiten.

Bearbeiten Sie den Bucket nach Bedarf.

Klicken Sie auf Bucket aktualisieren.

gcloud

Führen Sie zum Aktualisieren der Eigenschaften Ihres Buckets den Befehl

gcloud logging buckets updateaus:gcloud logging buckets update BUCKET_ID --location=LOCATION UPDATED_ATTRIBUTES

Beispiel:

gcloud logging buckets update my-bucket --location=global --description "Updated description"

REST

Verwenden Sie zum Aktualisieren der Eigenschaften Ihres Buckets

projects.locations.buckets.patchin der Logging API.Bucket für die Verwendung von Log Analytics upgraden

Nachdem Sie ein Upgrade für einen Bucket zur Verwendung von Log Analytics durchgeführt haben, können Sie alle neuen Logeinträge, die eingehen, über die Log Analytics-Benutzeroberfläche analysieren. Cloud Logging initiiert außerdem einen Backfill-Vorgang, mit dem Sie ältere Logeinträge analysieren können, die vor dem Upgrade geschrieben wurden. Der Backfill-Prozess kann mehrere Stunden dauern. Sie können ein Upgrade für einen Bucket nicht rückgängig machen.

Für das Upgrade eines vorhandenen Buckets zur Verwendung von Loganalysen gelten die folgenden Einschränkungen:

- Der Log-Bucket wurde auf der Ebene des Projekts Google Cloud erstellt.

- Der Log-Bucket ist entsperrt, sofern es sich nicht um den Bucket

_Requiredhandelt. Für den Bucket sind keine Updates ausstehend.

Google Cloud Console

So führen Sie ein Upgrade eines vorhandenen Buckets durch, um Loganalysen zu verwenden:

-

Rufen Sie in der Google Cloud Console die Seite Logspeicher auf:

Wenn Sie diese Seite über die Suchleiste suchen, wählen Sie das Ergebnis aus, dessen Zwischenüberschrift Logging ist.

Suchen Sie den Bucket, den Sie upgraden möchten.

Wenn in der Spalte Loganalysen verfügbar die Option Upgrade angezeigt wird, können Sie den Log-Bucket upgraden, um Loganalysen zu verwenden. Klicken Sie auf Upgrade.

Ein Dialogfeld wird geöffnet. Klicken Sie auf Bestätigen.

gcloud

Führen Sie den Befehl

gcloud logging buckets updateaus, um Ihr Log-Bucket für die Verwendung von Log Analytics zu aktualisieren. Sie müssen das Flag--enable-analyticsfestlegen. Wir empfehlen, auch das Flag--asynceinzufügen:gcloud logging buckets update BUCKET_ID --location=LOCATION --enable-analytics --async

Das Flag

--asyncerzwingt, dass der Befehl asynchron ausgeführt wird. Der Rückgabewert einer asynchronen Methode ist einOperation-Objekt, das Informationen zum Fortschritt der Methode enthält. Wenn die Methode abgeschlossen ist, enthält dasOperation-Objekt den Status. Weitere Informationen finden Sie unter Asynchrone API-Methoden.REST

Wenn Sie einen Log-Bucket auf Loganalysen umstellen möchten, verwenden Sie die Methode

projects.locations.buckets.updateAsyncder Cloud Logging API.Bereiten Sie die Argumente für die Methode so vor:

- Setzen Sie den booleschen Wert

LogBucket.analyticsEnabledauftrue. - Verwenden Sie für den Abfrageparameter des Befehls

updateMask=analyticsEnabled.

Die Antwort auf die asynchronen Methoden ist ein

Operation-Objekt. Dieses Objekt enthält Informationen zum Fortschritt der Methode. Wenn die Methode abgeschlossen ist, enthält dasOperation-Objekt den Status. Weitere Informationen finden Sie unter Asynchrone API-Methoden.Die Ausführung von

updateAsynckann einige Minuten dauern.Verknüpftes BigQuery-Dataset erstellen

Wenn Sie die Funktionen von BigQuery zum Analysieren Ihrer Logdaten nutzen möchten, führen Sie ein Upgrade eines Log-Buckets durch, um Loganalysen zu verwenden, und erstellen Sie dann ein verknüpftes Dataset. Bei dieser Konfiguration werden Ihre Logdaten in Logging gespeichert, können aber von BigQuery gelesen werden.

Google Cloud Console

So erstellen Sie einen Link zu einem BigQuery-Dataset für einen vorhandenen Log-Bucket:

-

Rufen Sie in der Google Cloud Console die Seite Logspeicher auf:

Wenn Sie diese Seite über die Suchleiste suchen, wählen Sie das Ergebnis aus, dessen Zwischenüberschrift Logging ist.

Suchen Sie den Log-Bucket und prüfen Sie, ob in der Spalte Loganalysen verfügbar die Option Öffnen angezeigt wird.

Wenn in dieser Spalte Upgrade angezeigt wird, wurde für den Log-Bucket noch kein Upgrade für die Verwendung von Log Analytics durchgeführt. So konfigurieren Sie Log Analytics:

- Klicken Sie auf Upgrade.

- Klicken Sie im Dialogfeld auf Bestätigen.

Fahren Sie nach Abschluss des Upgrades mit dem nächsten Schritt fort.

Klicken Sie auf den Log-Bucket auf Mehrmore_vert und dann auf Bucket bearbeiten.

Das Dialogfeld Log-Bucket bearbeiten wird geöffnet.

Wählen Sie Neues BigQuery-Dataset erstellen, das mit diesem Bucket verknüpft ist aus und geben Sie den Namen für das neue Dataset ein.

Der Dataset-Name muss für jedes Google Cloud Projekt eindeutig sein. Wenn Sie den Namen eines vorhandenen Datasets eingeben, wird der folgende Fehler angezeigt:

Dataset name must be unique in the selected region.Klicken Sie auf Fertig und dann auf Bucket aktualisieren.

Nachdem der Name des verknüpften Datasets auf der Seite Logs Storage (Logs-Speicher) angezeigt wird, kann es einige Minuten dauern, bis BigQuery das Dataset erkennt.

gcloud

Führen Sie den Befehl

gcloud logging links createaus, um ein verknüpftes Dataset für einen Log-Bucket zu erstellen, der für die Verwendung von Loganalysen aktualisiert wurde:gcloud logging links create LINK_ID --bucket=BUCKET_ID --location=LOCATION

Der von Ihnen angegebene LINK_ID wird als Name des BigQuery-Datasets verwendet. Der Wert dieses Felds muss für Ihr Google Cloud -Projekt eindeutig sein.

Der Befehl

links createist asynchron. Der Rückgabewert einer asynchronen Methode ist einOperation-Objekt, das Informationen zum Fortschritt der Methode enthält. Wenn die Methode abgeschlossen ist, enthält dasOperation-Objekt den Status. Weitere Informationen finden Sie unter Asynchrone API-Methoden.Die Ausführung des Befehls

links createkann mehrere Minuten dauern.Mit dem folgenden Befehl wird beispielsweise ein verknüpftes Dataset mit dem Namen

mylinkfür den Log-Bucket mit dem Namenmy-bucketerstellt:gcloud logging links create mylink --bucket=my-bucket --location=global

Der Dataset-Name muss für jedes Google Cloud Projekt eindeutig sein. Wenn Sie versuchen, ein Dataset mit demselben Namen wie ein vorhandenes Dataset zu erstellen, wird der folgende Fehler angezeigt:

BigQuery dataset with name "LINK_ID" already exists.Wenn Sie versuchen, ein verknüpftes Dataset für einen Log-Bucket zu erstellen, für den kein Upgrade auf Loganalysen durchgeführt wurde, wird der folgende Fehler gemeldet:

A link can only be created for an analytics-enabled bucket.REST

Wenn Sie ein verknüpftes BigQuery-Dataset für einen vorhandenen Log-Bucket erstellen möchten, für den ein Upgrade auf Loganalysen durchgeführt wurde, rufen Sie die asynchrone Methode

projects.locations.buckets.links.createder Cloud Logging API auf.Bereiten Sie die Argumente für die Methode so vor:

- Erstellen Sie den Anfragetext für den Befehl

create. Der Anfragetext ist alsLink-Objekt formatiert. - Verwenden Sie für den Abfrageparameter des Befehls

linkId=LINK_ID. Der von Ihnen angegebene LINK_ID wird als Name des BigQuery-Datasets verwendet. Der Wert dieses Felds muss für Ihr Google Cloud -Projekt eindeutig sein.

Die Antwort auf die asynchronen Methoden ist ein

Operation-Objekt. Dieses Objekt enthält Informationen zum Fortschritt der Methode. Wenn die Methode abgeschlossen ist, enthält dasOperation-Objekt den Status. Weitere Informationen finden Sie unter Asynchrone API-Methoden.Die Methode

links.createkann mehrere Minuten dauern.Der Dataset-Name muss für jedes Google Cloud Projekt eindeutig sein. Wenn Sie versuchen, ein Dataset mit demselben Namen wie ein vorhandenes Dataset zu erstellen, wird der folgende Fehler angezeigt:

BigQuery dataset with name "LINK_ID" already exists.Wenn Sie versuchen, ein verknüpftes Dataset für einen Log-Bucket zu erstellen, für den kein Upgrade auf Loganalysen durchgeführt wurde, wird der folgende Fehler gemeldet:

A link can only be created for an analytics-enabled bucket.Bucket sperren

Wenn Sie einen Bucket vor Aktualisierungen sperren, wird auch die Aufbewahrungsrichtlinie des Buckets gesperrt. Nachdem eine Aufbewahrungsrichtlinie gesperrt wurde, können Sie den Bucket erst löschen, wenn die Aufbewahrungsdauer für jeden Logeintrag im Bucket abgelaufen ist. Wenn Sie verhindern möchten, dass ein Projekt, das einen gesperrten Log-Bucket enthält, versehentlich gelöscht wird, fügen Sie dem Projekt eine Sperre hinzu. Weitere Informationen finden Sie unter Projekte mit Sperren schützen.

Wenn Sie verhindern möchten, dass ein Log-Bucket aktualisiert oder gelöscht wird, sperren Sie den Bucket. So sperren Sie den Bucket:

Google Cloud Console

Die Google Cloud Console unterstützt das Sperren eines Log-Buckets nicht.

gcloud

Führen Sie zum Sperren des Buckets den Befehl

gcloud logging buckets updatemit dem Flag--lockedaus:gcloud logging buckets update BUCKET_ID --location=LOCATION --locked

Beispiel:

gcloud logging buckets update my-bucket --location=global --locked

REST

Verwenden Sie

projects.locations.buckets.patchin der Logging API, um die Attribute Ihres Buckets zu sperren. Setzen Sie den Parameterlockedauftrue.Buckets auflisten

So listen Sie die mit einem Google Cloud -Projekt verknüpften Log-Buckets auf und rufen Details z. B. zu Aufbewahrungseinstellungen auf:

Google Cloud Console

Rufen Sie in der Google Cloud Console die Seite Logspeicher auf:

Wenn Sie diese Seite über die Suchleiste suchen, wählen Sie das Ergebnis aus, dessen Zwischenüberschrift Logging ist.

In der Tabelle Log-Buckets werden die Buckets aufgeführt, die dem aktuellenGoogle Cloud -Projekt zugeordnet sind.

In der Tabelle sind die folgenden Attribute für jeden Log-Bucket aufgeführt:

- Name: Der Name des Log-Buckets.

- Beschreibung: Die Beschreibung des Buckets.

- Aufbewahrungsdauer: Wie viel Tage lang die Daten des Buckets von Cloud Logging gespeichert werden.

- Region: Der geografische Ort, an dem die Daten des Buckets gespeichert sind.

- Status: Gibt an, ob der Bucket gesperrt oder nicht gesperrt ist.

Wenn ein Bucket zum Löschen durch Cloud Logging ansteht, wird sein Tabelleneintrag mit dem warning-Symbol für Warnung versehen.

gcloud

Führen Sie den Befehl

gcloud logging buckets listaus:gcloud logging buckets list

Für die Log-Buckets werden die folgenden Attribute angezeigt:

LOCATIONist die Region, in der die Daten des Buckets gespeichert werden.BUCKET_ID: Der Name des Log-Buckets.RETENTION_DAYS: Wie viel Tage lang die Daten des Buckets von Cloud Logging gespeichert werden.LIFECYCLE_STATE: Gibt an, ob der Bucket von Cloud Logging gelöscht werden soll.LOCKED: Gibt an, ob der Bucket gesperrt oder nicht gesperrt ist.CREATE_TIME: Ein Zeitstempel, der angibt, wann der Bucket erstellt wurde.UPDATE_TIME: Ein Zeitstempel, der angibt, wann der Bucket zuletzt geändert wurde.

Sie können auch die Attribute für nur einen Bucket aufrufen. Um beispielsweise die Details für den Log-Bucket

_Defaultin der Regionglobalaufzurufen, führen Sie den Befehlgcloud logging buckets describeaus:gcloud logging buckets describe _Default --location=global

REST

Verwenden Sie

projects.locations.buckets.listin der Logging API, um die mit einem Google Cloud -Projekt verknüpften Log-Buckets aufzulisten.Details eines Buckets anzeigen lassen

So rufen Sie die Details eines einzelnen Log-Buckets auf:

Google Cloud Console

Rufen Sie in der Google Cloud Console die Seite Logspeicher auf:

Wenn Sie diese Seite über die Suchleiste suchen, wählen Sie das Ergebnis aus, dessen Zwischenüberschrift Logging ist.

Klicken Sie für den Log-Bucket auf more_vert Mehr und wählen Sie dann Bucket-Details ansehen aus.

Im Dialogfeld sind die folgenden Attribute für den Log-Bucket aufgeführt:

- Name: Der Name des Log-Buckets.

- Beschreibung: Die Beschreibung des Log-Buckets.

- Aufbewahrungsdauer: Wie viel Tage lang die Daten des Buckets von Cloud Logging gespeichert werden.

- Region: Der geografische Ort, an dem die Daten des Buckets gespeichert sind.

- Loganalysen: Gibt an, ob für Ihren Bucket ein Upgrade für die Verwendung von Loganalysen durchgeführt wurde.

- BigQuery-Analyse: Gibt an, ob ein BigQuery-Dataset mit Ihrem Bucket verknüpft ist.

- BigQuery-Dataset: Enthält einen Link zu Ihrem BigQuery-Dataset, das auf der Seite BigQuery Studio geöffnet wird. Das Datum, an dem die BigQuery-Verknüpfung aktiviert wurde, wird ebenfalls angezeigt.

gcloud

Führen Sie den Befehl

gcloud logging buckets describeaus.Mit dem folgenden Befehl werden beispielsweise die Details des Buckets

_Defaultausgegeben:gcloud logging buckets describe _Default --location=global

Für den Log-Bucket werden die folgenden Attribute angezeigt:

createTime: Ein Zeitstempel, der angibt, wann der Bucket erstellt wurde.description: Die Beschreibung des Log-Buckets.lifecycleState: Gibt an, ob der Bucket von Cloud Logging gelöscht werden soll.name: Der Name des Log-Buckets.retentionDays: Wie viel Tage lang die Daten des Buckets von Cloud Logging gespeichert werden.updateTime: Ein Zeitstempel, der angibt, wann der Bucket zuletzt geändert wurde.

REST

Wenn Sie die Details eines einzelnen Log-Buckets aufrufen möchten, verwenden Sie

projects.locations.buckets.getin der Logging API.Buckets löschen

Sie können Log-Buckets löschen, die eine der folgenden Bedingungen erfüllen:

- Der Log-Bucket ist entsperrt.

- Der Log-Bucket ist gesperrt und alle Logeinträge im Log-Bucket haben die Aufbewahrungsdauer des Buckets erfüllt.

Sie können einen Log-Bucket, der vor Aktualisierungen gesperrt ist, nicht löschen, wenn in diesem Log-Bucket Logeinträge gespeichert sind, die die Aufbewahrungsdauer des Buckets noch nicht erreicht haben.

Nachdem Sie den Löschbefehl ausgegeben haben, wechselt der Log-Bucket in den Status

DELETE_REQUESTEDund verbleibt 7 Tage lang in diesem Status. Während dieses Zeitraums werden die Logs weiterhin von Logging an den Log-Bucket weitergeleitet. Sie können das Routing von Logs an den Log-Bucket beenden, indem Sie die Logsenken löschen oder ändern, die Logeinträge an den Bucket weiterleiten.Sie können keinen neuen Log-Bucket mit demselben Namen wie ein Log-Bucket im Status

DELETE_REQUESTEDerstellen.So löschen Sie einen Log-Bucket:

Google Cloud Console

So löschen Sie einen Log-Bucket:

-

Rufen Sie in der Google Cloud Console die Seite Logspeicher auf:

Wenn Sie diese Seite über die Suchleiste suchen, wählen Sie das Ergebnis aus, dessen Zwischenüberschrift Logging ist.

Suchen Sie den Bucket, den Sie löschen möchten, und klicken Sie auf das more_vertDreipunkt-Menü.

Wenn in der Spalte Verknüpftes Dataset in BigQuery ein Link angezeigt wird, löschen Sie das verknüpfte BigQuery-Dataset:

Klicken Sie auf Bucket bearbeiten.

Entfernen Sie das Häkchen aus dem Kästchen Neues BigQuery-Dataset erstellen, das mit diesem Bucket verknüpft ist, klicken Sie auf Fertig und dann auf Bucket aktualisieren.

Klicken Sie nach der Rückkehr zur Seite Log-Speicher für den Bucket, den Sie löschen möchten, auf more_vertMehr und fahren Sie mit den nächsten Schritten fort.

Klicken Sie auf Bucket löschen.

Klicken Sie im Bestätigungsfeld auf Löschen.

Auf der Seite Logspeicher wird der Hinweis angezeigt, dass der Löschvorgang des Buckets aussteht. Der Bucket mit allen darin enthaltenen Logs wird dann nach sieben Tagen gelöscht.

gcloud

Führen Sie den Befehl

gcloud logging buckets deleteaus, um einen Log-Bucket zu löschen:gcloud logging buckets delete BUCKET_ID --location=LOCATION

Sie können einen Log-Bucket nicht löschen, wenn er mit einem BigQuery-Dataset verknüpft ist:

- Führen Sie den Befehl

gcloud logging links listaus, um die mit einem Log-Bucket verknüpften Links aufzulisten. - Führen Sie den Befehl

gcloud logging links deleteaus, um ein verknüpftes Dataset zu löschen.

REST

Verwenden Sie

projects.locations.buckets.deletein der Logging API, um einen Bucket zu löschen.Es ist ein Fehler, einen Log-Bucket zu löschen, wenn er mit einem BigQuery-Dataset verknüpft ist. Sie müssen das verknüpfte Dataset löschen, bevor Sie den Log-Bucket löschen können:

- Mit der Methode

projects.locations.buckets.links.listkönnen Sie die mit einem Log-Bucket verknüpften Links auflisten. - Führen Sie die Methode

projects.locations.buckets.links.deleteaus, um ein verknüpftes Dataset zu löschen.

Gelöschten Bucket wiederherstellen

Sie können einen Log-Bucket mit dem Status "Ausstehend" wiederherstellen oder den Löschvorgang aufheben. So stellen Sie einen Log-Bucket wieder her:

Google Cloud Console

So stellen Sie einen Log-Bucket wieder her, dessen Löschvorgang aussteht:

-

Rufen Sie in der Google Cloud Console die Seite Logspeicher auf:

Wenn Sie diese Seite über die Suchleiste suchen, wählen Sie das Ergebnis aus, dessen Zwischenüberschrift Logging ist.

Klicken Sie für den Bucket, den Sie wiederherstellen möchten, auf more_vert Mehr und wählen Sie dann Gelöschten Bucket wiederherstellen aus.

Klicken Sie im Bestätigungsfeld auf Wiederherstellen.

Auf der Seite Logspeicher wird dann die Anzeige für den ausstehenden Löschvorgang aus dem Log-Bucket entfernt.

gcloud

Wenn Sie einen Log-Bucket wiederherstellen möchten, dessen Löschvorgang aussteht, führen Sie den Befehl

gcloud logging buckets undeleteaus:gcloud logging buckets undelete BUCKET_ID --location=LOCATION

REST

Verwenden Sie

projects.locations.buckets.undeletein der Logging API, um einen Bucket wiederherzustellen, dessen Löschvorgang aussteht.Benachrichtigungen über monatliche Logbyte, die in Log-Buckets gespeichert sind

Klicken Sie zum Erstellen einer Benachrichtigungsrichtlinie auf der Seite Logs Storage (Logs-Speicher) in derGoogle Cloud Console auf add_alert Create usage alert (Nutzungsbenachrichtigung erstellen). Über diese Schaltfläche wird die Seite Benachrichtigungsrichtlinie erstellen in Monitoring geöffnet und das Feld „Messwerttyp“ wird mit

logging.googleapis.com/billing/bytes_ingestedausgefüllt.Verwenden Sie die folgenden Einstellungen, um eine Benachrichtigungsrichtlinie zu erstellen, sodass Sie benachrichtigt werden, wenn die Anzahl der in Ihre Log-Buckets geschriebenen Log-Byte Ihr benutzerdefiniertes Limit für Cloud Logging überschreitet.

Neue Bedingung

Feld

WertRessource und Messwert Wählen Sie im Menü Ressourcen die Option Global aus.

Wählen Sie im Menü Messwertkategorien die Option Logbasierter Messwert aus.

Wählen Sie im Menü Messwerte die Option Monatlich aufgenommene Logbytes aus.Filter Keine. Über Zeitreihen hinweg

Zeitreihenaggregationsum

Rollierendes Zeitfenster 60 m

Funktion für rollierendes Zeitfenster maxBenachrichtigungstrigger konfigurieren

Feld

WertBedingungstyp ThresholdBenachrichtigungstrigger Any time series violatesGrenzwertposition Above thresholdGrenzwert Sie legen den akzeptablen Wert fest. Zeitfenster noch einmal testen Der kleinste akzeptable Wert liegt bei 30 Minuten. Weitere Informationen zu Benachrichtigungsrichtlinien finden Sie unter Benachrichtigungen – Übersicht.

In einen Bucket schreiben

Sie schreiben Logs nicht direkt in einen Log-Bucket. Stattdessen schreiben Sie Logs in dieGoogle Cloud -Ressource: ein Google Cloud -Projekt, einen Ordner oder eine Organisation. Die Senken in der übergeordneten Ressource leiten dann die Logs an Ziele weiter, einschließlich Log-Buckets. Eine Senke leitet Logs an ein Log-Bucket-Ziel weiter, wenn die Logs mit dem Filter der Senke übereinstimmen und die Senke berechtigt ist, die Logs an den Log-Bucket weiterzuleiten.

Aus einem Bucket lesen

Jeder Log-Bucket verfügt über eine Reihe von Logansichten. Zum Lesen von Logs aus einem Log-Bucket benötigen Sie Zugriff auf eine Logansicht des Log-Buckets. Mit Logansichten können Sie einem Nutzer Zugriff auf nur eine Teilmenge der in einem Log-Bucket gespeicherten Logs gewähren. Informationen zum Konfigurieren von Logansichten und zum Gewähren des Zugriffs auf bestimmte Logansichten finden Sie unter Logansichten für einen Log-Bucket konfigurieren.

So lesen Sie Logs aus einem Log-Bucket:

Google Cloud Console

-

Rufen Sie in der Google Cloud Console die Seite Log-Explorer auf:

Wenn Sie diese Seite über die Suchleiste suchen, wählen Sie das Ergebnis aus, dessen Zwischenüberschrift Logging ist.

Wenn Sie anpassen möchten, welche Logs im Log-Explorer angezeigt werden, klicken Sie auf Bereich verfeinern und wählen Sie eine Option aus. Sie können sich beispielsweise Logs ansehen, die in einem Projekt oder in einer Logansicht gespeichert sind.

Klicken Sie auf Übernehmen. Der Bereich Abfrageergebnisse wird mit Logs neu geladen, die der ausgewählten Option entsprechen.

Weitere Informationen finden Sie unter Log-Explorer – Übersicht: Bereich eingrenzen.

gcloud

Verwenden Sie den Befehl

gcloud logging readund fügen Sie einLOG_FILTERhinzu, um Daten aus einem Log-Bucket zu lesen:gcloud logging read LOG_FILTER --bucket=BUCKET_ID --location=LOCATION --view=LOG_VIEW_ID

REST

Verwenden Sie die Methode entries.list, um Logs aus einem Log-Bucket zu lesen. Legen Sie

resourceNamesfest, um den entsprechenden Bucket und die entsprechende Logansicht anzugeben, und legen Siefilterfest, um Daten auszuwählen.Ausführliche Informationen zur Filtersyntax finden Sie unter Logging-Abfragesprache.

Benutzerdefinierte Aufbewahrung konfigurieren

Wenn Sie einen Log-Bucket erstellen, können Sie den Zeitraum anpassen, für den Cloud Logging die Logs des Buckets speichert. Sie können die Aufbewahrungsdauer für jeden benutzerdefinierten Log-Bucket und auch für den Log-Bucket

_Defaultkonfigurieren. Sie können die Aufbewahrungsdauer des Log-Buckets_Requirednicht ändern.Wenn Sie die Aufbewahrungsdauer eines Buckets verkürzen, gibt es eine 7-tägige Kulanzfrist, in der abgelaufene Logs nicht gelöscht werden. Sie können diese abgelaufenen Logs nicht abfragen oder ansehen. Innerhalb dieser 7 Tage können Sie jedoch den vollständigen Zugriff wiederherstellen, indem Sie die Aufbewahrungsdauer des Buckets verlängern. Logs, die während des Kulanzzeitraums gespeichert werden, werden auf Ihre Aufbewahrungskosten angerechnet.

Die Durchsetzung der Aufbewahrungsrichtlinien ist ein letztendlich konsistenter Prozess. Wenn Sie Logeinträge in einen Log-Bucket schreiben, die älter als die Aufbewahrungsdauer des Buckets sind, können Sie diese Logeinträge möglicherweise kurz sehen. Wenn Sie beispielsweise 10 Tage alte Logeinträge an einen Log-Bucket mit einer Aufbewahrungsdauer von 7 Tagen senden, werden diese Logeinträge gespeichert und dann schließlich gelöscht. Diese Logeinträge tragen nicht zu Ihren Aufbewahrungskosten bei. Sie tragen jedoch zu Ihren Speicherkosten bei. Um die Speicherkosten zu minimieren, sollten Sie keine Logeinträge schreiben, die älter als die Aufbewahrungsdauer Ihres Buckets sind.

So aktualisieren Sie die Aufbewahrungsdauer für einen benutzerdefinierten Log-Bucket oder für den Log-Bucket

_Default:Google Cloud Console

So aktualisieren Sie die Aufbewahrungsdauer eines Log-Buckets:

-

Rufen Sie in der Google Cloud Console die Seite Logspeicher auf:

Wenn Sie diese Seite über die Suchleiste suchen, wählen Sie das Ergebnis aus, dessen Zwischenüberschrift Logging ist.

Klicken Sie für den Bucket, den Sie aktualisieren möchten, auf more_vert Mehr und wählen Sie dann Bucket bearbeiten aus.

Geben Sie im Feld Aufbewahrung die Anzahl der Tage zwischen 1 und 3650 Tagen ein, in denen Cloud Logging die Logs speichern soll.

Klicken Sie auf Bucket aktualisieren. Die neue Aufbewahrungsdauer wird in der Liste Log-Bucket angezeigt.

gcloud

Führen Sie zum Aktualisieren der Aufbewahrungsdauer für einen Log-Bucket den Befehl

gcloud logging buckets updateaus, nachdem Sie einen Wert für RETENTION_DAYS festgelegt haben:gcloud logging buckets update BUCKET_ID --location=LOCATION --retention-days=RETENTION_DAYS

Wenn Sie beispielsweise die Logs im

_Default-Bucket am Standortglobalfür ein Jahr aufbewahren möchten, würde Ihr Befehl so aussehen:gcloud logging buckets update _Default --location=global --retention-days=365

Wenn Sie die Aufbewahrungsdauer eines Buckets verlängern, gelten die Aufbewahrungsregeln in Zukunft und nicht rückwirkend. Logs können nach Ablauf der Aufbewahrungsdauer nicht wiederhergestellt werden.

Asynchrone API-Methoden

Die Antwort einer asynchronen Methode wie

projects.locations.buckets.createAsyncist einOperation-Objekt.Anwendungen, die eine asynchrone API-Methode aufrufen, sollten den Endpunkt

operation.getabfragen, bis das FeldOperation.doneden Werttruehat:Wenn

doneden Wertfalsehat, wird der Vorgang noch ausgeführt.Senden Sie zum Aktualisieren der Statusinformationen eine

GET-Anfrage an den Endpunktoperation.get.Wenn

doneden Werttruehat, ist der Vorgang abgeschlossen und entweder das Felderroroderresponseist festgelegt:error: Wenn dies festgelegt ist, ist der asynchrone Vorgang fehlgeschlagen. Der Wert dieses Felds ist einStatus-Objekt, das einen gRPC-Fehlercode und eine Fehlermeldung enthält.response: Wenn dies festgelegt ist, wurde der asynchrone Vorgang erfolgreich abgeschlossen und der Wert spiegelt das Ergebnis wider.

Führen Sie den folgenden Befehl aus, um einen asynchronen Befehl mit der Google Cloud CLI abzufragen:

gcloud logging operations describe OPERATION_ID --location=LOCATION --project=PROJECT_ID

Weitere Informationen finden Sie unter

gcloud logging operations describe.Häufige Probleme beheben

Wenn bei der Verwendung von Log-Buckets Probleme auftreten, lesen Sie folgende Schritte zur Fehlerbehebung und Antworten auf häufig gestellte Fragen.

Warum kann ich diesen Bucket nicht löschen?

Wenn Sie versuchen, einen Bucket zu löschen, gehen Sie so vor:

Prüfen Sie, ob Sie die erforderlichen Berechtigungen zum Löschen des Buckets haben. Eine Liste der benötigten Berechtigungen finden Sie unter Zugriffssteuerung mit IAM.

Bestimmen Sie, ob der Bucket gesperrt ist. Listen Sie dazu die Attribute des Buckets auf. Wenn der Bucket gesperrt ist, prüfen Sie die Aufbewahrungsdauer. Sie können gesperrte Buckets erst löschen, wenn alle Logs im Bucket die Aufbewahrungsdauer des Buckets erreicht haben.

Prüfen Sie, ob dem Log-Bucket ein BigQuery-Dataset zugewiesen ist. Sie können keinen Log-Bucket mit einem verknüpften Dataset löschen.

Der folgende Fehler wird als Reaktion auf einen

delete-Befehl für einen Log-Bucket mit einem verknüpften Dataset angezeigt:FAILED_PRECONDITION: This bucket is used for advanced analytics and has an active link. The link must be deleted first before deleting the bucket

Wenn Sie die mit einem Log-Bucket verknüpften Links auflisten möchten, führen Sie den Befehl

gcloud logging links listoder die API-Methodeprojects.locations.buckets.links.listaus.

Welche Dienstkonten leiten Logs an meinen Bucket weiter?

So ermitteln Sie, ob Dienstkonten IAM-Berechtigungen zum Weiterleiten von Logs an Ihren Bucket haben:

-

Rufen Sie in der Google Cloud -Console die Seite IAM auf:

Rufen Sie IAM auf.

Wenn Sie diese Seite über die Suchleiste suchen, wählen Sie das Ergebnis aus, dessen Zwischenüberschrift IAM & Admin lautet.

Wählen Sie aus dem Tab Berechtigungen die Ansicht nach Rollen. Sie sehen eine Tabelle mit allen IAM-Rollen und -Hauptkonten, die IhremGoogle Cloud -Projekt zugeordnet sind.

Geben Sie in das Textfeld Filter filter_list der Tabelle Log-Bucket-Autor ein.

Sie sehen alle Hauptkonten mit der Rolle Log-Bucket-Autor. Wenn ein Hauptkonto ein Dienstkonto ist, enthält dessen ID den String

gserviceaccount.com.Optional: Wenn Sie ein Dienstkonto daran hindern möchten, Logs an Ihr Google Cloud -Projekt weiterzuleiten, aktivieren Sie das Kästchen check_box_outline_blank für das Dienstkonto und klicken Sie auf Entfernen.

Warum sehe ich Logs für ein Google Cloud -Projekt, obwohl ich sie von meiner

_Default-Senke ausgeschlossen habe?Möglicherweise sehen Sie Logs in einem Log-Bucket in einem zentralisierten Google Cloud Projekt, in dem Logs aus Ihrer Organisation zusammengefasst werden.

Wenn Sie mit dem Log-Explorer auf diese Logs zugreifen und Logs sehen, die Sie von der

_Default-Senke ausgeschlossen haben, ist Ihre Ansicht möglicherweise auf dieGoogle Cloud -Projektebene festgelegt.Um dieses Problem zu beheben, wählen Sie im Menü Bereich eingrenzen die Option Logansicht aus und wählen Sie dann die Logansicht aus, die dem

_Default-Bucket in IhremGoogle Cloud -Projekt zugeordnet ist. Die ausgeschlossenen Logs sollten nun nicht mehr angezeigt werden.Nächste Schritte

Informationen zu den Methoden der Logs Bucket API finden Sie in der

LogBucket-Referenzdokumentation.Wenn Sie eine Organisation oder einen Ordner verwalten, können Sie den Speicherort der

_Default- und_Required-Log-Buckets untergeordneter Ressourcen angeben. Sie können auch konfigurieren, ob Log-Buckets CMEK verwenden, und das Verhalten des_Default-Log-Senken. Weitere Informationen finden Sie unter Standardeinstellungen für Organisationen und Ordner konfigurieren.Informationen zur Bewältigung gängiger Anwendungsfälle mit Log-Buckets finden Sie in den folgenden Themen:

Sofern nicht anders angegeben, sind die Inhalte dieser Seite unter der Creative Commons Attribution 4.0 License und Codebeispiele unter der Apache 2.0 License lizenziert. Weitere Informationen finden Sie in den Websiterichtlinien von Google Developers. Java ist eine eingetragene Marke von Oracle und/oder seinen Partnern.

Zuletzt aktualisiert: 2025-10-22 (UTC).

- Wenn Sie die Google Cloud CLI oder die Cloud Logging API zum Erstellen oder Verwalten Ihrer Log-Buckets verwenden möchten, müssen Sie die Formatierungsanforderungen für