Auf dieser Seite wird beschrieben, wie Entitäten in Firestore im Datastore-Modus mithilfe des verwalteten Export- und Importdienstes exportiert und importiert werden. Der verwaltete Export- und Importdienst ist über die Google Cloud Console, die Google Cloud CLI und die Datastore Admin API (REST, RPC) verfügbar.

Mit dem verwalteten Export- und Importdienst können Sie versehentlich gelöschte Daten wiederherstellen und Daten für die Offlineverarbeitung exportieren. Sie können alle Entitäten oder nur bestimmte Arten von Entitäten exportieren. Ebenso können Sie alle Daten eines Exports oder nur bestimmte Arten importieren. Berücksichtigen Sie bei der Verwendung des verwalteten Export- und Importdiensts Folgendes:

Der Exportdienst verwendet Eventual Consistency-Lesevorgänge. Sie können nicht davon ausgehen, dass ein Export zu einem bestimmten Zeitpunkt stattfindet. Der Export kann Entitäten einbeziehen, die nach dem Beginn des Exports geschrieben wurden, und Entitäten ausschließen, die vor dem Beginn des Exports geschrieben wurden.

Ein Export enthält keine Indexe. Beim Importieren werden die erforderlichen Indexe automatisch entsprechend den aktuellen Indexdefinitionen Ihrer Datenbank neu erstellt. Entitätsspezifische Attributwert-Indexeinstellungen werden exportiert und während des Imports berücksichtigt.

Beim Importieren werden Entitäten keine neuen IDs zugewiesen. Importe verwenden die zum Zeitpunkt des Exports vorhandenen IDs und überschreiben alle vorhandenen Entitäten mit derselben ID. Während eines Imports werden die IDs für den Zeitraum reserviert, in dem die Entitäten importiert werden. Durch diese Funktion werden ID-Kollisionen mit neuen Entitäten verhindert, wenn Schreibvorgänge während der Ausführung eines Imports aktiviert sind.

Wenn eine Entität in Ihrer Datenbank nicht von einem Import betroffen ist, verbleibt sie nach dem Import in der Datenbank.

Aus einer Datenbank im Datastore-Modus exportierte Daten können in eine andere Datenbank im Datastore-Modus importiert werden, auch wenn sich diese in einem anderen Projekt befindet.

Im verwalteten Export- und Importdienst ist die Anzahl gleichzeitiger Exporte und Importe auf 50 begrenzt. Je Projekt sind bis zu 20 Export- und Importanfragen pro Minute möglich. Für jede Anfrage begrenzt der Dienst die Anzahl der Kombinationen von Entitätsfiltern auf 100.

Die Ausgabe eines verwalteten Exports verwendet das LevelDB-Logformat.

Sie müssen beim Exportieren einen Entitätsfilter angeben, um nur einen Teil der Entitäten zu importieren oder Daten in BigQuery zu importieren.

Der Dateiname

.overall_export_metadatamuss mit dem Namen des übergeordneten Ordners übereinstimmen:gs://BUCKET_NAME/OPTIONAL_NAMESPACE_PATH/PARENT_FOLDER_NAME/PARENT_FOLDER_NAME.overall_export_metadataWenn Sie die Ausgabedateien eines Exports verschieben oder kopieren, behalten Sie die

PARENT_FOLDER_NAME, den Inhalt der Unterordner und den Dateinamen.overall_export_metadatabei.

Hinweise

Bevor Sie den verwalteten Export- und Importdienst verwenden können:

Aktivieren Sie die Abrechnung für Ihr Google Cloud Projekt. Die Export- und Importfunktionen können nur für Google Cloud -Projekte mit aktivierter Abrechnung verwendet werden.

Erstellen Sie einen Cloud Storage-Bucket am selben Speicherort, an dem sich Ihre Firestore-Datenbank im Datastore-Modus befindet. Einen Bucket mit der Funktion "Anfragesteller bezahlt" können Sie nicht für Export- und Importvorgänge verwenden.

Wenn Sie Daten exportieren, weisen Sie Ihrem Nutzerkonto eine IAM-Rolle zu, die die Berechtigung

datastore.databases.exportgewährt. Wenn Sie Daten importieren, weisen Sie eine Rolle mit der Berechtigungdatastore.databases.importzu. Die RolleDatastore Import Export Adminbeispielsweise gewährt beide Berechtigungen.Wenn sich der Cloud Storage-Bucket in einem anderen Projekt befindet, gewähren Sie dem Firestore-Dienst-Agent Zugriff auf den Bucket.

gcloud für das Projekt einrichten

Wenn Sie Ihre Import- und Exportvorgänge mit gcloud starten möchten, richten Sie gcloud ein und stellen Sie auf eine der folgenden Arten eine Verbindung zu Ihrem Projekt her:

Rufen Sie

gcloudüber die Google Cloud -Konsole mit Cloud Shell auf.Konfigurieren Sie das gcloud CLI für die Verwendung Ihres aktuellen Projekts:

gcloud config set project project-id

Berechtigungen

Zum Ausführen von Export- und Importvorgängen benötigen Ihr Nutzerkonto und der Dienst-Agent für den Datastore-Modus Ihres Projekts die folgenden Identity and Access Management-Berechtigungen.

Nutzerkontoberechtigungen

Zum Starten des Vorgangs müssen das Nutzerkonto oder Dienstkonto die IAM-Berechtigungen datastore.databases.export und datastore.databases.import haben. Wenn Sie der Projektinhaber sind, hat Ihr Konto bereits die erforderlichen Berechtigungen. Andernfalls gewähren die folgenden IAM-Rollen die erforderlichen Berechtigungen:

- Datastore-Inhaber

- Import-Export-Administrator für Datastore

Sie können diese Berechtigungen auch mit einer benutzerdefinierten Rolle zuweisen.

Ein Projektinhaber kann eine dieser Rollen durch Ausführen der Schritte unter Zugriffsrechte erteilen zuweisen.

Berechtigungen des Dienst-Agents

Export- und Importvorgänge verwenden einen Firestore-Dienst-Agent, um Cloud Storage-Vorgänge zu autorisieren. Der Firestore-Dienst-Agent verwendet die folgende Namenskonvention:

- Firestore-Dienst-Agent

service-PROJECT_NUMBER@gcp-sa-firestore.iam.gserviceaccount.com

Weitere Informationen zu Dienst-Agents finden Sie unter Dienst-Agents.

Der Firestore-Dienst-Agent benötigt Zugriff auf den Cloud Storage-Bucket, der in einem Export- oder Importvorgang verwendet wird. Wenn sich Ihr Cloud Storage-Bucket im selben Projekt wie Ihre Firestore-Datenbank befindet, kann der Firestore-Dienst-Agent standardmäßig auf den Bucket zugreifen.

Wenn sich der Cloud Storage-Bucket in einem anderen Projekt befindet, müssen Sie dem Firestore-Dienst-Agent Zugriff auf den Cloud Storage-Bucket gewähren.

Dienst-Agent Rollen zuweisen

Sie können das gsutil-Befehlszeilentool verwenden, um eine der folgenden Rollen zuzuweisen. Führen Sie beispielsweise den folgenden Befehl aus, um dem Firestore-Dienst-Agent die Rolle des Storage-Administrators zuzuweisen:

gsutil iam ch serviceAccount:service-PROJECT_NUMBER@gcp-sa-firestore.iam.gserviceaccount.com:roles/storage.admin \ gs://[BUCKET_NAME]

Ersetzen Sie PROJECT_NUMBER durch Ihre Projektnummer, die zum Benennen Ihres Firestore-Dienstkontos verwendet wird. Informationen zum Anzeigen des Dienst-Agent-Namens finden Sie unter Dienst-Agent-Namen ansehen.

Alternativ können Sie diese Rolle über die Google Cloud Console zuweisen.

Name des Dienst-Agents ansehen

Das Konto, mit dem Ihre Import- und Exportvorgänge Anfragen auf der Seite Import/Export in der Google Cloud Konsole autorisieren, können Sie dort einsehen. Sie können auch sehen, ob für Ihre Datenbank der Firestore-Service-Agent oder das alte App Engine-Dienstkonto verwendet wird.

-

Rufen Sie in der Google Cloud Console die Seite Datenbanken auf.

-

Wählen Sie die benötigte Datenbank aus der Liste der Datenbanken aus.

-

Klicken Sie im Navigationsmenü auf Import/Export.

- Das Autorisierungskonto wird neben dem Label Import-/Exportjobs werden ausgeführt als angezeigt.

Exportvorgänge

Ändern Sie bei Exportvorgängen mit einem Bucket in einem anderen Projekt die Berechtigungen des Buckets: Weisen Sie dem Datastore-Modus-Dienstkonto des Projekts, das Ihre Datenbank im Datastore-Modus enthält, eine der folgenden Identity and Access Management-Rollen zu:

- Storage-Administrator

- Inhaber (einfache Rolle)

Sie können auch eine benutzerdefinierte IAM-Rolle mit etwas anderen Berechtigungen als in den oben aufgeführten Rollen erstellen:

storage.buckets.getstorage.objects.createstorage.objects.deletestorage.objects.list

Importvorgänge

Ändern Sie bei Importvorgängen mit einem Cloud Storage-Bucket in einem anderen Projekt die Berechtigungen des Buckets, um dem Datastore-Modus-Dienst-Agent des Projekts, das Ihre Datenbank im Datastore-Modus enthält, eine der folgenden Cloud Storage-Rollen zuzuweisen:

- Storage-Administrator

- Sowohl Storage-Objekt-Betrachter als auch Leser alter Storage-Buckets

Mit den folgenden Berechtigungen können Sie auch eine benutzerdefinierte IAM-Rolle erstellen:

storage.buckets.getstorage.objects.get

Verwaltete Export- und Importvorgänge starten

In diesem Abschnitt wird beschrieben, wie ein verwalteter Export- oder Importvorgang gestartet wird.

Alle Entitäten exportieren

Konsole

Rufen Sie in der Google Cloud Console die Seite Datenbanken auf.

Wählen Sie die benötigte Datenbank aus der Liste der Datenbanken aus.

- Klicken Sie im Navigationsmenü auf Import/Export.

- Klicken Sie auf Exportieren.

- Setzen Sie das Feld Namespace auf

All Namespacesund das Feld Art aufAll Kinds. - Geben Sie unter Ziel den Namen Ihres Cloud Storage-Buckets ein.

- Klicken Sie auf Exportieren.

Die Console kehrt zur Seite Import/Export zurück. In einer Benachrichtigung wird der Erfolg oder Misserfolg Ihrer verwalteten Exportanfrage gemeldet.

gcloud

Verwenden Sie den Befehl gcloud firestore export, um alle Entitäten in Ihrer Datenbank zu exportieren.

gcloud firestore export gs://bucket-name --async --database=DATABASE

Dabei ist bucket-name der Name Ihres Cloud Storage-Buckets und ein optionales Präfix, z. B. bucket-name/datastore-exports/export-name. Sie können dasselbe Präfix nicht für einen anderen Exportvorgang verwenden. Wenn Sie kein Dateipräfix angeben, erstellt der verwaltete Exportdienst ein Präfix anhand der aktuellen Uhrzeit.

Verwenden Sie das Flag [--async][async-flag], damit gcloud nicht wartet, bis der Vorgang abgeschlossen ist. Wenn Sie das Flag --async weglassen, können Sie Ctrl+c eingeben, um das Warten auf einen Vorgang zu beenden. Dies bricht den Vorgang aber nicht ab.

Legen Sie das Flag --database auf den Namen der Datenbank fest, aus der Sie die Einheiten exportieren möchten. Verwenden Sie --database='(default)' für die Standarddatenbank.

REST

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- project-id: Ihre Projekt-ID

- bucket-name: Name Ihres Cloud Storage-Buckets

HTTP-Methode und URL:

POST https://datastore.googleapis.com/v1/projects/project-id:export

JSON-Text anfordern:

{

"outputUrlPrefix": "gs://bucket-name",

}

Wenn Sie die Anfrage senden möchten, maximieren Sie eine der folgenden Optionen:

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

{

"name": "projects/project-id/operations/operation-id",

"metadata": {

"@type": "type.googleapis.com/google.datastore.admin.v1.ExportEntitiesMetadata",

"common": {

"startTime": "2019-09-18T18:42:26.591949Z",

"operationType": "EXPORT_ENTITIES",

"state": "PROCESSING"

},

"entityFilter": {},

"outputUrlPrefix": "gs://bucket-name/2019-09-18T18:42:26_85726"

}

}

Bestimmte Arten oder Namespaces exportieren

Um eine bestimmte Teilmenge von Arten und/oder Namespaces zu exportieren, setzen Sie einen Entitätsfilter mit Werten für Arten und Namespace-IDs. Jede Anfrage ist auf 100 Kombinationen von Entitätsfiltern beschränkt, wobei jede Kombination aus gefiltertem Art und Namespace als separater Filter auf dieses Limit angerechnet wird.

Console

In der Console können Sie entweder alle Arten oder eine bestimmte Art auswählen. Ebenso können Sie alle Namespaces oder einen bestimmten Namespace auswählen.

Um eine Liste der zu exportierenden Namespaces und Arten anzugeben, verwenden Sie gcloud.

Rufen Sie in der Google Cloud Console die Seite Datenbanken auf.

Wählen Sie die benötigte Datenbank aus der Liste der Datenbanken aus.

Klicken Sie im Navigationsmenü auf Import/Export.

Klicken Sie auf Exportieren.

Stellen Sie das Feld Namespace auf

All Namespacesoder auf den Namen eines Ihrer Namespaces ein.Stellen Sie das Feld Art auf

All Kindsoder auf den Namen einer Art ein.Geben Sie unter Ziel den Namen Ihres Cloud Storage-Buckets ein.

Klicken Sie auf Exportieren.

Die Console kehrt zur Seite Import/Export zurück. In einer Benachrichtigung wird der Erfolg oder Misserfolg Ihrer verwalteten Exportanfrage gemeldet.

gcloud

gcloud firestore export --collection-ids="KIND1,KIND2" \ --namespaces="(default),NAMESPACE2" \ gs://bucket-name \ --async \ --database=DATABASE

Dabei ist bucket-name der Name Ihres Cloud Storage-Buckets und ein optionales Präfix, z. B. bucket-name/datastore-exports/export-name. Sie können dasselbe Präfix nicht für einen anderen Exportvorgang verwenden. Wenn Sie kein Dateipräfix angeben, erstellt der verwaltete Exportdienst ein Präfix anhand der aktuellen Uhrzeit.

Verwenden Sie das Flag [--async][async-flag], damit gcloud nicht wartet, bis der Vorgang abgeschlossen ist. Wenn Sie das Flag --async weglassen, können Sie Ctrl+c eingeben, um das Warten auf einen Vorgang zu beenden. Dies bricht den Vorgang aber nicht ab.

Setzen Sie das Flag --database auf den Namen der Datenbank, aus der Sie bestimmte Arten oder Namespaces exportieren möchten. Verwenden Sie --database='(default)' für die Standarddatenbank.

REST

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- project-id: Ihre Projekt-ID

- bucket-name: Name Ihres Cloud Storage-Buckets

- kind: Entitätstyp

- namespace: Namespace-ID (verwenden Sie "" für die Standard-Namespace-ID)

HTTP-Methode und URL:

POST https://datastore.googleapis.com/v1/projects/project-id:export

JSON-Text anfordern:

{

"outputUrlPrefix": "gs://bucket-name",

"entityFilter": {

"kinds": ["kind"],

"namespaceIds": ["namespace"],

},

}

Wenn Sie die Anfrage senden möchten, maximieren Sie eine der folgenden Optionen:

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

{

"name": "projects/project-id/operations/operation-id",

"metadata": {

"@type": "type.googleapis.com/google.datastore.admin.v1.ExportEntitiesMetadata",

"common": {

"startTime": "2019-09-18T21:17:36.232704Z",

"operationType": "EXPORT_ENTITIES",

"state": "PROCESSING"

},

"entityFilter": {

"kinds": [

"Task"

],

"namespaceIds": [

""

]

},

"outputUrlPrefix": "gs://bucket-name/2019-09-18T21:17:36_82974"

}

}

Metadatendateien

Beim Exportvorgang wird für jede angegebene Kombination von Namespace und Art eine Metadatendatei erstellt. Metadatendateien heißen in der Regel NAMESPACE_NAME_KIND_NAME.export_metadata. Wenn jedoch der Name eines Namespace oder einer Art einen ungültigen Cloud Storage-Objektnamen ergeben würde, erhält die Datei den Namen export[NUM].export_metadata.

Die Metadatendateien sind Protokollpuffer und können mit dem Protokollcompiler protoc decodiert werden.

Sie können beispielsweise eine Metadatendatei decodieren, um den Namespace und die Art der Exportdateien zu bestimmen:

protoc --decode_raw < export0.export_metadata

Alle Entitäten importieren

Konsole

Rufen Sie in der Google Cloud Console die Seite Datenbanken auf.

Wählen Sie die benötigte Datenbank aus der Liste der Datenbanken aus.

Klicken Sie im Navigationsmenü auf Import/Export.

Klicken Sie auf Importieren.

Klicken Sie im Feld

Fileauf Durchsuchen und wählen Sie eine.overall_export_metadata-Datei aus.Die Datei

.overall_export_metadatadarf nicht vom Standardspeicherort verschoben werden.Setzen Sie das Feld Namespace auf

All Namespacesund das Feld Art aufAll Kinds.Klicken Sie auf Importieren.

Die Console kehrt zur Seite Import/Export zurück. In einer Benachrichtigung wird der Erfolg oder Misserfolg Ihrer verwalteten Importanfrage gemeldet.

gcloud

Verwenden Sie den Befehl gcloud firestore import, um alle Entitäten zu importieren, die zuvor mit dem verwalteten Exportdienst exportiert wurden.

gcloud firestore import gs://bucket-name/file-path/file-name.overall_export_metadata \ --async \ --database=DATABASE

Dabei ist bucket-name/file-path/file-name der Pfad zur Datei overall_export_metadata in Ihrem Cloud Storage-Bucket.

Verwenden Sie das Flag [--async][async-flag], damit gcloud nicht wartet, bis der Vorgang abgeschlossen ist. Wenn Sie das Flag --async weglassen, können Sie Ctrl+c eingeben, um das Warten auf einen Vorgang zu beenden. Dies bricht den Vorgang aber nicht ab.

Legen Sie das Flag --database auf den Namen der Datenbank fest, in die Sie alle Entitäten importieren möchten. Verwenden Sie --database='(default)' für die Standarddatenbank.

REST

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- project-id: Ihre Projekt-ID

- bucket-name: Name Ihres Cloud Storage-Buckets

- object-name: Name Ihres Cloud Storage-Objekts (Beispiel:

2017-05-25T23:54:39_76544/2017-05-25T23:54:39_76544.overall_export_metadata)

HTTP-Methode und URL:

POST https://datastore.googleapis.com/v1/projects/project-id:import

JSON-Text anfordern:

{

"inputUrl": "gs://bucket-name/object-name",

}

Wenn Sie die Anfrage senden möchten, maximieren Sie eine der folgenden Optionen:

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

{

"name": "projects/project-id/operations/operation-id",

"metadata": {

"@type": "type.googleapis.com/google.datastore.admin.v1.ImportEntitiesMetadata",

"common": {

"startTime": "2019-09-18T21:25:02.863621Z",

"operationType": "IMPORT_ENTITIES",

"state": "PROCESSING"

},

"entityFilter": {},

"inputUrl": "gs://bucket-name/2019-09-18T18:42:26_85726/2019-09-18T18:42:26_85726.overall_export_metadata"

}

}

overall_export_metadata-Datei finden

Sie können den für den Importspeicherort zu verwendenden Wert mithilfe des Cloud Storage-Browsers in der Google Cloud Console ermitteln:

Sie können auch abgeschlossene Vorgänge auflisten und beschreiben. Im Feld outputURL wird der Name der Datei overall_export_metadata angezeigt:

"outputUrl": "gs://bucket-name/2017-05-25T23:54:39_76544/2017-05-25T23:54:39_76544.overall_export_metadata",

Bestimmte Arten oder Namespaces importieren

Um eine bestimmte Teilmenge von Arten und/oder Namespaces zu importieren, setzen Sie einen Entitätsfilter mit Werten für Arten und Namespace-IDs.

Arten und Namespaces lassen sich nur dann angeben, wenn die Exportdateien mit einem Entitätsfilter erstellt wurden. Der Import einer Teilmenge von Arten und Namespaces aus einem Export aller Entitäten wird nicht unterstützt.

Console

In der Console können Sie entweder alle Arten oder eine bestimmte Art auswählen. Ebenso können Sie alle Namespaces oder einen bestimmten Namespace auswählen.

Um eine Liste der zu importierenden Namespaces und Arten anzugeben, verwenden Sie gcloud.

Rufen Sie in der Google Cloud Console die Seite Datenbanken auf.

Wählen Sie die benötigte Datenbank aus der Liste der Datenbanken aus.

Klicken Sie im Navigationsmenü auf Import/Export.

Klicken Sie auf Importieren.

Klicken Sie im Feld

Fileauf Durchsuchen und wählen Sie eine.overall_export_metadata-Datei aus.Achten Sie darauf, dass Sie die Datei

.overall_export_metadataund nicht die Datei.export_metadataimportieren.Setzen Sie das Feld Namespace auf

All Namespacesoder auf einen bestimmten Namespace.Setzen Sie das Feld Art auf

All Kindsoder auf eine bestimmte Art.Klicken Sie auf Importieren.

Die Console kehrt zur Seite Import/Export zurück. In einer Benachrichtigung wird der Erfolg oder Misserfolg Ihrer verwalteten Importanfrage gemeldet.

gcloud

gcloud firestore import --collection-ids="KIND1,KIND2" \ --namespaces="(default),NAMESPACE2" \ gs://bucket-name/file-path/file-nameoverall_export_metadata \ --async \ --database=DATABASE

Dabei ist bucket-name/file-path/file-name der Pfad zur Datei overall_export_metadata in Ihrem Cloud Storage-Bucket.

Verwenden Sie das Flag [--async][async-flag], damit gcloud nicht wartet, bis der Vorgang abgeschlossen ist. Wenn Sie das Flag --async weglassen, können Sie Ctrl+c eingeben, um das Warten auf einen Vorgang zu beenden. Dies bricht den Vorgang aber nicht ab.

Setzen Sie das Flag --database auf den Namen der Datenbank, in die Sie die spezifischen Arten oder Namespaces importieren möchten. Verwenden Sie --database='(default)' für die Standarddatenbank.

REST

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- project-id: Ihre Projekt-ID

- bucket-name: Name Ihres Cloud Storage-Buckets

- object-name: Name Ihres Cloud Storage-Objekts (Beispiel:

2017-05-25T23:54:39_76544/2017-05-25T23:54:39_76544.overall_export_metadata) - kind: Entitätstyp

- namespace: Namespace-ID (verwenden Sie "" für die Standard-Namespace-ID)

HTTP-Methode und URL:

POST https://datastore.googleapis.com/v1/projects/project-id:import

JSON-Text anfordern:

{

"inputUrl": "gs://bucket-name/object-name",

"entityFilter": {

"kinds": ["kind"],

"namespaceIds": ["namespace"],

},

}

Wenn Sie die Anfrage senden möchten, maximieren Sie eine der folgenden Optionen:

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

{

"name": "projects/project-id/operations/operation-id",

"metadata": {

"@type": "type.googleapis.com/google.datastore.admin.v1.ImportEntitiesMetadata",

"common": {

"startTime": "2019-09-18T21:51:02.830608Z",

"operationType": "IMPORT_ENTITIES",

"state": "PROCESSING"

},

"entityFilter": {

"kinds": [

"Task"

],

"namespaceIds": [

""

]

},

"inputUrl": "gs://bucket-name/2019-09-18T21:49:25_96833/2019-09-18T21:49:25_96833.overall_export_metadata"

}

}

Aus PITR-Daten exportieren und importieren

Sie können Ihre Datenbank aus [PITR-Daten][pitr] in Cloud Storage exportieren.

Sie können PITR-Daten exportieren, deren Zeitstempel ein Zeitstempel für eine volle Minute innerhalb der letzten sieben Tage ist, aber nicht vor dem earliestVersionTime. Wenn zum angegebenen Zeitstempel keine Daten mehr vorhanden sind, schlägt der Exportvorgang fehl.

Der PITR-Exportvorgang unterstützt alle Filter, einschließlich des Exports aller Dokumente und des Exports bestimmter Sammlungen.

Beachten Sie vor dem Exportieren von PITR-Daten die folgenden Punkte:

- Geben Sie den Zeitstempel im RFC 3339-Format an. Beispiel:

2023-05-26T10:20:00.00Z. - Achten Sie darauf, dass der von Ihnen angegebene Zeitstempel ein Zeitstempel für eine volle Minute innerhalb der letzten sieben Tage ist, aber nicht vor dem

earliestVersionTime. Wenn zum angegebenen Zeitstempel keine Daten mehr vorhanden sind, wird ein Fehler generiert. - Ein fehlgeschlagener PITR-Export wird Ihnen nicht in Rechnung gestellt.

Konsole

-

Rufen Sie in der Google Cloud Console die Seite Datenbanken auf.

Zur Seite „Datenbanken“ - Wählen Sie eine Datenbank aus der Liste der Datenbanken aus.

- Klicken Sie im Navigationsmenü auf Import/Export.

- Klicken Sie auf Exportieren.

- Zu exportierenden Namespace auswählen

- Wählen Sie die zu exportierenden Arten aus.

Wählen Sie im Abschnitt Zustand der zu exportierenden Datenbank auswählen die Option Von einem früheren Zeitpunkt exportieren aus.

Snapshot-Zeit für den Export auswählen

- Geben Sie im Bereich Ziel den Namen eines Cloud Storage-Buckets ein oder wählen Sie mit der Schaltfläche Durchsuchen einen Bucket aus.

-

Klicken Sie auf Exportieren.

Die Console kehrt zur Seite Import/Export zurück. Wenn der Vorgang erfolgreich gestartet wird, fügt die Seite der letzten Import- und Exportseite einen Eintrag hinzu. Bei einem Fehler wird auf der Seite eine Fehlermeldung angezeigt.

gcloud

Sie können Ihre Datenbank mit dem Befehl gcloud firestore export aus PITR-Daten in Cloud Storage exportieren.

Der PITR-Exportvorgang unterstützt alle Filter, einschließlich des Exports aller Entitäten und des Exports bestimmter Arten oder Namespaces.

Exportieren Sie die Datenbank und geben Sie für den Parameter snapshot-time einen Wiederherstellungszeitstempel an. Führen Sie den folgenden Befehl aus, um die Datenbank in Ihren Bucket zu exportieren.

gcloud firestore export gs://[BUCKET_NAME_PATH] \ --snapshot-time=[PITR_TIMESTAMP] \ --collection-ids=[COLLECTION_IDS] \ --namespace-ids=[NAMESPACE_IDS]

Dabei ist PITR_TIMESTAMP ein PITR-Zeitstempel mit Minutengranularität, z. B. 2023-05-26T10:20:00.00Z.

Transformationen importieren

Beachten Sie beim Importieren von Entitäten aus einem anderen Projekt, dass Entitätsschlüssel die Projekt-ID enthalten. Ein Importvorgang aktualisiert Entitätsschlüssel und Schlüsselreferenzattribute in den Importdaten mit der Projekt-ID des Zielprojekts. Wenn durch diese Aktualisierung die Entitätsgrößen erhöht werden, kann es bei Importvorgängen zu Fehlermeldungen wie "Entität ist zu groß" oder "Indexeinträge zu groß" kommen.

Durch den Import in ein Zielprojekt mit einer kürzeren Projekt-ID können Sie diese Fehler vermeiden. Dies wirkt sich nicht auf Importvorgänge mit Daten aus demselben Projekt aus.

Umgang mit lang andauernden Vorgängen

Verwaltete Import- und Exportvorgänge sind lang andauernde Vorgänge. Diese Methodenaufrufe können sehr viel Zeit in Anspruch nehmen.

Nachdem Sie einen Export- oder Importvorgang gestartet haben, weist der Datastore-Modus dem Vorgang einen eindeutigen Namen zu. Sie können den Vorgangsnamen verwenden, um den Vorgang zu löschen, abzubrechen oder den Status zu prüfen.

Vorgangsnamen haben das Präfix projects/[PROJECT_ID]/databases/(default)/operations/, zum Beispiel:

projects/project-id/databases/(default)/operations/ASA1MTAwNDQxNAgadGx1YWZlZAcSeWx0aGdpbi1zYm9qLW5pbWRhEgopEg

Wenn Sie für gcloud-Befehle einen Vorgangsnamen angeben, können Sie das Präfix weglassen.

Lang andauernde Vorgänge auflisten

Sie können laufende und kürzlich abgeschlossene Vorgänge auf folgende Weise aufrufen. Die Vorgänge sind nach Abschluss einige Tage lang in der Liste enthalten:

Konsole

Eine Liste der Vorgänge, die lange dauern, finden Sie in der Google Cloud -Konsole auf der Seite Import/Export.

Rufen Sie in der Google Cloud Console die Seite Datenbanken auf.

Wählen Sie die benötigte Datenbank aus der Liste der Datenbanken aus.

Klicken Sie im Navigationsmenü auf Import/Export.

gcloud

Verwenden Sie zum Auflisten von Vorgängen mit langer Ausführungszeit den Befehl gcloud datastore operations list:

gcloud datastore operations list

Beispiel: Ein kürzlich abgeschlossener Exportvorgang enthält die folgenden Informationen:

{

"operations": [

{

"name": "projects/project-id/operations/ASAyMDAwOTEzBxp0bHVhZmVkBxJsYXJ0bmVjc3Utc2Jvai1uaW1kYRQKKhI",

"metadata": {

"@type": "type.googleapis.com/google.datastore.admin.v1.ExportEntitiesMetadata",

"common": {

"startTime": "2017-12-05T23:01:39.583780Z",

"endTime": "2017-12-05T23:54:58.474750Z",

"operationType": "EXPORT_ENTITIES"

},

"progressEntities": {

"workCompleted": "21933027",

"workEstimated": "21898182"

},

"progressBytes": {

"workCompleted": "12421451292",

"workEstimated": "9759724245"

},

"entityFilter": {

"namespaceIds": [

""

]

},

"outputUrlPrefix": "gs://bucket-name"

},

"done": true,

"response": {

"@type": "type.googleapis.com/google.datastore.admin.v1.ExportEntitiesResponse",

"outputUrl": "gs://bucket-name/2017-05-25T23:54:39_76544/2017-05-25T23:54:39_76544.overall_export_metadata"

}

}

]

}

rest

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- project-id: Ihre Projekt-ID

HTTP-Methode und URL:

GET https://datastore.googleapis.com/v1/projects/project-id/operations

Wenn Sie die Anfrage senden möchten, maximieren Sie eine der folgenden Optionen:

Weitere Informationen zur Antwort finden Sie weiter unten.

Beispiel: Ein kürzlich abgeschlossener Exportvorgang enthält die folgenden Informationen:

{

"operations": [

{

"name": "projects/project-id/operations/ASAyMDAwOTEzBxp0bHVhZmVkBxJsYXJ0bmVjc3Utc2Jvai1uaW1kYRQKKhI",

"metadata": {

"@type": "type.googleapis.com/google.datastore.admin.v1.ExportEntitiesMetadata",

"common": {

"startTime": "2017-12-05T23:01:39.583780Z",

"endTime": "2017-12-05T23:54:58.474750Z",

"operationType": "EXPORT_ENTITIES"

},

"progressEntities": {

"workCompleted": "21933027",

"workEstimated": "21898182"

},

"progressBytes": {

"workCompleted": "12421451292",

"workEstimated": "9759724245"

},

"entityFilter": {

"namespaceIds": [

""

]

},

"outputUrlPrefix": "gs://bucket-name"

},

"done": true,

"response": {

"@type": "type.googleapis.com/google.datastore.admin.v1.ExportEntitiesResponse",

"outputUrl": "gs://bucket-name/2017-05-25T23:54:39_76544/2017-05-25T23:54:39_76544.overall_export_metadata"

}

}

]

}

Vorgangsstatus prüfen

So zeigen Sie den Status eines lang andauernden Vorgangs an:

Konsole

Eine Liste der letzten Export- und Importvorgänge finden Sie in der Google Cloud -Konsole auf der Seite Import/Export.

Rufen Sie in der Google Cloud Console die Seite Datenbanken auf.

Wählen Sie die benötigte Datenbank aus der Liste der Datenbanken aus.

Klicken Sie im Navigationsmenü auf Import/Export.

gcloud

Verwenden Sie den Befehl operations describe, um den Status eines lang andauernden Vorgangs anzuzeigen.

gcloud datastore operations describe operation-name

rest

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- project-id: Ihre Projekt-ID

- operation-name: Der Name des Vorgangs

HTTP-Methode und URL:

GET https://datastore.googleapis.com/v1/projects/project-id/operations/operation-name

Wenn Sie die Anfrage senden möchten, maximieren Sie eine der folgenden Optionen:

Sie sollten in etwa folgende JSON-Antwort erhalten:

{

"name": "projects/project-id/operations/ASA3ODAwMzQxNjIyChp0bHVhZmVkBxJsYXJ0bmVjc3Utc2Jvai1uaW1kYRQKLRI",

"metadata": {

"@type": "type.googleapis.com/google.datastore.admin.v1.ExportEntitiesMetadata",

"common": {

"startTime": "2019-10-08T20:07:28.105236Z",

"endTime": "2019-10-08T20:07:36.310653Z",

"operationType": "EXPORT_ENTITIES",

"state": "SUCCESSFUL"

},

"progressEntities": {

"workCompleted": "21",

"workEstimated": "21"

},

"progressBytes": {

"workCompleted": "2272",

"workEstimated": "2065"

},

"entityFilter": {},

"outputUrlPrefix": "gs://bucket-name/2019-10-08T20:07:28_28481"

},

"done": true,

"response": {

"@type": "type.googleapis.com/google.datastore.admin.v1.ExportEntitiesResponse",

"outputUrl": "gs://bucket-name/2019-10-08T20:07:28_28481/2019-10-08T20:07:28_28481.overall_export_metadata"

}

}

Fertigstellungszeit schätzen

Während der Ausführung eines Vorgangs wird im Feld state der Gesamtstatus des Vorgangs angezeigt.

Eine Anfrage für den Status eines Vorgangs mit langer Ausführungszeit liefert die Messwerte workEstimated und workCompleted. Beide Messwerte werden als Anzahl der Byte und als Anzahl der Entitäten zurückgegeben:

workEstimatedweist die geschätzte Gesamtzahl der Byte und Dokumente aus, die ein Vorgang verarbeitet. Im Datastore-Modus wird dieser Messwert möglicherweise ausgelassen, wenn keine Schätzung möglich ist.workCompletedweist die Anzahl der bisher verarbeiteten Byte und Dokumente aus. Nachdem der Vorgang abgeschlossen ist, zeigt der Wert die Gesamtanzahl der tatsächlich verarbeiteten Byte und Dokumente an, die möglicherweise größer als der Wert vonworkEstimatedist.

Teilen Sie workCompleted durch workEstimated, um eine grobe Schätzung des Fortschritts zu erhalten. Diese Schätzung ist möglicherweise ungenau, da sie von der verzögerten Statistikerfassung abhängt.

Das folgende Beispiel zeigt den Fortschrittsstatus eines Exportvorgangs:

{

"operations": [

{

"name": "projects/project-id/operations/ASAyMDAwOTEzBxp0bHVhZmVkBxJsYXJ0bmVjc3Utc2Jvai1uaW1kYRQKKhI",

"metadata": {

"@type": "type.googleapis.com/google.datastore.admin.v1.ExportEntitiesMetadata",

...

"progressEntities": {

"workCompleted": "1",

"workEstimated": "3"

},

"progressBytes": {

"workCompleted": "85",

"workEstimated": "257"

},

...

Wenn ein Vorgang abgeschlossen ist, enthält die Vorgangsbeschreibung "done":

true. Der Wert des Feldes state stellt das Ergebnis des Vorgangs dar. Wenn das Feld done nicht in der Antwort festgelegt ist, lautet der Wert false. Verlassen Sie sich bei laufenden Vorgängen nicht auf die Existenz des Werts done.

Vorgang abbrechen

Konsole

Sie können laufende Export- oder Importvorgänge auf der Seite Import/Export der Google Cloud -Konsole abbrechen.

Rufen Sie in der Google Cloud Console die Seite Datenbanken auf.

Wählen Sie die benötigte Datenbank aus der Liste der Datenbanken aus.

Klicken Sie im Navigationsmenü auf Import/Export.

In der Tabelle Aktuelle Importe und Exporte enthalten aktuell ausgeführte Vorgänge die Schaltfläche Abbrechen in der Spalte Abgeschlossen. Klicken Sie auf die Schaltfläche Abbrechen, um den Vorgang zu beenden. Die Schaltfläche ändert sich in eine Abbrechen- und, sobald der Vorgang komplett ist, in eine Storniert-Nachricht.

gcloud

Verwenden Sie den Befehl operations cancel, um einen laufenden Vorgang zu stoppen:

gcloud datastore operations cancel operation-name

Durch das Abbrechen eines laufenden Vorgangs wird der Vorgang nicht rückgängig gemacht. Bei einem abgebrochenen Exportvorgang werden bereits in Cloud Storage exportierte Dokumente dort beibehalten. Bei einem abgebrochenen Importvorgang werden die bereits an der Datenbank vorgenommenen Aktualisierungen beibehalten. Sie können einen unvollständigen Export nicht importieren.

Vorgang löschen

gcloud

Verwenden Sie den Befehl operations delete, um einen Vorgang aus der Liste der letzten Vorgänge zu entfernen. Mit diesem Befehl werden keine Exportdateien aus Cloud Storage gelöscht.

gcloud datastore operations delete operation-name

Abrechnung und Preise für verwaltete Exporte und Importe

Sie müssen die Abrechnung für Ihr Google Cloud -Projekt aktivieren, bevor Sie den verwalteten Export- und Importdienst verwenden können. Export- und Importvorgänge tragen auf folgende Weise zu Ihren Google Cloud -Kosten bei:

- Lese- und Schreibvorgänge für Entitäten, bei Export- und Importvorgängen ausgeführt wurden, werden auf die Kosten von Firestore im Datastore-Modus angerechnet. Bei Exportvorgängen wird pro exportierter Entität eine Leseoperation durchgeführt. Bei Importvorgängen wird für jede importierte Einheit ein Schreibvorgang ausgeführt.

- In Cloud Storage gespeicherte Ausgabedateien werden auf Ihre in Cloud Storage gespeicherten Daten angerechnet.

Export- oder Importvorgänge können erst nach Abschluss eine Google Cloud -Budgetbenachrichtigung auslösen. Die während eines Export- oder Importvorgangs ausgeführten Lese- und Schreibvorgänge werden nach Abschluss des Vorgangs auf Ihr Tageskontingent angerechnet.

Preise für Export und Import aufrufen

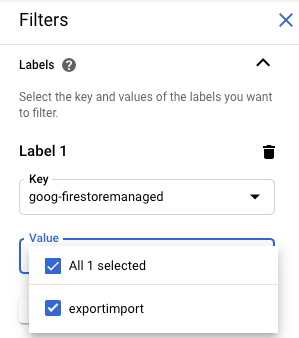

Bei Export- und Importvorgängen wird das goog-firestoremanaged:exportimport-Label auf in Rechnung gestellte Vorgänge angewendet. Auf der Seite der Cloud Billing-Berichte können Sie über dieses Label Kosten für Import- und Exportvorgänge aufrufen:

Unterschiede zu Datastore Admin-Sicherungen

Wenn Sie zuvor die Datastore Admin-Konsole für Sicherungen verwendet haben, sollten Sie die folgenden Unterschiede beachten:

Exporte, die bei einem verwalteten Export erstellt wurden, werden nicht in der Datastore Admin-Konsole angezeigt. Verwaltete Exporte und Importe sind ein neuer Dienst. Dieser teilt keine Daten mit der Sicherungs- und Wiederherstellungsfunktion von App Engine, die über die Google Cloud -Konsole verwaltet wird.

Der verwaltete Export- und Importdienst unterstützt nicht dieselben Metadaten wie die Datastore Admin-Sicherung und speichert den Fortschrittsstatus nicht in Ihrer Datenbank. Weitere Informationen zum Prüfen des Fortschritts von Export- und Importvorgängen finden Sie unter Umgang mit lang andauernden Vorgängen

Sie können keine Dienstlogs von verwalteten Export- und Importvorgängen abrufen.

Der verwaltete Importdienst ist abwärtskompatibel mit Datastore Admin-Sicherungsdateien. Sie können eine Datastore Admin-Sicherungsdatei mithilfe des verwalteten Importdiensts importieren. Die Ausgabe eines verwalteten Exports kann jedoch nicht mithilfe der Datastore Admin-Konsole importiert werden.

In BigQuery importieren

Informationen zum Importieren von Daten aus einem verwalteten Export in BigQuery finden Sie unter Daten des Datastore-Exportdienstes laden.

Daten, die ohne Angabe eines Entitätsfilters exportiert wurden, können nicht in BigQuery geladen werden. Wenn Sie Daten in BigQuery importieren möchten, muss die Exportanfrage im Entitätsfilter einen oder mehrere Artnamen enthalten.

BigQuery-Spaltenlimit

In BigQuery gilt ein Limit von 10.000 Spalten pro Tabelle. Exportvorgänge generieren ein BigQuery-Tabellenschema für jede Art. In diesem Schema wird jedes eindeutige Attribut innerhalb der Entitäten einer Art zu einer Schemaspalte.

Wenn das BigQuery-Schema einer Art 10.000 Spalten überschreitet, versucht der Exportvorgang, unterhalb des Spaltenlimits zu bleiben. Dafür werden eingebettete Entitäten als Blobs behandelt. Wenn durch diese Konvertierung die Anzahl der Spalten im Schema unter 10.000 bleibt, können Sie die Daten in BigQuery laden, aber Sie können die Attribute innerhalb eingebetteter Entitäten nicht abfragen. Wenn die Anzahl der Spalten 10.000 weiterhin überschreitet, generiert der Exportvorgang kein BigQuery-Schema für die Art und Sie können die Daten nicht in BigQuery laden.

Migration von Dienst-Agents

Firestore verwendet einen Firestore-Dienst-Agent, um Import- und Exportvorgänge zu autorisieren, anstatt das App Engine-Dienstkonto zu verwenden. Für den Dienst-Agent und das Dienstkonto gelten die folgenden Namenskonventionen:

- Firestore-Dienst-Agent

service-PROJECT_NUMBER@gcp-sa-firestore.iam.gserviceaccount.com

Bisher wurde in Firestore das App Engine-Standarddienstkonto anstelle des Firestore-Dienst-Agents verwendet. Wenn Ihre Datenbank weiterhin das App Engine-Dienstkonto zum Importieren oder Exportieren von Daten verwendet, empfehlen wir, die Anleitung in diesem Abschnitt zu befolgen, um zur Verwendung des Firestore-Dienst-Agents zu migrieren.

- App Engine-Dienstkonto

PROJECT_ID@appspot.gserviceaccount.com

Der Firestore-Dienst-Agent ist vorzuziehen, da er speziell für Firestore entwickelt wurde. Das App Engine-Dienstkonto wird von mehreren Diensten gemeinsam genutzt.

Autorisierungskonto ansehen

Auf der Seite Import/Export in der Google Cloud -Konsole können Sie sehen, mit welchem Konto Ihre Import- und Exportvorgänge Anfragen autorisieren. Sie können auch prüfen, ob Ihre Datenbank bereits den Firestore-Dienst-Agent verwendet.

-

Rufen Sie in der Google Cloud Console die Seite Datenbanken auf.

- Wählen Sie die benötigte Datenbank aus der Liste der Datenbanken aus.

-

Klicken Sie im Navigationsmenü auf Import/Export.

- Das Autorisierungskonto wird neben dem Label Import-/Exportjobs werden ausgeführt als angezeigt.

Wenn in Ihrem Projekt nicht der Firestore-Dienst-Agent verwendet wird, können Sie mit einer der folgenden Methoden zum Firestore-Dienst-Agent migrieren:

- Projekt migrieren, indem Sie die Berechtigungen für Cloud Storage-Bucket prüfen und aktualisieren (empfohlen)

- Fügen Sie eine organisationsweite Einschränkung für Organisationsrichtlinien hinzu, die sich auf alle Projekte in der Organisation auswirkt.

Die erste dieser Techniken ist vorzuziehen, da sie den Wirkungsbereich auf ein einzelnes Datastore-Modus-Projekt beschränkt. Die zweite Methode wird nicht empfohlen, da vorhandene Berechtigungen für Cloud Storage-Bucket nicht migriert werden. Sie bietet jedoch Sicherheitskonformität auf Organisationsebene.

Migration durch Prüfen und Aktualisieren von Cloud Storage-Bucket-Berechtigungen

Der Migrationsprozess umfasst zwei Schritte:

- Cloud Storage-Bucket-Berechtigungen aktualisieren Weitere Informationen finden Sie im nächsten Abschnitt.

- Bestätigen Sie die Migration zum Firestore-Dienst-Agent.

Bucket-Berechtigungen für Dienst-Agents

Für alle Export- oder Importvorgänge, bei denen ein Cloud Storage-Bucket in einem anderen Projekt verwendet wird, müssen Sie dem Firestore-Dienst-Agent Berechtigungen für diesen Bucket gewähren. Bei Vorgängen, bei denen Daten in ein anderes Projekt verschoben werden, muss beispielsweise auf einen Bucket in diesem anderen Projekt zugegriffen werden. Andernfalls schlagen diese Vorgänge nach der Migration zum Firestore-Dienst-Agent fehl.

Für Import- und Exportvorgänge, die im selben Projekt bleiben, sind keine Änderungen an den Berechtigungen erforderlich. Der Firestore-Dienst-Agent kann standardmäßig auf Buckets im selben Projekt zugreifen.

Aktualisieren Sie die Berechtigungen für Cloud Storage-Buckets aus anderen Projekten, um dem Dienst-Agent service-PROJECT_NUMBER@gcp-sa-firestore.iam.gserviceaccount.com Zugriff zu gewähren. Weisen Sie dem Dienst-Agent die Rolle Firestore Service Agent zu.

Die Rolle Firestore Service Agent gewährt Lese- und Schreibberechtigungen für einen Cloud Storage-Bucket. Wenn Sie nur Lese- oder nur Schreibberechtigungen gewähren möchten, verwenden Sie eine benutzerdefinierte Rolle.

Der im folgenden Abschnitt beschriebene Migrationsprozess hilft Ihnen, Cloud Storage-Buckets zu identifizieren, für die möglicherweise Berechtigungen aktualisiert werden müssen.

Projekt zum Firestore-Dienst-Agent migrieren

Führen Sie die folgenden Schritte aus, um vom App Engine-Dienstkonto zum Firestore-Dienst-Agent zu migrieren. Wenn die Migration abgeschlossen ist, kann sie nicht mehr rückgängig gemacht werden.

-

Rufen Sie in der Google Cloud Console die Seite Datenbanken auf.

- Wählen Sie die benötigte Datenbank aus der Liste der Datenbanken aus.

-

Klicken Sie im Navigationsmenü auf Import/Export.

-

Wenn Ihr Projekt noch nicht zum Firestore-Dienst-Agent migriert wurde, wird ein Banner mit einer Beschreibung der Migration und der Schaltfläche Bucket-Status prüfen angezeigt. Im nächsten Schritt können Sie potenzielle Berechtigungsfehler identifizieren und beheben.

Klicken Sie auf Bucket-Status prüfen.

Ein Menü mit der Option zum Abschließen der Migration und einer Liste von Cloud Storage-Buckets wird angezeigt. Es kann einige Minuten dauern, bis die Liste vollständig geladen ist.

Diese Liste enthält Buckets, die vor Kurzem für Import- und Exportvorgänge verwendet wurden, für die der Datastore-Modus-Dienst-Agent derzeit jedoch keine Lese- und Schreibberechtigungen hat.

- Notieren Sie sich den Prinzipalnamen des Dienst-Agents für den Datastore-Modus Ihres Projekts. Der Name des Dienst-Agents wird unter dem Label Dienst-Agent, dem Zugriff gewährt werden soll angezeigt.

-

Führen Sie für jeden Bucket in der Liste, den Sie für zukünftige Import- oder Exportvorgänge verwenden möchten, die folgenden Schritte aus:

-

Klicken Sie in der Tabellenzeile dieses Bucket auf Beheben. Dadurch wird die Berechtigungsseite des entsprechenden Buckets in einem neuen Tab geöffnet.

- Klicken Sie auf Hinzufügen.

- Geben Sie im Feld Neue Hauptkonten den Namen Ihres Firestore-Dienst-Agents ein.

- Wählen Sie im Feld Rolle auswählen die Option Dienst-Agents > Firestore-Dienst-Agent aus.

- Klicken Sie auf Speichern.

- Kehren Sie zum Tab mit der Seite „Import/Export“ für den Datastore-Modus zurück.

- Wiederholen Sie diese Schritte für die anderen Gruppen in der Liste. Sehen Sie sich alle Seiten der Liste an.

-

-

Klicken Sie auf Zum Firestore-Dienst-Agent migrieren. Wenn Sie weiterhin Buckets mit fehlgeschlagenen Berechtigungsprüfungen haben, müssen Sie die Migration bestätigen, indem Sie auf Migrieren klicken.

Sie werden benachrichtigt, wenn die Migration abgeschlossen ist. Die Migration kann nicht rückgängig gemacht werden.

Status der Migration abrufen

So prüfen Sie den Migrationsstatus Ihres Projekts:

-

Rufen Sie in der Google Cloud Console die Seite Datenbanken auf.

- Wählen Sie die benötigte Datenbank aus der Liste der Datenbanken aus.

-

Klicken Sie im Navigationsmenü auf Import/Export.

-

Suchen Sie neben dem Label Import-/Exportjobs werden ausgeführt als nach dem Prinzipal.

Wenn das Hauptkonto

service-PROJECT_NUMBER@gcp-sa-firestore.iam.gserviceaccount.comist, wurde Ihr Projekt bereits zum Firestore-Dienstkonto migriert. Die Migration kann nicht rückgängig gemacht werden.Wenn das Projekt noch nicht migriert wurde, wird oben auf der Seite ein Banner mit der Schaltfläche Bucket-Status prüfen angezeigt. Weitere Informationen finden Sie unter Zum Firestore-Dienst-Agent migrieren.

Organisationsweite Einschränkung für Richtlinie hinzufügen

-

Legen Sie die folgende Einschränkung in der Richtlinie Ihrer Organisation fest:

Firestore-Dienst-Agent für Import/Export erforderlich (

firestore.requireP4SAforImportExport).Diese Einschränkung erfordert, dass bei Import- und Exportvorgängen der Firestore-Dienst-Agent verwendet wird, um Anfragen zu autorisieren. Informationen zum Festlegen dieser Einschränkung finden Sie unter Organisationsrichtlinien erstellen und verwalten .

Durch Anwenden dieser Einschränkung für Organisationsrichtlinien werden nicht automatisch die entsprechenden Cloud Storage-Bucket-Berechtigungen für den Firestore-Dienst-Agent gewährt.

Wenn durch die Einschränkung Berechtigungsfehler für Import- oder Exportworkflows entstehen, können Sie sie deaktivieren, um wieder das Standarddienstkonto zu verwenden. Nachdem Sie die Berechtigungen für den Cloud Storage-Bucket geprüft und aktualisiert haben, können Sie die Einschränkung wieder aktivieren.