Schritt 3: Integrationsmechanismus festlegen

Auf dieser Seite wird der dritte Schritt zum Bereitstellen der Cortex Framework Data Foundation, dem Kern von Cortex Framework, beschrieben. In diesem Schritt konfigurieren Sie die Integration mit der ausgewählten Datenquelle. Wenn Sie Beispieldaten verwenden, überspringen Sie diesen Schritt.

Überblick über die Integration

Mit dem Cortex Framework können Sie Daten aus verschiedenen Quellen und anderen Plattformen zentralisieren. So schaffen Sie eine zentrale Informationsquelle für Ihre Daten. Cortex Data Foundation wird auf unterschiedliche Weise in die einzelnen Datenquellen eingebunden, aber die meisten folgen einem ähnlichen Verfahren:

- Source to Raw layer (Quelle zu Rohdaten-Ebene): Daten aus der Datenquelle werden mithilfe von APIs in das Rohdaten-Dataset aufgenommen. Dies wird durch die Verwendung von Dataflow-Pipelines erreicht, die über Cloud Composer-DAGs ausgelöst werden.

- Rohdatenschicht zur CDC-Schicht: Wenden Sie die CDC-Verarbeitung auf das Rohdatenset an und speichern Sie die Ausgabe im CDC-Dataset. Dies wird durch Cloud Composer-DAGs erreicht, in denen BigQuery-SQL-Code ausgeführt wird.

- CDC-Ebene zur Berichtsebene:Erstellt endgültige Berichtstabellen aus CDC-Tabellen im Berichts-Dataset. Dies erfolgt entweder durch das Erstellen von Laufzeitansichten auf CDC-Tabellen oder durch das Ausführen von Cloud Composer-DAGs für materialisierte Daten in BigQuery-Tabellen – je nach Konfiguration. Weitere Informationen zur Konfiguration finden Sie unter Datei mit benutzerdefinierten Berichtseinstellungen.

In der Datei config.json werden die Einstellungen konfiguriert, die für die Verbindung mit Datenquellen zum Übertragen von Daten aus verschiedenen Arbeitslasten erforderlich sind. In den folgenden Ressourcen finden Sie die Integrationsoptionen für die einzelnen Datenquellen.

- Betrieb:

- Marketing:

- Nachhaltigkeit:

Weitere Informationen zu den Entity-Relationship-Diagrammen, die von den einzelnen Datenquellen unterstützt werden, finden Sie im Ordner docs im Repository „Cortex Framework Data Foundation“.

K9-Bereitstellung

Der K9-Deployer vereinfacht die Integration verschiedener Datenquellen. Der K9-Deployer ist ein vordefiniertes Dataset in der BigQuery-Umgebung, das für die Aufnahme, Verarbeitung und Modellierung von Komponenten zuständig ist, die für verschiedene Datenquellen wiederverwendet werden können.

Die Dimension time kann beispielsweise für alle Datenquellen wiederverwendet werden, in denen Tabellen möglicherweise Analyseergebnisse auf Grundlage eines gregorianischen Kalenders benötigen. Der K9-Deployer kombiniert externe Daten wie Wetter oder Google Trends mit anderen Datenquellen (z. B. SAP, Salesforce, Marketing). Dieser angereicherte Datensatz ermöglicht detailliertere Analysen und umfassendere Erkenntnisse.

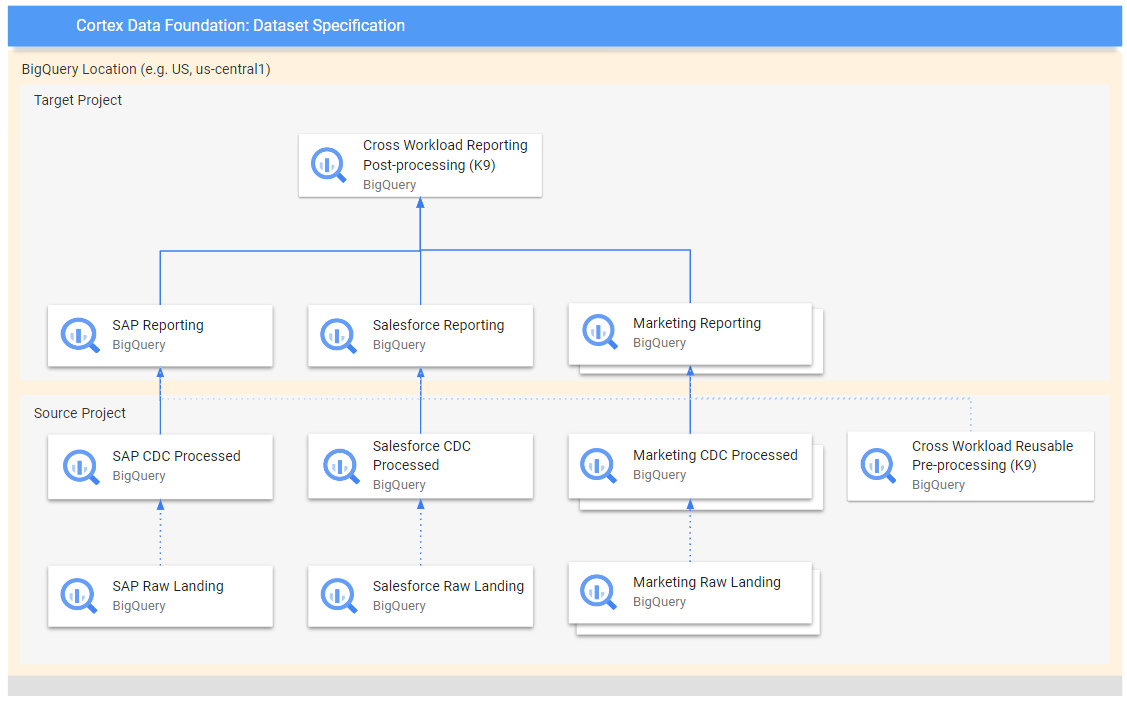

Das folgende Diagramm zeigt den Datenfluss von verschiedenen Rohdatenquellen zu den verschiedenen Berichtsebenen:

Im Diagramm enthält das Quellprojekt die Rohdaten aus den ausgewählten Datenquellen (SAP, Salesforce und Marketing). Das Zielprojekt enthält verarbeitete Daten, die aus dem CDC-Prozess (Change Data Capture) stammen.

Der K9-Vorverarbeitungsschritt wird ausgeführt, bevor alle Arbeitslasten mit der Bereitstellung beginnen. Die wiederverwendbaren Modelle sind also während der Bereitstellung verfügbar. In diesem Schritt werden Daten aus verschiedenen Quellen transformiert, um ein einheitliches und wiederverwendbares Dataset zu erstellen.

Die K9-Schritte für die Nachbearbeitung erfolgen, nachdem alle Arbeitslasten ihre Berichtsmodelle bereitgestellt haben, um die Berichterstellung für mehrere Arbeitslasten zu ermöglichen oder Modelle zu erweitern, damit sie die erforderlichen Abhängigkeiten in den einzelnen Berichtsdatasets finden.

K9-Bereitstellung konfigurieren

Konfigurieren Sie die zu generierenden gerichteten azyklischen Graphen (Directed Acyclic Graphs, DAGs) und Modelle in der K9-Manifestdatei.

Der K9-Vorverarbeitungsschritt ist wichtig, da er dafür sorgt, dass alle Arbeitslasten in der Datenpipeline Zugriff auf einheitlich vorbereitete Daten haben. Dadurch wird die Redundanz verringert und die Datenkonsistenz sichergestellt.

Weitere Informationen zum Konfigurieren externer Datasets für K9 finden Sie unter Externe Datasets für K9 konfigurieren.

Nächste Schritte

Fahren Sie nach Abschluss dieses Schritts mit den folgenden Bereitstellungsschritten fort:

- Arbeitslasten einrichten:

- Repository klonen

- Integrationsmechanismus festlegen (diese Seite)

- Komponenten einrichten

- Bereitstellung konfigurieren

- Bereitstellung ausführen