Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

このページでは、トラブルシューティングの手順と一般的なワークフローの問題に関する情報を提供します。

DAG 実行の問題の多くは、最適ではない環境のパフォーマンスが原因で発生します。環境のパフォーマンスと費用を最適化するガイドに沿って、環境を最適化できます。

一部の DAG 実行の問題は、Airflow スケジューラが正しく動作しないか、最適に機能していないことが原因の可能性があります。スケジューラのトラブルシューティング手順に沿って問題を解決してください。

トラブルシューティングのワークフロー

トラブルシューティングを開始するには、次の手順を行います。

Airflow ログを確認します。

Airflow のロギングレベルを上げるには、次の Airflow 構成オプションをオーバーライドします。

セクション キー 値 logginglogging_levelデフォルト値は INFOです。 ログメッセージの詳細度を上げるには、DEBUGに設定します。モニタリング ダッシュボードを確認します。

Cloud Monitoring を確認します。

Google Cloud コンソールで、環境のコンポーネントのページのエラーを確認します。

Airflow ウェブ インターフェースの DAG のグラフビューで、失敗したタスク インスタンスを確認します。

セクション キー 値 webserverdag_orientationLR、TB、RL、またはBT

演算子の失敗をデバッグする

演算子の失敗をデバッグするには、次の手順を行います。

- タスク固有のエラーを確認します。

- Airflow ログを確認します。

- Cloud Monitoring を確認します。

- 演算子固有のログを確認します。

- エラーを修正します。

/dagsフォルダに DAG をアップロードします。- Airflow ウェブ インターフェースで、DAG の過去の状態を消去します。

- DAG を再開または実行します。

タスク実行のトラブルシューティング

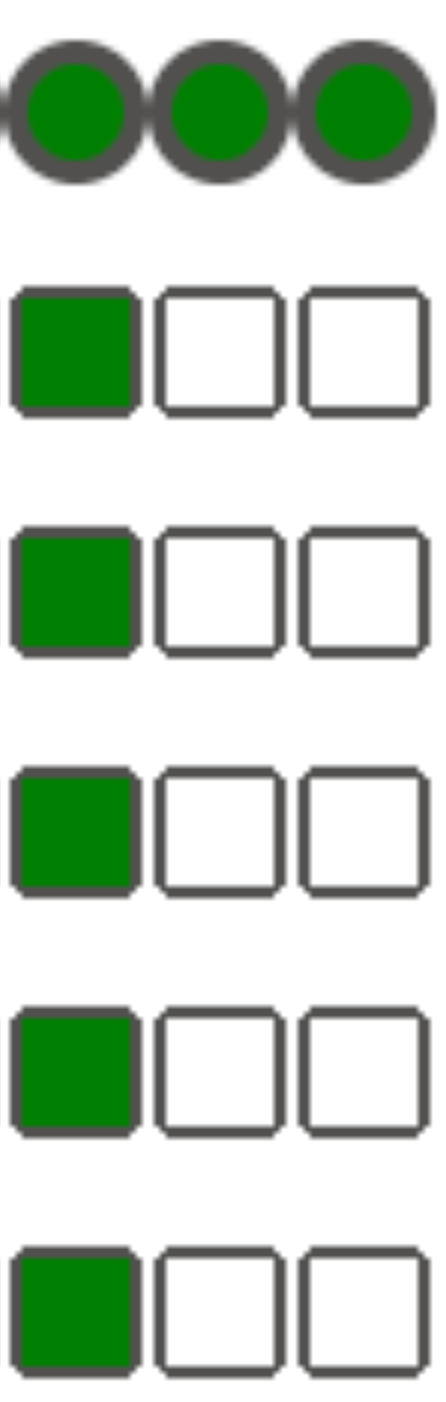

Airflow は、タスクキューや Airflow データベースを介して相互に通信を行い、シグナル(SIGTERM など)を送信する、スケジューラ、エグゼキュータ、ワーカーなどのさまざまなエンティティを持つ分散システムです。次の図は、Airflow コンポーネント間の相互接続の概要を示しています。

Airflow などの分散システムでは、ネットワーク接続に問題があるか、基盤となるインフラストラクチャで断続的な問題が発生している可能性があります。この場合、タスクが失敗して実行が再スケジュールされたり、タスクが正常に完了していない(ゾンビタスク、実行中にエラーになったタスクなど)ことがあります。Airflow には、こうした状況に対処するためのメカニズムがあり、自動的に機能を再開します。以下のセクションでは、Airflow によるタスクの実行中に発生する一般的な問題について説明します。

ログが出力されずタスクが失敗する

DAG 解析エラーのためにログが出力されずタスクが失敗する

微妙な DAG エラーが原因で、Airflow スケジューラがタスクの実行をスケジュールでき、DAG プロセッサが DAG ファイルを解析できるが、DAG ファイルにプログラミング エラーがあるために Airflow ワーカーが DAG からタスクを実行できない場合があります。このため、Airflow タスクが Failed とマークされ、実行からのログが存在しないことがあります。

ソリューション:

Airflow ワーカーログで、Airflow ワーカーによって引き起こされる、DAG が見つからない、または DAG 解析エラーに関連するエラーが発生していないことを確認します。

DAG の解析に関連付けられたパラメータを増やします。

[dagbag-import-timeout][ext-airflow-dagrun-import-timeout] を 120 秒以上(必要に応じてそれ以上)に増やします。

dag-file-processor-timeout を 180 秒以上(必要に応じてそれ以上)に増やします。この値は

dagbag-import-timeoutより大きい値にする必要があります。

DAG プロセッサの問題のトラブルシューティングもご覧ください。

タスクが突然中断される

タスクの実行中に、タスク自体に直接関連しない問題が原因で Airflow ワーカーが突然終了することがあります。このようなシナリオと可能な解決策のリストについては、一般的な根本原因をご覧ください。以降のセクションでは、これらの根本原因から発生する可能性のある追加の症状について説明します。

ゾンビタスク

Airflow は、タスクとタスクを実行するプロセスの間で次の 2 種類の不一致を検出します。

ゾンビタスクは、実行されるはずであるが実行されていないタスクです。これは、タスクのプロセスが終了済みか応答していない場合、Airflow ワーカーが過負荷のためにタスク ステータスを時間内に報告しなかった場合、またはタスクが実行された VM がシャットダウンされた場合に発生します。Airflow はそのようなタスクを定期的に検出し、タスクの設定に応じて、失敗するか、再試行します。

ゾンビタスクを検出する

resource.type="cloud_composer_environment" resource.labels.environment_name="ENVIRONMENT_NAME" log_id("airflow-scheduler") textPayload:"Detected zombie job"デッドタスクとは、実行すべきでないタスクです。Airflow はそのようなタスクを定期的に検出し、終了させます。

ゾンビタスクのトラブルシューティング方法については、一般的な根本原因をご覧ください。

SIGTERM シグナル

SIGTERM シグナルは、Linux、Kubernetes、Airflow スケジューラ、Celery が Airflow ワーカーまたは Airflow タスクの実行を処理するプロセスを終了するために使用されます。

次のようないくつかの理由で、SIGTERM シグナルが環境内で送信される場合があります。

タスクがゾンビタスクになったため、停止する必要がある。

スケジューラがタスクの重複を検出し、インスタンス終了と SIGTERM シグナルをタスクに送信してタスクを停止する。

水平 Pod 自動スケーリングで、GKE コントロール プレーンが SIGTERM シグナルを送信して、不要になった Pod を削除する。

スケジューラは、DagFileProcessorManager プロセスに SIGTERM シグナルを送信できます。このような SIGTERM シグナルは、DagFileProcessorManager プロセスのライフサイクルを管理するために Scheduler によって使用され、無視しても問題ありません。

例:

Launched DagFileProcessorManager with pid: 353002 Sending Signals.SIGTERM to group 353002. PIDs of all processes in the group: [] Sending the signal Signals.SIGTERM to group 353002 Sending the signal Signals.SIGTERM to process 353002 as process group is missing.タスクの実行をモニタリングする local_task_job のハートビート コールバックと終了コールバック間の競合状態。ハートビートは、タスクが成功とマークされたことを検出した場合、タスク自体が成功したのか、タスクが成功したと見なすように Airflow が通知されたのかを区別できません。それでも、タスクランナーは、終了するのを待たずに停止します。

このような SIGTERM シグナルは無視してもかまいません。タスクはすでに成功状態にあり、DAG 実行全体の実行は影響を受けません。

ログエントリ

Received SIGTERM.は、通常の終了と成功した状態のタスクの停止との唯一の違いです。図 2.ハートビート コールバックと終了コールバック間の競合状態(クリックして拡大) Airflow コンポーネントが、クラスタノードで許可されているよりも多くのリソース(CPU、メモリ)を使用している。

GKE Service は、メンテナンス オペレーションを実行し、アップグレードされようとしているノード上で実行される Pod に SIGTERM シグナルを送信します。

タスク インスタンスが SIGTERM で停止すると、タスクを実行する Airflow ワーカーのログに次のログエントリが表示されます。

{local_task_job.py:211} WARNING - State of this instance has been externally set to queued. Terminating instance. {taskinstance.py:1411} ERROR - Received SIGTERM. Terminating subprocesses. {taskinstance.py:1703} ERROR - Task failed with exception

解決策の提示

この問題は、タスクを実行する VM のメモリが不足している場合に発生します。これは Airflow 構成ではなく、VM で使用可能なメモリ量に関連します。

Cloud Composer 2 では、より多くの CPU リソースとメモリリソースを Airflow ワーカーに割り当てることができます。

[celery]worker_concurrency同時実行 Airflow 構成オプションの値を小さくできます。このオプションは、特定の Airflow ワーカーによって同時に実行されるタスクの数を決定します。

環境の最適化の詳細については、環境のパフォーマンスと費用を最適化するをご覧ください。

Airflow タスクが Negsignal.SIGKILL によって中断された

タスクによっては、Airflow ワーカーに割り当てられているメモリよりも多くのメモリを使用する場合があります。このような状況では、Negsignal.SIGKILL によって中断される可能性があります。このシグナルは、他の Airflow タスクの実行に影響する可能性のあるメモリ消費のさらなる増大を回避するためにシステムによって送信されます。Airflow ワーカーのログに次のようなログエントリが表示される場合があります。

{local_task_job.py:102} INFO - Task exited with return code Negsignal.SIGKILL

Negsignal.SIGKILL はコード -9 として表示される場合もあります。

解決策の提示

Airflow ワーカーの

worker_concurrencyを減らす。Airflow ワーカーが使用できるメモリ量を増やします。

KubernetesPodOperator または GKEStartPodOperator を使用してタスクの分離とカスタマイズされたリソース割り当てを行うことで、Cloud Composer でリソースを大量に消費するタスクを管理します。

使用するメモリを少なくするようタスクを最適化します。

リソースの負荷が原因でタスクが失敗する

症状: タスクの実行中に、Airflow タスクの実行を担当する Airflow ワーカー サブプロセスが突然中断されます。 Airflow ワーカーのログに表示されるエラーは、次のようになります。

...

File "/opt/python3.8/lib/python3.8/site-packages/celery/app/trace.py", line 412, in trace_task R = retval = fun(*args, **kwargs) File "/opt/python3.8/lib/python3.8/site-packages/celery/app/trace.py", line 704, in __protected_call__ return self.run(*args, **kwargs) File "/opt/python3.8/lib/python3.8/site-packages/airflow/executors/celery_executor.py", line 88, in execute_command _execute_in_fork(command_to_exec) File "/opt/python3.8/lib/python3.8/site-packages/airflow/executors/celery_executor.py", line 99, in _execute_in_fork

raise AirflowException('Celery command failed on host: ' + get_hostname())airflow.exceptions.AirflowException: Celery command failed on host: airflow-worker-9qg9x

...

解決方法:

Cloud Composer 2 で、Airflow ワーカーのメモリ上限を増やします。

環境でゾンビタスクも生成される場合は、ゾンビタスクのトラブルシューティングをご覧ください。

メモリ不足に関する問題のデバッグに関するチュートリアルについては、メモリ不足とストレージ不足に関する DAG の問題をデバッグするをご覧ください。

Pod のエビクションが原因でタスクが失敗する

Google Kubernetes Engine Pod には Kubernetes Pod Lifecycle と Pod の強制排除が適用されます。タスクの急激な増大は、Cloud Composer で Pod が強制排除される最も一般的な原因です。

Pod の強制排除は、特定の Pod が、ノードの構成済みのリソース使用量予想と比較して、ノードのリソースを過剰に使用すると発生する可能性があります。たとえば、強制排除は、Pod 内でメモリを多く消費するいくつかのタスクが実行され、それらの負荷の合計によりこの Pod が実行されるノードがメモリ使用量上限を超過する場合に発生する可能性があります。

Airflow ワーカー Pod が強制排除されると、その Pod で実行されているすべてのタスク インスタンスは中断され、後で Airflow によって失敗としてマークされます。

ログはバッファリングされます。バッファリングがフラッシュする前にワーカー Pod が強制排除された場合、ログは出力されません。ログなしでタスクが失敗する場合は、メモリ不足(OOM)により Airflow ワーカーが再起動されたことを示します。Airflow ログが出力されなかった場合でも、一部のログが Cloud Logging に存在することがあります。

ログを表示するには:

Google Cloud コンソールで、[環境] ページに移動します。

環境のリストで、ご利用の環境の名前をクリックします。[環境の詳細] ページが開きます。

[ログ] タブに移動します。

[すべてのログ] > [Airflow ログ] > [ワーカー] で個々の Airflow ワーカーのログを表示します。

症状:

Google Cloud コンソールで、[ワークロード] ページに移動します。

Evictedを示すairflow-workerPod が存在する場合は、強制排除された各 Pod をクリックして、ウィンドウ上部のThe node was low on resource: memoryメッセージを確認します。

解決方法:

Airflow ワーカーのメモリ上限を増やします。

強制排除の考えられる原因について、

airflow-workerPod のログを確認します。個別の Pod からログを取得する際の詳細については、デプロイされたワークロードの問題のトラブルシューティングをご覧ください。DAG 内のタスクがべき等で再試行可能であることを確認します。

Airflow ワーカーのローカル ファイル システムに不要なファイルをダウンロードしないようにします。

Airflow ワーカーのローカル ファイル システムの容量には上限があります。 Airflow ワーカーは 1 GB~10 GB のストレージを使用できます。保存容量が不足すると、Airflow ワーカー Pod は GKE コントロール プレーンによって強制排除されます。これによって、強制排除されたワーカーが実行していたすべてのタスクが失敗します。

問題のあるオペレーションの例:

- ファイルまたはオブジェクトをダウンロードして、Airflow ワーカーにローカルに保存する。代わりに、これらのオブジェクトを Cloud Storage バケットなどの適切なサービスに直接保存する。

- Airflow ワーカーからの

/dataフォルダ内の大きなオブジェクトへアクセスする。 Airflow ワーカーがオブジェクトをローカル ファイル システムにダウンロードする。 代わりに、DAG を実装して、大きなファイルが Airflow ワーカー Pod の外部で処理されるようにする。

一般的な根本原因

Airflow ワーカーのメモリ不足

各 Airflow ワーカーは、最大 [celery]worker_concurrency 個のタスク インスタンスを同時に実行できます。これらのタスク インスタンスの累積メモリ使用量が Airflow ワーカーのメモリ上限を超えると、ワーカー上のランダムなプロセスが終了し、リソースが解放されます。

Airflow ワーカーのメモリ不足イベントを検出する

resource.type="k8s_node"

resource.labels.cluster_name="GKE_CLUSTER_NAME"

log_id("events")

jsonPayload.message:"Killed process"

jsonPayload.message:("airflow task" OR "celeryd")Airflow ワーカーのメモリ不足が原因で、SQL Alchemy セッション中にデータベース、DNS サーバー、または DAG によって呼び出される他のサービスに不正な形式のパケットが送信されることがあります。この場合、接続のもう一方の端で、Airflow ワーカーからの接続が拒否またはドロップされる可能性があります。次に例を示します。

"UNKNOWN:Error received from peer

{created_time:"2024-11-31T10:09:52.217738071+00:00", grpc_status:14,

grpc_message:"failed to connect to all addresses; last error: UNKNOWN:

ipv4:<ip address>:443: handshaker shutdown"}"

解決策:

たとえば、トップレベル コードを避けることで、使用するメモリを少なくするようタスクを最適化します。

減少

[celery]worker_concurrency。[celery]worker_concurrencyの変更に対応するため、Airflow ワーカーのメモリを増やします。2.6.0 より前のバージョンの Cloud Composer 2 では、この値が小さい場合は現在の数式を使用して

[celery]worker_concurrencyを更新します。

Airflow ワーカーが強制排除された

Pod の強制排除は、Kubernetes でワークロードを実行するうえで通常行われることです。GKE は、ストレージが不足した場合や、優先度の高いワークロード用にリソースを解放する場合に Pod を強制排除します。

Airflow ワーカーの強制排除を検出する

resource.type="k8s_pod"

resource.labels.cluster_name="GKE_CLUSTER_NAME"

resource.labels.pod_name:"airflow-worker"

log_id("events")

jsonPayload.reason="Evicted"解決策:

- ストレージ不足が原因で強制排除が発生した場合は、ストレージ使用量を削減するか、一時ファイルが不要になったらすぐに削除することができます。または、使用可能なストレージを増やすか、

KubernetesPodOperatorを使用して専用の Pod でワークロードを実行することもできます。

Airflow ワーカーが終了した

Airflow ワーカーが外部要因で削除される可能性があります。現在実行中のタスクが正常な終了期間内に完了しなかった場合、タスクは中断され、ゾンビとして検出される可能性があります。

Airflow ワーカー Pod の終了を検出する

resource.type="k8s_cluster" resource.labels.cluster_name="GKE_CLUSTER_NAME" protoPayload.methodName:"pods.delete" protoPayload.response.metadata.name:"airflow-worker"

考えられるシナリオと解決策:

Airflow ワーカーは、アップグレードやパッケージのインストールなどの環境の変更中に再起動されます。

Composer 環境の変更を検出する

resource.type="cloud_composer_environment" resource.labels.environment_name="ENVIRONMENT_NAME" log_id("cloudaudit.googleapis.com%2Factivity")このようなオペレーションは、重要なタスクが実行されていないときに行います。またはタスクの再試行を有効にします。

メンテナンス オペレーション中は、さまざまなコンポーネントが一時的に使用できなくなることがあります。

GKE メンテナンス オペレーションを検出する

resource.type="gke_nodepool" resource.labels.cluster_name="GKE_CLUSTER_NAME" protoPayload.metadata.operationType="UPGRADE_NODES"

重要なタスク実行との重複を最小限に抑えることができます。

Cloud Composer 2 バージョン 2.4.5 より前では、終了する Airflow ワーカーが SIGTERM シグナルを無視し、タスクの実行を続行することがあります。

Composer 自動スケーリングによるスケールダウンを検出する

resource.type="cloud_composer_environment" resource.labels.environment_name="ENVIRONMENT_NAME" log_id("airflow-worker-set") textPayload:"Workers deleted"この問題が修正されている Cloud Composer の新しいバージョンにアップグレードできます。

Airflow ワーカーに大きな負荷がかかっていた

Airflow ワーカーで使用できる CPU リソースとメモリリソースの量は、環境の構成によって制限されます。リソース使用率が上限に近づくと、リソース競合が発生し、タスクの実行中に不要な遅延が発生する可能性があります。極端な状況では、長期間リソースが不足すると、ゾンビタスクが発生する可能性があります。

解決策:

- ワーカーの CPU とメモリ使用量をモニタリングし、80% を超えないように調整します。

Pod の再起動または強制排除の理由を特定する Cloud Logging クエリ

Cloud Composer の環境では、コンピューティング インフラストラクチャ レイヤとして GKE クラスタが使用されます。このセクションでは、Airflow ワーカーや Airflow スケジューラの再起動、強制排除の原因を特定することに役立つクエリについて説明します。

以下に示すクエリは、次のように調整できます。

Cloud Logging で必要なタイムラインを指定できます。たとえば、過去 6 時間、3 日、またはカスタム期間を定義できます。

CLUSTER_NAME に環境のクラスタの名前を指定する必要があります。

POD_NAME を追加して、検索を特定の Pod に限定することもできます。

再起動されたコンテナを検出する

resource.type="k8s_node"

log_id("kubelet")

jsonPayload.MESSAGE:"will be restarted"

resource.labels.cluster_name="CLUSTER_NAME"

結果を特定の Pod に限定する代替クエリ:

resource.type="k8s_node"

log_id("kubelet")

jsonPayload.MESSAGE:"will be restarted"

resource.labels.cluster_name="CLUSTER_NAME"

"POD_NAME"

メモリ不足イベントの結果としてのコンテナのシャットダウンを検出する

resource.type="k8s_node"

log_id("events")

(jsonPayload.reason:("OOMKilling" OR "SystemOOM")

OR jsonPayload.message:("OOM encountered" OR "out of memory"))

severity=WARNING

resource.labels.cluster_name="CLUSTER_NAME"

結果を特定の Pod に限定する代替クエリ:

resource.type="k8s_node"

log_id("events")

(jsonPayload.reason:("OOMKilling" OR "SystemOOM")

OR jsonPayload.message:("OOM encountered" OR "out of memory"))

severity=WARNING

resource.labels.cluster_name="CLUSTER_NAME"

"POD_NAME"

実行を停止したコンテナを検出する

resource.type="k8s_node"

log_id("kubelet")

jsonPayload.MESSAGE:"ContainerDied"

severity=DEFAULT

resource.labels.cluster_name="CLUSTER_NAME"

結果を特定の Pod に限定する代替クエリ:

resource.type="k8s_node"

log_id("kubelet")

jsonPayload.MESSAGE:"ContainerDied"

severity=DEFAULT

resource.labels.cluster_name="CLUSTER_NAME"

"POD_NAME"

Airflow データベースに大きな負荷がかかっていた

データベースは、さまざまな Airflow コンポーネントが相互に通信するために使用されます。特に、タスク インスタンスのハートビートを保存するために使用されます。データベースのリソース不足により、クエリ時間が長くなり、タスクの実行に影響する可能性があります。

Airflow ワーカーのログに次のエラーが表示されることがあります。

(psycopg2.OperationalError) connection to server at <IP address>,

port 3306 failed: server closed the connection unexpectedly

This probably means the server terminated abnormally before or while

processing the request.

解決策:

- トップレベルの DAG コードで

Variables.get指示を大量に使用しないでください。代わりに、Jinja テンプレートを使用して Airflow 変数の値を取得します。 - トップレベルの DAG コードの Jinja テンプレートで xcom_push 指示と xcom_pull 指示の使用を最適化(削減)します。

- より大きな環境サイズ(中または大)へのアップグレードを検討してください。

- スケジューラの数を減らします。

- DAG 解析の頻度を下げる。

- データベースの CPU とメモリ使用量をモニタリングします。

Airflow データベースが一時的に利用できなくなった

Airflow ワーカーは、一時的な接続の問題などの断続的なエラーを検出して正常に処理するまでに時間がかかる場合があります。デフォルトのゾンビ検出しきい値を超える可能性があります。

Airflow ハートビートのタイムアウトを検出する

resource.type="cloud_composer_environment"

resource.labels.environment_name="ENVIRONMENT_NAME"

log_id("airflow-worker")

textPayload:"Heartbeat time limit exceeded"解決策:

ゾンビタスクのタイムアウトを増やし、

[scheduler]scheduler_zombie_task_thresholdAirflow 構成オプションの値をオーバーライドします。セクション キー 値 備考 schedulerscheduler_zombie_task_threshold新しいタイムアウト(秒単位) デフォルト値は 300です

実行中にエラーが発生したため、タスクが失敗する

インスタンスを終了しています

Airflow は、終了インスタンスメカニズムを使用して Airflow タスクをシャットダウンします。このメカニズムは、次のような状況で使用されます。

- スケジューラが時間内に完了しなかったタスクを終了するとき。

- タスクがタイムアウトした場合や、実行時間が長すぎる場合。

Airflow がタスク インスタンスを終了すると、タスクを実行した Airflow ワーカーのログに次のログエントリが表示されます。

INFO - Subtask ... WARNING - State of this instance has been externally set

to success. Terminating instance.

INFO - Subtask ... INFO - Sending Signals.SIGTERM to GPID <X>

INFO - Subtask ... ERROR - Received SIGTERM. Terminating subprocesses.

解決策の提示

実行に時間がかかりすぎる原因となるエラーがないか、タスクコードを確認します。

タスクをより迅速に実行できるように、Airflow ワーカーの CPU とメモリを増やします。

[celery_broker_transport_options]visibility_timeoutAirflow 構成オプションの値を増やします。その結果、スケジューラはタスクの完了を待機してから、そのタスクをゾンビタスクとみなします。このオプションは、何時間もかかる作業に特に便利です。値が低すぎる場合(3 時間など)、スケジューラは 5~6 時間実行されたタスクを「ハングした」(ゾンビタスク)と見なします。

[core]killed_task_cleanup_timeAirflow 構成オプションの値を増やします。値を大きくすると、Airflow ワーカーはタスクを正常に完了するまでの時間が長くなります。値が小さすぎると、Airflow タスクが突然中断され、作業を正常に完了するのに十分な時間がありません。

DAG 実行が想定時間内に終了しない

症状:

Airflow タスクが停止し、DAG 実行が想定より長く続くため、DAG 実行が終了しないことがあります。通常の条件下では、Airflow のキューまたは実行状態が無期限に続くことはありません。これは、Airflow にはこの状況を回避するためのタイムアウトとクリーンアップ手順があるためです。

修正:

DAG には

dagrun_timeoutパラメータを使用します。例:dagrun_timeout=timedelta(minutes=120)したがって、各 DAG 実行は DAG 実行タイムアウト内に終了する必要があります。Airflow タスクの状態の詳細については、Apache Airflow のドキュメントをご覧ください。タスク実行タイムアウト パラメータを使用して、Apache Airflow 演算子に基づいて実行されるタスクのデフォルトのタイムアウトを定義します。

クエリ例外中に失われた Postgres サーバーへの接続は、タスク実行中またはその直後にスルーされます。

Lost connection to Postgres server during query 例外は、次の条件に該当する場合に頻繁に発生します。

- DAG で

PythonOperatorまたはカスタム演算子が使用されます。 - DAG で Airflow データベースにクエリが行われます。

呼び出し可能な関数から複数のクエリが行われた場合、トレースバックによって Airflow コードの self.refresh_from_db(lock_for_update=True) 行が誤って指し示されることがあります。これがタスク実行後の最初のデータベース クエリです。これ以前に例外の実際の原因が生じるのは、SQLAlchemy セッションが適切に終了していない場合です。

SQLAlchemy セッションはスレッドを対象としており、呼び出し可能な関数セッションで作成され、後で Airflow コード内で継続できます。1 つのセッション内のクエリ間で大幅な遅延が発生している場合は、Postgres サーバーによって接続がすでに閉じられている可能性があります。Cloud Composer 環境の接続タイムアウトは約 10 分に設定されています。

解決方法:

airflow.utils.db.provide_sessionデコレータを使用します。このデコレータは、sessionパラメータで Airflow データベースへの有効なセッションを提供し、関数の最後でセッションが正しく終了します。- 単一の長時間実行関数を使用しないでください。代わりに、すべてのデータベース クエリを別々の関数に移動し、

airflow.utils.db.provide_sessionデコレータを持つ複数の関数が存在するようにします。この場合、セッションはクエリ結果を取得した後に自動的に終了します。

Airflow メタデータ DB への接続時の一時的な中断

Cloud Composer は分散インフラストラクチャ上で動作します。つまり、一時的な問題によって Airflow タスクの実行が中断される場合があります。

この場合、Airflow ワーカーのログに次のエラー メッセージが表示されることがあります。

"Can't connect to Postgres server on 'airflow-sqlproxy-service.default.svc.cluster.local' (111)"

または

"Can't connect to Postgres server on 'airflow-sqlproxy-service.default.svc.cluster.local' (104)"

このような断続的な問題は、Cloud Composer 環境に対して実施されるメンテナンス オペレーションによっても発生する可能性もあります。

通常、このようなエラーは断続的に発生し、Airflow タスクがべき等で、再試行が構成されている場合は影響を受けません。メンテナンスの時間枠を定義することも検討してください。

このようなエラーが発生するもう 1 つの理由は、環境のクラスタにリソースがないことが挙げられます。そのような場合は、環境のスケーリングまたは環境の最適化の説明に沿って、環境をスケールアップまたは最適化できます。

DAG 実行が成功とマークされているものの、実行されたタスクがない

DAG 実行 execution_date が DAG の start_date よりも前に行われる場合、タスクは実行されていないものの、成功としてマークされている DAG 実行が表示される場合があります。

原因

この状況は、次のいずれかの場合で発生する可能性があります。

DAG の

execution_dateとstart_dateのタイムゾーンの違いにより不一致が発生している。たとえば、pendulum.parse(...)を使用してstart_dateを設定すると、そのようになる場合があります。DAG の

start_dateが動的な値(例:airflow.utils.dates.days_ago(1))に設定されている

解決策

execution_dateとstart_dateで同じタイムゾーンを使用していることを確認します。過去の開始日で DAG が実行されないようにするため、静的な

start_dateを指定し、catchup=Falseと合わせて使用します。

ベスト プラクティス

更新またはアップグレード オペレーションが Airflow タスクの実行に及ぼす影響

更新またはアップグレード オペレーションは、タスクが遅延モードで実行されている場合を除き、現在実行中の Airflow タスクを中断します。

Airflow タスクの実行への影響が最小限に抑えられることが予想される場合にこれらのオペレーションを実行して、DAG とタスクに適切な再試行メカニズムを設定することをおすすめします。

プログラムで生成された DAG を同時にスケジュールしないでください

DAG ファイルからプログラムで DAG オブジェクトを生成することは、わずかな違いしかない多くの類似の DAG を作成する効率的な方法です。

このような DAG のすべてをすぐには実行しないようにスケジュールすることが重要です。同時にスケジュールされているすべてのタスクを実行するのに十分な CPU とメモリリソースが Airflow ワーカーにない可能性があります。

プログラマティック DAG のスケジューリングの問題を回避するには:

- ワーカーの同時実行を増やし、環境をスケールアップして、より多くのタスクを同時に実行できるようにします。

- スケジュールを時間の経過とともに均等に分散する方法で DAG を生成し、数百のタスクを同時にスケジュールしないようにします。これにより、Airflow ワーカーはすべてのスケジュールされたタスクを実行する時間が得られます。

同じ DAG の DAG、タスク、並列実行の実行時間の管理

特定の DAG に対する単一の DAG 実行時間を制御する場合は、dagrun_timeout DAG パラメータを使用します。たとえば、単一の DAG 実行(実行が失敗したか失敗したかは問わない)が 1 時間を超えないようにする必要がある場合は、このパラメータを 3,600 秒に設定します。

1 つの Airflow タスクの実行時間を制御することもできます。これを行うには execution_timeout を使用できます。

特定の DAG に対して実行するアクティブな DAG 実行の数を制御する場合は、[core]max-active-runs-per-dag Airflow 構成オプションを使用します。

特定の時点で DAG のインスタンスを 1 つしか実行しない場合は、max-active-runs-per-dag パラメータを 1 に設定します。

Airflow データベースとのネットワーク トラフィックの増加を回避する

環境の GKE クラスタと Airflow データベース間のトラフィック ネットワークの量は、DAG の数、DAG 内のタスクの数、DAG が Airflow データベースのデータにアクセスする方法によって異なります。ネットワーク使用量に影響する要因は次のとおりです。

Airflow データベースに対するクエリ。DAG で多くのクエリを実行すると、大量のトラフィックが発生します。例: 他のタスクに進む前にタスクのステータスを確認する、XCom テーブルに対してクエリを実行する、Airflow データベース コンテンツをダンプする。

多数のタスク。スケジュールするタスクが多いほど、生成されるネットワーク トラフィックは多くなります。この考慮事項は、DAG のタスクの合計数とスケジュール設定頻度の両方に適用されます。Airflow スケジューラが DAG の実行をスケジュールすると、Airflow データベースにクエリが実行され、トラフィックが生成されます。

Airflow ウェブ インターフェースによって、Airflow データベースにクエリが行われるので、ネットワーク トラフィックが生成されます。グラフ、タスク、図を含むページを集中的に使用すると、大量のネットワーク トラフィックが生成されます。