Sobald Sie ein Modell erstellt (trainiert) und bereitgestellt haben, können Sie Online-Vorhersageanfragen (synchrone Anfragen) an dieses senden.

Beispiel für eine Onlinevorhersage (Einzelvorhersage)

Nachdem Sie Ihr trainiertes Modell bereitgestellt haben, können Sie mithilfe der Methode predict eine Vorhersage für ein Bild anfordern oder die Benutzeroberfläche zum Abrufen von Vorhersage-Annotationen verwenden. Die predict-Methode wendet Labels auf die Objektbegrenzungsrahmen in Ihrem Bild an.

Während der Bereitstellung fallen für das Modell Gebühren an. Nachdem Sie mit dem trainierten Modell Vorhersagen getroffen haben, können Sie dessen Bereitstellung aufheben, wenn Sie weitere Gebühren für das Modellhosting vermeiden möchten.

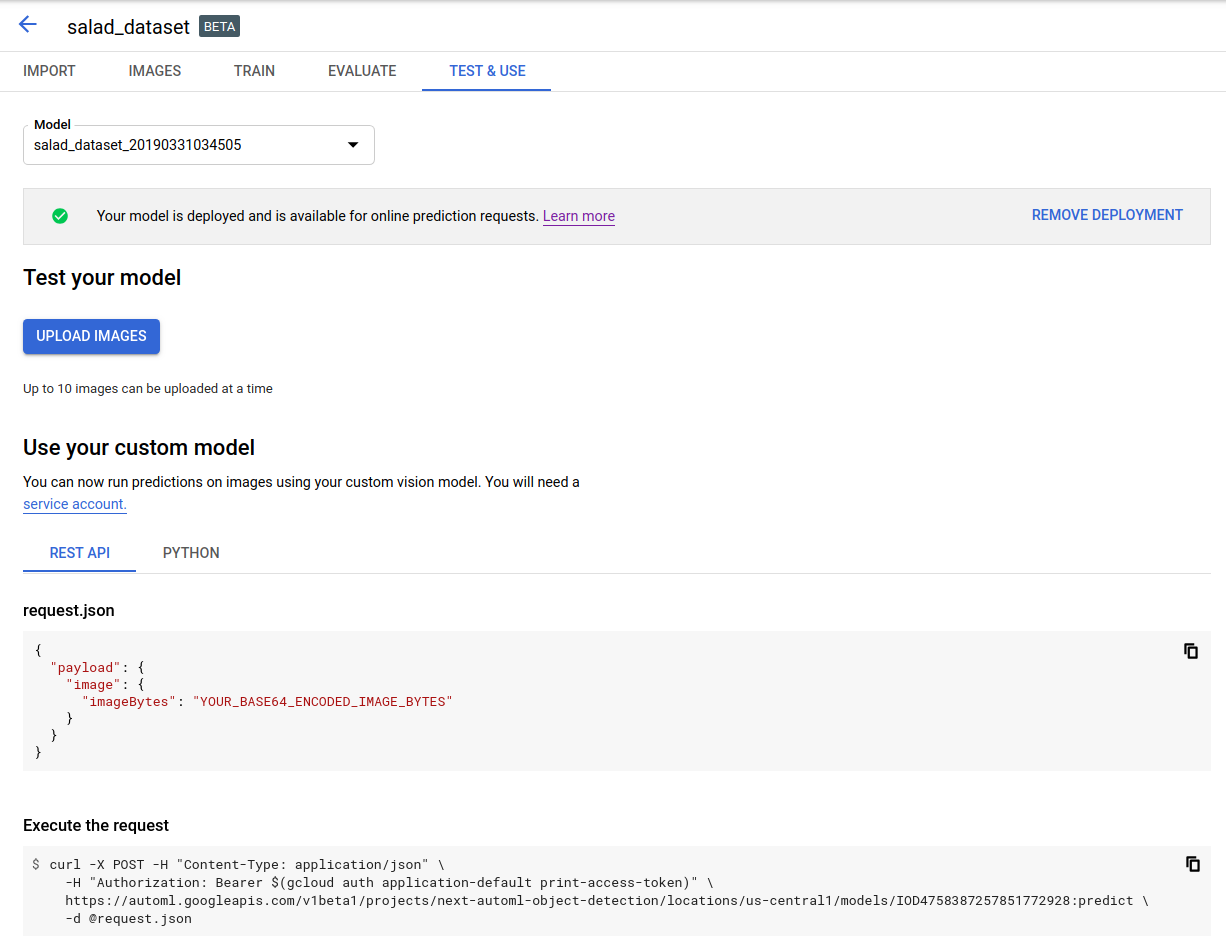

Web-UI

Öffnen Sie die AutoML Vision-Benutzeroberfläche für die Objekterkennung und klicken Sie in der linken Navigationsleiste auf den Tab Modelle mit dem Glühbirnensymbol, um die verfügbaren Modelle aufzurufen.

Wenn Sie die Modelle für ein anderes Projekt ansehen möchten, wählen Sie das Projekt in der Dropdown-Liste rechts oben in der Titelleiste aus.

Klicken Sie auf die Zeile für das Modell, das Sie verwenden möchten, um die Bilder mit Labels zu versehen.

Wenn Ihr Modell noch nicht bereitgestellt wurde, klicken Sie jetzt auf Modell bereitstellen.

Das Modell muss bereitgestellt werden, um Onlinevorhersagen verwenden zu können. Für das Bereitstellen des Modells fallen Gebühren an. Weitere Informationen finden Sie in der Preisübersicht.

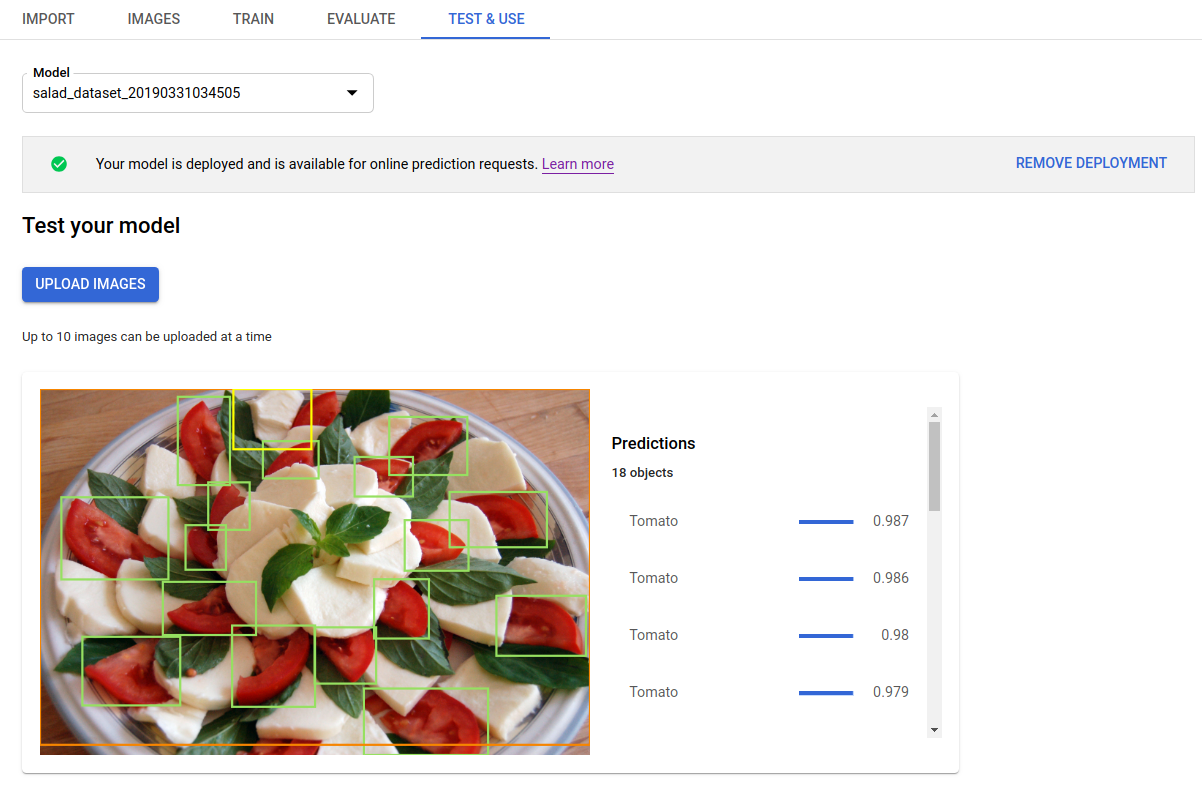

Klicken Sie auf den Tab Testen und verwenden direkt unter der Titelleiste.

Klicken Sie auf Bilder hochladen, um die Bilder hochzuladen, die Sie mit Labels versehen möchten.

REST

Damit Sie die Vorhersage testen können, müssen Sie zuerst Ihr in der Cloud gehostetes Modell bereitstellen.

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- project-id: die ID Ihres GCP-Projekts.

- model-id: die ID Ihres Modells aus der Antwort beim Erstellen des Modells. Sie ist das letzte Element des Modellnamens.

Beispiel:

- Modellname:

projects/project-id/locations/location-id/models/IOD4412217016962778756 - model id:

IOD4412217016962778756

- Modellname:

- base64-encoded-image: die Base64-Darstellung (ASCII-String) der Binärbilddaten. Dieser String sollte in etwa so aussehen:

/9j/4QAYRXhpZgAA...9tAVx/zDQDlGxn//2Q==. Weitere Informationen erhalten Sie unter Base64-Codierung.

Feldspezifische Hinweise:

scoreThreshold: ein Wert zwischen 0 und 1. Es werden nur Werte mit Konfidenzwert-Schwellenwerten von mindestens diesem Wert angezeigt. Der Standardwert ist 0,5.maxBoundingBoxCount: die Höchstzahl (Obergrenze) von Begrenzungsrahmen, die in einer Antwort zurückgegeben werden sollen. Der Standardwert ist 100 und der Höchstwert ist 500. Dieser Wert unterliegt Ressourcenlimits und kann durch den Server beschränkt sein.

HTTP-Methode und URL:

POST https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID:predict

JSON-Text der Anfrage:

{

"payload": {

"image": {

"imageBytes": "BASE64_ENCODED_IMAGE"

}

},

"params": {

"scoreThreshold": "0.5",

"maxBoundingBoxCount": "100"

}

}

Wenn Sie die Anfrage senden möchten, wählen Sie eine der folgenden Optionen aus:

curl

Speichern Sie den Anfragetext in einer Datei mit dem Namen request.json und führen Sie den folgenden Befehl aus:

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID:predict"

PowerShell

Speichern Sie den Anfragetext in einer Datei mit dem Namen request.json und führen Sie den folgenden Befehl aus:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID:predict" | Select-Object -Expand Content

Die Ausgabe wird im JSON-Format zurückgegeben. Die Vorhersagen aus dem AutoML Vision-Objekterkennungsmodell sind im Feld payload enthalten:

- Der

boundingBoxeines Objekts wird durch diagonal gegenüberliegende Eckpunkte angegeben. displayNameist das Label des Objekts, das vom AutoML Vision-Objekterkennungsmodell vorhergesagt wurde.scoresteht für das Konfidenzniveau, das das angegebene Label auf das Bild anwendet. Das Konfidenzniveau reicht von0(keine Konfidenz) bis1(hohe Konfidenz).

{

"payload": [

{

"imageObjectDetection": {

"boundingBox": {

"normalizedVertices": [

{

"x": 0.034553755,

"y": 0.015524037

},

{

"x": 0.941527,

"y": 0.9912563

}

]

},

"score": 0.9997793

},

"displayName": "Salad"

},

{

"imageObjectDetection": {

"boundingBox": {

"normalizedVertices": [

{

"x": 0.11737197,

"y": 0.7098793

},

{

"x": 0.510878,

"y": 0.87987

}

]

},

"score": 0.63219965

},

"displayName": "Tomato"

}

]

}

Go

Bevor Sie dieses Beispiel ausprobieren, folgen Sie der Einrichtungsanleitung für diese Sprache auf der Seite Clientbibliotheken.

Java

Bevor Sie dieses Beispiel ausprobieren, folgen Sie der Einrichtungsanleitung für diese Sprache auf der Seite Clientbibliotheken.

Node.js

Bevor Sie dieses Beispiel ausprobieren, folgen Sie der Einrichtungsanleitung für diese Sprache auf der Seite Clientbibliotheken.

Python

Bevor Sie dieses Beispiel ausprobieren, folgen Sie der Einrichtungsanleitung für diese Sprache auf der Seite Clientbibliotheken.

Weitere Sprachen

C#: Folgen Sie der Anleitung zur Einrichtung von C# auf der Seite der Clientbibliotheken und rufen Sie dann die Referenzdokumentation zur AutoML Vision-Objekterkennung für .NET auf.

PHP Folgen Sie der Anleitung zur Einrichtung von PHP auf der Seite der Clientbibliotheken und rufen Sie dann die Referenzdokumentation zur AutoML Vision-Objekterkennung für PHP auf.

Ruby: Folgen Sie der Anleitung zur Einrichtung von Ruby auf der Seite der Clientbibliotheken und rufen Sie dann die AutoML Vision Object Detection-Referenzdokumentation für Ruby auf.