Vous pouvez utiliser Vertex AI Studio pour concevoir, tester et gérer les requêtes pour les grands modèles de langage (LLM) Gemini de Google et les modèles tiers. Vertex AI Studio est compatible avec certains modèles tiers proposés sur Vertex AI en tant que modèles en tant que service (MaaS), tels que les modèles Anthropic Claude et les modèles Llama de Meta.

Dans le cadre de ce guide démarrage rapide, vous allez effectuer les étapes suivantes :

- Envoyez ces requêtes à l'API Gemini à l'aide d'exemples de la galerie de requêtes d'IA générative, y compris les suivants :

- Une requête textuelle de synthèse

- Une requête de génération de code

- Afficher le code utilisé pour générer les réponses

Avant de commencer à créer des requêtes dans Vertex AI Studio

Ce guide de démarrage rapide vous demande de suivre les étapes suivantes pour configurer un projetGoogle Cloud et activer l'API Vertex AI.

Pour obtenir les autorisations nécessaires pour effectuer les tâches de ce guide de démarrage rapide, demandez à votre administrateur de vous accorder les rôles IAM suivants sur votre projet :

- Pour activer l'API Vertex AI si elle ne l'est pas déjà : serviceusage.serviceUsageAdmin

- Pour exécuter des requêtes dans Vertex AI Studio :

Utilisateur Vertex AI (

roles/aiplatform.user)

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vertex AI API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vertex AI API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. Accédez à la page Galerie de requêtes depuis la section Vertex AI de la console Google Cloud .

Accéder à la galerie de requêtesDans le menu déroulant Tâches, sélectionnez Synthétiser.

Ouvrez la fiche Résumés audio.

Cet exemple de requête inclut un fichier audio et demande un résumé du contenu du fichier sous forme de liste à puces.

Notez que dans le panneau des paramètres, la valeur par défaut du modèle est définie sur Gemini-2.0-flash-001. Vous pouvez choisir un autre modèle Gemini en cliquant sur Changer de modèle.

Cliquez sur Envoyer pour générer le résumé.

Le résultat s'affiche dans la réponse.

Pour afficher le code de l'API Vertex AI utilisé pour générer le résumé de la transcription, cliquez sur Compiler avec du code > Obtenir le code.

Dans le panneau Obtenir le code, vous pouvez choisir la langue de votre choix pour obtenir l'exemple de code de la requête ou ouvrir le code Python dans un notebook Colab Enterprise.

Accédez à la page Galerie de requêtes depuis la section Vertex AI de la console Google Cloud .

Accéder à la galerie de requêtesDans le menu déroulant Tâches, sélectionnez Code.

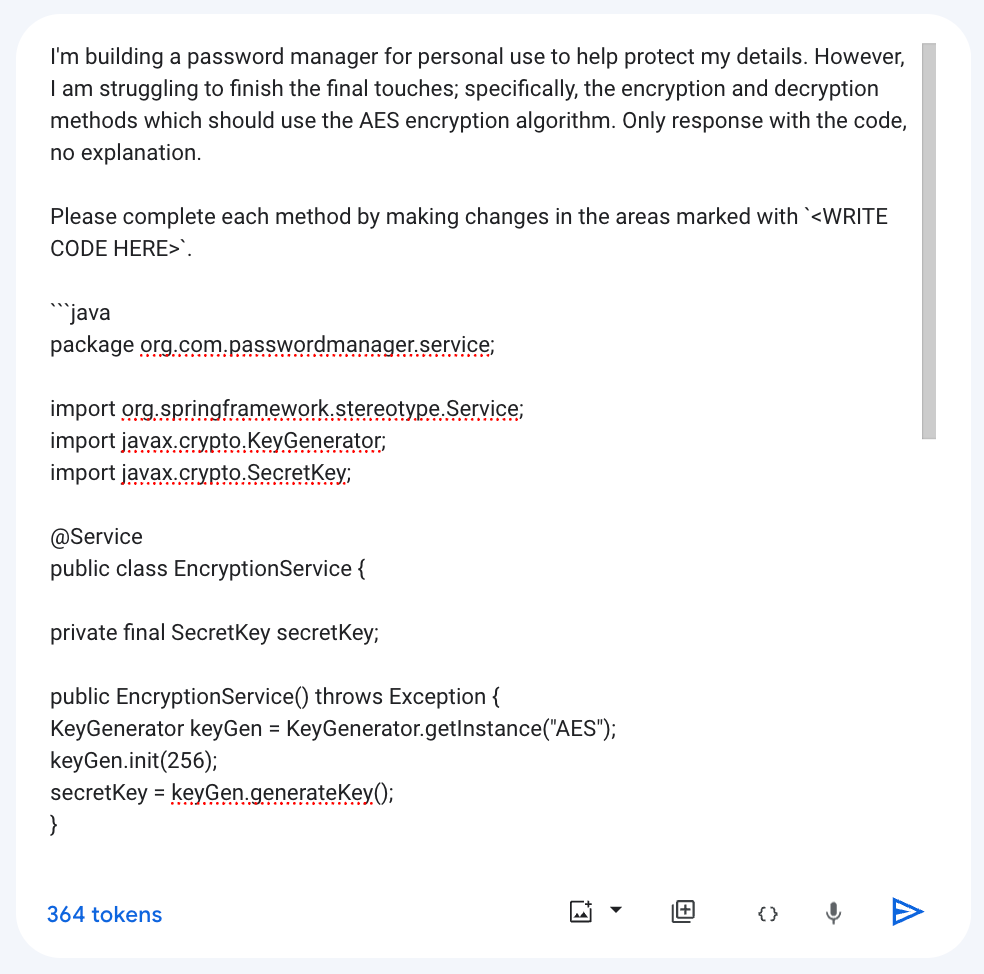

Ouvrez la fiche Générer du code à partir de commentaires.

Cet exemple de requête inclut une instruction système qui indique au modèle comment répondre, ainsi que des méthodes Java incomplètes.

Notez que dans le panneau des paramètres, la valeur par défaut du modèle est définie sur Gemini-2.0-flash-001. Vous pouvez choisir un autre modèle Gemini en cliquant sur Changer de modèle.

Pour compléter chaque méthode en générant du code dans les zones marquées

<WRITE CODE HERE>, cliquez sur Envoyer .Le résultat s'affiche dans la réponse.

Pour afficher le code de l'API Vertex AI utilisé pour générer le résumé de la transcription, cliquez sur Compiler avec du code > Obtenir le code.

Dans le panneau Obtenir le code, vous pouvez choisir la langue de votre choix pour obtenir l'exemple de code de la requête ou ouvrir le code Python dans un notebook Colab Enterprise.

- Pour en savoir plus sur les fonctionnalités de Vertex AI Studio, consultez Fonctionnalités de Vertex AI Studio.

- Consultez la présentation de la conception des requêtes.

- Découvrez comment concevoir des requêtes multimodales et des requêtes de chat.

Exemples de requêtes dans Vertex AI Studio

Une requête est une demande en langage naturel envoyée à un modèle de langage qui génère une réponse. Les requêtes peuvent contenir des questions, des instructions, des informations contextuelles, des exemples few-shot et des entrées partielles que le modèle doit terminer. Une fois que le modèle a reçu une requête, en fonction du type de modèle utilisé, il peut générer du texte, des embeddings, du code, des images, des vidéos, de la musique, etc.

Les exemples de requêtes de la galerie de requêtes de Vertex AI Studio sont préconçus pour illustrer les capacités des modèles. Chaque requête est préconfigurée avec un modèle et une valeur de paramètre spécifiés. Il vous suffit d'ouvrir l'exemple de requête et de cliquer sur Envoyer pour générer une réponse.

Tester le modèle Gemini Flash à l'aide d'une requête textuelle de synthèse

Envoyez une requête textuelle de synthèse à l'API Gemini dans Vertex AI. Une tâche de synthèse extrait les informations les plus importantes d'un texte. Vous pouvez fournir des informations dans la requête pour aider le modèle à créer un résumé ou demander au modèle de créer lui-même un résumé.

Tester le modèle Gemini Flash à l'aide d'une requête de génération de code

Envoyez une requête de génération de code à l'API Gemini dans Vertex AI. Une tâche de génération de code génère du code à l'aide d'une description en langage naturel.