Vertex AI Agent Engine, qui fait partie de la plate-forme Vertex AI, est un ensemble de services qui permet aux développeurs de déployer, de gérer et de faire évoluer des agents IA en production. Agent Engine gère l'infrastructure pour faire évoluer les agents en production, ce qui vous permet de vous concentrer sur la création d'applications. Vertex AI Agent Engine propose les services suivants, que vous pouvez utiliser individuellement ou en combinaison :

Environnement d'exécution :

- Déployez et mettez à l'échelle des agents avec un environnement d'exécution géré et des fonctionnalités de gestion de bout en bout.

- Personnalisez l'image de conteneur de l'agent avec des scripts d'installation au moment de la compilation pour les dépendances système.

- Utilisez des fonctionnalités de sécurité, y compris la conformité VPC-SC et la configuration de l'authentification et d'IAM.

- Accédez à des modèles et des outils tels que l'appel de fonction.

- Déployez des agents créés à l'aide de différents frameworks Python :

- Comprenez le comportement de l'agent avec Google Cloud Trace (compatible avec OpenTelemetry), Cloud Monitoring et Cloud Logging.

Qualité et évaluation (aperçu) : évaluez la qualité des agents avec le service d'évaluation de l'IA générative intégré et optimisez les agents avec les exécutions d'entraînement du modèle Gemini.

Example Store (aperçu) : stockez et récupérez dynamiquement des exemples few-shot pour améliorer les performances de l'agent.

Sessions (version preview) : les sessions Agent Engine vous permettent de stocker les interactions individuelles entre les utilisateurs et les agents, ce qui fournit des sources définitives pour le contexte de la conversation.

Banque de mémoire (version preview) : la banque de mémoire Agent Engine vous permet de stocker et de récupérer des informations à partir de sessions pour personnaliser les interactions avec l'agent.

Vertex AI Agent Engine fait partie de Vertex AI Agent Builder, une suite de fonctionnalités permettant de découvrir, de créer et de déployer des agents d'IA.

Créer et déployer sur Vertex AI Agent Engine

Remarque : Pour une expérience de développement et de déploiement basée sur un IDE simplifiée avec Vertex AI Agent Engine, envisagez d'utiliser le pack de démarrage d'agent. Il fournit des modèles prêts à l'emploi, une UI intégrée pour l'expérimentation et simplifie le déploiement, les opérations, l'évaluation, la personnalisation et l'observabilité.

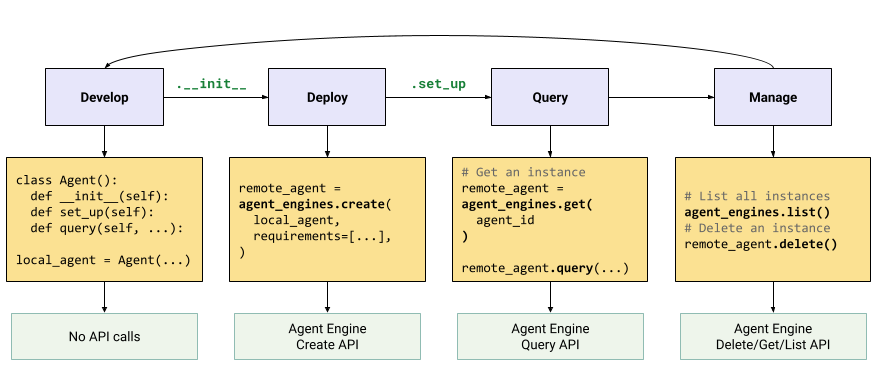

Le workflow pour créer un agent sur Vertex AI Agent Engine est le suivant :

| Étapes | Description |

|---|---|

| 1. Configurer l'environnement | Configurez votre projet Google et installez la dernière version du SDK Vertex AI pour Python. |

| 2. Développer un agent | Développer un agent pouvant être déployé sur Vertex AI Agent Engine. |

| 3. Déployer l'agent | Déployez l'agent sur l'environnement d'exécution géré Vertex AI Agent Engine. |

| 4. Utiliser l'agent | Interrogez l'agent en envoyant une requête API. |

| 5. Gérer l'agent déployé | Gérez et supprimez les agents que vous avez déployés sur Vertex AI Agent Engine. |

Les étapes sont illustrées dans le schéma suivant :

Frameworks compatibles

Le tableau suivant décrit le niveau de compatibilité de Vertex AI Agent Engine avec différents frameworks d'agents :

| Niveau d'assistance | Frameworks d'agent |

|---|---|

| Modèle personnalisé : vous pouvez adapter un modèle personnalisé pour prendre en charge le déploiement dans Vertex AI Agent Engine à partir de votre framework. | CrewAI, frameworks personnalisés |

| Intégration du SDK Vertex AI : Vertex AI Agent Engine fournit des modèles gérés par framework dans le SDK Vertex AI et la documentation. | AG2, LlamaIndex |

| Intégration complète : les fonctionnalités sont intégrées pour fonctionner dans le framework, Vertex AI Agent Engine et l'écosystème Google Cloud plus large. | Agent Development Kit (ADK), LangChain, LangGraph |

Déployer en production avec Agent Starter Pack

Le pack de démarrage d'agent est un ensemble de modèles d'agents d'IA générative prêts pour la production et conçus pour Vertex AI Agent Engine. Le pack de démarrage pour les agents fournit les éléments suivants :

- Modèles d'agents prédéfinis : ReAct, RAG, multi-agents et autres modèles.

- Playground interactif : testez votre agent et interagissez avec lui.

- Infrastructure automatisée : utilise Terraform pour une gestion simplifiée des ressources.

- Pipelines CI/CD : workflows de déploiement automatisés utilisant Cloud Build.

- Observabilité : compatibilité intégrée avec Cloud Trace et Cloud Logging.

Pour commencer, consultez le guide de démarrage rapide.

Cas d'utilisation

Pour en savoir plus sur Vertex AI Agent Engine avec des exemples de bout en bout, consultez les ressources suivantes :

| Cas d'utilisation | Description | Liens |

|---|---|---|

| Créer des agents en se connectant à des API publiques | Convertissez des devises. Créez une fonction qui se connecte à une application de change de devises pour permettre au modèle de fournir des réponses précises à des requêtes telles que "Quel est le taux de change de l'euro par rapport au dollar aujourd'hui ?" |

Notebook SDK Vertex AI pour Python : présentation de la création et du déploiement d'un agent avec Vertex AI Agent Engine |

| Concevoir un projet d'énergie solaire communautaire. Identifiez des emplacements potentiels, recherchez les fournisseurs et les organismes gouvernementaux concernés, et examinez les images satellite et le potentiel solaire des régions et des bâtiments pour trouver l'emplacement optimal pour installer vos panneaux solaires. |

Notebook du SDK Vertex AI pour Python : créer et déployer un agent de l'API Google Maps avec Vertex AI Agent Engine | |

| Créer des agents en se connectant à des bases de données | Intégration à AlloyDB et Cloud SQL pour PostgreSQL. | Article de blog : annonce de LangChain sur Vertex AI pour AlloyDB et Cloud SQL pour PostgreSQL Notebook SDK Vertex AI pour Python : déployer une application RAG avec Cloud SQL pour PostgreSQL sur Vertex AI Agent Engine Notebook SDK Vertex AI pour Python : déployer une application RAG avec AlloyDB pour PostgreSQL sur Vertex AI Agent Engine |

| Créez des agents avec des outils qui accèdent aux données de votre base de données. | Notebook SDK Vertex AI pour Python : déployer un agent avec Vertex AI Agent Engine et la boîte à outils MCP pour les bases de données | |

| Interroger et comprendre des data stores structurés en langage naturel. | Notebook SDK Vertex AI pour Python : créer un agent de recherche conversationnel avec Vertex AI Agent Engine et le RAG dans Vertex AI Search | |

| Interroger et comprendre des bases de données orientées graphe en langage naturel | Article de blog : GraphRAG GenAI et agents d'IA utilisant Vertex AI Agent Engine avec LangChain et Neo4j | |

| Interroger et comprendre des magasins de vecteurs en langage naturel | Article de blog : Simplifier le RAG GenAI avec MongoDB Atlas et Vertex AI Agent Engine | |

| Créer des agents avec Agent Development Kit (preview) | Créez et déployez des agents à l'aide d'Agent Development Kit. | Agent Development Kit : déployer sur Vertex AI Agent Engine |

| Gérez le contexte avec les sessions Vertex AI Agent Engine et la banque de mémoire en mode Express Vertex AI sans facturation. | Kit de développement d'agents : sessions Vertex AI Agent Engine et banque de mémoire en mode Express Vertex AI | |

| Créer des agents avec des frameworks OSS | Créez et déployez des agents à l'aide du framework Open Source Onetwo. | Article de blog : OneTwo et Vertex AI Agent Engine : explorer le développement d'agents d'IA avancée sur Google Cloud |

| Créer et déployer des agents à l'aide du framework Open Source LangGraph. | Notebook SDK Vertex AI pour Python : créer et déployer une application LangGraph avec Vertex AI Agent Engine | |

| Déboguer et optimiser les agents | Créer et tracer des agents à l'aide d'OpenTelemetry et de Cloud Trace | Notebook SDK Vertex AI pour Python : débogage et optimisation des agents : guide de traçage dans Vertex AI Agent Engine |

Sécurité d'entreprise

Vertex AI Agent Engine propose plusieurs fonctionnalités pour vous aider à répondre aux exigences de sécurité des entreprises, à respecter les règles de sécurité de votre organisation et à suivre les bonnes pratiques de sécurité. Les fonctionnalités suivantes sont disponibles :

Clés de chiffrement gérées par le client (CMEK) : Vertex AI Agent Engine est compatible avec les CMEK pour protéger vos données avec vos propres clés de chiffrement. Vous possédez ainsi les clés qui protègent vos données au repos dans Google Cloudet les contrôlez entièrement. Pour en savoir plus, consultez CMEK Agent Engine.

VPC Service Controls : Vertex AI Agent Engine est compatible avec VPC Service Controls pour renforcer la sécurité des données et limiter les risques d'exfiltration de données. Lorsque VPC Service Controls est configuré, l'agent déployé conserve un accès sécurisé aux API et services Google, tels que les API BigQuery, API Cloud SQL Admin et Vertex AI, ce qui garantit un fonctionnement fluide dans le périmètre que vous avez défini. De manière critique, VPC Service Controls bloque efficacement tout accès à l'Internet public, limitant le transfert de données aux limites de votre réseau autorisé et améliorant considérablement la sécurité de votre entreprise.

Interface Private Service Connect (PSC-I) : permet à vos agents d'interagir avec des services hébergés de manière privée dans le VPC de l'utilisateur. Pour en savoir plus, consultez Configurer l'interface VPC Service Controls.

HIPAA : en tant que composant de la plate-forme Vertex AI, Vertex AI Agent Engine est compatible avec les charges de travail HIPAA.

Régions où le service est disponible

Vertex AI Agent Engine est disponible dans les régions suivantes :

| Région | Emplacement | Versions compatibles |

|---|---|---|

us-central1 |

Iowa | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

us-east4 |

Virginie du Nord | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

us-west1 |

Oregon | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

europe-west1 |

Belgique | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

europe-west2 |

Londres | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

europe-west3 |

Francfort | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

europe-west4 |

Pays-Bas | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

europe-southwest1 |

Madrid | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

asia-east1 |

Taïwan | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

asia-northeast1 |

Tokyo | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

asia-south1 |

Mumbai | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

asia-southeast1 |

Singapour | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

australia-southeast2 |

Melbourne | v1 est compatible avec les fonctionnalités en disponibilité générale. v1beta1 est compatible avec les fonctionnalités en version preview. |

Pour la mémoire Agent Engine (aperçu), les régions suivantes sont acceptées :

| Région | Emplacement | Versions compatibles |

|---|---|---|

us-central1 |

Iowa | La version v1beta1 est compatible. |

us-east4 |

Virginie du Nord | La version v1beta1 est compatible. |

us-west1 |

Oregon | La version v1beta1 est compatible. |

europe-west1 |

Belgique | La version v1beta1 est compatible. |

europe-west4 |

Pays-Bas | La version v1beta1 est compatible. |

europe-southwest1 |

Madrid | La version v1beta1 est compatible. |

Quota

Les limites suivantes s'appliquent à Vertex AI Agent Engine pour un projet donné dans chaque région :| Description | Limite |

|---|---|

| Créer, supprimer ou mettre à jour Vertex AI Agent Engine par minute | 10 |

| Créer, supprimer ou mettre à jour des sessions Vertex AI Agent Engine par minute | 100 |

Query ou StreamQuery Vertex AI Agent Engine par minute |

90 |

| Ajouter un événement aux sessions Vertex AI Agent Engine par minute | 300 |

| Nombre maximal de ressources Vertex AI Agent Engine | 100 |

| Créer, supprimer ou mettre à jour des ressources de mémoire Vertex AI Agent Engine par minute | 100 |

| Obtenir, lister ou récupérer des données depuis la banque de mémoire Vertex AI Agent Engine par minute | 300 |

Tarifs

La tarification d'Agent Engine Runtime est basée sur le calcul (heures de processeur virtuel) et la mémoire (heures de Gio) utilisés par votre agent pour traiter les requêtes. Aucuns frais ne sont facturés pour le temps d'inactivité d'un agent déployé.

| Produit | ID du SKU | Prix |

|---|---|---|

| vCPU ReasoningEngine | 8A55-0B95-B7DC | 0,0994 $/vCPU-H |

| Mémoire ReasoningEngine | 0B45-6103-6EC1 | 0,0105 $ par Gio/h |

Pour en savoir plus, reportez-vous à la page Tarifs.