Questa pagina descrive il supporto di più reti per i pod, inclusi casi d'uso, concetti, terminologia e vantaggi pertinenti.

Panoramica

Google Cloud supporta più interfacce di rete a livello di istanza di macchina virtuale (VM). Puoi connettere una VM a un massimo di otto reti con più interfacce di rete, inclusa la rete predefinita più sette reti aggiuntive.

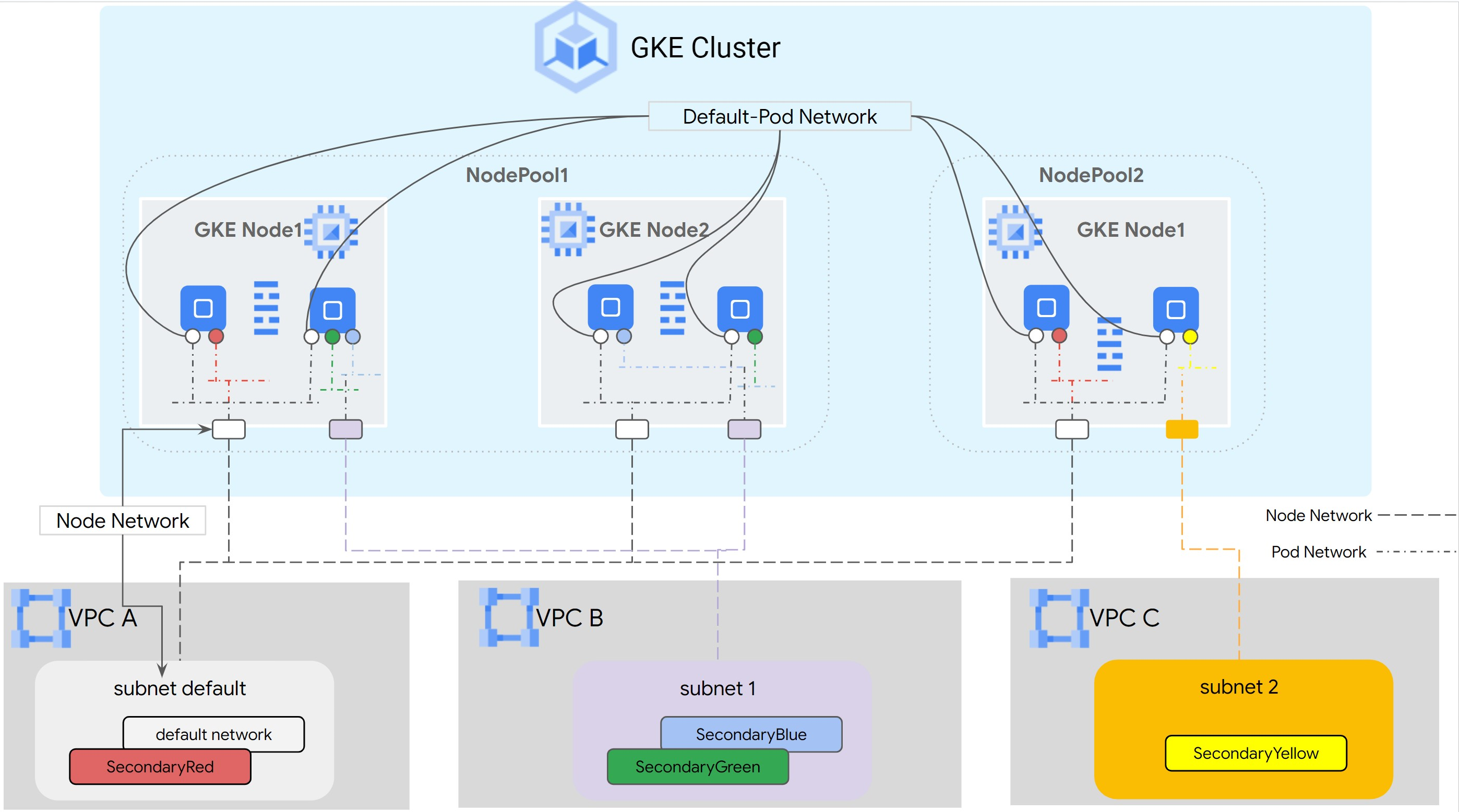

Il networking di Google Kubernetes Engine (GKE) estende le funzionalità di networking multiplo ai pod eseguiti sui nodi. Con il supporto di più reti per i pod, puoi abilitare più interfacce su nodi e pod in un cluster GKE. Il supporto di più reti per i pod rimuove la limitazione della singola interfaccia per i pool di nodi, che limitava i nodi a un singolo VPC per il networking.

Network Function Optimizer (NFO) è un servizio di rete disponibile per GKE che fornisce supporto multi-rete, indirizzi IP permanenti e un piano dati ad alte prestazioni nativo di Kubernetes. NFO consente funzioni di rete containerizzate su GKE. Multi-network è uno dei pilastri fondamentali di NFO.

Per utilizzare il supporto di più reti per i pod e i nodi, consulta Configurare il supporto di più reti per i pod.

Terminologia e concetti

Questa pagina utilizza i seguenti concetti:

VPC principale: la VPC principale è una VPC preconfigurata con un insieme di impostazioni e risorse predefinite. Il cluster GKE viene creato in questo VPC. Se elimini il VPC preconfigurato, il cluster GKE viene creato nel VPC principale.

Subnet: in Google Cloud, una subnet è il modo per creare Classless Inter-Domain Routing (CIDR) con maschere di rete in un VPC. Una subnet ha un singolo intervallo di indirizzi IP primari assegnato ai nodi e può avere più intervalli secondari che possono appartenere a pod e servizi.

Node-network: node-network si riferisce a una combinazione dedicata di una coppia di rete VPC e subnet. All'interno di questa rete di nodi, ai nodi appartenenti al pool di nodi vengono allocati indirizzi IP dall'intervallo di indirizzi IP principale.

Intervallo secondario: un intervallo secondario Google Cloud è un CIDR e una maschera di rete appartenenti a una subnet. GKE lo utilizza come rete di pod di livello 3. Un pod può connettersi a più reti di pod.

Pod-network: un oggetto di rete che funge da punto di connessione per i pod.

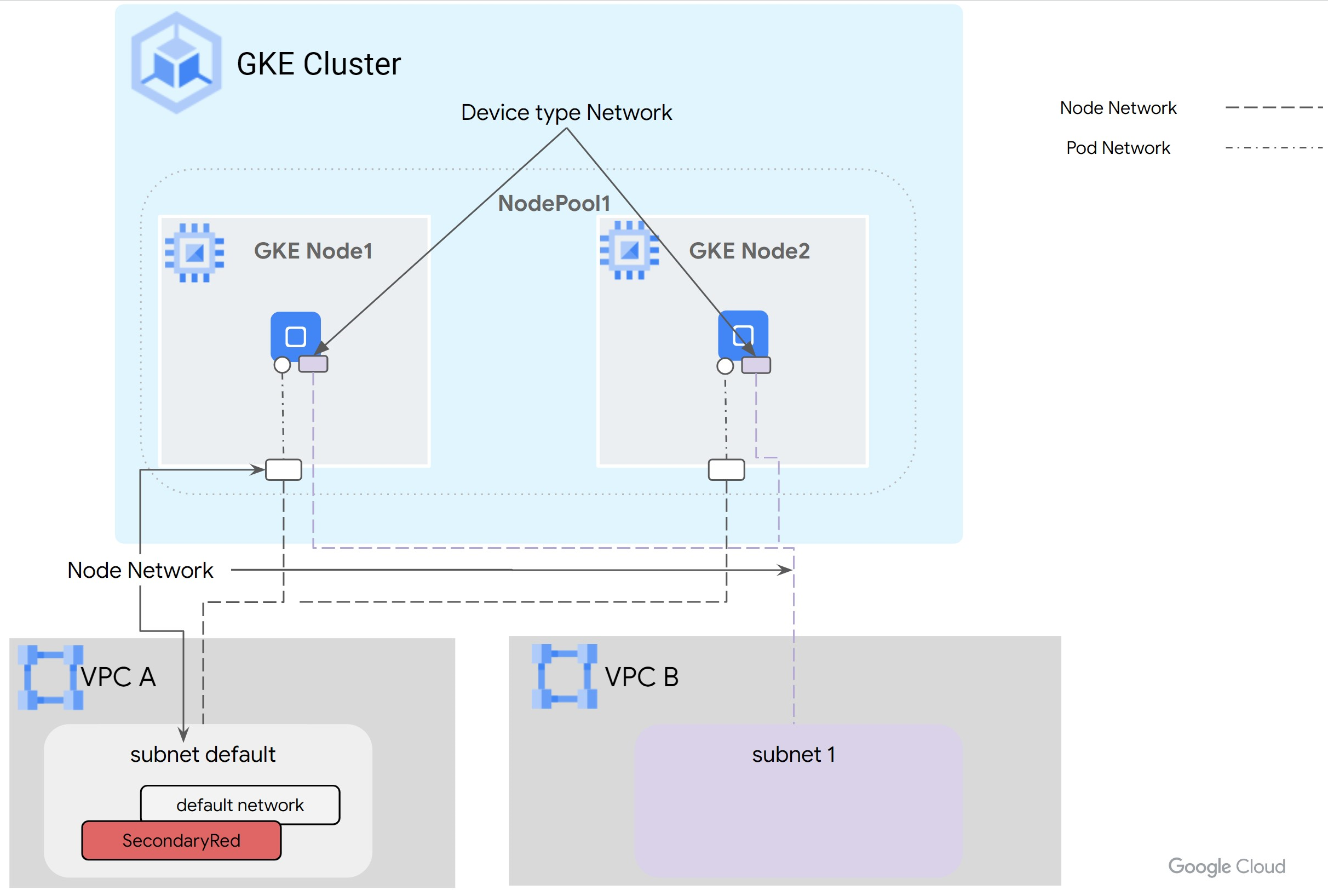

La connessione può essere di tipo Layer 3 o Device. Puoi configurare reti di tipo Device in modalità netdevice o DPDK (Data Plane Development Kit).

Le reti Layer 3 corrispondono a un intervallo secondario di una subnet. Device network

corrispondono a una subnet su un VPC. Il modello dei dati per la

rete di pod in GKE multi-rete è il seguente:

Per la rete

Layer 3: VPC -> Nome subnet -> Nome intervallo secondarioPer la

Devicerete: VPC -> Nome subnet

Rete di pod predefinita: Google Cloud crea una rete di pod predefinita durante la creazione del cluster. La rete pod predefinita utilizza il VPC principale come rete dei nodi. La rete pod predefinita è disponibile su tutti i nodi del cluster e sui pod per impostazione predefinita.

Pod con più interfacce: più interfacce sui pod non possono connettersi alla stessa rete di pod.

Il seguente diagramma mostra una tipica architettura dei cluster GKE con reti Layer 3:

Per le reti di tipo Device, che possono essere configurate in modalità netdevice o DPDK, il vNIC della VM viene gestito come risorsa e trasferito al pod. In questo caso, la rete di pod è mappata direttamente alla rete di nodi. Gli intervalli secondari non sono obbligatori per le reti di tipo Device.

Casi d'uso

Il supporto di più reti per i pod risolve i seguenti casi d'uso:

- Deploy Containerized Network Functions:se esegui le funzioni di rete nei container, che hanno piani di gestione e dati separati. Multi-network per i pod isola le reti per diversi piani utente, prestazioni elevate o bassa latenza da interfacce specifiche o multi-tenancy a livello di rete. È necessario per la conformità, la qualità del servizio e la sicurezza.

- Connetti il VPC all'interno della stessa organizzazione e dello stesso progetto: vuoi creare cluster GKE in un VPC e devi connetterti ai servizi in un altro VPC. Puoi utilizzare l'opzione dei nodi multi-NIC per la connettività diretta. Ciò potrebbe essere dovuto a un modello hub-and-spoke, in cui un servizio centralizzato (logging, autenticazione) opera all'interno di un VPC hub e gli spoke richiedono una connettività privata per accedervi. Puoi utilizzare il supporto di più reti per i pod per connettere direttamente i pod in esecuzione nel cluster GKE al VPC hub.

- Esegui applicazioni DPDK con VFIO:vuoi eseguire applicazioni DPDK che richiedono l'accesso alla NIC sul nodo tramite il driver VFIO. Puoi ottenere la velocità di pacchetti ottimale bypassando completamente il kernel, Kubernetes e GKE Dataplane V2.

- Attiva l'accesso diretto alla vNIC ignorando Kubernetes e GKE Dataplane V2: Esegui le funzioni di rete nei container che richiedono l'accesso diretto alla scheda di interfaccia di rete (NIC) sul nodo. Ad esempio, le applicazioni di computing ad alte prestazioni (HPC) che vogliono bypassare Kubernetes e GKE Dataplane V2 per ottenere la latenza più bassa. Alcune applicazioni richiedono anche l'accesso alle informazioni sulla topologia PCIe della NIC per la collocazione con altri dispositivi come la GPU.

Vantaggi

Il supporto di più reti per i pod offre i seguenti vantaggi:

- Isolamento del traffico: il supporto di più reti per i pod consente di isolare il traffico in un cluster GKE. Puoi creare pod con più interfacce di rete per separare il traffico in base alla funzionalità, ad esempio gestione e piano dati, all'interno dei pod che eseguono CNF (Cloud Native Functions) specifiche.

- Dual homing: il dual homing consente a un pod di avere più interfacce e di instradare il traffico a VPC diversi, consentendo al pod di stabilire connessioni con un VPC primario e uno secondario. Se un VPC riscontra problemi, l'applicazione può eseguire il failover sul VPC secondario.

- Segmentazione della rete: i pod possono connettersi a reti interne o esterne in base alle esigenze del carico di lavoro. A seconda dei requisiti specifici dei tuoi carichi di lavoro, puoi scegliere quali pod o gruppi di pod si connettono a ciascuna rete. Ad esempio, puoi utilizzare una rete interna per la comunicazione est-ovest e una rete esterna per l'accesso a internet. In questo modo, puoi personalizzare la connettività di rete dei tuoi workload in base alle loro esigenze specifiche.

- Prestazioni ottimali con DPDK: il supporto di più reti per i pod in GKE consente alle applicazioni DPDK di essere eseguite nei pod GKE, il che garantisce prestazioni ottimali di elaborazione dei pacchetti.

- NIC host disponibile direttamente nel pod: il supporto NIC in modalità

netdevicecon più reti passa la NIC della VM direttamente al pod, bypassando Kubernetes e GKE Dataplane V2. In questo modo si ottiene la latenza più bassa per la collaborazione tra i dispositivi. - Rendimento: per migliorare il rendimento delle applicazioni, puoi connetterle alla rete più adatta alle loro esigenze.