Desplegar una aplicación en un destino con la estrategia canary

En esta guía de inicio rápido se muestra cómo usar Cloud Deploy para entregar una imagen de aplicación de muestra en una implementación canaria en Google Kubernetes Engine o en Cloud Run. También puedes llevar a cabo un despliegue canary en GKE Enterprise, pero en esta guía de inicio rápido solo se muestran GKE y Cloud Run.

Una implementación canaria divide el tráfico entre una versión de la aplicación que ya se ha implementado y la nueva versión. Cloud Run asigna el tráfico en función de los porcentajes que configures en el flujo de procesamiento de entrega. GKE implementa la nueva versión en una proporción de pods. Esta guía de inicio rápido se implementa primero en el 50% y, después, en el 100%.

En esta guía de inicio rápido, solo hay un destino (prod).

Por lo tanto, solo creamos un clúster de GKE o un servicio de Cloud Run para ejecutar tu aplicación.

En esta guía de inicio rápido, harás lo siguiente:

Crea un clúster de GKE o define un servicio de Cloud Run.

También puedes hacer un despliegue canary en clústeres de GKE Enterprise, pero en esta guía de inicio rápido solo se usan GKE y Cloud Run.

Crea una configuración de Skaffold y un manifiesto de Kubernetes para especificar la imagen de contenedor (prediseñada) que se va a desplegar.

Define tu flujo de procesamiento de entrega y tu destino de implementación de Cloud Deploy.

Invoca tu flujo de procesamiento de entrega creando una versión, que se desplegará automáticamente en un destino.

En esta primera versión no se incluye la fase canary.

Consulta la canalización de distribución y la versión en la Google Cloud consola.

Crea una segunda versión y, esta vez, ejecuta la fase canary para desplegar la aplicación al 50%.

Avanza la versión para que se implemente al 100%.

Antes de empezar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Deploy, Cloud Build, GKE, Cloud Run, and Cloud Storage APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Si utilizas un proveedor de identidades (IdP) externo, primero debes iniciar sesión en la CLI de gcloud con tu identidad federada.

-

Para inicializar gcloud CLI, ejecuta el siguiente comando:

gcloud init -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Deploy, Cloud Build, GKE, Cloud Run, and Cloud Storage APIs.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Si utilizas un proveedor de identidades (IdP) externo, primero debes iniciar sesión en la CLI de gcloud con tu identidad federada.

-

Para inicializar gcloud CLI, ejecuta el siguiente comando:

gcloud init - Comprueba que la cuenta de servicio predeterminada de Compute Engine tenga los permisos suficientes.

Es posible que la cuenta de servicio ya tenga los permisos necesarios. Estos pasos se incluyen para los proyectos que inhabilitan las concesiones automáticas de roles para las cuentas de servicio predeterminadas.

- Primero, añade el rol

clouddeploy.jobRunner:gcloud projects add-iam-policy-binding PROJECT_ID \ --member=serviceAccount:$(gcloud projects describe PROJECT_ID \ --format="value(projectNumber)")-compute@developer.gserviceaccount.com \ --role="roles/clouddeploy.jobRunner" - Añade el rol de desarrollador para tu tiempo de ejecución específico.

- En GKE y GKE con la API Gateway:

gcloud projects add-iam-policy-binding PROJECT_ID \ --member=serviceAccount:$(gcloud projects describe PROJECT_ID \ --format="value(projectNumber)")-compute@developer.gserviceaccount.com \ --role="roles/container.developer" - En Cloud Run:

gcloud projects add-iam-policy-binding PROJECT_ID \ --member=serviceAccount:$(gcloud projects describe PROJECT_ID \ --format="value(projectNumber)")-compute@developer.gserviceaccount.com \ --role="roles/run.developer" -

Añade el rol

iam.serviceAccountUser, que incluye el permisoactAspara implementar en el tiempo de ejecución:gcloud iam service-accounts add-iam-policy-binding $(gcloud projects describe PROJECT_ID \ --format="value(projectNumber)")-compute@developer.gserviceaccount.com \ --member=serviceAccount:$(gcloud projects describe PROJECT_ID \ --format="value(projectNumber)")-compute@developer.gserviceaccount.com \ --role="roles/iam.serviceAccountUser" \ --project=PROJECT_ID

Crear el entorno de ejecución

GKE

Crea un clúster de Autopilot de GKE:

gcloud container clusters create-auto canary-quickstart-cluster \ --project=PROJECT_ID \ --region=us-central1GKE + API Gateway

Crea un clúster de GKE con los ajustes recomendados para que sea compatible con Istio:

gcloud container clusters create canary-quickstart-cluster \ --machine-type=n1-standard-1 \ --num-nodes 4 \ --region=us-central1 \ --project=PROJECT_IDObtén las credenciales del clúster:

gcloud container clusters get-credentials canary-quickstart-cluster \ --project=PROJECT_ID \ --region=us-central1Instala los CRDs de la API de Kubernetes Gateway si aún no están presentes en el clúster.

kubectl apply -f https://github.com/kubernetes-sigs/gateway-api/releases/download/v0.6.2/standard-install.yamlHabilita la implementación del controlador de la pasarela de Istio instalando Istio.

curl -L https://istio.io/downloadIstio | ISTIO_VERSION=1.17.2 sh - \ && ./istio-1.17.2/bin/istioctl install --set profile=minimal -y

Cloud Run

Si usas Cloud Run, puedes omitir este comando. No tienes que hacer nada.

Preparar la configuración de Skaffold y el manifiesto de la aplicación

Cloud Deploy usa Skaffold para proporcionar los detalles de qué desplegar y cómo desplegarlo correctamente en tu destino.

En esta guía de inicio rápido, crearás un archivo

skaffold.yaml, que identifica el manifiesto de Kubernetes o la configuración del servicio de Cloud Run que se va a desplegar.Abre una ventana de terminal.

Crea un directorio y accede a él.

GKE

mkdir deploy-canary-quickstart-gke cd deploy-canary-quickstart-gkeGKE + API Gateway

mkdir deploy-canary-quickstart-gke-gatewayapi cd deploy-canary-quickstart-gke-gatewayapiCloud Run

mkdir deploy-canary-quickstart-run cd deploy-canary-quickstart-runCrea un archivo llamado

skaffold.yamlcon el siguiente contenido:GKE

apiVersion: skaffold/v4beta7 kind: Config manifests: rawYaml: - kubernetes.yaml deploy: kubectl: {}GKE + API Gateway

apiVersion: skaffold/v4beta7 kind: Config manifests: rawYaml: - kubernetes.yaml deploy: kubectl: {}Cloud Run

apiVersion: skaffold/v4beta7 kind: Config manifests: rawYaml: - run.yaml deploy: cloudrun: {}Este archivo es una configuración mínima de Skaffold que identifica tu manifiesto. En esta guía de inicio rápido, crearás el archivo. Sin embargo, también puedes pedir a Cloud Deploy que cree uno por ti para aplicaciones sencillas que no sean de producción.

Consulta la referencia de

skaffold.yamlpara obtener más información sobre este archivo.Crea el archivo de manifiesto de tu aplicación.

GKE

Crea un archivo llamado

kubernetes.yamlen el directoriodeploy-canary-quickstart-gkecon el siguiente contenido:apiVersion: apps/v1 kind: Deployment metadata: name: my-deployment labels: app: my-app namespace: default spec: replicas: 1 selector: matchLabels: app: my-app template: metadata: labels: app: my-app spec: containers: - name: nginx image: my-app-image --- apiVersion: v1 kind: Service metadata: name: my-service namespace: default spec: selector: app: my-app ports: - protocol: TCP port: 80Este archivo es un manifiesto de Kubernetes, que se aplica al clúster para desplegar la aplicación. Este manifiesto incluye los recursos Service y Deployment necesarios para el despliegue canary, así como un recurso HTTPRoute y un recurso Gateway, que se necesitan para usar la API Gateway.

La imagen de contenedor que se va a desplegar se define aquí como marcador de posición,

my-app-image, que se sustituye por la imagen específica cuando creas la versión.GKE + API Gateway

Crea un archivo llamado

kubernetes.yamlen el directoriodeploy-canary-quickstart-gke-gatewayapicon el siguiente contenido:kind: Gateway apiVersion: gateway.networking.k8s.io/v1beta1 metadata: name: my-gateway annotations: networking.istio.io/service-type: "ClusterIP" spec: gatewayClassName: istio listeners: - name: default hostname: "*.example.com" port: 80 protocol: HTTP allowedRoutes: namespaces: from: All --- kind: HTTPRoute apiVersion: gateway.networking.k8s.io/v1beta1 metadata: name: my-httproute spec: parentRefs: - kind: Gateway name: my-gateway hostnames: - "test.example.com" rules: - backendRefs: - name: my-service port: 80 --- apiVersion: v1 kind: Service metadata: name: my-service spec: selector: app: my-app ports: - name: tcp-port protocol: TCP port: 80 targetPort: 8080 --- apiVersion: apps/v1 kind: Deployment metadata: name: my-deployment labels: app: my-app spec: replicas: 1 selector: matchLabels: app: my-app template: metadata: labels: app: my-app spec: containers: - name: nginx image: my-app-imageEste archivo es un manifiesto de Kubernetes, que se aplica al clúster para desplegar la aplicación. Este manifiesto incluye los recursos Service y Deployment necesarios para el despliegue canary, así como un recurso HTTPRoute y un recurso Gateway, que se necesitan para usar la API Gateway.

La imagen de contenedor que se va a desplegar se define aquí como marcador de posición,

my-app-image, que se sustituye por la imagen específica cuando creas la versión.Cloud Run

Crea un archivo llamado

run.yamlen el directoriodeploy-canary-quickstart-runcon el siguiente contenido:apiVersion: serving.knative.dev/v1 kind: Service metadata: name: my-canary-run-service spec: template: spec: containers: - image: my-app-imageEste archivo es una definición básica de un servicio de Cloud Run, que se aplica en el momento del despliegue para crear el servicio en Cloud Run. La imagen del contenedor que se va a implementar se define aquí como un marcador de posición,

my-app-image, que se sustituye por la imagen específica cuando creas la versión.

Crea tu flujo de procesamiento de entrega y tus objetivos

Puedes definir tu canal de distribución y tus destinos en un archivo o en archivos independientes. En esta guía de inicio rápido, crearemos un archivo para nuestra canalización y nuestro único destino:

GKE

Crea un archivo llamado

clouddeploy.yamlen el directoriodeploy-canary-quickstart-gkecon el siguiente contenido:apiVersion: deploy.cloud.google.com/v1 kind: DeliveryPipeline metadata: name: my-canary-demo-app-1 description: main application pipeline serialPipeline: stages: - targetId: prod profiles: [] strategy: canary: runtimeConfig: kubernetes: serviceNetworking: service: "my-service" deployment: "my-deployment" canaryDeployment: percentages: [50] verify: false --- apiVersion: deploy.cloud.google.com/v1 kind: Target metadata: name: prod description: prod GKE cluster gke: cluster: projects/PROJECT_ID/locations/us-central1/clusters/canary-quickstart-clusterGKE + API Gateway

Crea un archivo llamado

clouddeploy.yamlen el directoriodeploy-canary-quickstart-gke-gatewayapicon el siguiente contenido:apiVersion: deploy.cloud.google.com/v1 kind: DeliveryPipeline metadata: name: my-canary-demo-app-1 description: main application pipeline serialPipeline: stages: - targetId: prod profiles: [] strategy: canary: runtimeConfig: kubernetes: gatewayServiceMesh: httpRoute: "my-httproute" service: "my-service" deployment: "my-deployment" canaryDeployment: percentages: [50] verify: false --- apiVersion: deploy.cloud.google.com/v1 kind: Target metadata: name: prod description: prod GKE cluster gke: cluster: projects/PROJECT_ID/locations/us-central1/clusters/canary-quickstart-clusterCloud Run

Crea un archivo llamado

clouddeploy.yamlen el directoriodeploy-canary-quickstart-runcon el siguiente contenido:apiVersion: deploy.cloud.google.com/v1 kind: DeliveryPipeline metadata: name: my-canary-demo-app-1 description: main application pipeline serialPipeline: stages: - targetId: prod profiles: [] strategy: canary: runtimeConfig: cloudRun: automaticTrafficControl: true canaryDeployment: percentages: [50] verify: false --- apiVersion: deploy.cloud.google.com/v1 kind: Target metadata: name: prod description: prod Run Service run: location: projects/PROJECT_ID/locations/us-central1Registra tu canal y tus destinos en el servicio Cloud Deploy:

gcloud deploy apply --file=clouddeploy.yaml --region=us-central1 --project=PROJECT_IDAhora tienes una canalización con un destino configurado para una estrategia de implementación canary.

Confirma tu flujo de procesamiento y tus objetivos:

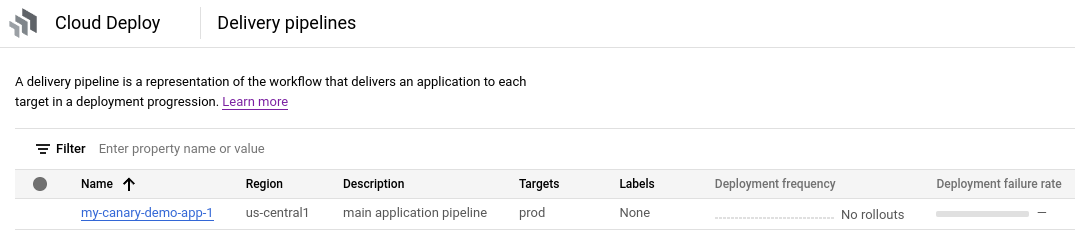

En la Google Cloud consola, ve a la página Pipelines de entrega de Cloud Deploy para ver una lista de los pipelines de entrega disponibles.

Abre la página Pipelines de entrega.

Se muestra el proceso de publicación que acaba de crear y el objetivo que ha configurado aparece en la columna Objetivos.

Crear una versión

Una versión es el recurso central de Cloud Deploy que representa los cambios que se están desplegando. El flujo de procesamiento de entrega define el ciclo de vida de esa versión. Consulta la arquitectura de servicio de Cloud Deploy para obtener más información sobre ese ciclo de vida.

Para crear un recurso

releaseque represente la imagen del contenedor que se va a desplegar, ejecuta el siguiente comando desde el directoriodeploy-canary-quickstart-gke,deploy-canary-quickstart-gke-gatewayapiodeploy-canary-quickstart-run:GKE

gcloud deploy releases create test-release-001 \ --project=PROJECT_ID \ --region=us-central1 \ --delivery-pipeline=my-canary-demo-app-1 \ --images=my-app-image=gcr.io/google-containers/nginx@sha256:f49a843c290594dcf4d193535d1f4ba8af7d56cea2cf79d1e9554f077f1e7aaaGKE + API Gateway

gcloud deploy releases create test-release-001 \ --project=PROJECT_ID \ --region=us-central1 \ --delivery-pipeline=my-canary-demo-app-1 \ --images=my-app-image=gcr.io/google-containers/nginx@sha256:f49a843c290594dcf4d193535d1f4ba8af7d56cea2cf79d1e9554f077f1e7aaaCloud Run

gcloud deploy releases create test-release-001 \ --project=PROJECT_ID \ --region=us-central1 \ --delivery-pipeline=my-canary-demo-app-1 \ --images=my-app-image=us-docker.pkg.dev/cloudrun/container/hello@sha256:95ade4b17adcd07623b0a0c68359e344fe54e65d0cb01b989e24c39f2fcd296aFíjate en la marca

--images=, que se usa para sustituir el marcador de posición (my-app-image) en el manifiesto o la definición de servicio por la imagen específica cualificada por SHA. Google recomienda que conviertas tus manifiestos en plantillas de esta forma y que uses nombres de imágenes cualificados por SHA al crear lanzamientos.Cuando creas un lanzamiento, Cloud Deploy también crea automáticamente un recurso de lanzamiento para desplegarlo inmediatamente en tu único destino,

prod.Pasamos a la fase estable

En esta primera versión, nos saltamos la fase canary y la implementamos al 100% (fase estable). Esto se debe a que la aplicación no se ha desplegado antes, por lo que no se puede calcular el 50% de los pods (en GKE) ni cómo se divide el tráfico del servicio (en Cloud Run). Los pods (GKE) o las revisiones (Cloud Run) aún no existen.

Como nos hemos saltado la fase canary, ahora podemos empezar la fase estable, que lleva el tráfico al 100%. Después, crearemos otra versión, que ejecutará la versión canary.

En una situación real, normalmente ejecutarás una implementación canary en la que tu aplicación ya se esté ejecutando, por lo que esta fase de omisión será poco habitual.

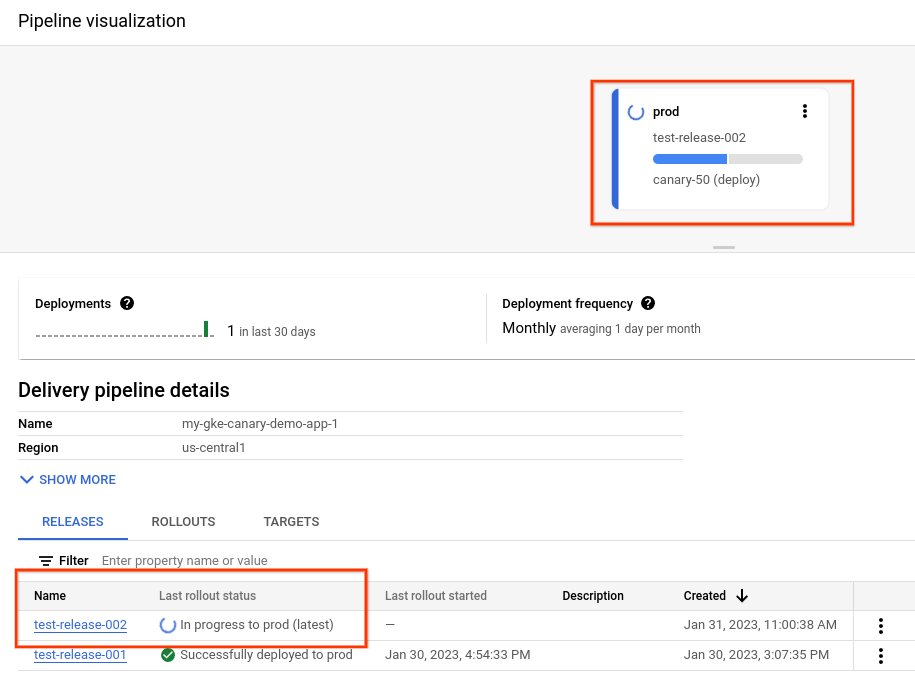

Ver la versión en la consola Google Cloud

Ahora que has creado la primera versión, se ha creado el lanzamiento y puedes ver la versión y el lanzamiento en Google Cloud Console. También puedes ver la visualización de la canalización, que muestra el estado actual de la versión.

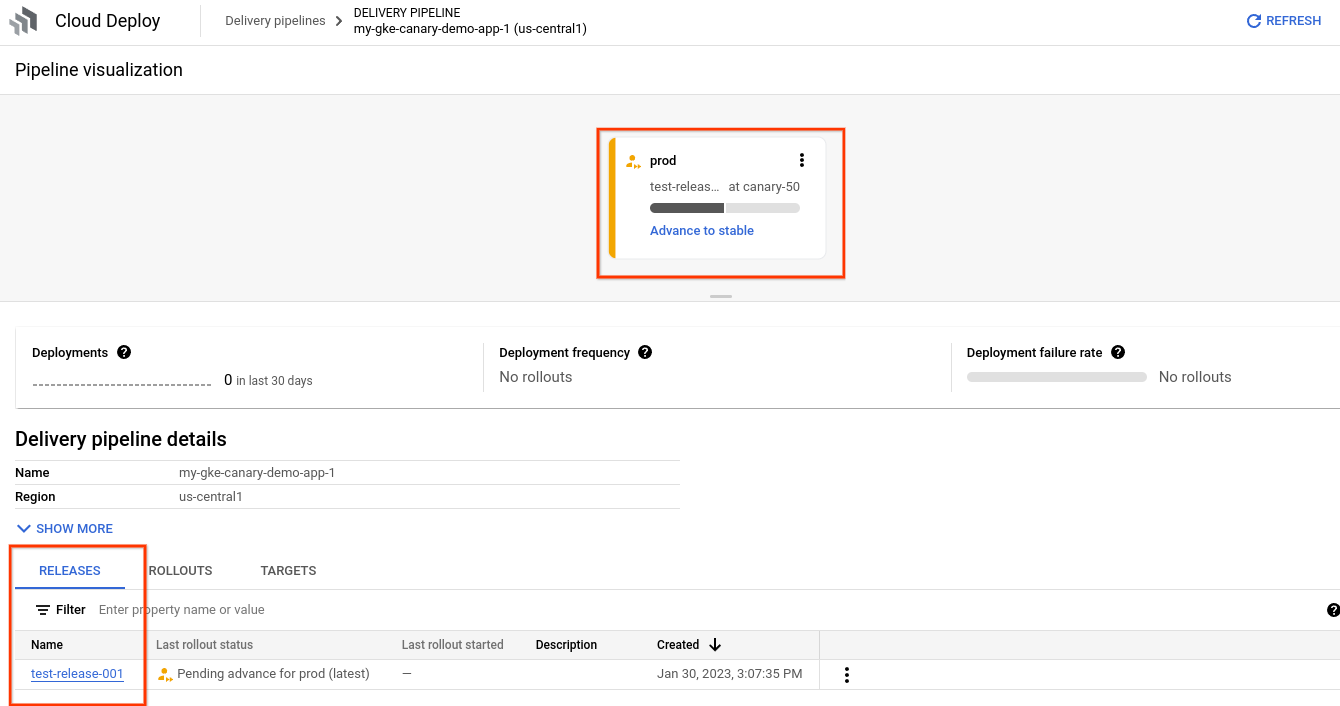

En la Google Cloud consola, ve a la página Flujos de procesamiento de entrega de Cloud Deploy para ver el flujo de procesamiento de entrega my-canary-demo-app-1.

Haga clic en el nombre de su flujo de procesamiento de entrega "my-canary-demo-app-1".

La visualización de la canalización muestra el estado de la implementación de la aplicación. Como solo hay una fase en la canalización, la visualización muestra un solo nodo.

Tu lanzamiento aparecerá en la pestaña Lanzamientos, en Detalles de la canalización de entrega.

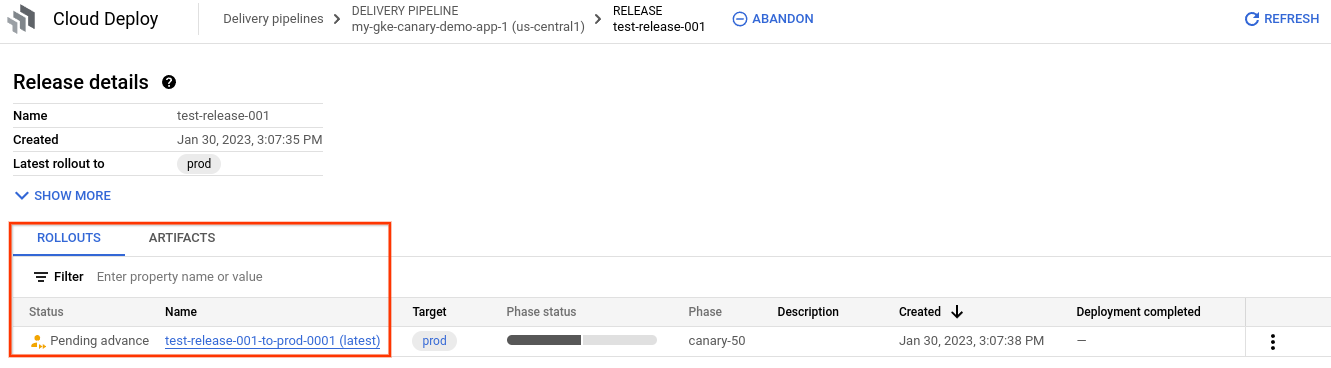

Haz clic en el nombre de la versión

test-release-001.Tus lanzamientos aparecerán en Lanzamientos. Puedes hacer clic en un lanzamiento para ver sus detalles, incluido el registro de implementación.

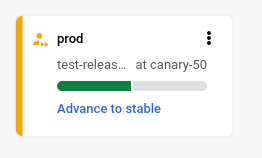

Verá que el estado del lanzamiento es "Pendiente de avance" y que el objetivo que se muestra en la visualización de la canalización tiene un enlace a "Avanzar a estable".

Avanzar en la fase de lanzamiento

Después de la primera versión, se omitió la fase canary y el lanzamiento está esperando para iniciar la fase "estable", que implementa la aplicación al 100%:

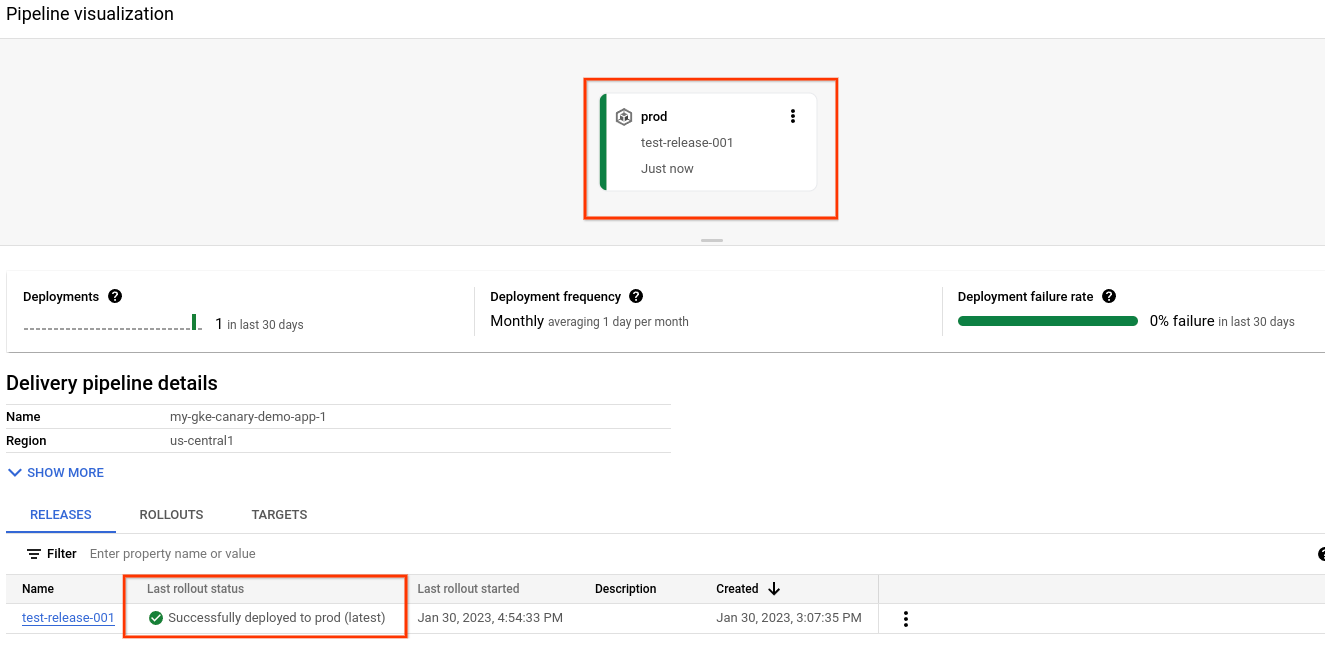

En la visualización de la canalización, haz clic en Pasar a estable.

Cuando se te solicite, haz clic en Avanzar para confirmar la acción.

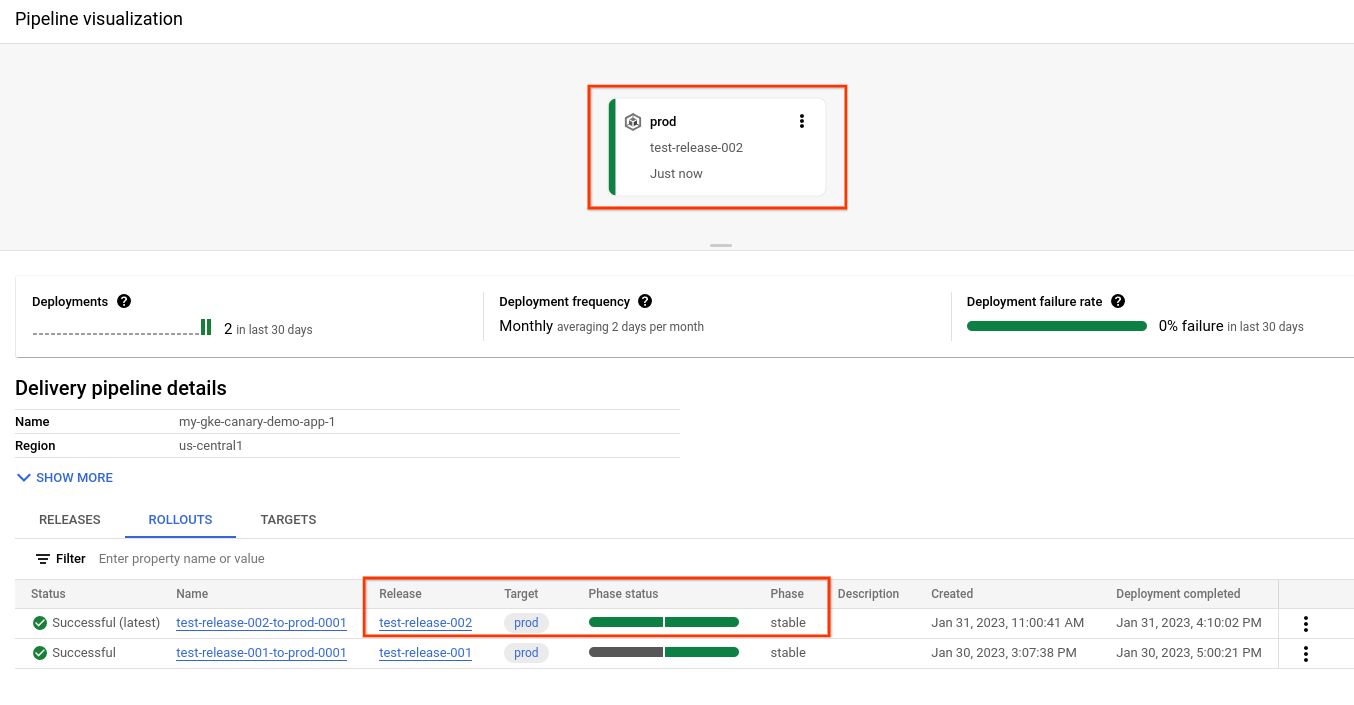

Al cabo de unos minutos, el lanzamiento se encuentra en la fase "estable" y la aplicación se ha implementado al 100%.

Ejecutar el despliegue canary

Como en la primera versión se ha omitido la fase canary, ahora crearemos otra versión que sí ejecute una implementación canary.

Para crear un

release, ejecuta el siguiente comando desde el directoriodeploy-canary-quickstart-gke,deploy-canary-quickstart-gke-gatewayapiodeploy-canary-quickstart-run:GKE

gcloud deploy releases create test-release-002 \ --project=PROJECT_ID \ --region=us-central1 \ --delivery-pipeline=my-canary-demo-app-1 \ --images=my-app-image=gcr.io/google-containers/nginx@sha256:f49a843c290594dcf4d193535d1f4ba8af7d56cea2cf79d1e9554f077f1e7aaaGKE + API Gateway

gcloud deploy releases create test-release-002 \ --project=PROJECT_ID \ --region=us-central1 \ --delivery-pipeline=my-canary-demo-app-1 \ --images=my-app-image=gcr.io/google-containers/nginx@sha256:f49a843c290594dcf4d193535d1f4ba8af7d56cea2cf79d1e9554f077f1e7aaaCloud Run

gcloud deploy releases create test-release-002 \ --project=PROJECT_ID \ --region=us-central1 \ --delivery-pipeline=my-canary-demo-app-1 \ --images=my-app-image=us-docker.pkg.dev/cloudrun/container/hello@sha256:95ade4b17adcd07623b0a0c68359e344fe54e65d0cb01b989e24c39f2fcd296aAl cabo de unos minutos, se crea un lanzamiento y, esta vez, se ejecuta la fase canary:

Cuando finalice la primera fase de lanzamiento, se pasará a la fase canary:

Esto significa que la aplicación se ha implementado en el 50%. En el caso de GKE basado en serviceNetworking, se implementa en la mitad de tus pods. El tráfico de GKE y Cloud Run basado en la API Gateway se asigna al 50%.

Haz clic en Lanzamiento avanzado y, a continuación, en Avanzar cuando se te solicite.

De esta forma, el lanzamiento pasa a la fase "estable", en la que la aplicación se implementa al 100%.

Limpieza

Para evitar que se apliquen cargos en tu cuenta de Google Cloud por los recursos utilizados en esta página, sigue estos pasos.

Elimina el clúster

canary-quickstart-cluster(solo en GKE):gcloud container clusters delete canary-quickstart-cluster --region=us-central1 --project=PROJECT_IDElimina el servicio

my-canary-run-service(solo en Cloud Run):gcloud run services delete my-canary-run-service --region=us-central1 --project=PROJECT_IDElimina la canalización de distribución, el destino y todos los recursos de lanzamiento y de implementación:

gcloud deploy delete --file=clouddeploy.yaml --force --region=us-central1 --project=PROJECT_IDElimina los segmentos de Cloud Storage que haya creado Cloud Deploy.

Una termina con

_clouddeployy la otra es[region].deploy-artifacts.[project].appspot.com.

¡Ya has completado esta guía de inicio rápido!

Siguientes pasos

- Primero, añade el rol

Si ya tienes instalada la CLI, asegúrate de que estás usando la versión más reciente:

gcloud components update